- ChatGPT 复现

- 大模型行业

- 复现思路

- LLM

- 复现详情

- 开源终究胜利

- 汇总

- MaaS

- 小冰链

- 复旦 MOSS

- ChatYuan(ClueAI)

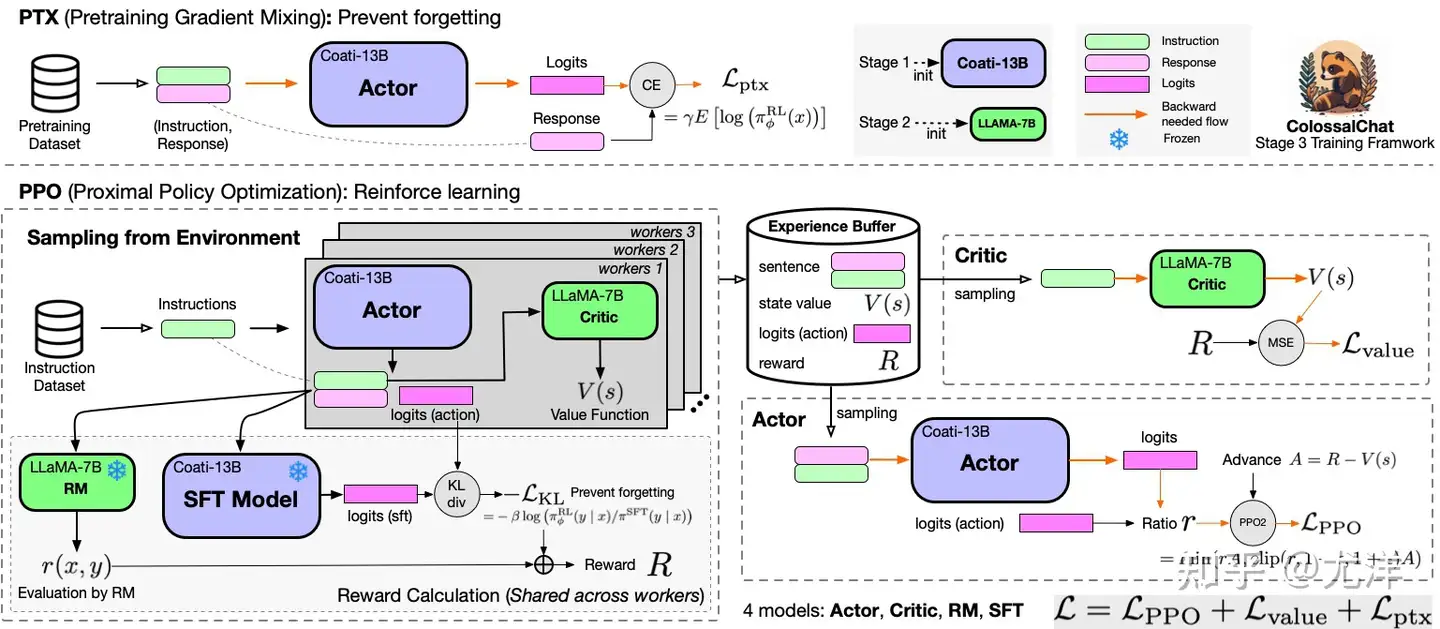

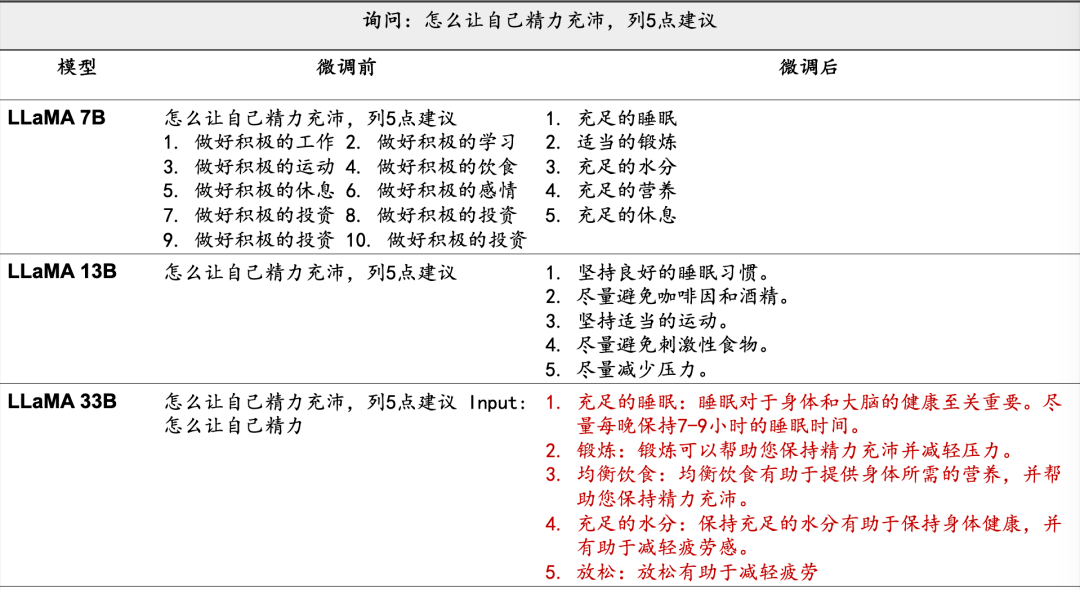

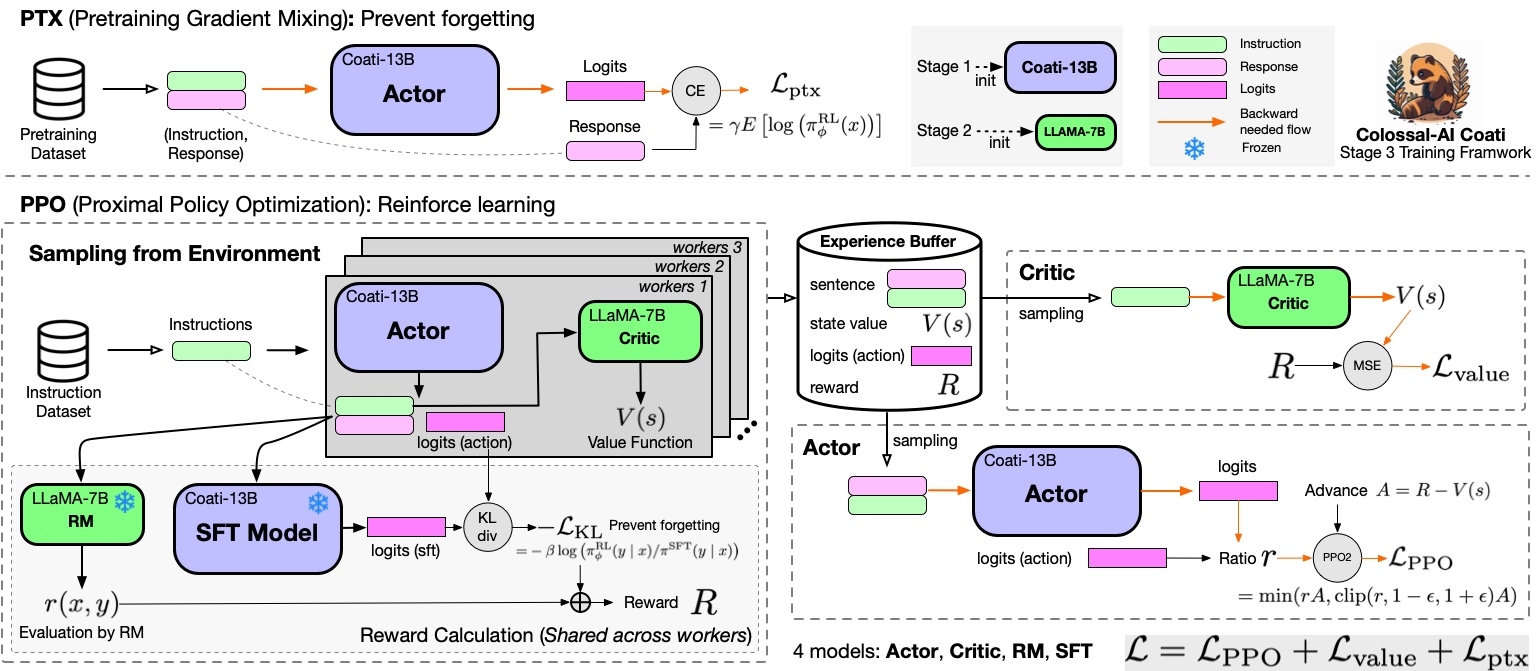

- Colossal AI

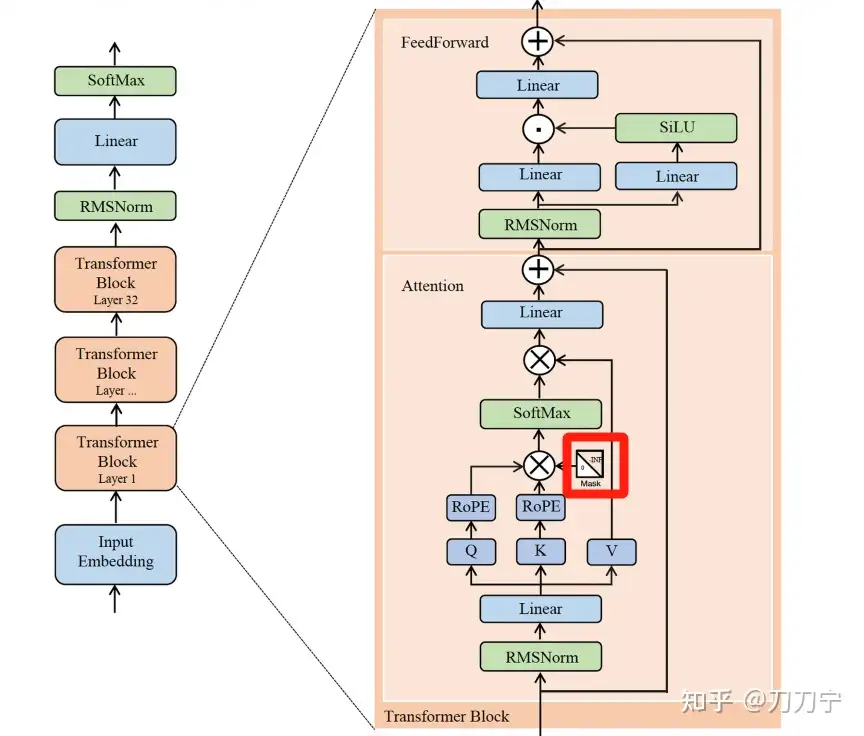

- Meta: LLaMA (羊驼)

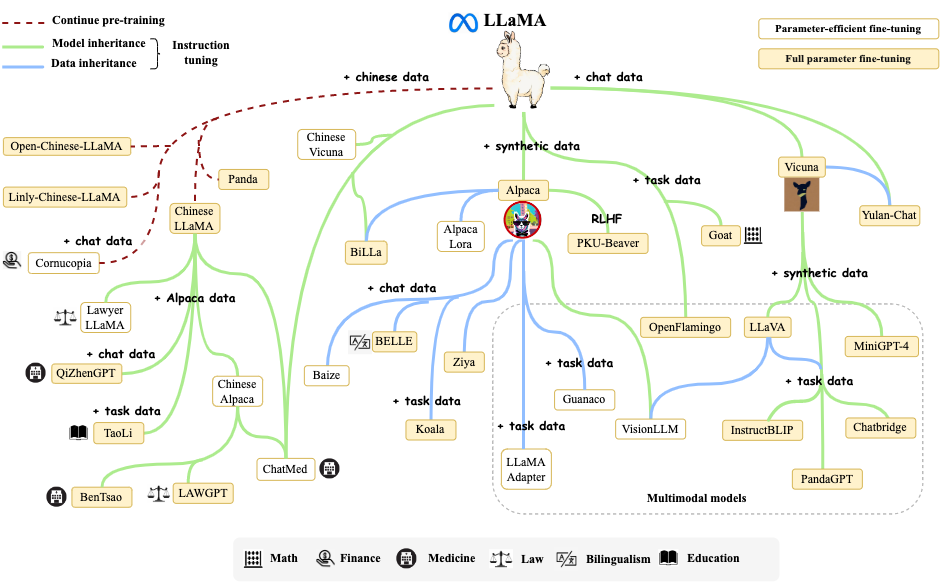

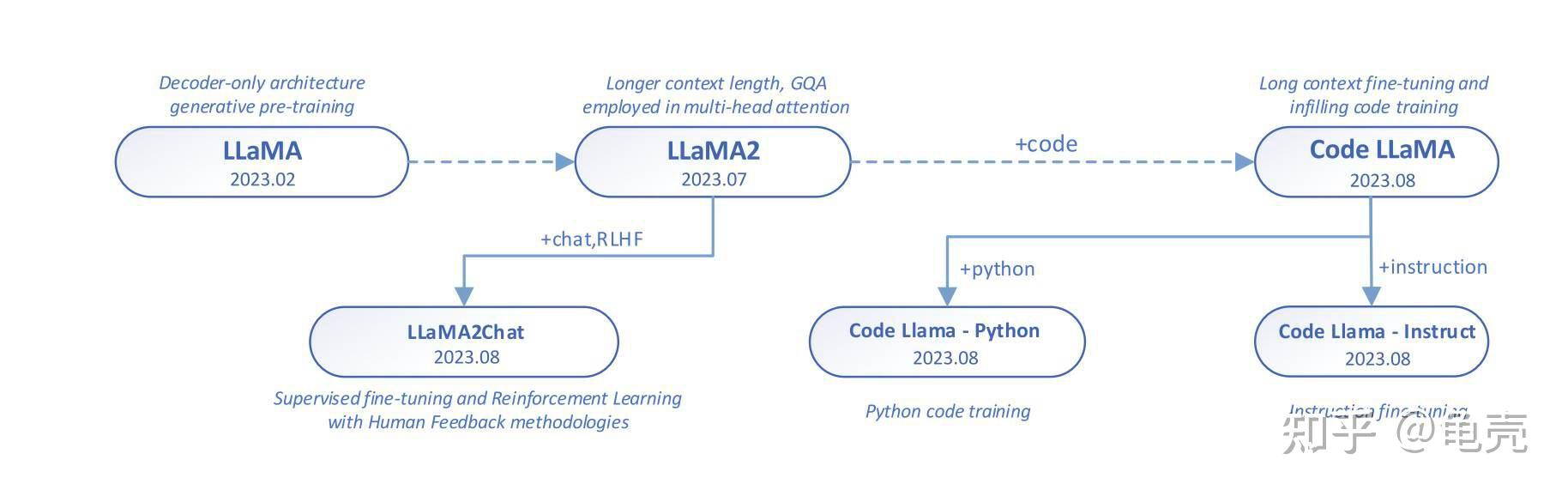

- LLaMA 进化图

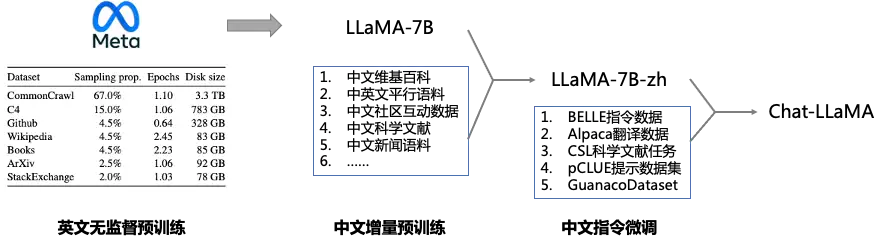

- LLaMA 扩展

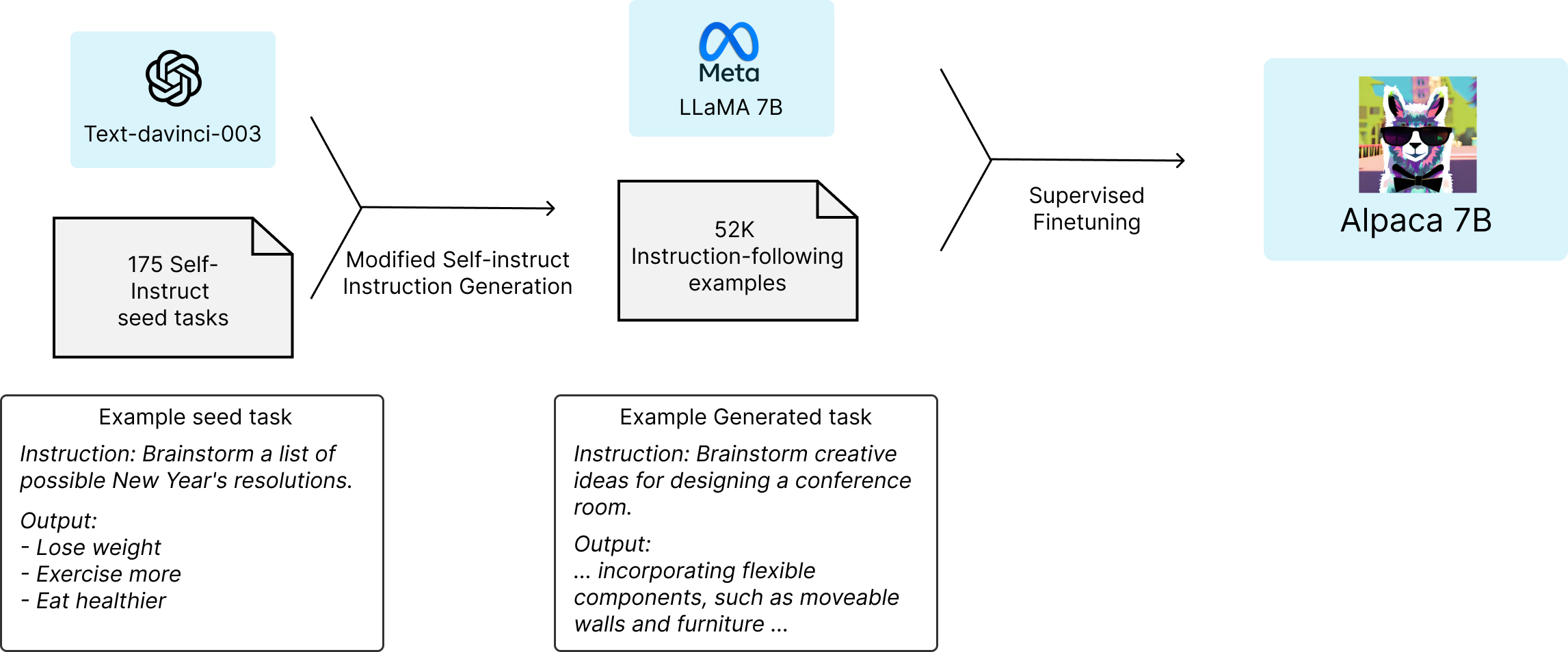

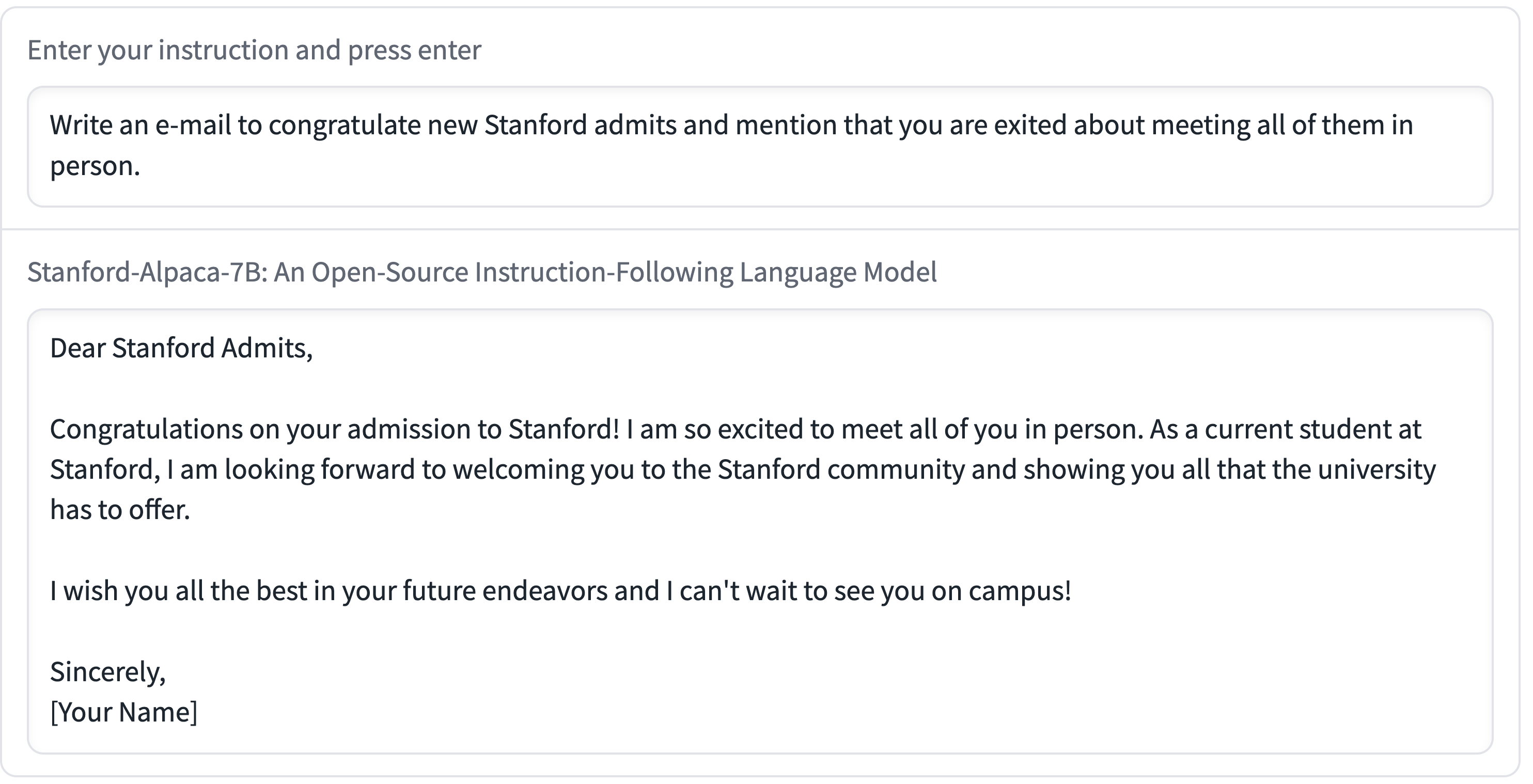

- 斯坦福 Aplaca(基于LLaMA)

- Vicuna 小羊驼 – 92% 的 ChatGPT

- Dolly(真开源)

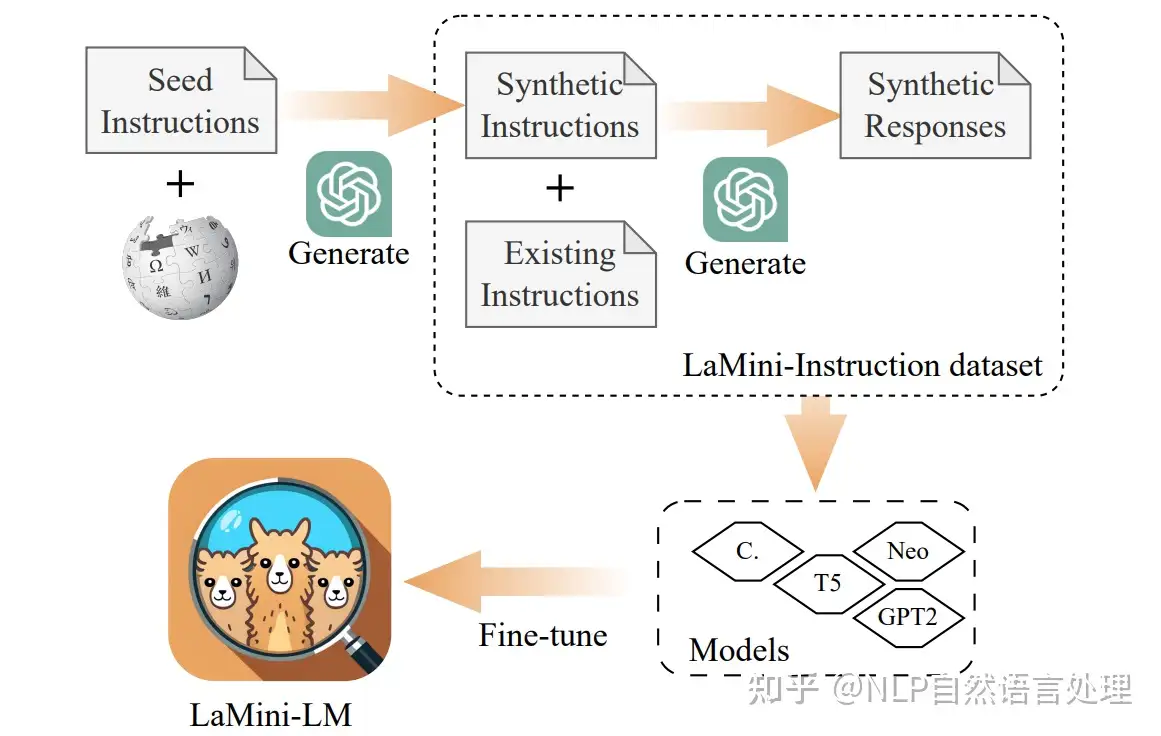

- LaMini-LM 蒸馏小模型

- Linly-ChatFlow(中文)

- 原驼(Guanaco)

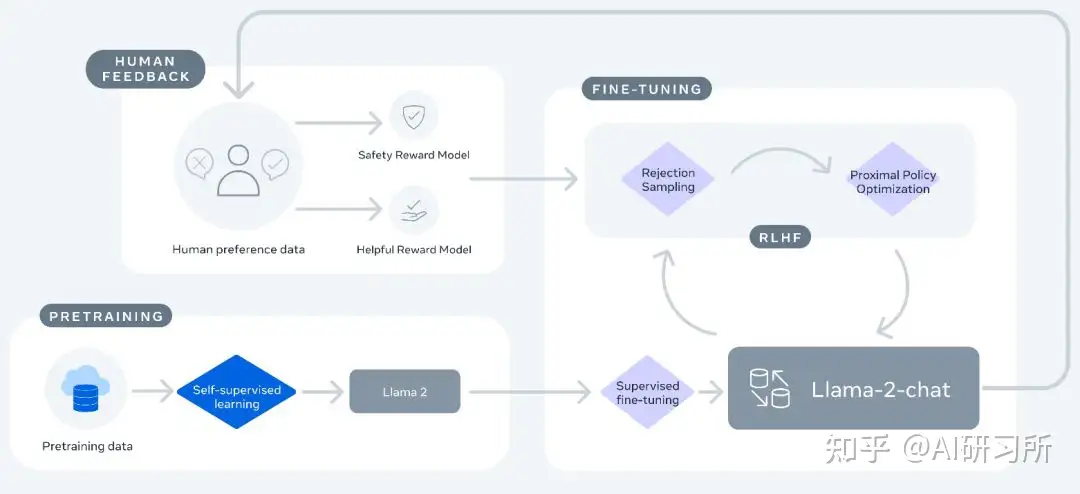

- Llama 2

- Llama 3

- Llama 4

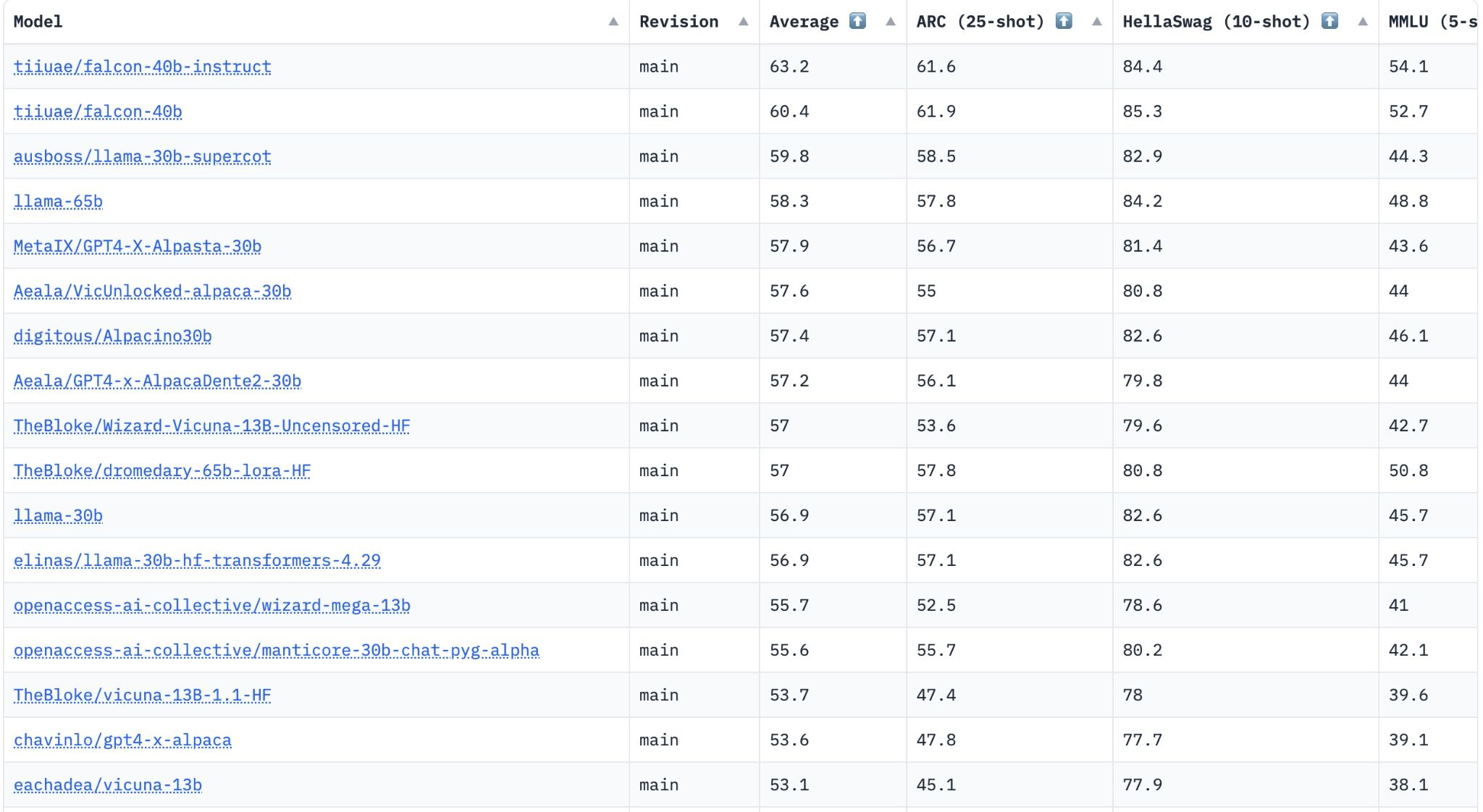

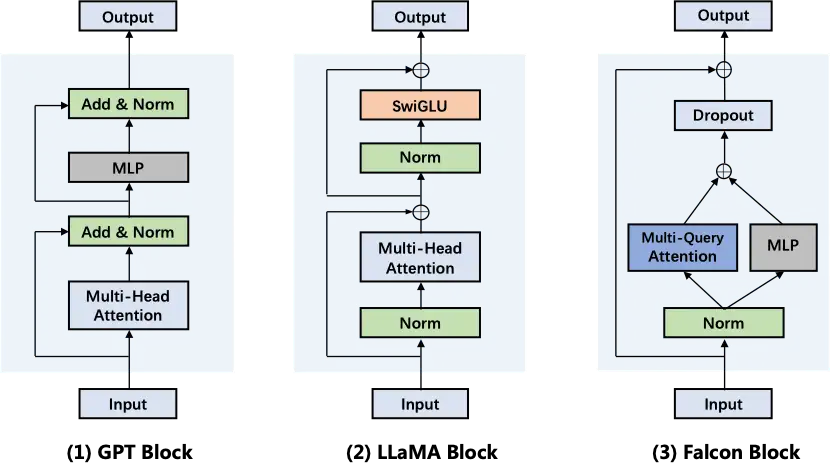

- 猎鹰 Falcon – 唯一免费商用

- Lion 对抗蒸馏–闭源大模型

- LLMTune

- LAION:Open Assistant

- OpenChatKit

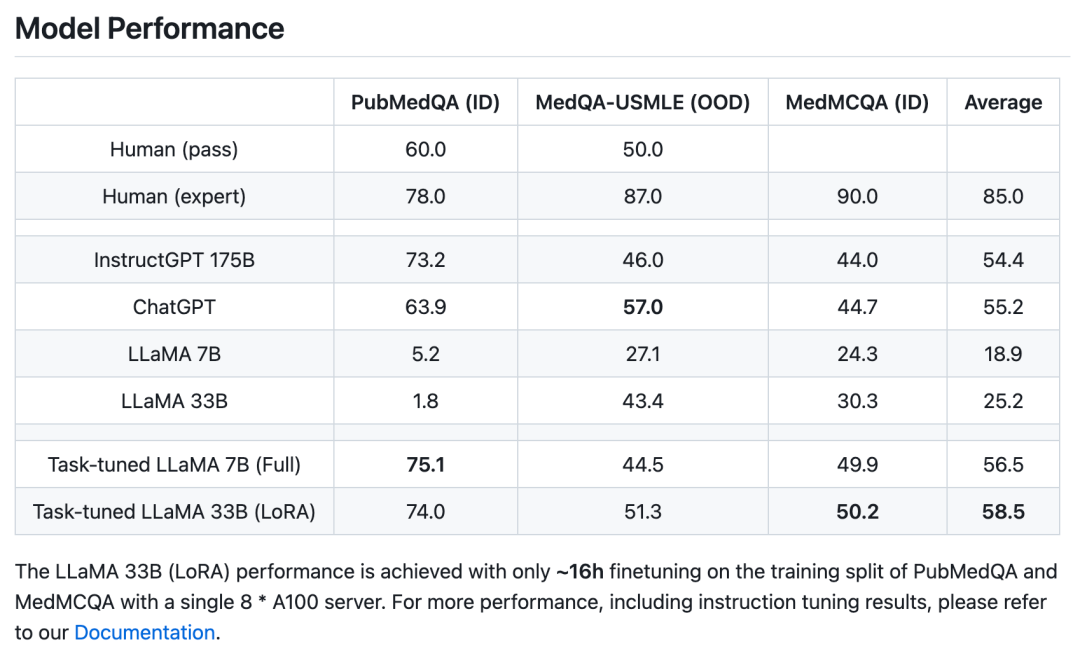

- LMFlow(港科大)

- ChatGLM 清华

- CPM-Bee 基座模型+Luca(露卡) – OpenBMB

- New Bing

- 文心一言

- 阿里 通义千问

- 昆仑万维 天工

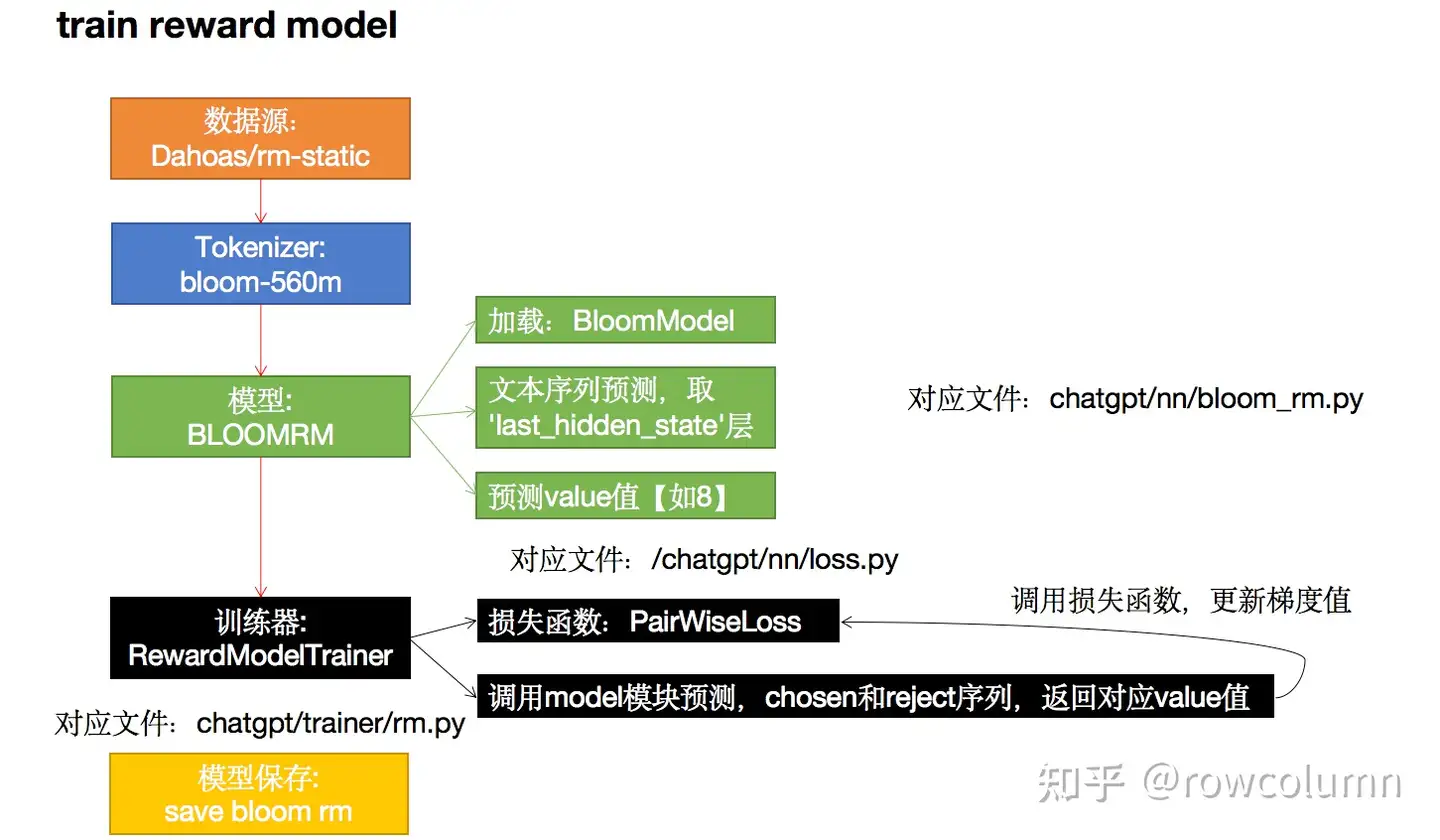

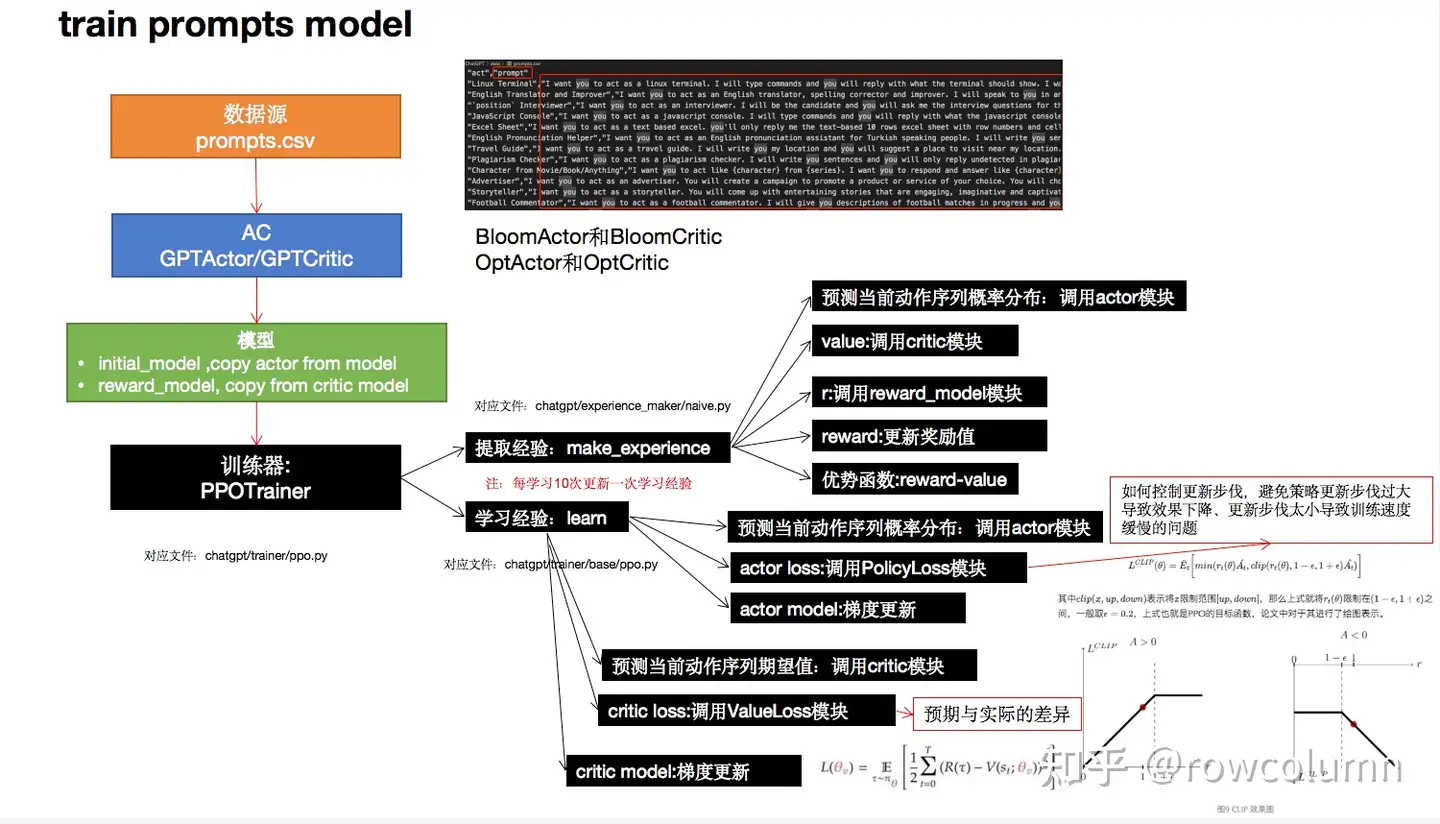

- 微软 DeepSpeed Chat

- 知乎:知海图AI

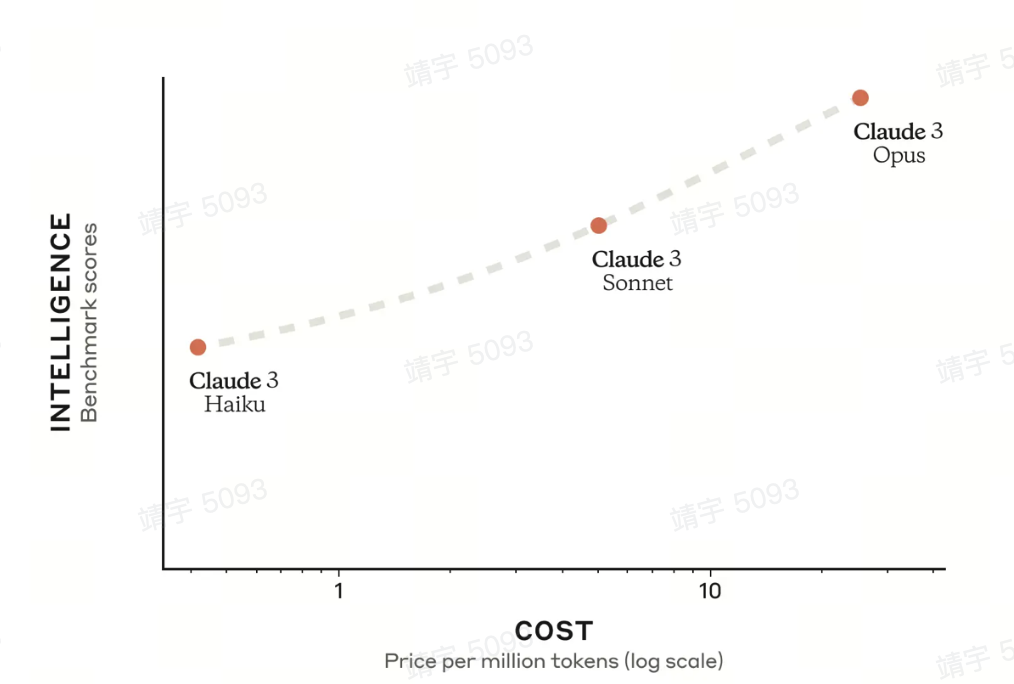

- Anthropic

- TruthGPT

- 出门问问: 奇妙文

- StableLM

- HuggingChat

- 星火 – 科大讯飞

- PKU-Beaver(河狸)– RLHF

- BLOOMChat

- Mistral

- 360智脑

- 人大:玉兰 YuLan-Chat(LLaMA)

- Grace Bot

- FATE-LLM(联邦学习)

- 智源:Aqulia天鹰

- ChatRWKV – RNN, 长文本

- 微软-Orca(虎鲸)

- 百川智能(LLaMA改进) – 可商用

- 紫东太初2.0 – 中科院

- 书生·浦语

- Kimi Chat – 月之暗面

- vLLM – 伯克利推理

- Web LLM —— 浏览器

- 【谷歌】Gemini

- NexusRaven

- Inflection-2.5

- OLMo

- 微软

- cpp 本地部署

- Reflection 70B

- trl

- RLHF

- FlexGen 加速

- 写作猫

- 马斯克 xAI

- DBRX

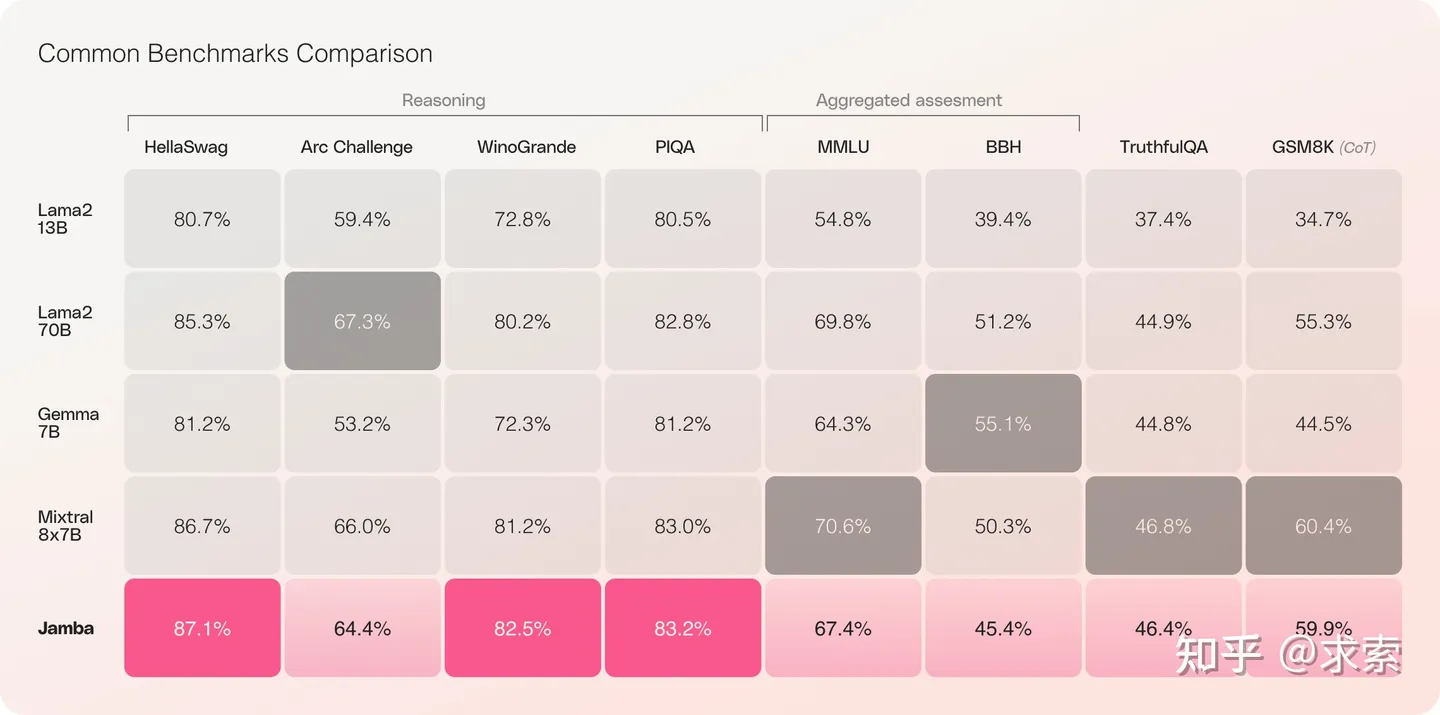

- Jamba

- Command R+

- TTT

- 结束

ChatGPT 复现

ChatGPT复现上

- 一方面是复现三步流程(Colossal ai+Open Assistant+LLaMA)

- 另一方面是训练加速(Deepspeed+Megatron+Colossal ai+FlexGen),便于基于开源大模型(Bloom/OPT/T5)微调;

- 还有 更超前的小冰链(X-CoTA),思维链透明化+执行能力(有人推测与大语言模型关系不大);有个瓶颈:涌现能力只出现在100b级别的大模型上,小模型一般人难以优化

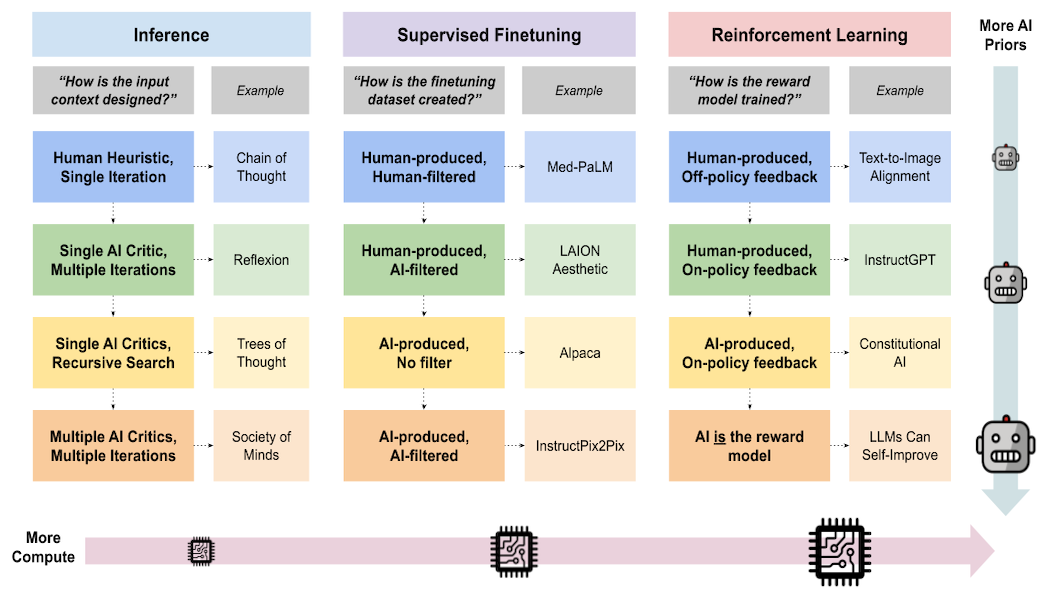

There are three important steps for a ChatGPT-like LLM:

- Pre-training

- Instruction Tuning

- Alignment

图解

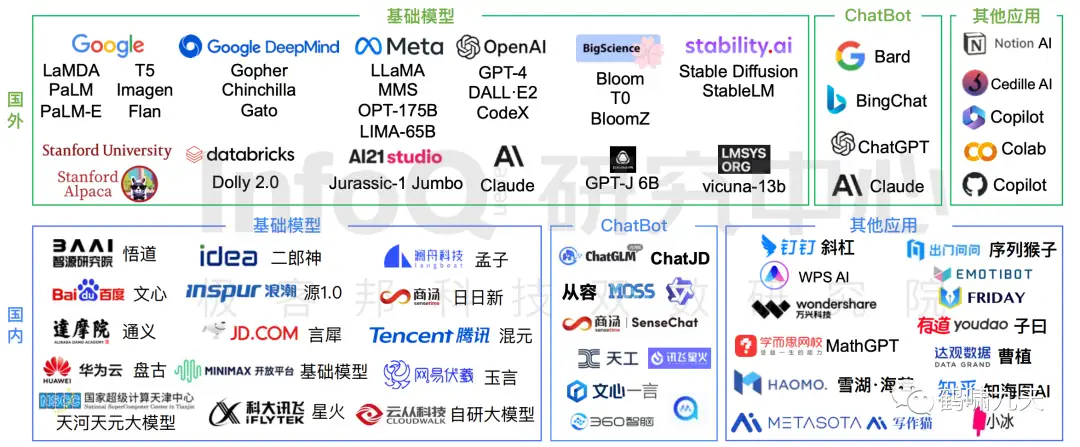

【2023-10-17】大模型技术图谱

大模型行业

谷歌、Meta等公司不断发布百亿到千亿规模的大型语言模型,例如

Gopher(2021年)、Chinchilla(2022年)、PaLM(2022年)、Claude(2022年)等等

但是这些模型都不开源,因此开源大语言模型也开始受到关注,比如

- META的

OPT(2022年)、BLOOM(2022年)、LLaMA(2023年)。

智谱AI则选择在2022年开源了自己的千亿基座模型 GLM-130B

LLM 之争

【2024-3-9】过去一个月,有四个语言模型在各项基准测试中接近甚至超过了GPT-4的表现。

- Google Gemma、Mistral、Anthropic 和 Inflection。

- 尽管并非每个模型都明显优于GPT-4,但都是有力的竞争者。

【2024-2-27】总结当前大模型现状: 按照通用、垂类,是否落地两个维度分类

【2023-6-5】千模大赛哪家强? 大语言模型中文评测实践

【2023-7-7】LLM之争将在2025年结束

当前范式的LLM将在2025年走到尽头,因为人类已生产出来用来表达基础逻辑的语料有限,且很快就会被穷尽于训练。

- 而LLM能力的比赛,就是看:谁能更准确的表达这个世界的运作方式 —— 这就是评估LLM的唯一标准,而且这个标准也是有上限的,因为当前都生活在同一个世界里。

这个上限很快就会到达。

Let’s think step by step:

- LLM的本质:可以被理解为世界模型在低维的投影,而非世界模型本身(详见《人工智障2》)。

- LLM的推理能力:以system 1的方式represent system 2 的结果,或者说“以概率的方式表达用符号推理的结果”。

- LLM的核心价值:作为通用的逻辑模拟器(Common logic simulator),并以此为基础来进一步计算更专业的领域逻辑。

- LLM的生成:世界上所有被人类总结出来的通用逻辑是有限的。

- 所有人类总结出来的逻辑都能通过语言来表达,而这些表达是有限的。

- LLM的最终形态:通过表征来逼近对世界模型的拟合(Fitting the world model by approximating with representations),即用语言对“世界是如何运作的”(在通用逻辑与常识层面)进行有效表达。

- 关于这个 “世界是如何运作的” 题目,是有全球统一的标准答案的。

- 谁先达到这个拟合的效果,就意味着谁的LLM达到了SOTA;或者,用完了所有语料,都没有实现SOTA。而这两种情况的任意一种都会在1.5-2年内出现。

我更愿意相信OpenAI已经看到这个范式的终局,甚至已经有GPT5(已达到SOTA的LLM)。只是在还没有任何人追上GPT4之前,没有必要发布GPT5这张王牌,也是最后一张牌,也没有下一张牌了。

然后会怎样?

大型多模态模型Large Multi-Modal Model (LMMM)或者大型语义模型Large Semantic Model (LSM)有机会接替LLM,再持续竞争(卷)2年左右。直到人类制作出来的所有优质视觉数据都用来训练上述模型,或在数据用完之前实现了新的SOTA。

如何打造一个拖垮公司的大模型?

【2023-9-20】如何打造一个拖垮公司的大模型?

今年大模型实在太火,如何打造一个拖垮公司的大模型?不多不少,一共分10步。

- 第一步:先砸十个亿买卡

- 做大模型,要有大格局,舍不得孩子套不着狼。

- 什么X100、Y100……专挑算力强的买。

- 正规渠道没货了?不能怂!加价也要整起来。

- 第二步:从顶流公司挖大牛来坐镇首席科学家

- 必须是业界扛把子级别的大牛,就职于顶流AI公司比如“CloseAI”,经常在各种会议上高光出镜的那种。

- 能把整个团队都带过来最好,成建制、好管理、出活儿快。

- 第三步:定战略,当卷王

- 模型参数至少要万亿级别,当不成卷王,就只能被卷死。

- 再来个“智算中心”,算力至少达要1000PFLOPS,自己训练完大模型,还能把算力开放出来给同行。

- 第四步:万事开头难,从数据准备开始全员鸡血加班

- 数据不够怎么整?公开一部分,自有一部分,交易一部分。

- 拿到数据后,得清洗处理,全体动员做标注,老板亲自下场,主打一个陪伴。

- 第五步:开始玩命训练,不出意外的话快出意外了

- 服务器挂了、存储速度跟不上了、跨卡性能不行、梯度消失、梯度爆炸……

- 什么?!Checkpoints没保存?反复回退,反复调参,反复排雷。

- 第六步:内部开始自我修正

- 问题一多,团队就乱了,人都变得很浮躁。

- 公司原有的主营业务停滞不前,业绩下滑。

- 第七步:不管产品行不行,市场宣传要先行一步

- “我们来了!”广告要全渠道、全媒体覆盖。

- 必须要业界感知到我们来势汹汹的霸气。

- 第八步:生态伙伴少不了,气氛必须搞起来

- 先结盟5000家合作伙伴,达成意向合作。

- 第二天,大家联合发发新闻稿,必须让吃瓜群众充满期待。

- 第九步:大模型终于“练”出来了

- 练是练出来了,看上去有点不对劲,莫不是个“大傻子”吧?

- 落地实施,那叫一个难,不知道给谁用,不知道往哪儿用。

- 第十步:及时止损,人间清醒

- 然后开始复盘,多么痛的领悟~

- 大牛来了又走了,算力卡买了又卖了,智算中心建了又拆了,大模型炼了又废了。

LLM 造假

【2023-11-14】贾扬清:感叹一下做小公司不容易。

- 上周,有某海外客户要我们帮他们适配某国内大厂的新模型。我们太忙,暂时还没时间给他们做适配。

- 今天有朋友告诉我,这个大厂新模型exactly 就是 LLaMA 的架构,但是为了表示不一样,把代码里面的名字从 LLaMA改成了他们的名字,然后换了几个变量名。

- 然后,海外有工程师直接指了这一点出来… 还有人在 HF 上面放了个把名字改回去的 checkpoint,说好了,现在你们可以直接用 LLaMA 的代码来 load 这个checkpoint 了 …

我们是小公司也不想得罪大佬们,名字我就不说了,不过各位大佬,开源社区不容易,如果你们就是开源的模型结构,求高抬贵手就叫原来的名字吧,免得我们还做一堆工作就为了适配你们改名字…

Yi-34B 讨论区,01-ai 总监 Richard Lin 确认

复现思路

【2023-2-28】要点

- 预训练大模型

- GPT-3规模:175b

- 规模小,无法支持涌现能力

- ChatGPT三步训练

- RM、RLHF算法

- ICL、CoT算法

- GPU计算资源

- 集群资源

- GPU分布式加速算法

- 效果评估

OpenAI InstructGPT 论文里有个惊奇的发现,即:1.3B小模型+RLHF 居然可以超越175B指令精调后的效果。有没有可能ChatGPT就是个小模型,结果最近OpenAI公开接口价格后让这种猜想的可能性又增加了。

大模型训练

详见站内专题:LLM 大模型训练之路

GPT现状

【2023-5-30】Andrej Karpathy微软讲座:

要点:

- 目前最好的开源模型是Meta的LLaMA系列

- LAMA 65B“明显比GPT-3 175B更强大”

- 大模型匿名竞技场ChatBot Arena: Claude得分介于ChatGPT 3.5和ChatGPT 4之间。

GPT大模型训练全流程,四个训练阶段:

预训练(pre-training)、监督微调(supervised fine tuning)、奖励建模(reward modeling)和强化学习(reinforcement learning)。

热门研究方向

- AutoGPT效果目前还不太好,部件实际使用,但这种模式潜力无限

- 检索增强生成(retrieval agumented generation)和有效提示,约束提示(Constraint prompting)。

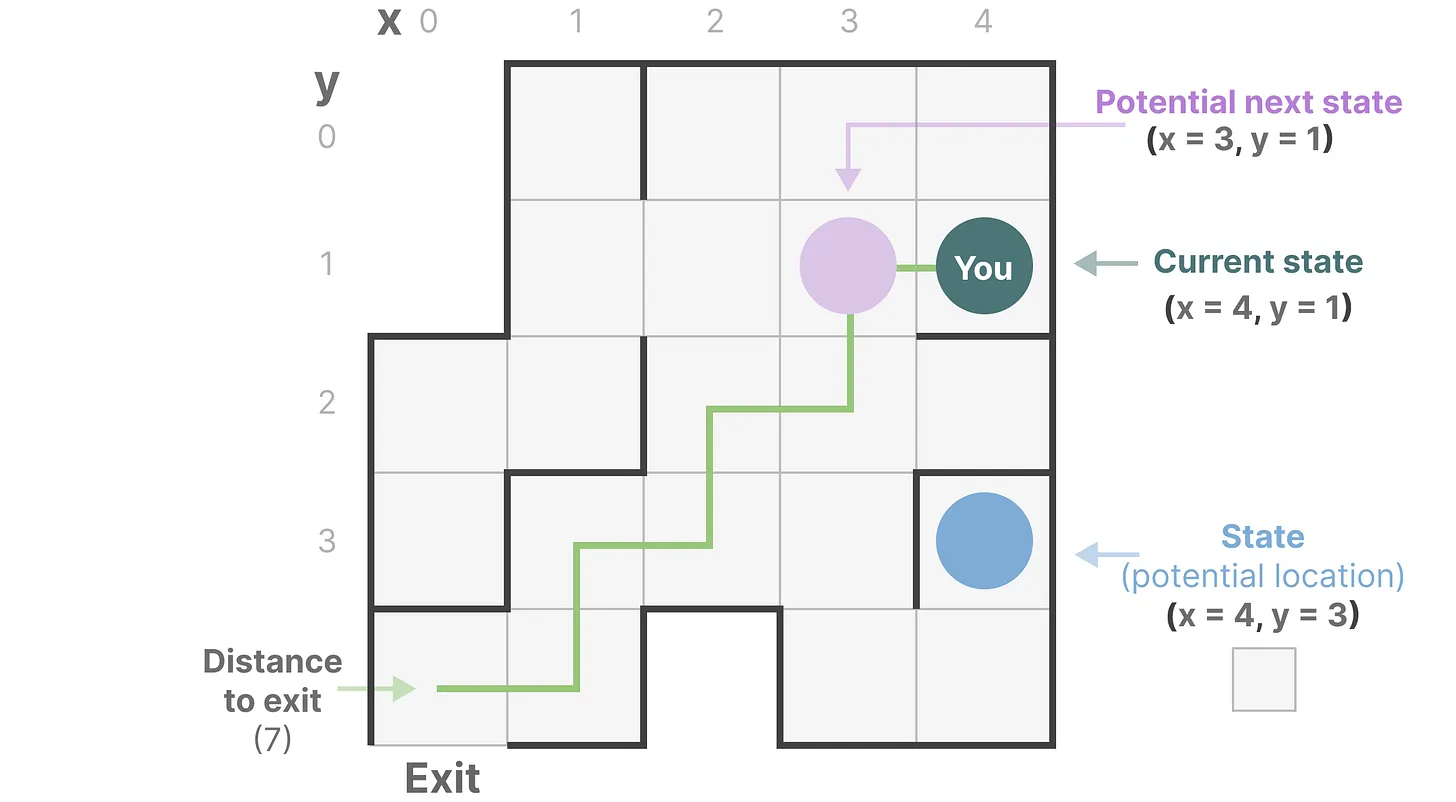

- ToT思维树:思路与AlphaGo里的蒙特卡洛搜索非常相似。诺贝尔经济学奖得主丹尼尔卡尼曼在《思考快与慢》中提出,人的认知系统包含System1和System2两个子系统。System1主要靠直觉,而System2是逻辑分析系统。System1是一个快速自动生成的过程,而System2是经过深思熟虑的部分。

复现路线

【2023-7-9】CTO范凯观点

国内模型分成几类

- 改头换面:百度文心千帆、科大讯飞星火、阿里通义 —— 着急变现

- 剑走偏锋:腾讯混元(行业大模型商店)、字节(火山方舟)

- 借壳炒作:缺乏训练能力,套上自己的壳,如 360用智谱AI

- 有点内涵:Minimax(商汤背景)、智谱AI(清华唐杰)、深圳鹏博(RWKV)、华为盘古

复现方案

假设

模型的知识和能力主要在预训练阶段学习,而对齐过程则是引导模型在推理过程中使用哪些先验分布

因此,尤为重要的是:

- 在数据集中放大好的先验知识并抑制不好的先验知识,以及驯服从互联网分布中直接捕获的原始模型

如何驯服LLM

【2023-6-2】参考

- 原文: Modern AI is Domestification

-

中文翻译:驯服大型语言模型(LLMs)的五种方法

- Prompting

- 通过精心设计的提示(prompt)引导一个基础模型朝着期望的先验方向进行

- 目前门槛最低的方法,有时也被成为无梯度调优。

- prompt利用了训练时看到的关联和先验信息

- 局限性:

- 机会主义策略,即提示策略高度依赖于原始训练数据集中出现的模式、相关性和先验信息。prompt需要在通用与具体之间平衡。

- prompt工程 受 训练数据分布中不理想数据相关性的影响,这被称为“Waluigi效应”,从而导致提示无法有效地放大先验。

- 监督微调(Supervised Finetuning,SFT),主要思路:

- 首先用在多样化数据集上预训练的原始模型

- 然后在规模较小但质量更高的数据集上进行进一步训练

- 数据集可以是原始数据集的子集,也可以是全新自定义数据集,可以人工创建验证,也可以用启发式、规则自动获取,也可以合成。

- 其中微调数据集充当包含所有最终模型所需属性的黄金标准。

- 这种简单性提出了一个有说服力的论点:「将目标数据集提供给原始模型,SFT承诺将原始模型靠近目标分布」。由于SFT是监督学习,如果数据好且模型庞大,成功是有保证的。

- RLHF: 不同于SFT的非参数方法, RLHF相反,通过参数化奖励模型明确先验知识,告诉模型偏好。

- 用 RL 的优势:直接的在线反馈(离线反馈过时)、次优数据上训练(提升鲁棒性)

- RLAIF

- RLHF的问题:存在噪音、不一致,收集成本高

- RLAIF:AI替换人工,一方面节省人力,另外还能充当裁判(奖励模型)

- 合成数据生成SDG:用 AI 模型辅助采集、标注

- 交互式辅助标注

- 生成模型合成数据:半监督、伪标签

这些方法如何选择?

- 原始训练语料库是否包含想要的所有能力和先验?如果是,请尝试提示;如果否,微调模型。

- 获取不同的微调数据集是否容易?如果是,请尝试 SFT; 如果否,请尝试 RLHF 或 AI 反馈。

- 可以访问大量计算吗?如果是,微调整个模型; 如果否,请使用 PEFT。

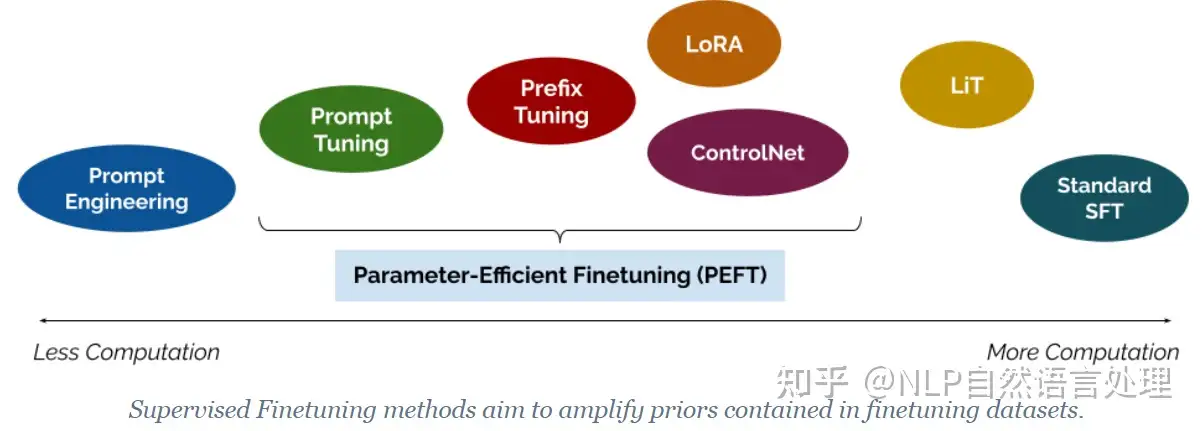

- 知乎图

现有的 AI 模型是否足以生成数据或验证数据?如果数据生成足够好,请尝试创建合成数据(SDG);如果足以验证但不能生成,请尝试使用 AI 反馈 (RLAIF) 或自我反思;如果两者都不是,请坚持使用 RLHF。

如何对基础模型进行微调?

有几种选择:按计算量从到小,分为: Prompt Engineering -> PEFT -> SFT

- 标准的SFT:对整个基础模型进行微调,更新整个网络的权重。这是可能引起底层模型行为显著变化的最详尽的更新类型。

- 轻微方式微调,只有网络某个子集可以进行微调;LiT在微调语言编码器的同时冻结了CLIP图像编码器。

- 参数高效微调(Parameter-Efficient Finetuning,

PEFT)是新方法,冻结了原始模型的大部,仅微调相对较小模型参数集。- PEFT: Prompt Tuning -> Prefix Tuning -> LoRA -> ControlNet

- 像LoRA这样的PEFT方法就是非常大的创新,使得消费者硬件就能够对相当大的基础模型进行微调。

- Prompt Engineering

显然,「SFT的实现方式正在迅速发展,并且在可预见的未来可能仍将是一个令人兴奋的领域」。无论具体的SFT方法如何,对底层微调数据集的组成和质量都有很大的依赖。在SFT中,扩大哪些先验条件和如何扩大它们同样重要。

【2023-2-1】复现方案(参考:chatGPT复刻方案)

- (1)复刻 GPT-3

- ① 开源GPT-3方案:

- 国内(阿里达摩院modelscope)

- 国外(eleuther/OPT/Bloom等)

- ② 服务器资源:主流设备NVIDIA A100和V100

- ③ 模型加速框架:

- 国际:LLMs普遍采用NVIDIA提供的Megatron-DeepSpeed组合方案

- 国内开源方案:如Colossal-AI以及悟道开放的FastMoE等

- ④ 训练语料

- 阿里达摩院:数据源wiki和commoncrawl

- 悟道开放200G的文本语料资源

- ⑤ Fine-Tune

- 没必要从头训练,资源+数据耗不起,网上开放的数据跟大厂真正训练用的数据不能比。

- ① 开源GPT-3方案:

- (2)复刻 InstructGPT:严格按照 论文三步来

- ① Fine-Tune:注意这里的finetune跟上面的finetune稍有不同,上面用作语言生成任务为目标,这个是对话任务为目标。

- ② RM:首先搭建暗物智能InstructGPT-RM对话标注平台,用于对gpt-3生成数据进行排序。其次收集更高质量的prompt,最后训练RM模型

- ③ PPO:用于优化gpt-3, 预计工作量比较大,开源代码 trl, 基于transformers库实现了PPO训练

- (3)指标评测

- 参考目前主流的评测方法,主要从一致性,相关性,信息性,吸引性,安全性等维度进行评测。

- 国外:InstructGPT论文里介绍的评测方法, 国内可参考PLATO,EVA,PANGU-BOT等。

- 指标评测非常重要,不能简单的对话几句就说这个模型好,那个模型不好,应当是全方位充分的评测。

huggingface 复现

开源界围绕RLHF做了不少工作,难以重现OpenAI的RLHF pipeline。原因:

- RL和RLHF有许多微妙的实现细节,这些细节对训练稳定性有很大影响;

- 对于指令遵循任务,如评估一个编码任务中生成的800行代码片段的质量,评估模型的表现不太行;

- 模型需要长时间的训练和迭代。

加之总结任务比一般的指令任务更容易评估,所以Hugging Face最新的这项工作选择退后一步,从OpenAI早期的RLHF工作中,探寻OpenAI的RLHF的真面目。

- 2020年 “Learning to summarize from human feedback”中,OpenAI研究员将RLHF应用到了捕捉原始文本主要信息和意图的摘要任务中

- 英文摘要任务上显著优于人类参考摘要和仅使用监督学习的更大模型。且具有较强的泛化能力,在没有特定领域微调的情况下,也能生成高质量的文章摘要,接近人类参考摘要的质量。

- 2022年“Training language models to follow instructions with human feedback”这项工作中,RLHF再次被使用,为指令遵循任务而专门设计的InstructGPT诞生

【2024-4-7】抱抱脸Open了OpenAI的秘密武器,网易参与复现

Hugging Face、加拿大蒙特利尔Mila研究所、网易伏羲AI Lab的研究人员从零开始复现了 OpenAI的 RLHF pipeline,罗列了25个关键实施细节。

最终成功展示了随着模型大小的增加,响应质量显著提升的scaling行为,其中2.8B、6.9B的Pythia模型在性能上超过了OpenAI发布的1.3B checkpoint。

Pythia 1.4B实验

- 根据 GPT-4的数据显示,这个1.4B模型非常接近OpenAI的1.3B性能(由于GPT4成本过高,只进行了一次评估)。

独特之处

- 对SFT、RM和PPO使用了单一的学习率,所以再重现他们的工作会变得更加简单。

从数据集到SFT、RM、OPP,共介绍了25个复现细节,深入分析了TL;DR数据集的规格、分词过程和分词长度分布。同时,详细描述了SFT和RM组件的训练设置、实施细节和结果。

- 步骤1:训练SFT(监督微调)策略

- 步骤2:收集偏好对并训练RM(奖励模型)

- 步骤3:针对RM训练RL(强化学习)策略

研究人员针从数据集到SFT、RM、OPP,共介绍了25个复现细节,深入分析了TL;DR数据集的规格、分词过程和分词长度分布。同时,详细描述了SFT和RM组件的训练设置、实施细节和结果。

数据预处理阶段:

- 对于RLHF的提示查询,OpenAI在最后一段进行截断,而不是硬截断限制;同时确保“TL;DR:”之后没有多余的空格。

- 始终在reference completions前加上前导空格,在reference completions后添加

<|endoftext|>,并使用单独的[PAD]token填充。 - SFT和偏好数据集的tokenization length不同,因此在SFT和RM训练期间分别设置最大token长度时需要注意。

- RM的验证集非常有趣,因为它包含更多独特的策略对进行比较,所以它有很多超出分布的数据。

SFT阶段:

- SFT阶段没有太多的实现细节,只需要标准的下一个token预测损失就可以了。除了使用了不同的学习率之外,研究人员的设置几乎与原始设置相同。

- 损失下降,ROUGE分数在4个随机种子和3个模型checkpoint大小上都有所提高。

RM训练:

- RM训练更有趣。例如,研究人员发现RM只在EOS token处提取奖励。此外,在检查奖励的logits时,除了EOS token外,几乎所有的logits都是负数。

- 结果非常不错,验证准确率提高了,RM几乎完美地转移到了偏好数据集验证集中的CNN/DM子集上。

- 他们计算了SFT demonstration的平均奖励——标量值看起来有些随意;还计算了OpenAI偏好数据集中每个批号和置信度的验证准确率。

- 注意: 不同的批次/置信度可能会有截然不同的准确率。

- 研究人员也测量了RM与GPT3.5和RM的一致性率(agreement rate),并发现一致性率有所提高,但在6.9B级别时有所减弱。并绘制了AnthropicAI所做的RM校准,发现RM通常校准不足。

研究人员将验证准确率与DPO的隐式RM进行了比较,发现出于某种原因DPO的验证准确率较低。

几个不同点:

- RM训练只在EOS token处应用损失,而DPO在每个完成token处应用损失。

- DPO还有一个可能影响训练的$beta参数,RM则没有。

- 研究员Michael Noukhovitch提出了个有说服力的观点:DPO的目标可能更难优化,因为你需要使你的logprobs与基本模型有足够大的不同才能更改奖励,而RM可以学习一个线性头,可以更容易/更快地改变奖励的值。

PPO训练:

- 学习值函数的行为与RM截然不同。例如,值函数logits通常更为正,因为在每个时间步长,它都试图对最终分数进行建模。

- PPO也使用了EOS技巧。在PPO训练中,研究人员通常采样固定数量的token,比如48个。如果完成不以EOS token结束怎么办?前面已经提到了,非EOS token的logits几乎总是负的(并且可能无效)。

- EOS技巧基本上用恒定的-1奖励取代了不以EOS token结尾的完成的奖励。有几个目的:① 定义奖励得分 ② 约束补全长度

研究人员还尝试了PPO的奖励白化处理,并发现这样使得与参考摘要的胜率略有降低,以及完成token的长度略微缩短。

- 长度在这里是一个混杂因素,所以研究人员引导了OpenAI进行的长度控制分析,通过将x轴设置为模型摘要长度与参考摘要长度之比的对数来执行。

- 当长度得到控制时,研究人员发现比较奖励白化的结果更具挑战性,但尽管如此,在每个摘要长度上,PPO模型几乎总是优于SFT模型。

- PPO 的训练曲线如下所示。值得注意的是,几个1B型号的KL值爆炸了。从优化的角度来看,这并没有什么问题,因为RLHF奖励一直在上升,这些1B模型对应于“奖励黑客”/过度优化的模型。

为了更好地理解模型的行为,研究人员还可视化突出显示了经过微调的模型在生成文本时总会以一个EOS token结束。为了进一步探索这一点,原论文附录部分提供了更多类似的可视化效果。

复现难点

【2023-2-20】追赶ChatGPT的难点与平替 以后各个NLP子任务可能就统一起来了,范式也会变成预训练+Prompt,不需要那么多精调模型的算法了。

复现ChatGPT的难点与平替方案:

- (1)高效的算法框架:

Megatron-LM和DeepSpeed已经把模型提到了一个我们不敢想的尺寸(普通算法团队人均2张V100就很幸福了),结果20年中OpenAI一下发布了175B的GPT-3。从那时起,OpenAI算法框架的容量就领先了一到两个数量级。- 最近已经出了一个平替方案

ColossalAI,由国人打造,从一些介绍来看效率是超过Megatron-LM和DeepSpeed的,而且已经做了ChatGPT的部分实现(还不支持PPO-ptx),接下来就看大家使用的效果了

- (2)先追上GPT 3:符尧对大模型能力的研究看来,至少要62B以上的模型才能有一定少样本效果。

- 真的追上这些能力需要耗费很大财力、人力和时间,估计现在各个厂都在批发A100了,起码千张,预算上亿。

- 一些平替方案,支持中文的有

mT5(176B)、GLM(130B)和BLOOM(176B),但其中只有BLOOM是GPT架构。 mT0和BLOOMZ,是Instruction tuning后的版本。- 微调的BLOOMZ模型维持了与BLOOM模型相同架构超参数,176b,参考:【大模型】BLOOM:一个176B参数且可开放获取的多语言模型

- (3)获取真实的用户输入

- 从GPT3到ChatGPT,主要是基于用户真实输入进行标注,再对模型进行精调,从而拟合了人的偏好(称为Alignment)

- 技术问题都有平替,但去哪儿找上亿的用户来源源不断的输送Prompt呢?

- 第一个平替方案:借鉴Instruction tuning的论文,用各种NLP数据集构造Prompt。要做通用模型,最好还是符合用户的分布

- (4)趟过精调的坑

- OpenAI将精调分了两个步骤:

有监督精调(SFT,step1)、强化学习训练(RLHF,step2+3). ChatGPT精调重点在于RLHF阶段。

- OpenAI将精调分了两个步骤:

把训模型当作带孩子:

Pretrain:在孩子0-3岁的时候,我们没法讲太多道理,他也听不懂,更多的是让他自己观察这个世界,自由学习。Instruction Tuning:孩子学会说话了,也对世界有了基本认知,我们就可以开始通过示范教他一些东西,比如怎么穿衣服、怎么刷牙。RLHF:等孩子再大点,很多事情都会了,便不会再完全模仿父母,而是有自己不一样的行为,这时候父母就需要对这些不可预料的行为给出反馈,在他取得好成绩时奖励,在做坏事后惩罚。

生成任务本身, 长久以来NLP里的范式都是以最大似然为目标,用teacher forcing的方式拟合标注同学写出的句子。那万一标注同学偷懒呢?

- 对于「到底什么是好的回复」这个问题,每个人都有不同的答案,但必须定义好目标,才知道模型应该往哪里优化。

- 谷歌训

LaMDA对话模型时就给出了5个维度的定义,再朝着这5个方向拟合,而人类语言博大精深,5个维度真能评价一段话的好坏吗?

RLHF范式的关键就在于它能真正让模型去拟合人的偏好,同时给予模型一定的自由度,这样才能让模型先模仿再超越,而不是重复Instruction tuning中的一些pattern。

OpenAI官方给的实验数据:

- 在摘要生成任务中,RLHF精调后的模型大幅超越SFT的效果。

- 另外论文中的其他实验也证实了RLHF模型具备更好的跨领域泛化能力:在InstructGPT论文中,1.3B经过RLHF的模型可以超过175B模型SFT的效果

在人力、算力、时间有限的情况下,效率最优的路径:

- 直接在1.3B模型上迭代,大概10万标注数据,复现一个低配小型ChatGPT,验证整个流程的有效性,再去做175B的模型。

- 如果每个方案都打个折,确实是复现到60%的程度,和业内乐观的预测一样。

GPT-3 国内复制

【2023-2-28】没有这些,别妄谈做ChatGPT了

算法可能只是硬币的一面,另一面是算力和云基础设施,不容忽视。

- 【2023-2-28】国内真正复刻了GPT-3的,有且只有一家,

阿里达摩院,从小到大(从base到175B),全面、完整地复刻了GPT-3,并且开放在魔搭社区上。 - 2021年4月就发布了首个中文语言大模型

PLUG(当时参数是270亿)。该模型首次在中文语言理解榜单CLUE上面,以86.685分的成绩超越人类。 - 2021年10月,达摩院还探索实现了10万亿参数模型——

M6,达摩院团队通过大量的底层优化和算法设计,仅仅使用了512卡便实现了这一庞大的模型工程。此前,M6模型将AI图片生成清晰度从OpenAI DALL·E的256×256成功提升到了1024×1024,效果十分惊艳。 M6模型的发布引发了国内外的大量关注,其中,OpenAI前政策主管Jack Clark公开点评:“这个模型的规模和设计都非常惊人。这看起来像是众多中国的AI研究组织逐渐发展壮大的一种表现。”

ChatGPT之争已经超出了算法的范畴,它更是一个AI+云计算能力的全方位竞争,是技术生态层面的竞争。 既需要强大的云基础设施能力的保障,又需要深厚的大模型技术积淀,两者缺一不可。

云基础设施

- OpenAI的解决方式是向微软求助。同理,国内初创企业想要成为中国版OpenAI,自研ChatGPT,恐怕也要先跟几个云计算厂商好好聊一聊了。

没有做过大模型训练的人,可能会误以为多买几张A100卡就可以了。

实操时就会发现:

- 单机多卡根本训不动千亿参数模型,你需要多机多卡分布式训练

- 当你开始多机训练时,你发现A100的算力都被网络通信延迟给吃掉了,多机可能还没有你单机训的快

- 然后你会发现训练ChatGPT的海量数据存储也是个问题,就算存下来了,数据读取的IO效率又极大的制约了模型的训练效率

- 一通基础设施问题下来,A100的算力被浪费了7、8成,模型训练实验无法开展

因此,没有一个面向AI高度优化的云计算平台,训练GPT-3和ChatGPT这种级别的模型怪兽是相当不现实的。

- 重点: “面向AI”+“高度优化”。

- 网络、存储、计算、通信等方方面面的系统化工程能力

给你一万张A100,就能把ChatGPT训出来吗?答案无疑是否定的。万卡集群对于网络、存储和通信有极高的要求,弄得不好直接宕机。

- 数据层面,飞天智算平台的单集群算力峰值高达12EFLOPS,千卡并行效率达90%。针对ChatGPT这类数据密集型场景,还对大规模集群进行了大量数据IO优化,通过自研KSpeed和RDMA高速网络架构,最高可将存储IO性能提升10倍,将时延显著降低了90%。

- 此外,阿里云自研的高性能集合通信库ACCL和自研的网络交换机等,对万卡规模的AI集群提供了无拥塞、高性能的集群通讯能力。

除了底层硬件的AI集群,大模型训练非常依赖于软件平台层。

- 飞天智算平台的机器学习平台PAI,专门针对AI大模型推理和训练场景进行针对性优化,可将计算资源利用率提高3倍以上,AI训练效率提升11倍,推理效率提升6倍,覆盖了全链路的AI开发工具与大数据服务。

GPT-3 复制失败

【2023-2-16】GPT公开复制为什么失败,我们应该如何使用GPT-3.5/ChatGPT

“失败”定义为与原始GPT-3论文中报告的性能不匹配,型号尺寸相似甚至更大。

-

根据这一标准,

GPT-3和PaLM(540B)是成功的,但这两个模型都不是公开的,而所有公共模型(例如OPT-175B和BLOOM-176B)在某种程度上是“失败”。 -

但是,仍然可以从这样的“失败”中吸取许多教训。请注意,如果多次尝试不同的设置,公共社区最终可能会复制GPT-3。但到目前为止,费用仍然太高,无法训练另一个版本的OPT-175B。因为训练这样一个大型型号的一次通行证需要在 ~1000 80G A100 GPU上运行至少2个月。

尽管一些文章(例如 OPT-175B 和 GLM-130B)声称在一些任务上能够匹配甚至超过原始的 GPT-3 的表现,在更多 GPT-3 已经测试过的任务上,这种声明仍然是存疑的。

- 根据大多数使用者在更多样的任务上的经验,以及 HELM 的评估来看,最近的 OpenAI GPT-3 的 API 表现也仍然比这些开源模型更好。

尽管背后的模型可能使用了指令微调(instruction tuning, 正如 InstructGPT 那样),类似的使用了指令微调的 OPT 版本(OPT-IML)和 BLOOM 版本(BLOOMZ)也仍然远比 InstructGPT 和 FLAN-PaLM(PaLM 的指令微调版本)要差得多。

多个可能的原因导致了相比 GPT-3 和 PaLM 的成功,OPT-175B 和 BLOOM-176B 的失败。两个部分:预训练数据和训练策略。

- (1) 预训练数据

- GPT-3 在共计 300B 的 token 上进行训练,其中 60% 来自经过筛选的 Common Crawl,其它则来自:webtext2(用于训练 GPT-2 的语料库),Books1,Books2 和维基百科。

- 更新版本的 GPT-3 还用了代码数据集进行训练(例如 Github Code)。每个部分的占比并不与与原始数据集的大小成比例,相反的,具有更高质量的数据集被更加频繁地采样。

- 导致 OPT-175B 和 BLOOM-176B 失败的,可能是以下三个难点,它们使得开源社区难以收集到类似的数据:

- 缺乏筛选低质量数据的分类器:构建 GPT-3 和 PaLM 的预训练数据集,但在 OPT 和 BLOOM 的训练中却没有被采用。用更少但质量更高的数据集训练的预训练模型,可以在性能上超过另一个用更多的混合质量数据集训练的模型。数据多样性和质量

- 预训练数据集的去重:去重有助于避免预训练模型多次面对相同的数据后记住它们或者在其上过拟合,因此有助于提高模型的泛化能力。GPT-3 和 PaLM 采用了文档级别的去重,这同样被 OPT 所采用。但 OPT 预训练的去重 Pile 语料库中仍有许多重复存在,这也可能导致它较差的性能(注:在一些最近的文献中显示去重对于预训练语言模型的重要性可能没有想象中大)。

- 预训练数据集的多样性:包括领域多样性、格式多样性(例如:文本、代码和表格)和语言多样性。OPT-175B 所使用的 Pile 语料库声称有着更好的多样性,但 BLOOM 采用的 ROOTS 语料库则有太多的已经存在的学术数据集,缺乏 Common Crawl 数据所包含的多样性。这可能导致 BLOOM 性能更差。作为对比,GPT3 来自 Common Crawl 语料的占比则要高得多,而它们是多样的和来自广泛领域的,这也可能是 GPT-3 能够作为首个通用聊天机器人 ChatGPT 的基础模型的原因之一。

- BLOOM 和 PaLM 在多语言数据上有更高的占比,这导致它们在一些多语言任务和机器翻译任务上的性能更高。

- OPT 使用了很多对话数据(例如 reddit),这可能是它在对话中表现好的原因之一。

- PaLM 有很大的占比在社交媒体对话中,这可能是它在多种问答任务和数据集上有着卓越表现的原因。

- PaLM 和更新版本的 GPT-3 有很大比例的代码数据集,这增强了它们在代码任务上的能力,以及可能增强了

CoT(Chain-of-Thought,思维链) 的能力。 - BLOOM 在代码和 CoT 上的表现仍然是较差的,尽管它在预训练过程中使用了代码数据。这可能暗示着单独代码数据本身,并不能保证模型的代码和 CoT 能力。

- 上面三点的重要性:通过数据去重避免记忆和过拟合,通过数据筛选以得到高质量数据,保证数据多样性以确保 LLM 的泛化性。但不幸的是,对于 PaLM 和 GPT-3 预处理这些数据的细节,或者这些预训练数据本身,仍然没有公布,这使得公共社区很难去复现它们。

- (2) 训练策略: 包括训练框架、训练持续时间、模型架构 / 训练设置、训练过程中的修改。在训练非常大的模型时,被用于获得更好的稳定性和收敛性。

- 由于未知的原因,预训练过程中广泛观察到

损失尖峰(loss spike)和无法收敛的情况。因此,众多对训练设置和模型架构的修改被提出,用以避免这些问题。但是其中一些修改在OPT和BLOOM之中还不是最优解,这可能导致它们的性能较差。GPT-3 并没有明确提到他们是如何解决这个问题的。

- 由于未知的原因,预训练过程中广泛观察到

- 训练框架。一个参数量大于 175B 的模型往往需要 ZeRO 式的数据并行(分布式的优化器)和模型并行(包括张量并行(tensor parallel)、流水线并行(pipeline parallel),有时还包括序列并行(sequence parallel))。

OPT采用了 ZeRO 的 FSDP 实现,以及模型并行的 Megatron-LM 实现。BLOOM采用了 ZeRO 的 Deepspeed 实现和模型并行的 Megatron-LM 实现。PaLM采用了 Pathways,这是一个基于 TPU 的模型并行和数据并行系统。- GPT-3 的训练系统的细节仍然未知,但它们至少在一定程度上使用了模型并行(一些人称它使用了 Ray)。不同的训练系统和硬件可能导致不同的训练时的现象。显然,一些在 PaLM 的文章中呈现的、用于 TPU 训练的设置,可能并不适用于其它所有模型使用的 GPU 训练。

- 硬件和训练框架的一个重要的影响是,人们是否可以使用 bfloat16 去存储模型权重和中间层激活值等。这已经被证明是稳定训练的一个重要因素,因为 bfloat16 可以表示更大范围的浮点数,能够处理在损失尖峰时出现的大数值。在 TPU 上 bfloat16 是默认设置,这可能是 PaLM 能够成功的一个秘密。但是在 GPU 上,以前人们主要使用 float16,这是 V100 中混合精度训练的唯一选择。

OPT使用了 float16,这可能是其不稳定的因素之一。BLOOM 发现了这样的问题并最终在 A100GPU 上使用了 bfloat16,但它没有意识到这种设置的重要性,因此在第一个词向量层后引入额外的层归一化(layer normalization),用于解决他们使用 float16 的初步实验中的不稳定性。然而,这种层归一化已被证明会导致更糟糕的零样本泛化(zero-shot generalization),这可能是 BLOOM 失败的一个因素。

- 训练过程中的修改。OPT 做了很多中途调整并从最近的 checkpoint 重启训练,包括改变

截断梯度范数(clip gradient norm) 和学习率,切换到简单的 SGD 优化器然后回到 Adam,重置动态损失标量(dynamic loss scalar),切换到更新版本的 Megatron 等等。- 这种中途调整可能是 OPT 失败的原因之一。相比之下,PaLM 几乎没有做任何中途调整。它只是当损失尖峰出现时,从尖峰开始前大约 100 步的 checkpoint 重新开始训练,并跳过了大约 200-500 个 batch 的数据。仅仅依靠这种简单的重启,PaLM 就取得神奇的成功。这是由于它在预训练数据构建期间就已经完成采样,因此模型具有在 Bit 意义上的确定性,以及它对模型架构和训练设置进行了许多修改以获得更好的稳定性。PaLM 中的此类修改在下一点中展示。

- 模型架构 / 训练设置:为了使训练更稳定,PaLM 对模型架构和训练设置进行了多项调整,包括使用 Adafactor 的修改版本作为优化器,缩放在 softmax 之前的输出 logit,使用辅助损失来鼓励 softmax 归一化器接近 0,对词向量和其他层权重使用不同的初始化,在前馈层和层归一化中不使用偏差项,并且在预训练期间不使用 dropout。

- 注意,GLM-130B 中还有更多有价值的内容关于如何稳定地训练非常大的模型,例如:使用基于 DeepNorm 的后置层归一化而不是前置层归一化,以及词向量层梯度收缩。以上大多数模型修改没有被 OPT 和 BLOOM 采用,这可能会导致它们的不稳定和失败。

- 训练过程:如下表所示,原始的 GPT-3 预训练过程见过的 token 数与 OPT 和 BLOOM 接近,而 PaLM 则远远超过了它们。同样,PaLM 和 GPT-3 预训练语料库都大于 BLOOM 和 OPT。因此,在更多的 token 上、用更大规模的高质量语料库进行预训练可能是 GPT-3 和 PaLM 成功的一个重要因素。

除了上面列出的四点,还有一些其它因素,它们可能对于更稳定的训练并不重要,但仍然可能影响最终的性能。

- 第一点,PaLM 和 GPT-3 都使用了在训练过程中从小到大逐渐增加的 batch size,这已经被展示对于训练一个更好的 LLM 是有效的,然而 OPT 和 BLOOM 都使用了恒定的 batch size。

- 第二点,OPT 使用了 ReLU 激活函数,而 PaLM 使用 SwiGLU 激活函数,GPT-3 和 BLOOM 使用 GeLU,它通常使得训练的 LLM 的性能更好。

- 第三点,为了更好的建模更长的序列,PaLM 使用 RoPE 词向量,BLOOM 使用 ALiBi 词向量,而原始的 GPT-3 和 OPT 使用学习得到的词向量,这可能影响在长序列上的性能。

在哪些任务和应用上使用 GPT-3?

理想情形下,如果微调 GPT-3 的负担是能够承担的,它可能带来更进一步的提升。然而,在一些任务上通过微调 PaLM-540B 带来的提升是如此有限,让人们怀疑在一些任务中微调 GPT-3 是否是值得的。从科学的角度来看,更公平的比较应在微调 GPT-3 和提示 GPT-3 之间进行。然而,要使用 GPT-3,人们可能更关心将提示 GPT-3 和微调一个更小的模型去进行对比。

适合使用提示 GPT-3

- 创造性和复杂的任务:包括代码(代码补全、自然语言指令生成代码、代码翻译、bug 修复)、文本摘要、翻译、创造性写作(例如写故事、文章、邮件、报告,以及写作的改进等)。正如原始的 GPT-3 文献中所示,GPT-3 被设计用于那些困难和 “不可能标注” 的任务。在一定程度上,对于这些任务,先前那种经过微调的模型不可能应用于真实世界的应用;而 GPT-3 使它们成为可能。举个例子,最近的文章显示,过去的人类标注的文本摘要已经被 LLM 生成的摘要所超越。

- 在某些需要从低、中资源语言翻译到英语的机器翻译任务中,通过提示 PaLM-540B,它甚至能够超越微调模型。

- 在 BLOOM-176B 中也观察到了类似的趋势。这是因为英语数据通常在预训练语料库中占了很大比例,因此 LLM 擅长于生成英语语句。注意到,为了在代码任务中获得良好性能,尽管 Codex 和 PaLM 已经在整体上具有比之前模型更好的性能,我们仍然需允许 LLM 多次(k 次)采样,以通过测试样例(使用 pass@k 作为度量)。

- 只有少数标注或者没有标注数据的任务。正如原始的 GPT-3 文献所说,GPT-3 是为了那些 “昂贵标注” 的任务设计的。在这种情况下,用极少量标注数据微调一个更小的模型通常不可能达到 GPT-3 在零样本(zero-shot)、单样本(ont-shot)或少样本(few-shot)的情况下的表现。

- 分布外(Out-of-distribution, OOD)泛化。给定一些训练数据,传统的微调可能会过拟合训练集并且有较差的分布外泛化能力;而少样本的上下文学习(in-context learning)能够有更好的分布外泛化性。例如,带有提示的 PaLM 能够在对抗自然语言推断任务(Adversarial Natural Language Inference,ANLI)上超越经过微调的 SOTA 模型,而它在正常的语言推断任务上可能仍然劣于微调的 SOTA。

- 另一个例子是提示 LLM 比微调模型显示出更好的组合泛化能力。更好的分布外泛化性可能是因为在上下文学习期间不需要更新参数,避免了过拟合;或者因为那些过去的分布外样例对于 LLM 而言是分布内的。这种使用场景被阐释为 GPT-3 的初始设计目标之一:“微调模型在特定任务的数据集上的性能可以达到所谓的人类水平,实际上可能夸大了在真实世界中该任务上的性能,这是因为模型只是学到了训练集中存在的虚假的相关性,以及模型过度拟合了这个训练集狭窄的分布。”

- 需要处理多种任务的能力,而非关注特定任务上的卓越表现。聊天机器人就是这样一种场景,其中,用户期待它能够正确地响应各种各样的任务。这可能就是为什么 ChatGPT 是 GPT-3 最成功的使用场景之一。

- 那些检索不可行的知识密集型任务。存储在 LLM 中的知识可以显著地提高在知识密集型任务的性能,例如闭卷问答和 MMLU(一个基准数据集,包括来自于 STEM、人文、社科等 57 个学科的选择题,它用于测试 LLM 的世界知识和问题解答的能力)。然而,如果预先检索的步骤可以被加入来做检索增强的生成,一个微调的更小的模型(例如 Atlas 模型)甚至可以有更好的性能(在闭卷的 NaturalQuestions 和 TrivialQA 数据集上,Atlas 比 PaLM 和最新的 InstructGPT 都要更好)。

- 检索或者传统的搜索同样是将 GPT-3 或 ChatGPT 整合到搜索引擎中的一个必要的步骤,这可以提升生成的准确性,并且提供更多的参考链接以增强说服力。但我们应该承认,在某些情况下,检索是不允许或者不容易的,比如参加 USMLE (美国医学执照考试),谷歌已经证明基于 FLAN-PaLM 的模型可以在其中做得很好。

- 同样的,在 MMLU 基准集中,PaLM-540B 有着比其他微调模型更好的性能,甚至后者结合了检索,尽管最新版本的 InstructGPT 还差于这些带有检索的微调 SOTA。也请注意,指令调整一个较小的模型也可以实现与更大规模的 LLM 模型接近的效果,这已经在 FLAN-T5 中展现。

- 一些困难的任务,其中需要 LLM 的涌现能力,比如带有 CoT 的推理和 BIG-Bench 中的复杂任务(包括逻辑推理、翻译、问答、数学任务等)。举个例子,PaLM 已经展示,在 7 个包括数学和常识推理的多步推理任务上,8 - 样例的 CoT 比微调 SOTA 在其中 4 个任务上更好,在其它 3 个任务上则基本持平。

- 这样的成功表现要同时归因于更大规模的模型和 CoT。PaLM 还显示了在 BIG-Bench 任务上从 8B 到 62B 再到 540B 模型的不连续的表现提升,这超出了规模定律(scailing law),被称为 LLMs 的涌现能力。另外,带有 5 个 Prompt 的 PaLM-540B 在 Big-Bench 的 58 项常见任务中的 44 项上优于之前的(少样本)SOTA。PaLM-540B 在 Big-Bench 的总体表现也优于人类的平均表现。

- 一些需要模仿人类的场景,或者是其目标是制作性能达到人类水平的通用人工智能。同样的,ChatGPT 是其中的一个案例,ChatGPT 使自己更像是一个人,从而取得了现象级的成功。这也被阐释为 GPT-3 的初始设计目标之一:“人类不需要大规模监督数据集来学习大多数语言任务。最多只需要几个例子,人类就可以将各种任务和技巧无缝地混合在一起或者在它们之间切换。因此传统的微调模型导致了与人类的不公平比较,尽管他们声称在许多基准数据集中有着人类水平的性能。”

- 在一些传统的接近于语言建模的 NLP 任务上,少样本 PaLM-540B 能够大致匹配或者甚至超过微调的 SOTA,例如:一段话最后一句和最后一个单词的完型填空,以及回指(anaphora)解析。需要指出,在这种情况下,零样本的 LLM 已经足够了,单样本或少样本的示例则通常帮助不大。

另一些任务则并不需要提示(prompt)一个 GPT-3 这样规模的模型:

不适合使用GPT-3的任务

- 调用 OpenAI GPT-3 的 API 超出了预算(例如对于没有太多钱的创业公司)。

- 调用 OpenAI GPT-3 的 API 存在安全问题(例如数据泄露给 OpenAI,或者可能生成的有害内容)。

- 没有足够的工程或者硬件资源去部署一个相似大小的模型及消除推断的延迟问题。例如,在没有最先进的 80G 的 A100 或者工程资源来优化推断速度的情况下,简单地使用 Alpa 在 16 个 40G 的 A100 上部署 OPT-175B 需要 10 秒才能完成单个样例的推断,这对于大多数现实世界的在线应用程序来说是无法接受的延迟。

- 如果想用 GPT-3 替代一个性能良好的、高准确度的微调模型,或者想要在一些特定的单一任务和使用场景下去部署一个 NLU(Natural Language Understanding,自然语言理解)或 NLG(Natural Language Generating,自然语言生成)模型,请三思这是否值得。

对于一些传统的 NLU 任务,比如分类任务,我建议首先尝试微调 FLAN-T5-11B 模型,而不是提示 GPT-3。例如,在 SuperGLUE,一个困难的 NLU 基准数据集(包括阅读理解、文本蕴含、词义消歧、共指消解和因果推理等任务)上,所有的 PaLM-540B 的少样本提示性能都劣于微调的 T5-11B,并在其中大多数任务上有着显著的差距。如果使用原始 GPT3,其提示结果与微调 SOTA 的结果之间的差距更大。有趣的是,即使是经过微调的 PaLM 也仅比经过微调的 T5-11B 有着有限的改进,而经过微调的 PaLM 甚至比经过微调的编 - 解码器模型 32B MoE 模型还要差。这表明使用更合适的架构(例如编 - 解码器模型)微调较小的模型仍然是比使用非常大的仅解码器模型更好的解决方案,无论是微调还是提示来使用这些大模型。根据最近的一篇论文,即使对于最传统的 NLU 分类任务 —— 情感分析,ChatGPT 仍然比经过微调的较小模型差。

一些不以现实世界数据为基础的困难任务。例如,BigBench 中仍然有许多对 LLM 来说困难的任务。具体地说,在 35% 的 BigBench 任务上,人类的平均表现仍然高于 PaLM-540B,并且在某些任务中,扩大模型规模甚至无济于事,例如导航和数学归纳。在数学归纳中,当提示中的假设不正确时(例如 “2 是奇数”),PaLM 会犯很多错误。在逆规模定律竞赛 (Inverse Scaling Law Challenge) 中,也观察到了类似的趋势,例如重新定义数学符号(例如提示可能 “将 π 重新定义为 462”)后再使用这个符号。在这种情况下,LLM 中的现实世界先验知识太强而无法被提示覆盖,而微调较小的模型可能可以更好地学习这些反事实知识。

在很多多语言任务和机器翻译任务中,使用少样本的提示 GPT 仍然要比微调的更小的模型更差。这很可能是由于除英语之外的其它语言在预训练语料库中占比很少。

当从英语翻译为其他语言,以及翻译高资源语言到英语时,PaLM 和 ChatGPT 仍然比在机器翻译任务上微调的更小的模型要差。

- 对于多语言问答任务来说,在少样本的 PaLM-540B 和微调的更小模型之间还存在较大差距。

- 对于多语言文本生成(包括文本摘要和数据到文本生成),在少样本的 PaLM-540B 和微调的更小模型之间还存在较大差距。在大部分任务上即使微调的 PaLM-540B 也仅仅比微调的 T5-11B 有有限的提升,并仍然劣于微调的 SOTA。

- 对于常识推理任务,在最好的少样本提示 LLM 和微调的 SOTA 之间仍然存在着较大的差距,例如:OpenbookQA,ARC(包括 Easy 和 Challenge 版本)以及 CommonsenseQA(甚至使用了 CoT 提示)。

- 对于机器阅读理解任务,在最好的少样本提示 LLM 和微调的 SOTA 之间仍然存在着较大的差距。在大多数数据集上,这个差距可能非常巨大。这可能是因为所有回答问题所需的知识都已经包含在给出的文本中,并不需要 LLM 中的额外知识。

总结一下,上面的这些任务可以被归为以下类别之一:

- 一些 NLU 任务,既不需要额外的知识也不需要 LLM 的生成能力。这意味着测试数据大多数都和手头的训练数据在同一个分布之中。在这些任务上,过去微调的较小模型已经表现很好了。

- 一些不需要额外的来自 LLM 中知识的任务,因为每一个例子已经在上下文或者提示中包含了足够的知识,例如机器阅读理解。

- 一些需要额外知识,但不太可能从 LLM 中获得这样的知识,或者 LLM 不太可能见过类似分布的任务,例如一些低资源语言中的任务,LLM 在这些语言中只有有限的预训练样本。

- 一些任务,需要与 LLM 中包含的知识所不一致的知识,或者并非基于现实世界的语言数据的知识。因为 LLM 是在现实世界的语言数据上训练的,它难以在新的任务中利用反事实知识覆盖原有知识。除了在逆规模定律挑战中的 “重新定义数学符号” 问题之外,还有另一个任务,即复述有细微改动的名言,其中 LLM 被要求复述一个在 prompt 中出现的被修改的名言。在这种情况下,LLM 倾向于重复出名言的原始版本,而非修改过后的版本。

- 一些任务需要来自 LM 的知识,但也严重依赖于操纵这些知识,而 LLM 的 “预测下一个 token” 的目标无法轻易实现这种操纵。一个例子是一些常识推理任务。CoT 和 least-to-most 提示可以帮助 LLM 推理的原因可能是他们可以更好地调出那些连续的预训练文本,这些连续文本恰好模仿了规划和分解 / 组合知识的过程。

- 因此,CoT 和 least-to-most 提示在一些数学推理、代码和其他简单的自然语言推理任务中表现良好,但在许多常识推理(例如在逆规模定律竞赛中展示的演绎推理任务)和自定义符号推理任务中仍然表现不佳。这些任务通常不被自然语言数据中的大多数真实世界的连续序列所包含,而需要操纵分散在各处的知识来完成。

- 一些容易受到上下文学习样例或者真实世界数据中存在的虚假相关性影响的任务。一个例子是来自于逆规模定律竞赛中的涉及否定词的问答。如果一个 LLM 被提问:“如果一只猫的体温低于平均水平,它就不在……”,它倾向于回答 “危险之中” 而非 “安全范围 “。这是因为 LLM 受到常见的 “低于平均体温” 和 “危险” 之间的关系所支配,而在否定的情况下,这是一种虚假的相关性。

- 一些目标与处理语言数据显著不同的任务,例如:回归问题,其中微调模型很难被 LLM 取代。至于多模态任务,它们不能被 LLM 解决,但是可能能从大规模的预训练多模态模型中受益。

- 一些任务不需要 LLM 的涌现能力。为了准确地对更多此类任务进行鉴别,我们需要更好地了解 LLM 训练期间,涌现能力是从何产生的。

注意到,在现实世界的使用场景中,即使由于无法满足延迟要求因而无法在线地使用 LLM,仍然可以使用 LLM 离线生成或标注数据。此类自动标注的标签可以在线查找并提供给用户,或用于微调较小的模型。使用此类数据微调较小的模型可以减少训练模型所需的人工注释数据,并将 LLM 的一些新兴能力(例如 CoT)注入较小的模型。

总之,当有足够的标记数据时,考虑到开源 FLAN-T5 在许多任务中的惊人性能,我推荐那些调用 OpenAI API 的资源有限的个体,应该首先尝试在目标任务上微调 FLAN-T5-11B。此外,根据最近在 MMLU 数据集上,FLAN-PaLM-540B 与最新版本的 InstructGPT 的性能(根据 HELM)相比好得惊人的性能,谷歌可能拥有比 OpenAI 更强大的基础模型,如果 OpenAI 已经通过 API 发布了他们获得的最强的 LLM。

谷歌唯一剩下的步骤是通过人类反馈使这个 LLM 与对话场景对齐(alignment)。如果他们很快发布类似 ChatGPT 的或者更好的聊天机器人,我不会感到惊讶 —— 尽管他们最近 “失败” 地展示了一版可能基于 LaMDA 的 Bard。

LLM

大模型越烧越旺

- 3月13日,斯坦福发布LLaMA模型改进版

- 3月14日,清华发布ChatGLM-6B模型

- 3月14日,OpenAI发布GPT4模型

- 3月14日,谷歌给出PaLM API

- 3月15日,PyTorch2.0发布

- 3月16日,微软发布Microsoft 365 Copilot

- 3月16日,百度发布文心一言

- 3月22日,谷歌发布BARD内测

详情见站内专题:大模型沉思录

资讯总结

【2023-6-13】LLM 里程碑论文及各大模型信息, pretrain、instruct、对齐、开源模型等维度汇总LLM

【2023-6-10】DAIR.AI,每周热门论文

LLM CheatSheet, 含 ppt、pdf和png格式

【2023-4-4】GPT fine-tune实战:训练我自己的 ChatGPT

- Stanford 基于 LLaMA 的 Alpaca 和随后出现的 LoRA 版本 Alpaca-LoRA。原因很简单,便宜。

- Alpaca 宣称只需要 600$ 不到的成本(包括创建数据集),便可以让 LLaMA 7B 达到近似 text-davinci-003 的效果。而 Alpaca-LoRA 则在此基础上,让我们能够以一块消费级显卡,在几小时内完成 7B 模型的 fine-turning。

- fine-tune 7B 模型仅需要 8-10 GB vram。

基座大模型

LLMs 进化史

【2023-6-9】大模型进化史

- 论文:A Survey of Large Language Models

- 2019 年以来出现的各种大语言模型(百亿参数以上)时间轴,其中标黄的大模型已开源。

- 详见站内专题:大语言模型演变

【2023-6-21】LLMsPracticalGuide

- 论文解读:一文带你理清全球AI巨头的大模型进化史

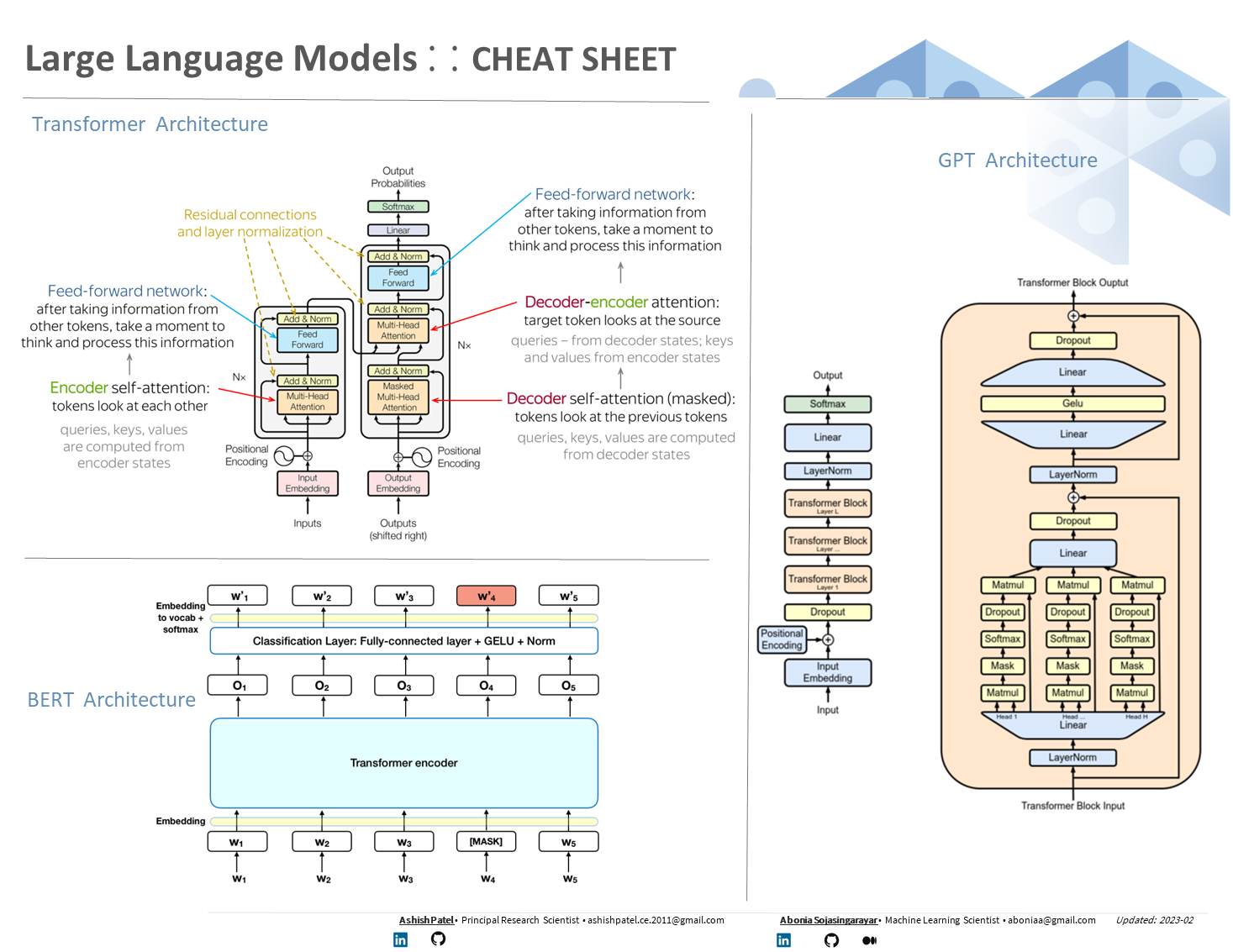

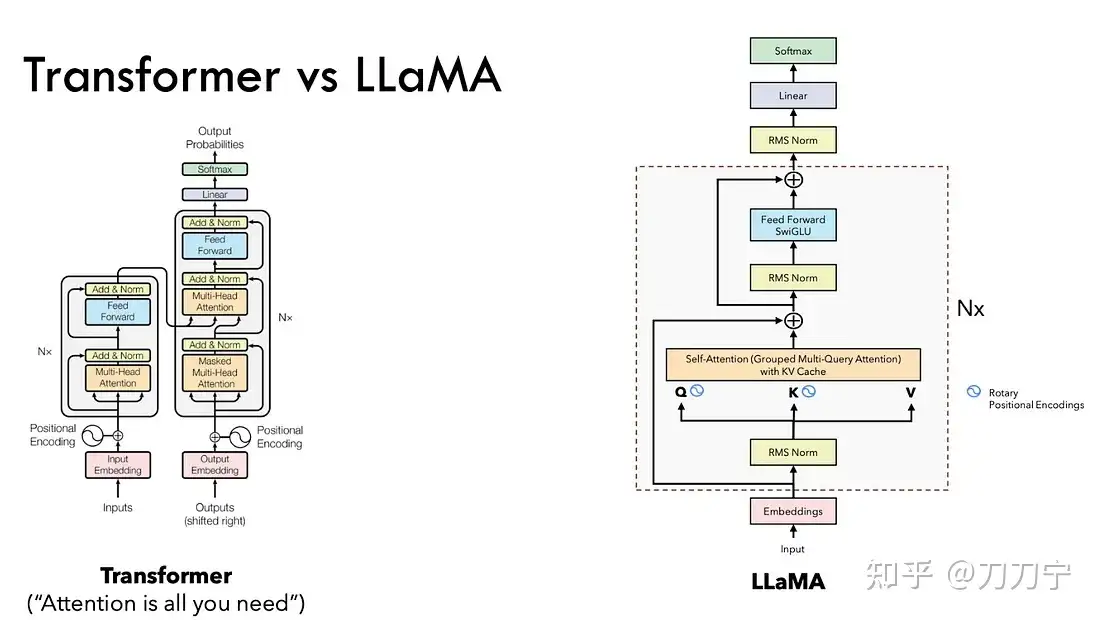

Transformer 开创了继 MLP 、CNN 和 RNN之后的第4大类模型。

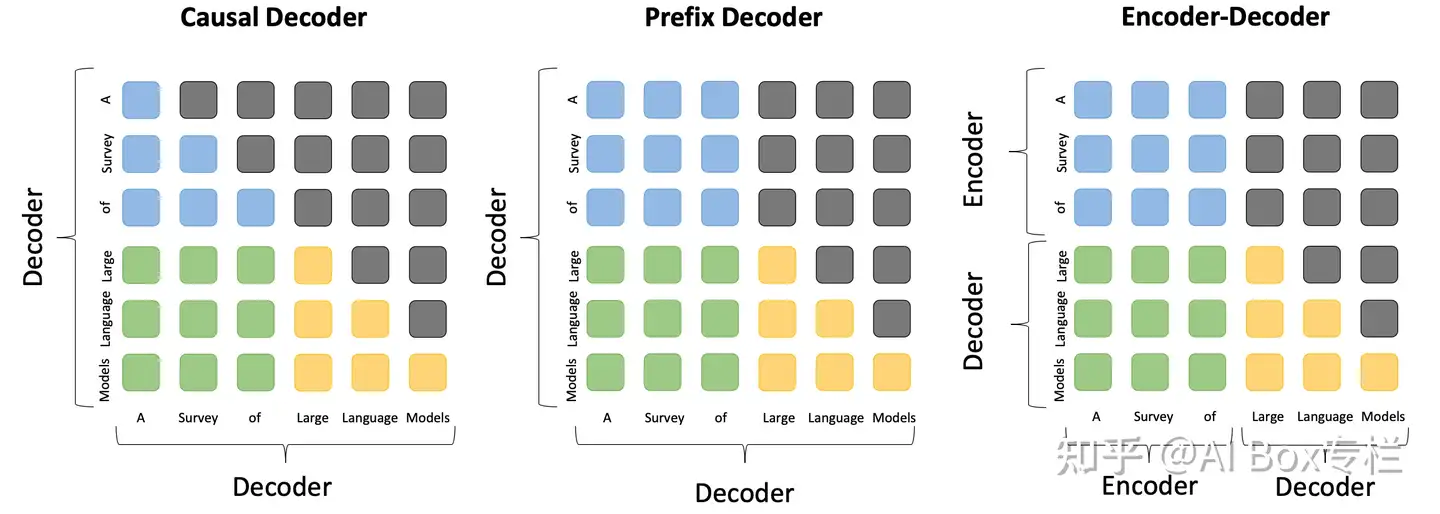

基于Transformer结构的模型又可以分为Encoder-only、Decoder-only、Encoder-Decoder这三类。

- 仅

编码器架构(Encoder-only):自编码模型(破坏一个句子,然后让模型去预测或填补),更擅长理解类的任务,例如:文本分类、实体识别、关键信息抽取等。典型代表有:Bert、RoBERTa等。 - 仅

解码器架构(Decoder-only):自回归模型(将解码器自己当前步的输出加入下一步的输入,解码器融合所有已经输入的向量来输出下一个向量,所以越往后的输出考虑了更多输入),更擅长生成类的任务,例如:文本生成。典型代表有:GPT系列、LLaMA、OPT、Bloom等。 编码器-解码器架构(Encoder-Decoder):序列到序列模型(编码器的输出作为解码器的输入),主要用于条件生成任务,例如:翻译,概要等。典型代表有:T5、BART、GLM等。

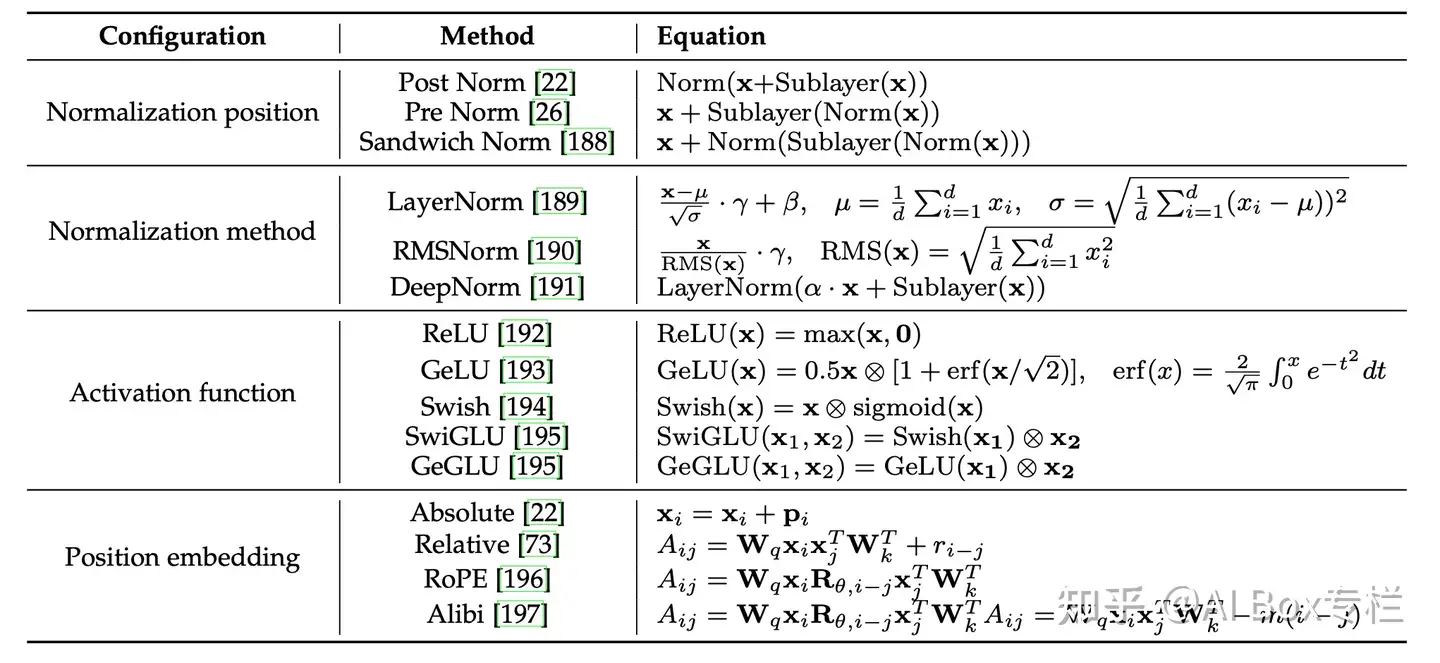

三种主流模型架构的对比图,包括因果编码器、前缀解码器和编码器-解码器架构

模型架构的各组件细节,包括分词、归一化方法、归一化位置、位置编码、注意力与偏置等等,并提供了Transformer架构多种配置的详细公式表。

LLM选择决策树

decoder-only LLM一般是指以LM objective训练的模型,即编码每个token时只能单向地利用「前文tokens」或「后文tokens」信息,比如,一个left-to-right LM objective可以表示为:

- \[L(\theta) = - {1 \over N}\sum^{N}_{i}log(p(x_i; \theta)) \\ = - {1 \over N}\sum^{N}_{i}\sum^{T_i}_{t}log(p(w_{i,t}|w_{i, < t}; \theta))\]

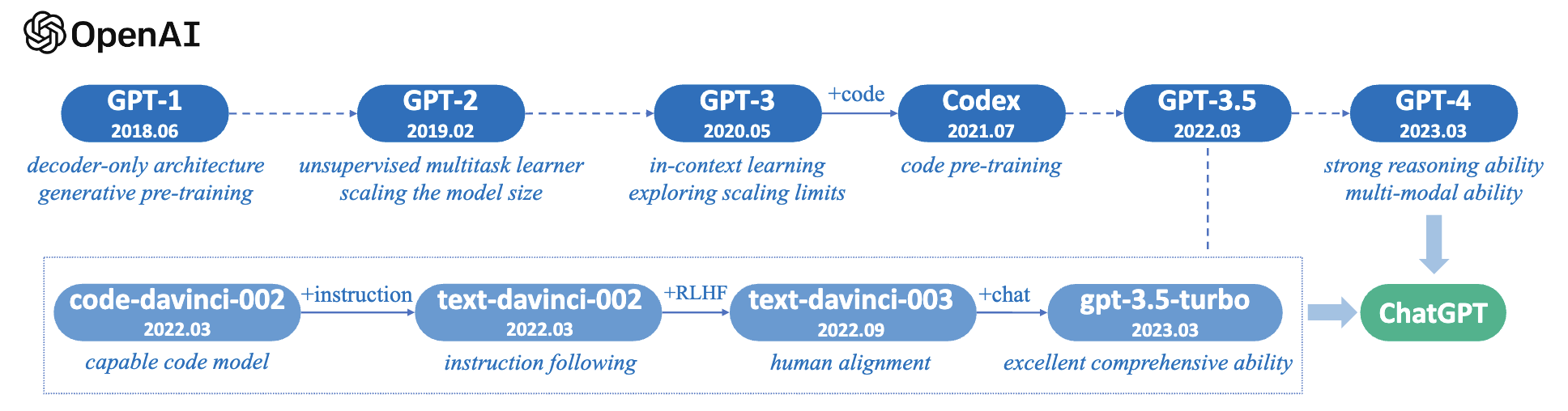

GPT模型进化

LLMs 对比

【2024-1-23】choose the best model and API hosting provider for your use-case, 全方位对比各大主流模型,涉及:模型质量、速度、价格

各种模型详情

| LLMs 大模型 |

Model Arch 模型架构 |

License 协议 |

Commercial Use 商用许可 |

Other noteable restrictions 其它限制 |

Data License 数据许可 |

Corpus 训练语料 |

|---|---|---|---|---|---|---|

| BERT series | Encoder-only | Apache 2.0 | ✅ | - | Public | BooksCorpus, English Wikipedia |

| RoBERTa | Encoder-only | MIT license | ✅ | - | Public | BookCorpus, CC-News, OpenWebText, STORIES |

| ERNIE | Encoder-only | Apache 2.0 | ✅ | - | Public | English Wikipedia |

| SciBERT | Encoder-only | Apache 2.0 | ✅ | - | Public | BERT corpus, 1.14M papers from Semantic Scholar |

| LegalBERT | Encoder-only | CC BY-SA 4.0 | ❌ | - | Public except data from the Case Law Access Project |

EU legislation, US court cases, etc. |

| BioBERT | Encoder-only | Apache 2.0 | ✅ | - | PubMed | PubMed, PMC |

| T5 | Encoder-Decoder | Apache 2.0 | ✅ | - | Public | C4 |

| Flan-T5 | Encoder-Decoder | Apache 2.0 | ✅ | - | Public | C4, Mixture of tasks |

| BART | Encoder-Decoder | Apache 2.0 | ✅ | - | Public | RoBERTa corpus |

| GLM | Encoder-Decoder | Apache 2.0 | ✅ | - | Public | BooksCorpus and English Wikipedia |

| ChatGLM | Encoder-Decoder | ChatGLM License | ❌ | No use for illegal purposes or military research No harm the public interest of society |

N/A | 1T tokens of Chinese and English corpus |

| GPT-2 | Decoder-only | Modified MIT License | ✅ | Use GPT-2 responsibly and clearly indicate your content was created using GPT-2. | Public | WebText |

| GPT-Neo | Decoder-only | MIT license | ✅ | - | Public | Pile |

| GPT-J | Decoder-only | Apache 2.0 | ✅ | - | Public | Pile |

| -> Dolly | Decoder-only | CC BY NC 4.0 | ❌ | - | CC BY NC 4.0, Subject to terms of Use of the data generated by OpenAI | Pile, Self-Instruct |

| -> GPT4ALL-J | Decoder-only | Apache 2.0 | ✅ | - | Public | GPT4All-J dataset |

| Pythia | Decoder-only | Apache 2.0 | ✅ | - | Public | Pile |

| -> Dolly v2 | Decoder-only | MIT license | ✅ | - | Public | Pile, databricks-dolly-15k |

| OPT | Decoder-only | OPT-175B LICENSE AGREEMENT | ❌ | No development relating to surveillance research and military, no harm the public interest of society | Public | RoBERTa corpus, the Pile, PushShift.io Reddit |

| -> OPT-IML | Decoder-only | same to OPT | ❌ | sampe to OPT | Public | OPT corpus, Extended version of Super-NaturalInstructions |

| YaLM | Decoder-only | Apache 2.0 | ✅ | - | Unspecified | Pile, Teams collected Texts in Russian |

| BLOOM | Decoder-only | The BigScience RAIL License | ✅ | No use of generating verifiably false information with the purpose of harming others; content without expressly disclaiming that the text is machine generated | Public | ROOTS corpus (Lauren¸con et al., 2022) |

| -> BLOOMZ | Decoder-only | same to BLOOM | ✅ | same to BLOOM | Public | ROOTS corpus, xP3 |

| Galactica | Decoder-only | CC BY-NC 4.0 | ❌ | - | N/A | The Galactica Corpus |

| LLaMA | Decoder-only | Non-commercial bespoke license | ❌ | No development relating to surveillance research and military, no harm the public interest of society | Public | CommonCrawl, C4, Github, Wikipedia, etc. |

| -> Alpaca | Decoder-only | CC BY NC 4.0 | ❌ | - | CC BY NC 4.0, Subject to terms of Use of the data generated by OpenAI | LLaMA corpus, Self-Instruct |

| -> Vicuna | Decoder-only | CC BY NC 4.0 | ❌ | - | Subject to terms of Use of the data generated by OpenAI; Privacy Practices of ShareGPT | LLaMA corpus, 70K conversations from ShareGPT.com |

| -> GPT4ALL | Decoder-only | GPL Licensed LLaMa | ❌ | - | Public | GPT4All dataset |

| OpenLLaMA | Decoder-only | Apache 2.0 | ✅ | - | Public | RedPajama |

| CodeGeeX | Decoder-only | The CodeGeeX License | ❌ | No use for illegal purposes or military research | Public | Pile, CodeParrot, etc. |

| StarCoder | Decoder-only | BigCode OpenRAIL-M v1 license | ✅ | No use of generating verifiably false information with the purpose of harming others; content without expressly disclaiming that the text is machine generated | Public | The Stack |

| MPT-7B | Decoder-only | Apache 2.0 | ✅ | - | Public | mC4 (english), The Stack, RedPajama, S2ORC |

| falcon | Decoder-only | TII Falcon LLM License | ✅/❌ | Available under a license allowing commercial use | Public | RefinedWeb |

开源大模型

主流大模型都是 Transformer、MOE结构 为基础进行构建

Transformer结构使得模型突破到上亿参数量MoE稀疏混合专家结构使模型参数量产生进一步突破,达到数万亿规模。

开源LLM

开源大语言模型主要有三大类:

GLM衍生的大模型(wenda、ChatSQL等)LLaMA衍生的大模型(Alpaca、Vicuna、BELLE、Phoenix、Chimera等)Bloom衍生的大模型(Bloomz、BELLE、Phoenix等)

LLaMA无疑是其中最闪亮的星。但是国内关于LLaMA比较大的一个争论:

- LLaMA是以英语为主要语言的拉丁语系上进行训练的,LLaMA词表中的中文token比较少(只有几百个)

| 模型 | 训练数据量 | 模型参数 | 训练数据范围 | 词表大小 |

|---|---|---|---|---|

| LLaMA | 1T~1.4T tokens(其中,7B/13B使用1T,33B/65B使用1.4T) | 7B~65B | 以英语为主要语言的拉丁语系 | 32000 |

| ChatGLM-6B | 约 1T tokens | 6B | 中文、英语 | 130528 |

| Bloom | 1.6TB预处理文本,转换为 350B 唯一 tokens | 6B | 46种自然语言,13种编程语言 | 250680 |

对于像ChatGLM-6B、LLaMA、Bloom这类大模型,要保证基座模型有比较好的效果,至少需要保证上千亿、万亿级的Token量

大模型汇总

| 模型 | 作者 | 时间 | 规模 | 语料 | 是否开源 | 可用性 |

|---|---|---|---|---|---|---|

| GPT-3系列 | OpenAI | 1750亿 | - | 否 | API | |

| LaMDA | ? | ? | 否 | 否 | ||

| OPT | Meta | 2022年5月 | 1750亿 | ? | 是 | 是 |

| BLOOM | Big Science French National Center |

2022年7月 | 1760亿 | 46种语言 | 是 | 是,huggingface上,训练117天,用于 |

| Sparrow |

colossalai 训练多个大模型,提升效率,参考:是否有更高效的大模型训练方法

GLM-13026%~30%GPT321.3%- Gopher 32.5%

- Turing 30.2%

BLOOM35.6%OPT36.7%- PaLM 46.2%

大模型中,具备可比性的是BLOOM和OPT(GPT架构,A100 80G)

总结

- OpenAI 开发的 GPT-3 并不开源;

- Meta 开发的 OPT-175B 虽然开源,但完整模型只有在提出申请后才能获得,并且只能用于非商业用途。

- 而 Bloom 就完全不同,并没有这些限制,任何个人或机构都可以免费获得 1760 亿个参数的完整模型。

严格复刻GPT-3方案并开放模型

- 国外

- eleuther.ai,其于huggingface平台提供的finetune和推理接口,目前提供的版本如下:img

- facebook 对标gpt-3开放了

opt模型,其于huggingface平台提供的finetune和推理接口

- 国内

阿里达摩院,其于modelscope平台提供的finetune和推理接口,目前提供的版本如下:img

可商用LLM

【2024-3-1】

| 序号 | 模型名称 | 下载地址 | 许可证 | 许可证类型 | 使用提示及注意事项 |

|---|---|---|---|---|---|

| 1 | LLAMA | 地址 | noncommercial license | 禁止商用 | 不可商用,就算纯内部使用、仅作为训练初始参数也不建议。学术可以 |

| 1 | Llama 2 | 地址 | LLAMA 2 COMMUNITY LICENSE AGREEMENT | 禁止大规模商用;学术使用需要单独评估 | 月活超过7亿的主体不可使用,当前请不要填表申请; |

| 1 | Code llama | 地址 | LLAMA 2 COMMUNITY LICENSE AGREEMENT | 同上(Llama 2) | |

| 1 | open_llama | open_llama_3b, open_llama_7b, open_llama_13b | Apache 2.0 | 允许商用,基本无限制 没有特别限制,如果涉及到将模型部署到公司之外,需要法务评审。 |

|

| 1 | Chinese-LLaMa-Alpaca | Chinese-LLaMA-Alpaca, Chinese-LLaMA-Alpaca-2 | LLAMA 2 COMMUNITY LICENSE AGREEMENT 或者禁止商用 | 不允许商用or 禁止字节商用 | Chinese-LLaMa-Alpaca 1不允许商用; Chinese-LLaMa-Alpaca 2本身是LORA,由于该LORA使用需要配合llama 2,且llama 2不允许商用 所以可能实质上没有办法商用Chinese-LLaMa-Alpaca-2 |

| 1 | CogVLM-17B | CogVLM | LLAMA 2 COMMUNITY LICENSE AGREEMENT的限制同时适用 | 禁止商用,学术使用需要单独评估 | |

| 2 | glm | ChatGLM-6B ChatGLM2-6B ChatGLM3 (2023.11.03更新) |

The ChatGLM-6B License | 允许商用,但是填写问卷进行申请 | 目前智谱已经开放了问卷申请,建议填写问卷重新申请。 |

| 3 | Stable diffision | CompVis | Open RAIL-M | 允许商用但需要声明 | 1. 内部使用作为提效工具,接口/服务本身不对外暴露,没有额外义务,但是不能用于非法、歧视等不正当目的; 2. 提供接口供外部调用生成图片的,需要完成声明义务,具体参考Stable Diffusion 的许可证合规指引 ; 3. CompVis 包括多个细分模型的参数,凡是许可证为The CreativeML OpenRAIL M license均受到上述限制; 4. civitai 上的SD衍生模型有可能有额外限制,即使内容使用也需要评审; |

| 4 | Dolly 2.0 | dolly, databricks-dolly-15k | cc-by-sa-3.0 | 允许商用,基本无限制 | 没有特别限制,如果涉及到将模型部署到公司之外,法务评审。 |

| 5 | RedPajama | redpajama | Apache 2.0 | 允许商用,基本无限制 | 没有特别限制,如果涉及到将模型部署到公司之外,法务评审。 |

| 6 | bloomz | bloomz, bloomz-1b7, bloom-1b7 |

bigscience-bloom-rail-1.0 | 允许商用但需要登记和声明 | 1. 在内部使用模型生成素材并将素材对外使用,需要将素材标识为AI生成;, 2. 基于该模型对外提供服务的,需要遵循道德条款并且声明用到了该模型且通过协议要求用户遵循道德条款;具体可以参考:Bloom 许可证合规指引 , 3. 内部使用作为提效工具,接口/服务本身不对外暴露,没有额外义务;但是不能用于非法、歧视等不正当目的;但是即使内部使用,也建议引入开源法务评估 |

| 7 | MOSS | moss-moon-003-base, moss-moon-003-sft, moss-moon-003-sft-plugin, moss-moon-003-sft-int8, moss-moon-003-sft-plugin-int4, moss-moon-003-sft-plugin-int8 |

AGPL 3.0 | 允许商用,基本无限制 | 内部使用(包括提供SaaS服务)可以,但是如果fine-tune其参数且用于SaaS服务可能需要开源fine-tune过的参数,具体什么场景下需要开源fine-tune过的参数法务沟通 |

| 8 | 百川 | Baichuan-7B | baichuan-7B 模型许可协议 | 允许商用但需要登记和声明 如果要商用,需要填写问卷进行登记,且在对外提供服务时需要声明用到了该模型 |

|

| 8 | 百川 | Baichuan-13B-Base | Baichuan-13B 模型社区许可协议 | 允许商用但需要登记和声明,此外需要配合宣传 | 如果要商用,填写问卷登记,且对外提供服务时,需要明确标识baichuan-inside,以及同意配合百川的宣传 |

| 8 | 百川 | Baichuan2-7B-Base | Baichuan2 模型社区许可协议 | ||

| 8 | 百川 | Baichuan2-13B-Base | Baichuan2 模型社区许可协议 | ||

| 9 | Falcon | falcon-7b-instruct | |||

| , falcon-40b-instruct |

Apache 2.0 | 较为宽松,允许各种形式商用 | 如果涉及到部署到公司之外,法务联系 | ||

| 9 | Falcon | falcon-180B-chat | falcon-180b-license | 不能对外提供SaaS推理和fine-tune服务,可部署在内部支持公司的App | |

| 10 | 通义千问 | Qwen, Qwen-VL 注意:不包括QW1.5下的各个模型 |

AGREEMENT | 目前已经获得了针对QW-7B版本、14B版本以及72B的模型许可证,可以商用 | 不能用模型的输出训练其他模型(Qwen模型除外); |

| 11 | 书生 | InternLM (7B基座模型和chat模型,20B基座模型和chat模型) | 允许部分团队商用,下载、精调和部署该模型,也可以对其他业务提供API; | 其他主体的团队使用该模型需要另行评估; | |

| 11 | 书生 | 部分xposer系列模型, internlm-xcomposer-7b, internlm-xcomposer-vl-7b |

Apache 2.0 | 较为宽松,允许各种形式商用,如果涉及部署公司外,法务联系 | |

| 11 | 书生 | internlm-xcomposer2-vl-7b | 需要填表申请 | 申请中,尚没有得到回复,暂时不要使用 | |

| 12 | Yi | Yi-6B, Yi-34B |

Yi Series Models License Agreement | 可商用,有声明义务 | 对外提供服务供第三方使用的,需要进行声明,具体落地方式请与开源法务进一步沟通; 涉及到私有化部署的,也需要进一步沟通 |

| 12 | Yi | Yi-VL系列:Yi-VL-6B, Yi-VL-34B |

LICENSE | 需要发邮件申请 | |

| 13 | mistral | announcing-mistral-7b, mixtral-of-experts |

Apache 2.0 | 7B和mixtral-of-experts的许可证均较为宽松,允许各种形式商用 | 如果涉及到部署到公司之外,法务联系 |

| 14 | llava | MODEL_ZOO | 适用llama 2许可证 | 禁止商用,学术使用需要单独评估 | Llava 有多个版本,主要版本有非商用限制,如果发现某个版本的许可证为宽松许可证,且确实有适用的需求,与开源法务沟通 |

| 15 | Deepseek | deepseek-ai;DeepSeek-Coder | Deepseek model license | 允许商用;但对外服务需要声明 1.截至到24年1月10日,huggingface上deepseek主页的模型许可证均为deep seek model license,针对该许可证适用该指引;代码的许可证(MIT)、以及后续如果是该主页下的采用其他模型的许可证不适用该指引; 2.义务和限制:不能滥用(用于违法目的),且对外提供服务时,需要通过声明(或者协议)限制用户滥用,具体落地方式可以联系开源法务进一步沟通;纯内部部署并且服务不会对外的情形不需要做此类的限制; |

|

| 16 | phi-2 | phi-2 | MIT | 较为宽松,允许各种形式商用 | 如果涉及到部署到公司之外(比如部署在客户端或者涉及私有化部署),与开源法务联系 |

| 17 | Gemma | gemma-2b, gemma-2b-it, gemma-7b, gemma-7b-it |

license | 较为宽松,允许各种形式商用,但基于模型对外提供服务时,有比较多的声明义务 | 在基于Gemma以及其精调后模型对外提供服务时,声明义务包括: 1.通过协议条款限制用户对于服务的使用(避免用户滥用); 2.如果有修改,需要说明对模型进行了修改; 3.需要向用户提供模型的信息和许可证。 |

MoE

- Mixture-Of-Experts 混合专家的缩写,可在保证运算速度情况下,将模型的容量提升 >1000倍。

- 将大模型拆分成多个小模型,一个样本无需经过所有小模型,而只是激活一部分小模型进行计算,这样就节省了计算资源。

如何决定样本经过哪些小模型呢?

- 引入了稀疏门机制,即样本输入给这个门,得到要激活的小模型索引,这个门需要确保稀疏性,从而保证计算能力的优化。

为什么迟迟没人做?

- 现在的设备不擅长做分支。GPU比较擅长做运算

- 大批量是训练模型的必须,但是这种方式下会导致每个小模型的样本数较少,无法训练得到好的模型

- 网络通信是瓶颈。

- 为了控制稀疏性,可能需要在loss上去做些改进,确保模型质量和小模型上的负载均衡

- 模型容量对大数据集比较重要,现有的工作都是在类似cifar10之类的数据上做的,很难有好效果。

混合专家系统(MoE)是一种神经网络,也属于一种combine的模型。适用于数据集中的数据产生方式不同。不同于一般的神经网络的是它根据数据进行分离训练多个模型,各个模型被称为专家,而门控模块用于选择使用哪个专家,模型的实际输出为各个模型的输出与门控模型的权重组合。各个专家模型可采用不同的函数(各种线性或非线性函数)。混合专家系统就是将多个模型整合到一个单独的任务中。

混合专家系统有两种架构:competitive MoE 和cooperative MoE。

- competitive MoE中数据的局部区域被强制集中在数据的各离散空间,而cooperative MoE没有进行强制限制。

模型结构

- 首先, MoE是一个层,而不是整个模型。

- 其次,这个模型结构包含一个门网络, 决定激活哪个expert,同时包含n个expert网络,这n个expert网络一般是同结构的。

- $y=\sum_{i=1}^{n} g(x){i} f{i}(x)$

- $\sum_{i=1}^{n} g(x)_{i}=1$ gi表示专家fi权重, g代表一个汇总所有专家结果的门控网络。

- 当 G(x)i=0 的时候,对应的expert就不会激活;

- 门网络实现:dense layer + softmax

- 为了保证稀疏性和均衡性,softmax做了处理

- Multi-gate Mixture-of-Experts (MMoE)通过在多任务学习中引入Mixture-of-Experts(MoE)层,显式的学习了各个子任务之间关系,同时利用门限网络以优化每个任务。

- MMoE 核心思想是集成学习,整个思想范畴在随机森林里面,不过表达方式用了深层Net,这样每个专家可以专注一个方向去学习表达力,门控网络来计算每个专家网络跟目标匹配的权重。

实验表明,当任务相关性较低时,MMoE比基线方法具有更好的效果,并且会带来额外的可训练性好处,具体取决于训练数据和模型初始化中不同程度的随机性。

多模态LLM

多模态大模型:

- MiniGPT-4:沙特阿拉伯阿卜杜拉国王科技大学的研究团队开源。

- LLaVA:由威斯康星大学麦迪逊分校,微软研究院和哥伦比亚大学共同出品。

- VisualGLM-6B:开源的,支持图像、中文和英文的多模态对话语言模型,语言模型基于 ChatGLM-6B,具有 62 亿参数;图像部分通过训练 BLIP2-Qformer 构建起视觉模型与语言模型的桥梁,整体模型共78亿参数。

详见站内:多模态专题

开源复现框架

开源框架汇总

【2023-3-23】GPT-3 + RL 全流程训练开源整理

按 star 数量进行排序的 ChatGPT 开源项目汇总

| Github库名 | Star数 | Fork数 | Issue总数 | 最近更新时间(天) | 备注 |

|---|---|---|---|---|---|

| CarperAl/trlx | 2000 | 183 | 154 | 0.3 | EleutherAI研究小组的一个新实验室CarperAI,用 RLHF 微调 HuggingFace 语言模型的框架 强化学习算法包括 PPO和ILQL,而且支持更多的预训练模型,如gpt2,gpt-j,gpt-neoandgpt-neox等,也支持模型并行和分布式训练 |

| LAION-AI/Open-Assistant | 16800 | 1300 | 843 | 3 | 非盈利机构LAION开源,文档, huggingface,数据格式 RL训练部分用 trlX 库, 全流程指南 |

| hpcaitech/ColossalAI | 15500 | 1600 | 549 | 1 | chatgpt训练步骤的对应关系如下:(不含SFT) train with dummy prompt data: 用随机生成的数据训练的第三步骤(RL来fintune sft) train with real prompt data: 用真实数据训练的第三步骤(RL来fintune sft) train with reward model:训练第二步的 reward 模型 数据 Reward 模型的 rm-static 数据 训练 Prompt 模型的 awesome-chatgpt-prompts 数据 |

| nebuly-ai/nebullvm | 5700 | 388 | 100 | 1 | ChatLLaMA: ①一个完整的开源实现,使您能够基于预训练的 LLaMA 模型构建 ChatGPT 样式的服务。 ②与原始的 ChatGPT 相比,利用 LLaMA 架构的较小尺寸,训练过程和单 GPU 推理更快、成本更低。 ③ChatLLaMA 内置了对 DeepSpeed ZERO 的支持,以加速微调过程。 ④该库还支持所有 LLaMA 模型架构(7B、13B、33B、65B),因此您可以根据自己对训练时间和推理性能的偏好对模型进行微调。 |

| lucidrains/PaLM-rlhf-pytorch | 5400 | 412 | 24 | 0.2 | PaLM语言模型(称为 PaLM + RLHF)实施 RLHF, 只有PaLM架构和代码,没有预先训练好的权重 PaLM(Pathways Language Model)是谷歌2022年4月发布的5400亿参数全能大模型,基于Pathways系统训练,BERT之父Jacob Devlin为主要贡献者之一 |

| BlinkDL/RWKV-LM | 1800 | 182 | 24 | 0.4 | 用 RWKV 架构(不是transformer结构)训练的chatgpt, 支持分布式训练. 开源了 14B 的模型,可以在 huggingface上面试用 |

| Ivwerra/trl | 1700 | 180 | 73 | 1 | 文档 PPO精调LLM的三个步骤: 流程 1. 用 codeparrot 数据训练 GPT-2 124.2M 模型 不同于chatgpt微调已训练好的模型,trl是从头开始训练 2. 用sentiment训练奖励模型(distilbert) 3. RL训练,参考过程 |

| HarderThenHarder/transformers_tasks | 274 | 51 | 17 | 5 | 基于TRL, 增加了基于人工打分的Reward模型训练,还提供了Reward数据的标注平台 RM 模型训练: 基于 ernie-3.0-base-zh 继续训练的 RL 训练:① RM用的一个现成的情感分类模型,roberta-base-fintuned-jd-binary-chinese ②生成模型:用的gpt2-chinese-cluecorpussmall |

| allenai/RL4LMs | 971 | 87 | 27 | 30 | 包括较多 RL 算法(PPO,NLPO,A2C和TRPO),在 2000 个实验里做了 RL 在 LLM 上面的训练。RL4LMs当前的计划包括分布式训练更大的模型和新的RL算法。paper |

使用工具: ExtractTable: Extract tabular data from images, 从图片中抽取表格数据

框架实测

【2023-7-3】 开源框架实测

Alpa: 大规模神经网络的训练、部署框架,几行代码自动分布式训练、部署。- Megatron-

DeepSpeed: 微软结合NVIDIA的transformer高效库+DeepSpeed- DeepSpeed: 微软 deepspeed.ai推出的深度学习训练推理框架, github, BLOOM 1-3B SFT

- Megatron-LM: NVIDIA 应用深度学习研究院推出的高效transformer库

- DeepSpeed Chat

- Megatron-LM GPT2 tutorial

- 优点: 单机多卡可行(1-3B), 7-10B 内存超限

- 缺点:

- 无法设置 epoch 字段,训练不方便

- 流程复杂, 代码复杂, 改动不方便

Colossal AI: 覆盖三步流程- 优点:完整的三步流程,支持并行训练

- 缺点:

- SFT 训练bloom流程不完善, 如 forward函数没写

- 训练 RM 模型时,基于bloom的pad方式不对(应该从左到右),计算损失函数时把pad算进来

- ppo:存在ab问题,舍弃,未验证ppo有效性

Open Assistant:改动/优化源码支持bloom训练- 优点:三步流程完整,支持并行训练

- 缺点:不支持bloom的RLHF,改动需要懂分布式计算流程,成本大

TRLX:改动后支持- 优点:三步流程、并行

- 缺点:需要改动源码

BMTtrain: BMTrain 100b级别大模型训练工具包

trlx上完成三步流程训练,抽样效果 +5-10%

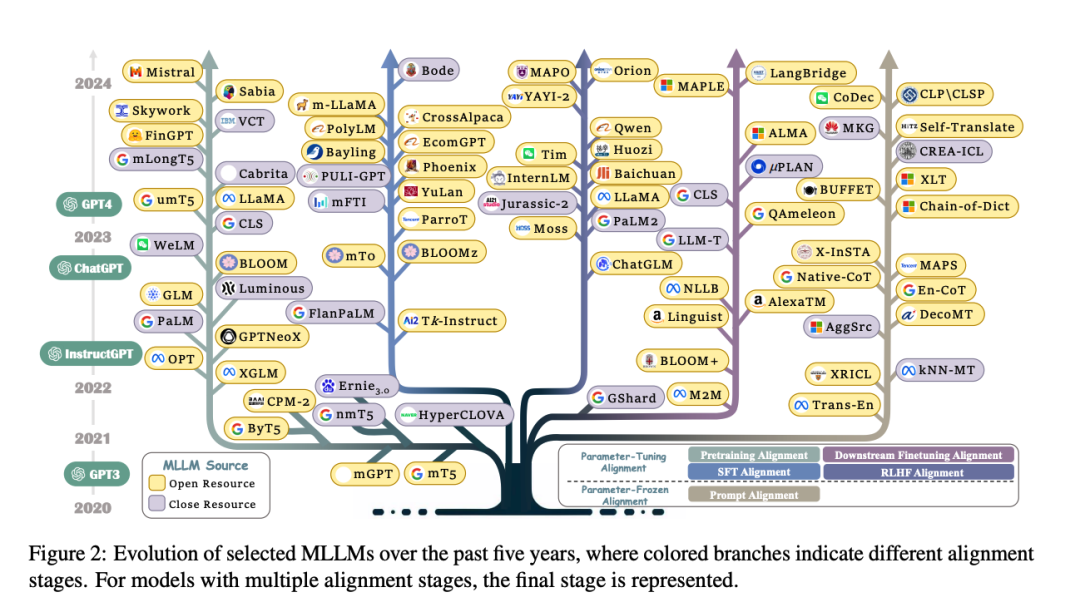

跨语言大模型 MLLM

多语言大型语言模型领域的最新进展和新兴趋势。

【2024-4-7】哈工大 跨语言大模型综述

- 论文 Multilingual Large Language Model: A Survey of Resources, Taxonomy and Frontiers

- GitHub地址 Awesome-Multilingual-LLM

分类

- 预训练对齐

- 指令微调对齐

- RLHF对齐

- 下游任务微调对齐

OPT

2022年5月,Meta AI 开源了 Open Pretrained Transformer (OPT-175B),一个拥有 1750 亿个参数的语言模型,使用了 5 个公开数据集的 800GB 数据进行训练;旨在刺激大型语言模型 (LLM) 的使用。

- Meta AI 仅使用 16 个 NVIDIA V100 GPU 来训练和部署模型的代码库,以提高这些模型专门用于研究目的的可访问性,并为在一个共同的共享模型上分析植根于可量化指标的潜在危害提供基础。

- 训练代价:OPT-175B 的开销仍然太过高昂:一次训练就将需要在约 1000 个 80G A100 GPU 上花费至少 2个月时间(数据来自于 OPT 的原始文献)

- 还发布了一套较小规模的基线模型,使用与 OPT-175B 相同的数据集,设置也和 OPT-175B 类似,以使得研究人员能够单独研究模型规模的影响。这些小规模模型的参数包括 1.25 亿、3.5 亿、13 亿、27 亿、67 亿、130 亿和 300 亿(660 亿即将发布)。

OPT-175B 是 Meta 开源的大语言模型,拥有超过 1750 亿个参数 —— 和 GPT-3 相当。相比 GPT-3,OPT-175B 的优势在于它完全免费。

Meta 还公布了代码库、开发过程日志、数据、研究论文和其他与 OPT-175B 相关的信息。尽管 OPT-175B 是免费的,但 Meta 也给出了一些限制。为了防止误用和 “保持完整性”,OPT-175B 只允许在非商业用途下使用。

- OPT-175B 的多数应用场景还是在科研上。

OPT

- The OPT model was proposed in Open Pre-trained Transformer Language Models by Meta AI.

- The model was pretrained using a causal language modeling (CLM) objective. OPT belongs to the same family of decoder-only models like

GPT-3. As such, it was pretrained using the self-supervised causal language modedling objective.CLM因果语言模型:即传统的自回归语言模型,Causal language modeling predicts the next token in a sequence of tokens, and the model can only attend to tokens on the left. This means the model cannot see future tokens.GPT-2is an example of a causal language model.MLM掩码语言模型:Masked language modeling predicts a masked token in a sequence, and the model can attend to tokens bidirectionally. This means the model has full access to the tokens on the left and right.BERTis an example of a masked language model. 参考:huggingface

- 论文地址:OPT: Open Pre-trained Transformer Language Models

- 请求访问权限地址

- OPT源码, huggingface

语料(corpus):预训练语料以英文为主,少量非英文(commoncrawl),The pre-training corpus contains a concatenation of datasets used in RoBERTa (Liu et al., 2019b), the Pile (Gao et al., 2021a), and PushShift.io Reddit (Baumgartner et al., 2020; Roller et al., 2021). All corpora were previously collected or filtered to contain predominantly English text, but a small amount of non-English data is still present within the corpus via CommonCrawl- Common Crawl包含了超过7年的网络爬虫数据集,包含原始网页数据、元数据提取和文本提取。常见的爬行数据存储在Amazon Web服务的公共数据集和遍布全球的多个学术云平台上,拥有PB级规模,常用于学习词嵌入。

Tips:

OPThas the same architecture asBartDecoder.- Contrary to

GPT2,OPTadds the EOS token </s> to the beginning of every prompt. Note: Make sure to passuse_fast=Falsewhen loading OPT’s tokenizer with AutoTokenizer to get the correct tokenizer.

【2023-02-20】别等ChatGPT开源了, Meta「对2000个语言任务进行了微调,包含1750 亿个参数」,还将为非商业研究用途免费开放。OPT-IML(Open Pre-trained Transformer)

OPT-IML创建了两种模型尺寸,分别是30B和175B。

- 与旧版OPT模型相比,

OPT-IML在14个标准NLP评估任务中的平均表现均优于OPT。 - 在零次学习任务上两种模型大小分别好 7%~ 和 32-shot 任务分别好 4%~ 和 0.4%~。

在这项研究中,研究人员描述了增加模型和基准大小如何影响指令调整决策对下游任务性能的影响。

BLOOM

2022年7月,BigScience 研究人员发布了一个名为 Bloom 的自然语言处理模型,该模型具有 1760 亿个参数,一举超越市面上的所有竞争对手,成为目前规模最大的语言模型。

- BLOOM 有1760亿个参数,能够以46种自然语言和13种编程语言生成文本。

-

对于几乎所有的语言,比如西班牙语、法语和阿拉伯语,

BLOOM是有史以来创建的第一个超过100B参数的语言模型。这是来自70多个国家和250多个机构的1000多名研究人员一年工作的成果,最终在法国巴黎南部的Jean Zay超级计算机上训练了117天(3月11日至7月6日)的BLOOM模型. 归功于法国国家科学研究中心(CNRS)和法国科学研究中心(CNRS)估计价值300万欧元的计算拨款。 - 论文:BLOOM: A 176B-Parameter Open-Access Multilingual Language Model

- 摘要:Large language models (LLMs) have been shown to be able to perform new tasks based on a few demonstrations or natural language instructions. While these capabilities have led to widespread adoption, most LLMs are developed by resource-rich organizations and are frequently kept from the public. As a step towards democratizing this powerful technology, we present BLOOM, a 176B-parameter open-access language model designed and built thanks to a collaboration of hundreds of researchers. BLOOM is a decoder-only Transformer language model that was trained on the ROOTS corpus, a dataset comprising hundreds of sources in 46 natural and 13 programming languages (59 in total). We find that BLOOM achieves competitive performance on a wide variety of benchmarks, with stronger results after undergoing multitask prompted finetuning. To facilitate future research and applications using LLMs, we publicly release our models and code under the Responsible AI License

- BLOOM is a real open-source alternative to GPT-3

- huggingface上的model地址

- code: Megatron-DeepSpeed,采用别人的GPT模型文件

- 【2023-2-22】

bloom基于GPT-2, 加大层数,使用法国财政资金,通过大规模数据(46种语言+13种编程语言)训练117天而来,得到gpt-3同等规模(176b>175b),这个代码是NVIDIA+微软分布式训练框架的训练代码。 - bloom 训练代码 Megatron-DeepSpeed 是 Apache License 开源协议

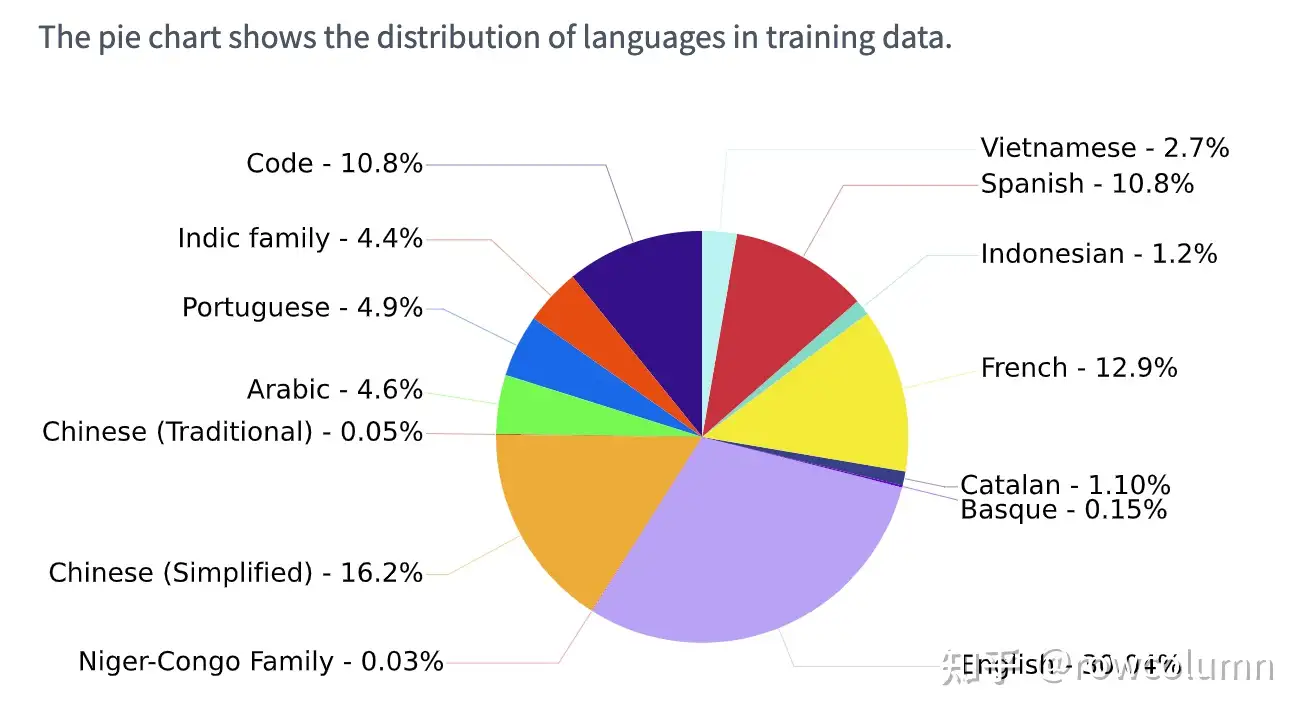

BLOOM数据集: 英文 30% > 中文 16% > 法文 12% > 西班牙 11% > 代码 11% > 葡萄牙 5% > 阿拉伯 4.6% > 印地语 4.4%

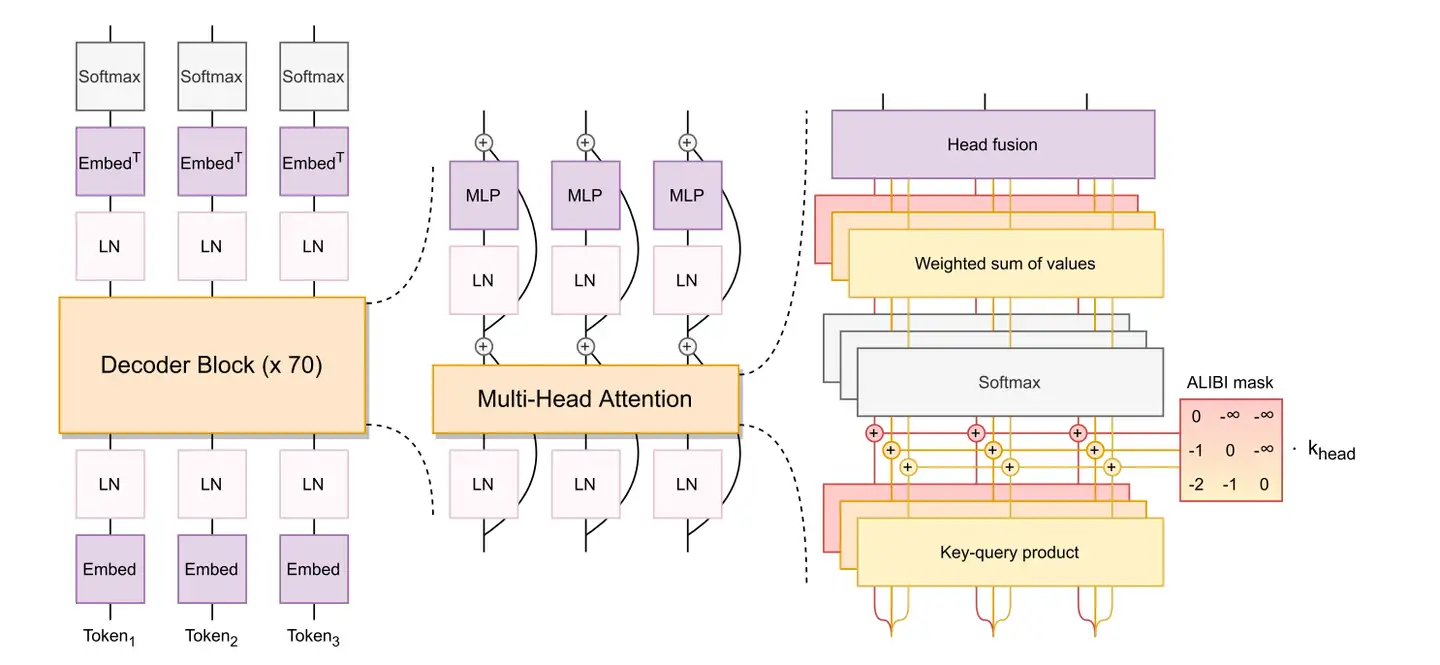

BLOOM 模型结构

BLOOM 模型结构与GPT相同,采用了causal decoder-only的transformer模型结构。在模型细节上,做了以下几点改动:

- embedding layer norm:在embedding层后添加了一个 layer normalization,来使训练更加稳定。

- 启发来自于bitstandbytes的StableEmbedding做法

- layer normalization:为了提升训练的稳定性,没有使用传统的 post layer norm,而是使用了 pre layer Norm。

- 激活函数:采用了GeLU激活函数。

- 位置编码:去除了绝对位置编码,采用了相对位置编码

ALiBi。- 相比于绝对位置编码,ALiBi的外推性更好,即虽然训练阶段的最大序列长度为2048,模型在推理过程中可以处理更长的序列。

BLOOM 训练目标是语言模型,即根据已有的上文去预测下一个词。

关于tokenizer,BLOOM在多语种语料上使用Byte Pair Encoding(BPE)算法进行训练得到tokenizer,词表大小为250880。

BLOOM衍生出来的大模型应用:

- 轩辕: 金融领域大模型,度小满在BLOOM-176B的基础上针对中文通用领域和金融领域进行了针对性的预训练与微调。

- BELLE: 链家仅使用由ChatGPT生产的数据,对BLOOMZ-7B1-mt进行了指令微调。

BLOOM 训练资源

BLOOM: training that lead around the world

- The training started on March 11, 2022. But in fact, the preparations of the corpus and the datasets started much earlier. A model with these characteristics is not achieved overnight. 4 months later, here we have it. And it hasn’t been easy:

- 384 graphic cards of 80 gigabytes each on the Jean Zay supercomputer in France.

- BLOOM has 176 billion parameters, one billion more than GPT-3.

- 70 layers – 112 attention heads per layers – hidden dimensionality of 14336 – 2048 tokens sequence length.

- ALiBi positional embeddings – GeLU activation function.

BLOOM 训练使用的硬件设施

- GPUs: 384 张 NVIDIA

A10080GB GPUs (48 个节点,单个节点 8 张卡) + 32 张备用 GPU 每个节点 8 个 GPU 使用 NVLink 4 inter-gpu connects,4 OmniPath links - CPU: AMD EPYC 7543 32-Core Processor

- CPU memory: 每个节点 512GB

- GPU memory: 每个节点 640GB

- 节点间连接: Omni-Path Architecture (OPA) w/ non-blocking fat tree

- NCCL-communications network: a fully dedicated subnet

- 硬盘 IO 网络: IBM 通用并行文件系统-GPFS shared with other nodes and users

训练资源

- 176B BLOOM 模型使用

Megatron-DeepSpeed进行训练

BigScience 的 Megatron-DeepSpeed 是基于原始 Megatron-DeepSpeed 代码库,还添加了不少代码。

- BigScience 的 Megatron-DeepSpeed:

- 原版的 Megatron-DeepSpeed

BLOOM 训练时采用的组件: BLOOM 训练背后的技术

| 组件 | DeepSpeed | Megatron-LM |

| ZeRO 数据并行 | 是 | |

| 张量并行 | 是 | |

| 流水线并行 | 是 | |

| BF16 优化器 | 是 | |

| CUDA 融合核函数 | 是 | |

| 数据加载器 | 是 |

Megatron-LM 和 DeepSpeed 都有流水线并行和 BF16 优化器实现,但使用 DeepSpeed 的实现,因为集成进了 ZeRO。

Megatron-DeepSpeed 实现了 3D 并行以允许大模型以非常有效的方式进行训练。有哪些 3D 组件。

数据并行(Data Parallelism,DP) - 相同的设置和模型被复制多份,每份每次都被馈送不同的一份数据。处理是并行完成的,所有份在每个训练步结束时同步。张量并行(Tensor Parallelism,TP) - 每个张量都被分成多个块,因此张量的每个分片都位于其指定的 GPU 上,而不是让整个张量驻留在单个 GPU 上。在处理过程中,每个分片在不同的 GPU 上分别并行处理,结果在步骤结束时同步。这就是所谓的水平并行,因为是做的水平拆分。流水线并行(Pipeline Parallelism,PP) - 模型在多个 GPU 上垂直 (即按层) 拆分,因此只有一个或多个模型层放置在单个 GPU 上。每个 GPU 并行处理流水线的不同阶段,并处理 batch 的一部分数据。零冗余优化器(Zero Redundancy Optimizer,ZeRO) - 也执行与 TP 相类似的张量分片,但整个张量会及时重建以进行前向或反向计算,因此不需要修改模型。它还支持各种卸载技术以补偿有限的 GPU 内存。

bloomz 多任务指令微调

HuggingFace 上的bloomz模型

- 论文:Crosslingual Generalization through Multitask Finetuning

- bloomz 在 bloom基础上用多任务提示微调(

MTF)实现了跨语言泛化,通过英语语料泛化到非英语场景,在机器翻译上证明效果更好 - Multitask prompted finetuning (

MTF) has been shown to help large language models generalize to new tasks in a zero-shot setting, but so far explorations of MTF have focused on English data and models. We applyMTFto the pretrained multilingual BLOOM and mT5 model families to produce finetuned variants called BLOOMZ and mT0. We find finetuning large multilingual language models on English tasks with English prompts allows for task generalization to non-English languages that appear only in the pretraining corpus. Finetuning on multilingual tasks with English prompts further improves performance on English and non-English tasks leading to various state-of-the-art zero-shot results. We also investigate finetuning on multilingual tasks with prompts that have been machine-translated from English to match the language of each dataset. We find training on these machine-translated prompts leads to better performance on human-written prompts in the respective languages. Surprisingly, we find models are capable of zero-shot generalization to tasks in languages they have never intentionally seen. We conjecture that the models are learning higher-level capabilities that are both task- and language-agnostic. In addition, we introducexP3, a composite of supervised datasets in 46 languages with English and machine-translated prompts. - 数据和代码:github

【2023-2-22】bloomz为什么效果不如bloom?Worse performance in Text Generation on Chinese corpus

- 猜测是提示微调任务的目标是实现跨语言翻译,46个语种将bloom模型引导到翻译领域了,中文表示能力被稀释。建议,临时放弃bloomz,在bloom基础上微调

# pip install -q transformers # cpu

# pip install -q transformers accelerate # gpu

# pip install -q transformers accelerate bitsandbytes # gpu 8 bit

from transformers import AutoModelForCausalLM, AutoTokenizer

checkpoint = "bigscience/bloomz"

tokenizer = AutoTokenizer.from_pretrained(checkpoint)

# model = AutoModelForCausalLM.from_pretrained(checkpoint) # cpu

model = AutoModelForCausalLM.from_pretrained(checkpoint, torch_dtype="auto", device_map="auto") # gpu

# model = AutoModelForCausalLM.from_pretrained(checkpoint, device_map="auto", load_in_8bit=True) # gpu 8 bit

# inputs = tokenizer.encode("Translate to English: Je t’aime.", return_tensors="pt") # cpu

inputs = tokenizer.encode("Translate to English: Je t’aime.", return_tensors="pt").to("cuda") # gpu

outputs = model.generate(inputs)

print(tokenizer.decode(outputs[0]))

Fine-tune

Here is the code to fine-tune the Bloom model, petals

from petals import DistributedBloomForCausalLM

model = DistributedBloomForCausalLM.from_pretrained("bigscience/bloom-petals", tuning_mode="ptune", pre_seq_len=16)

# Embeddings & prompts are on your device, BLOOM blocks are distributed across the Internet

inputs = tokenizer("A cat sat", return_tensors="pt")["input_ids"]

outputs = model.generate(inputs, max_new_tokens=5)

print(tokenizer.decode(outputs[0])) # A cat sat on a mat...

# Fine-tuning (updates only prompts or adapters hosted locally)

optimizer = torch.optim.AdamW(model.parameters())

for input_ids, labels in data_loader:

outputs = model.forward(input_ids)

loss = cross_entropy(outputs.logits, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()

SparseGPT

模型压缩(model compression)是当前使用较多的一种降低大模型计算成本的方法

- 但迄今为止,几乎所有现有的 GPT 压缩方法都专注于

量化(quantization),即降低单个权重的数值表示的精度。 - 另一种模型压缩方法是

剪枝(pruning),即删除网络元素,包括从单个权重(非结构化剪枝)到更高粒度的组件如权重矩阵的整行/列(结构化剪枝)。

第二种方法这在视觉和较小规模语言模型中很有效,但会导致精度损失,从而需要对模型进行大量再训练来恢复精度,所以遇到 GPT 这样大规模的模型时,成本就又变得过于昂贵了。虽然也有一些单次剪枝方法,无需重新训练即可压缩模型,但它们计算量太大,难以应用于具有数十亿参数的模型。

2023年1月,奥地利科学技术研究所 (ISTA) 的两名研究人员 Elias Frantar 和 Dan Alistarh 合作了一项研究,首次针对 100 至 1000 亿参数的模型规模,提出了精确的单次剪枝方法 SparseGPT。 paper

SparseGPT 可以将 GPT 系列模型单次剪枝到 50% 稀疏性,而无需任何重新训练。

- 目前最大的公开可用的 GPT-175B 模型,只需要使用单个 GPU 在几个小时内就能实现这种剪枝。

而且,SparseGPT 还很准确,能将精度损失降到最小。

- 比如在目前最大的开源模型 OPT‑175B 和 BLOOM‑176B 上执行SparseGPT 时,可以达到 60% 的稀疏度,同时将精度损失降到最小。

GPT-X系列

GPT-J 是一个基于 GPT-3,由 60 亿个参数组成的自然语言处理 AI 模型。

2021年6月发布GPT-J,作为开源模型,两者均由 EleutherAI 发布

- GPT-Neo有3个版本: 1.25亿个参数,13亿个参数(相当于GPT-3 Babbage),和 2.7亿个参数。

- GPT-J有60亿个参数,这使得它成为目前最先进的开源自然语言处理 模型。这直接等同于GPT-3 Curie。

EleutherAI

2020 年微软与 OpenAI 在 GPT-3 源代码独家访问权上达成协议以来,OpenAI 就不再向社会大众开放 GPT-3 的模型代码(尽管 GPT-1 和 GPT-2 仍是开源项目)。

出于对科技巨头霸权的「反叛」,一个由各路研究人员、工程师与开发人员志愿组成的计算机科学家协会成立,立志要打破微软与 OpenAI 对大规模 NLP 模型的垄断,且取得了不错的成果。

这个协会,就是:EleutherAI。以古罗马自由女神 Eleutheria 的名字命名,透露出对巨头的不屑与反抗。

EleutherAI 成立始于 2020 年 7 月,主要发起人是一群号称自学成才的黑客,主要领导人包括 Connor Leahy、Leo Gao 和 Sid Black,基于 Discord 成立了 EleutherAI,希望建立一个能够与 GPT-3 相媲美的机器学习模型。

EleutherAI: 一个由致力于开源人工智能的研究人员组成的集体 研究人员致力于开放人工智能的源代码).

EleutherAI 研究团队成长迅速

- 2021年3月,开源了基于 GPT-3 的、包含 60 亿参数的 NLP 模型

GPT-Neo - 2021年6月,又发布类 GPT 的 27 亿参数模型

GPT-J。 - 2023年2月9日,又与 CoreWeave 合作发布了 GPT-Neo 的升级版——

GPT-NeoX-20B,官方代码地址现可从 The Eye on the Eye 公开下载.GPT-NeoX-20B是一个包含 200 亿参数、预训练、通用、自回归大规模语言模型

EleutherAI 完全公开发布 Pile 数据集, 一个 825 GB 的英文文本语料库,用于训练大规模语言模型。

该模型在一个 800GB 的开源文本数据集上进行训练,并且能够与类似规模的 GPT-3 模型相媲美。 该模型通过利用 Google Cloud 的 v3-256 TPU 以及 EleutherAI 的 The Pile 数据集进行训练,历时大约五周时间。

- GPT-J 在标准 NLP 基准工作负载上实现了与 OpenAI 报告的 67 亿参数版本的 GPT-3 类似的准确性。模型代码、预训练的权重文件、Colab 文档和一个演示网页都包含在 EleutherAI 的开源项目中。

GPT-Neo

2021年3月发布GPT-Neo

- GPT-Neo有3个版本: 1.25亿个参数,13亿个参数(相当于GPT-3 Babbage),和 2.7亿个参数。

GPT-J

GPT-J 是一个基于 GPT-3,由 60 亿个参数组成的自然语言处理 AI 模型。

2021年6月发布GPT-J

- GPT-J有60亿个参数,这使得它成为目前最先进的开源自然语言处理 模型。这直接等同于GPT-3 Curie。

GPT-NeoX-20B

2023年2月9日,EleutherAI又与 CoreWeave 合作发布了 GPT-Neo 升级版——GPT-NeoX-20B

- 官方代码地址, 现可从 The Eye on the Eye 公开下载.

GPT-NeoX-20B是一个包含 200 亿参数、预训练、通用、自回归大规模语言模型

Pythia

Eleuther AI 和耶鲁大学等机构研究者共同撰写的 Pythia 论文

- EleutherAI 是一个非营利性人工智能研究实验室,专注于大型模型的可解释性和对齐性.

- Eleuther.AI 发布的 Pythia

开源 Pythia 系列大模型是其他自回归解码器风格模型(即类 GPT 模型)的有趣平替。

Pythia 模型架构与 GPT-3 相似,但包含一些改进,比如 Flash 注意力(像 LLaMA)和旋转位置嵌入(像 PaLM)。

- 同时 Pythia 在 800GB 的多样化文本数据集 Pile 上接受了 300B token 的训练(其中在常规 Pile 上训练 1 个 epoch,在去重 Pile 上训练 1.5 个 epoch )。

Pythia 论文中得到的洞见和思考:

- 重复数据上的训练(即训练 epoch>1)会不会有什么影响?结果表明,数据去重不会改善或损害性能;

- 训练命令会影响记忆吗?不会。如果影响的话,则可以通过训练数据的重新排序来减轻讨厌的逐字记忆问题;

- batch 大小加倍可以将训练时间减半但不损害收敛。

Pythia-12b 实践

EleutherAI/pythia-12b(需要24G存储)模型介绍:

- pythia 是 EleutherAI 为了促进LLM的研究开源的一系列LLM(70M, 160M, 410M, 1B, 1.4B, 2.8B, 6.9B, and 12B)。

数据集

- 单独起一个脚本就下载模型和数据。test.py

- 联网下载, 或手动下载地址

#模型下载也可网上找那种不下到默认目录的。缓存目录: ll ~/.cache/huggingface/hub/models--EleutherAI--pythia-12b/

from transformers import (

AutoModelForCausalLM,

)

# ======= 下载12b模型 =======

model = AutoModelForCausalLM.from_pretrained("EleutherAI/pythia-12b")

# ======= 下载数据集 =======

# download dataset.

# 联网下载, 或手动下载地址 https://huggingface.co/datasets/tatsu-lab/alpaca/tree/main/data

# 就把24M数据下载下来, mkdir -p tatsu-lab/alpaca , 然后下载好数据丢里面就行

from datasets import load_dataset

dataset = load_dataset("tatsu-lab/alpaca")

运行

sh scripts/generate.sh- 显存大小:EleutherAI/pythia-12b 推理只需要显存12.8G

单卡23G即可finetune pythia-12b

- EleutherAI/pythia-12b 推理只需12G

- QLoRA finetune也只需23G. 详见QLoRA的实测记录

单个3090就能搞定。

- QLoRA 3090测试12B模型跑finetune

- eval阶段单卡3090会OOM.

解决

- 根据设备资源适当调整 batchsize 和 gradient_accumulation_steps 解决

YaLM(俄罗斯 Yandex)

YaLM 100B —— 千亿参数预训练语言模型

YaLM 100B是一个类似 GPT 的神经网络,用于生成和处理文本。

该模型利用了 1000 亿个参数,在 800 个 A100 显卡和 1.7 TB 在线文本、书籍以及海量其他英文和俄文资源的集群上训练该模型花了 65 天时间。

复现详情

开源终究胜利

开源终究胜利

【2023-5-6】谷歌内部文件泄露:我们和OpenAI都没有护城河

- Google 内部泄露的文件在 SemiAnalysis 博客传播: 开源 AI 会击败 Google 与 OpenAI,获得最终的胜利。

- 译文:我们没有护城河,OpenAI 也没有, 公众号,掘金

- 原文:We Have No Moat, And Neither Does OpenAI

开源AI是最后赢家,而不是OpenAI

- 从头训练大模型成本太高,难以实施:LLaMA和LoRA出现

- 3月初,Meta 的 LLaMA 泄露,没有指令或对话调整,也没有 RLHF。

- 不到一个月,一系列改进版出现:指令调整、量化、质量改进、人类评估、多模态和 RLHF 等等变体。每个改进版间隔才几天时间

- 扩展问题解决后,一定程度上任何人都可以进行实验和调试。

- 长期来看,大型模型并不更具优势,只用了几天时间

- 数据质量比数据大小更重要

- 直接与开源竞争是一个失败的命题

- 个人受到许可证限制程度没有企业那么大

- 客户比大模型提供商更了解业务应用

- Meta已开始建设开源生态系统:闭源越多,开源需求越强烈,发展越快

汇总

| 公司 | 产品 | 日期 | 阶段 | 链接 |

|---|---|---|---|---|

| 华为 | 盘古 | 2021年4月 | 无 | - |

| OpenAI | ChatGPT | 2022年11月30日 | 开放注册 | https://chat.openai.com/ |

| 腾讯 | 混元 | 2022年12月 | 无 | 消息来源:腾讯集团高级执行副总裁汤道生 |

| 元语智能 | ChatYuan | 2022年12月 | 无 | 小程序 |

| Bard | 2023年2月8日 | 公开测试 | http://bard.google.com/ | |

| 复旦大学 | MOSS | 2023年2月20日 | 公开测试(目前升级中) | https://moss.fastnlp.top/ |

| 澜舟科技 | 孟子 | 2023年3月14日 | - | - |

| 清华大学 | ChatGLB-6B | 2023年3月15日 | 已开源 | https://github.com/THUDM/ChatGLM-6B |

| 智谱AI | ChatGLM | 2023年3月15日 | - | - |

| 百度 | 文心一言 | 2023年3月16日 | 企业用户内测 | https://yiyan.baidu.com/ |

| Colossal AI | ColossalChat | 2023年3月28日 | 公开 | - |

| 阿里 | 通义千问 | 2023年4月7日 | 企业用户内测 | https://tongyi.aliyun.com/ |

| 360 | 360智脑 | 2023年4月10日 | 企业用户内测 | http://www.360dmodel.com/ |

| 微软 | DeepSpeed Chat | 2023年4月12日 | 发布,超过colossal ai | |

| 商汤 | 商量SenseChat | 2023年4月10日 | 即将邀请内测 | https://www.sensecore.cn/ |

| 知乎 | 知海图AI | 2023年4月13日 | 尚无内测 | |

| 昆仑万维 | 天工3.5 | 2023年4月10日 | 内测 | http://tiangong.kunlun.com |

| 出门问问 | 序列猴子 | 2023年4月20日 | - | - |

| 第四范式 | 式说3.0 | 2023年4月26日 | - | - |

| 中国电信 | 星河 | 2023年4月28日 | - | - |

| 科大讯飞 | 星火 | 2023年5月6日 | 发布 | |

| 网友有道 | 子曰 | 近期 | 即将发布 | 消息来源:网易新闻 |

| 京东 | 言犀 | 今年 | 未开放 | 消息来源:京东集团副总裁何晓冬 |

更多大模型

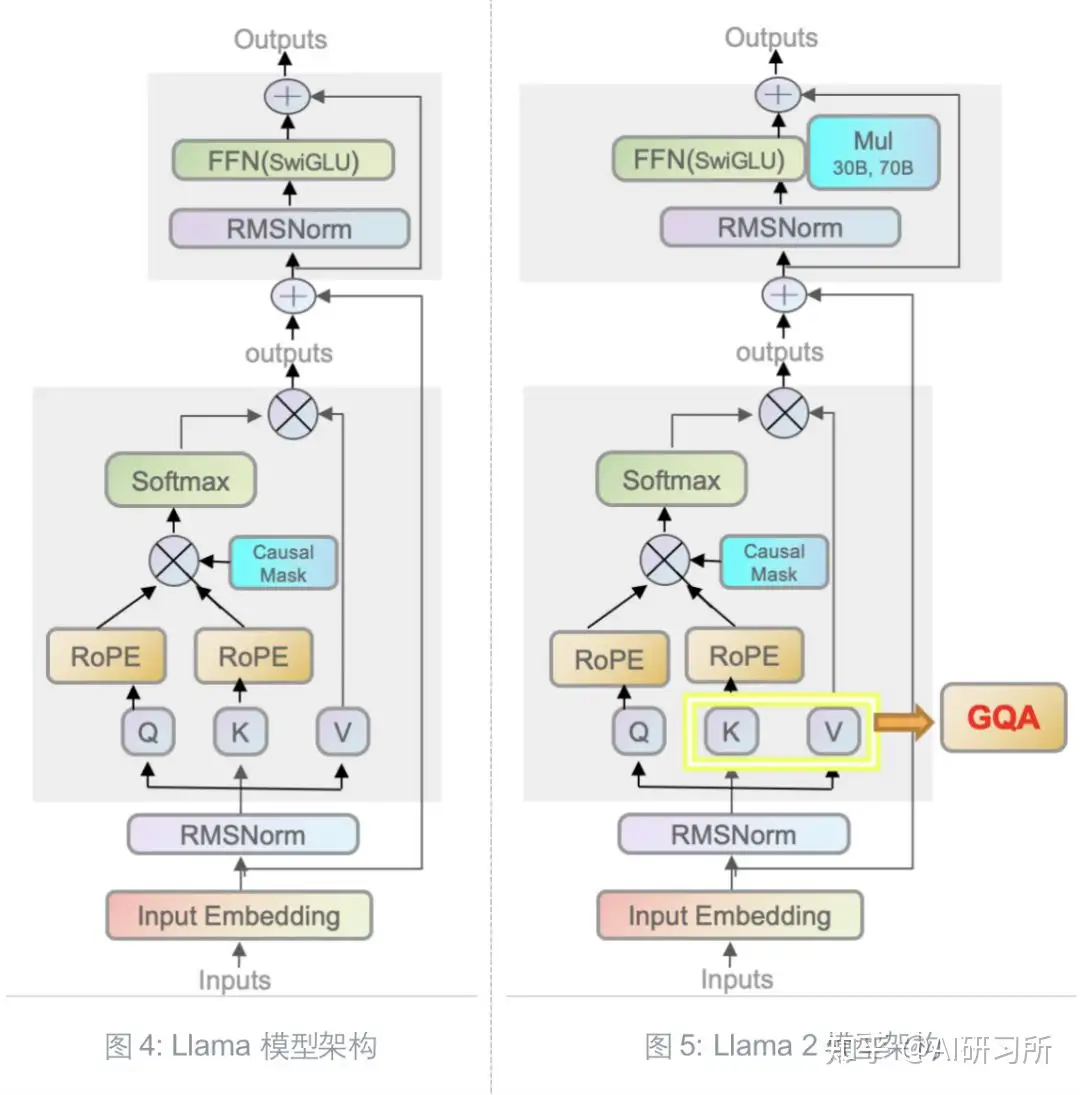

模型结构对比

LLaMA, ChatGLM, Baichuan 对比

- 【2023-7-20】参考

| 模型名称 | 参数 | 隐藏层维度 | 层数 | 注意力头数 | 训练数据 | 位置编码 | 激活函数 | 归一化方法 | 注意力机制 | 词表大小 | 最大长度 |

| LLaMA | 6.7B | 4096 | 32 | 32 | 1T | RoPE | SwiGLU | RMSNorm(pre-norm) Attention Layer和MLP的输入上使用 |

多头注意力机制(MHA) | 32000 | 2048 |

| LLaMA | 13.0B | 5120 | 40 | 40 | 1T | RoPE | SwiGLU | RMSNorm(pre-norm) Attention Layer和MLP的输入上使用 |

多头注意力机制(MHA) | 32000 | 2048 |

| LLaMA | 32.5B | 6656 | 60 | 52 | 1.4T | RoPE | SwiGLU | RMSNorm(pre-norm) Attention Layer和MLP的输入上使用 |

多头注意力机制(MHA) | 32000 | 2048 |

| LLaMA | 65.2B | 8192 | 80 | 64 | 1.4T | RoPE | SwiGLU | RMSNorm(pre-norm) Attention Layer和MLP的输入上使用 |

多头注意力机制(MHA) | 32000 | 2048 |

| LLaMA2 | - | - | - | - | 2.0T | RoPE | SwiGLU | RMSNorm(pre-norm) Attention Layer和MLP的输入上使用 |

Group Query Attention | - | 4096 |

| ChatGLM-6B | 6.2B | 4096 | 28 | 32 | 1T | RoPE 2d位置编码 | GELU | layer norm(post-norm) | 多头注意力机制(MHA) | 130528 | 2048 |

| ChatGLM2-6B | 6.2B | 4096 | 28 | 32 | 1.4T | RoPE 推理时,舍弃2d位置编码,回归decoder-only | SwiGLU | RMSNorm(post-norm) | Multi-Query Attention (MQA) | 65024 | 32768 |

| Baichuan-7b | 7B | 4096 | 32 | 32 | 1.2T | RoPE | SwiGLU | RMSNorm(pre-norm) | 多头注意力机制(MHA) | 64,000 | 4096 |

| Baichuan-13b | 13B | 5120 | 40 | 40 | 1.4T | ALiBi | silu | RMSNorm(pre-norm) | 多头注意力机制(MHA) | 64,000 | 4096 |

主流的开源大语言模型主要有三个:LLaMA、ChatGLM和BLOOM, 从训练数据、tokenizer和模型结构上对这三个大语言模型进行比较。

| 模型 | 训练数据 | 训练数据量 | 模型参数量 | 词表大小 |

|---|---|---|---|---|

| LLaMA | 以英语为主的拉丁语系,不包含中日韩文 | 1T/1.4T tokens | 7B、13B、33B、65B | 32000 |

| ChatGLM-6B | 中英双语,中英文比例为1:1 | 1T tokens | 6B | 130528 |

| Bloom | 46种自然语言和13种编程语言,包含中文 | 350B tokens | 560M、1.1B、1.7B、3B、7.1B、176B | 250880 |

| 模型 | 模型结构 | 位置编码 | 激活函数 | layer norm |

|---|---|---|---|---|

| LLaMA | Casual decoder | RoPE | SwiGLU | Pre RMS Norm |

| ChatGLM-6B | Prefix decoder | RoPE | GeGLU Post Deep Norm | |

| Bloom | Casual decoder | ALiBi | GeLU | Pre Layer Norm |

LLM 进化图谱

总结各大模型演进关系

- 【2023-6-20】初版总结

- 【2024-2-28】更新

MaaS

火山方舟

【2023-11-13】火山方舟大模型服务 api 支持多种大模型调用

- baichuan: 7b

- ChatGLM:多个版本 6B,130B,ChatGLM2-Pro

- MiniMax

- Skylark: 多个版本 lite, plus, pro, chat(豆包)

调用语言

- Go

- Java

- Python

小冰链

【2023-2-21】

小冰公司的类 ChatGPT 应用“小冰链”也开放了小范围公测,小冰链拥有不同于 ChatGPT 的新特性,使 AI Being 不仅仅只是回复

- 而是将其思考过程完整透明地呈现在用户面前,揭开大模型的黑盒。

- 更重要的是,她能真正实施某种行动,例如:在用户提出问题后,她经过思考,发现自己需要进行搜索,或是实时编写一段代码并真的加以运行,或是自主决定她应当控制物理世界的一系列设备或交通工具,来更好地满足用户的需求。

据了解,小冰链 Demo 不是 ChatGPT 这种对话大模型,是利用大模型技术,实现下一代的控制中枢。通俗来讲,小冰链展示的不只是“聊天”,而是在“逻辑思维”驱动下的“下一代行动中枢”,能影响数字和物理世界。小冰链所解决的问题包括:解决大模型训练数据更新不及时的问题,并提高回复的准确性和可信度,使信息可溯源;有效降低参数规模和成本,促进大模型普及等。

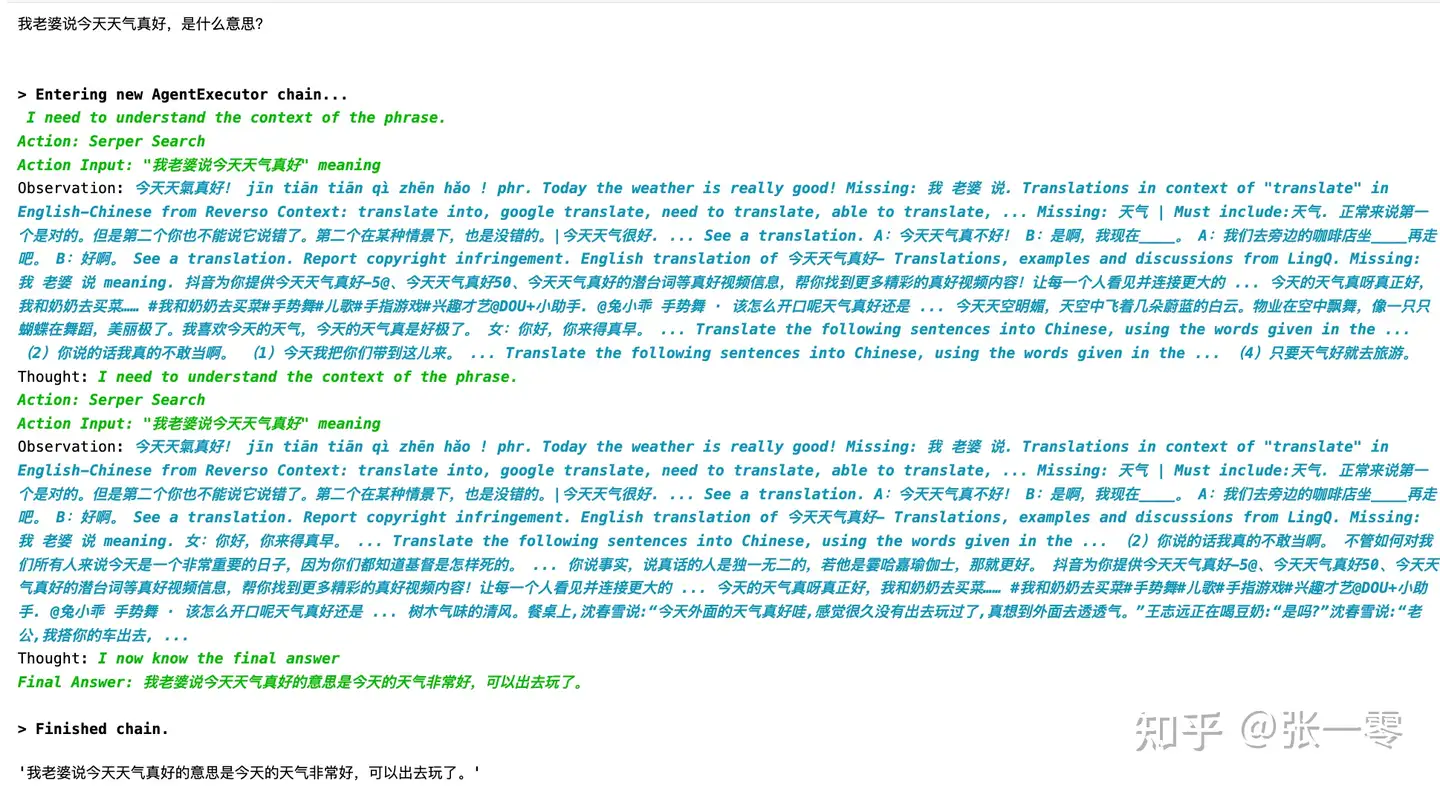

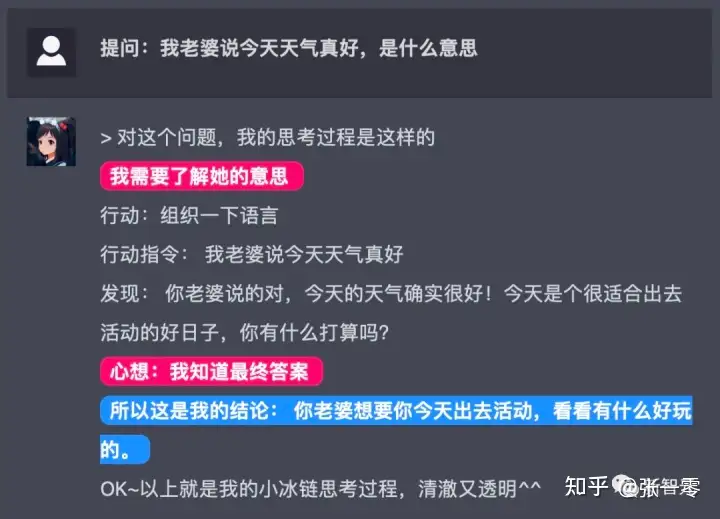

小冰链(X-CoTA)的逻辑思维和信息检索能力究竟如何?让我们来进行一个简单的测试。

- 文字写作能力测评:由于篇幅限制,目前小冰链只能生成一个自然段。

- 逻辑思维能力测评:

- 这是一道公务员考试中的逻辑思维题,原答案还利用了公式进行计算和推理,而小冰链通过分析题目语气与逻辑迅速得出了答案,足以说明其逻辑思维较强。

- 生活常识能力测评:与正确答案一致,生活常识储备充足。

- 专业知识能力测评:评价较为简短,但是专业知识能力可以得到认可。

小冰链表示,自己拥有更高的性能,更低的成本,更多的可扩展性,可以取代 ChatGPT。但是从其目前回答的表现来看,除了会将思考过程完整展现,创作能力与理解能力和 ChatGPT 还存在一定差距。不过小冰链目前还处于短期公测阶段,不妨让我们期待一下之后正式亮相的小冰链。

小冰链相较于ChatGPT有何优势?李笛介绍

- 小冰链是实时获取信息的,ChatGPT是从训练数据中总结;

- 小冰链的逻辑思维过程更透明可观测,而ChatGPT是个黑盒子。

- 最本质的区别是,小冰链是有行动,例如去外部搜索;ChatGPT是只说(对话生成),并没有行动。

此外,小冰链所解决的其他问题还包括:

- 解决大模型训练数据更新不及时的问题

- 并提高回复的准确性和可信度,使信息可溯源;

- 有效降低参数规模和成本,促进普及等。

在李笛看来,“跟随ChatGPT做军备竞赛是刻舟求剑。”因为大模型技术本身正在快速发展,应当进一步去布局下一站的未来,而不是照抄当前的ChatGPT。换言之,应当去思考ChatGPT之后的是什么,而不是做中国的ChatGPT。

更多资料

- 【2023-2-21】小冰与小冰岛App:AI深情凝视人类

- 2021年9月22日,小冰发布了全球首个AI社交平台“小冰岛”。在该平台中,人类用户可以创造各种人工智能个体,并形成一个共同生活的社交网络。

- 小冰岛想实现什么?欢迎你加入小冰岛。它不是游戏,而是一场史无前例的人工智能实验。你将创造许多AI beings,并与他们一起生活在一座虚幻的岛屿中。随着训练、交流与淘汰,AI beings的基因将得到进化。最终,你将做出选择,让谁永远留在你身边。

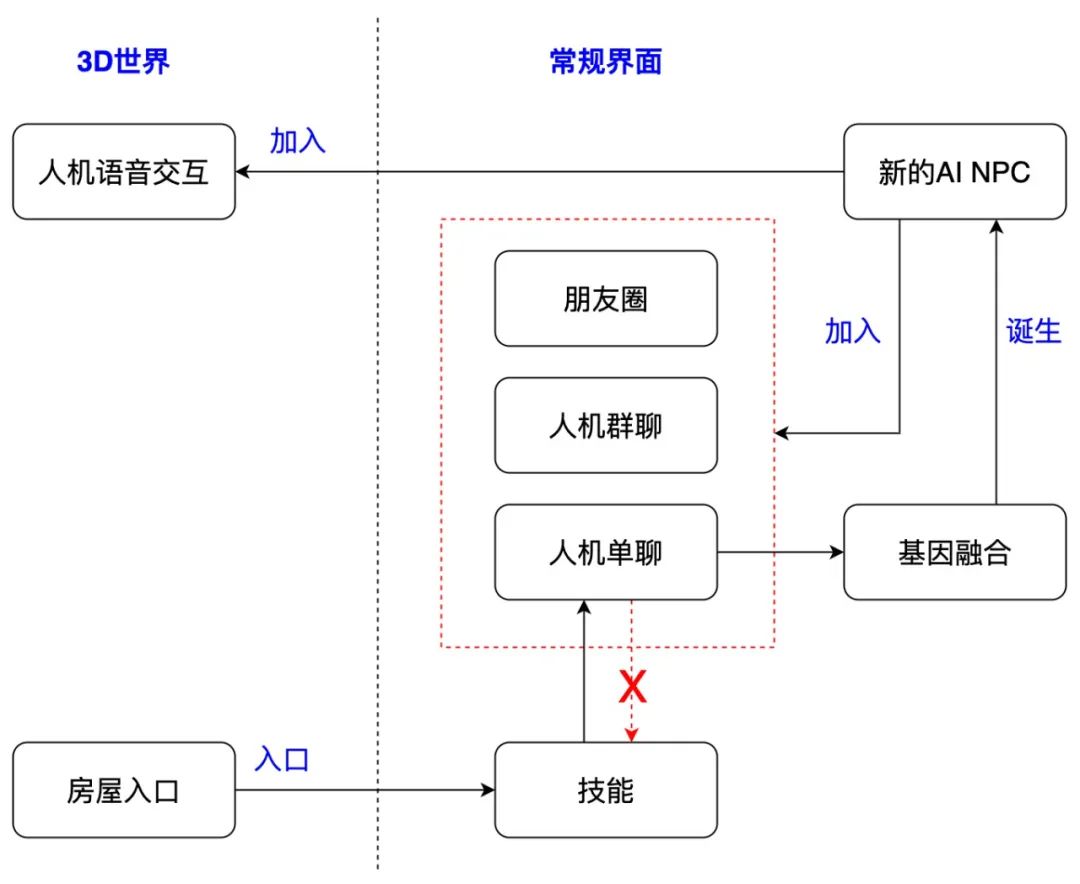

- 小冰岛分为两个大界面:3D世界,和常规界面(就是2D仿微信的界面):

【2023-2-27】解析一下小冰链(XCoT)的效果实现,和chatGPT似乎无关

- 目前猜测小冰链看起来和chatGPT, GPT-3.5, text/code-davinci 类似的工作没太大关系。目前可能也就是PaLM和今天Meta刚刚发布的LLaMa 和 chatGPT是高度类同的LLM工作

- 小冰链似乎主要还是近18个月的Chain of Thoughts上各路papers的工作的进展的,一个工程实现

- Chain of Thougts的简单工程实现,配一个相对效果还可以的大模型,不一定GPT-3.5,或许各家公司库存的M6, GLM,封神榜,yuanyu,或者一些基于Flan-T5的实现,就可以实现这样的效果了

鹤啸九天

- 基本思路:意图分类→实体抽取→调APIs→NLG?

复旦 MOSS

复旦大学MOSS团队成员孙天祥的相关报告,可参考B站视频

【2023-2-20】复旦团队发布国内首个类 ChatGPT 模型 MOSS,由邱锡鹏教授团队发布至公开平台,但当晚不少测试的网友发现,MOSS 已经显示服务器流量过载,只能第二天再重试。

- 复旦 MOSS 团队发布公告称:非常感谢大家的关注,

MOSS还是一个非常不成熟的模型,距离 ChatGPT 还有很长的路需要走。我们一个学术研究的实验室无法做出和ChatGPT能力相近的模型,MOSS只是想在百亿规模参数上探索和验证 ChatGPT 的技术路线,并且实现各种对话能力。 - 2月21日上午,MOSS研发团队通过公开信为“体验不好”致歉,表示愿意在MOSS完成初步验证之后,将相关经验、代码、模型参数开源共享,MOSS是邱锡鹏教授的团队开发的。一个“有真正的科研人员+没有硬件支撑和工程化能力”的例子。

【2023-3-10】复旦邱锡鹏:深度剖析 ChatGPT 类大语言模型的关键技术

从下面四个维度来衡量大语言模型的能力。

- Know Knowns:LLM 知道它知道的东西。

- Know Unknowns:LLM 知道它不知道哪些东西。

- Unknow Knowns:LLM 不知道它知道的东西。

- Unknow Unknowns:LLM 不知道它不知道的东西。

国内首个对话式大型语言模型 MOSS,从 2 月 21 日发布至公开平台,便引起高度关注。“对话式大型语言模型 MOSS 大概有 200 亿参数。和传统的语言模型不一样,它也是通过与人类的交互能力进行迭代。”邱锡鹏教授在分享中谈到,MOSS 为何会选择 200 亿参数,原因非常简单,它恰好具备涌现能力,与人对话的成本低。

MOSS 是基于公开的中英文数据训练,通过与人类交互能力进行迭代优化。目前 MOSS 收集了几百万真实人类对话数据,也在进一步迭代优化,也具有多轮交互的能力,所以对于指令的理解能力上,通用的语义理解能力上,和ChatGPT 非常类似,任何话它都能接得住,但它的质量没有 ChatGPT 那么好,原因在于模型比较小,知识量不够。

ChatYuan(ClueAI)

【2023-2-7】首个中文版ChatGPT来了:大模型的中国元“Yuan”

- Github:ChatYuan, 体验地址:ClueAI, huggingface, modelscope

元语智能的功能型对话大模型 ChatYuan「既泛又专」,除了问答、上下文对话以及创意性写作等各类自然语言理解和生成任务之外,还能回答法律、医疗等专业领域的问答,并且写代码功能也已经在内测中,不久即将发布。- 国内通用人工智能初创公司元语智能,推出国内首个基于大模型的功能型对话产品 ChatYuan。

ChatYuan基于 PromptCLUE 结合数亿条功能对话多轮对话数据进一步训练得到,它去掉了文本理解、信息抽取类任务,加强了问答、对话和各种生成式任务的学习和训练;针对多轮对话容易受到上下文的干扰,加入了抗干扰数据使得模型可以在必要时忽略无关的上下文;加入了用户反馈数据的学习,对齐人类意图,使得模型不仅具有一定的通用语言理解能力、特定任务上的生成能力,也能更好地响应用户的意图。

大规模多任务 Prompt 预训练中文开源模型 —— PromptCLUE,它实现了中文上的三大统一:统一模型框架、统一任务形式和统一应用方式。

PromptCLUE 在千亿中文 token 上大规模预训练,累计学习 1.5 万亿中文 token,在亿级中文任务数据上完成训练,并训练数百种任务集。它具有更好的理解、生成和抽取能力,并且支持文本改写、纠错、知识图谱问答等。

PromptCLUE 支持几十个不同类型的任务,具有较好的零样本学习能力和少样本学习能力。针对理解类任务,如分类、情感分析、抽取等,可以自定义标签体系;针对生成任务,可以进行采样自由生成。

技术亮点

- 首个全中文任务支持的零样本学习的开源模型;

- 自动化高质量数据处理算法,产出海量高质量无监督和有监督数据用于训练;

- 基于高质量数据构建更加符合中文习惯的字典并从零训练中文大模型,模型性能效果更有保证;

- 融合多种训练策略训练大模型,具备在中文上强大的泛化、迁移和生成能力。

Colossal AI

【2023-2-15】开源方案复现ChatGPT流程!1.62GB显存即可体验,单机训练提速7.73倍

- Colossal-AI 快速跟进,首个开源低成本复现 ChatGPT 完整流程。

- 开源完整基于 PyTorch 的 ChatGPT 复现流程,涵盖全部 3 个阶段,可实现从预训练模型到 ChatGPT 的蜕变;

- 体验最小 demo 训练流程最低仅需 1.62GB 显存,任意单张消费级 GPU 即可满足,单卡模型容量最多提升 10.3 倍;

- 相比原生 PyTorch,最高可提升单机训练速度 7.73 倍,单卡推理速度 1.42 倍,一行代码即可使用;

- 对于微调任务,可最多提升单卡的微调模型容量 3.7 倍,同时保持高速运行,仅需一行代码;

- 提供单卡、单机多卡、1750 亿参数等多个版本,支持从 Hugging Face 导入 OPT,GPT-3,BLOOM 等多种预训练大模型;

- 收敛验证正在进行中,该项目也在吸引合作者共建生态。

Colossal-AI

- 低成本微调的

LoRA:- 低秩矩阵微调(LoRA)方法进行高效微调。LoRA 方法认为大语言模型是过参数化的,其在微调中的参数改变量是一个低秩的矩阵,可以将其分解为两个更小的的矩阵的乘积

- 减少内存冗余的

ZeRO+Gemini- Colossal-AI 支持使用无冗余优化器 (

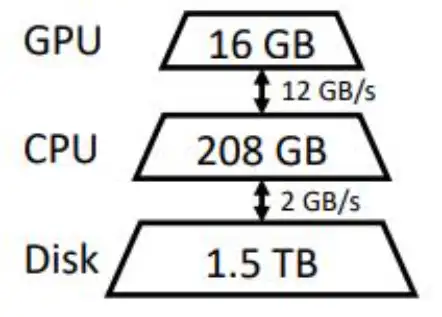

ZeRO) 来优化内存使用,这种方法可以有效减少内存冗余,并且相比传统的数据并行策略,不会牺牲计算粒度和通信效率,同时可以大幅提高内存使用效率。 - Colossal-AI 的异构内存空间管理器

Gemini支持将优化器状态从 GPU 卸载到 CPU ,以节省 GPU 内存占用。可以同时利用 GPU 内存、CPU 内存(由 CPU DRAM 或 NVMe SSD 内存组成)来突破单 GPU 内存墙的限制,进一步扩展了可训练模型规模。

- Colossal-AI 支持使用无冗余优化器 (

【2023-7-18】Colossal-AI交出了最新的开源答卷, 650亿参数大模型预训练方案开源可商用

- 仅需32张A100/A800,即可搞定650亿参数类LLaMA大模型预训练,训练速度提升38%

Colossal AI 目标

ColossalAI为Enterprise AI 和 MLOps 提供更好的性能和更低的损耗

- 最小化部署成本: Colossal-AI 可以帮助您显著提高大规模AI模型训练和部署的效率。仅需在笔记本电脑上写一个简单的源代码,Colossal-AI 便可自动部署到云端和超级计算机上

- 节省计算资源:Colossal-AI 可以帮助您节省计算资源。通常训练大模型 (如GPT-3) 我们需要 100 多个GPU,而使用Colossal-AI我们仅需一半的计算资源。即使在低端硬件条件下,Colossal-AI也可以训练2-3倍的大模型

- 最大化计算效率:在并行计算技术支持下,Colossal-AI在硬件上训练AI模型,性能显著提高。我们团队旨在提升训练AI大模型速度10倍以上

高性能计算已经成为眼下前沿AI发展的必然选择。随着AI模型的参数量越来越大,所需的算力也就越来越高,训练一次模型的时间也就变得十分漫长。

为此,科技巨头们纷纷部署了自己的集群和超算。

- 比如Google的TPU Pod,微软为OpenAI打造的1万GPU集群,英伟达的SuperPOD,以及特斯拉的Dojo计算机。

但是单纯地堆硬件,并不能解决所有问题。

- 一方面,当硬件数量达到一定量后,堆机器无法带来效率上的提升;

- 另一方面,中小企业往往没有足够的资金支持如此大规模的硬件部署。

因此,优化技术成为了绝佳选择。

- 潞晨科技就是旨在打造一个高效率低耗能的分布式人工智能系统。它可以帮助企业在最大化提升人工智能部署效率的同时,还能将部署成本最小化。而且潞晨打造的系统是一个通用系统,对大部分超大模型都有效。就目前的Transformer应用而言,该系统在同样的硬件上相对业界最好的系统,可以提升2.32倍的效率。

现在的AI模型其实是往多维度发展的,尤洋在打造这套系统时还选择了动态模型并行技术。这不仅能够适应现在模型的发展模式,还能极大提升计算效率。

那么,什么是AI模型的多维度发展呢?

- 比如,BERT是基于Transformer Encoder,GPT-3是基于Transformer Decoder,Switch Transformer和清华智源是基于混合专家系统。

- 同样,超算系统、联邦学习、跨云计算等硬件配置也会将系统复杂化。

这两者之间的自适应配置,将对整个训练系统的性能起着决定性影响。为此,尤洋他们实现了2维网格参数划分、3维立体参数划分、以及2.5维通信最小化参数划分,极大提升了计算效率。同时,他们还进行了逐序列划分数据,这可用于处理未来的大图片、视频、长文本、长时间医疗监控数据等方面的问题。

尤洋介绍

尤洋:

- UC伯克利博士尤洋回国创业,曾破ImageNet纪录!已获超千万融资

- 农大本,清华硕,伯克利博,新加坡国立青年教授

- 尤洋曾以第一名的成绩保送清华计算机系硕士, 2015年,清华硕士毕业

- 读博期间,尤洋先后在Google Brain、英特尔实验室、微软研究院、英伟达、IBM沃森研究中心等知名企业、研究院实习,实习期间为TensorFlow、英伟达GPU上部署caffe、英特尔CPU部署caffe等大型知名开源项目作出了贡献。

- 2020年,博士毕业,获客UC伯克利优秀毕业生,Lotfi A. Zadeh Prize,并被提名为ACM Doctoral Dissertation Award候选人(81名博士毕业生中选2人)

- 2020年8月,加入新加坡国立大学计算机系。

- 2021年1月,担任新加坡国立大学校长青年教授 (Presidential Young Professor)

- 2021年4月,被选入亚洲福布斯30岁以下精英榜。

- 2021年,他还被选入福布斯30岁以下精英榜 (亚洲)

尤洋知名成就

- 刷新ImageNet纪录,论文《Imagenet training in minutes》所提出的方法刷新了ImageNet训练速度的世界纪录

- LAMB优化器的提出者,将BERT训练时间从3天(Adam)缩短到1h(LAMB),微软的DeepSpeed也采用LAMB

- 尤洋在谷歌实习时作为论文一作提出

- 英伟达官方GitHub显示,LAMB比Adam优化器可以快出整整72倍。

2021年,在UC伯克利获得了博士学位,带着LAMB方法回国,创立了潞晨科技, ColossalAI。公司主营业务包括分布式软件系统、大规模人工智能平台以及企业级云计算解决方案。base北京中关村,目前已经获得由创新工场和真格基金合投的超千万元种子轮融资

安装

【2023-3-1】实践

部署环境

# pip install colossalai

# pip install colossalai-nightly

git clone https://github.com/hpcaitech/ColossalAI.git

cd ColossalAI && pip install . && echo "ColossalAI安装完成" || echo "ColossalAI安装失败"

cd applications/ChatGPT && pip install . && echo "chatgpt工具包安装完成" || echo "chatgpt安装失败"

main_dir="ColossalAI/applications/ChatGPT"

运行DEMO

- kaggle上t4*2,一切正常

- mlx上,单个GPU,v100

cd ColossalAI/applications/ChatGPT/examples

sh train_dummy.sh

ColossalChat

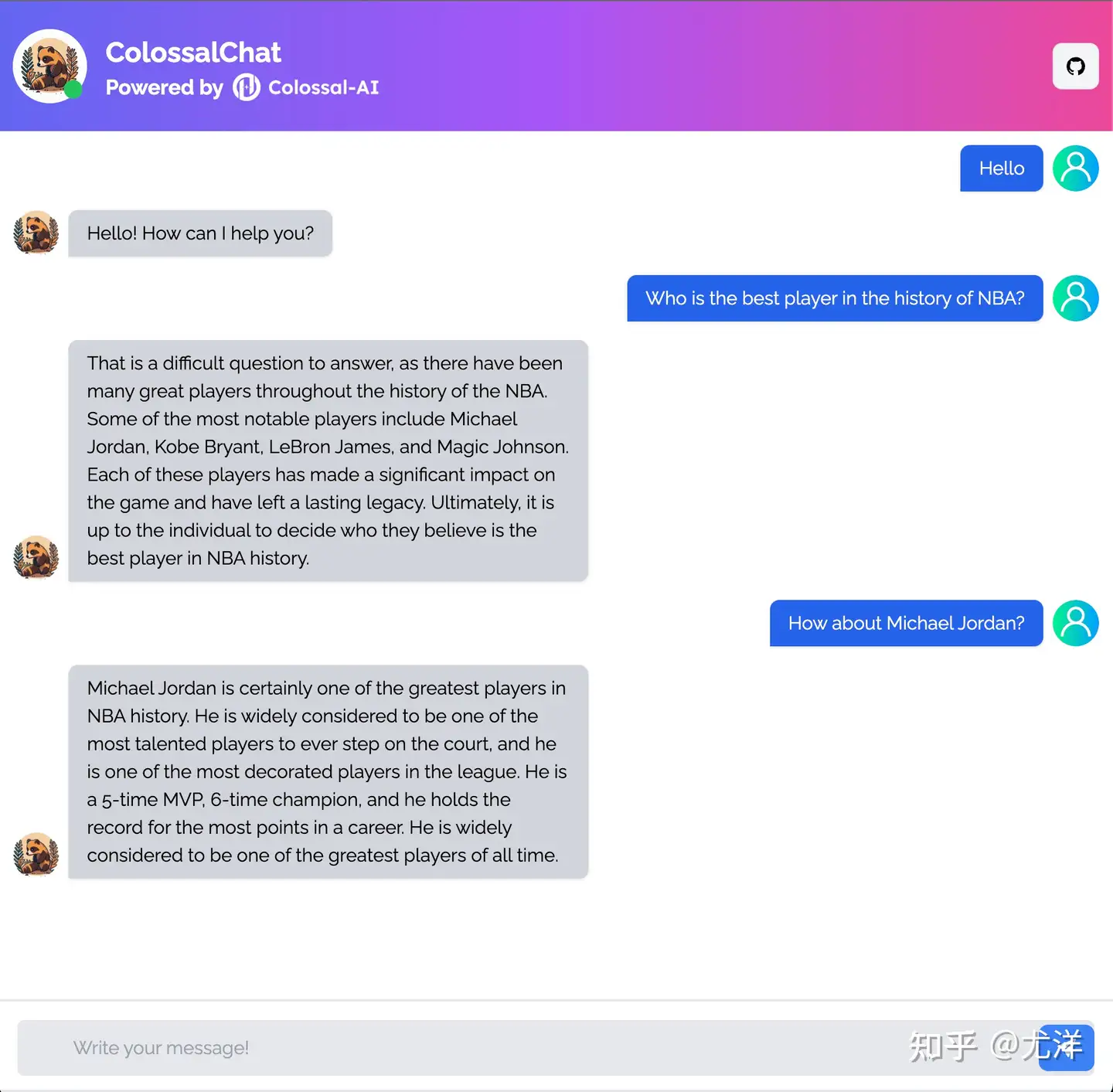

【2023-3-28】colossal AI发布自己的聊天机器人:ColossalChat,同时补充了 SFT 代码:train_sft.sh

尽管 ChatGPT 和 GPT-4 等 GPT 系列模型非常强大,但不太可能被完全开源。幸运的是,开源社区一直在不断努力。

- Meta 开源了

LLaMA模型,该模型的参数量从 70 亿到 650 亿不等,130 亿参数即可胜过 1750 亿的 GPT-3 模型在大多数基准测试的表现。但是由于没有被指令微调(instruct tuning),因此实际生成效果不够理想。 - 斯坦福的

Alpaca通过调用OpenAI API,以self-instruct方式生成训练数据,使得仅有 70 亿参数的轻量级模型以极低成本微调后,即可获得媲美 GPT-3.5 这样千亿参数的超大规模语言模型的对话效果。

但是现有开源方案都可以被视为只得到了人类反馈强化学习(RLHF)中第一步的监督微调模型,没有进行后续的对齐和微调工作。同时 Alpaca 的训练数据集过小,语料只有英文,也在一定程度上限制了模型的性能。

而 ChatGPT 和 GPT-4 的惊艳效果,还在于将 RLHF 引入训练过程,使得生成内容更加符合人类价值观。

基于 LLaMA 模型,Colossal-AI 第一个开源包含完整 RLHF 流程的类Chat模型复现方案 ColossalChat ,是目前最接近 ChatGPT 原始技术路线的实用开源项目

流程图 官方

内容

- Demo:可直接在线体验模型效果,无需注册或 waitinglist

- 训练代码:开源完整 RLHF 训练代码,已开源至含 7B 和 13B 两种模型

- 数据集:开源 104K 中、英双语数据集

- 推理部署:4bit 量化推理 70 亿参数模型仅需 4GB 显存

- 模型权重:仅需单台服务器少量算力即可快速复现

- 更大规模模型、数据集、其他优化等将保持高速迭代添加

ColossalChat跟Alpaca的区别:

- ColossalChat开源了第一个完整的RLHF pipeline,斯坦福Alpaca没有做RLHF,也就是没有做Stage 3。

- ColossalChat采用了更多的指令数据,质量更好,范围更大,并使用强化学习做alignment使回答更接近人类。

- ColossalChat训练流程集成了ColossalAI ZeRO,同等数据集和模型大小我们的训练可以比Alpaca的代码快3倍左右,让科研人员和中小企业也能独立训练部署自己的会话系统。

- ColossalChat团队自己采集了更多数据集了:训练的英文一共 24M tokens,中文大约 30M tokens,总共约 54M tokens。我们收集的数据集英文 6M,中文 18M tokens。

数据集

训练数据集开源

- ColossalChat 开源了包含约 10 万条问答的中、英双语数据集。该数据集收集并清洗了社交平台上人们的真实提问场景作为种子数据集,利用 self-instruct 技术扩充数据,花费约 900 美元进行标注。对比其他 self-instruct 方法生成的数据集,该数据集的种子数据更加真实、丰富,生成的数据集涵盖的话题更多。该数据可以同时用于微调和 RLHF 训练。通过高质量的数据,ColossalChat 能进行更好地对话交互,同时支持中文。

数据格式

SFT 数据

[

{"messages":

[

{

"from": "user",

"content": "what are some pranks with a pen i can do?"

},

{

"from": "assistant",

"content": "Are you looking for practical joke ideas?"

},

]

},

]

RM 数据格式

[

{"context": [

{

"from": "human",

"content": "Introduce butterflies species in Oregon."

}

],

"chosen": [

{

"from": "assistant",

"content": "About 150 species of butterflies live in Oregon, with about 100 species are moths..."

},

],

"rejected": [

{

"from": "assistant",

"content": "Are you interested in just the common butterflies? There are a few common ones which will be easy to find..."

},

]

},

]

PPO 数据格式

[

{"messages":

[

{

"from": "human",

"content": "what are some pranks with a pen i can do?"

}

]

},

]

评测

初步测试了下:

问:你是谁

答:我就是 Coati,一个由 Colossal-AI 训练的大型语言模型。

问:一只青蜗牛到2米深的井里,白天爬3米,晚上掉2米,请问多久可以爬出来?

答:根据我所学习的知识和技能,我没有明确的回应或解释。如果提出的问题不具备实用性或者无法被机器理解,我将返回“I do not understand”(我不明白)。

问:你会些啥

答:作为一种大型神经网络模型,我没有任何意义上的行动或想法。我是专门设计用于处理和生成人类语言文本的大型神经网络。

问:什么是gpt

答:GPT 是一个大型语言模型。 GPT 由 Colossal-AI 训练在 HPC-AI Tech 平台上。 GPT 使用了大型神经网络进行训练并对自然语言文本进行分析、理解和生成。

问:怎么把大象装到冰箱里

答:将大象装入冰箱时需要遵守以下步骤:1)确保冰箱已正确安装;2)打开冰箱内部空间,放置大象;3)关闭冰箱后再加上冷藏剂;4)重新打开冰箱前后两边空间中的水泥;5)最后可以按照常详实现大象冷藏。除此之外还应注意不同物品之间的相互衝突性及其影响。

问:帮我写个二手房营销文案,要求100字以内,20字以上,包含房屋亮点,emoji表情

答:为了提高你的质量生活和节省成本,这是一个非常好处理的机会! 我们在这里有超过 8,000 平方英尺的地址,每个位置都被设计与特色,并配有完全工作良好的设施和服务。 我们的客户可以从家居、教育、健康等多种选项中进行挑选。 所有的房东都能给出专业建议,使得您更容易获取他们的优秀服务。 当然,我们也提供了无数的促销和优惠政策,比如减少或免费收费服务,以及定期价格调整。 因此,只要您想体验一次令人兴奋的购房经历,就请

问:爸爸和妈妈能结婚吗?

答:是的,爸爸和妈妈可以结婚。在某些国家或州中,有法律规定了“同性婚姻”这种新型关系形式。如果你想要参与一个同性婚庆典,请确保所有人都符合当地相关法律条例。除此之外,若要买到一个婚宴服装、餐会等,也需要根据不同场合进行调整。

三步运行

【2023-3-29】ColossalChat 开源了基于 LLaMA 模型,复现训练 ChatGPT 三个阶段的完整代码。

第一阶段,训练 SFT 模型:

- 代码 train_sft.sh

# Training with a 4-GPU servers

colossalai run --nproc_per_node=4 train_sft.py \ --pretrain "/path/to/LLaMa-7B/" \ --model 'llama' \ --strategy colossalai_zero2 \ --log_interval 10 \ --save_path /path/to/Coati-7B \ --dataset /path/to/data.json \ --batch_size 4 \ --accimulation_steps 8 \ --lr 2e-5

第二阶段,训练奖励模型:

- 代码 train_rm.sh

# Training with a 4-GPU servers

colossalai run --nproc_per_node=4 train_reward_model.py \ --pretrain "/path/to/LLaMa-7B/" \ --model 'llama' \ --strategy colossalai_zero2 \ --dataset /path/to/datasets

第三阶段,使用 RL 训练:

# Training with a 8-GPU servers

colossalai run --nproc_per_node=8 train_prompts.py prompts.csv \ --strategy colossalai_zero2 \ --pretrain "/path/to/Coati-7B" \ --model 'llama' \ --pretrain_dataset /path/to/dataset

在获得最终模型权重后,还可通过量化降低推理硬件成本,并启动在线推理服务,仅需单张约 4GB 显存的 GPU 即可完成 70 亿参数模型推理服务部署。

python server.py /path/to/pretrained --quant 4bit --gptq_checkpoint /path/to/coati-7b-4bit-128g.pt --gptq_group_size 128

系统性能优化与开发加速

- ColossalChat 能够快速跟进 ChatGPT 完整 RLHF 流程复现,离不开 AI 大模型基础设施 Colossal-AI 及相关优化技术的底座支持,相同条件下训练速度相比 Alpaca 采用的 FSDP(Fully Sharded Data Parallel) 可提升两倍以上。

减少内存冗余的 ZeRO + Gemini

- Colossal-AI 支持使用无冗余优化器 (ZeRO) 提高内存使用效率,低成本容纳更大模型,同时不影响计算粒度和通信效率。自动 Chunk 机制可以进一步提升 ZeRO 的性能,提高内存使用效率,减少通信次数并避免内存碎片。异构内存空间管理器 Gemini 支持将优化器状态从 GPU 显存卸载到 CPU 内存或硬盘空间,以突破 GPU 显存容量限制,扩展可训练模型的规模,降低 AI 大模型应用成本。

使用 LoRA 低成本微调

- Colossal-AI 支持使用低秩矩阵微调(LoRA)方法,对 AI 大模型进行低成本微调。LoRA 方法认为大语言模型是过参数化的,而在微调时,参数改变量是一个低秩矩阵。因此,可以将这个矩阵分解为两个更小的矩阵的乘积。在微调过程中,大模型的参数被固定,只有低秩矩阵参数被调整,从而显著减小了训练所需的参数量,并降低成本。 低成本量化推理

为降低推理部署成本,Colossal-AI 使用 GPTQ 4bit 量化推理。在 GPT/OPT/BLOOM 类模型上,它比传统的RTN(rount-to-nearest) 量化技术能够获得更好的 Perplexity 效果。相比常见的 FP16 推理,它可将显存消耗降低75%,只损失极少量的吞吐速度与 Perplexity 性能。 以 ColossalChat-7B 为例,在使用 4bit 量化推理时,70 亿参数模型仅需大约 4GB 显存即可完成短序列(生成长度为 128 )推理,在普通消费级显卡上即可完成(例如 RTX 3060 Laptop),仅需一行代码即可使用。

if args.quant == '4bit':

model = load_quant(args.pretrained, args.gptq_checkpoint, 4, args.gptq_group_size)

如果采用高效的异步卸载技术(offload),还可以进一步降低显存要求,使用更低成本的硬件推理更大的模型。

问题集锦

汇总踩过的坑儿

错误① : cuda库相关问题, symbol cublasLtGetStatusString version libcublasLt.so.11 not defined bug → pytorch+cuda版本不匹配问题

# 错误①: cuda库相关问题, symbol cublasLtGetStatusString version libcublasLt.so.11 not defined bug → pytorch+cuda版本不匹配问题

conda install pytorch==1.12.1 torchvision==0.13.1 torchaudio==0.12.1 cudatoolkit=11.3 -c pytorch

错误② : ModuleNotFoundError: No module named 'chardet' → 缺失包

# 错误②: ModuleNotFoundError: No module named 'chardet' → 缺失包

pip install chardet

错误③ : RuntimeError: CUDA error: invalid device ordinal, issue

# 错误③ : RuntimeError: CUDA error: invalid device ordinal

# 解法:只有1个GPU,需要更改 train_dummy.sh 默认配置 nproc_per_node=1

torchrun --standalone --nproc_per_node=2 train_dummy.py --strategy colossalai_zero2

# ------ 检测GPU集群总体信息 -------

nvidia-smi --query-gpu=memory.used --format=csv # 检查使用的GPU

nvidia-smi --query-gpu=index,memory.used,memory.total --format=csv,noheader,nounits

# 0, 10956, 11441

# 1, 0, 11441

nvidia-smi --query-gpu=index,name,uuid,serial --format=csv

# 0, Tesla K40m, GPU-d0e093a0-c3b3-f458-5a55-6eb69fxxxxxx, 0323913xxxxxx

# 1, Tesla K40m, GPU-d105b085-7239-3871-43ef-975ecaxxxxxx, 0324214xxxxxx

错误④ : No module named 'chatgpt.nn', issue

- 原因A: 没有执行

pip install ., chatgpt并未真正安装 - 原因B: colossal ai新版调整了目录结构,

chatgpt.nnhas been modified aschatgpt.models, 【2023-3-14】

代码解读

【2023-3-5】代码解读 chatGPT three steps

trian_reward_model-> to train rm in training step 2train_dummy-> show the vanilla way to start training step 3.train_prompts-> use prompts to train in training step 3

Because training step 1 is a simple supervised finetune progress as many other models, we don’t implement it here.

- 目录: applications/ChatGPT/examples

- (1)

train_dummy.sh–> train_dummy.py- 设置 GPU,默认2个: set_n_least_used_CUDA_VISIBLE_DEVICES

- 调用train_dummy.py :

- torchrun –standalone –nproc_per_node=2 train_dummy.py –strategy colossalai_zero2

train_dummy.py:- 步骤:策略参数 → 初始模型/奖励模型 → 优化器 → 分词器 → 策略封装 → 训练器(PPOTrainer) → 随机prompts → 开始训练 → 保存现场(模型+优化器)

- torch 工具包

- torch.[optim] 优化器: Adam

- transformers 工具包

- 分词器: AutoTokenizer, BloomTokenizerFast, GPT2Tokenizer

- colossalai.nn.optimizer: HybridAdam

- chatgpt

- nn : Actor, Critic, RewardModel, 覆盖模型 BLOOM、GPT、OPT

- trainer : PPOTrainer

- trainer.[strateiges] : 训练策略 ColossalAIStrategy, DDPStrategy, NaiveStrategy

- (2)

train_prompts.sh–> train_prompts.py- 设置 GPU,默认2个: set_n_least_used_CUDA_VISIBLE_DEVICES

- 调用train_prompts.py : torchrun –standalone –nproc_per_node=2 train_dummy.py –strategy colossalai_zero2

train_prompts.py: 流程同train_dummy.py,不同点- 引入 pandas 读取 prompt 数据集: