- PyTorch 学习笔记

- PyTorch 教程

- pytorch 内部机制

- 结束

PyTorch 学习笔记

2017 年 1 月,FAIR(Facebook AI Research)发布 PyTorch。

PyTorch在Torch基础上用 python 语言重新打造的一款深度学习框架。- Torch 是采用 Lua 语言为接口的机器学习框架,但因为 Lua 语言较为小众,导致 Torch 学习成本高,因此知名度不高。

Pytorch 是基于 Python 的科学计算库,加速深度学习应用

- PyTorch 工作流程非常接近 科学计算库 NumPy

- PyTorch 提供类似 NumPy 的抽象方法来表征

张量(或多维数组),利用 GPU 来加速训练。

深度学习框架

【2022-4-8】中国开源深度学习框架第六年:百度飞桨国内综合份额第一,全球开发者超400万,和讯网地址

- 国际两大主流深度学习框架TensorFlow、PyTorch之外,中国的开源框架,发展怎么样?

- 百度飞桨(PaddlePaddle),深度学习开源框架的先头兵,在2016年就已率先对外发布。

- 2020年,国内开源框架迎来了第一波集中爆发。

- 独角兽旷视拿出工业级深度学习框架天元(MegEngine),一流科技OneFlow、华为昇思(MindSpore)也在同年登场。

- 学界方面,清华大学开源了支持即时编译的深度学习框架计图(Jittor)。

- 过去几年中,”开源”、”AI底层”成为了国内AI厂商们十分重视的发展战略。

发展历史

PyTorch 历史

PyTorch 发展

- 2017 年 1 月正式发布 PyTorch。

- 2018 年 4 月更新 0.4.0 版,支持 Windows 系统,caffe2 正式并入 PyTorch。

- 2018 年 11 月更新 1.0 稳定版,已成为 Github 上增长第二快的开源项目。

- 2019 年 5 月更新 1.1.0 版,支持 TensorBoard,增强可视化功能。

- 2019 年 8 月更新 1.2.0 版,更新 Torchvision,torchaudio 和torchtext,支持更多功能。

目前 PyTorch 超越 Tensorflow。

深度学习框架渊源

- 【2021-3-3】深度学习框架编年史:搞深度学习的那帮人,不是疯子,就是骗子!

- 2002年,瑞士是物理和数学领域的领跑者。也在2002年,瑞士戴尔莫尔感知人工智能(Idiap)研究所诞生了第一个机器学习库Torch。

- 机器学习库Torch,出自”葡萄酒产区”研究所的一份研究报告(三位作者分别是:Ronan Collobert、Samy Bengio、Johnny Mariéthoz)。其中一位作者姓本吉奥(Bengio),没错,这位眉毛粗粗的科学家,就是深度学习三巨头之一,约舒亚·本吉奥(Yoshua Bengio)的兄弟。2007年他跳槽去了谷歌。

- 2007年,加拿大蒙特利尔大学开发了第一个深度学习框架Theano(行业祖师爷)。框架和图灵奖获得者颇有渊源,约舒亚·本吉奥(Yoshua Bengio)和伊恩·古德费洛(Ian Goodfellow)都有参与Theano。

- 库和框架的不同之处,在于境界。库是兵器库,框架则是一套武林绝学的世界观,程序员在这个世界观的约束下去练(编)拳(程)法(序),结果被框架所调用。框架接管了程序的主控制流。有了框架,才能做到只关注算法的原理和逻辑,不用去费事搞定底层系统、工程的事。

- 2013年,著名的Caffe框架诞生,发音和”咖啡”相似,是”快速特征提取的卷积框架”论文的英文简称。贾扬清第一个C++项目

- 贾扬清已经在美国加州大学伯克利分校攻读博士学位,开启了计算机视觉的相关研究。那时候,他常被一个问题困扰:怎样训练和设计深度学习的网络?为此,贾扬清想造一个通用工具。

- 2013年,Parameter Server(参数服务器)的两位著名教授走向台前,邢波(Eric Xing)教授和Alex Smola教授,现在两位均在美国卡内基梅隆大学(CMU)任教。

- 参数服务器是个编程框架,也支持其他AI算法,对深度学习框架有重要影响。

- 高校实验室善于技术创新,深度学习框架的很多精髓创意源于此地。但是,深度学习框架复杂性高、工程量极大,长期负责复杂产品,高校并不擅长。多年后,高校出生的深度学习框架,都以某种方式”进入”企业,或者被企业赶超

- 2015年11月,谷歌大脑团队开发的TensorFlow开源,原创者之一是谷歌天才科学家,杰夫·迪恩(Jeff Dean)。谷歌的搜索、油管、广告、地图、街景和翻译的背后,都有其身影。

- TensorFlow直译,张量(tensor)在图中流动(flow)。由此也可获知,数据流图是框架的重要技术。数据流图由算子组成,算子又分为大算子和小算子。Caffe是大算子抽象,TensorFlow是小算子抽象。小算子好处是灵活,坏处是性能优化难。

- 在2000年下半年的时候,Jeff Dean的代码速度突然激增了40倍,原因是他把自己的键盘升级到了USB 2.0。编译器从来不会给Jeff Dean警告,但Jeff Dean会警告编译器。—— 段子

- 2015 年是一个重要的年份,何恺明等人的研究成果,突破了边界,在准确率上再创新高,风头一时无二。

- 2015年,谷歌AI研究员弗朗索瓦·乔莱特(Francois Chollet)几乎是独自完成了著名的Keras 框架的开发,为谷歌再添一条护城河,大有”千秋万代,一统江湖”的势头。

- 2016年,微软CNTK(Cognitive Toolkit)伸手接过女神(内部孵化项目Minerva)的接力棒,可惜魔障难消,用的人少,没有推广开,于2019年停止维护。

- 2016年,贾扬清从谷歌TensorFlow团队离职,跳槽到了Facebook公司。与谷歌挥手道别,四载光阴(实习两年,工作两年),往事依稀,他的内心充满感怀。

- 2016年5月,陈天奇读博二开发的MXNet(读作”mixnet”,mix是中文”混合”之意)开源,浓缩了当时的精华,合并了几个原来有的项目,陈天奇cxxnet、参数服务器、智慧女神、颜水成学生林敏的purine2。仅一年时间里,就做出了完整的架构。团队中还有一位闻名遐迩的大神,李沐(现任亚马逊公司资深主任科学家,principal scientist)。2017年9月,MXNet被亚马逊选为官方开源平台。

- 2017年,祖师爷Theano官宣退休。贾扬清借鉴谷歌TensorFlow框架里面的一些新思想,实现了一个全新的开源Caffe2。三十而立的他,成长为遍历世界级产品的第一高手。

- 2018年,PyTorch接纳Caffe2后,意外崛起,上演令谷歌框架王冠落地的戏剧性一幕。易用性确实可以抢客户,但谷歌没有想到脸书抢了这么多。后来者确实可以居上,但谷歌没有想到脸书仅用如此短的时间。

- 谷歌出发最早,为何没有独坐钓鱼台?为什么是脸书抢了市场?

- 谷歌野心非常大,初期想做很大很全的工具。虽然完备性很强,但是,系统过度复杂。虽然以底层操作为主,有很多基础的功能,但是这些功能没能封装得很好,需要开发者自己解决(定义),手动工作过多。

- 仅仅是丢市场还不够惨,PyTorch框架带火了背后的技术(动态执行等),脸书开始左右技术趋势。

- 微软在智慧女神和CNTK两次滑铁卢之后,依然斗志昂扬准备第三次入局。微软思路清奇地设计了ONNX(全称Open Neural Network Exchange),一种开放式深度学习神经网络模型的格式,用于统一模型格式标准。

- 2016 年8月,百度PaddlePaddle开源,PaddlePaddle作为国内唯一的开源深度学习框架,此后两年多,都是孤家寡人。2013年,百度第一位T11徐伟,同时也是百度深度学习框架PaddlePaddle的原创者和奠基人。

- 2019年,百度PaddlePaddle有了中文名,名叫”飞桨”。国外产品连个中文名都懒得起。

- 2019年2月,一流科技获得千万级Pre-A轮投资,袁进辉是创始人兼CEO。邢波教授团队和袁进辉团队双剑合璧开发了OneFlow

- 2014年,微软亚研院副院长马维英(现任清华大学智能产业研究院讲席教授、首席科学家)找到一位研究员,名叫袁进辉,他是清华大学计算机专业的博士,师从张钹院士。

- 来自美国CMU的教授,名叫邢波,此时任微软亚研院顾问一职,他擅长的领域包括大规模计算系统。

- 2020年,国产深度学习框架井喷。国产深度学习框架的”元年”。

- 3月20日,清华大学计图(Jittor)。

- 3月25日,旷视科技天元(MegEngine) 。

- 3月28日,华为MindSpore。

- 7月31日,一流科技OneFlow。OneFlow有两个创新点:一会自动安排数据通信。二把数据通信和计算的关系协调好,让整体效率更高。

- 守旧的经验是,既然国外开源了,就抓紧学。既然人家成了事实工业标准,就尽力参与。总是慢了好几拍,Linux这轮就是这样。

- 引用某游戏厂商的经典台词是:”别催了,在抄了,在抄了。”

- 可惜竞争从来不是游戏。

- 深度学习框架的台词是:”不能照抄,不能舔狗,舔到最后,一无所有。”

- 这世界上唯一能够碾压国内一线城市房价增速的,只有AI模型的规模,虽然硬件和软件的进步已经将每年的训练成本降低了37%;但是,AI模型越来越大,以每年10倍的速度增长。

- 前美国国防部咨询顾问,史蒂夫·马奎斯的说法是:”开源项目,来源于最纯粹的竞争。如果一个开源项目在商业世界获得了成功,那决不会是出于侥幸,决不会是因为其它竞争者恰好被规章制度所累、被知识产权法约束、被人傻钱多的金主拖垮。一个开源项目胜出了,背后只会有一个原因——它真的比其他竞争者都要好。”

PyTorch 优缺点

PyTorch 优点

PyTorch 优点

- 上手快,掌握 Numpy 和基本深度学习概念即可上手。

- 支持 Python:PyTorch 可与 Python 数据科学栈相结合

- 与 NumPy 一样简单,甚至都感觉不出区别

- 代码简洁灵活:

- 用

nn.Module封装, 网络搭建更加方便。 - 基于

动态图机制,更加灵活。

- 用

- 资源多

- arXiv 中新论文的算法大多有 PyTorch 实现。

- 开发者多

- Github 上贡献者(Contributors)已经超过 1100+

动态计算图:- PyTorch 不再采用特定函数预定义计算图,而是提供构建

动态计算图框架,甚至可在运行时修正。 - 这种动态框架在不知道所构建的神经网络需要多少内存时非常有用。

- PyTorch 不再采用特定函数预定义计算图,而是提供构建

- 其它:

- 还有多 GPU 支持、自定义数据加载器和极简的预处理过程等

Tensorflow v.s. Pytorch

结论:

- 如果是工程师,应该优先选TensorFlow2.

- 如果是学生/研究人员,应该优先选择Pytorch.

- 如果时间足够,最好TensorFlow2和Pytorch都要学习掌握。

- 理由如下:

- 1,在工业界最重要的是模型落地,目前国内的大部分互联网企业只支持TensorFlow模型的在线部署,不支持Pytorch。 并且工业界更加注重的是模型的高可用性,许多时候使用的都是成熟的模型架构,调试需求并不大。

- 2,研究人员最重要的是快速迭代发表文章,需要尝试一些较新的模型架构。而Pytorch在易用性上相比TensorFlow2有一些优势,更加方便调试。 并且在2019年以来在学术界占领了大半壁江山,能够找到的相应最新研究成果更多。

- 3,TensorFlow2和Pytorch实际上整体风格已经非常相似了,学会了其中一个,学习另外一个将比较容易。两种框架都掌握的话,能够参考的开源模型案例更多,并且可以方便地在两种框架之间切换。

- Keras库在2.3.0版本后将不再更新,用户应该使用tf.keras

总结:

- (1)模型可用性:pytorch更好

- (2)部署便捷性:TensorFlow更好

- Serving 和 TFLite 比 PyTorch 的同类型工具要稳健一些。而且,将 TFLite 与谷歌的 Coral 设备一起用于本地 AI 的能力是许多行业的必备条件。相比之下,PyTorch Live 只专注于移动平台,而 TorchServe 仍处于起步阶段。

- 既想用 TensorFlow 的部署基础设施,又想访问只能在 PyTorch 中使用的模型,作者推荐使用 ONNX 将模型从 PyTorch 移植到 TensorFlow。

- (3)生态系统对比:TensorFlow 胜出

2022年了,PyTorch和TensorFlow你选哪个?

选择指南:

- (1)

工程师- TensorFlow 强大的部署框架和端到端的 TensorFlow Extended 平台是很珍贵的。能在 gRPC 服务器上进行轻松部署以及模型监控和工件跟踪是行业应用的关键

- 仅在 PyTorch 中可用的 SOTA 模型,那也可以考虑使用 PyTorch(TorchServe)

- 移动应用,也可以用pytorch live

- 音频或视频输入,应该使用 TensorFlow

- 用 AI 的嵌入式系统或 IoT 设备,鉴于 TFLite + Coral 生态系统,用tf

- (2)

研究者- 大概率会使用 PyTorch,坚持使用,大多数 SOTA 模型都适用于 PyTorch;

- 但强化学习领域的一些研究应该考虑使用 TensorFlow。原生 Agents 库,并且 DeepMind 的 Acme框架和Sonnet

- 想用TPU训练,但不想用TensorFlow,那考虑探索谷歌的JAX。JAX 本身不是神经网络框架,而是更接近于具有自动微分能力的 GPU/TPU 的 NumPy 实现。

- 不用TPU 训练,那最好是坚持使用 PyTorch

- (3)

教授,因课程重点而已- 培养具备行业技能的深度学习工程师,胜任整个端到端深度学习任务,而不仅仅是掌握深度学习理论,那应该使用 TensorFlow

- 深度学习理论和理解深度学习模型的底层原理/高级课程/研究,那应该使用 PyTorch。

- (4)

职业转型- 对框架完全不熟悉,请使用 TensorFlow,因为它是首选的行业框架。

- (5)

业余爱好者- 大项目,部署到物联网/嵌入式设备,TensorFlow + TFLite

- 了解深度学习,PyTorch

- 入门即可,keras

HuggingFace 使得深度学习从业者仅借助几行代码就能将训练、微调好的 SOTA 模型整合到其 pipeline 中。

- HuggingFace中大约有85%的模型只能在PyTorch上用,剩下的模型还有一半也可以在 PyTorch 上用。

- 相比之下,只有16%的模型能在 TensorFlow 上用,只有 8% 是 TensorFlow 所独有的。

- Top 30 个模型中,能在 TensorFlow 上用的还不到 2/3,但能在 PyTorch 上用的却达到了 100%,没有哪个模型只能在 TensorFlow 上用。

- 8个顶级研究期刊论文中框架采用情况:PyTorch 的采用率增长迅速,几年时间就从原来的 7% 长到了近 80%。 很多转向 PyTorch 的研究者都表示 TensorFlow 1 太难用了。尽管 2019 年发布的 TensorFlow 2 改掉了一些问题,但彼时,PyTorch 的增长势头已经难以遏制。

- 2018 年还在用 TensorFlow 的论文作者中,有 55% 的人在 2019 年转向了 PyTorch,但 2018 年就在用 PyTorch 的人有 85% 都留了下来。

- Papers with Code 本季度创建的 4500 个库中,有 60% 是在 PyTorch 中实现的,只有 11% 是在 TensorFlow 中实现的。相比之下,TensorFlow 的使用率在稳步下降,2019 年 TensorFlow 2 的发布也没有扭转这一趋势。

大公司:

- Google AI:谷歌发布的论文自然会用 TensorFlow。鉴于在论文方面谷歌比 Facebook 更高产,一些研究者可能会发现掌握 TensorFlow 还是很有用的。

- DeepMind:DeepMind 也用 TensorFlow,而且也比 Facebook 高产。他们创建了一个名叫 Sonnet 的 TensorFlow 高级 API,用于研究目的。有人管这个 API 叫「科研版 Keras」,那些考虑用 TensorFlow 做研究的人可能会用到它。此外,DeepMind 的 Acme 框架可能对于强化学习研究者很有用。

- OpenAI:OpenAI 在 2020 年宣布了全面拥抱 PyTorch 的决定。但他们之前的强化学习基线库都是在 TensorFlow 上部署的。基线提供了高质量强化学习算法的实现,因此 TensorFlow 可能还是强化学习从业者的最佳选择。

- JAX:谷歌还有另一个框架——JAX,它在研究社区中越来越受欢迎。与 PyTorch 和 TensorFlow 相比,JAX 的开销要小得多。但同时,JAX 和前两个框架差别也很大,因此迁移到 JAX 对于大多数人来说可能并不是一个好选择。目前,有越来越多的模型 / 论文已经在用 JAX,但未来几年的趋势依然不甚明朗。

模型部署

TensorFlow Serving:

- TensorFlow Serving 用于在服务器上部署 TensorFlow 模型,无论是在内部还是在云上,并在 TensorFlow Extended(TFX)端到端机器学习平台中使用。Serving 使得用模型标记(model tag)将模型序列化到定义良好的目录中变得很容易,并且可以选择在保持服务器架构和 API 静态的情况下使用哪个模型来进行推理请求。

- Serving 可以帮用户轻松地在 gRPC 服务器上部署模型,这些服务器运行谷歌为高性能 RPC 打造的开源框架。gRPC 的设计意图是连接不同的微服务生态系统,因此这些服务器非常适合模型部署。Serving 通过 Vertex AI 和 Google Cloud 紧密地集成在一起,还和 Kubernetes 以及 Docker 进行了集成。

TensorFlow Lite:

- TensorFlow Lite 用于在移动或物联网 / 嵌入式设备上部署 TensorFlow 模型。TFLite 对这些设备上的模型进行了压缩和优化,并解决了设备上的 AI 的 5 个约束——延迟、连接、隐私、大小和功耗。可以使用相同的 pipeline 同时导出基于标准 Keras 的 SavedModels(和 Serving 一起使用)和 TFLite 模型,这样就能比较模型的质量。

- TFLite 可用于 Android、iOS、微控制器和嵌入式 Linux。TensorFlow 针对 Python、Java、C++、JavaScript 和 Swift 的 API 为开发人员提供了广泛的语言选项。

PyTorch 用户需要使用 Flask 或 Django 在模型之上构建一个 REST API,但现在他们有了 TorchServe 和 PyTorch Live 的本地部署选项。

TorchServe:

- TorchServe 是 AWS 和 Facebook 合作的开源部署框架,于 2020 年发布。它具有端点规范、模型归档和指标观测等基本功能,但仍然不如 TensorFlow。TorchServe 同时支持 REST 和 gRPC API。

PyTorch Live:

- PyTorch 于 2019 年首次发布 PyTorch Mobile,旨在为部署优化的机器学习模型创建端到端工作流,适用于 Android、iOS 和 Linux。

- PyTorch Live 于 12 月初发布,以移动平台为基础。它使用 JavaScript 和 React Native 来创建带有相关 UI 的跨平台 iOS 和 Android AI 应用。设备上的推理仍然由 PyTorch Mobile 执行。Live 提供了示例项目来辅助入门,并计划在未来支持音频和视频输入。

生态系统

PyTorch 2024 研讨会

【2024-10-14】PyTorch 2024 Conference-亮点内容

PyTorch 2024 研讨会议近期结束了,主要内容涵盖通用AI、LLM、分布式、边缘计算等,邀请了开发者、供应商和周边团队。

LLM 相关内容

- 原生接口LLM库:

TorchTian、TorchTune、TorchChat; - 编译库: torchao;FSDP2;vLLM

SD(Speculative Decoding)的内容,可以搜索一下(柳晓萱)的论文:Optimizing Speculative Decoding for Serving Large Language Models Using Goodput。

2024年推出torch原生三大件:TorchTian、TorchTune、TorchChat

TorchTian: Pre-Training 预训练阶段使用TorchTune: Fine-Tuning 微调阶段使用TorchChat: Inference 推理阶段使用

TorchTian

TorchTian 分布式训练服务模块,结合pytorch图编译complie以及ao量化。

主要特性:并行策略、分布式CKPT、高性能训练

- 并行策略, 还是三个:区分维度是GPU数量,而非模型参数量

- 数据并行:DDP+FSDP。 适配场景 <= 512 GPU 训练。

- FSDP承担了ZeRO功能

- 张量并行:TP/seq。 <=2K GPU;

- PP并行:解决超过2K场景训练;

- 数据并行:DDP+FSDP。 适配场景 <= 512 GPU 训练。

区别

- 原生支持 torch.compile,以及FSDP的进化->v2

追赶并超越 Megtron/Deepspeed/colossalAI 类的框架,可能得依靠原生(Native)这个力量。

TorchTune

TorchTune 库主打原生

tune 特点(或者说它期望的目标)侧重内存效率和性能:

目前支持主流模型,但还不支持如Deepseek、Claude、Yi等榜上有名的模型

TorchChat

Chat属于端侧部署模块,瞄准服务器以及小型终端(PC、手机)的部署的应用。

终端的算力体量虽然没有服务器的大,但是作为生态的一个重要板块能够很好的抓住用户。

当前已支持Llama 3.2 11B 模型部署,而且支持的硬件系统多:

- Linux (x86)

- Mac OS (M1/M2/M3)

- Android (Devices that support XNNPACK)

- iOS 17+ and 8+ Gb of RAM (iPhone 15 Pro+ or iPad with Apple Silicon)

Pytorch 生态

Hub:- PyTorch Hub 作为面向研究的官方平台,用于与预训练模型共享存储库。Hub 拥有广泛类别的模型,包括用于音频、视觉、NLP 任务的模型,还有用于生成任务的 GAN 模型。

SpeechBrain:- SpeechBrain 是 PyTorch 的官方开源语音工具包。SpeechBrain 能够完成自动语音识别(ASR)、说话人识别、验证和分类等任务。如果你不想构建任何模型,而是想要一个具有情感分析、实体检测等功能的即插即用工具,可以选择使用 AssemblyAI 的 Speech-to-Text API。

- 当然,PyTorch 的工具页面还有很多其他有用的库,包括为计算机视觉和自然语言处理量身定制的库,例如 fast.ai。

TorchElastic:- TorchElastic 是 AWS 和 Facebook 2020 年联合发布的分布式训练工具,可管理工作进程并协调重启行为,以便用户在计算节点集群上训练模型,这些节点可以动态变化而不会影响训练。因此,TorchElastic 可防止因服务器维护或网络问题等导致的灾难性故障,不会丢失训练进度。TorchElastic 具有与 Kubernetes 集成的特性,并已集成到 PyTorch 1.9+ 中。

TorchX:- TorchX 是一个用于快速构建和部署机器学习应用程序的 SDK。TorchX 包括 Training Session Manager API,可在支持的调度程序上启动分布式 PyTorch 应用程序。TorchX 负责启动分布式作业,同时原生支持由 TorchElastic 局部管理的作业。

Lightning:- PyTorch Lightning 有时被称为 PyTorch 的 Keras。虽然这种类比并不准确,但 Lightning 的确是简化 PyTorch 中模型工程和训练过程的有用工具,自 2019 年首次发布以来已经逐渐趋于成熟。Lightning 以面向对象的方式处理建模过程,定义了可重用和可跨项目使用的可共享组件。

【2023-7-9】 torchkeras 详见介绍

- torch4keras 功能: 像使用keras一样使用pytorch, 是从 bert4torch 中抽象出来的 trainer, 适用于一般神经网络的训练,用户仅需关注网络结构代码的实现,而无需关注训练工程代码

功能介绍

- 模型训练: 模型训练过程和keras很相似

- model.compile(optimizer,loss, scheduler,metric) 指定loss, 优化器,scheduler,mertrics;

- model.fit(train_dataloader, epoch, steps_per_epoch) 进行模型训练

- 特色功能:

- 进度条展示训练过程;

- 自带和自定义metric;

- 自带Evaluator, Checkpoint, Tensorboard, Logger等keras自带的Callback,也可自定义Callback;

- 支持dp和ddp的多卡训练

- 设计初衷:前期功能是作为bert4torch和rec4torch的Trainer,用户可用于各类pytorch模型训练

TorchServe

- 【2020-4-27】PyTorch 1.5 发布,与AWS联手推出TorchServe

- PyTorch 1.5 发布,升级了主要的 torchvision (视觉),torchtext(文本) 和 torchaudio(语音) 库,并推出将模型从 Python API 转换为 C++ API 等功能。

- Facebook 还和 Amazon 合作,推出了两个重磅的工具:TorchServe 模型服务框架 和 TorchElastic Kubernetes 控制器。

- TorchServe 旨在为大规模部署 PyTorch 模型推理,提供一个干净、兼容性好的工业级路径。

- TorchElastic Kubernetes 控制器,可让开发人员快速使用 Kubernetes 集群,在 PyTorch 中创建容错分布式训练作业。

- 【2021-1-19】pytorch模型部署工具TorchServe

如何评价 PyTorch 在 2020 年 4 月推出的 TorchServe?

- TorchServe 旨在为大规模部署 PyTorch 模型推理,提供一个干净、兼容性好的工业级路径。其主要的特点包括有:

- 原生态 API:支持用于预测的推理 API,和用于管理模型服务器的管理 API。

- 安全部署:包括对安全部署的 HTTPS 支持。

- 强大的模型管理功能:允许通过命令行接口、配置文件或运行时 API 对模型、版本和单个工作线程进行完整配置。

- 模型归档:提供执行「模型归档」的工具,这是一个将模型、参数和支持文件打包到单个持久工件的过程。使用一个简单的命令行界面,可以打包和导出为单个「.mar」文件,其中包含提供 PyTorch 模型所需的一切。该 .mar 文件可以共享和重用。

- 内置的模型处理程序:支持涵盖最常见用例,如图像分类、对象检测、文本分类、图像分割的模型处理程序。TorchServe 还支持自定义处理程序。

- 日志记录和指标:支持可靠的日志记录和实时指标,以监视推理服务和端点、性能、资源利用率和错误。还可以生成自定义日志并定义自定义指标。

- 模型管理:支持同时管理多个模型或同一模型的多个版本。你可以使用模型版本回到早期版本,或者将流量路由到不同的版本进行 A/B 测试。

- 预构建的图像:准备就绪后,可以在基于 CPU 和 NVIDIA GPU 的环境中,部署 TorchServe 的 Dockerfile 和 Docker 镜像。

- 综上可知,这次的 TorchServe 在推理任务上,将会有很大的使用空间,对于广大开发者来说是一件好事。这一点可以留着以后去慢慢验证。对于这次 Facebook 和 AWS 合作,明显可以看出双方在各取所长,试图打造一个可以反抗谷歌 TensorFlow 垄断的方案。

- 问题:

- 为什么 TorchServe 采用 Java 开发,而没有像 TensorFlow Serving 一样采用更好性能的C++,抑或是采用 Golang?

- TorchServe Architecture

- Model Server for PyTorch Documentation

Basic Features

- Serving Quick Start - Basic server usage tutorial

- Model Archive Quick Start - Tutorial that shows you how to package a model archive file.

- Installation - Installation procedures

- Serving Models - Explains how to use

torchserve. - Packaging Model Archive - Explains how to package model archive file, use

model-archiver. - Logging - How to configure logging

- Metrics - How to configure metrics

- Batch inference with TorchServe - How to create and serve a model with batch inference in TorchServe

- Model Snapshots - Describes how to use snapshot feature for resiliency due to a planned or unplanned service stop

Advanced Features

- Advanced settings - Describes advanced TorchServe configurations.

- Custom Model Service - Describes how to develop custom inference services.

- Unit Tests - Housekeeping unit tests for TorchServe.

- Benchmark - Use JMeter to run TorchServe through the paces and collect benchmark data

Default Handlers

- Image Classifier - This handler takes an image and returns the name of object in that image

- Text Classifier - This handler takes a text (string) as input and returns the classification text based on the model vocabulary

- Object Detector - This handler takes an image and returns list of detected classes and bounding boxes respectively

- Image Segmenter - This handler takes an image and returns output shape as [CL H W], CL - number of classes, H - height and W - width

端侧部署 ExecuTorch

【2023-10-18】端侧AI推理,高效部署PyTorch模型:官方新工具,Meta已经用上了

2023 年 PyTorch 大会宣布了一个用于在边缘和移动设备上实现 AI 推理的解决方案: ExecuTorch

ExecuTorch 理解成一个 PyTorch 平台,其能提供基础设施来运行 PyTorch 程序,从 AR/VR 可穿戴设备到标准的 iOS 和 Android 设备的移动部署。

ExecuTorch 最大优势是可移植性,能够在移动和嵌入式设备上运行。不仅如此,ExecuTorch 还可以提高开发人员的工作效率。

ExecuTorch 可以有效地将 PyTorch 模型部署到边缘设备。ExecuTorch 的优点包括:

- 可移植性:与各种计算平台兼容,从高端移动手机到高度受限的嵌入式系统和微控制器。

- 提高生产力:开发人员能够使用相同的工具链和 SDK,从而提高生产力。

- 提高性能:由于轻量级运行时和充分利用 CPU、NPU 和 DSP 等硬件功能,为最终用户提供了无缝和高性能的体验。

由于 ExecuTorch 严重依赖 PyTorch 相关知识,因而想要熟练掌握 ExecuTorch,还需提前补充相关知识。官方文档已经提供了入门级教程。例如,在构建 ExecuTorch Android 演示应用程序示例当中,大家可以跟随指导教程,从而熟悉如何使用 ExecuTorch。

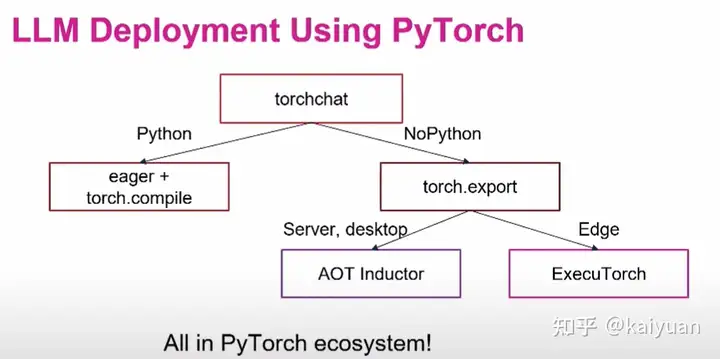

torchchat

【2024-7-30】 PyTorch 发布 torchchat,使得在本地运行 LLM 变得非常容易。 🔥

- 支持多种型号,包括 Llama 3.1。

- 可以在服务器、桌面甚至移动设备上使用它。

- 实现起来非常简单

- 提供 Python 和本机执行模式。它还支持 eval 和量化。

官方介绍

PyTorch 教程

PyTorch 的设计哲学是解决当务之急,也就是说即时构建和运行计算图。

PyTorch 基于python的科学计算包,针对两类受众:

- 代替Numpy从而利用GPU的强大功能;

- 提供最大灵活性和速度的深度学习研究平台。

PyTorch 是一个建立在 Torch 库之上的 Python 包,旨在加速深度学习应用。

- PyTorch 提供一种类似 NumPy 的抽象方法来表征张量(或多维数组),利用 GPU 来加速训练。

TorchRL

TorchRL 是一个基于PyTorch的强化学习(Reinforcement Learning, RL)库,专为研究人员和开发者设计,提供一个灵活、高效的框架来实现和实验各种RL算法。

- 与

PyTorch深度集成:TorchRL 充分利用了PyTorch 生态系统,使用户能够无缝地将RL算法与深度学习模型结合。 - 模块化设计:库提供了可组合的组件,允许用户轻松构建和定制RL算法。

- 高性能:TorchRL注重效率,支持GPU加速和并行化,以加快训练和推理速度。

- 多环境支持:兼容多种RL环境,包括 OpenAI Gym、DeepMind Control Suite等。

- 丰富的算法实现:内置多种流行的RL算法,如 DQN、PPO、SAC等。

- 扩展性:易于扩展和添加新的算法、环境和功能。

【2024-9-7】Python TorchRL 进行多代理强化学习

pytorch 提供的框架, 开发和实验多代理强化学习(MARL)算法

用 VMAS 模拟器,这是一个多机器人模拟器并且可以在 GPU 上进行并行训练

pip3 install torchrl

pip3 install vmas

pip3 install tqdm

PPO 中, 学习过程依赖于一个评论家(critic), 评估策略所采取行动的质量。

评论家估计给定状态的价值,通过比较预期回报与实际结果来指导策略优化。

在多代理设置中, 部署多个策略,每个代理一个,通常以分散方式运作。每个代理的策略仅根据其局部观察来决定其行动。但是评论家可以是集中或分散:

MAPPO: 评论家集中,以全局观察或连接的代理观察作为输入。这种方法在可获得全局状态信息的集中式训练场景中有益。IPPO: 评论家分散,仅依赖于局部观察。这种设置支持分散式训练,代理只需要局部信息。

集中式评论家有助于缓解多个代理同时学习时出现的非平稳性问题,但可能因输入的高维度性而面临挑战。

资料

资料

- PyTorch 学习笔记:Colab, GitHub

- 【2024-3-28】站内 pytorch手册

- w3c pytorch 入门系列教程

- 国外 PyTorch Zero to All

- PyTorch 中文教程, Deep-Learning-with-PyTorch-Tutorials, 含pdf

- 深度学习网络架构的pytorch实现, ppt, Google Docs

- 【2023-2-20】李宏毅学生萧淇元的pytorch ppt, 李宏毅春季机器学习课程, 含 GPT/扩散等知识

【2024-10-18】pytorch 学习指南

- DL-with-Python-and-PyTorch2

- 2018年, pytorch-tutorial 含 速成代码, 用 RNN/MLP/CNN 实现 mnist

git clone https://github.com/hpzhao/pytorch-tutorial.git

安装

- 根据提示分别选择系统(Linux、Mac 或者 Windows),安装方式(Conda,Pip,LibTorch 或者源码安装)、编程语言(Python 2.7 或者 Python 3.5,3.6,3.7 或者是 C++),

Python 版本和某些库版本不一致时,会导致冲突。

为了减少冲突,用 Anaconda 管理多个 Python 虚拟环境。

Pytorch

安装:

pip install torch

pip install torchvision # 视觉数据集

pip install torchtext # 文本数据集

pip install torchaudio # 音频数据集

验证:

python -c "import torch;x = torch.rand(5, 3);print(x)"

GPU

PyTorch 是一个张量和动态神经网络 Python 库,GPU 加速性能极其强大。

- 可直接定义 GPU 张量,或由 CPU 张量转化为 GPU 张量

CUDA 接口

PyTorch 优势之一是为张量和 autograd 库提供 CUDA 接口。

使用 CUDA GPU,不仅可以加速神经网络训练和推断,还可以加速任何映射至 PyTorch 张量的工作负载

cpu/gpu 检测

如何检查 PyTorch 是 GPU 还是 CPU版?

准备工作

- GPU 驱动检测: nvidia-smi, 显示 cuda 版本, 如 12.2

- 安装 PyTorch GPU 版: 官网选择对应环境信息后,出现安装命令

- pip3 install torch torchvision torchaudio –index-url https://download.pytorch.org/whl/cu121 -i https://pypi.tuna.tsinghua.edu.cn/simple

以下命令:

import torch

torch.cuda.is_available() # True,是否启用gpu

cuda_gpu =torch.cuda.is_available()

if cuda_gpu:

print("Great, you have a GPU!")

print('GPU数目: ', torch.cuda.device_count())#1

print('当前GPU编号: ', torch.cuda.current_device())#0

print('GPU设备地址: ', torch.cuda.device(0))#<torch.cuda.device at 0x7efce0b3be0>

print('GPU型号: ', torch.cuda.get_device_name(0))#'GeForce GTX 950M'

else:

print("Life is short -- consider a GPu!")

gpu 信息获取

torch.cuda.device_count() # 1

torch.cuda.current_device() # 0

torch.cuda.device(0) # <torch.cuda.device at 0x7efce0b03be0>

torch.cuda.get_device_name(0) # 'GeForce GTX 950M'

gpu 加速

使用 cuda 加速

- 张量上调用

.cuda(),则将执行从 CPU 到 CUDA GPU 的数据迁移。 - 模型上调用

.cuda(),则不仅将所有内部储存移到 GPU,还将整个计算图映射至 GPU。 - 将张量或模型复制回 CPU,比如和 NumPy 交互,可以调用

.cpu()。

x = torch.cuda.HalfTensor(5, 3).uniform_(-1, 1)

if cuda_gpu:

x = x.cuda()

print(type(x.data))

x = x.cpu()

print(type(x.data))

# --------------

x = torch.cuda.HalfTensor(5, 3).uniform_(-1, 1)

y = torch.cuda.HalfTensor(3, 5).uniform_(-1, 1)

z = torch.matmul(x, y)

# CPU张量 -> GPU张量

x = torch.FloatTensor(5, 3).uniform_(-1, 1)

x = x.cuda(device=0) # cpu -> gpu

x = x.cpu() # gpu -> cpu

问题

【2023-2-20】安装GPU版本(CPU版本执行时报错,找不到CUDA,实际上路径存在)

# 如:cuda 11.3, python 3.7.3时

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

问题

gcc 版本低

【2024-3-27】GPU上启动InternLM训练时,中途报错

错误信息

You're trying to build PyTorch with a too old version of GCC. We need GCC 9 or later

原因

- PyTorch版本过高,而系统 gcc版本又太低(<9.0)

解决办法: 更新gcc

本地信息

gcc -v

# gcc version 8.3.0 (Debian 8.3.0-6)

cuda 11.6

pytorch 2.2.1

解法

- ① make 源码编译,参考

- ② conda

conda install -c 3dhubs gcc-5

fused_adam

【2024-3-27】GPU上启动InternLM训练时,中途报错

- gcc 版本低 → ninja 执行有误 → 构建 fused_adam 错误

# ① gcc 问题

You're trying to build PyTorch with a too old version of GCC. We need GCC 9 or later

# ② ninja 问题

subprocess.CalledProcessError: Command '['ninja', '-v']' returned non-zero exit status 1.

# ③ fused_adam 问题

RuntimeError: Error building extension 'fused_adam'

数据集

【2023-1-28】PyTorch中的数据集Torchvision和Torchtext

Torchtext 数据集

IMDB:用于情感分类的数据集,其中包含一组 25,000 条高度极端的电影评论用于训练,另外 25,000 条用于测试。使用以下类加载这些数据torchtext:torchtext.datasets.IMDB()WikiText2:WikiText2语言建模数据集是一个超过 1 亿个标记的集合。- 从维基百科中提取的,并保留了标点符号和实际的字母大小写。它广泛用于涉及长期依赖的应用程序。

- 可从torchtext以下位置加载此数据:

torchtext.datasets.WikiText2()

除了上述两个流行的数据集,torchtext 库中还有更多可用的数据集,例如: SST、TREC、SNLI、MultiNLI、WikiText-2、WikiText103、PennTreebank、Multi30k 等。

数据模块细分为 4 个部分:

- 数据收集:样本和标签。

- 数据划分:训练集、验证集和测试集

- 数据读取:对应于PyTorch 的 DataLoader。

- DataLoader 包括

Sampler和DataSet。 - Sampler 生成索引

- DataSet 根据生成索引读取样本以及标签。

- DataLoader 包括

- 数据预处理:对应于 PyTorch 的 transforms

datasets

Torchvision 中的数据集

MNIST: 手写数字识别,超过 60,000 张训练图像和 10,000 张测试图像Fashion MNIST:类似于MNIST,但该数据集包含T恤、裤子、包包等服装项目,而不是手写数字,训练和测试样本数分别为60,000和10,000。EMNIST:EMNIST数据集是 MNIST 数据集的高级版本。它由包括数字和字母的图像组成。如果正在处理基于从图像中识别文本的问题,EMNIST是一个不错的选择。CIFAR:CIFAR数据集有两个版本,CIFAR10和CIFAR100。CIFAR10 由 10 个不同标签的图像组成,而 CIFAR100 有 100 个不同的类。这些包括常见的图像,如卡车、青蛙、船、汽车、鹿等。COCO:COCO数据集包含超过 100,000 个日常对象,如人、瓶子、文具、书籍等。这个图像数据集广泛用于对象检测和图像字幕应用IMAGE-NET:ImageNet 是用于训练高端神经网络的旗舰数据集之一。它由分布在 10,000 个类别中的超过 120 万张图像组成。通常,这个数据集加载在高端硬件系统上,因为单独的 CPU 无法处理这么大的数据集。

torch.utils.data.Dataset

功能:

- Dataset 是抽象类,所有自定义的 Dataset 都需要继承该类,并且重写

__getitem__()方法和__len__()方法 。__getitem__方法的作用是接收一个索引,返回索引对应的样本和标签,这是自己需要实现的逻辑。__len__()方法是返回所有样本的数量。

数据读取包含 3 个方面

- 读哪些数据:每个 Iteration 读取一个 Batchsize 大小的数据,每个 Iteration 应该读取哪些数据。

- 从哪里读取数据:如何找到硬盘中的数据,应该在哪里设置文件路径参数

- 如何读取数据:不同文件需要使用不同的读取方法和库

pytorch 数据读取流程图

- 首先在 for 循环中遍历 DataLoader

- 然后根据是否采用多进程,决定使用单进程或者多进程的 DataLoaderIter。

- 在DataLoaderIter 里调用Sampler生成 Index 的 list

- 再调用 DatasetFetcher 根据index获取数据。

- DatasetFetcher里会调用Dataset的

__getitem__()方法获取真正的数据。这里获取的数据是一个 list,其中每个元素是 (img, label) 的元组,再使用 collate_fn()函数整理成一个 list,里面包含两个元素,分别是 img 和 label 的tenser

- DatasetFetcher里会调用Dataset的

from torchvision.datasets import MNIST

# Download MNIST

data_train = MNIST('~/mnist_data', train=True, download=True)

torchvision.datasets.FashionMNIST() # fashion MNIST

torchvision.datasets.EMNIST()

torchvision.datasets.CIFAR10() # cifar10

torchvision.datasets.CIFAR100() # cifar100

torchvision.datasets.CocoCaptions() # COCO

torchvision.datasets.ImageNet() # imagenet

DataLoader

DataLoader, Sampler 和 Dataset 三者关系:

DataLoader包含Sampler(采样策略, 存数据索引) +Dataset(数据集, 存数据内容)- 两种sampler:

sampler和batch_sampler,都默认为None。sampler: 生成一系列的indexbatch_sampler: 将sampler生成的indices打包分组,得到一个又一个batch的index。

Epoch, Iteration, Batchsize: refer

Epoch: 所有训练样本都已经输入到模型中,称为1个 EpochIteration: 一批样本输入到模型中,称为1个 IterationBatchsize: 批大小,决定一个 iteration 有多少样本,也决定了1个 Epoch 有多少个 Iteration

torch.utils.data.DataLoader()

torch.utils.data.DataLoader(dataset, batch_size=1, shuffle=False, sampler=None, batch_sampler=None, num_workers=0, collate_fn=None, pin_memory=False, drop_last=False, timeout=0, worker_init_fn=None, multiprocessing_context=None)

加载原理

PyTorch 为数据分布式训练提供了多种选择。

随着应用从简单到复杂,从原型到产品,常见的开发轨迹可以是:

- 数据和模型能放入单个GPU,单设备训练,此时不用担心训练速度;

- 服务器上有多个GPU,且代码修改量最小,加速训练用单个机器多GPU

DataParallel; - 进一步加速训练,且愿意写点代码,用单个机器多个GPU

DistributedDataParallel; - 应用程序跨机器边界扩展,用多机器

DistributedDataParallel和启动脚本; - 预期有错误(比如OOM)或资源可动态连接和分离,使用

torchelastic来启动分布式训练。

要点 详见

- DataSet 把数据集数目发给 DistributedSampler。

- Sampler 按照某种规则发送数据indices给Loader。

- Loader 依据indices加载数据。

- Loader 把数据发给模型,进行训练。

参数

定义dataloader,一般接受3个重要参数

dataset: 数据集batch_size: 将数据集切分为多少份shuffle: 是否对数据集进行随机排序

DataLoader(object) 参数详解:

dataset(Dataset): 传入的数据集, Dataset 类,决定数据从哪里读取batch_size(int, optional): 每个batch有多少个样本shuffle(bool, optional): 在每个epoch开始时,对数据进行重新排序sampler(Sampler, optional): 自定义从数据集中采样策略,如果指定这个参数,那么shuffle必须为Falsebatch_sampler(Sampler, optional): 与sampler类似,但是1次只返回1个batch的indices(索引)- 一旦指定这个参数,那么

batch_size,shuffle,sampler,drop_last就不能再指定了(互斥——Mutually exclusive) - BatchSampler 是wrap一个sampler,生成mini-batch的索引(indices)的方式

- 一旦指定这个参数,那么

num_workers(int, optional): 是否多进程, 这个参数决定几个进程处理data loading。- 0 意味着所有数据都会被load进主进程。(默认为0)

collate_fn(callable, optional): 将list的sample组成一个mini-batch的函数;将1个batch的数据进行合并操作。- 默认的 collate_fn 将img和label分别合并成imgs和labels,所以如果

__getitem__方法只是返回 img, label,那么可用默认的collate_fn方法,但是如果你每次读取的数据有img, box, label等等,那么需要自定义collate_fn来将对应的数据合并成一个batch数据,这样方便后续的训练步骤。

- 默认的 collate_fn 将img和label分别合并成imgs和labels,所以如果

pin_memory(bool, optional):- 如果设置为True,那么data loader将会在返回之前,将tensors拷贝到CUDA中的固定内存(CUDA pinned memory)中.

drop_last(bool, optional): 当样本数不能被 batchsize 整除时,是否舍弃最后一批数据- 如果设置为True:对最后的未完成的batch,比如 batch_size设置为64,而一个epoch只有100个样本,那么训练时, 后面的36个就被扔掉了…

- 如果为 False(默认),那么会继续正常执行,只是最后的batch_size会小一点。

timeout(numeric, optional):- 如果是正数,等待从worker进程中收集一个batch等待的时间,若超出设定的时间还没有收集到,那就不收集这个内容了。

- 这个numeric应总是大于等于0。默认为0

worker_init_fn(callable, optional): 每个worker初始化函数- If not None, this will be called on each worker subprocess with the worker id (an int in [0, num_workers - 1]) as input, after seeding and before data loading. (default: None)

collate_fn 用法

- collate_fn 函数可对样本进一步处理(任何处理),返回值一个有结构的batch。

- 而DataLoader每次迭代的返回值就是collate_fn的返回值

indices = next(self.sample_iter)

batch = self.collate_fn([dataset[i] for i in indices])

源码

__init__()和__iter__():

(1)数据的shuffle和batch处理

- RandomSampler(dataset)

- SequentialSampler(dataset)

- BatchSampler(sampler, batch_size, drop_last)

(2)DataLoader只有__iter__()而没有实现__next__()

- 所以, DataLoader 是iterable, 而不是iterator。

- 这个iterator 实现在 _DataLoaderIter中。

class DataLoader(object):

__initialized = False

def __init__(self, dataset, batch_size=1, shuffle=False, sampler=None, batch_sampler=None,

num_workers=0, collate_fn=default_collate, pin_memory=False, drop_last=False,

timeout=0, worker_init_fn=None):

self.dataset = dataset

self.batch_size = batch_size

self.num_workers = num_workers

...

if sampler is not None and shuffle:

raise ValueError('sampler option is mutually exclusive with "shuffle"')

...

if batch_sampler is None:

if sampler is None:

if shuffle:

sampler = RandomSampler(dataset)

else:

sampler = SequentialSampler(dataset)

batch_sampler = BatchSampler(sampler, batch_size, drop_last)

self.sampler = sampler

self.batch_sampler = batch_sampler

self.__initialized = True

...

def __iter__(self):

return _DataLoaderIter(self)

...

DataLoader 用法

【2023-9-12】Pytorch中DataLoader的基本用法

DataLoader支持的两种数据集

Map格式:即 key,value形式,例如{0: '张三', 1: '李四'}Iterator格式:例如数组,迭代器等- python中,只要是for循环的数据,都是Iterator格式的数据

# list 是一个迭代器,for循环本质上调用next函数

data = [0,1,2,3,4]

for item in data:

print(item, end=' ')

# 等效写法

data = [0,1,2,3,4]

data_iter = iter(data) # 返回一个迭代器

item = next(data_iter, None) # 获取迭代器的下一个值

while item is not None:

print(item, end=' ')

item = next(data_iter, None)

Map 格式

Map格式的DataLoader

dataset = {0: '张三', 1:'李四', 2:'王五', 3:'赵六'}

dataloader = DataLoader(dataset, batch_size=2)

for i, value in enumerate(dataloader):

print(i, value)

Iterator 格式

from torch.utils.data import DataLoader

data = [i for i in range(100)] # 定义数据集,需要是一个可迭代的对象

dataloader = DataLoader(dataset=data, batch_size=6, shuffle=False)

for i, item in enumerate(dataloader): # 迭代输出

print(i, item)

输入一个数据集0~99,通过dataloader将数据集分成100/6 =17份,每份6个数据,最后一份因为不满6个,所以只返回了4个。

自定义的IterableDataset

- 可迭代对象在初始化中会调用一次

__init__方法,在获取迭代器时会调用一次__iter__方法,之后在获取元素时,每获取一个元素都会调用一次__next__方法

from torch.utils.data import DataLoader

from torch.utils.data import IterableDataset

class MyDataset(IterableDataset):

# 自定义数据集

def __init__(self):

print('init...')

def __iter__(self):

print('iter...') # 获取迭代器

self.n = 1

return self

def __next__(self):

print('next...') # 获取下一个元素

x = self.n

self.n += 1

if x >= 100: # 当x到100时停止

raise StopIteration

return x

dataloader = DataLoader(MyDataset(), batch_size=5)

for i, item in enumerate(dataloader):

print(i, item)

数据采样 Sampler

Sampler 重点:

- 如何让每个 worker 在数据集中,只加载自己所属的部分,并且worker之间实现对数据集的正交分配

已实现的Sampler 有几种:(均在torch.utils.data下)

SequentialSamplerRandomSamplerWeightedSamplerSubsetRandomSampler- 新增:

DistributedSampler分布式采样

shuffle 参数

- 若shuffle=True,则若未指定sampler,默认使用

- 若shuffle=False,则未指定sampler,默认使用

注意, DataLoader 部分初始化参数之间存在互斥关系,见源码

- 如果自定义

batch_sampler, 参数都必须用默认值:batch_size, shuffle, sampler, drop_last. - 如果自定义

sampler,那么shuffle需要设置为False - 如果

sampler和batch_sampler都为None, 那么batch_sampler使用Pytorch已经实现好的BatchSampler,而sampler分两种情况:- 若shuffle=True, 则sampler=

RandomSampler(dataset) - 若shuffle=False, 则sampler=

SequentialSampler(dataset)

- 若shuffle=True, 则sampler=

SequentialSampler

RandomSampler(dataset)、 SequentialSampler(dataset) 在 dataloader.py 同级目录下 torch/utils/data/sampler.py

from torch.utils.data import DataLoader, RandomSampler, SequentialSampler

from torch.utils.data.distributed import DistributedSampler

sampler.py 中实现了一个父类Sampler,以及SequentialSampler,RandomSampler和BatchSampler等五个继承Sampler的子类

import torch

class Sampler(object):

r"""Base class for all Samplers.

Every Sampler subclass has to provide an __iter__ method, providing a way

to iterate over indices of dataset elements, and a __len__ method that

returns the length of the returned iterators.

"""

def __init__(self, data_source):

pass

def __iter__(self):

raise NotImplementedError

def __len__(self):

raise NotImplementedError

class SequentialSampler(Sampler):

r"""Samples elements sequentially, always in the same order.

Arguments:

data_source (Dataset): dataset to sample from

"""

def __init__(self, data_source):

self.data_source = data_source

def __iter__(self):

return iter(range(len(self.data_source)))

def __len__(self):

return len(self.data_source)

class RandomSampler(Sampler):

r"""Samples elements randomly, without replacement.

Arguments:

data_source (Dataset): dataset to sample from

"""

def __init__(self, data_source):

self.data_source = data_source

def __iter__(self):

return iter(torch.randperm(len(self.data_source)).tolist())

def __len__(self):

return len(self.data_source)

if __name__ == "__main__":

print(list(RandomSampler(range(10))))

print(list(SequentialSampler(range(10))))

a = SequentialSampler(range(10))

from collections import Iterable

print(isinstance(a, Iterable))

from collections import Iterator

print(isinstance(a, Iterator))

for x in SequentialSampler(range(10)):

print(x)

print(next(a))

print(next(iter(a)))

假设有100个样本数据集,batch_size=4 时,以 SequentialSampler 和 BatchSampler 为例,Pytorch读取数据时,主要过程:

- SequentialSampler 类中的

__iter__方法返回iter(range(100))迭代器对象,对其进行遍历时,会依次得到range(100)中的每一个值,100个样本的下标索引。 BatchSampler类中__iter__使用for循环访问SequentialSampler类中的__iter__方法返回的迭代器对象,也就是iter(range(100))。当达到batch_size大小时,就使用yield方法返回。而含有yield方法为生成器也是一个迭代器对象,因此BatchSampler类中__iter__方法返回的也是一个迭代器对象,对其进行遍历时,会依次得到batch size大小的样本的下标索引。- DataLoaderIter 类会依次遍历类中的 BatchSampler 类中

__iter__方法返回的迭代器对象,得到每个batch的数据下标索引。

DistributedSampler

【2024-7-24】数据加载之DistributedSampler

对于数据并行和分布式训练,DistributedSampler 负责其数据采样的任务。

- DistributedSampler 是 Sampler 的派生类。

- 当 DistributedDataParallel 使用DistributedSampler 时,每个并行进程都会得到一个 DistributedSampler 实例,这个DistributedSampler 实例会给DataLoader发送指示,从而 DataLoader 加载具体数据。

- DistributedSampler 加载策略负责只提供加载数据集中的一个子集,这些DistributedSampler 提供的子集之间不重叠,不交叉。

自定义 sampler

如果现有 Dataset 不满足需求,可自定义 Dataset,通过继承 torch.utils.data.Dataset。

继承时,要 override 三个方法。

__init__: 初始化数据集__getitem__:给定索引值,返回该索引值对应的数据;- python built-in方法,让该类可以像list一样通过索引值对数据进行访问

__len__:用于 len(Dataset)时, 返回大小

整体结构

PyTorch 构建模型时的几大要素

- 数据:数据读取,数据清洗,数据划分和数据预处理

- 比如:读取图片如何预处理及数据增强。

- 模型:构建模型模块,组织复杂网络,初始化网络参数,定义网络层。

- 损失函数:创建损失函数,设置损失函数超参数,根据不同任务选择合适的损失函数。

- 优化器:根据梯度使用某种优化器更新参数,管理模型参数,管理多个参数组实现不同学习率,调整学习率。

- 迭代训练:组织4 个模块进行反复训练。

- 观察训练效果,绘制 Loss/ Accuracy 曲线,用 TensorBoard 进行可视化分析。

PyTorch由4个主要包装组成:

- 1、

Torch:类似于Numpy的通用数组库,可以在将张量类型转换为(torch.cuda.TensorFloat)并在GPU上进行计算。 - 2、torch.

autograd:用于构建计算图形并自动获取渐变的包 - 3、torch.

nn:具有共同层和成本函数的神经网络库 - 4、torch.

optim:具有通用优化算法(如SGD,Adam等)的优化包

流程概要

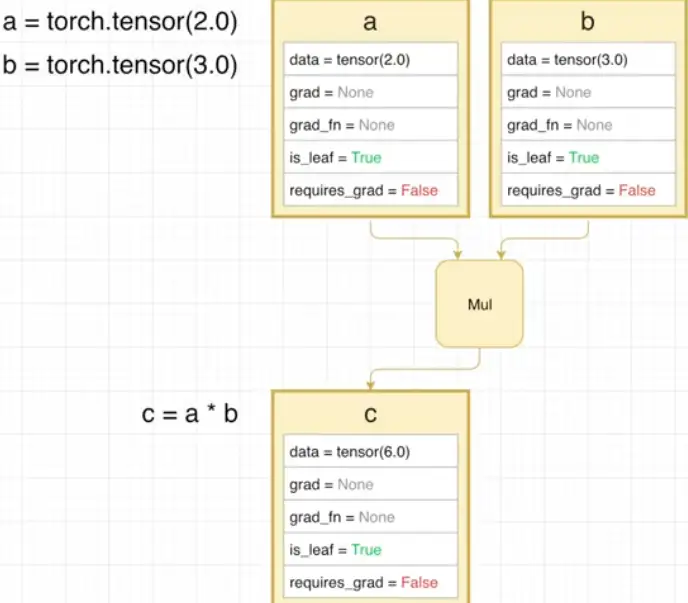

叶子节点

在反向传播过程中,只有叶子节点导数结果,会被最后保留下来

- requires_grad = False 的tensor,一定是

叶子节点 - requires_grad = True 时

- 当这个tensor是用户创建,是

叶子节点; - 当这个tensor是由其他运算操作产生时,不是

叶子节点

- 当这个tensor是用户创建,是

非叶子节点(即中间变量)是通过用户所定义的叶子节点,通过一系列运算生成的,用完后即被释放

- 叶子节点的 grad_fn属性都为空;

- 非叶子节点的 grad_fn不为空

inplace 操作

在不更改变量内存地址的情况下,直接修改变量的值

PyTorch 通过 tensor._version 来检测 tensor 是否发生了 inplace 操作。

- 每次 tensor 在进行

inplace操作时,变量_version就会加1,其初始值为0

组件图解

组件详解

深度学习任务中,PyTorch 程序主要包含以下这4个模块。

- 网络模型定义文件,如

network.py。 - 数据读取文件,如

dataset.py。 - 训练接口程序,如

train.py。 - 测试接口程序,如

evaluate.py。

除了 network,dataset,train 和 evaluate,还有定制的模块

- cal_metrics 用来计算实验指标

- cfg 用来设置某些超参数

- image_io_and_process 用来对图像进行预处理和后处理

- loss_functions 用来定义与实现某些损失

- utils 用来承载一些其他操作,比如读写txt文档。

详解:

- 网络模型定义文件,比如, 名为

network.py。- 定义Python类,并继承

torch.nn.Module。 - 重写构造函数

__init__来定义网络中使用的层,在定义层或者模块的时候,经常会使用到torch.nn这个库。 - 再重写父类的 forward 函数: 使用

__init__函数中定义的层, 实现网络的前传过程 - 问题: 所有单元都需要先在

__init__中定义吗?

- 定义Python类,并继承

- 数据读取文件,比如

dataset.py。- PyTorch 与其他框架差异: 数据读取接口非常规范。

- PyTorch 继承

torch.utils.data.Dataset类实现自己的数据集读取。 - 继承时,重写三个函数:

__init__函数,__getitem__函数和__len__函数。

__init__函数:初始化,比如, 读取所需记录数据的txt或者xml文件,传入一些预处理参数等等。__getitem__函数:规定每个batch训练给网络喂数据时,应该采用怎样的数据读取方式,以及怎样预处理。__len__函数:数据集中有多少数据 - 训练程序中只需使用torch.utils.data.DataLoader开始在每次训练中对数据集进行读取与遍历就行 - 除去 dataset,用的比较多的:batch_size,shuffle,num_workers和pin_memory这几个参数。batch_size指定一个批次的数据容量shuffle指定是否打乱数据num_workers指定用多少个线程对数据进行读取pin_memory指定是否将数据放入显存。

- 训练接口程序,比如

train.py。与其他深度学习框架类似,都是先搭建图(模型),然后在图上进行训练- 四个步骤,引用数据、引用模型、定义损失函数、定义优化器:

- ① 数据: 引用之前定义的数据读取接口。

- ② 模型: 引用model,即网络,需要的话就载入预训练参数。

- ③ 损失函数: 定义loss。

- ④ 优化器: 定义优化器。 - 然后, for循环中进行可训练参数更新了。

- 测试接口程序,比如名称为

evaluate.py。- 测试程序比训练程序简单很多,两个步骤:

- 定义网络

- 载入已训练参数

- 然后读取测试样本进行前传。

- 注意: 模型测试时,要将model置为测试模式,对应代码中

model.eval()

train_data_loader = torch.utils.data.DataLoader(dataset, batch_size=1, shuffle=False, sampler=None, batch_sampler=None, num_workers=0, collate_fn=default_collate, pin_memory=False, drop_last=False,timeout=0, worker_init_fn=None)

训练注意

- 保存模型和加载预训练参数。

- 保存模型的已训练参数/整个模型: 通过

torch.save函数完成; - 加载预训练参数: 通过model的父类,即

torch.nn.Module的load_state_dict完成。

- “strict”参数: 是否需要将预训练模型里面的参数与model里面的完全对齐。

- 保存模型的已训练参数/整个模型: 通过

- 使用GPU训练

- 如果使用GPU训练时,用到

to(device) 函数,将数据或者模型放到GPU上面。

- 如果使用GPU训练时,用到

- 参数更新过程,分成三步:

- 将可训练参数梯度置零

optimizer.zero_grad() - 根据损失值求梯度

loss.backward() - 更新可训练参数

optimizer.step()

- 将可训练参数梯度置零

- 将model置为训练模式

- 对应代码中的

model.train() - 训练模式会对某些定义的网络模块有影响,比如 使用dropout层,在训练时会被激活。

- 对应代码中的

PyTorch 程序比较规范,简洁与清晰。

- 还使用到了非常多的面向对象规范,有许多操作都是通过继承Python类进行实现的。

模式 train/eval

PyTorch 训练和测试时, 一定要把实例化的model指定 train/eval

pytorch 切换训练和评估(推断)模式: model.train() 和 model.eval()

model.train():启用 BatchNormalization 和 Dropoutmodel.eval():不启用 BatchNormalization 和 Dropout

分析:

- bn:

model.train(): 保证BN层用每一批数据的均值和方差,而model.eval()是保证BN用全部训练数据的均值和方差; - Dropout:

model.train()随机取一部分网络连接来训练更新参数,而model.eval()利用到了所有网络连接。 eval()时,框架会自动把BN和Dropout固定住,不会取平均,而是用训练好的值,一旦test的batch_size过小,很容易就会被BN层导致生成图片颜色失真极大

| 模式 | 切换方法 | 作用 | bn层 | dropout |

|---|---|---|---|---|

| 训练 | model.train() |

训练状态, 除了模型参数可变, 还有bn/droupout策略不同 | 均值/方差使用当前batch数值 | 按照参数随机选取部分连接 |

| 测试 | model.eval() |

推理/评估状态, 模型参数固定, 避免改变参数 | 均值/方差使用全部训练数据的数值 | 失效,使用全部网络连接 |

训练完train样本后,生成的模型model要用来测试样本。

model(test) 前,加上 model.eval(),否则,输入数据(即使不训练)会改变权值。

- model中含有batch normalization层所带来的的性质。

- one classification 时,训练集和测试集的样本分布是不一样,尤其需要注意这一点。

【2024-3-25】

- 训练阶段

model.train()让模型适应训练数据变化,并防止过拟合; - 而验证/测试阶段

model.eval()保证模型在新数据上的表现一致性,并且避免因为BN层在小批量数据上的不稳定统计,导致预测结果波动以及Dropout带来的不确定性。

网络单元在哪儿定义? __init__ 还是 forward ?

__init__: 训练时需要更新权重的单元forward: 不需要权重

# 定义一个网络

class Net(nn.Module):

def __init__(self, l1=120, l2=84):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 * 5 * 5, l1)

self.fc2 = nn.Linear(l1, l2)

self.fc3 = nn.Linear(l2, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

# 实例化这个网络

Model = Net()

# 训练模式使用.train()

Model.train(mode=True)

# 测试模型使用.eval()

Model.eval()

代码示例

代码示例

# (1)======= 模型定义 =======

class My_Network(nn.Module):

"""

模型定义: 继承自nn.Module, 实现 __init__ 和 forward 函数

"""

#

def __init__(self): # 重写构造函数定义网络结构

super(network, self).__init__()

self.conv1 = nn.Conv2d(3, 64, kernel_size=3, stride=1, padding=1) # 3×3卷积

self.bn1 = nn.BatchNorm2d(64) # BatchNorm

self.relu = nn.ReLU() # 激活

self.maxpool = nn.MaxPool2d(kernel_size=2, stride=2) # 最大池化

self.fc = nn.Linear(64 * 14 * 14, 512) # 全连接,将[n, (64*14*14)]变成[n, 512]

for m in self.modules(): # 对可训练参数进行初始化(上面定义的所有模块都存储在此)

if isinstance(m, nn.Conv2d):

nn.init.xavier_normal_(m.weight)

elif isinstance(m, nn.BatchNorm2d) or isinstance(m, nn.BatchNorm1d):

nn.init.constant_(m.weight, 1)

nn.init.constant_(m.bias, 0)

elif isinstance(m, nn.Linear):

nn.init.xavier_normal_(m.weight)

nn.init.constant_(m.bias, 0)

def forward(self, x): # 重写forward实现前传, 定义网络结构

# 前传,输入x尺寸为[n, c, 28, 28]

x = self.conv1(x)

x = self.bn1(x)

x = self.relu(x)

x = self.maxpool(x)

x = x.view(x.size(0), -1) # 将4维Tensor变成2维,作为全连接的输入

x = self.fc(x)

return x

# (2)======= 数据读取 =======

class My_Dataset(torch.utils.data.Dataset):

"""

数据集处理函数,重写函数:__init__, __getitem__, __len__

"""

def __init__(self, data_txt_path):

data_list = read_txt(data_txt_path) # 读取一下记录数据与标签的txt

self.data_list = np.random.permutation(data_list) # 打乱一下txt

self.transform = T.ToTensor() # 预处理,将数据转化成[n, c, h, w]的形式,并归一化到[0,1]

def __getitem__(self, index):

sample = self.data_list[index] # 读取txt中的一行,是一个数据对(image_path, label)

image_path = sample.split(' ')[0]

label = int(sample.split(' ')[-1])

resized_image = read_image(image_path) # 读取一下图像

image = self.transform(resized_image) # 转化成Tensor

return image.float(), label

def __len__(self):

# 数据量

return len(self.data_list)

# (3)======= 训练 ==========

from __future__ import print_function

import torch.nn

from torch.nn import DataParallel

import torch.optim

import torch.utils.data

import argparse

#import 所需的各种模块

parser = argparse.ArgumentParser(description="")

#添加各种自定义参数

args = parser.parse_args()

def main():

device = torch.device("cuda") # 注明用GPU

train_dataset = My_Dataset(txt_path) # 实例化数据集处理对象

train_data_loader = torch.utils.data.DataLoader(train_dataset, batch_size, shuffle, num_workers) # 读数据

model = My_Network() # 实例化模型

#若有预训练参数,可以载入预训练参数

model.load_state_dict(torch.load(ckpt_path), strict=False)

#定义损失,比如criterion = torch.nn.CrossEntropyLoss()

criterion = My_Loss # 损失函数

model.to(device)

model = DataParallel(model) # 将模型训练放在多张GPU上并行

optimizer = torch.optim.SGD(model.parameters(), lr, weight_decay) # 优化器

model.train() #将模型置为训练模式

# 开始训练

for i in range(epoch):

for ii, data in enumerate(train_data_loader):

data_input, label = data

data_input = data_input.to(device)

label = label.to(device).long()

output = model(data_input)

loss = criterion(output, label)

print("loss =: ", loss)

optimizer.zero_grad() #首先梯度置零

loss.backward() #然后求梯度

optimizer.step() #通过梯度更新参数

iters = i * len(train_data_loader) + ii

if iters % save_interval == 0:

torch.save(model.state_dict(), save_path) # 保存模型

if __name__ == "__main__":

main()

# (4)======= 测试 =======

from __future__ import print_function

import torch.nn

from torch.nn import DataParallel

import torch.optim

import torch.utils.data

import argparse

#import 所需的各种模块

parser = argparse.ArgumentParser(description="")

#添加各种自定义参数

args = parser.parse_args()

def main():

device = torch.device("cuda")

model = My_Network() # 模型实例化

model = DataParallel(model) # 多GPU

model.load_state_dict(torch.load(snapshot_path)) #载入参数

model.to(device)

model.eval() #将模型置为测试模式

for eval_data_path in eval_data_list:

eval_data = read_image(eval_data_path)

data = torch.from_numpy(eval_data) #将data转化为Tensor

data = data.to(device)

output = model(data) #前传得到结果

#自定义操作,比如计算精度

if __name__ == "__main__":

main()

网络结构

只需要定义forward函数,就可以使用autograd 定义backward函数(计算梯度)。forward函数中使用任何张量操作。

LR

单个神经元, LR 回归

y = sigmoid( w*x + b )

# 线性回归

lr = nn.Sequential(

nn.Linear(NUM_INPUTS, 1),

nn.Sigmoid()

)

# LR回归

lor = nn.Sequential(

nn.Linear(NUM_INPUTS, 1),

nn.Sigmoid()

)

MLP 全连接

全连接神经网络

m = 100

h = 1024

n = 20

# MLP

lor = nn.Sequential(

nn.Linear(m, h),

nn.Tanh(),

nn.Linear(h, h),

nn.Tanh(),

nn.Linear(h, n),

nn.LogSoftmax(dim=1)

)

LSTM

LSTM 解决 MNIST 识别问题

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.rnn = nn.LSTM(input_size=28, hidden_size=64, batch_first=True)

self.batchnorm = nn.BatchNorm1d(64)

self.dropout1 = nn.Dropout2d(0.25)

self.dropout2 = nn.Dropout2d(0.5)

self.fc1 = nn.Linear(64, 32)

self.fc2 = nn.Linear(32, 10)

def forward(self, input):

# Shape of input is (batch_size,1, 28, 28)

# converting shape of input to (batch_size, 28, 28)

# as required by RNN when batch_first is set True

input = input.reshape(-1, 28, 28)

output, hidden = self.rnn(input)

# RNN output shape is (seq_len, batch, input_size)

# Get last output of RNN

output = output[:, -1, :]

output = self.batchnorm(output)

output = self.dropout1(output)

output = self.fc1(output)

output = F.relu(output)

output = self.dropout2(output)

output = self.fc2(output)

output = F.log_softmax(output, dim=1)

return output

CNN

CNN 卷积神经网络

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(1, 32, 3, 1)

self.conv2 = nn.Conv2d(32, 64, 3, 1)

self.dropout1 = nn.Dropout(0.25)

self.dropout2 = nn.Dropout(0.5)

self.fc1 = nn.Linear(9216, 128)

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = self.conv1(x)

x = F.relu(x)

x = self.conv2(x)

x = F.relu(x)

x = F.max_pool2d(x, 2)

x = self.dropout1(x)

x = torch.flatten(x, 1)

x = self.fc1(x)

x = F.relu(x)

x = self.dropout2(x)

x = self.fc2(x)

output = F.log_softmax(x, dim=1)

return output

示例

import torch

import torch.nn as nn

import torch.nn.functional as F

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

# 1 input image channel, 6 output channels, 5x5 square convolution

# kernel

self.conv1 = nn.Conv2d(1, 6, 5)

self.conv2 = nn.Conv2d(6, 16, 5)

# an affine operation: y = Wx + b

self.fc1 = nn.Linear(16 * 5 * 5, 120) # 5*5 from image dimension

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

# Max pooling over a (2, 2) window

x = F.max_pool2d(F.relu(self.conv1(x)), (2, 2))

# If the size is a square, you can specify with a single number

x = F.max_pool2d(F.relu(self.conv2(x)), 2)

x = torch.flatten(x, 1) # flatten all dimensions except the batch dimension

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

# input -> conv2d -> relu -> maxpool2d -> conv2d -> relu -> maxpool2d

# -> view -> linear -> relu -> linear -> relu -> linear

# -> MSELoss

# -> loss

# 模型定义

net = Net()

print(net)

# 网络参数

params = list(net.parameters())

print(len(params))

print(params[0].size()) # conv1's .weight

# 输入数据

input = torch.randn(1, 1, 32, 32)

# 输出数据

out = net(input)

print(out)

# 使用随机梯度将所有参数和反向传播的梯度缓冲区归零

net.zero_grad() # 将梯度缓冲区手动设置为零

out.backward(torch.randn(1, 10))

注意

- torch.nn仅支持小批量。 整个torch.nn包仅支持作为微型样本而不是单个样本的输入。

- 例如,nn.Conv2d将采用nSamples x nChannels x Height x Width的 4D 张量。

- 如果只有一个样本,只需使用input.unsqueeze(0)添加一个假批量尺寸。

回顾:

- torch.Tensor 一个多维数组,支持诸如backward()的自动微分操作。 同样,保持相对于张量的梯度。

- nn.Module 神经网络模块。 封装参数的便捷方法,并带有将其移动到 GPU,导出,加载等的帮助器。

- nn.Parameter 一种张量,即将其分配为Module的属性时,自动注册为参数。

- autograd.Function 实现自动微分操作的正向和反向定义。 每个Tensor操作都会创建至少一个Function节点,该节点连接到创建Tensor的函数,并且编码其历史记录。

AE

class AE(nn.Module):

def __init__(self, num_inputs=784):

super().__init__()

# 编码器: 压缩成一个向量 C

self.encoder = nn.Sequential(

nn.Linear(num_inputs, 400),

nn.ReLU(inplace=True),

nn.Linear(400,400),

nn.ReLU(inplace=True),

nn.Linear(400, 20)

)

# 解码器

self.decoder = nn.Sequential(

nn.Linear(20,400),

nn.ReLU(inplace=True),

nn.Linear(400,400),

nn.ReLU(inplace=True),

nn.Linear(400, num_inputs)

)

def forward(self, x):

return self.decoder(self.encoder(x))

ae = AE(784)

x = torch.randn(10, 784)

print('Input tensor x size: ', x.size())

y = ae(x)

print('Output tensor y size: ', y.size())

VAE

class VAE(nn.Module):

def __init__(self):

super(VAE, self).__init__()

self.fc1 = nn.Linear(784, 400)

self.fc21 = nn.Linear(400, 20)

self.fc22 = nn.Linear(400, 20)

self.fc3 = nn.Linear(20, 400)

self.fc4 = nn.Linear(400, 784)

def encode(self, x):

# 编码器

h1 = F.relu(self.fc1(x))

return self.fc21(h1), self.fc22(h1)

def reparameterize(self, mu, logvar):

# 根据均值、方差,随机采样

std = torch.exp(0.5*logvar)

eps = torch.randn_like(std)

return mu + eps*std

def decode(self, z):

# 解码器

h3 = F.relu(self.fc3(z))

return torch.sigmoid(self.fc4(h3))

def forward(self, x):

mu, logvar = self.encode(x.view(-1, 784))

# 随机抽样生成新的C

z = self.reparameterize(mu, logvar)

return self.decode(z), mu, logvar

torch 知识点

torch.nn 模块

nn.xx 与 nn.functional.xx

- 实际功能相同,

nn.xx是包装好的类,nn.functional.xx是可直接调用的函数。

模块类型

【2023-1-14】PyTorch torch.nn 模块 Layer 总结

torch.nn 模块是 Pytorch 对 Layer 的总结

torch.nn 模块中的类分为 4 种:

- (1)

容器类,nn.modules.container是一系列层的组合。- 先通过索引先获取模块类,再按照模块类的方法

- 主要为

nn.Sequential()

- (2)

模型类,继承nn.module类,自行构建的神经网络模型,具体为 nn.modules.module.Module 类- 通过 .modules() 方法得到一个迭代器,获得模型中的所有模块类(可能有容器类)

- .modules()方法的第一个模型本身。对于嵌套的模块(即容器类),会以此往其子模块遍历

- (3)

模块类,nn.modules 类下除了容器类(nn.modules.container)和模型类(nn.modules.module.Module)均被划为此类,即层- 有学习参数的类:

nn.Linear(); - 无学习参数的类:

nn.Sigmoid()和nn.MSELoss()等 - 使用 type() 函数查看实例化对象,得到

<class 'torch.nn.modules....'>信息 - 通过特定属性,返回

nn.parameter类,再学习参数类的方法(即.data属性)得到,- 如:对于

nn.Linear()层,包括 2 种属性:.weight和.bias

- 如:对于

- 一些函数层(如:激活函数层,维度和尺寸改变层,损失函数层)可通过 torch 模块中或

torch.nn.functional模块中的函数实现;不需要先定义层,直接当做函数使用。- 激活函数层

nn.Sigmoid():torch.nn.functional.sigmoid() 和 torch.sigmoid(),但是 PyTorch 官方推荐使用后者 - 展平层

torch.nn.Flatten():torch.flatten() - 损失函数层

nn.MSELoss(): nn.functional.mse_loss()

- 激活函数层

- 有学习参数的类:

- (4)

学习参数类,nn.parameter类- 为了与函数或实例的传入参数区分,加上了限定词学习,即网络模型需要学习(即,训练,或优化)的参数

- 一般为

nn.Parameter()类初始化的实例 - 使用

type()函数查看实例化对象,可以得到<class 'torch.nn.parameter.Parameter'>的信息 - 直接通过

.data属性(或.detach()方法),得到学习参数值 - 返回 tensor 数据类型,且 autograd 启动

所有网络模型都是继承于nn.Module

注意

容器类(nn.modules.container)和模型类(nn.modules.module.Module)也是 nn.modules 类。

torch.nn 模块中类(即,层类)的使用:先定义,再输入

总结

- 一个 module 里可包含多个子 module。

- 比如 LeNet 是一个 Module,里面包括多个卷积层、池化层、全连接层等子 module

- module 相当于运算,必须实现

forward()函数 - 每个 module 都有 8 个字典管理自己的属性

通用层和容器层(Containers)

- torch.nn.

Parameter() 用于 wrap 待优化模型参数 Tensor - torch.nn.

Sequential() 将多个网络层,按照先后顺序串联起来 - torch.nn.

Module() 用来管理模型待优化的参数- nn.

ModuleList:像 pythonlist一样包装多个网络层,可以迭代; 包装一组网络层,以迭代方式调用网络层, 主要有以下 3 个方法:- append():在 ModuleList 后面添加网络层

- extend():拼接两个 ModuleList

- insert():在 ModuleList 的指定位置中插入网络层

- nn.

ModuleDict:像 pythondict一样包装多个网络层,通过 (key, value) 的方式为每个网络层指定名称。包装一组网络层,以索引的方式调用网络层,主要有以下 5 个方法:- clear():清空 ModuleDict

- items():返回可迭代的键值对 (key, value)

- keys():返回字典的所有 key

- values():返回字典的所有 value

- pop():返回一对键值,并从字典中删除

- nn.

容器总结

- nn.Sequetial:顺序性,各网络层之间严格按照顺序执行,常用于 block 构建,在前向传播时的代码调用变得简洁

- nn.ModuleList:迭代行,常用于大量重复网络构建,通过 for 循环实现重复构建

- nn.ModuleDict:索引性,常用于可选择的网络层

线性层

- torch.nn.Linear():对输入数据最后的一个维度上实现

- torch.nn.LazyLinear()

稀疏层 Sparse Layers

- torch.nn.Embedding() 用于词向量的嵌入

torch.nn.Module

torch.nn 专门为神经网络设计的模块化接口。nn构建于autograd之上,用来定义和运行神经网络。

nn.Module 是 nn 中十分重要的类,包含网络各层定义及forward方法。

一切自定义操作基本上都是继承nn.Module类来实现

nn.Module 方法

5 个方法:

clear():清空 ModuleDictitems():返回可迭代的键值对 (key, value)keys():返回字典的所有 keyvalues():返回字典的所有 valuepop():返回一对键值,并从字典中删除

自定义 Module

定义自已的网络:

- 需要继承

nn.Module类,并实现forward方法。 - 具有可学习参数层放在构造函数

__init__()中, - 不可学习参数层不限:

- 如

ReLU,dropout、BatchNormanation层, 可放在构造函数中,也可不放, (而在forward中使用nn.functional来代替)

- 如

- 只要在

nn.Module子类中定义了forward函数,backward函数就会被自动实现(利用Autograd)。 - forward函数中可用任何Variable支持的函数,毕竟在整个pytorch构建的图中,是Variable在流动。还可以使用if,for,print,log等python语法.

调用

- 执行

model(x)时候,底层自动调用forward方法计算结果

注:

- Pytorch 基于 nn.Module 构建模型中,只支持 mini-batch 的 Variable输入方式

- forward方法必须重写,实现模型的功能,各个层之间的连接关系的核心。

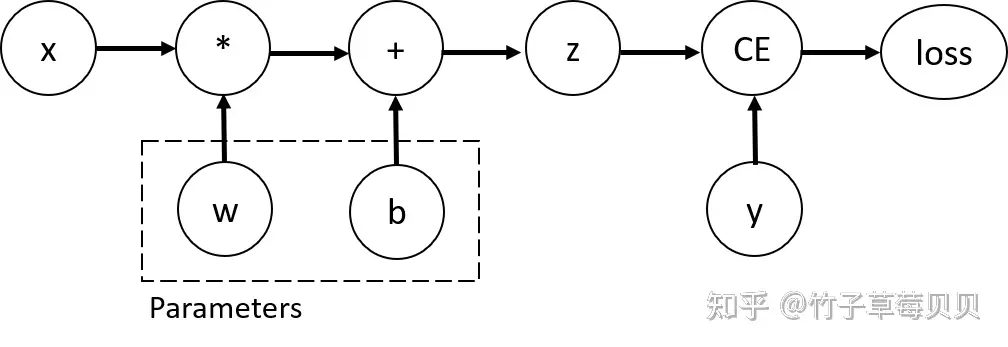

farward 原理

farward 是 神经网络的核心,定义了输入数据通过网络时的前向传播过程

实例化一个继承自 torch.nn.Module 的自定义类, 并传入输入数据时,要通过调用该实例来实现前向传播计算, 这实际上会隐式地调用 forward 方法。

执行 output = model(input_data) 时

- 首先,尝试调用 自定义model的

__call__方法。- 因为

nn.Module对__call__进行了特殊处理,确保先将输入数据准备好,并设置模型的状态(如启用或禁用批量归一化层的追踪模式等)。

- 因为

- 然后,

__call__内部调用自定义forward方法 执行前向传播计算,从而得到输出结果。 - 最终,output变量将存储从forward方法返回的前向传播输出结果。

forward 虽然不是“自动执行”,但通过直接对模型实例应用输入数据的方式,像自动执行了 forward 函数。

- 通过直接对模型实例 model 赋值输入数据并获取结果的方式,隐式地调用了

model.__call__()方法

import torch.nn as nn

class MyModel(nn.Module):

def __init__(self):

super(MyModel, self).__init__()

# 定义网络层结构...

def forward(self, x):

# 定义前向传播的具体步骤

out = self.some_layer(x)

# 进行更多操作...

return out

# 实例化模型

model = MyModel()

# 准备输入数据

input_data = torch.randn(1, 3, 224, 224) # 假设是针对图像分类任务的数据

# 调用模型(此时会自动调用forward方法),隐式地调用了 model.__call__() 方法

output = model(input_data)

源码

调用一个继承自nn.Module的子类实例时,如model(input_data),Python解释器会调用model.call(input_data)。在这个过程中,__call__方法首先确保模型的状态正确(例如是否处于训练或验证模式),然后调用子类重写的forward方法执行前向传播计算,并返回结果

详见原文

# 注意,这并非完整的真实源代码,而是为了说明原理而简化的伪代码

class torch.nn.Module:

def __init__(self):

super(Module, self).__init__()

self._modules = OrderedDict()

self.training = True # 默认训练模式

def _apply(self, fn):

for module in self.children():

module._apply(fn)

fn(self)

return self

def train(self, mode=True):

self.training = mode

for module in self.children():

module.train(mode)

return self

def __call__(self, *input, **kwargs):

# 确保模型处于正确的训练/评估模式

self.train(self.training)

# 在某些情况下可能还会处理梯度、模型参数等其他设置

# ...(这部分根据实际需要执行相关逻辑)

# 调用用户定义的前向传播函数

output = self.forward(*input, **kwargs)

# 返回前向传播的结果

return output

def forward(self, *input):

raise NotImplementedError("Subclasses of 'Module' must implement the 'forward' method")

# 用户自定义模块示例

class MyModel(nn.Module):

def __init__(self):

super(MyModel, self).__init__()

self.layer1 = nn.Linear(10, 5)

self.layer2 = nn.ReLU()

def forward(self, x):

x = self.layer1(x)

x = self.layer2(x)

return x

model = MyModel()

input_data = torch.randn((64, 10))

# 这一行会调用MyModel实例的__call__方法

output = model(input_data)

常用 nn 模块

用 torch.nn 包构建神经网络,API 的表达及意义

- 线性层 - nn.Linear、nn.Bilinear

- 卷积层 - nn.Conv1d、nn.Conv2d、nn.Conv3d、nn.ConvTranspose2d

- 非线性激活函数 - nn.Sigmoid、nn.Tanh、nn.ReLU、nn.LeakyReLU

- 池化层 - nn.MaxPool1d、nn.AveragePool2d

- 循环网络 - nn.LSTM、nn.GRU

- 归一化 - nn.BatchNorm2d

- Dropout - nn.Dropout、nn.Dropout2d

- 嵌入 - nn.Embedding

- 损失函数 - nn.MSELoss、nn.CrossEntropyLoss、nn.NLLLoss

示例

import torch.nn as nn

import torch.nn.functional as F

# ------- 先定义,再输入 -------

layer = nn.Linear(params) # 先定义,设置层的参数

# 一般在 nn.Module 模型的初始化函数 __init__() 中定义

output_data = layer(input_data) # 输入数据,得到输出数据

# 一般在函数 forward() 中定义

# ------- 等效表达 -------

input = torch.rand((3, 5))

# 方法 1:

layer = nn.Sigmoid()

output1 = layer(input)

# 方法 2:

output2 = F.sigmoid(input)

# 方法 3:

output3 = torch.sigmoid(input)

# 输出

print(ouput1.size())

print(torch.sum(torch.abs(output2 - output1)))

# ------- parameter -------

w = nn.Parameter(torch.Tensor([1., 1.,]))

print(w.detach()) # 返回新的tensor

print(w.data) # tensor数值,与原tensor共用

print(w.grad) # tensor梯度值,与原tensor共用

# ------- sequential -------

# 构建输入层为5,隐含层为3,输出层为1,激活函数为sigmoid的神经网络

model = nn.Sequential(

nn.Linear(5, 3),

nn.Sigmoid(),

nn.Linear(3, 1),

nn.Sigmoid(),

nn.Flatten(0, -1)

)

# ------- 模型定义 -------

class MyModel(torch.nn.Module):

def __init__(self):

super(MyModel, self).__init__()

# 放入需要学习的参数

# 正向传播

def forward(self, x):

return y

# 损失函数

def loss_func(self, y_pred, y_true):

return loss

# 评估函数(准确率)

def metric_func(self, y_pred, y_true):

return metric

# 优化器

@property

def optimizer(self):

return torch.optim.Adam(self.parameters(), lr=0.001)

1. 基本配置

导入包

import torch

import torch.nn as nn

#import torchvision

print(torch.__version__)

print(torch.version.cuda)

print(torch.backends.cudnn.version())

print(torch.cuda.get_device_name(0))

可复现性

- 硬件设备(CPU、GPU)不同时,完全可复现性无法保证,即使随机种子相同。

- 但是,同一个设备上,应该保证可复现性。

具体做法

- 程序开始时,固定torch随机种子,同时也把numpy随机种子固定。

np.random.seed(0)

torch.manual_seed(0)

torch.cuda.manual_seed_all(0)

torch.backends.cudnn.deterministic = True

torch.backends.cudnn.benchmark = False

cuda 设置

# 判断当前环境GPU是否可用, 然后将tensor导入GPU内运行

if torch.cuda.is_available():

tensor = tensor.to('cuda')

# ------------

# 如果只需要一张显卡

# Device configuration

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

# 常用语句:有GPU用GPU,没有用CPU

device = "cuda" if torch.cuda.is_available() else "cpu"

print(f"Using {device} device")

# 如果需要指定多张显卡,比如0,1号显卡。

import os

# 方法1

os.environ['CUDA_VISIBLE_DEVICES'] = '0,1'

# 方法2

os.environ['CUDA_VISIBLE_DEVICE']='1'

# 方法3

torch.cuda.set_device(id)

# 清除显存

torch.cuda.empty_cache()

也可以在命令行运行代码时,设置显卡:

# 命令行指定显卡

CUDA_VISIBLE_DEVICES=0,1

python train.py

# 命令行重置GPU的指令(清楚显存)

nvidia-smi --gpu-reset -i [gpu_id]

张量移动

GPU加速可显著提高模型训练速度。在将数据传递给GPU之前,需要将其转换为GPU可用格式。

常见操作

- x.

cuda() 移到 gpu - x.

cpu() 移到 cpu - x.

to() 移到指定设备, 不限 cpu/gpu

函数原型

def cuda(self: T, device: Optional[Union[int, device]] = None) -> T:

return self._apply(lambda t: t.cuda(device))

def cpu(self: T) -> T:

return self._apply(lambda t: t.cpu())

def to(self, *args, **kwargs):

...

def convert(t):

if convert_to_format is not None and t.dim() == 4:

return t.to(device, dtype if t.is_floating_point() else None, non_blocking, memory_format=convert_to_format)

return t.to(device, dtype if t.is_floating_point() else None, non_blocking)

return self._apply(convert)

Tensors 可用 x.to(device) 方法来将张量、模型移动到任意设备(CPU/GPU)上, 转为为可用格式.

- 将 x 复制一份到指定设备device(cpu, cuda)上, 之后的运算都在device上进行

张量

import torch

# 获取当前device序号

print('id: ', torch.cuda.current_device())

a = torch.Tensor([[2, 3], [4, 8], [7, 9]])

tensor = torch.randn(2, 2) # Initially dtype=float32, device=cpu

tensor.to(torch.float64) # to 的另一种用法, 类型转换

cuda0 = torch.device('cuda:0')

tensor.to(cuda0, dtype=torch.float64)

other = torch.randn((), dtype=torch.float64, device=cuda0)

tensor.to(other, non_blocking=True)

print(a)

if torch.cuda.is_available():

device = torch.device("cuda")

# torch.device('cuda', 0)

# torch.device('cuda:0')

y = torch.ones_like(a, device=device) # 显示创建在 GPU 上的一个 tensor

# 把 tensor a 放到GPU上

a_cuda = a.cuda() # 方法1: 将张量/模型转换为GPU可用格式

a_cuda = a.to(device) # 方法2 (建议)

print(a_cuda)

模型

import torch

from torch import nn

from torch import optim

# 创建一个模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.fc1 = nn.Linear(3, 2)

self.fc2 = nn.Linear(2, 1)

def forward(self, x):

x = self.fc1(x)

x = self.fc2(x)

return x

net = Net()

# 将模型参数和优化器转换为GPU可用的格式

net = net.cuda() # 直接转换为 gpu 格式

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

print(device.type) # 返回 设备类别, cuda, cpu

net = net.to(device) # 模型移到device

print(net)

optimizer = optim.SGD(net.parameters(), lr=0.01)

多设备操作

import torch

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

model = Model()

if torch.cuda.device_count() > 1:

# 多个设备

model = nn.DataParallel(model,device_ids=[0,1,2])

model.to(device)

问题

【2024-7-24】使用 to(device) 报错

to()received an invalid combination of arguments - got (module)

File "./llm/dschat/utils/utils.py", line 44, in to_device

output[k] = v.to(device)

TypeError: to() received an invalid combination of arguments - got (module), but expected one of:

* (torch.device device, torch.dtype dtype, bool non_blocking, bool copy, *, torch.memory_format memory_format)

* (torch.dtype dtype, bool non_blocking, bool copy, *, torch.memory_format memory_format)

* (Tensor tensor, bool non_blocking, bool copy, *, torch.memory_format memory_format)

2. 张量(Tensor)

张量概念

数学上,张量就是向量和矩阵的推广

PyTorch 张量是同类型元素组成的多维矩阵。

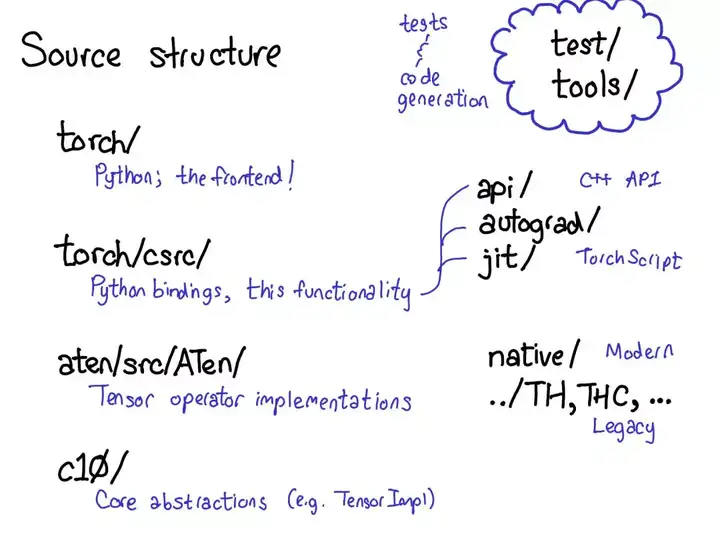

虽然 PyTorch 接口是 Python,但底层主要都是用 C++实现,而在 Python 中集成 C++代码通常被称为「扩展」

张量是一种包含某种标量类型(比如浮点数和整型数等)的 n 维数据结构。功能与 NumPy 的 ndarray 对象类似

Tensor 表面上像是 Python 列表,但是本质上完全不一样。图见文章

- Python 列表或元组是一些散落在内存块中的 Python 对象的集合

- Tensor 是原始 C 语言数字类型的连续内存块视图。无论 Tensor 的形状是什么(3行2列还是2行3列),其中的数据在底层都是分配在连续的内存块中。

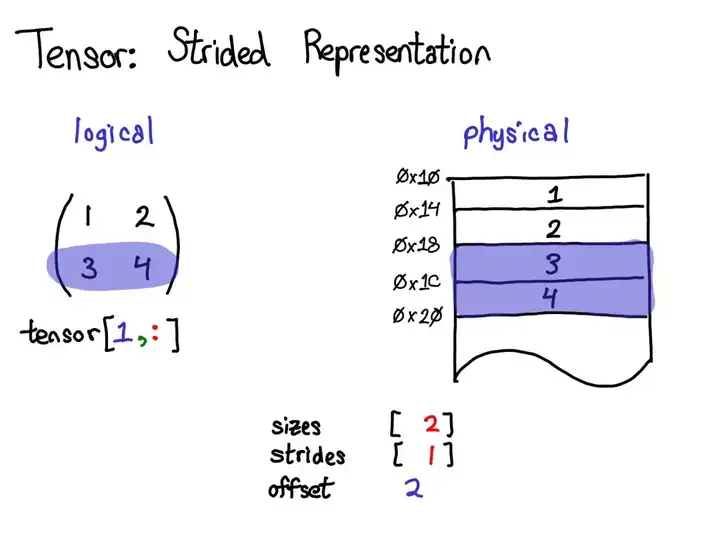

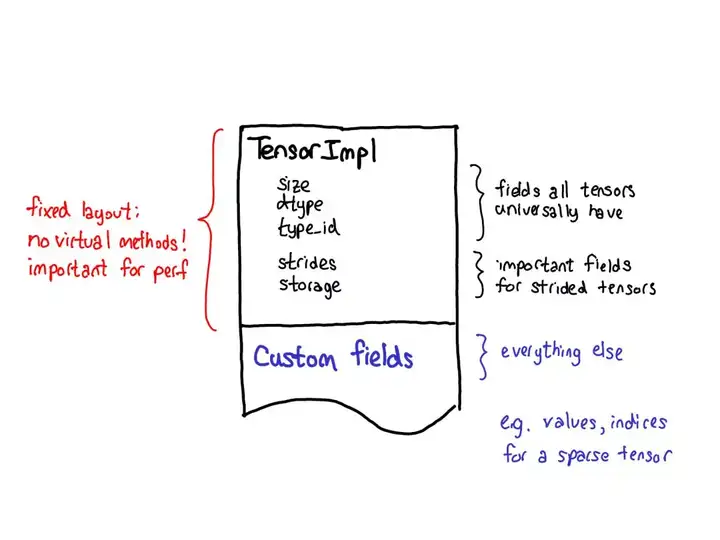

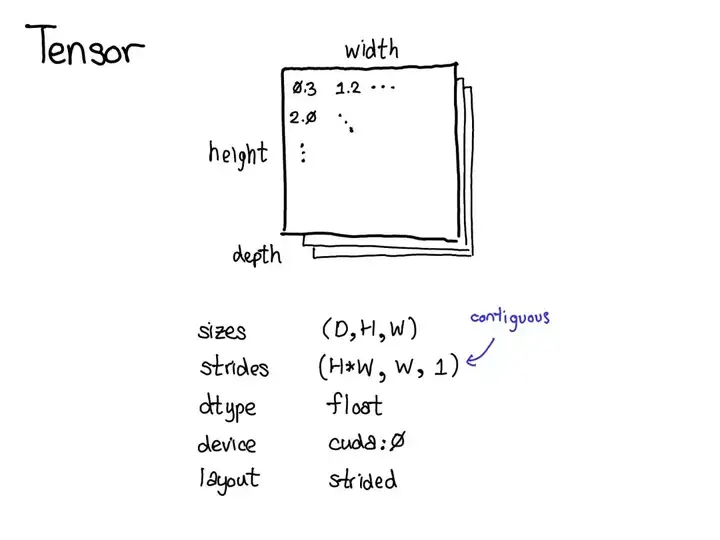

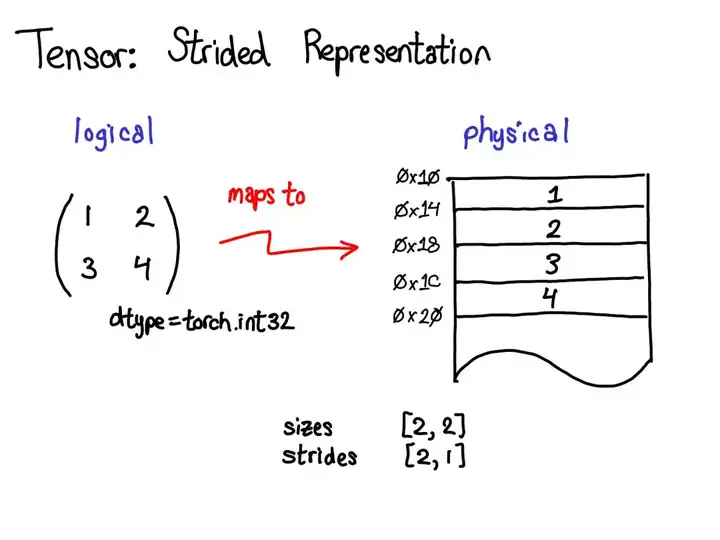

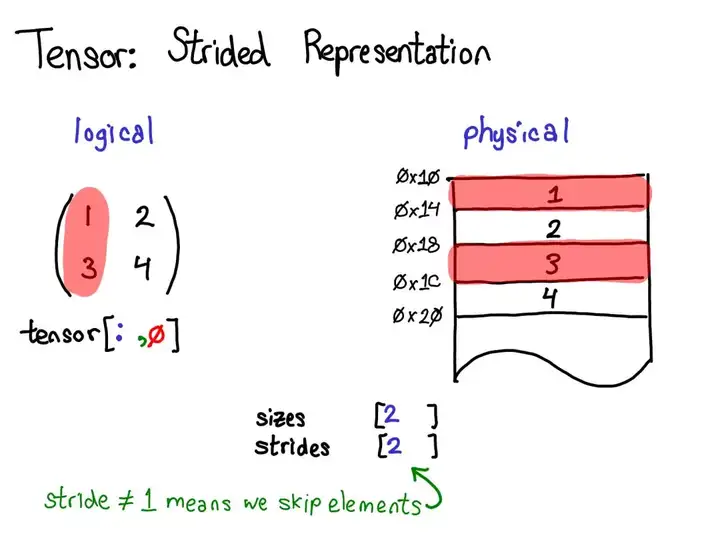

张量由一些数据构成,以及描述属性的元数据

- 张量大小、所包含的元素类型(dtype)、步幅(stride)

- 张量所在的设备(CPU 内存?CUDA 内存?)

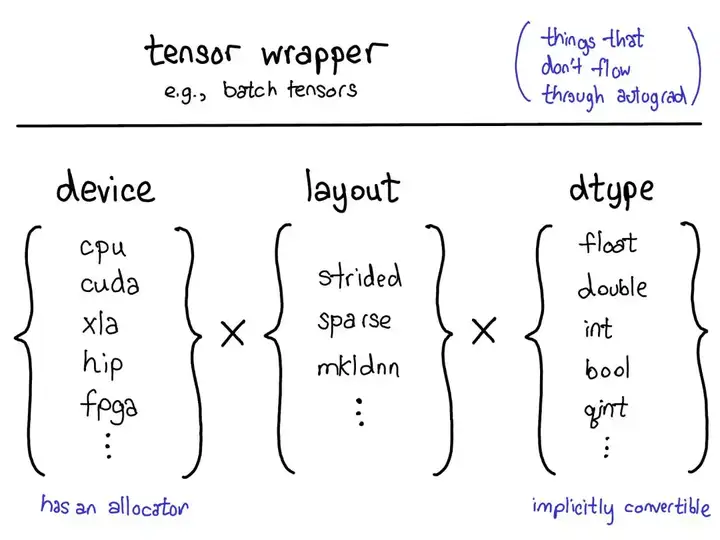

三个独立地确定张量类型的配套参数:

device(设备):实际存储张量的物理内存,比如在 CPU、英伟达 GPU(cuda)、AMD GPU(hip)或 TPU(xla)上。设备之间各不相同的特性是有各自自己的分配器(allocator),这没法用于其它设备。layout(布局):对物理内存进行逻辑解读的方式。最常用的布局是有步幅的张量(strided tensor),但稀疏张量的布局不同,其涉及到一对张量,一个用于索引,一个用于数据;MKL-DNN 张量的布局更加奇特,比如 blocked layout,仅用步幅不能表示它。dtype(数据类型):张量中每个元素实际存储的数据的类型,比如可以是浮点数、整型数或量化的整型数。

Tensor 总结

- (1)Tensor 和 Numpy都是矩阵,区别是前者可以在GPU上运行,后者只能在CPU上;

- (2)Tensor 和 Numpy互相转化很方便,类型也比较兼容

- (3)Tensor 可直接通过print显示数据类型,而Numpy不可以

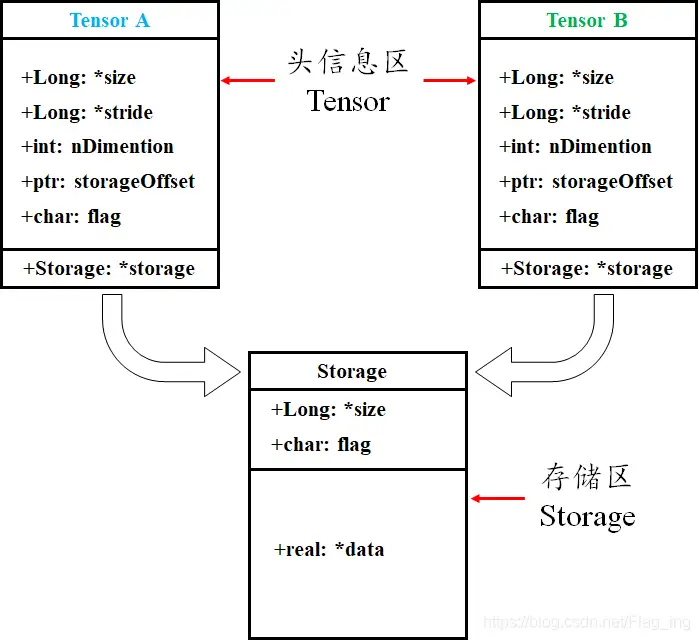

张量存储

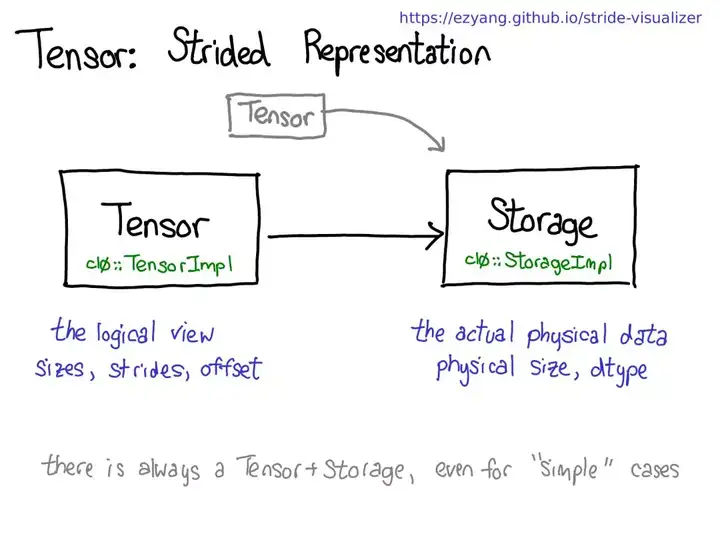

Pytorch Tensor 分为头信息区 (Tensor) 和存储区 (Storage)。

- 信息区保存 tensor的形状 (size)、步长 (stride)、数据类型 (type) 等信息。

- 真正的数据则保存成连续数组,存储在存储区。

1个Tensor 都会有相对应的 Storage,但也有另一种情况时多个 Tensor 都对应着相同的一个 Storage,这几个 Tensor 只是头信息区不同。

tensor 数据采用头信息区(Tensor)和存储区 (Storage)分开存储;

- 定义张量A,其形状size、步长stride、索引信息都存储在头信息区,真实数据在存储区

- 对A进行修改操作,赋值给B,此时B的头信息区变化,但数据存储区与A共享 ——

浅拷贝</span>

import torch

# -------张量属性-----

a = torch.arange(5) # ③ 初始化张量 a 为 [0, 1, 2, 3, 4]

b = a[2:] # 截取张量a的部分值并赋值给b,b其实只是改变了a对数据的索引方式

# a: tensor([0, 1, 2, 3, 4])

# b: tensor([2, 3, 4])

print('ptr of storage of a:', a.storage().data_ptr()) # 打印a的存储区地址

print('ptr of storage of b:', b.storage().data_ptr()) # 打印b的存储区地址, 两者共用存储区

# ptr of storage of a: 2862826251264

# ptr of storage of b: 2862826251264

tensor = torch.rand(3,4)

print(f"Shape of tensor: {tensor.shape}") # 形状(维数) Shape of tensor: torch.Size([3, 4])

print(f"Datatype of tensor: {tensor.dtype}") # 数据类型 Datatype of tensor: torch.float32

print(f"Device tensor is stored on: {tensor.device}") # 存储设备 Device tensor is stored on: cpu

print('==================================================================')

b[1] = 0 # 修改b中索引为1,即a中索引为3的数据为0

# a: tensor([0, 1, 2, 0, 4])

# b: tensor([2, 0, 4])

print('ptr of storage of a:', a.storage().data_ptr()) # 打印a的存储区地址,可以发现a的相应位置的值也跟着改变,说明两者是共用存储区

print('ptr of storage of b:', b.storage().data_ptr()) # 打印b的存储区地址

# ==================================================================

# ptr of storage of a: 2862826251264

# ptr of storage of b: 2862826251264

张量存储方式:多维数组以一维展开的几种方式

- C/C++中使用的是行优先方式(row major)

- Matlab、Fortran使用的是列优先方式(column major)

- PyTorch中Tensor底层实现是C,也是使用行优先顺序。

t = torch.arange(12).reshape(3,4)

#tensor([[ 0, 1, 2, 3],

# [ 4, 5, 6, 7],

# [ 8, 9, 10, 11]])

t.stride() # (4, 1) 连续

t.flatten()

#tensor([ 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11])

t2 = t.transpose(0,1)

#tensor([[ 0, 4, 8],

# [ 1, 5, 9],

# [ 2, 6, 10],

# [ 3, 7, 11]])

t2.stride() # (1, 4) 不连续

t.data_ptr() == t2.data_ptr() # True 底层数据是同一个一维数组

t.is_contiguous(),t2.is_contiguous() # t连续,t2不连续

- 行

- 列

张量定义

张量命名是一个非常有用的方法,可以方便地使用维度名字来做索引或其他操作,大大提高了可读性、易用性,防止出错。

- 注意:rand 和 rand_like 只能生成浮点型!

Tensor vs tensor

相同:

- Tensor 和 tensor 都用于生成新张量

异同:

torch.Tensor主要tensor类,所有tensor都是torch.Tensor的实例。torch.Tensor是torch.FloatTensor的别名。torch.Tensor([1,2])调用 Tensor类构造函数__init__,生成单精度浮点类型的张量

- 而

torch.tensor是一个函数,返回一个tensor.torch.tensor(data, dtype=None, device=None, requires_grad=False)- data 可以是:

list,tuple, NumPyndarray,scalar和其他类型。 torch.tensor从data中的数据部分做拷贝(而不是直接引用),根据原始数据类型生成相应的 torch.LongTensor、torch.FloatTensor和torch.DoubleTensor。

a = torch.Tensor([1,2]) # 直接生成 FloatTensor

a # tensor([1., 2.])

a.type() # 'torch.FloatTensor'

# ----------------

a = torch.tensor([1,2]) # 根据数据类型自动适配 int

a # tensor([1, 2])

a.type() # 'torch.LongTensor'

a = torch.tensor([1.,2.]) # 自动适配 float

a.type() # 'torch.FloatTensor'

a = np.zeros(2,dtype=np.float64)

a = torch.tensor(a) # 自动适配 double

a.type() # 'torch.DoubleTensor'

区别1

- torch.

Tensor(data) 将输入 data 转化 torch.FloatTensortorch.Tensor()只能指定数据类型为torch.float,所以torch.Tensor() 是 torch.empty() 的一个特殊情况

- torch.

tensor(data): (未指定dype的类型时) 将 data 自动转化为 torch.FloatTensor、torch.LongTensor、torch.DoubleTensor等类型,转化类型依据于data的类型或者dtype的值

区别2

- 使用如下语句:

tensor_without_data = torch.Tensor()可以创建一个空的FloatTensor - 而使用

tensor_without_data = torch.tensor()时候则会报错

如何创建一个空的tensor?

tensor_without_data = torch.Tensor() # tensor([])

tensor_without_data = torch.tensor(()) # tensor([])

tensor_without_data = torch.empty([]) # tensor(0.)

所以 torch.Tensor 同时具有 torch.tensor 和 torch.empty 的功能

- 但使用 torch.Tensor 可能会使代码 confusing,所以最好还是使用 torch.tensor 和 torch.empty,而不是 torch.Tensor。

Tensor vs numpy

Tensor 和 Numpy 数组可相互转换,并且共享在 CPU 内存空间

- 即: 改变其中一个的数值,另一个也随之改变。

Tensor(在CPU上) 与 numpy 数据共享基础内存位置, 改变其中一个的值, 另一个也会随之被改变.

- 除CharTensor外,CPU上所有张量都支持与 NumPy 相互转换。

- 用类似于Numpy的方式对张量进行操作, 可以像 numpy 一样 Tensor 切片

Tensor 与 numpy 互转

- 类似引用,没有新建内存,二者修改同步

# tensor → numpy

t = torch.ones(5)

n = t.numpy()

# numpy → tensor

n = np.ones(5)

t = torch.from_numpy(n)

代码

import numpy as np

import torch

# Numpy array --> Torch Tensor

a = np.ones(5)

b = torch.from_numpy(a)

np.add(a, 1, out=a)

print(a) # [2. 2. 2. 2. 2.]

print(b) # tensor([2., 2., 2., 2., 2.], dtype=torch.float64)

# Torch Tensor --> Numpy array

a = torch.ones(5) # a = tensor([1., 1., 1., 1., 1.])

b = a.numpy() # b = [1., 1., 1., 1., 1.]

a.add_(1)

print(a) # tensor([2., 2., 2., 2., 2.])

print(b) # [2. 2. 2. 2. 2.]

# tensor 切片

print(b[: 3]) # tensor([2., 2., 2.], dtype=torch.float64)

# ----- 索引 --------

# numpy 一样通过索引获取其中元素,同时改变它的值。

a = torch.zeros((3, 2))

print(a)

a[0, 1] = 100

print(a)

# tensor([[ 0., 100.],

# [ 0., 0.],

# [ 0., 0.]])

tensor = torch.ones(4,4)

print(tensor[0]) # 第一行(0开始)

print(tensor[;,0]) # 第一列(0开始)

print(tensor[...,-1]) # 最后一列

# 张量中只有一个元素, 可以用.item()将值取出, 作为一个python number

x = torch.randn(1) # 生成一个元素的张量

print(x) # tensor([0.5374])

print(x.item()) # 0.5374473929405212

x = torch.randn(2, 2)

print(x[1, 1]) # 输出张量:tensor(2.1489)

print(x[1, 1].item()) # 输出元素:2.1488616466522217

定义方法

张量创建方式

- ① 直接创建张量

- 随机创建,torch.rand()

- ② 从已有数据创建: 从 Python列表 或 NumPy数组 创建张量

- list: torch.tensor(a)

- numpy: torch.from_numpy(a)

- ③ 参考创建,据已有张量,创建类似张量

- torch.ones_like(a)

- torch.rand_like(a)

张量初始化

- 全 0 张量: torch.zeros(),torch.zeros_like

- 全 1 张量: torch.ones(),torch.ones_like()

- 全值张量(自定义): torch.full(),torch.full_like()

- 等差张量: torch.arange()

# 随机数矩阵

x1 = torch.rand(5,4) # 随机数矩阵

x2 = torch.empty(5,4) # 全0矩阵

x3 = torch.zeros(5, 3, dtype=torch.long) # 指定类型long

t = torch.full((3, 3), 5) # 都是5的 3*3 张量

t = torch.arange(2, 10, 2) # 等差张量, 区间为[start, end), 递增step(2), [2,4,6,8]

t= torch.linspace(2, 10, 6) # 等分张量, [ 2.0000, 3.6000, 5.2000, 6.8000, 8.4000, 10.0000]

t = torch.logspace(2, 10, 6, base=10) # 对数等分张量, 1.0000e+02, 3.9811e+03, 1.5849e+05, 6.3096e+06, 2.5119e+08, 1.0000e+10]

t = torch.eye(3,4) # 对角阵张量, 3*4 维

t_normal = torch.normal(0., 1., size=(4,)) # 概率张量, 均值mean(0),方差std(1),正态分布随机张量 1*4 维, 所有元素分布相同

mean = torch.arange(1, 5, dtype=torch.float)

std = torch.arange(1, 5, dtype=torch.float)

t_normal = torch.normal(mean, std) # 各个元素指定自己的mean和std

t = torch.randint(low=2, high=6, size=(3,4))

t = torch.randperm(n=4);t

#t = torch.bernoulli(input=(0.3, 0.1));t

概率分布

[0,1)均匀分布: torch.rand() 和 torch.rand_like()[0,1)正态分布: torch.randn() 和 torch.randn_like()[low, high]上整数均匀分布: torch.randint() 和 torch.randint_like()- 0 到 n-1 的随机排列。常用于生成索引: torch.randperm()

- 以 input 为概率,生成伯努利分布 (0-1 分布,两点分布): torch.bernoulli()

import torch

# ------- 张量定义 -------

data = [[1, 2], [3, 4]]

x_data = torch.tensor(data) # ① 直接根据已有数据创建,python list 转 tensor

x = torch.tensor([5.5, 3]) # tensor方法直接用参数初始化

x = torch.Tensor(5, 3) # 注意区别:Tensor!未初始化

np_array = np.array(data)

x_np = torch.from_numpy(np_array) # ② numpy 转 tensor

# 继承已有张量的数据属性(结构、类型), 也可以重新指定新的数据类型

x_ones = torch.ones_like(x_data) # ③ 参照已有张量"画瓢",保留 x_data 的属性

print(f"Ones Tensor: \n {x_ones} \n")

x_rand = torch.rand_like(x_data, dtype=torch.float) # 重写 x_data 的数据类型:int -> float

print(f"Random Tensor: \n {x_rand} \n")

# 利用randn_like方法得到相同张量尺寸的一个新张量, 并且采用随机初始化来对其赋值

y = torch.randn_like(x, dtype=torch.float)

# 利用news_methods方法得到一个张量

x = x.new_ones(5, 3, dtype=torch.double)

# 指定维度生成张量

shape = (2,3,)

rand_tensor = torch.rand(shape) # 随机数

rand_tensor = torch.rand(5, 3) # 随机数矩阵:5*3

x = torch.randn((2, 2)) # 服从标准正态分布

ones_tensor = torch.ones(shape) # 全1

zeros_tensor = torch.zeros(shape) # 全0

x = torch.zeros(5, 3, dtype=torch.long) # 指定数值类型

print(f"Random Tensor: \n {rand_tensor} \n")

print(f"Ones Tensor: \n {ones_tensor} \n")

print(f"Zeros Tensor: \n {zeros_tensor}")

# ---- rand & rand_like 用法 ------

t = torch.rand(10)

t = torch.rand(3,3)

t = torch.rand(size = (3,3))

t = torch.rand(size = [3,3])

t = torch.rand(size=(3,3), dtype=torch.float32) # 指定data_type

# 使用种子

gen = torch.Generator()

gen.manual_seed(2947587447)

tensor = torch.rand(size=(4,3), generator = gen)

#z3 = torch.rand_like(z2) # Error ! torch.rand is only implemented for float types

z3 = torch.rand_like(z2, dtype=torch.float32)

# 未初始化矩阵,所分配的内存中的任何值都将显示为初始值

x = torch.empty(5, 3) # 趋近于0的随机数,如:1.5975e-43

# 在PyTorch 1.3之前,需要使用注释

# Tensor[N, C, H, W]

images = torch.randn(32, 3, 56, 56)

images.sum(dim=1)

images.select(dim=1, index=0)

# PyTorch 1.3之后

NCHW = ['N', 'C', 'H', 'W']

images = torch.randn(32, 3, 56, 56, names=NCHW)

images.sum('C') # 使用维度名字索引

images.select('C', index=0)

# 也可以这么设置

tensor = torch.rand(3,4,1,2,names=('C', 'N', 'H', 'W'))

# 使用align_to可以对维度方便地排序

tensor = tensor.align_to('N', 'C', 'H', 'W')

new_* 方法

new_*方法用于替换之前的new方法,从已有张量中创建新张量(相同类型、设备)- It seems that in the newer versions of PyTorch there are many of various new_* methods that are intended to replace this “legacy” new method.

- So if you have some tensor t = torch.randn((3, 4)) then you can construct a new one with the same type and device using one of these methods, depending on your goals:

t = torch.randn((3, 4)) # 原始张量

a = t.new_tensor([1, 2, 3]) # same type, device, new data

b = t.new_empty((3, 4)) # same type, device, non-initialized

c = t.new_zeros((2, 3)) # same type, device, filled with zeros

# 查看张量信息

for x in (t, a, b, c):

print(x.type(), x.device, x.size())

# torch.FloatTensor cpu torch.Size([3, 4])

# torch.FloatTensor cpu torch.Size([3])

# torch.FloatTensor cpu torch.Size([3, 4])

# torch.FloatTensor cpu torch.Size([2, 3])

基本信息

0.4.0 以后版本,Variable 消失, 融入 Tensor 中

因此, Tensor 除了具有 Variable 5个属性,还有另外 3个属性。

张量的变量属性:

data:保存张量的数据grad:保存反向传播过程中计算的梯度值- 非叶子节点梯度为空, 如果反向传播后,仍要保留梯度, 使用方法

retain_grad()

- 非叶子节点梯度为空, 如果反向传播后,仍要保留梯度, 使用方法

grad_fn:创建张量时使用的方法(函数),反向传播求导时要用到is_leaf:是否叶子节点requires_grad:- 如果对于某个操作,其所有输入张量的

requires_grad属性均为false,那么该操作的输出张量的 requires_grad属性也是false,同时也不会生成后向图,且输出张量也是叶子节点- 张量a和b都是 requires_grad=False, c=a*b 为 False

- 张量a是 requires_grad=True,张量b是False,c=a*b 为 True

- 如果对于某个操作,其所有输入张量的

还有3个属性

dtype: 张量数据类型,如 torch.FloatTensor,torch.cuda.FloatTensor。shape: 张量形状。如 (64, 3, 224, 224)device: 张量所在设备 (CPU/GPU),GPU 是加速计算的关键

| 维度 | 叶子节点(requires_grad都是false) | 非叶子节点(requires_grad有true) |

|---|---|---|

| c=a*b |  |

|

torch tensor 也有步长属性。tensor 步长是从索引中的一个维度跨到下一个维度中间的跨度

- 卷积神经网络中卷积核对特征图的卷积操作也是有stride属性,但这两个stride可完全不是一个意思

Tensor 索引和 Python 列表索引一样, 但 Tensor 还支持更高级的索引方式。

t[t>3]

代码示例

import torch

tensor = torch.randn(3,4,5)

t = torch.randn(3,4,5)

print(t.shape, t.dtype, t.device)

print(tensor.type()) # 数据类型

print(tensor.size()) # 张量的shape,是个元组

print(tensor.dim()) # 维度的数量

print('size of a:', a.size()) # 查看a的shape

print('stride of a:', a.stride()) # 查看a的stride

print(a.storage_offset()) # 初始偏移量

print(a.storage()) # 打印a的储存区真实的数据

print('ptr of storage of a: ', a.storage().data_ptr()) # 查看a的storage区的地址

a = torch.arange(6).reshape(2, 3) # 初始化张量 a

b = torch.arange(6).view(3, 2) # 初始化张量 b

print('a:', a)

print('stride of a:', a.stride()) # 打印a的stride

print('b:', b)

print('stride of b:', b.stride()) # 打印b的stride

# 运行结果

# a: tensor([[0, 1, 2],

# [3, 4, 5]])

# stride of a: (3, 1)

#

# b: tensor([[0, 1],

# [2, 3],

# [4, 5]])

# stride of b: (2, 1)

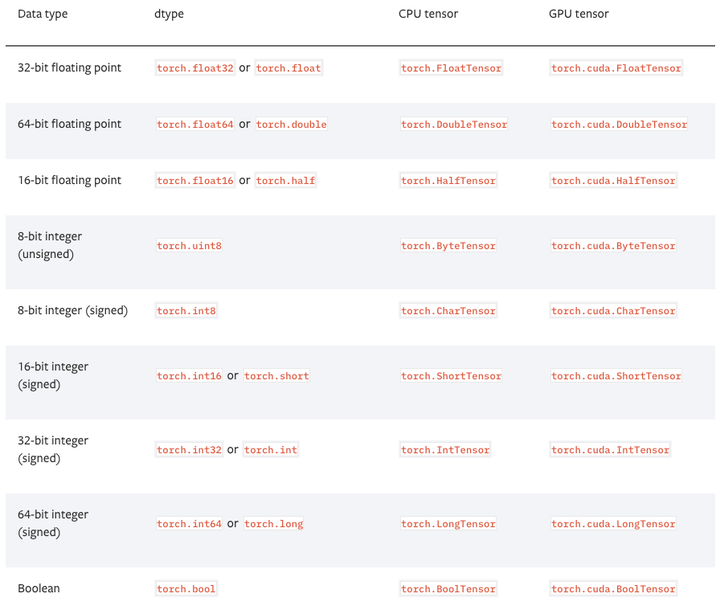

张量类型

PyTorch有9种CPU张量类型和9种GPU张量类型。

torch.Tensor 是一种包含单一数据类型元素的多维矩阵。

- torch.Tensor 是默认的tensor类型(torch.FlaotTensor)的简称。

类型介绍

Torch定义了7种CPU tensor类型和8种GPU tensor类型:

| Data type | CPU tensor | GPU tensor |

|---|---|---|

| 32-bit floating point | torch.FloatTensor |

torch.cuda.FloatTensor |

| 64-bit floating point | torch.DoubleTensor |

torch.cuda.DoubleTensor |

| 16-bit floating point | N/A | torch.cuda.HalfTensor |

| 8-bit integer (unsigned) | torch.ByteTensor |

torch.cuda.ByteTensor |

| 8-bit integer (signed) | torch.CharTensor |

torch.cuda.CharTensor |

| 16-bit integer (signed) | torch.ShortTensor |

torch.cuda.ShortTensor |

| 32-bit integer (signed) | torch.IntTensor |

torch.cuda.IntTensor |

| 64-bit integer (signed) | torch.LongTensor |

torch.cuda.LongTensor |

每个张量tensor都有相应的torch.Storage用来保存其数据。

- 类tensor提供了一个存储的多维的、横向视图,并且定义了在数值运算。

Tensor 数据类型

- torch.float32 或 torch.float:32位浮点,默认数据类型

- torch.float64 或 torch.double:64位双精度浮点

- torch.float16 或 torch.half:16位半精度浮点

- torch.int8:有符号8位整数

- torch.uint8:无符号8位整数

- torch.int16 或 torch.short:有符号16位整数

- torch.int32 或 torch.int:有符号32位整数

- torch.int64 或 torch.long:有符号64位整数

注意:

- 改变tensor 函数操作会用一个下划线后缀来标示。

- 否则 不会改变原tensor值!

- torch.FloatTensor.

abs_() 会在原地计算绝对值,并返回改变后的tensor - tensor.FloatTensor.

abs() 会在一个新的tensor中计算结果。 - 类似的,in-place 运算还有:

acos_,asin_,add_,addbmm_,addcmul_,ceil_ - 更多信息,参考官网

# 通过list或序列构建tensor

a = torch.FloatTensor([[1, 2, 3], [4, 5, 6]])

print(a[1][2]) # 6.0

a[0][1] = 8 # 索引和切片来获取和修改张量

print(a)

# 指定大小,创建tensor

torch.IntTensor(2, 4).zero_()

张量类型

- torch.

Tensor相当于torch.FloatTensor,32位浮点型 - torch.

DoubleTensor64位浮点型 - torch.

ShortTensor16位整型 - torch.

IntTensor32位整型 - torch.

LongTensor64位整型

类型转换

- 浮点型变化: 精度提升

- 32位与64位合并的tensor为64位

- 整型变化:

- 16位与64位合并的tensor为64位

- 浮点型+整型向更大的变化

- 浮点与整型合并为浮点

示例

import torch

# Tensor相当于FloatTensor

a = torch.Tensor([[1, 2], [3, 4], [5, 6]])

print(a)

print(a.type())

# 指定数据类型为64位浮点型

a = torch.DoubleTensor([[1, 2], [3, 4], [5, 6]])

print(a)

print(a.type())

# 16位整型

a = torch.ShortTensor ([[1, 2], [3, 4], [5, 6]])

print(a)

print(a.type())

# 32位整型

a = torch.IntTensor ([[1, 2], [3, 4], [5, 6]])

print(a)

print(a.type())

# torch.LongTensor:64位整型

a = torch.LongTensor ([[1, 2], [3, 4], [5, 6]])

print(a)

print(a.type())

# 类型转化

a = torch.ShortTensor ([[1, 2], [3, 4]])

b = torch.LongTensor([[5, 6], [7, 8]])

result = torch.cat([a,b], 0) # 拼接两个tensor

print(result)

print(result.dtype) # 64位

类型转换图解

转换方法

方法

- 直接转换:直接使用 float, long转换

- tensor.int()

- tensor.type(torch.IntTensor)

- 参考转换:

- type_as 转成指定变量同类型