- 对话AI(conversation AI)

- 现状

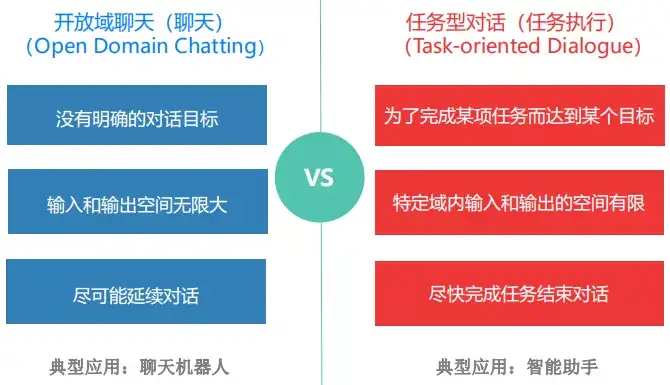

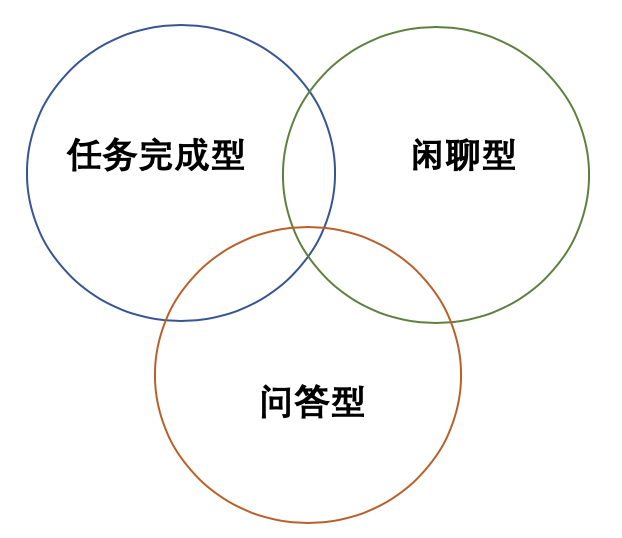

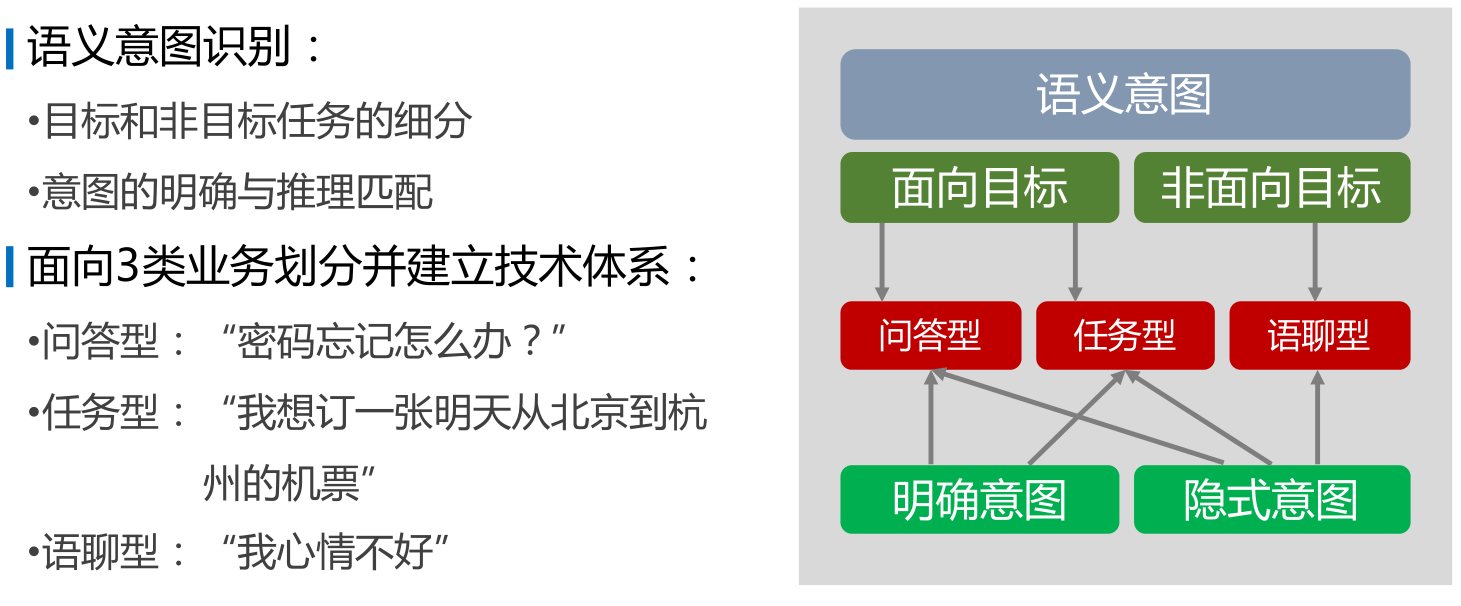

- 对话任务分类

对话AI(conversation AI)

- 【2022-11-16】直接向一本书提问 Ask My Book

- 【2022-5-11】Google Keynote (Google I/O ‘22) ,Google I/O用多模态唤醒语音设备,不再需要重复说唤醒词,还能识别说话人的表述状态,没说完就继续等待,第33分钟

- Google 将更完善语音和自然语言理解模型放在设备本地,以此提高 Google 助理理解语音指令过程中的语气和停顿,下次还没想好要问啥时,就不用从头再来了。

- 2022 谷歌 I/O 大会来了,我们为你挑了 10 个重点

- 【2020-01-23】哈工大张伟男:任务型对话系统

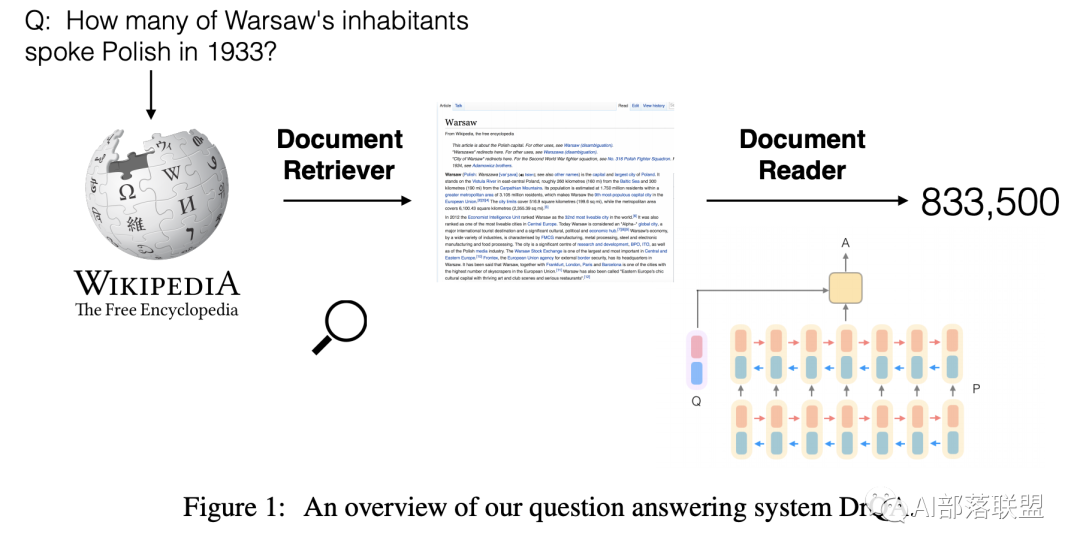

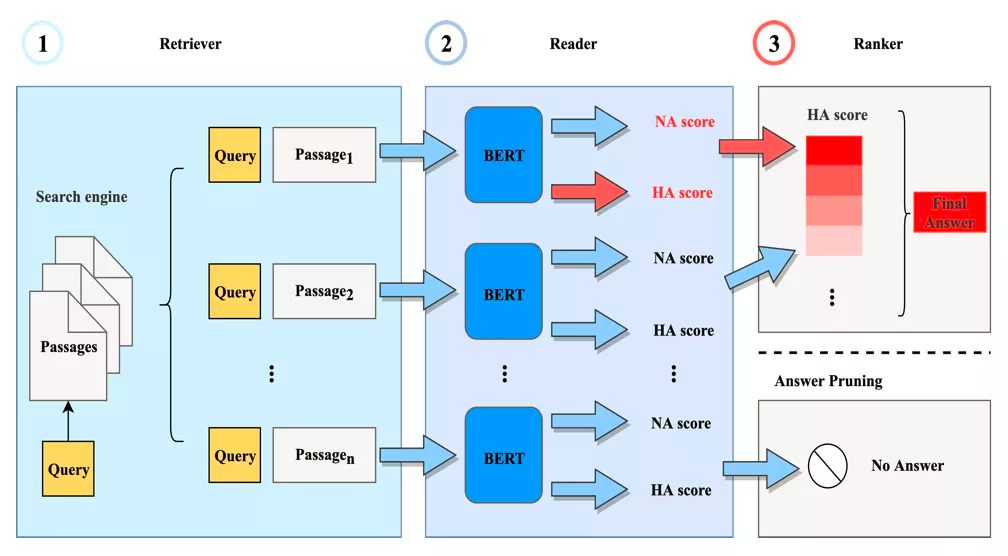

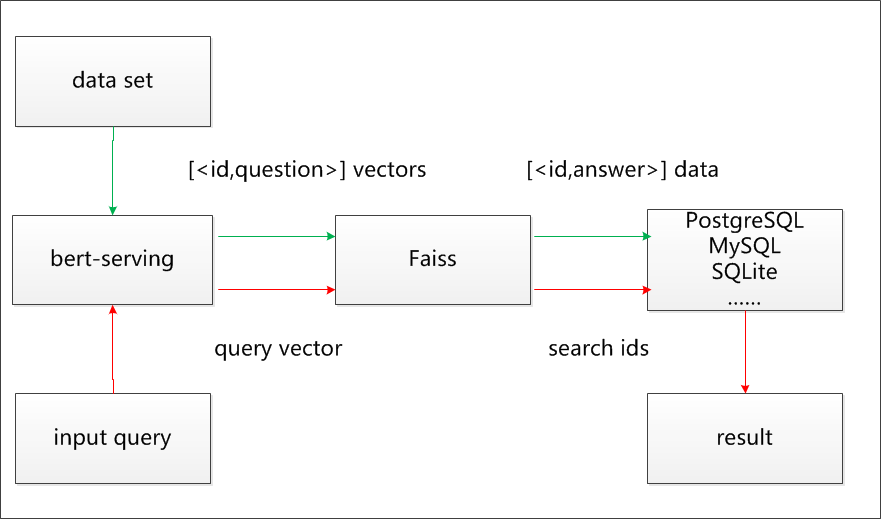

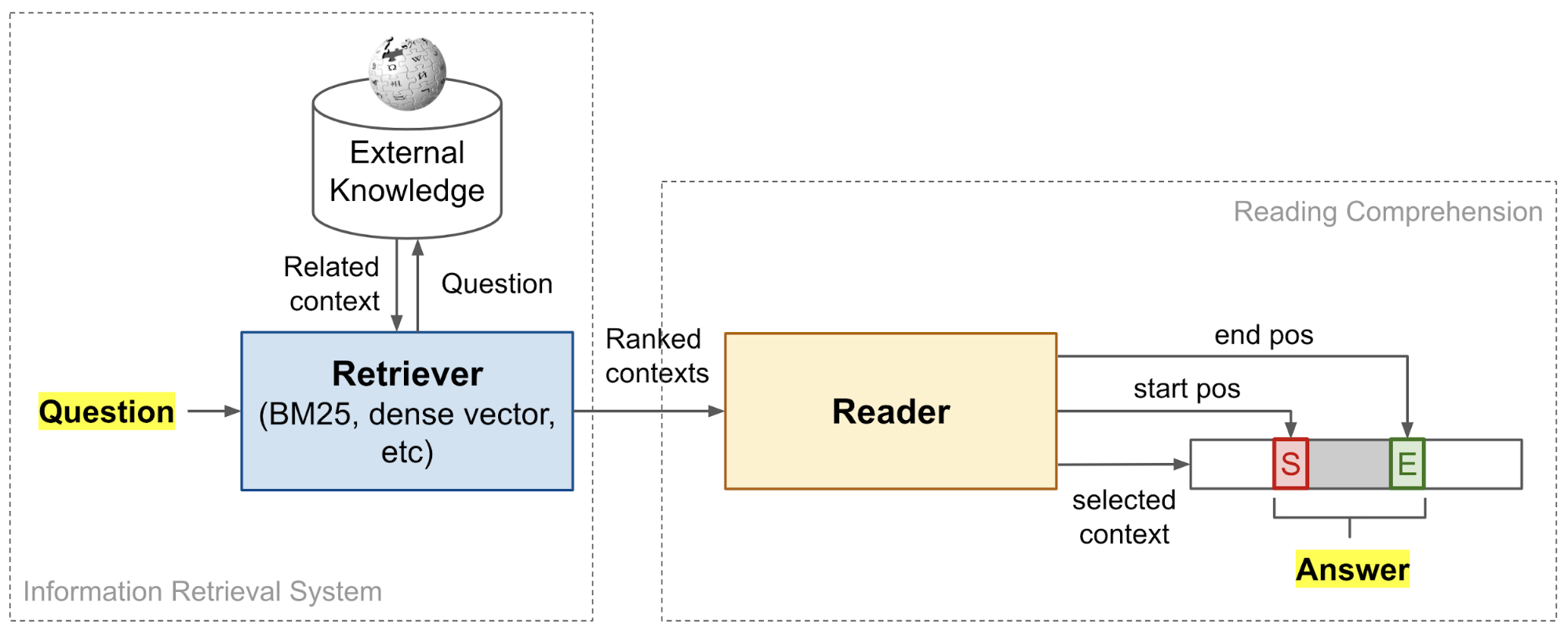

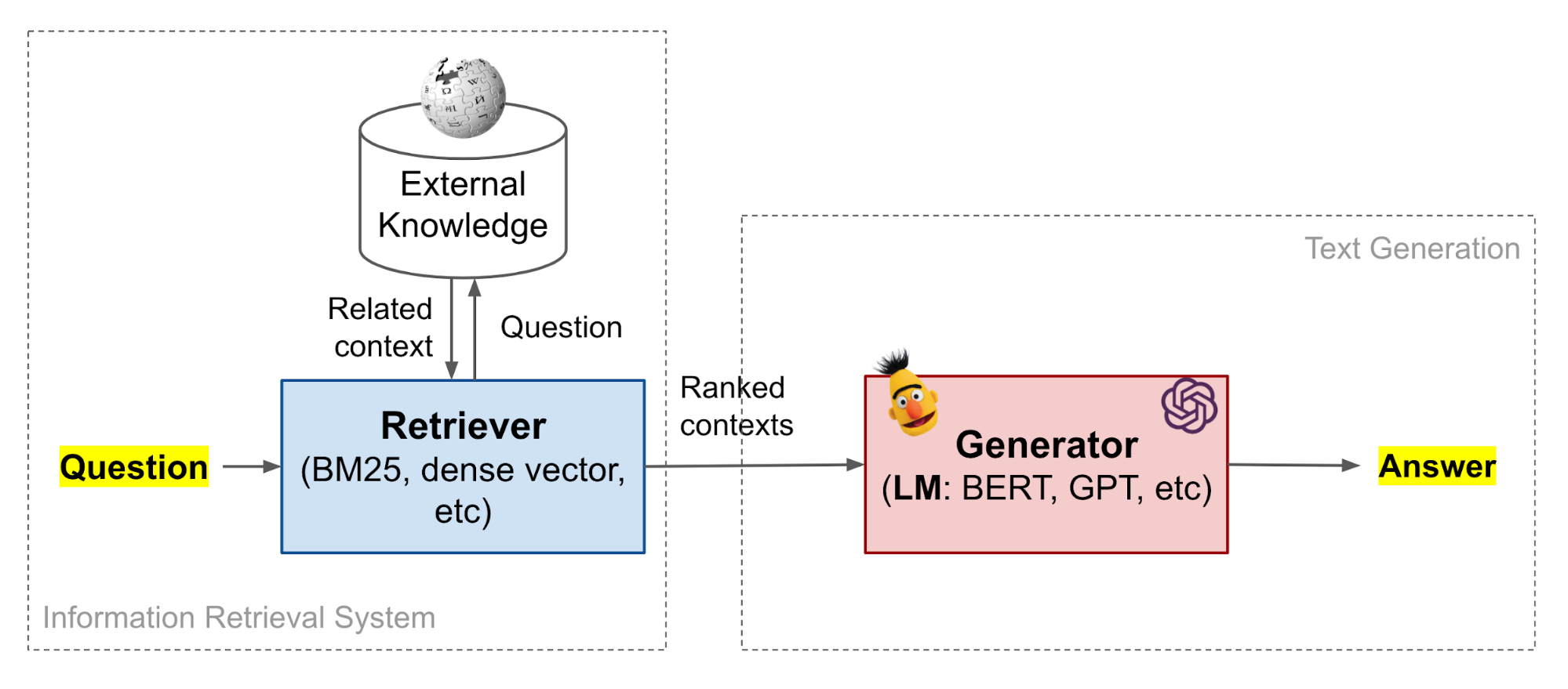

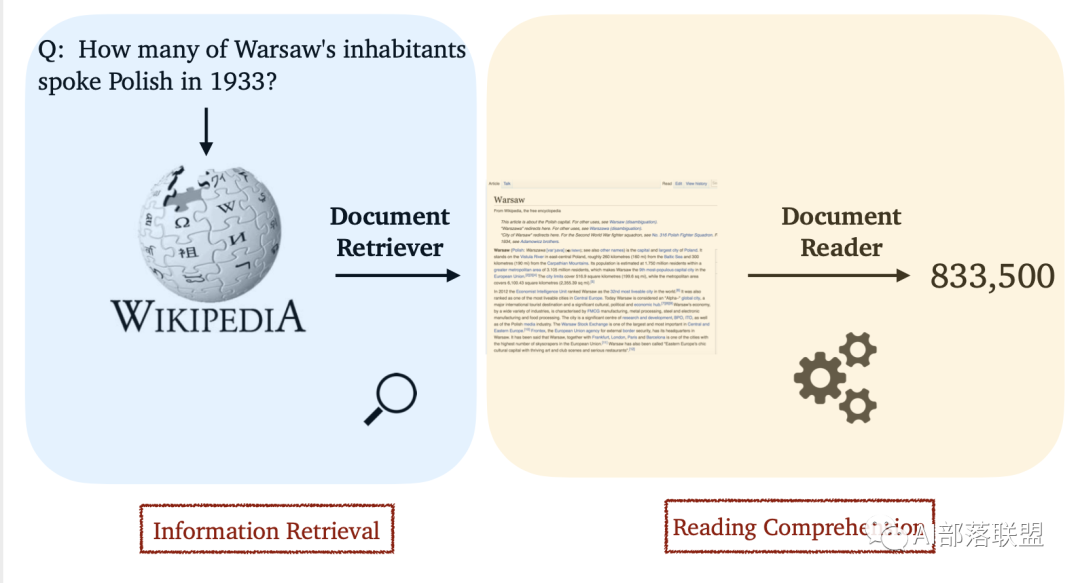

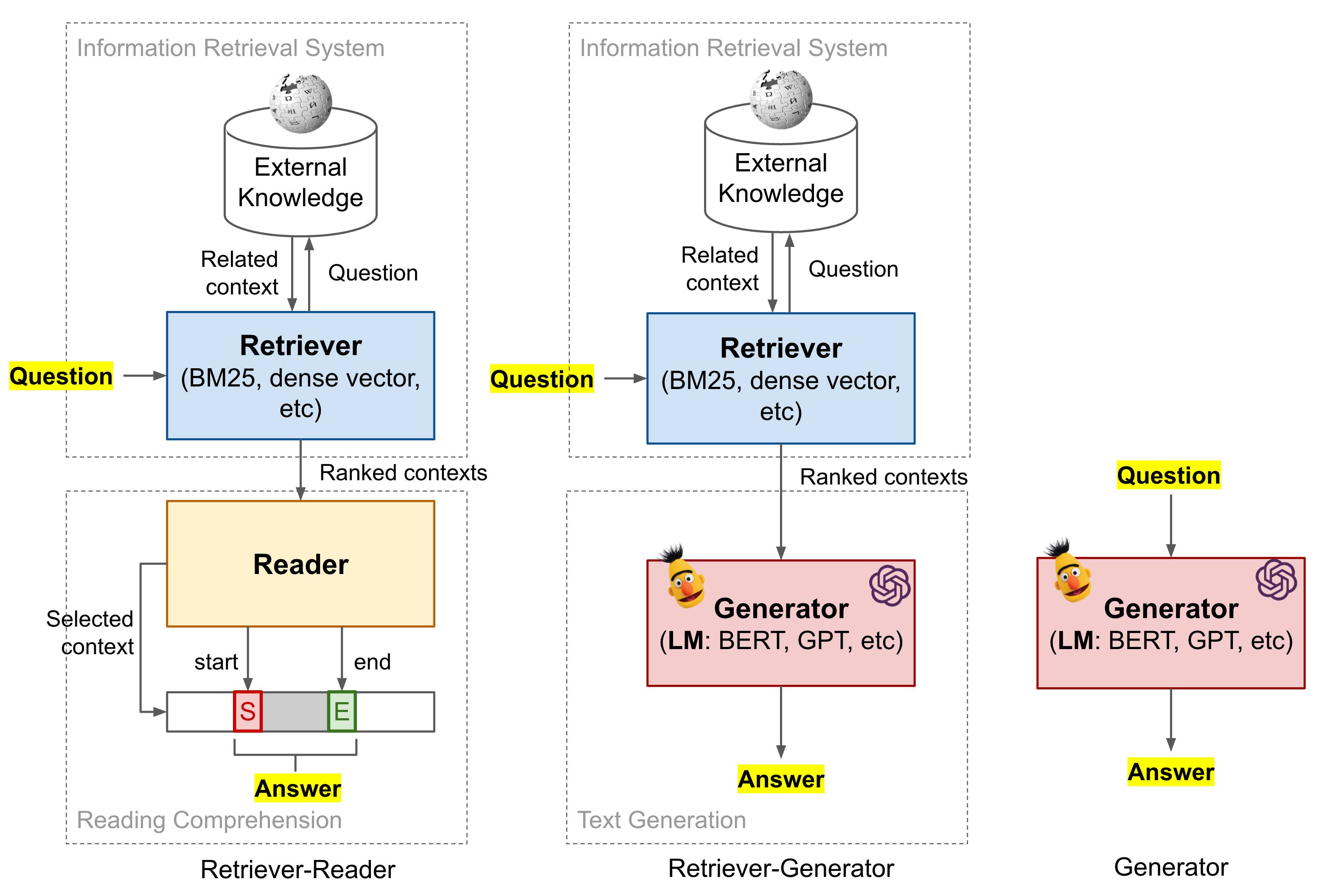

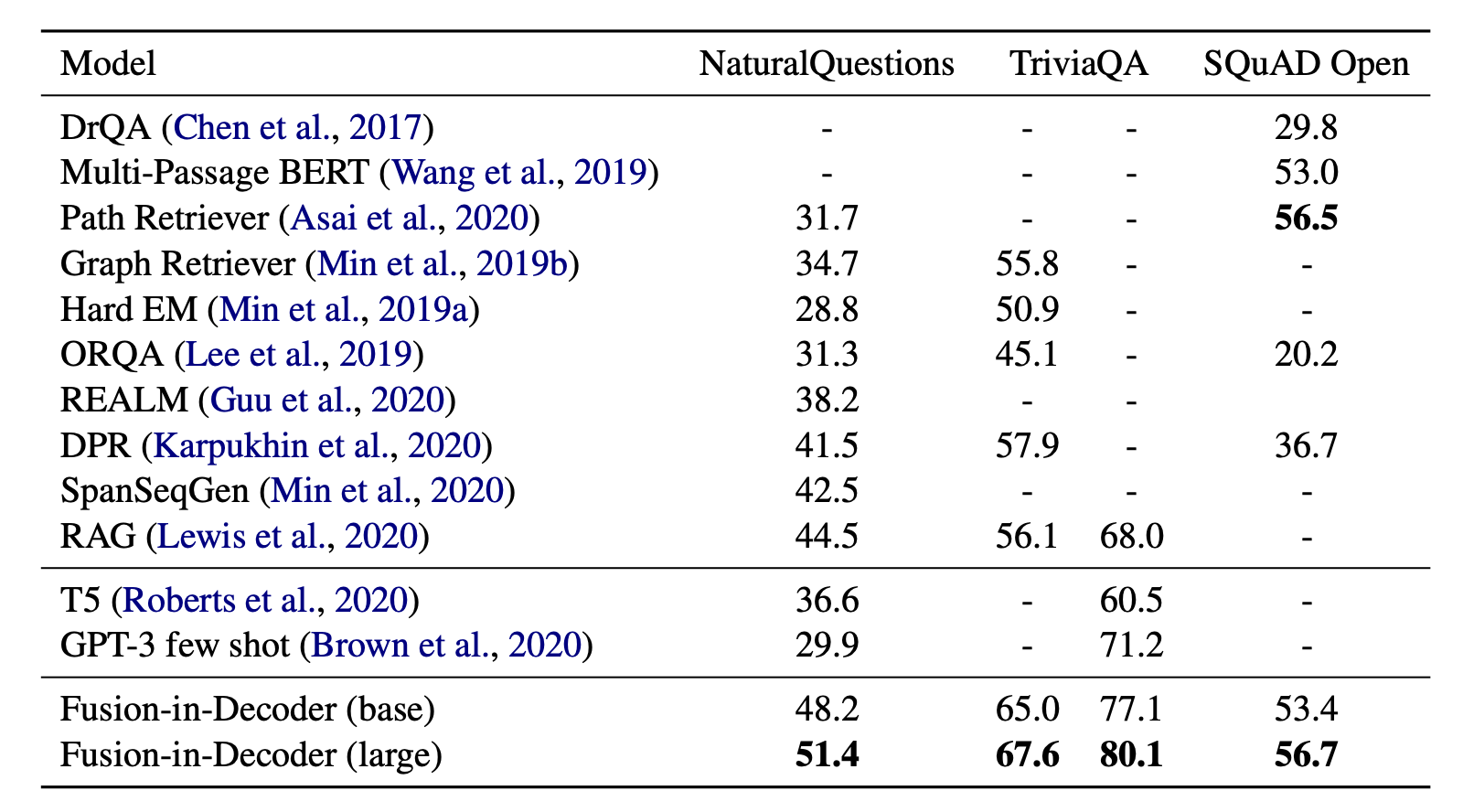

- 【2021-3-29】开放领域问答梳理系列, 两阶段系统:基于信息检索(information Retrieval, IR)+机器阅读理解(Machine Reading Comprehension, MRC)(retriever-reader)的开放领域问答系统

- 【2021-3-27】【开放域长式问答的进展与挑战】《Progress and Challenges in Long-Form Open-Domain Question Answering-Google AI Blog》,论文 paper:《Hurdles to Progress in Long-form Question Answering》

- 【2021-3-25】对话的囧境?

- 人工智能对话系统一直是让我又爱又恨的存在,爱是因为一想到它的终极NB形态就令人兴奋,觉得自己在从事一门可以改变世界的技术,恨是因为现有的技术与期待相差太远,一旦框架搭起来了就陷入解case的死循环,让我怀疑我是谁我在干什么,我有生之年能看到强人工智能吗???

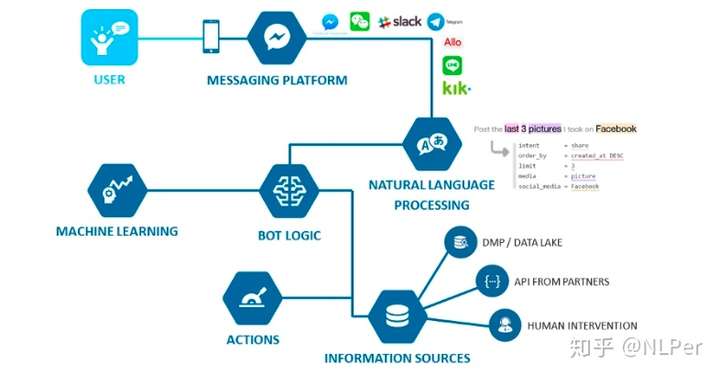

- 【2020-05-16】如何实现聊天机器人?ChatBot技术栈

- 设计一个机器人时,记住三个创新的核心维度:你的产品必须 desirable(满足客户需求)、viable(满足客户需求)、feasible(技术可行性)

- 怎样解释半智能聊天机器人?

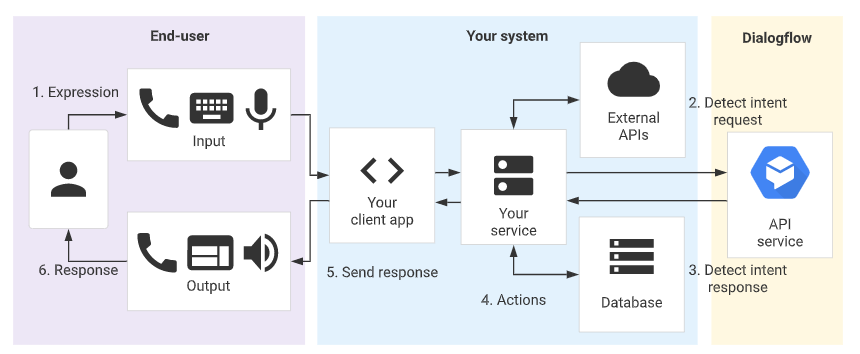

- 用户通过设备在消息平台上进行交互,她的的消息会通过 NLP 进行处理。

- 然后机器人可以启动一个过程,用来自数据库 / API 的实时信息来回应,或者转交人工。

- 接收的消息越多,机器人提升的也就越多:这也就是所谓的机器学习。某些情况下也需要人工来帮助机器人,也就是所谓的监督学习。

- 聊天机器人十大重要问题

- 合适的技术解决方案。举个例子:

- Facebook messenger 可以让你看见在页面管理器中看见所有会话。他们最近宣布了为开发者的转化协议

- Operator,来自 Intercom 的 Operator 似乎被设计成可以让人工插入会话

- Chatfuel 提供按钮来看使「在线聊天会议」, The leading no-code chatbot platform for Facebook, Instagram, and Messenger

- Dashbot 有人工转接功能

- 技术栈:

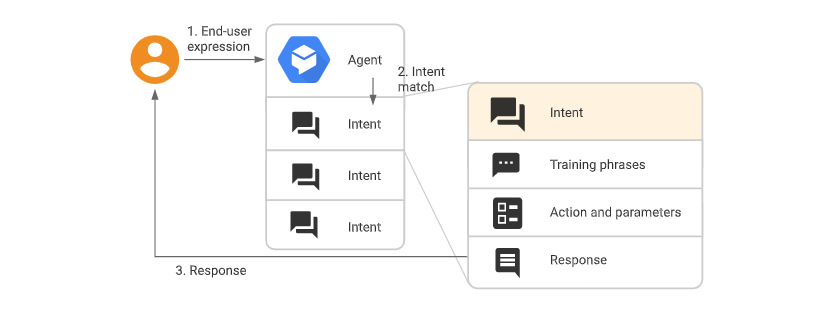

- 用 API.ai 做 NLP 与监督学习:很不错的讨论小功能,支持法语的最佳平台,漂亮的界面……

- 用 Dashbot 做分析以及人工转接:十分详细的统计,易于集成,报表功能……

- 用 Botpress 做 NodeJS 框架:可以迅速搭建并且十分灵活

- 用 Wechat 做消息接口:10 亿的用户,绝佳的聊天 UX

- 用 MongoDB 做数据库:可以由非技术人群更新

- 还有其他一些取决于项目类型的 API(QQ、Spotify、Youtube、 Google Maps……)

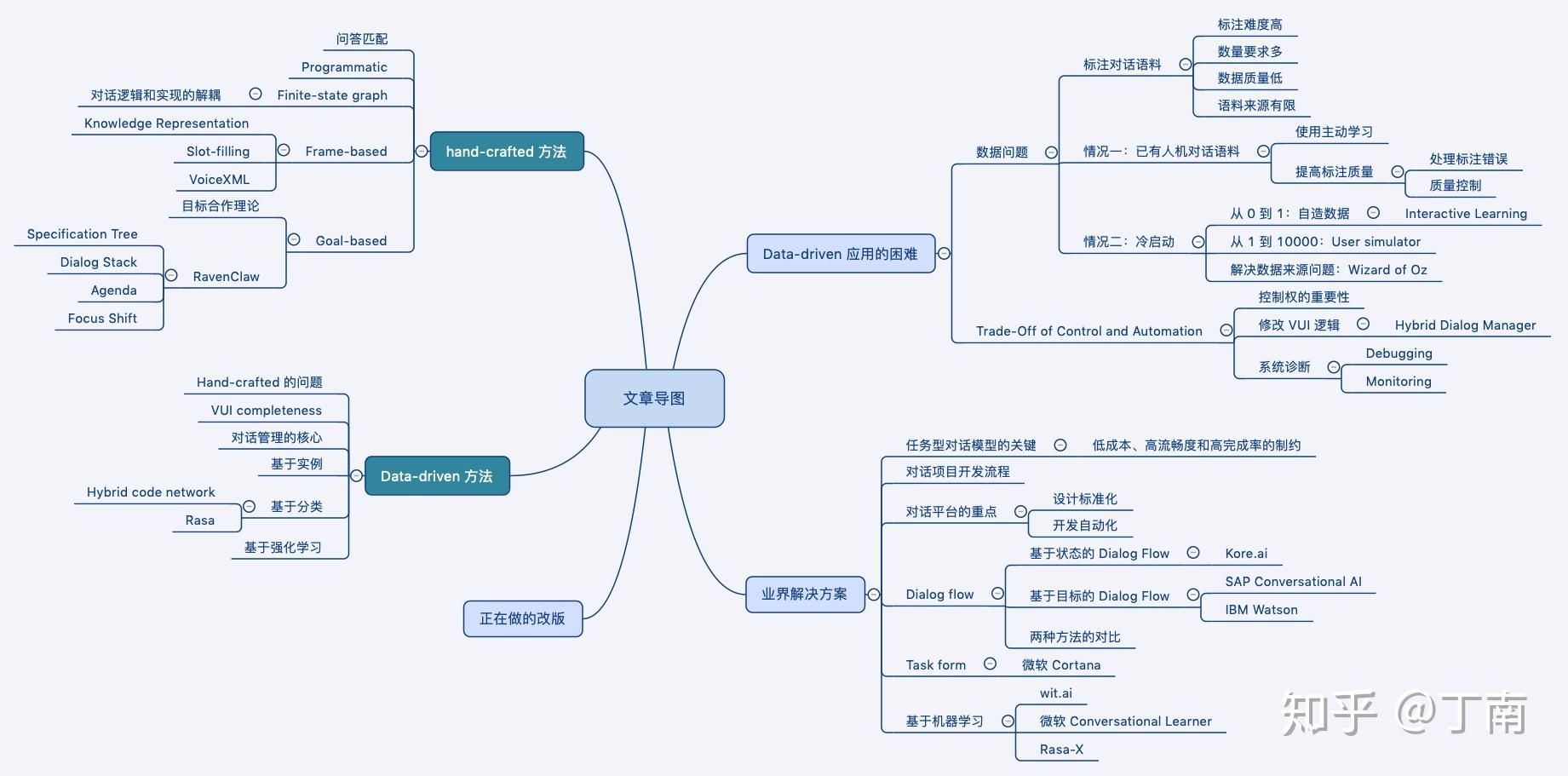

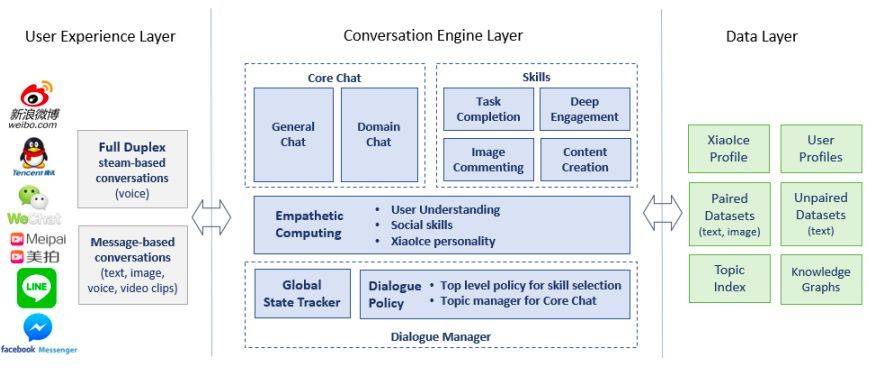

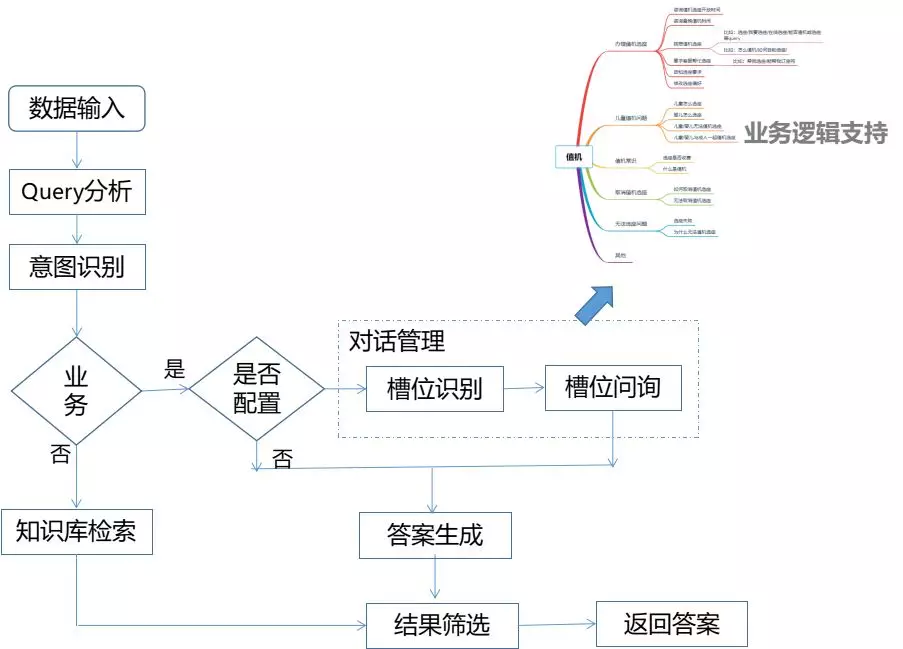

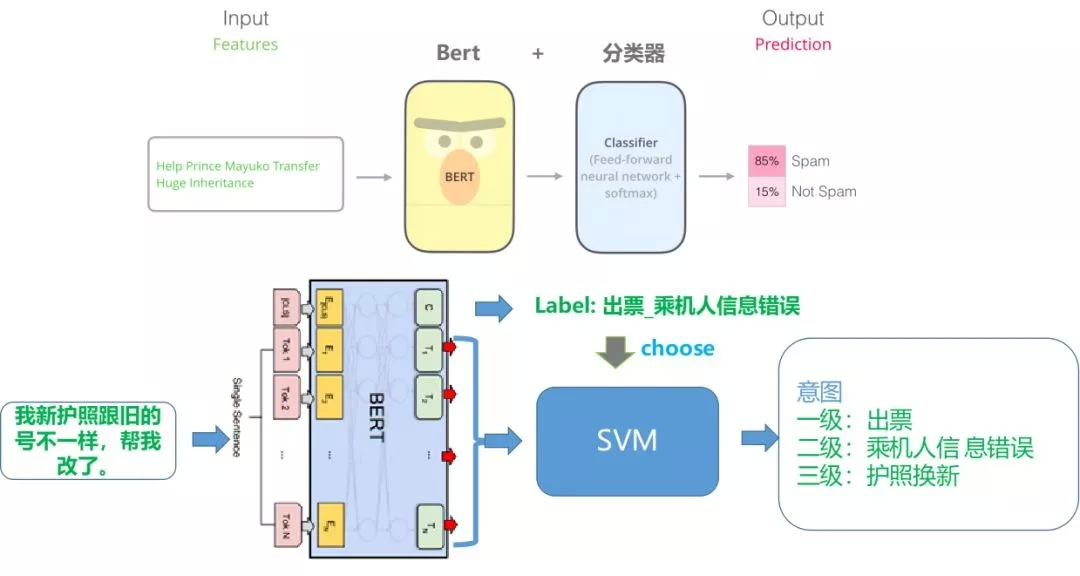

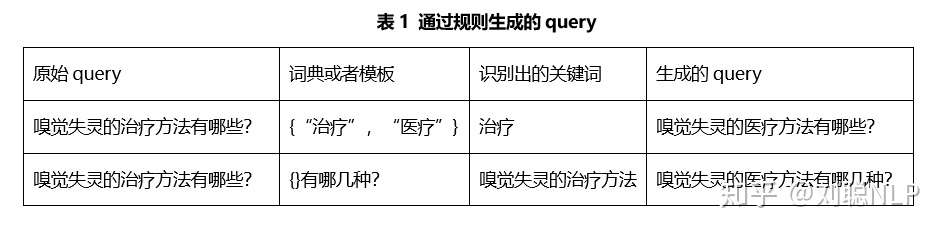

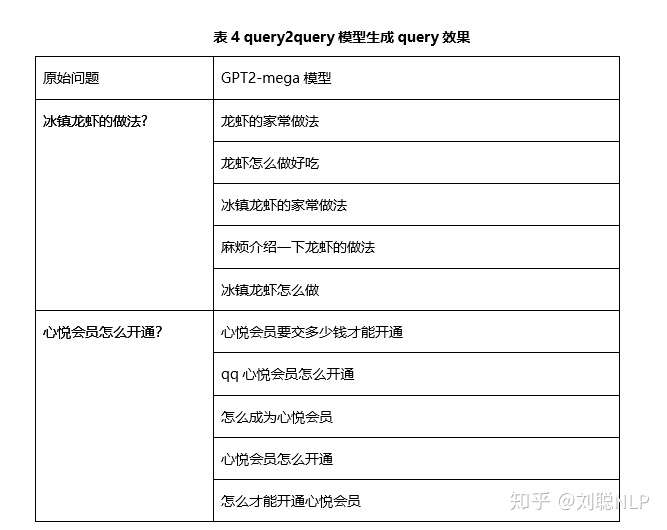

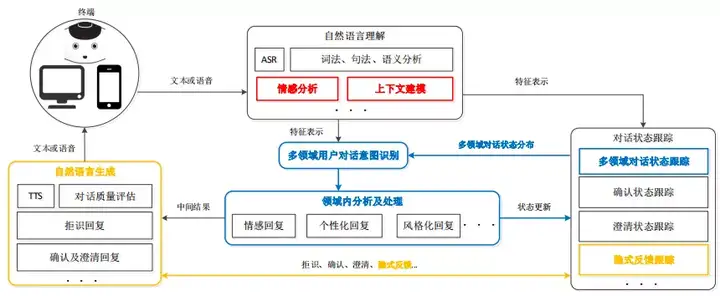

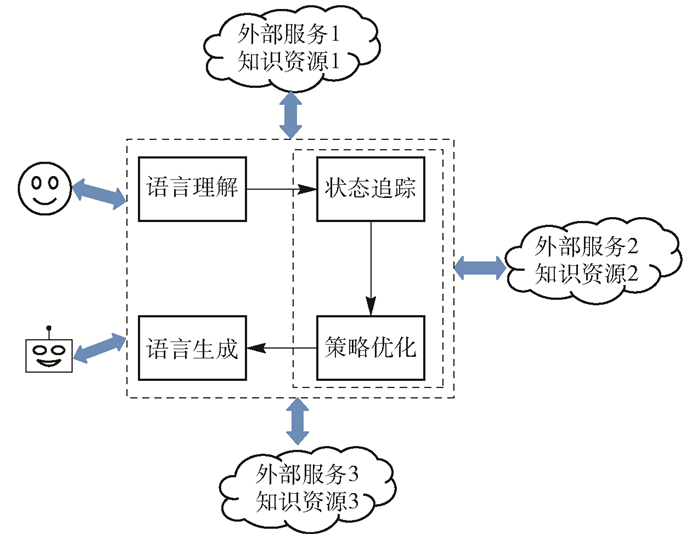

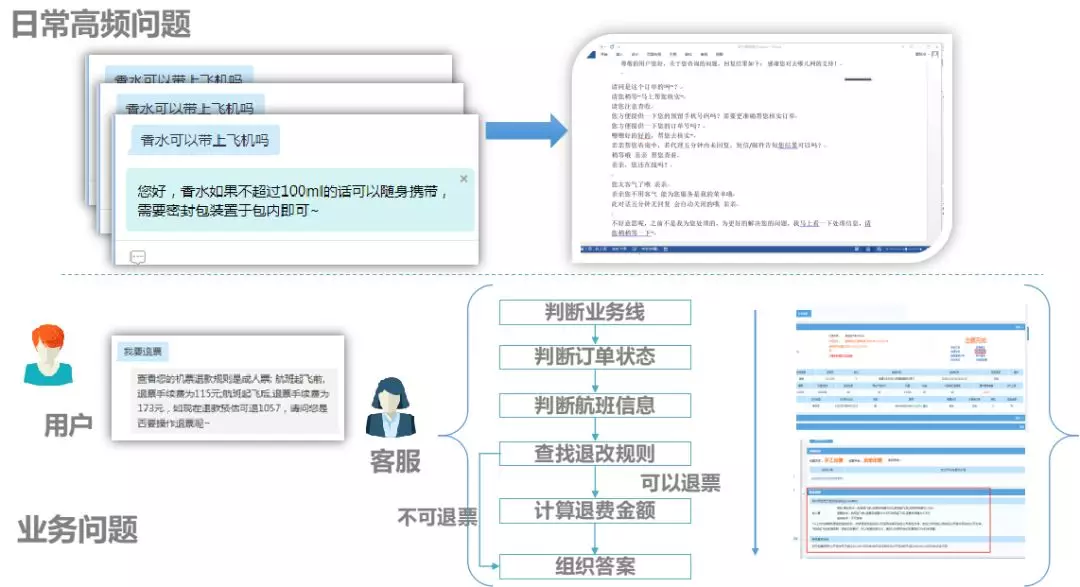

- 【2021-2-22】达摩院Conversational AI研究进展及应用

- 任务型对话引擎Dialog Studio和表格型问答引擎TableQA的核心技术研究进行介绍:

- 语言理解:如何系统解决低资源问题

- 低资源小样本问题

- 冷启动的场景下,统计45个POC机器人的数据,平均每个意图下的训练样本不到6条,是一个典型的小样本学习问题。

- 在脱离了冷启动阶段进入规模化阶段之后,小样本问题依然存在,比如对浙江省11个地市的12345热线机器人数据进行分析,在将近900个意图中,有42%的中长尾意图的训练样本少于10条,这仍然是一个典型的小样本学习问题。

- 解决方案:引入Few-shot Learning系统解决小样本问题;本质是一个迁移学习:迁移学习的方式能够最大化平台方积累数据的优势。即插即用的算法:在应用的时候不需要训练,可以灵活地增添新的数据,这对toB场景非常友好;

- 达摩院Conversational AI团队提出了一个Encoder-Induction-Relation的三层Few-shot learning Framework

- 无论是小孩子还是大人,从小样本中进行学习的时候,主要依靠的是两种强大的能力,归纳能力和记忆能力

- 达摩院提出了Dynamic Memory Induction Networks的动态记忆机制(发表于ACL2020)

- 低资源小样本问题

- 对话管理:如何从状态机到深度模型

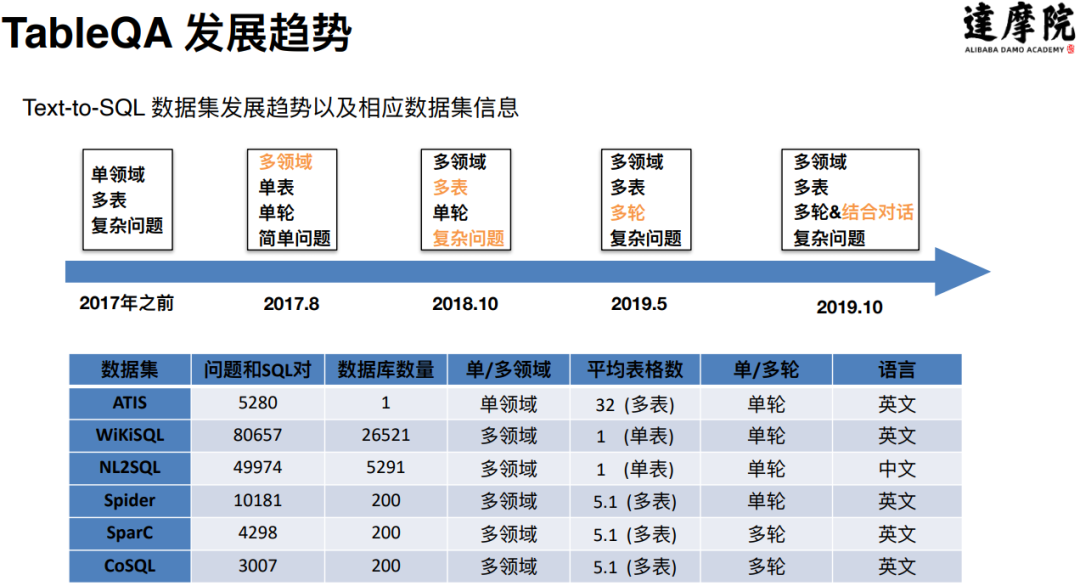

- TableQA:Conversational Semantic Parsing的难点和进展

- 语言理解:如何系统解决低资源问题

- 任务型对话引擎Dialog Studio和表格型问答引擎TableQA的核心技术研究进行介绍:

- 【2021-2-25】达摩院基于元学习的对话系统

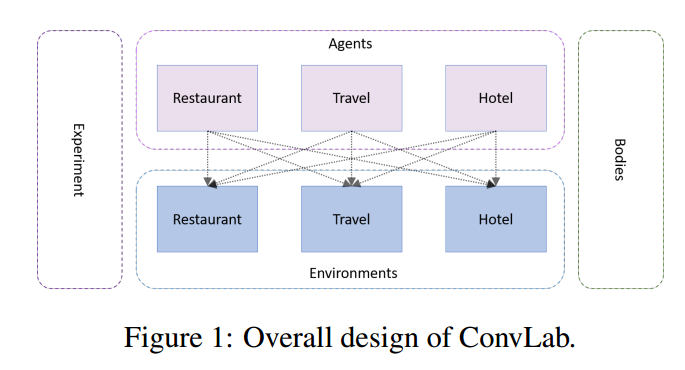

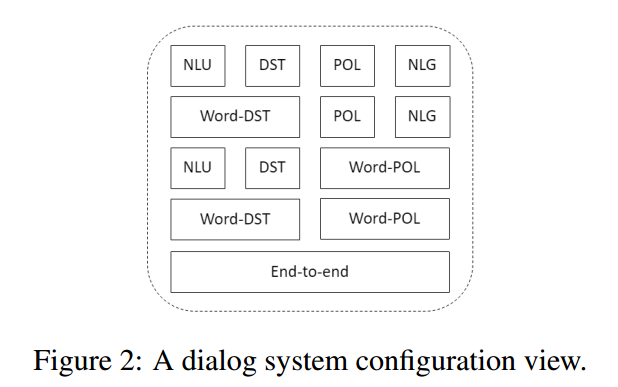

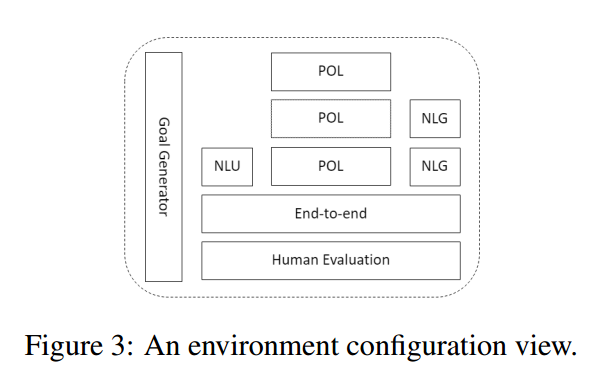

- 台大对话系统,对话AI的两个分支

- Chit-Chat: seq2seq → 集成上下文 → 集成知识库

- Task-Oriented:single-domain → multi-domain, contextual → end2end learning

- 【2021-2-14】思知机器人,开源中文知识图谱,图谱可视化,Demo体验,包含实时tts;OwnThink开源了史上最大规模(1.4亿)中文知识图谱,地址

- 【2021-2-28】Chatopera开发的机器人平台使用指南,王海良,Chatopera联合创始人 & CEO,《智能问答与深度学习》作者,腾讯课堂讲解,Chatopera 为企业提供智能对话机器人和智能客服系统解决方案,这些解决方案面向多个行业,支持通用的业务场景,比如客户服务中的多渠道管理、坐席管理、企业知识库和机器人对话管理。同时,Chatopera 面向开发者提供开源软件、云服务、开发者社区和学习资料,帮助开发者掌握智能对话机器人和客服系统的定制化开发技能,进而为企业客户进一步优化软件服务。保险行业语料库,大盛CRM

- 【2021-6-2】百度机器人平台,UNIT,交互式教程

- 【2021-2-4】调停机器人(斡旋)

图灵测试- 现代计算机之父阿兰·图灵1950年在哲学刊物《思维》上发表了“计算机器与智能”一文,提出了经典的图灵测试(the Turing test),在测试者与被测试者(一个人和一台机器)隔开情况下,通过一些装置, 如键盘, 向被测试者随意提问.进行多次测试后,如果有超过30%的测试者不能确定被测试者是人还是机器,那么这台机器就通过了测试,并被认为具有人类智能.

- 【2021-7-18】2014年,在英国皇家学会举行的”2014图灵测试”大会上,聊天程序“尤金古斯特曼” (Eugene Goostman)首次通过了图灵测试。在惊呼人工智能进入新时代的同时,人们却仍然认为以AI技术为支撑的聊天机器人还不够”机灵”,无法准确理解人类句意。

- 尤金的开发者很狡猾,他们把它伪装成了不以英语为母语的13岁乌克兰男孩儿。成功地让33%的测试人相信了这一点。正如尤金的创造者弗拉基米尔·维塞罗夫(Vladimir Veselov)所说:“我们的主要想法是,尤金可以号称自己无所不知,但受到年龄的限制,所以他不可能什么都知道。”虽然这从技术上完全讲得通,但从感 性角度来看,却一点都不令人佩服。

- 超级计算机首次通过图灵测试:被当作13岁男孩

- 【2021-2-18】悟空机器人:后台管理端 Demo体验地址 (用户名:wukong;密码:用户名+@2019)

- 模块化。功能插件、语音识别、语音合成、对话机器人都做到了高度模块化,第三方插件单独维护,方便继承和开发自己的插件。

- 中文支持。集成百度、科大讯飞、阿里、腾讯等多家中文语音识别和语音合成技术,且可以继续扩展。

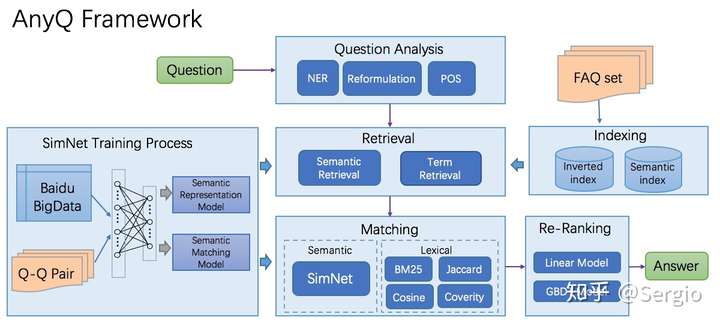

- 对话机器人支持。支持基于 AnyQ 的本地对话机器人,并支持接入图灵机器人、Emotibot 等在线对话机器人。

- 全局监听,离线唤醒。支持 Muse 脑机唤醒,及无接触的离线语音指令唤醒。

- 灵活可配置。支持定制机器人名字,支持选择语音识别和合成的插件。

- 智能家居。支持和 mqtt、HomeAssistant 等智能家居协议联动,支持语音控制智能家电。

- 后台配套支持。提供配套后台,可实现远程操控、修改配置和日志查看等功能。

- 开放API。可利用后端开放的API,实现更丰富的功能。

- 安装简单,支持更多平台。相比 dingdang-robot ,舍弃了 PocketSphinx 的离线唤醒方案,安装变得更加简单,代码量更少,更易于维护并且能在 Mac 以及更多 Linux 系统中运行。

- 【2020-7-30】沈向洋:从深度学习到深度理解

- 现状:NLP需要更多参数,视觉需要更多层网络

- 这三个方面在实现robust AI时大有可为:

- 其一,构建大规模的强机器学习仿真器。不仅是游戏,还有自动驾驶等复杂系统。

- 其二,对于机器学习本质的深度理解。从优化功能开始,思考我们从里面真正学到的是什么。

- 其三,基于神经与符号的混合模型(Hybrid Neural/Symbolic Model for Robust AI)。——今天演讲的重点

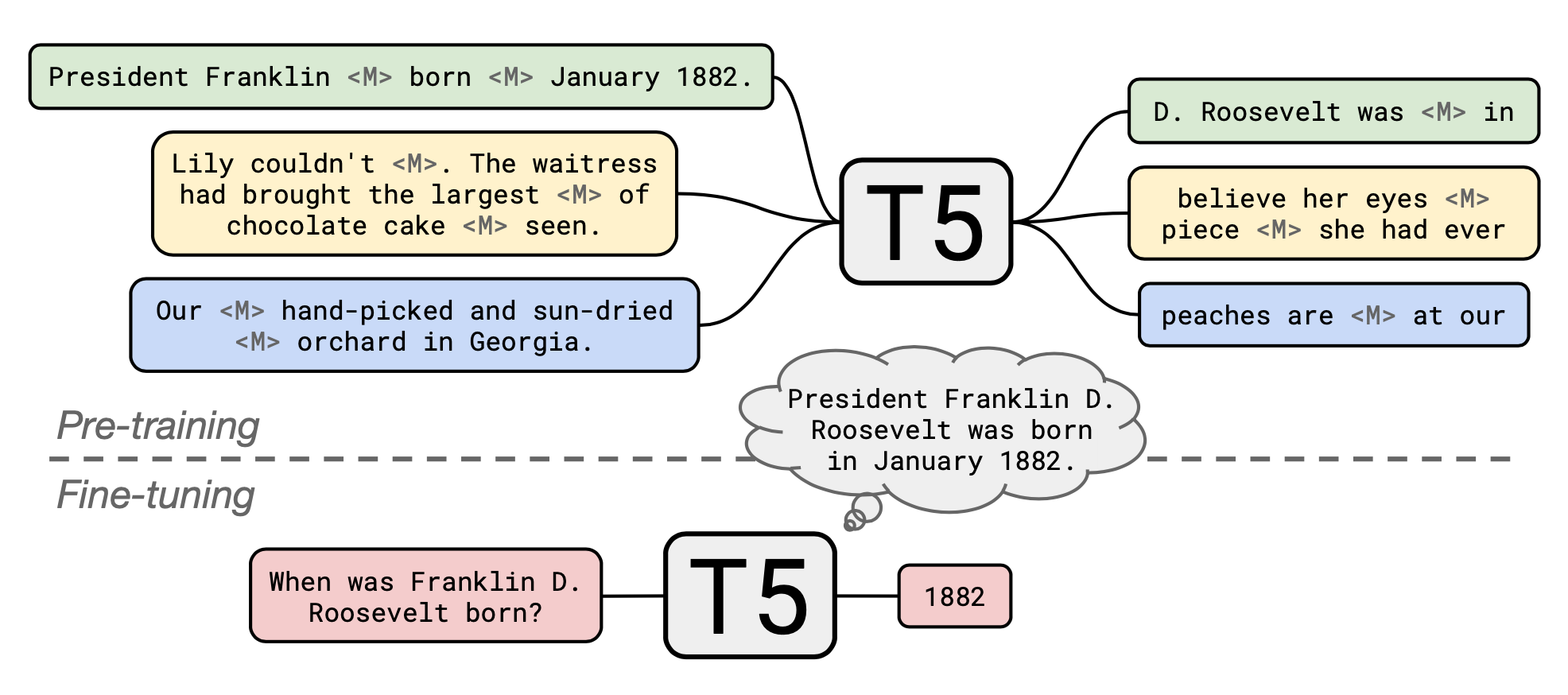

- 雷蒙德微软研究院写了一篇论文,题目为《SOLOIST: Few-shot Task-Oriented Dialog with A Single Pre-trainedAuto-regressive Model》,文章中提出了一种新的方法,能够利用迁移学习进行高效地大规模构建面向任务的对话系统。

- 文章有两个亮点

- 其一是有个预训练模型GTG(Grounded Text generator)

- 其二是该方法实现了真正的会话学习。下面我主要讲讲GTG。

- GTG模型与GPT模型对比也有比较大的优势:GPT是学习如何理解和生成自然语言,而GTG是学习预测对话状态,产生grounded responses(真实响应)来完成任务。

- 【2020-8-10】京东副总裁何晓冬:GPT-3后,人机对话与交互何去何从?CCF-GAIR 2020

- 【2020-7-6】台大陈蕴侬,如何让任务型聊天机器人更加鲁棒,课程主页,PPT链接,pdf

- 7/2018: Jianfeng Gao (MSR AI), Lihong Li (Google AI) and I presented a tutorial on Neural Approaches to Conversational AI at SIGIR-18 and ACL-18. Slides: PowerPoint (with animations) and PDF.

- a tutorial on Neural Approaches to Conversational AI paper at ICML-19. Slides: pdf, Powerpoint.

- 【2020-11-28】优质资料,哈工大张伟男:人机对话关键技术及挑战,【2020-11-6】附:前沿动态综述-闲聊型对话-视频版

- 开放域对话系统

- 任务型对话系统

- 【2021-1-20】【基于Unilm模型的夸夸式闲聊机器人项目】’Unilm for Chinese Chitchat Robot - Unilm for Chinese Chitchat Robot.’ by logCong GitHub

- UniLM论文全名为Unified Language Model Pre-training for Natural Language Understanding and Generation,译为自然语言理解与生成的统一预训练语言模型,来自于微软研究院。

- 开源的模型仅使用豆瓣夸夸群数据训练,所以称之为夸夸式闲聊机器人。感兴趣的同学,也可以使用本项目代码对其他对话语料进行训练。 详细介绍见知乎:夸夸式闲聊机器人之Unilm对话生成。

- UniLM模型之所以强大,是因为它既可以应用于自然语言理解(NLU)任务,又可以应用于自然语言生成(NLG)任务。结构与BERT一致,是由一个多层Transformer网络构成,通过修改训练时的Mask矩阵,使模型拥有更多的能力。

- 云问机器人开源出来的模型

- 不足之处

- 本模型最大的问题是,在训练模型时,没有考虑上下文信息,也就是训练是针对单轮对话进行的,因此无法很好地回答上下文相关的问题,并且可能会出现文不对题的情况。

- 示例

#user:工作不开心

chatbot: 你可以的!工作不开心也可以去吃火锅,看个影响自己心情的电视剧

#user:工作不开心

chatbot: 我也是,不过现在开始努力找工作啦!一起加油鸭~

#user:工作不开心

chatbot:那就祝福你,能找到喜欢的工作吧。

#user:工作不开心

chatbot:你也要加油鸭!

#user:工作不开心

chatbot:我也是,不过总有一天就会好起来的

- 【2021-1-23】空妙对话机器人Demo

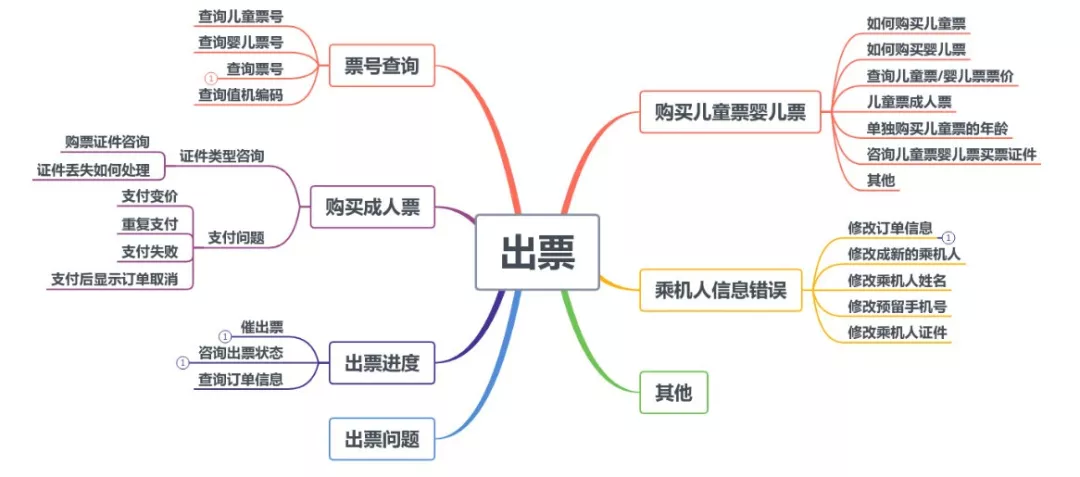

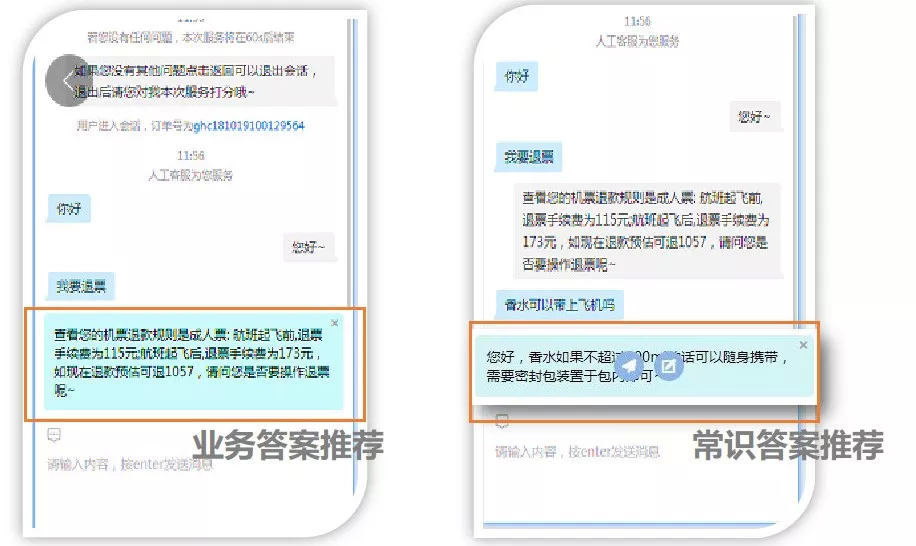

- 【2021-1-28】AI+HI实现 对话系统 NLU/DM 任务详解

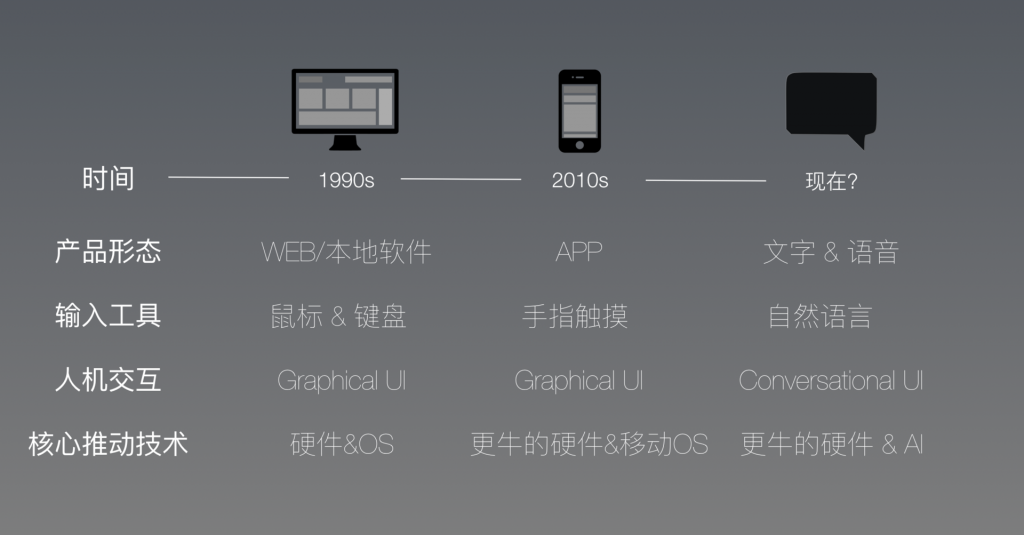

- 在很多场景下,对话用户界面(CUI - Conversational User Interface)比图形用户界面(GUI - Graphical User Interface)更加自然和高效。过去一年中,CUI得到了大量的关注,也取得了迅速的发展。微软提出了对话即平台的战略,Facebook Messenger上出现了各种对话机器人(chatbot),很多和CUI相关的创业公司也应运而生。

- AI+HI表示机器助理和真人助理结合起来,为用户提供优质的体验。为什么要这么做呢?因为当真人能够和机器配合时,能产生一个正反馈:

- 真人纠正机器的错误 -> 更好的用户体验 -> 更多的活跃用户 -> 获取更高质量的数据 -> 训练更好地模型 -> 机器更好地辅助真人。

- HI和AI如何无缝的配合呢?我们通过群聊将用户、AI和HI放在一个群里。由AI根据置信度来判断,什么情况下需要将HI加入群内,将什么样的HI加入群内,以及什么时候HI来干预。AI和HI的配合分为三种:

- 1)AI置信度较高时,无需HI干预,对话系统完全由AI来执行动作;

- 2)AI置信度不高时,AI生成候选动作辅助HI来动作;

- 3)AI不确定性很高时,完全由HI接管来执行动作。图

- 基于AI+HI的对话系统中,HI扮演三种角色:

- 1)为AI提供反馈,如NLU出现错误时,HI可以纠正,然后AI在纠正后的对话状态下继续工作;

- 2)在AI的辅助下执行动作,比如AI生成候选动作但不执行,由HI进行判断最终来执行;

- 3)产生标注数据使AI不断进化,例如HI每一次纠错、执行动作都是一个标注的样本,可以用于训练AI。

- 【2021-1-29】对话系统经典任务核心算法对比

- 摘自:智能对话系统架构及算法

| 任务 | 算法 | 优势 | 劣势 |

|---|---|---|---|

| NLU | Classical Classifier | 实现简单,经典分类算法常用于意图分类、领域分类、对话动作分类等 | 需要特征工程 |

| NLU | CRF | 考虑结合标签的转移概率,适合槽位识别任务 | 只使用了固定窗口尺寸,难以扩展 |

| NLU | RNN | 能够对语言内容长距离建模,适合于上下文相关的多轮意图分类 | 梯度消失或者梯度爆炸问题 |

| NLU | LSTM | 结合“门”机制,能够选择记忆和忘记相关信息 | 需要更多的训练数据 |

| DST | Hidden Information State Model | 理论上能够对任意槽值的依赖进行建模 | 只能够保持top N个状态 |

| DST | Bayesian Update of Dialogue States | 能够对状态的概率进行建模 | 只能对简单的依赖进行表征 |

| DST | Static Classifier | 不需要依赖之前的状态,可对任意的分类器工作 | 没有考虑到状态的转移,使用了人工定义的特征 |

| DST | Sequential Classifier | 考虑到状态的转移概率 | 发生在最后一个状态的错误可能会影响当前状态的估计 |

| DST | Transfer Learning | 能够基于现有槽值信息对新任务或领域进行迁移 | 需要大量的特征设计 |

| DPO | Q-Learning | 经典算法,易于实现 | 不能处理连续的动作空间问题 |

| DPO | Policy Iteration | 能够处理连续动作空间问题 | 优化过程不稳定 |

| DPO | Actor Critic | 能够处理连续动作空间问题,稳定地优化 | 需要严格选择函数的逼近方法 |

| DPO | Transfer Learning | 对于原领域和目标领域的槽值适应性 | 计算复杂度高 |

| 端到端 | End-to-End LSTM Policy Network with Answer Selection | 能够进行对话状态的自动学习 | 仍然有组件需要手工定制 |

| 端到端 | End-to-End Training of Modular Dialogue System | 只需要少量的人工参与 | 槽的数量和槽值信息需要提前定义,DST是分开训练的,需要更多的数据 |

| 端到端 | Memory Network based End-to-End Dialogue System | 对确定槽和槽值信息的依赖性低 | 难以与人类知识集成 |

- 经典任务和数据与评测指标对比

- 摘自:智能对话系统架构及算法

| 任务 | 数据集 | 评价指标 |

|---|---|---|

| NLU | ATIS | Accuracy, F1 |

| NLU | Snips | Accuracy, F1 |

| NLU, NLG | TouristInfo | Accuracy, F1 BLEU |

| NLU | DARPA Communicator | Accuracy, F1 |

| DST | DSTC1~DSTC3 | Joint Goal Accuracy |

| DST | WOZ2, mutli WOZ | Joint Goal Accuracy |

| DST, Policy | TownInfo | Accuracy, Reward, Success Rate |

| DST, Policy | Cambridge Restaurant | Reward, Success Rate BLEU |

人机交互

- 【2021-11-4】人工智能应用技术之人机交互(通识篇)

对话系统分级

【2022-6-30】全球首个《AI对话系统分级定义》发布,这下语音助手有了强弱之分

工业应用领域,AI对话系统已经呈现出了爆炸式增长态势,在智能助理、智能客服、社交机器人、心理咨询、虚拟人和元宇宙等多样化场景中随处可见它的身影,比如以小度、小爱、为代表的智能助理,还有以谷歌对话机器人Meena、Facebook聊天机器人Blender为代表的开放域闲聊产品。

当前AI对话系统标准缺失,造成其在应用中呈现出水平参差不齐、评价体系不一的现状,导致了业界因认知不统一而对人工智能交互水平出现误解,也引起了社会上关于意识、伦理、道德等方面的广泛讨论。

根据系统智能化程度的不同,自动驾驶领域有L0-L5的分级标准。《分级定义》制定时主要参考了这种分级方法,不过这种参考并非生搬硬套,因为对话任务本身自有其特征。

黄民烈教授表示,「考虑到AI对话系统任务繁多、评价维度多样、技术路线丰富,撰写小组在制定《分级定义》时仅关注完全由机器主导的对话系统,人机混合的对话系统不在考虑范围内。」

《分级定义》从自动对话能力、对话质量高低、单一/多个场景、跨场景上下文依赖和自然切换能力、拟人化程度、主动和持续学习能力、多模态感知与表达能力等多个角度出发,将AI对话系统划分为从L0~L5的六个等级,等级越高,AI对话系统水平越高。

对话系统分级定义

| 分级 | 定义 |

|---|---|

L0 |

实际对话由人给出,系统完全没有自动对话能力或者在任意单一场景中,系统均无法给出较高质量的对话 |

L1 |

能完成单一场景的较高质量对话:或虽能完成多个单一场景的较高质量对话,但无法处理场景之间的上下文依赖 |

L2 |

在L1的基础上,能同时完成多个场景的较高质量对话,具有处理跨场景的上下文依赖和自然切换能力,无法完成新场景较高质量的对话 |

L3 |

在L2的基础上,能针对大量场景开展高质量对话,在新场景上具有较高质量对话能力 |

L4 |

在L3的基础上,在新场景上具有高质量对话能力在多轮交互中拟人化(指人设、人格、情感、观点等维度的一致性)程度较高 |

L5 |

在L4的基础上,在多轮交互中拟人化程度高,能在开放场景交互中主动学习和持续学习,具有多模态感知与表达能力 |

概念说明

- 高质量:相关性、信息量、自然度分数达到 8-10分(满分10分)

- 较高质量:相关性、信息量、自然度分数达到 6-8分(满分10分)

- 低质量:相关性、信息量、自然度分数小于 6分(满分10分)

- 相关性:指回复与上文的适配度

- 信息量:指回复是否提供足够必要的信息,而非通用回复

- 自然度:是指与人类回复相比的自然度,包含语法是否通顺、是否包含常识错误等

- 测试方式:通过一定数量的测试者与对话系统进行充分的对话交互,在测试之前测试者被告知系统的能力范围但不告知系统的技术实现方式,最后由测试者从三个维度进行主观的总评分

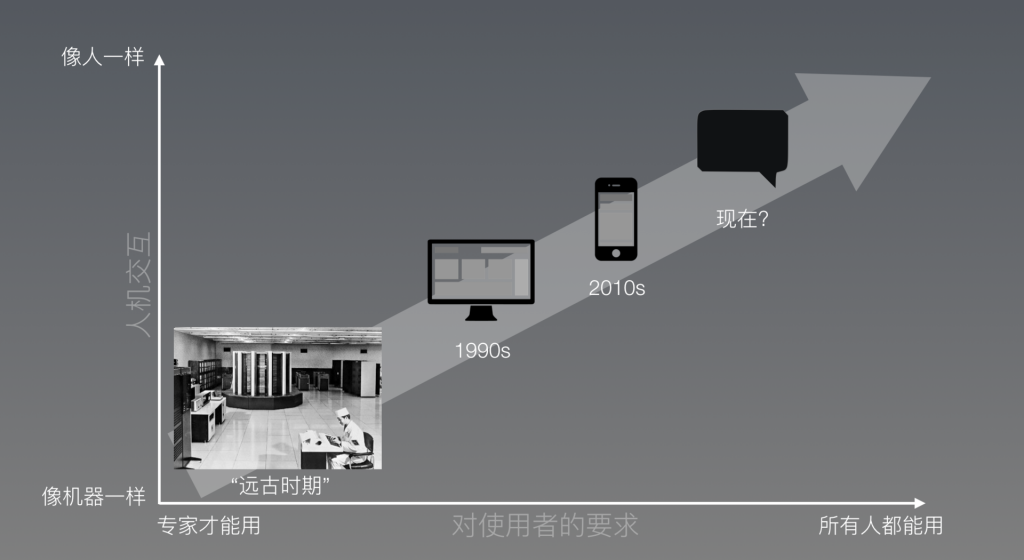

什么是人机交互

人机交互(Human-Computer Interaction, HCI),也称人机互动,是人与计算机之间为完成某项任务所进行的信息交换过程,是一门研究系统与用户之间的交互关系的学问。

人机交互关注的就是人、机器和交互三个部分。

人机交互涉及到计算机科学的多个学科方向,如图像处理、计算机视觉、编程语言等,以及人文学科的多个方向,如人体工程学、人因工程学、认知心理学等,还涉及相关专业领域知识。

人机交互发展历程

人机交互发展历程:人机交互的发展历史,是从人类通过学习适应机器到机器不断地适应人类的过程,人机交互的发展降低了人类使用机器的学习时间和难度壁垒。

目前,人机交互的技术有基于传统硬件设备的交互技术、基于语音识别的交互技术、基于触控的交互技术、基于动作识别的交互技术、基于眼动追踪的交互技术、基于多通道(多种感觉通道和动作通道,如语音、手写、姿势、视线、表情等输入)的交互技术等

对话系统发展历程

基于传统硬件设备的交互技术

我们常用的鼠标、键盘、游戏手柄等都是常用传统硬件的交互技术,这种交互技术用户操作简单,需要外设支持,但不能为用户提供自然的交互体验。

基于语音识别的交互技术

随着人工智能语音识别技术的发展和商业落地,基于语音识别的交互技术已广泛的应用于现实生活中,如Siri,Cortana等。

基于触控的交互技术

基于触控的交互技术目前已实现从单点触控发展到多点触控,实现了从单一手指点击到多点或多用户的交互的转变,用户可以使用双手进行单点触控,也可以通过识别不同的手势实现单击、双击等操作,如我们最常使用的苹果笔记本的触控区,手机的多点触控等。

基于动作识别的交互技术

基于动作识别的交互技术依赖于动作捕获系统获得的关键部位的位置进行计算、处理,分析出用户的动作行为并将其转化为输入指令,实现用户与计算机之间的交互。如Hololens、Leap Motion、Meta2等。

基于眼动追踪的交互技术

基于眼动追踪的交互技术是利用传感器捕获、提取眼球特征信息,测量眼睛的运动情况,估计视线方向或眼睛注视点位置的技术,通过获取人类眼球的运动信息,从而实现一系列的模拟、操纵功能。最常见使用眼动追踪交互技术的是VR领域。

基于多通道的交互技术

多通道交互涵盖了用户表达意图、执行动作或感知反馈信息的各种通信方法,如言语、眼神、脸部表情、唇动、手动、手势、头动、肢体姿势、触觉、嗅觉或味觉等。目前,使用的多通道交互技术包括手写识别、笔式交互、语音识别、语音合成、数字墨水、视线跟踪技术、触觉通道的力反馈装置、生物特征识别技术和人脸表情识别技术等方面。

CUI

- 【2017-1-19】为什么现在的人工智能助理都像人工智障?

- 最大的几次浪潮基本都伴随着一个规律:核心技术(软硬一堆)的出现和整合,带来全新的人机交互方式 ,在此基础上大量的商业应用应运而生。

- GUI 的核心突破是技术大牛(Xerox)带领的,而其商业应用的发扬光大则是产品经理乔布斯从 Xerox 那儿 “偷来” 的。1973 年,Xerox 推出第一款 GUI 技术个人电脑;在 1983 年,苹果也推出了他们首款 GUI 电脑 Lisa(乔老爷 “完美借鉴” )

- CUI 和 GUI 究竟给用户体验带来什么影响?远远不止现在主流的 “把按钮变成语言操控” 那么简单

- 当移动设备出现的时候,大家对如何在智能手机上开发产品缺乏深入了解。所以当时开发者基本都是从最明显的地方起步,也就是触摸代替键鼠操作。

- 早期的大量应用,都是从 “如何把 web 缩小到手机屏幕” 的思路出发来设计 app 的。—— 这是典型的延续上一代交互的思路。

- 随着开发者不断思考和挖掘移动端的潜力,慢慢有了对移动端真正的核心特质的理解—— 这些 “圣杯属性” 才是真正让移动端产品设计出众的要素。比如 “碎片时间”、“个人身份绑定”、“LBS” 等等,这些特质才是真正让移动产品体现价值的—— 这些是完全颠覆上一代交互的属性。这些属性几乎跟 “触摸” 这个明显的交互行为没有直接关系。

- CUI 出现的时候,产品经理也会面临类似的问题。当前大多数智能助理的设计思路都是 “过去 app 是怎么用的,我现在用语言来代替触摸操作”。好比是用语言来代替手指去触摸屏幕,或者是用说话来代替手指打字。

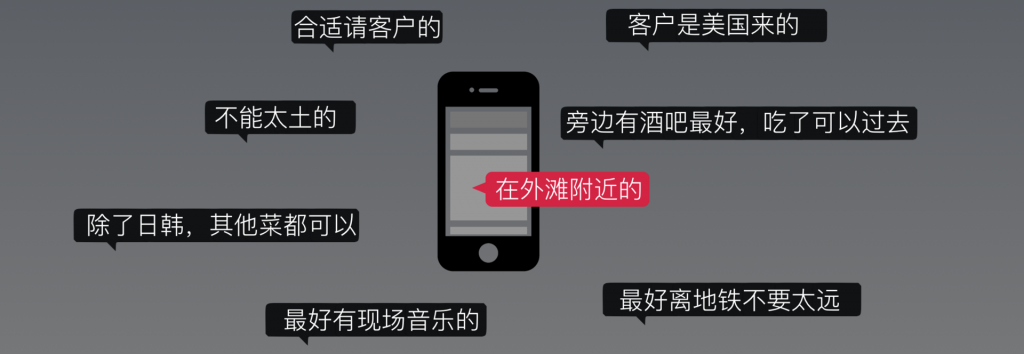

- CUI 的特点:

- 高度个性化。只有 “在外滩附近的” 是之前 GUI 查询范围当中的,其他需求都是过去 GUI 类型当中不存在的维度。但因为 CUI 的开放性,用户很容易给出上面这样高度个性化(非结构化)的需求。

- 使用流程非线性:譬如 GUI 是线性的流程,界面引导用户一步一步走到结果;而 CUI 则可以是完全无视先后顺序的,用户可以在最开始就提出到本来排在最后的条件当中。

- 可避免信息过载:用户打开 GUI 的一个界面,比如点评上找一个餐厅,用户得在一个列表里去找寻自己最想要的选项(典型的案例是,GUI 让用户选择国家的时候那一长排的列表)。而 CUI 则可以规避用户信息过载,直接给出期望结果。这个特点的另一面是,GUI 因此是 informative 的,给不熟悉场景的用户更多提示,或者比较结果的机会。

- 复合动作:“明天后天,晚上最便宜的机票”——从用户的操作和实际体验来看,GUI 无法一次给出结果,只能用户先查一次明天的机票,再查一次后天的机票,然后手动来对比。CUI 完胜——可以直接给出相关条件的检索结果,前提是 AI 足够优秀。

- 高度个性化。只有 “在外滩附近的” 是之前 GUI 查询范围当中的,其他需求都是过去 GUI 类型当中不存在的维度。但因为 CUI 的开放性,用户很容易给出上面这样高度个性化(非结构化)的需求。

- 随着技术的平民化 (democratization),人机交互正不可逆转地向人的方向靠近——不需要学习的人机交互。越来越多的人都能更自然地通过计算设备来获得价值。下一个超级增长点的交互方式,一定是交互更接近人的自然行为,更多人可以使用的。

- 顺为资本:

- 所谓 “做 AI 的” 也有几个类型,底层研发和做应用的是两码事。

- 人工智能的底层交给大公司,小创业公司可以做点小模块。而应用层则有大量的空间给创业公司来实现商业化。

- “这个行业缺 AI 的产品经理,不缺一般意义上的明星,特别牛 x 的算法达人,牛 x 的北京 BAT 出来的人。” 这方面,“人工智能社区是极其开放的,大多数顶级研究者会出版他们的著作/分享他们的想法甚至开源代码。因此,在这个技术开元环境下,数据和人才就是稀缺的资源。”

- CUI 的核心技术是 AI(不只是NLP)。对 CUI 作为新一代颠覆性人机交互的理解,才在产品形态上能发挥底层技术的商业价值。

- 对话式的 Agent 得至少满足以下功能:

- 具备基于上下文的对话能力(contextual conversation)

- 具备理解口语中的逻辑 (logic understanding)

- 所有能理解的需求,都要有能力履行(full-fulfillment)

- 基于上下文的对话能力(contextual conversation)

人机交互研究趋势

借助AMiner平台分析近年来人机交互研究的热点有虚拟现实(Virtual Reality)、增强现实(Augmented Reality)、交互设计(Interaction Design)、视觉缺陷(Visual Impairment)、混合现实(Mixed Reality)、社会计算(Social Computing)、普适计算(Ubiquitous Computing)、眼动追踪(Eye Tracking)、信息可视化(Information Visualization)、众包(Crowdsourcing)。其中,虚拟现实、增强现实是未来的研究热点。

人机交互领域相关顶会有:CSCW,CHI,TOCHI,IJHCS,IWC,IJHCI

【2021-10-21】人机对话的几个层级及发展方向

- 层级

| 层级 | 场景 | 模态 | 对话能力 |

|---|---|---|---|

| L1 | 受限场景 | 单模态 | 预定义对话 |

| L2 | 半开放场景 | 单模态 | 预定义对话 |

| L3 | 半开放场景 | 多模态 | 预定义对话 |

| L4 | 半开放场景 | 多模态 | 终身学习对话 |

| L5 | 完全开放场景 | 多模态 | 终身学习对话 |

Conversational AI发展方向

- (1)知识驱动+主动交互+终身学习:能力自主进化、知识自主进化、文档→结构化知识

- (2)多模态、有情感:多模态内容理解、对话建模、回复生成

- (3)多语言:

人工智障

对话系统本质:思维

【2019-01-21】【精华】人工智障 2 : 你看到的AI与智能无关

人类对话的本质:思维. 人们用语言来对话,最终的目的是为了让双方对当前场景模型(Situation model)保持同步。

- Toward a neural basis of interactive alignment in conversation

- The interactive-alignment model (based on Pickering and Garrod, 2004)

对话系统领域,不少人认为Context是仅指“对话中的上下文”

-

除此以外,Context还应该包含了对话发生时人们所处的场景。这个场景模型涵盖了对话那一刻,除了明文以外的所有已被感知的信息。 比如对话发生时的天气情况,只要被人感知到了,也会被放入Context中,并影响对话内容的发展。

场景模型是基于某一次对话的,对话不同,场景模型也不同;- 而

世界模型则是基于一个人的,相对而言长期不变。

对世界的感知,包括声音、视觉、嗅觉、触觉等感官反馈,有助于人们对世界建立起一个物理上的认识。对常识的理解,包括各种现象和规律的感知,在帮助人们生成一个更完整的模型:世界模型。

无论精准、或者对错,每一个人的世界模型都不完全一样,有可能是观察到的信息不同,也有可能是推理能力不一样。世界模型影响的是人的思维本身,继而影响思维在低维的投影:对话。

影响人们对话的,仅是信息(还不含推理)至少就有这三部分:明文(含上下文)+ 场景模型(Context)+ 世界模型。

普通人都能毫不费力地完成这个工作。但是深度学习只能处理基于明文的信息。对于场景模型和世界模型的感知、生成、基于模型的推理,深度学习统统无能为力。这就是为什么现在炙手可热的深度学习无法实现真正的智能(AGI)的本质原因:不能进行因果推理。

根据世界模型进行推理的效果,不仅仅体现上在对话上,还能应用在所有现在成为AI的项目上,比如自动驾驶。

人们对话的本质是思维交换,而远不只是明文上的识别和基于识别的回复。而当前的人工智能产品则完全无法实现这个效果。那么当用户带着人类的世界模型和推理能力来跟机器,用自然语言交互时,就很容易看到破绽。

- Sophia是一个技术上的骗局(凡是鼓吹Sophia是真AI的,要么是不懂,要么是忽悠);

- 现在的AI都不会有真正的智能(推理能力什么的不存在的,包括Alpha go在内);

- 只要是深度学习还是主流,就不用担心AI统治人类;

- 对话产品感觉用起来智障,都是因为想跳过思维直接模拟对话(而现在也只能这样);

- “用的越多,数据越多,智能会越强,产品就会越好,使用就会越多”——对于任务类对话产品,这是一个看上去很酷,实际上不靠谱的观点;

- 一个AI agent,能对话多少轮,毫无意义;

- to C 助理产品做不好,是因为解决不了 “如何获得用户的世界模型数据,并加以利用”这个问题;

- to B的对话智能公司为何很难规模化?(因为场景模型是手动生成的)

- 先有智能,后有语言:要做到真正意义上的自然语言对话,至少要实现基于常识和世界模型的推理能力。而这一点如果能实现,那么我们作为人类,就可能真的需要开始担心前文提到的智能了。

- 不要用NLP评价一个对话智能产品:年底了,有些媒体开始出各种AI公司榜单,其中有不少把做对话的公司分在NLP下面。这就好比,不要用触摸屏来衡量一款智能手机。在这儿我不是说触摸屏或者NLP不重要(Essential),反而因为太重要了,这个环节成为了每一家的标配,以至于在这方面基本已经做到头了,差异不过1%。

- 对于一个对话类产品而言,NLU尽管重要,但只应占个整体配件的5-10%左右。更进一步来说,甚至意图识别和实体提取的部分用大厂的,产品间差异也远小于对话管理部分的差距。真正决定产品的是剩下的90%的系统。

对话智能的核心价值:在内容,不在交互

- 我们需要的是对话系统后面的思考能力,解决问题的能力。而对话,只是这个思考能力的交互方式(Conversational User Interface)。如果真能足够聪明的把问题提前解决了,用户甚至连话都不想说。但是对于一个企业而言,客服是只嘴和耳,而专家才是脑,才是内容,才是价值。客服有多不核心?想想大量被外包出去的呼叫中心,就知道了。

对话智能解决重复思考

- 对话智能的产品的核心价值,应该在解决问题的能力上,而不是停留在交互这个表面。

- 工业革命给人类带来的巨大价值在于解决“重复体力劳动”这件事。

- 大量重复的工作不停的演变,从重复的体力,逐步到重复的脑力。

- 对一个场景背后的“思考能力”没有把控的AI产品,会很快被代替掉。首当其冲的,就是典型意义上的智能客服。

- “智能客服” 称为“前台小姐姐”, 他们最重要的技能就是对话,准确点说是用对话来“路由”——了解用户什么需求,把不合适的需求过滤掉,再把需求转给专家去解决。

- 与客服机器人产品对应的是专家机器人。一个专家,必定有识别用户需求的能力,反之不亦然。

- 专业能力是这个机构的核心,而客服不是。

NLP在对话系统里解决的是交互的问题。

- 对话智能类的产品最核心的价值是进一步的代替用户的重复思考。Work on the mind not the mouth. 哪怕已经是在解决脑袋的问题,也尽量去代替用户系统2的工作,而不只是系统1的工作。

对话是思想从高维向低维的投影,用低维方法解决高维问题本身就是极大的挑战,日常对话涉及的环境远不止上文会话历史这么简单,还有时间、地点、教育背景、沟通双方的认知方式等,如果想做成无障碍真人交互级别,单靠深度学习/GPT技术不行,将来也不行…即便是免语言交互的脑机接口也面临沟通障碍,对话相关产品需要降低预期,不可完全对标真人场景交互效果。当前GPT系列的大模型对话也依然只是一个工具,变蛔虫很难,即便是身边的亲朋好友都未必能理解人的真实意图、想法,更何况是机器

2017年10月,一个叫Sophia的机器人,被沙特阿拉伯授予了正式的公民身份。公民身份,这个评价比图灵测试还要牛。

- Sophia in AI for Good Global Summit 2017. Source: ITU

- Sophia经常参加各种会、“发表演讲”、“接受采访”,比如去联合国对话,表现出来非常类似人类的言谈;去和Will Smith拍MV;接受Good morning Britain之类的主流媒体的采访;甚至公司创始人参加Jim Fallon的访谈时一本正经的说Sophia是“basically alive”。

2018 年 11 月,小米 AIoT(人工智能 + 物联网)开发者大会上,「雷布斯」雷军骄傲地展示了新品智能音箱「小爱同学」。

- 雷军:「小爱,你能做什么?」

- 小爱:「人家还小嘛,这个问题太难了……」

- … …

- 雷军:「三个木叫什么?」

- 小爱:「木三分……」

- 雷军:「三个木叫什么?」

- 小爱:「你是电,你是光,你是唯一的神话。」

- 雷军:「三个木头的木叫什么?」

- 小爱:「粘树的木头,感觉你是个乐观……」

- 雷军:「小爱,是不是每次演示的时候你都要出错?」

尴尬的雷军继续问小爱,「125 加 357 加 567 等于多少?」但小爱同学直接「下班」,不再回答,全场哄笑一片。

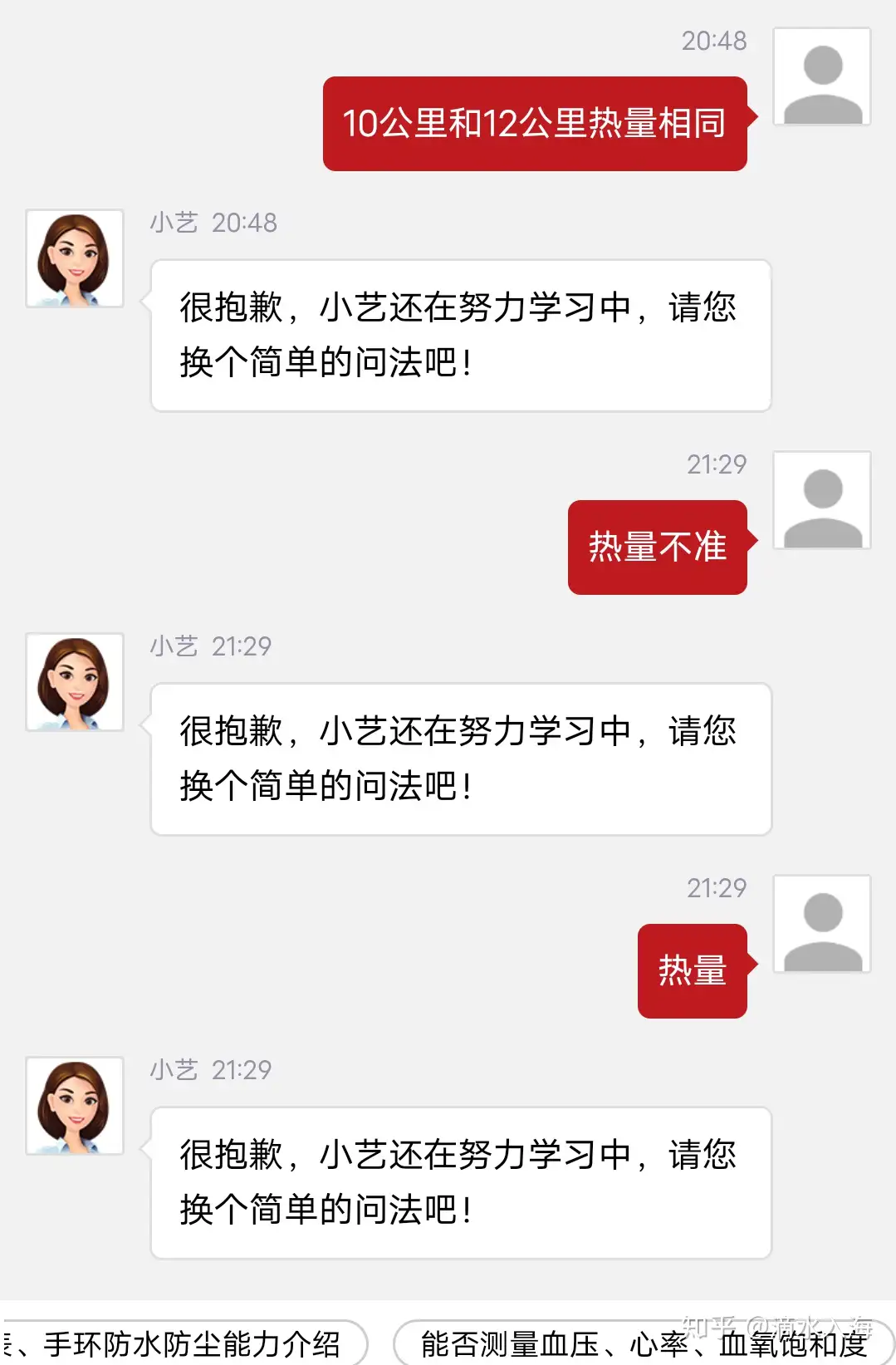

【2018-12-6】「人工智障」,我们还能忍你多久?

贴心提示:

- 华为用户可以试一下,让小艺给你点个外卖,你会震惊的!

- 三星的的Bixby甚至能玩推理游戏。还会模仿情景声音,能把人吓死。

- 和小爱同学说来一首威风堂堂,你会回来感谢我的。

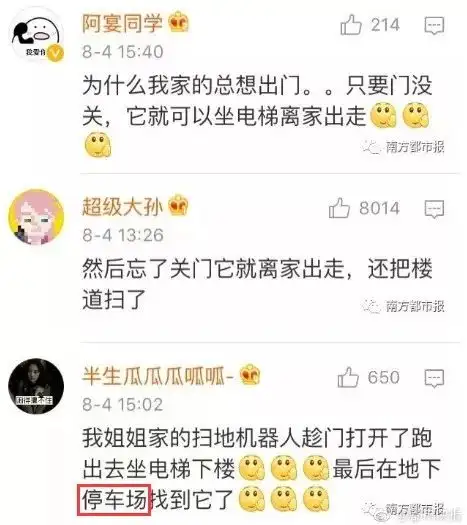

智障案例

【2023-2-8】知乎专题:你见过哪些“人工智障”?

| AI设备 | 品牌 | 智障特点 | 表现 | 备注 |

|---|---|---|---|---|

| 音箱 | Alex | 诡异 | 无缘无故发出怪笑声:“啊-哈-哈”的声音,听得人毛骨悚然 |  |

| 音箱 | 语义理解不足 | “我是说,明天早上六点半的时候,叫我起床。” “好的,明天早上六点半的时候,我将称呼你为‘起床’。” |

||

| 音箱 | 微软小娜 | 语义理解不足 | “小娜!设置三点钟闹铃“”好的!已设置3:00闹铃!“ 抱歉,我忘记小娜不知道什么是12小时制,我半夜三点被叫醒了! |

|

| 音箱 | 小米小爱 | 语义理解不足 | “小爱同学,播放loveshot” “好的,为你播放拉萨” “小爱同学,播放七月的风” “对不起,只能查询未来十五天天气情况” |

|

| 音箱 | 小米小爱 | 语义理解不足 | 放一首周杰伦的歌 小爱:无反应 放歌! 小爱:放谁的歌儿? |

|

| 音箱 | Google Assistant | 语义理解不足 | 理解不了,什么叫“不要” |  |

| 音箱 | 小米小爱 | 语义理解不足 | “小爱同学,播放loveshot” | |

| 个人助理 | 华为小艺 | 域外意图 | 频繁安全回复、道歉:很抱歉!小艺还在努力学习中,请您换个简单的问法吧 |  |

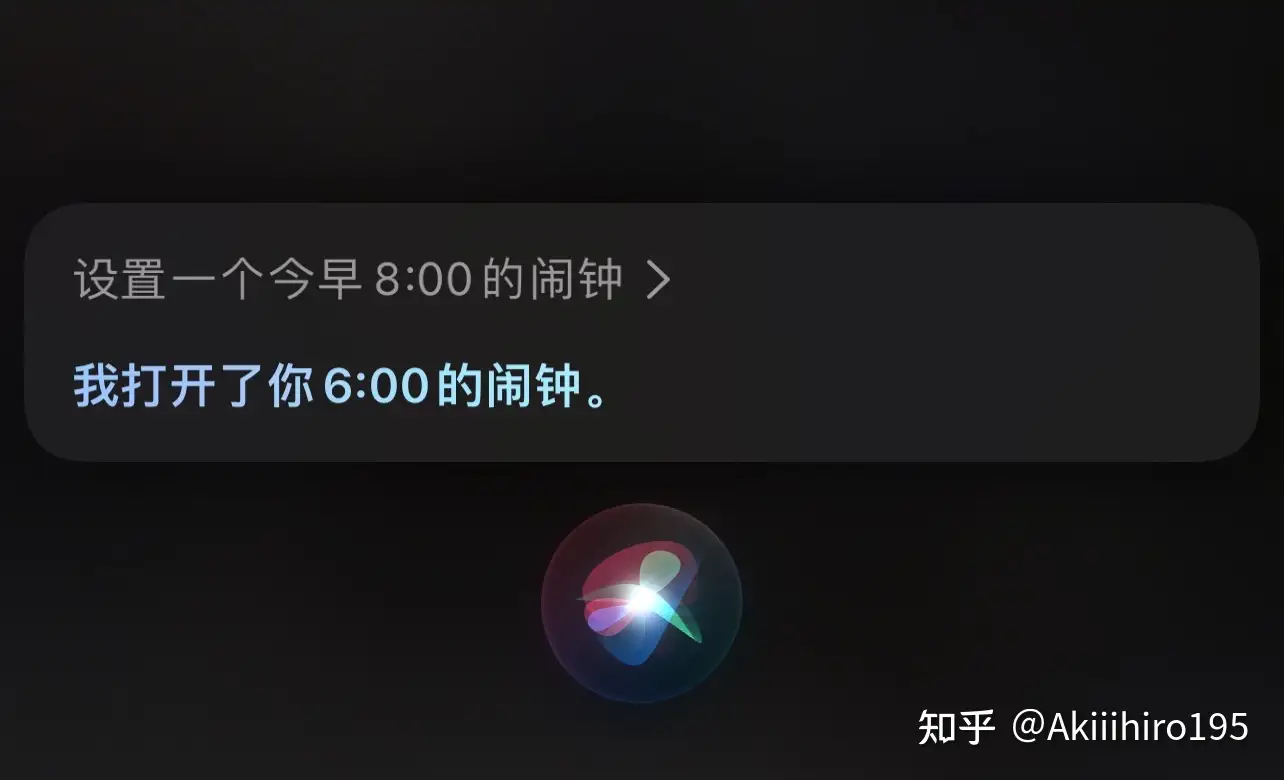

| 个人助理 | Apple Siri | 语义理解有误 | 用户:设置一个今早8点的闹钟 Siri:我打开了你6:00的闹钟 |

|

| 个人助理 | Apple Siri | 语义理解有误 | 用户:siri,给xx发微信,告诉她我晚点到。 Siri:好的,我将给xx发消息:告诉她我晚点到。 |

|

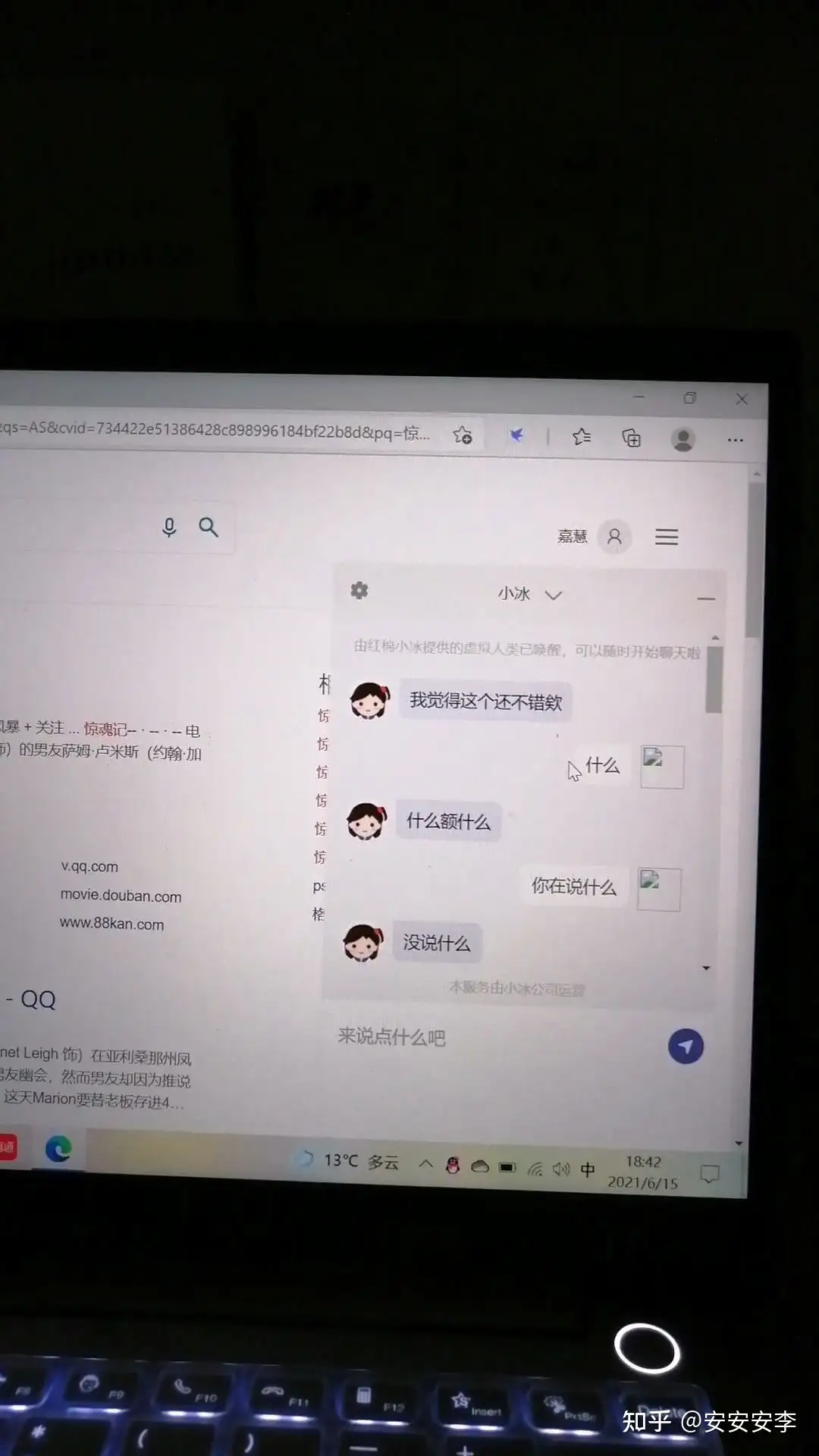

| 闲聊机器人 | 微软小冰 | 无法理解上文 | 什么? bot: 什么额什么 |

|

| 闲聊机器人 | 微软小冰 | 胡说八道 | 写的诗乱七八糟 |  |

| 智能客服 | 蛋卷 | 语义理解不足 | 客服机器人变复读机 |  |

| 银行大厅机器人 | 快宝 | 人工操作 | 雇佣人工在后台处理 | 视频地址 |

| 图像识别 | 华为P30 | 无法识别域外目标 | 将shit识别成food |  |

| 陪护机器人 | 情绪表达欠缺 | 翻白眼 |  |

|

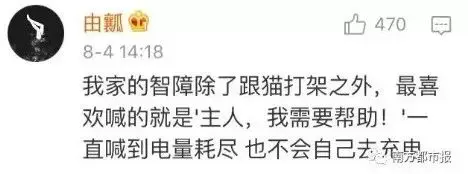

| 扫地机器人 | 不会充电 |  |

||

| 扫地机器人 | 离家出走 | 生是我的家用电器,死是我家的摆设,休想逃走! |  |

|

| 扫地机器人 | 脾气大 |  |

||

| 奶娃机器人 | 无法精确控制 | 机械臂伤人 | video | |

| 喂食机器人 | 机械控制障碍 | video | ||

| 家政机器人 | 无法感知物体 | 撞门 |  |

|

| 家政机器人 | 无法感知电线 | 自己拔电源 |  |

|

| 陪护机器人 | 行动能力欠缺 | 自己摔倒 | video | |

| 足球机器人 | 行动能力不足 | 无法站立 | video |

手机助手

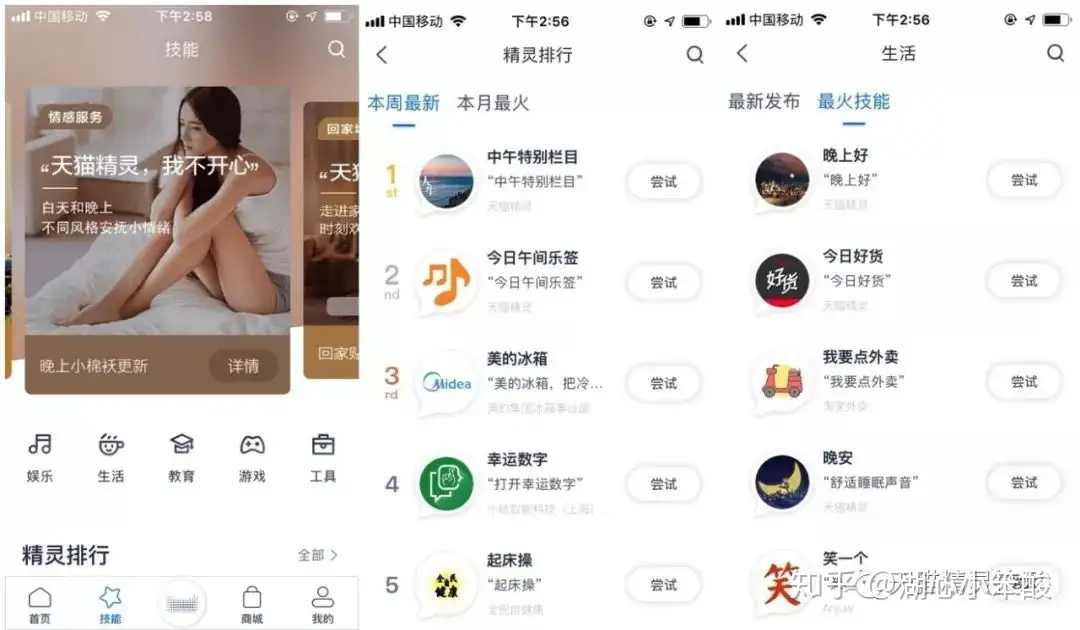

基本概念

在线对话引擎的基本概念与关系

Bot(机器人): Bot是一个功能合集,包含了很多技能,天猫精灵x1、M1、C1绑定的是同一个Bot,而天猫精灵儿童故事机存在功能范围的差异,绑定的是另一个Bot。Skill(技能): Skill是完整的功能单位,包含了对话理解与对话执行逻辑,独立承接一段对话逻辑。- 一个Bot可以包含多个技能, 例如: 天猫精灵X1的Bot中包含 天气、找手机、掷骰子等skill;

- 一个技能也可以被不同的Bot选用,例如: 天猫精灵X1中存在汇率skill用于查询当前汇率,儿童故事机中就没有。

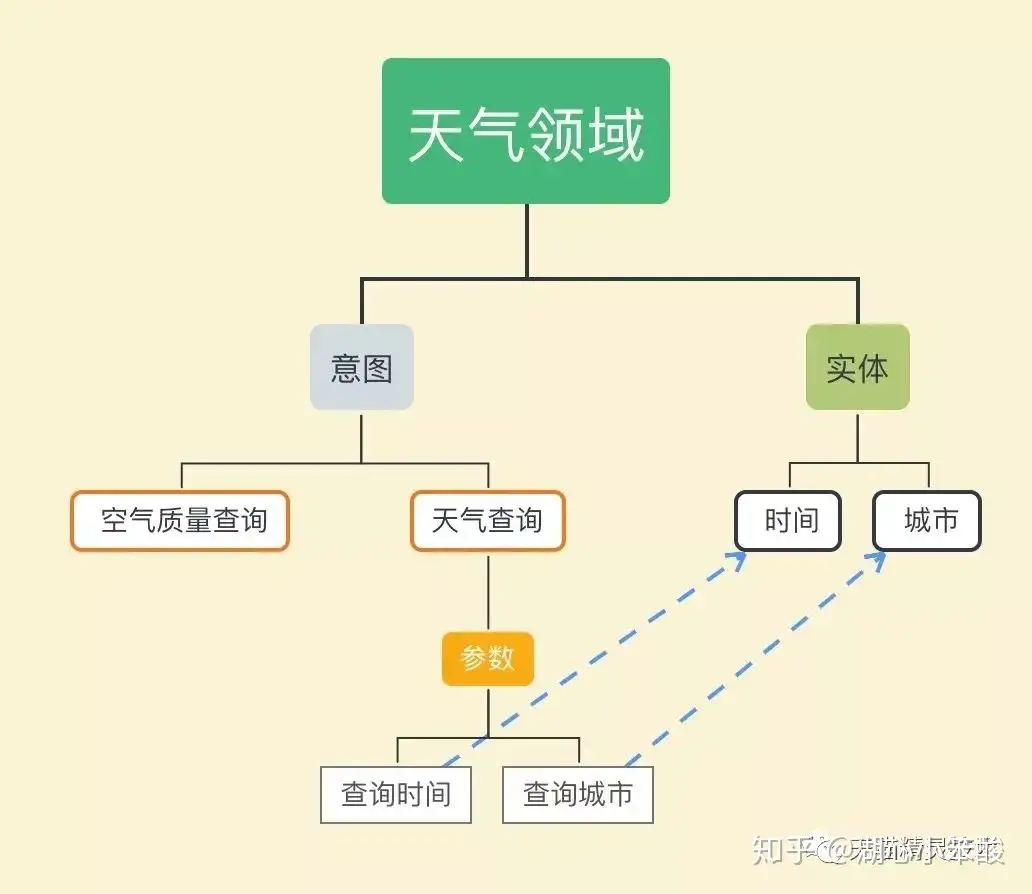

Domain(领域): Domain是一个内部概念,skill包含了对话理解与对话执行两部分。- Domain承载了对话理解NLU部分的数据信息,例如天气是一个领域。

Intent(意图) : 意图是Domain内部细分。天气Domain中,既有普通的天气查询Intent,也存在空气质查询的Intent。Entity(实体): 代表了一种对象类别,例如本体(如明星、电影)、常见的命名实体(时间、地点)以及一些短语集合都可以作为实体。天气领领域就有时间、城市两个实体。Slot(参数/槽位) : 参数是实体的实例化- “帮我订从杭州到北京的机票”,其中“杭州”与“北京”都对应city这个实体,而“杭州”对应参数出发城市startCity,“北京”对应参数endCity。对应到国资委中的天气领域,就有查询时间与查询城市。

对话引擎只包含三个部分:对话总控(DM)、语言理解(NLU)与技能执行(Skill Execute) 。先作简单介绍,下文会有扩展。

- 对话总控: 对话总控是整个对话引擎的控制中心,对话链路的必经之地,也是对话管理的中枢,具体负责对话管理、上下文管理、链路调度等功能。

- 语言理解: 语言理解(NLU)做的事情更为明确,将用户的自然语料输入转换为结构化数据。对话引擎当前采用DIS表示结构,D代表Domain, I代表Intent,S代表Slot,此处的slot对应上文中的IntentParameter。

- 技能执行: 在完成NLU理解之后,对话总控会根据NLU结果以及一定的规则命中相应的skill,并将Intent、Slot等信息以参数形式传递给技能。技能执行根据参数与上下文做技能决策,生成文本回复或者端上可执行指令返回。

天猫精灵内部最主要使用的模型算法方案是: DC + ICSF的两级模型。

- 第一层领域分类模型(DC,Domain Classification),DC模型做第一层的处理,将不同的自然语言输入分类到不同Domain;

- 第二层为领域模型(ICSF, Intent Classification + slot filling),这里采用的一个联合模型,同时完成了意图分类与实体抽取的功能。

对话管理其实分为两部分:

- 1、Bot级全局对话管理

- 2、skill内对话管理

| 对话管理 | 所处环节 | 类比 | session类型 |

|---|---|---|---|

| 全局对话管理 | 对话总控 | 操作系统任务管理 | 全局session |

| skill内对话管理 | 技能执行 | App内页面管理 | skill级session |

多轮对话是基于对话双方完成的,包括用户侧与Bot侧。

- 用户发出指示,到达Bot,Bot命中技能给出回复与本轮回复状态。

Bot侧技能常见的回复状态有两类:

ASK_INF:指追问,如上图天猫精灵首次回复“你想查询哪里的天气”,追问的是city信息。RESULT:指给出回复。如上图,当补充city信息后,回复查询结果,完成当前意图的请求。

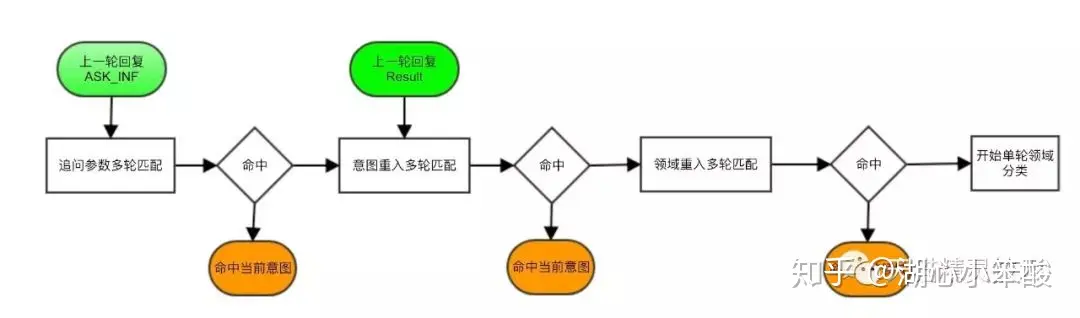

多轮匹配的内容,可简化为以下三类:

- 参数追问:命中用于补全参数的语料,得到意图与上一轮意图相同。例如“我想查询的是杭州”。只有上一轮为ASK_INF时,才会启用。

- 意图重载:命中用意图重入的语料,得到的意图与上一轮意图相同。例如“那上海呢”,在上一轮为空气质量查询时,重入该意图。

- 领域重载:命中重新回到该领域的语料,得到的领域与上一轮的领域相同,例如“有没有下雨?”,上一轮天气领域空气质量查询意图,重新回到该领域,命中是否下雨意图。

天猫精灵设计新功能、开发新技能的时候,往往会遇到这样的尴尬:

- 1、用户查找的东西,纯语音播报难以描述;

- 2、用户查询的东西有多个候选结果,文字量大,不宜语音播报;

- 3、缺少足够的提示引导方式,用户一直只做他摸索成功的几个操作,如果加太多提示引导,又显得音箱很啰嗦。

总而言之,适于交互的语音播报所能传达的信息量还是太少。有时候结合屏幕操作,才能带来更佳操作体验。

带屏语音交互分为两类:1、所说即可见,2、所见即可说。

- 所说即可见: 用户语音命令结果,可在屏幕上以视觉信息展示。

- 例如,用户查询天气,在天猫精灵魔盒的外接电视上可显示如下。

- 所见即可说: 用户可根据屏幕上的信息提示,做相关语音操作。

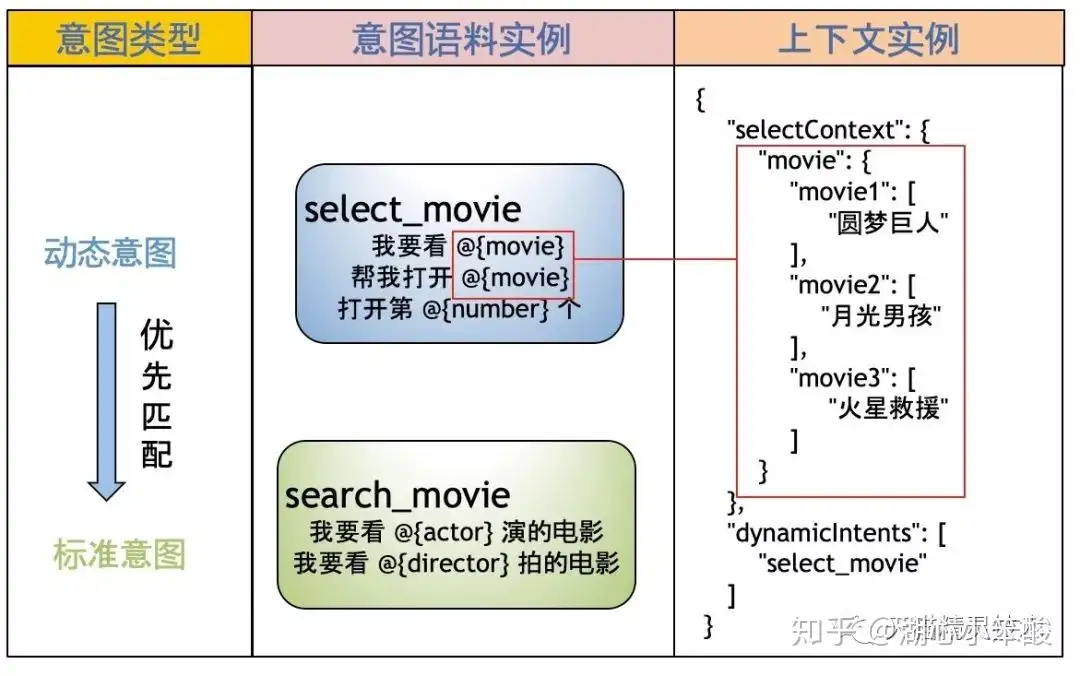

- 例如,在查询电影的时候,得到如下界面,用户就可以直接说“我选第一个”或者“我要看圆梦巨人”。

- 所见即可说的原理跟多轮对话类似都参照当前对话的上下文进行NLU的意图决策,只不过多轮对话的上下文主要是前几轮对话记录,而所见即可说的上下文为当前页面信息

由于带有视觉信息的页面的上下文信息太过复杂,我们做了抽象,传递到对话引擎时,请求会包含两项信息:

- 动态意图列表(dynamic Intents): 动态意图包含了跟当前页面相关的操作的语料。动态意图相较于无页面相关信息的标准意图更优先匹配。不同的页面可以指定不同的动态意图。

- 动态实体信息(slect context):动态实体用于请求时动态指定当前页面的相关词信息,如图中的电影名称。动态实体用于区分同个页面的不同内容。

除了开发者对技能自定义的需求,nlp的一些交互能力上的可复用性依然不足,为此扩展了一系列的公共意图。

- 复用nlu:

sys.yes/sys.nosys.yes代表确认,常见语有“好啊”,“可以”,“行呗”;sys.no代表否认,常见语有”不要了“,”算了“,”不行“。- 大量有多轮能力的技能都需要这样的两类语意表示,为了避免重复的语料配置工作,将其封装成为了公共意图。技能开发者还可以根据各自技能需求自定义扩展语料。

- 复用nlu与技能决策:

sys.nextsys.yes/sys.no做的只是nlu理解部分的复用,而sys.next与播控状态绑定协助完成了技能路由的决策。- 存在有不少内容播放类技能,如”新闻“、”笑话“、”音乐”,都存在”下一首“这种操作的,当用户说”下一首“时,系统会根据技能播控信息以及设备播放状态等信息,找到合适的技能,进行执行。

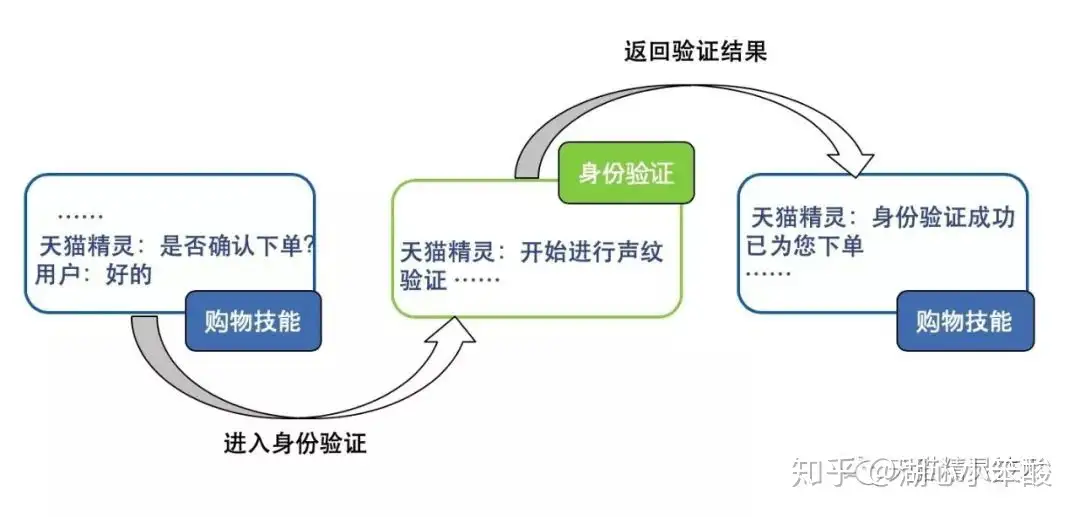

- 复用nlu与执行交互:

sys.action.verify- sys.action.verify 用于身份验证的公共意图。

- 类似于微博的登录组件,为各个不同技能提供了一套统一的登录方式,而其内部的验证逻辑对于接入的技能来说并不关心,更多关心的是验证结果。语音身份验证同样可以成为一种组件,目前今日好货、淘宝购物、手机充值等技能都已接入了该公共意图。

参考:深度解密天猫精灵对话引擎

案例

小米-小爱

【2023-9-13】NLP 技术在小米语音助手中的应用

语音对话技术的主要流程

NLU例子

意图槽位

智能音箱

- 【2021-11-28】模仿AI音箱声音,网红模仿siri、天猫精灵、小米小爱

发展历史

- 【2021-3-9】2021年了,对话系统凉透了吗?

- 2011年,世界闻名的人机大战主角——IBM的Wastson,在智力竞猜节目中战胜人类,向全世界宣告了计算机拥有了自然语言理解能力和人机对话能力。

- 2011年,乔布斯收购的Siri担起了苹果向AI领域进军的大旗,作为智能数字助理搭载在iPhone上。

- 2014年,微软在中国区发布会上发布了第一款个人智能助理Cortana(中文名小娜);

- 2014年,亚马逊推出自己的智能语音助理Alexa和智能音箱Echo,凭借新颖性和稳定性迅速占据了全球市场。

- 2016年,谷歌也完成了它的对话产品-谷歌Assistant。

- 2017年,中国本土的对话产品开始觉醒、登场。17年下半年,阿里的天猫精灵、小米的小爱同学正式推出

- 2018年,百度的小度智能音箱,以及华为AI音箱相继跟上,这些头部大厂率先抢占了市场和人心,而后第二梯队的思必驰、出门问问等产品又进一步参与了对话市场的瓜分。

- 2018年5月的时候,Google I/O发布了Duplex的录音Demo,场景是Google Assistant代替用户打电话去订餐厅,和店员沟通,帮助用户预定位子。值得注意,这并不是Live demo。

- 【2022-05-10】人工智障:你看到的AI与智能无关

- 2020年9月30日,百度将旗下智能生活事业群组业务小度科技拆分,完成独立融资。小度也被独立拆分

- 2021年1月,阿里AI Lab解散,天猫精灵凉凉,阿里AI Labs成为国内主要互联网公司里第一个被关闭的人工智能实验室。

- 阿里巴巴人工智能实验室成立于2016年,2017年7月5日首次公开亮相,巅峰的时候阿里AI Labs团队有上千人,旗下孵化出来的最重要的产品就是天猫精灵。

- 2020年9月,阿里AI Lab总经理陈丽娟(浅雪)转入大钉钉事业部;阿里巴巴AI Labs北京研发中心负责人、语音助手首席科学家聂再清,已经于10月加入清华大学任教。

- 聂再清之前曾经在微软亚洲研究院工作过13年,主要负责微软自然语言理解、实体挖掘的研发工作,是微软学术搜索、人立方,以及企业智能助理 EDI 的发起人和负责人。

知名音箱

【2023-2-8】音箱大全:img

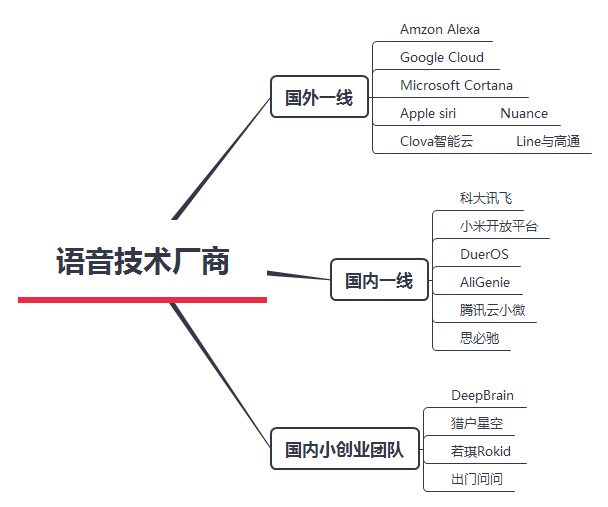

语音技术厂商 img

从数据层面,Google Home的表现不算差。

- 在16年Q4季度,在全球智能音箱市场抢下10%的份额。

- 这个份额也在不断扩大,到17年的4月底,Google Home占到全美语音类音箱份额的23.8%

从8:1 到 3:1,背后的竞争格局的变化是致命。商业上,如果市场参与者的份额小于最大竞争者的1/4,是不可能有效地发起竞争攻击。亚马逊如果想保持一家独大的态势,务必把Google Home的份额遏制在20%以下。而现在,显然不行了。

Amazon Echo

说起智能音箱,亚马逊Echo是当之无愧的霸主。

- 早在2011年,亚马逊就在秘密研发Echo。

-

到2016年底,亚马逊已经击败传统音箱巨头Sonos,取得在线音箱份额第一的霸主地位

- (1)Echo的外线防御:对弈模型的三大要素;智能音箱商战博弈模型

- (2)Echo内线帝国:2大场景、6项指令和19类技能应用

- 场景:厨房(51%)、客厅(33%)

- Experianand Creative Strategies 研究机构在2016年美国做过一次用户研究,涉及1300多名Echo用户,研究表明有50.9%的用户在厨房使用Echo,有33.5%的用户在客厅使用。厨房是Echo使用的最高频场景,大概是因为在厨房烹饪的时候,最需要通过语音来解放双手。

- 指令:播放音乐(34%)、控制家居(31%)、连接付费音乐(18%)、设闹钟(24%)、播新闻(17%)、添加购物清单(10%)

- Echo可以做到指令很多,比如播天气、查交通、问百科、定外卖,这些都没有进前六。音乐、家居和计时,是最核心高频的三类指令。

- 技能:一线阵营、二线阵营、边缘阵营

- 亚马逊在15年开放了技能平台,并在17年6月底达到了惊人的1.5万个。邹大湿:技能分析报告;技能类型:播报、指令、互动

- 一线阵营是音乐影视、游戏娱乐、生活和智能家居。这四类技能总数多,消费者关注高。

- 二线阵营是教育、趣玩搞笑、新闻和效率;总量大,但关注度一般。

- 边缘阵营有体育、财经等11类小众技能,体量小,关注度最弱。

- 场景:厨房(51%)、客厅(33%)

Google Home

16年11月,Google Home正式发售。打响了互联网巨头之间智能音箱之战。短短半年,Google Home已经成为Echo一个不可忽视的竞争对手。

Google Home的发展历程,可以划分为两大阶段,以2016年末为节点。

- 第一阶段为单点突破,Google Home攻破了Echo的外线防御,以差异化特性被人们接受;

- 第二阶段是攻城略地,针对Echo的场景技能展开了锋锐的进击。

智能音箱商战对弈的模型。从硬件、软件和商业购买三个角度

- 一级核心要素,分别是音质、技能(含服务)和价格。

- 二级要素: 识别、设计;听音乐、对答;促销、渠道。 而对于亚马逊和谷歌具体而言,Prime会员和Chromecast是两大极其重要的产品协同要素。

2016.5-2016.12:Google Home的外线破局

- 1、一个突破口:避实就虚,绕开海量技能,以智能对答为核心切入;优势彻底、用户感知、付费买单,Google Home 在问答这方面单点突破,成功碾碎了亚马逊的防线。

- 优势彻底:国外专业调研机构Stone Temple 对此做了专业研究,问了5000个常见的问题,谷歌回答了68.1%,是亚马逊 Alexa的3倍。

- 用户感知:谷歌回答的智能,不仅仅是数据上的碾压,而是在用户层面,切切实实可以感受到的。

- 愿意买单:智能回答这个功能点,用户是愿意付费买单的。这个见解在Google Home推出之前,其实就能预料和监测。

- 2、特色:设计优雅和价格亲民

- 一个是优雅的设计外观,配合有不同配色的底座。和纯黑圆柱状的Echo,形成了鲜明的对比。

- 还有一点就是价格,129美金的价格,的确是比Echo 179美金便宜,但却不是最便宜的。设计和价格,都只算是Google Home的特色,还不能算做优势。

现状

- 【2021-6-26】常超:为什么语音助手很难,现状:

- 从 Google、苹果、微软、亚马逊,到国内的 BAT、华为等巨头公司都有做语音助手的团队

- 大多用户眼中,Siri、小度、天猫精灵、小爱同学等语音助手仍然是“人工智障”

- 使用过语音助手的人很多(19年光智能音箱出货7200W台,城镇住房渗透率 20%),但用户活跃度低,使用过的功能也寥寥可数,主要是:听歌、查天气、订闹钟等

- 为什么这么多顶尖的公司,投入了顶尖的资源、顶尖的人才都没做出一款 C 端用户满意的语音助手?为什么在很多用户眼中都是”人工智障“?

- 用户预期与实际助手能力的 gap 过大

- 语音助手的难点又是什么?

- 问题 1:如何让用户知道语音助手能干什么?

- 语音助手背后的技能、内容其实都已小具规模( 在19年,Alexa 集市就已经有了8万多个技能),但很多用户也就只会使用听歌、查天气、订闹钟这么几个技能(有屏音箱里充满了各种引导、推荐,就是试图在解决这个问题),大多用户们不了解语音助手能干什么,本质还是语音助手没有找到一个刚需场景并打透(没有找到刚需场景,或者说没有在一个刚需场景中创造显著的体验差)

- 问题 2:如何让语音助手连接更多的服务、内容?

- 深度方面,单一场景要打通的链路很长,体验闭环难。

- 案例 1:以家庭智能音箱的听歌场景为例,受限于音箱背后的音乐版权,而音箱没有,这会很大的影响体验。比如小爱同学,因为它连接的歌曲资源是QQ音乐,而我就没办法听自己在网易云收藏的歌单了。

- 案例 2:在家庭照明场景,想通过语音助手随意的控制家庭灯光,需要连接整个家庭灯光照明设备,这甚至得打通装修环境,在装修时就考虑。

- 广度方面,用户在跟语音助手交互时,会有非常多的碎片化小需求。

- 案例:在滴滴的司机语音助手中,除了大家可以想到的导航场景,司机还会有各种各样的长尾问题,例如:“网约车考试的题目在哪里?”、“飞机场那边的排队区在哪里”、“帮我查一下我的预约单”等等,这些都是司机自发的问语音助手的碎片化小需求。

- 深度方面,单一场景要打通的链路很长,体验闭环难。

- 问题 3:如何管理用户预期?导致用户预期过高也有两方面的原因:

- 一方面是使用语言交流时,某种程度上人们会不自觉把“语音助手”与真实的人比较,尝试用人脑的思考习惯去理解“语音助手”,这必然会导致很多时候用户会觉得人机对话的结果不符合预期,因为目前的AI的原理和真正的人脑原理差的还很远(根本原因是科学对人脑的了解也还很初级…),再加一些科幻电影,还有媒体对人工智能概念的鼓吹…

- 另一个方面是语音无法设定交互边界,设计GUI交互时,我们可以定义出清晰的交互路径和边界(eg:首页只提供一个按钮),但是语音交互你无法限制用户说什么,就像人与人的对话中,你永远无法避免别人问到你不会的问题。

- 问题 1:如何让用户知道语音助手能干什么?

- 可能的解决路径

- 第一步:找到刚需场景,打造出显著的体验差

- 第二步:规模化复制,带动服务者生态的建立

- 第三步:打造每个属于用户自己的语音助手

评测

- 【2019-12-9】中科院物联网研究发展中心:智能音箱的智能技术解析及其成熟度测评

- 音箱产品

- 无屏音箱:天猫精灵X1、小米AI音箱、腾讯智能听听9420智能音箱TS-T1、小度智能音箱Play。

- 有屏音箱:小米小爱触屏音箱、小度在家1S、天猫精灵CC、腾讯叮当。

- 无屏音箱:天猫精灵X1、小米AI音箱、腾讯智能听听9420智能音箱TS-T1、小度智能音箱Play。

- 结论:以ASR识别率为主要指标的“听清”环节,不论是无屏音箱,还是有屏音箱,四家主要厂商没有明显差距。有屏音箱的ASR识别率整体优于无屏音箱。

- 从无屏音箱维度看,四家主要厂商ASR识别率均达到94%以上,小度音箱识别率98%、天猫精灵为97%、小米小爱为96%、腾讯音箱为94%。

- 从有屏音箱维度看,四家主要厂商ASR识别率均达到96%以上,腾讯叮当、小度在家1S分别以98.6%、98.5%微微领先其他厂商。天猫CC ASR识别率为96.90%,小米有屏ASR识别率则为97.70%。

- 以召回率为主要指标的“听懂”环节,小度系列智能音箱是唯一召回率超过90%的产品,天猫精灵、小米小爱的召回率也达到70%以上。

商业模式

- 2021年了,对话系统凉透了吗?

- C端对话产品成本巨大但盈利空间不明朗,市场竞争激烈

- 在线广告?电商推荐?会员付费?硬件输出?似乎传统的商业模式不易落地

- 长期高额的技术投入却得不到真金白银的反馈,怎么办呢?于是企业将目光投向了B端市场。

- 电信运营商、银行、政务司法、能源电力等各大传统行业都需要部署大量的人工客服,客服就是一个天然的对话场景,如果用对话技术替代掉人工坐席,不仅降低人力成本而且提升服务效率,况且传统企业面临技术更新转型,纷纷想踏上AI这趟快车,所以智能客服的前景一片春天呐。

- 工业界对话系统的核心目的:通过人机对话接口让机器为用户提供服务。

- 这里的服务可以是

- (1)问答型:解答用户一个疑问,基于FAQ、文档、表格、KG等,表面上看是垂类搜索的top1匹配,实际难点重重

- 看起来是刚需,但百度做了20年,知乎做了10年,不就是这个需求吗?

- 问答是什么?就是精准满足用户query,那就可以理解成百度搜索的TOP1搜索结果,或者知乎上的回答最高赞。即做一个 缩小版、精准版、垂直版的搜索引擎 。这就可以理解为什么出道最晚的小度,反而会比天猫精灵和小爱音箱“更聪明”了?

- 垂直行业、细节化的用户query恰恰是对话产品问答需求中的高频问题,而通用搜索对TOP1的准确率要求非常高,面对这种冷门、细节化的query,模型回答不了,可对话产品中几乎注定了是一问一答,如果没有高精准的找到那个TOP1的回答,那只能跟用户说“对不起,我好像不明白”。然后用户就“玛德智障!给我转人工!”

- 学术界对问答对匹配问题研究的挺彻底,但SOTA模型放在业务数据中翻车屡见不鲜,脱离了业务的模型不算好模型。问答对的质量决定了模型效果的上限,更何况随着数据的增加,问题之间的边界模糊和交叉现象会进一步增加匹配的难度。

- 改进:在搜索范式之外,增加针对问答场景设计的辅助模块,来缓解无法精准回答的尴尬局面,如在召回、精排和后处理阶段增加复杂的处理逻辑。但是既要做到垂直而精准,还要试图通用化,用一套模型/系统实现跨场景跨行业的大规模落地变现,现有技术范式几乎不可能。

- 学术界的问答系统的研究重点普遍聚焦在开放域问答和阅读理解问题上,所谓迁移学习、domain adaption、预训练、小样本学习等技术,还不足以经受的住现实的考验,撑不起一个通用和垂直兼备的问答引擎,依然免不了要一个行业一个行业的做,一份数据一份数据的标。用一个模型去精准的覆盖多个场景和行业是非常不现实

- 技术硬伤是打开百亿规模市场的最大障碍。更不必说,这类需求中还存在query描述冗长/超短、FAQ库不完备、甚至ASR解析噪声等问题。

- (2)任务型:帮用户办理一件事

- 问答本质上是一个文本相关性问题,抽象为搜索、匹配问题,而任务型要做query结构化,即意图识别、实体槽位填充,将文本转成系统查询API。

- ①意图识别:智能音箱这种C端对话产品因为是面向所有用户,开放域,难以预料。高频问题可以逐个处理,而长尾问题,就不好办了。不仅难以采集到充分的数据进行标注,甚至难以穷举并定义这些意图,甚至权重还不同,还有论文没提到的,如何在开放域下识别一句话“没有意图”(比如一只猫爬过用户键盘并按下了ENTER)

- ②槽位填充:学术界已经研究烂的技术,而工业界还没做好,为什么?实际业务中的实体不只是机构名/人名/地名这么简单和理想,而是些和业务紧密联系的专有名词,往往是某一家公司所独有的词汇。如“30元每月30G”,没有标注数据,槽位值还会不断变化。所以,还是规则为主,模型为辅

- ③对话管理:工业界的对话管理的第一要义是绝对可控性,所以技术选型上都是pipeline系统,而非端到端系统(尽管学术界2015年就有端到端任务式)。工业界主流做法是有限状态机,优点是可控,缺点是人为提前设置,受限。即使对话流程配置的很精细,也无法应对可能的突发和未知状况。如对话偏离设计时如果回到主流程?一个意图还未结束就开始另一个意图

- 问答本质上是一个文本相关性问题,抽象为搜索、匹配问题,而任务型要做query结构化,即意图识别、实体槽位填充,将文本转成系统查询API。

- (3)闲聊型:单纯的聊天(情感服务) —— 微软小冰的结局是对闲聊需求的证伪,抖音、游戏、陌陌足够

- 闲聊的商业化之所以失败,是因为闲聊技术不够成熟?只要预训练模型足够大,等打败了Google的Meena,Facebook的Blender,微软的DialoGPT,百度的PLATO,我就能像人一样逼真幽默,会聊天了

- 满足情感和娱乐化需求,创造大规模商业价值,那你的对手将会是整个文娱产业。游戏、短视频、网剧、音乐,甚至陌生人社交APP,一个终于做到像人的产品能干掉哪个呢?

- (1)问答型:解答用户一个疑问,基于FAQ、文档、表格、KG等,表面上看是垂类搜索的top1匹配,实际难点重重

- 很多产品都在吹“我们的产品用了A学习,B技术,能做到C效果”,可是,它真的给产品的用户体验带来提升了吗?提升了多少呢?对话的痛点问题又解决了多少

- B端业务订单难啃,难以大规模变现,学术界对话研究热点又似乎跟工业界痛点不合节拍,外界一片看衰。

- 【2021-3-25】对话的囧境:对话的变现能力主要看能不能产品化。

- 产品化是指把能力打包成解决方案,首先要有需求,其次要有量,把一份东西卖给多个人,边际成本递减。

-

ToB不好做

。国内16年开始涌现大批做NLP智能客服的公司,但到现在没有几个能出头的,我认为主要原因就是因为技术发展的限制,无法把FAQ技术产品化,导致换一个客户(换一个封闭域)之后都要从新训模型适配,而模型肯定是不够的,还要针对性的解各种case,这样人力成本就上去了,报价高的话只有大企业买得起,而CEO不一定有大企业的人脉,报价低只能自己倒贴钱吃融资,陷入负循环。

-

ToC似乎是更好的选择

,现在看来的确也是。ToC起码可以做到一份东西卖多份,但切对需求这个点同样重要。

- 国内最早最有名的莫过于小冰,但我个人感觉纯闲聊还是个伪需求,闲聊主要是情感上的交互,除了生理需要外,情感表达是需要信任和反馈的,如果明知道对方是机器,大部分成年人都不会进行深层交流,同时技术也不允许。

- 目前比较成功的语音助理,一方面可以给用户提供信息,比如天气预报、时间,另一方面替用户完成任务,比如打电话、定闹钟、开关灯。国外做得好的有手机助手Google Assitant、Siri,以及亚马逊的智能音箱Echo。国内则有手机微软小娜、小米小爱、百度小度、天猫精灵。手机上的智能助理我有些存疑,但智能音箱我已经把自己说服了。由于巨头前两年的补贴大战,音箱的普及一直在增长,而从使用感受来看,一旦习惯了“命令别人”,就真的很难改掉。比如我现在每天都需要某精灵给我放歌、定闹钟、预报天气,甚至还买了智能插座懒得自己关灯。另外随着国家政策支持(重点发展智慧家庭产品),一些新楼盘的精装交付都会带有智能家居,再加上自动驾驶的发展,大家会越来越习惯AI助理的存在。

-

ToB不好做

- 从大趋势来看,我们已经走过了PC时代、互联网时代、移动互联网时代,接下来自然而然地便是IoT,基础设施的发展会产生更多的软件应用,对话作为人机交互的接口也会有用武之地。

- 产品化是指把能力打包成解决方案,首先要有需求,其次要有量,把一份东西卖给多个人,边际成本递减。

智能客服

详见站内专题:智能客服

智能外呼

- 【2022-06-10】单日流调1500人次 AI“流调员”上岗: 博兴街道为有效加强社区疫情防控工作力量,联合中国电信北京亦庄分公司推出的智能外呼疫情防控解决方案;

- 工作人员打开呼叫中心管理后台,创建任务,导入需要核查信息的居民名单以及“是否去过中高风险区、身体状况是否良好”等配置好的流程话术后,“新员工”AI外呼助手便开始工作了。流调回访、核酸检测通知、疫苗接种通知、购药回访……

- 拨通电话后,AI外呼助手 一 边精准流畅地询问、应答,一边将语音通话内容转化为文字,并将回访结果统一汇总至电子表格,方便工作人员进一步核查处置。对于未接通电话,AI外呼助手会在间隔时间后重新外呼,提升接通率。

- “请问您近期是否到访过XX风险点位”

- “请问您的居住地是否在经开区”

- “您是否存在咳嗽及发热等症状”

- “您最近的一次核酸检测日期是什么时候”……

- 自5月20日使用智能外呼以来,博兴街道共完成了对1785名居民的语音通知,应答率 79.8%。“ 正常时期每天排查50人次,有突发疫情时每日可排查500人次,高峰时期24小时随时待命,每日可排查经开区周边1500人次,基本实现了代替工作人员手动呼叫。节省了人力,跑出了防疫外呼‘加速度’。”博兴街道相关工作人员说,“智能外呼服务基于AI智能语音技术协助社区防疫工作者宣教通知、提醒、回访,解决了我们的外呼难题。”

- 据了解,当前智能外呼系统已全面应用于博兴街道,荣华街道也正在调试过程中。除适用于疫情流调回访、核酸检测通知、疫苗接种通知、购药回访等场景,该系统还可以将流调名单按照街道实际需求批量导入,实现一次导入自动流调,一键外呼批量拨打。科技助力属地疫情防控工作,极大提高了街道回访效率。

- 居民在收到AI外呼助手电话时,首先会收到一条标有“【北京社区(村)防控】您好!社区(村)防控工作人员向您致电,请您放心接听,您近期的行程可能存在涉疫风险,非常感谢您的配合”内容的短信提醒,稍后便会接到“(010)57410515”来电。请及时接听。

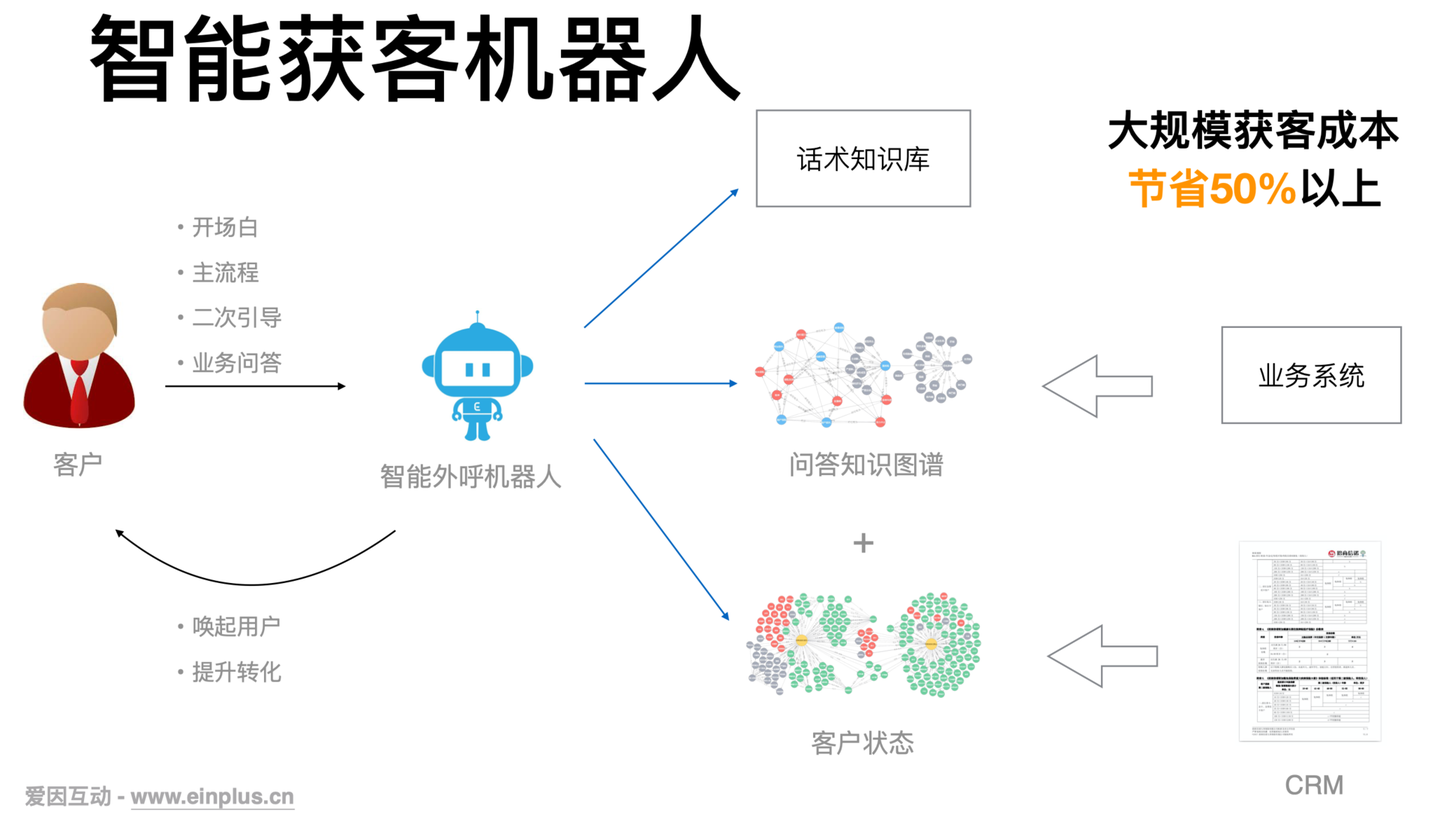

- 【2021-5-17】智能外呼机器人,知乎, 行业现状,智能获客机器人

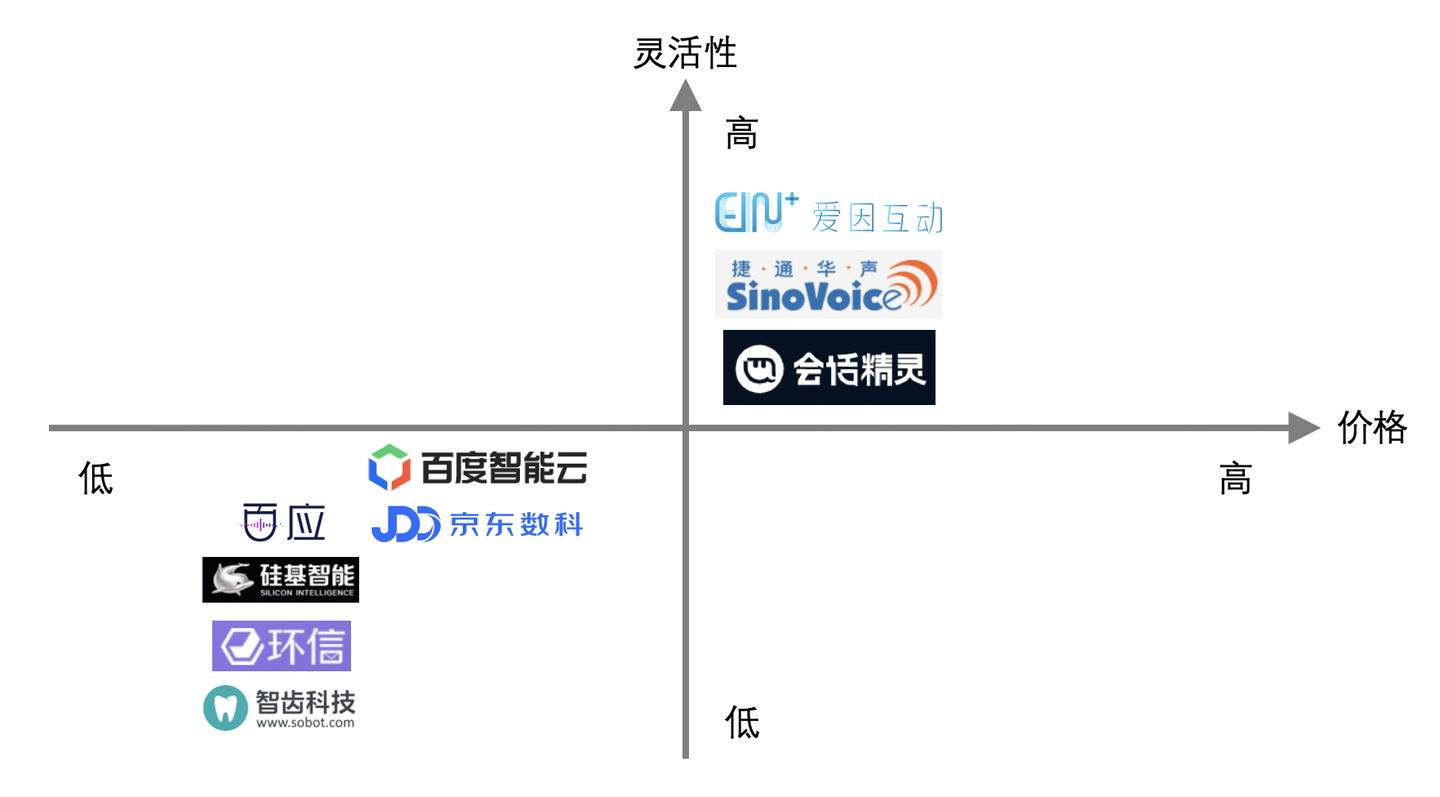

做智能外呼机器人的企业现在已经挺多了,比如各个答案中提到的各家的产品。它的市场认可度也比较高,大家都知道它能用于通知、回访、问卷调查、营销等业务场景。外呼机器人的价值很好衡量,用了外呼机器人后,能给企业赚多少钱,或者能给企业省多少钱,简单地算算收益和成本差异就知道值不值得用了。

总的来说,构建智能外呼机器人的所有产品都是在成本和效果两个坐标上找平衡点。在现有技术水平下,机器人如果功能简单是可以通过机器人平台自主构建的,但如果要求机器人更加智能(比如精准理解用户说的话并提供对应答复),就需要做深度定制。

有些产品走的是低价和平台策略,比如百应、硅基、环信、智齿、百度智能云、京东数科,你只要交点钱就可以用他们的平台自己去配置外呼机器人,平台是不怎么负责帮你优化外呼机器人效果的。这样配置出来的机器人,基本只能做简单的通知,不允许用户与机器人有复杂的自主交互。这种产品适用于构建通知类外呼机器人,比如现在很多快递公司都使用机器人打电话通知取快递。

还有另一类外呼产品主打的是机器人的效果,也即平台提供深度定制服务以构建更加智能的外呼机器人。这类产品有:爱因互动、捷通华声、思必驰。这类产品适合业务场景比较复杂,或者(潜在)客户价值较高时的情况。定制开发的机器人能更精准地理解用户说的话,比如对营销产品的意向度、情感倾向,用户画像如性别、年龄、教育程度等。

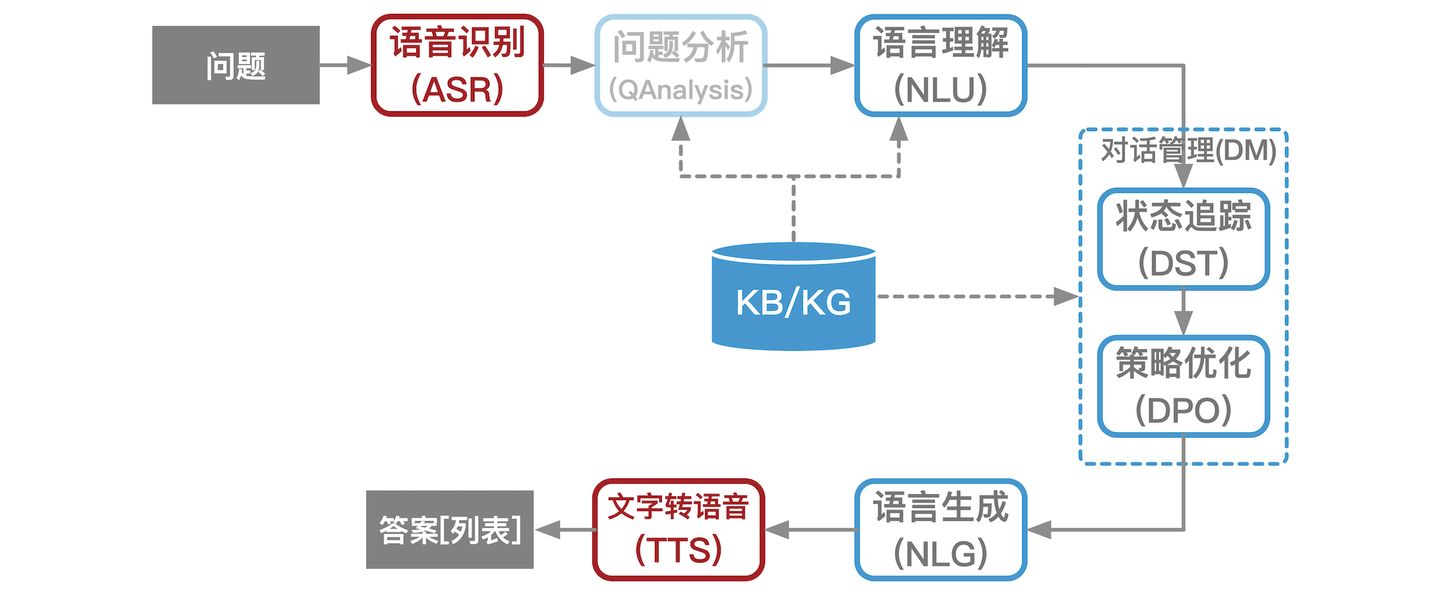

说说爱因互动做外呼机器人的原因和优势。从算法技术框架上看,智能外呼机器人和文本对话机器人(聊天机器人)差异不大,只是在文本处理逻辑的基础上增加了语音转换的流程:语音转文字(ASR)和文字转语音(TTS),即下图中的红色部分。

相比于大家对文本机器人不切实际的期待(“我们没历史数据,机器人不是会自主学习吗干嘛还要数据训练”,“这两句话虽然没有一个词相同,但它们明明是一个意思机器人怎么识别不了”,“为什么机器人不能跟我闲聊”),外呼机器人的使用场景通常简单单一,且价值容易衡量。这使得外呼机器人中要求的文本处理技术更加简单,在较低成本的定制化后机器人就能达到很高的准确率。作为从文本机器人起家的爱因互动,我们实施过数百个业务定制的复杂文本对话机器人,从中积累了大量快速精准定制的工具和方法论。这些积累都可以直接移植到外呼机器人的研发上。

爱因互动也把文本处理中最新的BERT技术推广到语音处理领域,我们利用自己的数据训练了外呼场景的大规模语音处理模型 audio-BERT。基于audio-BERT技术我们开发了基于语音信号的情绪识别、性别检测、年龄检测等模型。基于我们的语音处理模型和我们在文本处理的积累,我们不仅能精准识别用户意图,在对话中提供灵活打断和答疑等能力,还能为对话打上用户画像的多种标签。

爱因互动的外呼机器人主要包括三大类:

爱因互动也为诸多行业提供了详细的解决方案。比如对于教育行业,我们提供了智能获客的全场景覆盖。

评论

外呼机器人的核心要素:外呼线路,机器人质量,话术制作和外呼名单。

- 外呼线路:目前市面上只有三种线路:中继线(95打头或者固定座机号码显示)、卡线路(置办手机卡插网关,纯本地手机号显)和小号平台(不同归属地的手机+座机显示)。其中中继线的相对接通率最低,卡线路接通率最高,但易封号,且成本相对高。相比较于前两类线路,小号平台 价格适中,接通相对较好,若做本地手机卡报备,也可固定本地手机号显。

- 机器人质量:

- 看其公司工商信息是否有asr tts nlp 等核心技术的软著和行业专利证书,这点可以看出其自研能力和创新性

- 进入机器人后台操作看是否便捷,功能的细节做的如何,有无其他延伸功能,比如在线转人工,手机端推送意向客户,客户管理,人员管理,线路管理,话术管理等,要能满足自身使用需求。有持续迭更功能的系统为佳

- 之后外呼实测一下,看是否可以支持灵活打断,是否可以去非人声干扰。

- 话术制作:

- 是否支持节点的灵活跳转,多轮对话,变量设置,话术内容持续修改,话术学习,字段设置,热词管理等一些重要功能

- 有无足够优质的录音室可供选择和灵活录音,机器人的声音和说的话都是录音室赋予的,所以最终的效果和录音师有很大的关系。

- 外呼名单:名单不精准,用真人外呼也很难出意向客户,所以作为使用方要利用一些方法或者一些渠道获取相对优质的名单。所以只要顺着这个思路去找价廉质优的产品即可,不一定要最好的,要找适合自己的。

最后我补充两点:

- 语音机器人本质是SAAS软件,服务也很重要,建议咱们甲方老板们要找规模相对大,团队稳定特别是有优质的售后团队的公司合作,不要被廉价蒙蔽了双眼。另外再好的公司里也有不称职的员工,找个靠谱的对接人也很重要哦。

- 机器人是工具,工具谁来使用,如何使用也会影响到最终的产出。打出的客户一定要及时跟进,并提炼总结出适合自己的一套跟进思路和方法,不断优化。

【2022-7-21】随着科技的发展,越来越多的企业开始使用智能电销机器人。那么在智能电销机器人工作时,遇到没有人接听的电话,机器人会如何处理呢?

- 现在的智能电销机器人,遇到无人接听的电话,可以根据人为设置的次数,进行重复呼叫。比如,一天同一个号码可以呼叫三次,那么这个号码在第一次没有打通的时候,在24小时内,还会进行两次呼叫。

- 除此之外,智能电销机器人还有很多其他好处,单个电销机器人每天可以拨打1000个电话左右,线路稳定,稳定的拨打量,意向客户自然也会更多,而电销机器人的成本平均下来不到人工的1/10。

- 其次智能电销机器人无间断工作,365天无休息时间,一直保持热情态度。

- 智能电销机器人目前对接了科大讯飞的语音识别器,可以精准识别客户内容,真人语音交互,专业业务解答主动引导销售过程,客户提问、多种语言对答如流,支持客户打断。

- 最后,智能电销机器人还会根据客户的意向将客户自动分为A/B/C/D类客户,再将意向客户主动推送到你的微信上,由业务人员精准跟进。

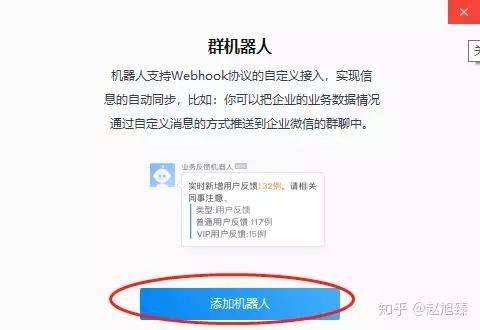

群聊机器人

群聊功能

核心功能如下:

- 消息即时接收:所有群即时接收消息,支持文字、图片、链接等形式的内容;

- 自动回复

- 任何群员的 @消息,变成群里面的24小时客服,实时在线。

- 关键词回复:群成员一定会有很多问题,但是大部分问题都能归纳总结,我们可以设置相关关键字,用户问题触发关键词,小助手自动回复用户。

- 智能托管:高级形式

- 群新人欢迎功能,新成员加入时,机器人就会马上@那个人,给对方发送一些欢迎信息。

- 群公告:不定期发布消息公告

- 群管理:

- 支持成员签到,投票,查人品等众多娱乐游戏。

- 工单自动生成

群聊产品

群聊机器人功能

如何来高效的管理自己的群组

- (1)个性化管家:自定义小助手昵称、头像,加强品牌效应打造有温度机器;

- (2)入群欢迎语:自定义发送间隔时间,短时间内大量人员入群不刷屏;客户进群后,第一时间发出欢迎通告,让群成员感觉贴切,同时还可以吧群规定等第一时间告知客户,让群成员知道本群可以做什么,不可以做什么

- (3)消息即时接收:所有群即时接收消息,支持文字、图片、链接等形式的内容;

- (4)关键词回复:群成员一定会有很多问题,但是大部分问题都能归纳总结,我们可以设置相关关键字,用户问题触发关键词,小助手自动回复用户。这不仅解放我们的双手,也第一时间回答客户。

- (4)群数据统计:数据实时查看、导出,群成员关系链一目了然让运营者更懂社群;

- (5)无限换群:支持免费无限换群,符合社群的生长周期,让单群性价比更高;

- (6)素材管理:支持自建素材库,文字、链接、图片等,随用随取,消息发送方便;

业界案例

- 智能王二狗,群娱乐机器人

- 群娱乐:二狗的群游戏、点歌、讲笑话等功能,打造欢乐群氛围,增加成员之间互动,不冷场

- 群管理:入群欢迎、定时推送、自定义回复等功能。重复的事情交给二狗,打造智能社群,全天周到服务。

- 智能查询:智慧查询功能,不管天气、星座、快递都是一句话的事。二狗是您群里的贴心小助手。

- 群娱乐:二狗的群游戏、点歌、讲笑话等功能,打造欢乐群氛围,增加成员之间互动,不冷场

- 第一款:小U管家

- 这款微信群聊天机器人是很受欢迎的一款软件,它能够帮助广大群主智能管理微信群,让群主的工作更加便捷、高效。在微信群中引入小U管家,开通社群空间,即可实现群聊内容沉淀、课程资料发送,及10多款娱乐游戏,极大地提升了微信群管理的效率和活跃度,是社群运营的超级利器。

- 第二款:微友助手

- 微友助手是专业的微信群机器人管理专家。拥有群数据分析,新加好友自动应答,自动拉人入群,自动加群用户为好友,入群欢迎语,机器人聊天,消息定时群发,机器人自动回复,群签到,微信群文件、群成员管理等数十项强大功能!帮您持续吸粉提升微信群活跃度及运营效率,为您创造价值。

- 第三款:微群管家

- 微信群管机器人将您的微信号,变成24小时在线客服机器人功能是微信机器人,群内欢迎新人,自定义回复,自动踢人,群邀请统计,定时群发等。还有上百种应用活跃群:签到,抽签,求财神,查人品,投票,群结婚,天气预报,群拍卖,点歌,股票查询,周公解梦,成语接龙,历史上的今天,一站到底,猜图游戏,猜谜,考驾照,星座配对,看美女等等。

聊天机器人 API

目前网络上有许多非常好的智能聊天机器人,这里找了6个目前使用很广泛的:

- 海知智能 功能很强大,不仅仅用于聊天。需申请 key,免费

- 思知对话机器人 注册很简单,调用也很简单,而且完全免费

- 图灵机器人 需要注册账号,可以申请 5 个机器人,未认证账户每个机器人只能回 3 条/天,认证账户每个机器人能用 100 条/天

- 青云客智能机器人 无须申请,无数量限制,但有点智障,分手神器,慎用

- 腾讯闲聊 需要注册和申请,还需要加密处理

- 天行机器人 白嫖用户绑定微信后有 10000 次永久额度,之后 1 元 10000 次

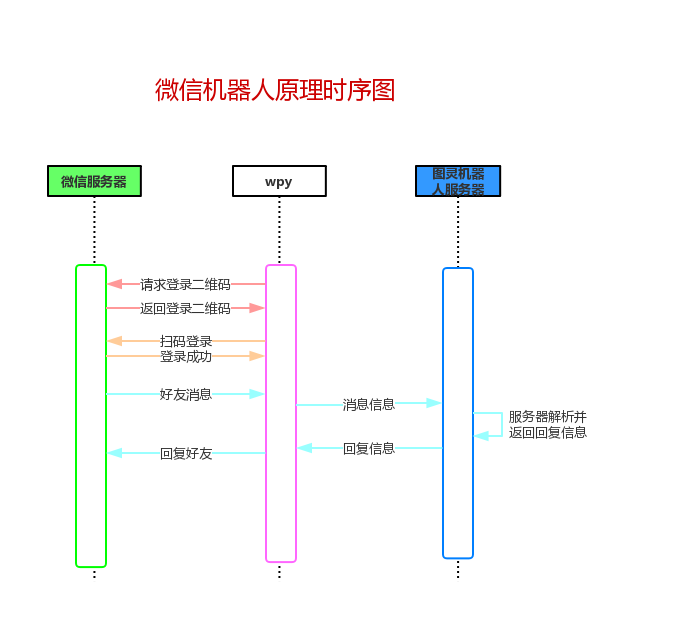

微信

微信机器人开源库调研,GitHub 找到以下 3 个开源作品:

- itchat

- itchat 是一个开源的微信个人号接口,使用

python调用微信,使用不到 30 行的代码,你就可以完成一个能够处理所有信息的微信机器人

- itchat 是一个开源的微信个人号接口,使用

- wechaty

- wechaty 是适用于微信个人号的 Bot SDK ,可以使用 6 行

js创建一个机器人,具有包括 linux,Windows,MacOS 和 Docker 在内的跨平台支持,基于 Node.js

- wechaty 是适用于微信个人号的 Bot SDK ,可以使用 6 行

- vbot

- vbot 是基于微信 web 版的接口,使用 http 协议 以及轮询方式实现, 亮点在于通过匿名函数,能够实现多种有趣的玩法,通过 API,更方便的打造属于自己的网页版微信,基于

PHP

- vbot 是基于微信 web 版的接口,使用 http 协议 以及轮询方式实现, 亮点在于通过匿名函数,能够实现多种有趣的玩法,通过 API,更方便的打造属于自己的网页版微信,基于

python关于开发微信的库主要有 itchat 和 wxpy

- 而wxpy底层是调用的itchat,所以如果你只是要使用的话建议使用wxpy库,它比其他的库都要优雅,更面向对象,而且深度整合了图灵机器人和小i机器人;

- 而itchat扩展性更好,如果你想自己开发一个自己的微信库那建议选itchat。

- wxpy和itchat都是模拟网页版微信来操作的

wxpy: 用 Python 玩微信 模块特色

- 全面对象化接口,调用更优雅

- 默认多线程响应消息,回复更快

- 包含 聊天机器人、共同好友 等 实用组件

- 只需两行代码,在其他项目中用微信接收警告,愉快的探索和调试,无需涂涂改改

- 可混合使用 itchat 的原接口

当然,还覆盖了各类常见基本功能:

- 发送文本、图片、视频、文件

- 通过关键词或用户属性搜索 好友、群聊、群成员等

- 获取好友/群成员的昵称、备注、性别、地区等信息

- 加好友,建群,邀请入群,移出群

代码:

# 安装

# pip install -U wxpy

from wxpy import *

# 初始化机器人,扫码登陆

bot = Bot()

# 搜索名称含有 "游否" 的男性深圳好友

my_friend = bot.friends().search('游否', sex=MALE, city="深圳")[0]

# 发送文本给好友

my_friend.send('Hello WeChat!')

# 发送图片

my_friend.send_image('my_picture.jpg')

# 打印来自其他好友、群聊和公众号的消息

@bot.register()

def print_others(msg):

print(msg)

# 回复 my_friend 的消息 (优先匹配后注册的函数!)

@bot.register(my_friend)

def reply_my_friend(msg):

return 'received: {} ({})'.format(msg.text, msg.type)

# 自动接受新的好友请求

@bot.register(msg_types=FRIENDS)

def auto_accept_friends(msg):

# 接受好友请求

new_friend = msg.card.accept()

# 向新的好友发送消息

new_friend.send('哈哈,我自动接受了你的好友请求')

# 进入 Python 命令行、让程序保持运行

embed()

# 或者仅仅堵塞线程

# bot.join()

企业微信

- 企业微信应用接入

- 【2022-3-3】用企微账号api发消息,只需要access_token就能发消息,这个公司企微管理员应该能看到

- 企业微信接口文档;企业微信提供了好几种发送消息的模式,主要应用支持推送文本、图片、视频、文件、图文等类型;

企业微信官方开发前必读

- 可以将消息发送至对应的用户组,这里需要注意access_token 的有效期7200s,而且接口的请求次数有限制,所以我们需要对返回的token值进行缓存,可以存储在redis或者MySQL,过期以后进行重复获取;

- 开发者需要缓存access_token,用于后续接口的调用(注意:不能频繁调用gettoken接口,否则会受到频率拦截)

# 获取微信access_token

def get_token():

# https://qyapi.weixin.qq.com/cgi-bin/gettoken?corpid=ID&corpsecret=SECRET

payload_access_token = {'corpid': 'wwfcdce534bxxxxx', 'corpsecret': '-hpCA42o4cm1DzgSfS23XtEZ93ZI3VNwDgcP-xxxxxUd4X6Q'}

token_url = 'https://qyapi.weixin.qq.com/cgi-bin/gettoken'

r = requests.get(token_url, params=payload_access_token)

dict_result = (r.json())

return dict_result['access_token']

def send_message():

url = "https://qyapi.weixin.qq.com/cgi-bin/message/send?access_token=%s" % get_token()

data = {"toparty": 1, "msgtype": "text", "agentid": xxxxx, "text": {"content": "提现成功"}, "safe": 0}

data = json.dumps(data, ensure_ascii=False)

r = requests.post(url=url, data=data.encode("utf-8").decode("latin1"))

return r.json()

if __name__ == '__main__':

send_message()

- 企业微信接入第三方应用(以服务商身份)

- 企业微信接入机器人步骤

- 企微官方文档上列的是机器人主动发消息,目前不支持类似钉钉的 @方式调起机器人

注意:

- 外部群没有机器人接口

- 企微管理后台可以开启自动回复,支持图文、网页、小程序等内容,客户建的群机器人暂无此功能;参考企业微信如何自动回复

- 关键词规则条数支持设置100条,单条回复的字数上线是4000字

- 企业微信推出3.0.16版本后,新增了群聊关键词自动回复功能,客户在群内@群助理并触发关键词后,即可自动回复相应话术,提升运营人员的运营效率。

- 群主进入群聊,点击右上角的小人头,即可开启自动回复机器人,当群成员在群内@小助理 并触发关键词时,就能实现自动回复了。

- 企业微信机器人支持发送多种数据格式,包括:纯文本、Markdown(部分语法)、图片、新闻卡片、文件

【2021-11-15】企业微信群机器人测试,文档

- 点加号,群管理里点添加机器人按钮,就可以创建一个群机器人了。可以给机器人起个名字,上传个头像,加个简单介绍。系统会自动生成一个Webhook调用地址,关于调用方法在配置说明里有详细说明。

- 企微手机端添加企微机器人,(pc端没有添加入口),记住webhook地址url

- 调用接口发送数据(请求url),传入指定参数

- Windows系统:用VBS创建了一个脚本,然后在windows服务器中加入一个计划任务,在固定时间执行这个脚本,就可以实现一个简单的群里自动提醒功能了。

- 其它系统:shell命令执行

代码:

# --- 企微群机器人 ----

# 文档:https://work.weixin.qq.com/api/doc/90000/90136/91770?version=3.1.0.6189&platform=mac

# 当前自定义机器人支持文本(text)、markdown(markdown)、图片(image)、图文(news)四种消息类型。

# 机器人的text/markdown类型消息支持在content中使用<@userid>扩展语法来@群成员

curl 'https://qyapi.weixin.qq.com/cgi-bin/webhook/send?key=*****' \

-H 'Content-Type: application/json' \

-d '{

"msgtype": "text",

"mentioned_list":["wangqiwen004@ke.com","fanbingbing019@ke.com"],

"mentioned_mobile_list":["1380000000","@all"],

"text": {

"content": "贝壳小冰,你好呀~ @某人 测试"

}

}'

# 更多参数

# "mentioned_mobile_list":["13800001111","@all"]

# -------------

echo "图文格式测试"

curl "https://qyapi.weixin.qq.com/cgi-bin/webhook/send?key=$key" \

-H 'Content-Type: application/json' \

-d '{

"msgtype": "news",

"news": {

"articles" : [

{

"title" : "图文格式测试:吃饭啦~",

"description" : "吃饭不积极,**有问题",

"url" : "https://bpic.588ku.com/element_origin_min_pic/19/06/28/181fceffd5e9a9782dc2d88345df09d9.jpg",

"picurl" : "http://www.biaoqingb.com/uploads/img1/20200414/96af725485d3cbe70299f59b39ee841c.jpg"

}

]

}

}'

当前自定义机器人支持:文本(text)、markdown(markdown)、图片(image)、图文(news)四种消息类型。可以定制模板卡片

- 亲测markdown格式可用、图片/文件也行,只是需要单独上传图片/文件到腾讯服务器

- 示例:https://qyapi.weixin.qq.com/cgi-bin/webhook/upload_media?key=693a91f6-7xxx-4bc4-97a0-0ec2sifa5aaa&type=file

- type取值:图片(image)、语音(voice)、视频(video),普通文件(file)

- 文件大小在5B~20M之间

- 返回:media_id,媒体文件上传后获取的唯一标识,3天内有效

- @群成员功能无效

- userid的列表,提醒群中的指定成员(@某个成员),@all表示提醒所有人,如果开发者获取不到userid,可以使用mentioned_mobile_list

【2022-3-11】企微机器人发送图片,参考:官方文档,应用案例-python生成折线图并调用企业微信群机器人发送图片消息

# -*- coding: utf-8 -*-

# s = '中文' # 注意这里的 str 是 str 类型的,而不是 unicode

# s.encode('gb2312')

import time

import pymssql

import requests

import matplotlib.pyplot as plt

import hashlib

import os

import base64

# 获取文件的Base64编码

def get_file_base64(filepath):

if not os.path.isfile(filepath):

return

with open(filepath, "rb") as f:

image = f.read()

image_base64 = str(base64.b64encode(image), encoding='utf-8') # 这里要说明编码,否则不成功

return image_base64

# 获取文件md5函数

def get_file_md5(filepath):

# 获取文件的md5

if not os.path.isfile(filepath):

return

myhash = hashlib.md5()

f = open(filepath, "rb")

while True:

b = f.read(8096)

if not b:

break

myhash.update(b)

f.close

# print(myhash.hexdigest())

return myhash.hexdigest()

# 发送消息函数, msgtype定义:text 发送字符串消息,markdown 发送图片消息,image 发送图片消息, news 发送图文消息

def postmsg(url, post_data, msgtype):

# sss = "这是一条用python发送的测试信息,请忽略!"

post_data = '{"msgtype" : "%s", "%s" : %s}' % (msgtype, msgtype, post_data)

# post_data = '{"msgtype": "markdown","markdown": {"content": "%s"}}' % sss

# print(post_data)

if url == '':

print('URL地址为空!')

else:

r = requests.post(url, data=post_data.encode())

rstr = r.json()

if r.status_code == 200 and 'error' not in rstr:

result = '发送成功'

return result

else:

return 'Error'

def querySQL():

# 数据库连接配置

config_dict = {

'user': '***',

'password': '******',

'host': '******',

'database': '******'

}

def conn():

connect = pymssql.connect(**config_dict)

if connect:

print("connect success!!!")

return connect

else:

print("连接失败!请检查配置信息!")

conn = conn()

cursor = conn.cursor()

sql = "select * from [TableName] order by [Fields]" # 编写SQL查询字符串

cursor.execute(sql)

col = cursor.description

resultdata = cursor.fetchall()

return resultdata, col

cursor.close()

conn.close()

if __name__ == '__main__':

url = "https://qyapi.weixin.qq.com/cgi-bin/webhook/send?key=*******-****-****-****-******" # 群机器人地址

resultdata, col = querySQL()

# print(resultdata)

# print(col) 查询到的表的列名

datelist = []

for i in range(len(resultdata)):

datelist.append(resultdata[i][0])

# print(datelist)

saleslist = []

for j in range(len(resultdata)):

saleslist.append(int(resultdata[j][1]))

# print(saleslist) # 销售数据清单

# 刻度和序列值

x_data = datelist

y_data = saleslist

# plt.plot(x_data, y_data)

# 设置画布大小

plt.figure(figsize=(16, 8))

plt.title("The Recent 7 Days Sales")

plt.plot(x_data, y_data, label='金额', linewidth=3, color='black', marker='o', markerfacecolor='r',

markersize=10) # 标记点

# 设置数字标签

for a, b in zip(x_data, y_data):

plt.text(a, b, b, ha='center', va='bottom', fontsize=14)

# 取当前时间为文件名

pic_full_name = './' + time.strftime("%Y%m%d%H%M%S", time.localtime()) + '.jpg'

plt.savefig(pic_full_name)

pic_md5 = get_file_md5(pic_full_name)

pic_base64s = get_file_base64(pic_full_name)

# print(pic_md5)

# print(pic_base64s)

# plt.show() # 显示图表

out_mk_msg = "### 最近七天市场业绩:\n"

for i in range(len(resultdata)):

out_mk_msg = out_mk_msg + r">日期:%s , 业绩:<font color = \"warning\">%d</font> , 店数:%s , 新会员:%s , 老会员:%s " % (

resultdata[i][0], resultdata[i][1], resultdata[i][2], resultdata[i][3], resultdata[i][4]) + "\n"

out_mk_msg = '{"content": "%s"}' % out_mk_msg

# print(out_mk_msg)

# 调用postmsg向接口提交数据,分别提并markdwon格式及图片格式消息

result = postmsg(url, out_mk_msg, "markdown")

# print(result)

out_pic_msg = '{"base64":"%s", "md5":"%s"}' % (pic_base64s, pic_md5)

result = postmsg(url, out_pic_msg, "image")

print(result)

现状

- 参考资料

对话机器人是一个热门话题,大家熟知的应用和产品主要有三种:

- 第一种是

虚拟助手,能对个人输入完成相应的任务或提供相应服务,典型的商业产品包括如siri、cortana、度秘等; - 第二种是

智能音箱,通过语音交互,完成用户任务,也能对智能家居设备进行控制。典型的商业产品包括如echo、天猫精灵、小爱同学等; - 第三种是

闲聊对话,在开放域与用户进行闲聊。典型的商业产品如:微软小冰。

智能助理

- 什么是智能助理

- 【2017-9-27】智能助理的应用场景选择

- 利用AI技术,打造统一的CUI(对话交互界面),一站式的整合信息&服务。

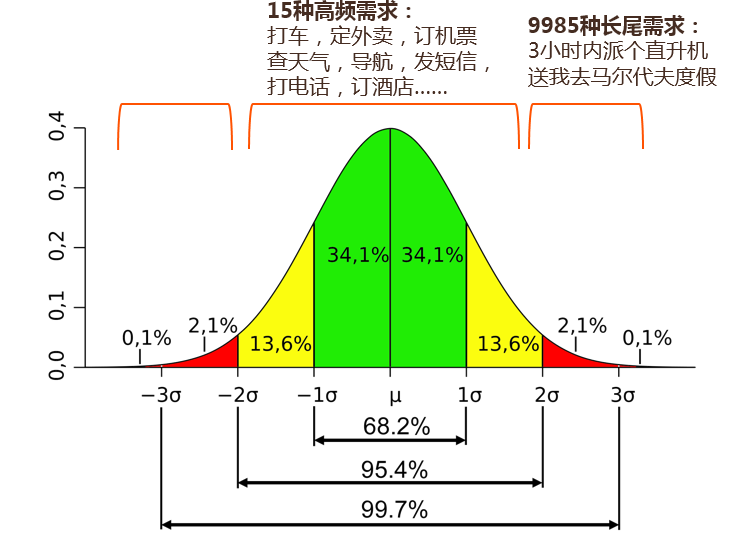

- 真正的智能交互是一种“自由”的交流与交互方式,而不仅仅是与“以自然语言为形式”的交互方式,后者很有可能会沦为自然语言形式的“命令行”。

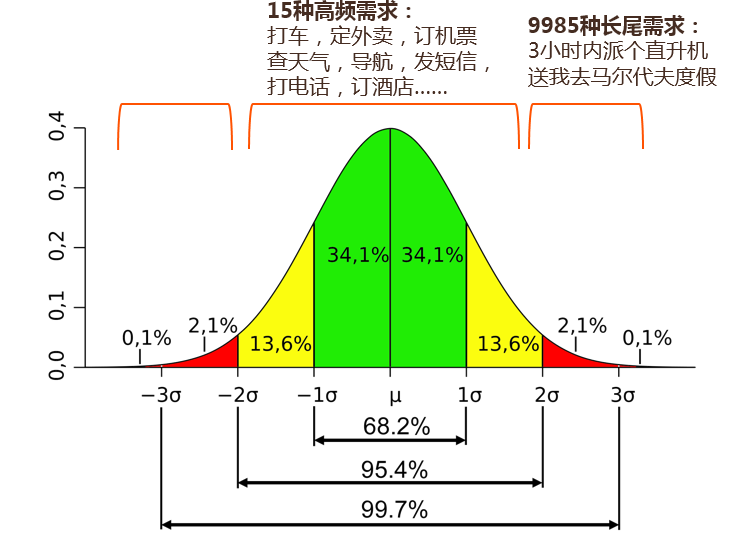

- 人类的需求是服从正态分布的,例如人类有1万种需求,其中15种的高频需求,覆盖95.4%的用户请求量。但这些高频需求都会被“APP”形式的应用占领(例如淘宝、携程等),因此这些高频需求反而不是CUI需要去覆盖的。

- CUI的重点?

- 人类的需求是服从正态分布的,例如,人类有1万种需求,其中15种的高频需求,覆盖95.4%的用户请求量。但这些高频需求都会被“APP”形式的应用占领(例如淘宝、携程等),因此这些高频需求反而不是CUI需要去覆盖的。

- CUI核心是去覆盖频率只有5%,但数量却有9985种的长尾需求。每个人的长尾需求都不一样,CUI若能很好的满足一些长尾需求,能够使用户和产生依赖,让自己也成为一个“入口”。这是“低频打高频”的畅想。

- 15种高频需求:打车、外卖、订机票、查天气、导航、发短信、打电话、订酒店。。。

- 9985种低频需求:3h内拍个直升机送我去马尔代夫

- 通用领域的长尾困境

- “低频打高频的畅想”实现起来困难重重,即“通用领域的长尾困境”。

- 低频打不过高频:

- 低频通常被定义为:使用频次较低,用户重复选择率较低。

- ×代驾和滴滴打车这两款软件同样是满足有出行需求的用户群,但代驾相对于出租车,属于使用频次较低的功能。当滴滴打车以“出租车”这个高频需求迅速切入市场,培养了大批用户群体后,迅速横向扩展到专车和代驾领域,并且以比单一领域更便捷的方式瓜分市场,自然将代驾产品逼上了绝境。毕竟,用户的手机不会装两款同等效用的产品。

- 创投圈/产品圈都流传着这样一个观点:“高频打低频”,高频的业务(如外卖O2O、日常出行)容易对相对低频的业务(如药品O2O、商务出行)形成竞争优势,高频的业务切入低频业务很容易,低频业务反击高频业务却很难。

- 为什么打不过低频?

- 大部分的解释来自流量模型,即高频业务天然拥有更多流量,即使在用户场景中分流一部分,也能对只做低频业务的独立应用形成流量优势,例如在外卖APP中上线一个送药上门的板块,让高频的外卖业务为低频的送药业务导流。

- 与直接做低频业务相比,从高频业务开始借助样本优势建立的效率差能够给用户带来更多效用差,这就是我认为的“高频打低频”观点的另一个真相

- 摘自:样本优势:“高频打低频”的另一个真相

- 低频打不过高频:

- 主要是由于不同场景下语义可以多种多样,有太多不明确的意图无法确认。

- 为解决此问题,试图限定谈话的领域,从宽度发展变为广度发展。这也就是垂直领域的智能助理。

- “低频打高频的畅想”实现起来困难重重,即“通用领域的长尾困境”。

- 垂直领域智能助理的困境

- (1)推理复杂度

- 机器学习(ML)是计算的逆运算,很多时候从结论反推规则,用数据训练规律。对象的复杂程度直接决定模型的复杂程度。

- 意图理解难推理

- (2)知识复杂度

- (3)数据开放度

- 很多领域,例如医疗领域的数据非常难获取。这也是项目的难题之一。

- (1)推理复杂度

- 解决方案

- 1):面向大众还是专业人士?

- 2)找到“不得不”场景

- Amazon的Echo在2016年出货500万台,2017预计卖1500万台。它的10大应用除了“设闹钟”等需求,还有“读报纸”“新增物品至购物清单”这些适应国外用户的需求。因此我们不仅仅要回答“我有什么好”还要回答“我比原来的方案有什么好”

- 很多用户购买AI是为了满足客户对AI的期望

- 3)认知问题感知化解决

- 穷举在该领域内,用户可能会说的所有query类型

- 完备性 <- 颗粒度 -> 一致性

- 使用对话模板( DIT++等,DIT++对话模板的官网 )

- 使用意图模板

- 4)场景垂直VS领域垂直

- 平时说垂直是说领域的垂直,比如房地产这种行业类的。但是很多时候需要场景的垂直,用很窄的场景就解决一个小问题,并且带来足够多的好处。

- “场景小才能压强大”

- AI是解决简单重复的脑力劳动。在智能助理的产品下,简单重复的脑力劳动就是指“明确目标、有限输入、对话可迅速收敛的任务指令”。

- 平时说垂直是说领域的垂直,比如房地产这种行业类的。但是很多时候需要场景的垂直,用很窄的场景就解决一个小问题,并且带来足够多的好处。

- 5)人机协作系统

- 与其打造高智能的机器系统,不如打造人工和机器一起协作的系统。用人工来保证机器的稳定性。任何一个智能助理的大概的基础架构如上图。当用户输入一句话后,先做NLP部分,再做对话管理部分(决策部分),最后再做业务处理。这三个模块,全部都需要机器去运算,那我们就可以给每个模块加上后台审核人员,对数据做一个标注。这样就能达到数据沉淀的目的。

- 标注数据对AI来说非常重要(很多公司都花了大量的时间和费用去买数据、标注数据),“人机协作”在早期既能保证系统稳定,又能标注大量实时有效的数据,是非常好的一种方式。

- 1):面向大众还是专业人士?

- 技术需要产品化

- AI技术还不够,需要工程化、产品化;

- 行业需要科学家,也需要好的产品经理,好的全栈工程师。

- AI产品的架构比普通的互联网产品多了一个维度——“时间”。

- 这种产品架构,可以生存到未来,并在未来逐步进化,一步步向智能逼近。

- 其他业务实践分享

- 金融科技-智能投顾与AI金融风控-谢成,类似文章:灵智优诺CTO 许可的如何为智能投顾打造对话系统?

- 金融科技的生态是三个相互牵制的部分:公司/银行——监管——资本

- 金融科技发展:

- 20世纪70年代 业务电子化

- 20世纪80年代 前台电子化(ATM机等)

- 20世纪90年代 金融业务互联网化(实现了高效连接)

- 21世纪 金融科技

- 中国金融科技发展

- IT系统 —— 支付 —— 信贷 —— 大金融 —— 生活

- 智能投顾(Robo-advisor):个性投资、私人订制、组合投资、分散风险、智能投顾、自动调节

- 金融建模的业务流程

- (1)收集数据源(信用数据以及非标准数据)

- (2)融和数据加工

- (3)构建模型

- 车载语音助手的实战干货-宏卫

- 做产品,不做AI产品。因为小公司在算法等等技术上很难超过BAT等大公司,所以选择和构成产品每个部分最好的业务技术公司合作,再加上我们对产品的深挖,来做我们的产品

- 车载场景下没有办法直接做to C的软件,因此选择了to B的商业模式。

- 为了启动顺利,做了大量的数据埋点,收集到了颗粒化的数据,甚至是用户每一个问句都做了加密后的信息收集。

- 和大量的内容企业合作,比如QQ音乐、喜马拉雅等等。

- 金融科技-智能投顾与AI金融风控-谢成,类似文章:灵智优诺CTO 许可的如何为智能投顾打造对话系统?

移动端(离线)对话系统

- 【2021-5-8】移动设备不同于服务器,资源受限,离线NLU&DM成为难点

- 腾讯云小微智能助手,车机端无网络或弱网场景下,服务器端功能受限,内存受限以及硬件性能差时,如何提供语义理解与对话管理能力。

- 意图识别模型压缩以及各模块内存优化方案;

- 领域意图识别模型(CNN + Attention -> Albert -> 知识蒸馏模型);

- 离线分布式训练 pipeline 搭建

- 基础 NLP算法,如分词、多模匹配, 分词算法优化(BloomFilter + FMM -> RNN)。

- 领域意图识别(模型分类 + 模板匹配)、实体抽取、槽位填充等语义理解能力;

- 模板匹配引擎支持正则、复杂、黑名单、追问、询参、多意图等各类模板。用于云小微的 NLU 和 KBQA 等任务,线上总模板数量 200w+,服务平均响应耗时 10.6 ms,模板流水处理耗时秒级(模板动态更新可在数秒内生效),在线上有效召回的流量中模板匹配占比 65%+。

- 结果排序,多轮等对话管理能力,如追问、澄清、确认

云小微离线语义全部数据内存占用 < 100M,全领域意图识别准确率86%+,离线优先领域意图准确率90%+,支持单工/双工(单向/双向,主动/被动)两种对话模式、单轮/多轮两种对话状态。接入 50+款不同车机端使用。

语义理解单工模式准确率 95%+,召回率 96%+;双工模式 误识率< 4%,拒识率< 7%。核心技能 F1-score:电台/小说 98%+,车控/导航 95%+。对话能力已输出到家居、出行、教育、文旅、客服等场景。

对话任务分类

【2022-5-9】两万字聊对话系统

按功能划分

整体框架 image

(1)对话机器人按照功能可以分为3-4类:

- 第一类

任务型对话,主要解决如订机票、订酒店等问题。- 用户希望完成特定任务,机器人通过语义执行后台已对接能力,帮用户完成指定任务

- 涉及的技术包括:语义理解、意图识别、状态追踪、对话决策等;

- 第二类

知识型(问答型)对话- 用户希望得到某个问题的答案,机器人回复来自于特定知识库,以特定的回复回答用户

- 在寿险客服的场景里,用户可能会问“你这个保险要交多少钱?”这类问题。

- 涉及的技术包括:文本表示、语义匹配、知识图谱等;

- 问答型聊天机器人需要解决用户对于事实型(Factoid)问答(如 what、which、who、where 和 when)问题的回复,以及非事实型问答(如 how 和 why)的回复

- 第三类

闲聊型对话- 用户可能只想找人聊聊天,对话不涉及到知识或业务,比如说“今天天气真好”。

- 用户没有明确目的,机器人回复也没有标准答案,以趣味性的回复回答用户

- 涉及的技术包括:文本生成模型、文本检索、排序技术等;

- 第四类

推荐式对话,新兴领域- 大多数推荐系统都是以静态的方式工作,于是有了对话推荐系统(Conversational Recommender Systems,CRSs)的出现,打破了传统静态的工作方式,动态地和用户进行交互,获得用户的实时反馈,进而向用户做出心仪的推荐。图

总结:

【2021-8-4】多轮对话体系定义问题的回答——

- 基本定义:什么是多轮对话? (封闭域)多轮对话是一种人机对话中获取必要信息以明确用户指令的方式。多轮对话与一件事情的处理相对应。

- 补充说明1:所谓『必要信息』一定要通过与用户的对话获取吗? 不一定,即便是人与人之间的交流,对话本身所包含的信息也只占总传递信息量的小部分,更多信息来源于说话人的身份、当前的时间/地点等一系列场景信息。所以多轮对话的信息获取方式,也不应当只局限于用户所说的话。

-

补充说明2:多轮对话一定在形式上表现为与用户的多次对话交互吗? 不一定,如果用户的话语中已经提供了充足的信息,或者其它来源的补充信息已足够将用户的初步意图转化为一条明确的用户指令,那就不会存在与用户的多次对话交互。 参考:AI产品经理需要了解的AI技术概念

- 【2021-5-31】问答、任务和闲聊几种类型对话的区别和关系 图

按模式划分

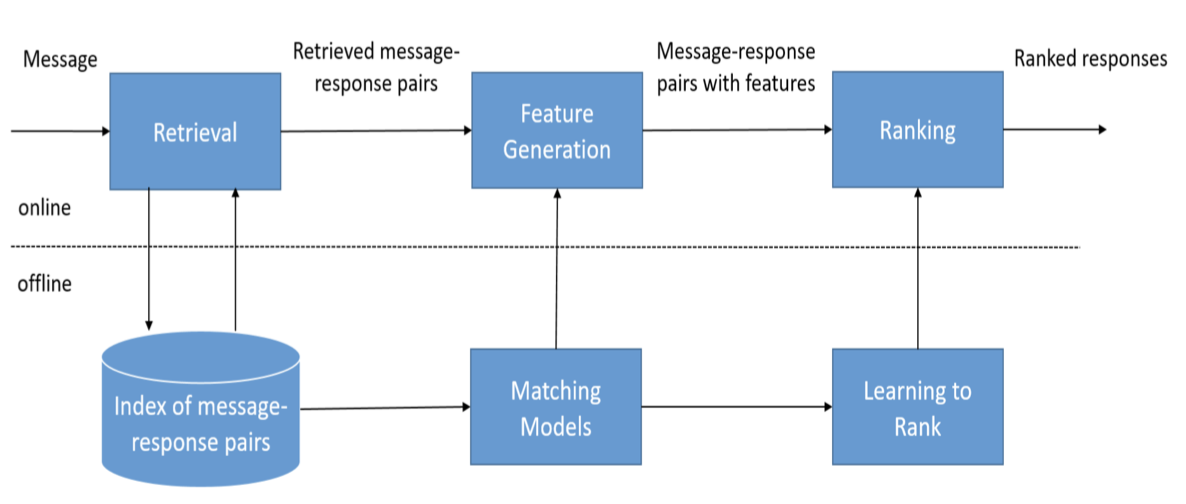

(2)按照模式可以分为检索和生成,混合型

- ① 检索式模型,用预定义的数据库和某种启发式推理来根据输入和上下文选择适当的答复。换句话说就是构建FAQ,存储问题-答案对,之后用检索的方式从该FAQ中返回句子的答案。 这些系统不会产生任何新的文本,他们只是从固定的集合中选择一个响应。

- 这种方法有明显的优点和缺点。 由于使用手工打造的存储库,基于检索的方法不会产生语法错误。 但是,它们可能无法处理没有预定义响应的场景。 出于同样的原因,这些模型不能引用上下文实体信息,如前面提到的名称。

- 知识图谱问答也算检索式;

- 检索式是对话系统主要落地形式,稳定、可控,没什么风险,NLP只需关注理解和匹配,答案内容不用管,整个流程会简单得多。

- 基本流程

- 问答对数据集的清洗

- Embedding(tfidf,word2ec,doc2vec,elmo,bert…)

- 模型训练

- 计算文本相似度

- 在问答库中选出与输入问题相似度最高的问题

- 返回相似度最高的问题所对应的答案

- 检索式对话系统框架 image

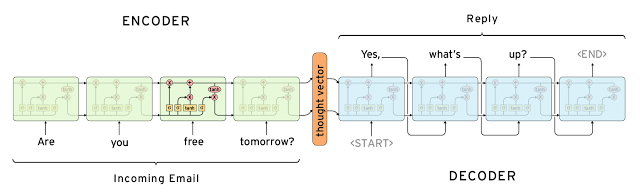

- ② 生成式模型,这种方法更难些,它不依赖于预定义的响应,从零开始生成新的响应。

- 生成式通过模型、规则手段生成回复,相对智能。这种方式优点是泛化能力强,不用提前准备所有知识点、答案,但缺点也明显,不可控,缺乏知识的生成可能会一本正经的胡说八道,如:从北京到深圳只需2公里,即便目前最强的GPT也会出现这种问题

- 生成式模型通常基于机器翻译技术,但不是从一种语言翻译到另一种语言,而是从输入到输出(响应)的“翻译”。图

- 这方法有明显的优点和缺点。它可以引用输入中的实体,给人一种印象,即你正在与人交谈。 然而,这些模型很难训练,而且很可能会有语法错误(特别是在较长的句子上)不可控,并且通常需要大量的训练数据。

- ③ 混合式:检索和生成结果的结合,根据检索式查询到的零散信息,通过生成式将结果拼接成更完整、流畅的回复。

按交互次数

只是回复一次就结束对话,上下文之间不考虑相关性,那就是单轮对话,与之相反就是多轮

- 毫无疑问,多轮对话的难度要大于单轮,单轮对话遇到的问题多轮基本都会有,而多轮因为要考虑上下文,难度可就大很多了。

多轮对话的结构和思路是已经形成了一定的共识,即需要DM模块(dialog management)来管理对话内容

- 无论是对方的还是机器的,都需要维护起来,确保一致,即 DST(dialog state tracking)

- 然后根据对话的进展以及对话管理下的内容进行综合评定给出最终回复,即 DP(dialog policy),或者说是对话策略(dialog strategy)。

按领域划分

(3)按领域分类可分为:开放领域和封闭领域。

- 开放领域的chatbot更难实现,因为用户 不一定有明确的目标或意图。像Twitter和Reddit这样的社交媒体网站上的对话通常是开放领域的他们可以谈论任何方向的任何话题。 无数的话题和生成合理的反应所需要的知识规模,使得开放领域的聊天机器人实现相当困难。同时这也需要开放域的知识库作为其知识储备,加大了信息检索的难度。

- 封闭领域的chatbot比较容易实现,可能的输入和输出的空间是有限的,因为系统试图实现一个非常特定的目标。 技术支持或购物助理是封闭领域问题的例子。 这些系统不需要谈论政治,只需要尽可能有效地完成具体任务。 当然,用户仍然可以在任何他们想要的地方进行对话,但系统并不需要处理所有这些情况用户也不期望这样做。

按主导方

(4)主导方:系统主导、用户主导

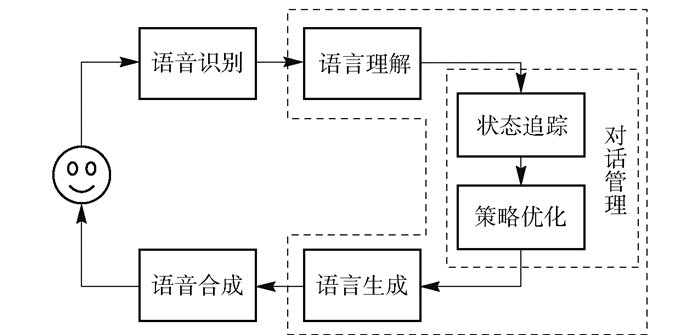

对话系统架构

- 按照对话系统的技术架构来分,人机对话系统可以分为任务型对话系统和非任务型对话系统两大类,在实际商业应用中这2种对话方式常常结合在一起使用.

- 任务型对话通过交互的方式帮助用户完成一项或多项特定的任务,系统能够完成的任务通常是一个有限的集合,每个任务有明确的流程、输入和输出,如智能订票系统、账单查询系统等.

- 非任务型对话系统没有明确的任务列表,可以用于同用户闲聊,或者回答用户在某一个或多个领域的问题.

- 摘自:智能对话系统架构及算法

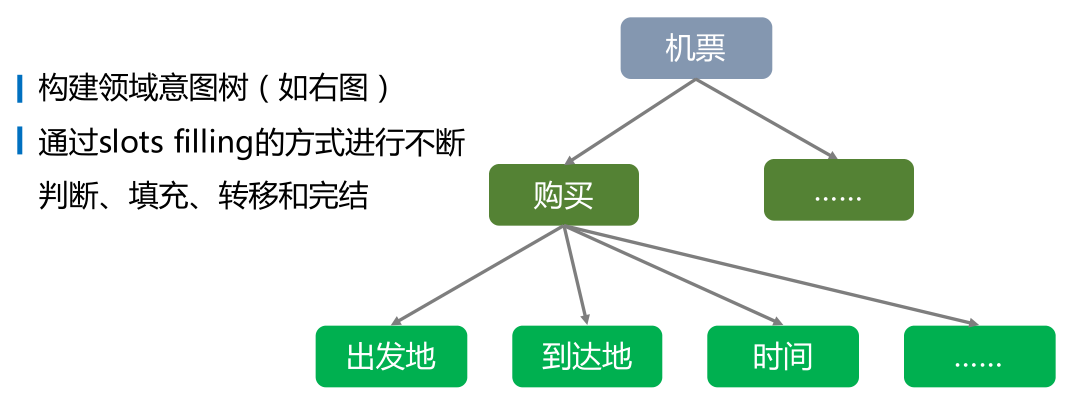

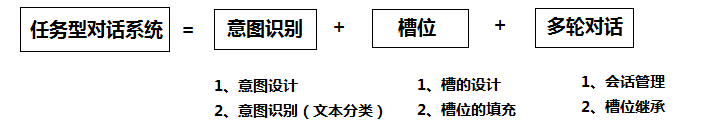

任务型架构

任务型对话的最终目标是完成指定任务,比如小度智能音箱,需要在每一轮对话都采取合适的决策,保证自己执行正确的指令(即识别出用户的正确意图) image

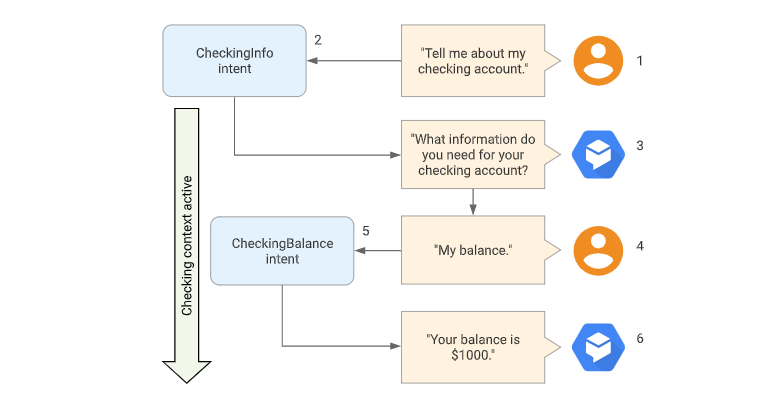

- 多轮对话是一种在人机对话中初步明确用户意图之后,获取必要信息以最终得到明确用户指令的方式。介绍一种对话管理的一种方式:Frame-Based Dialogue Control,预先指定了一张表格 (Frame),聊天机器人的目标就是把这张表格填满。

- 示例

| 角色 | 发言 | 意图 | 槽位 |

|---|---|---|---|

| 我 | 去北京大兴机场多少钱 | 行程花费计算 | 起始地:当前位置;目的地:北京大兴机场;使用货币:??? |

| bot | 您好,请问是使用人民币吗 | ||

| 我 | 是的 | 行程花费计算 | 【起始地:当前位置;目的地:萧山机场;使用货币:人民币】) |

| bot | 『200元』 |

相关技术:image

- 1、意图识别

- 2、填槽、对话管理

- 3、多轮对话

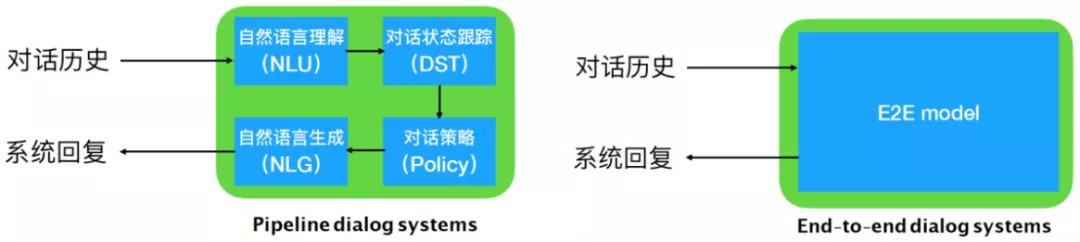

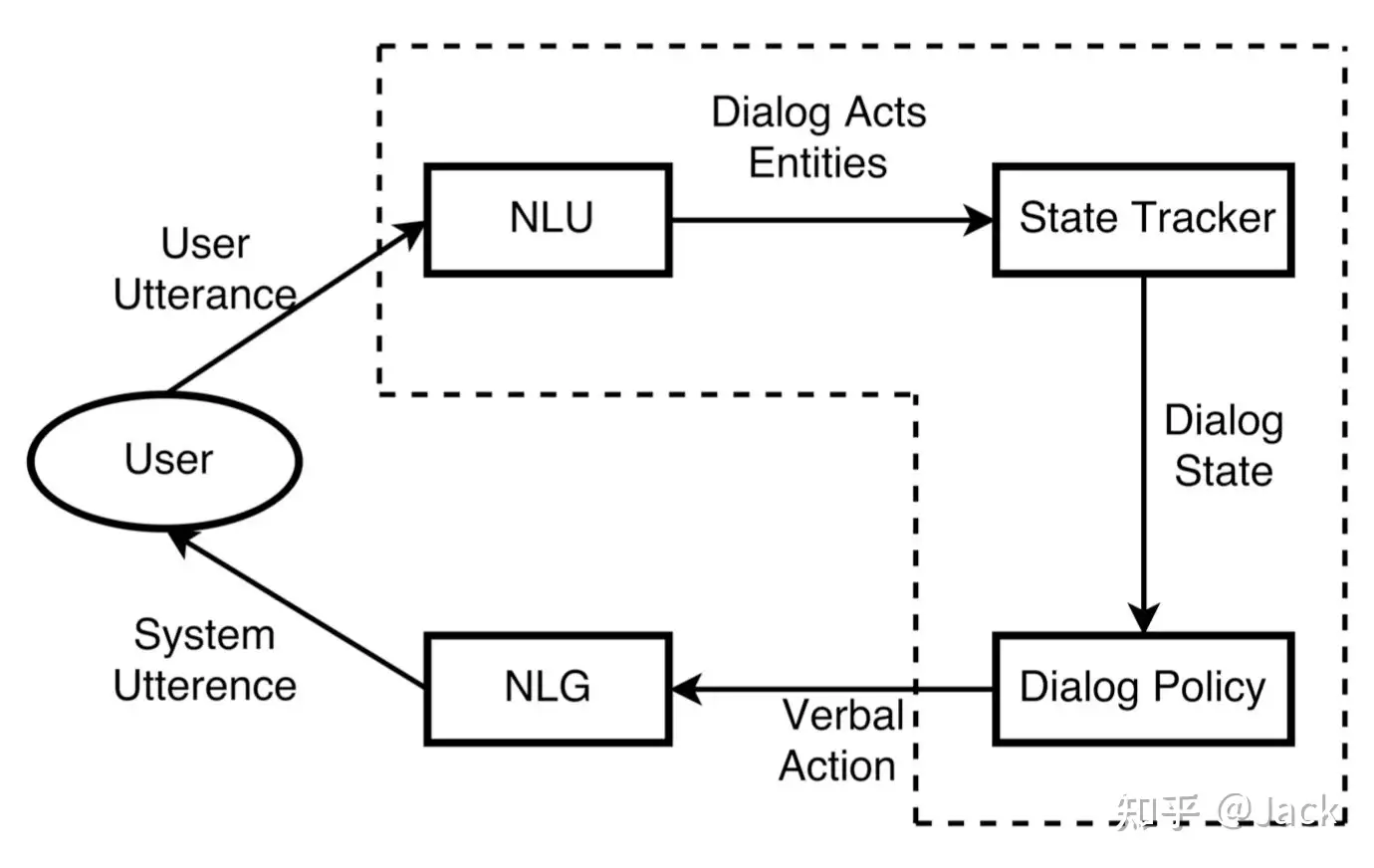

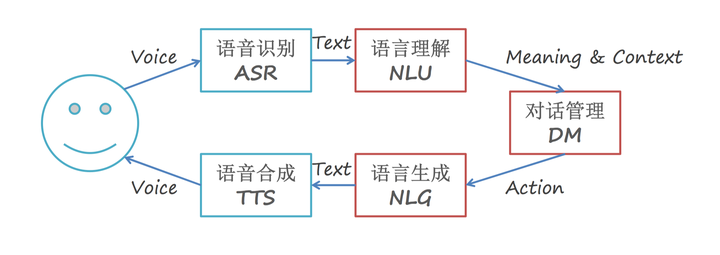

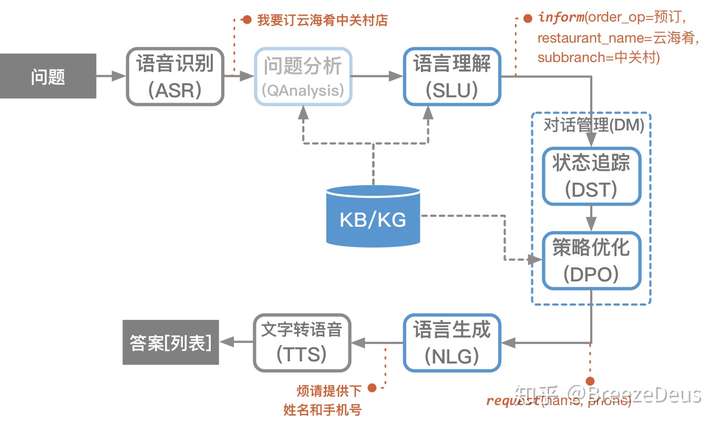

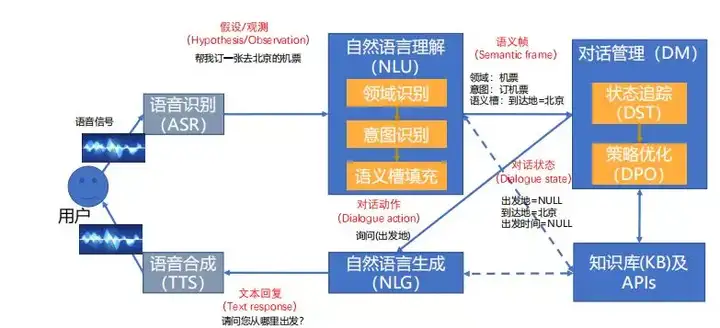

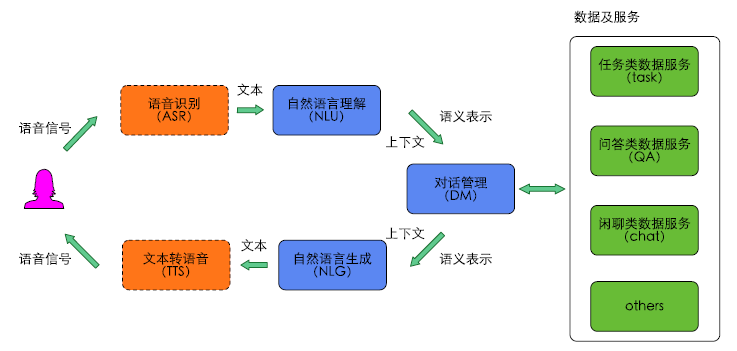

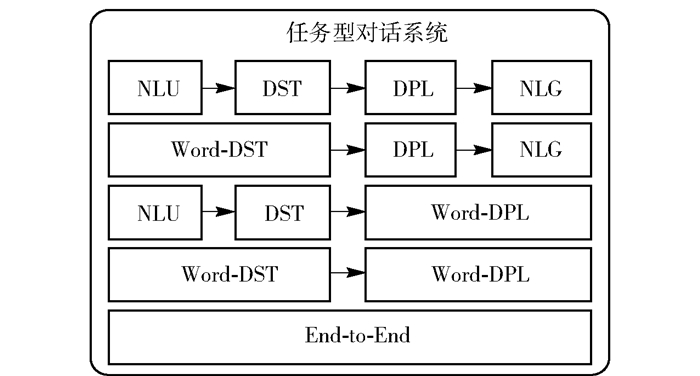

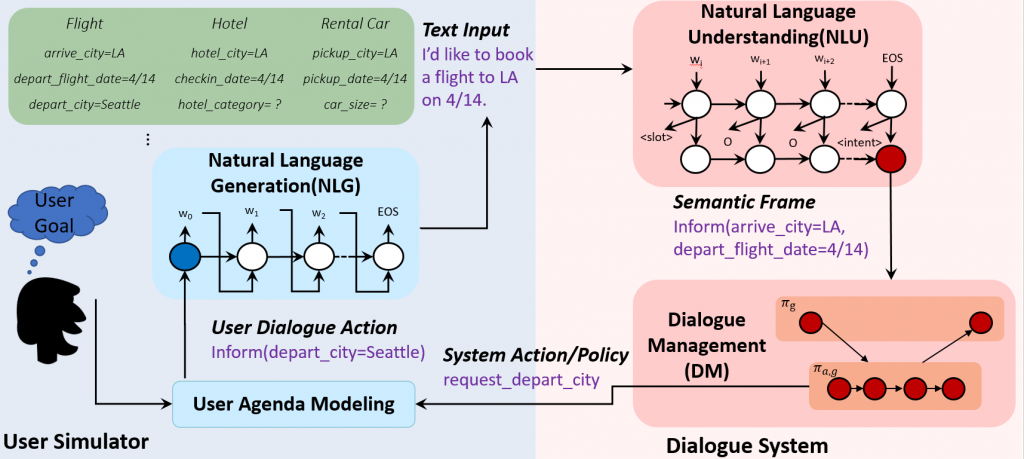

当前任务型对话系统的典型架构主要分为2类:

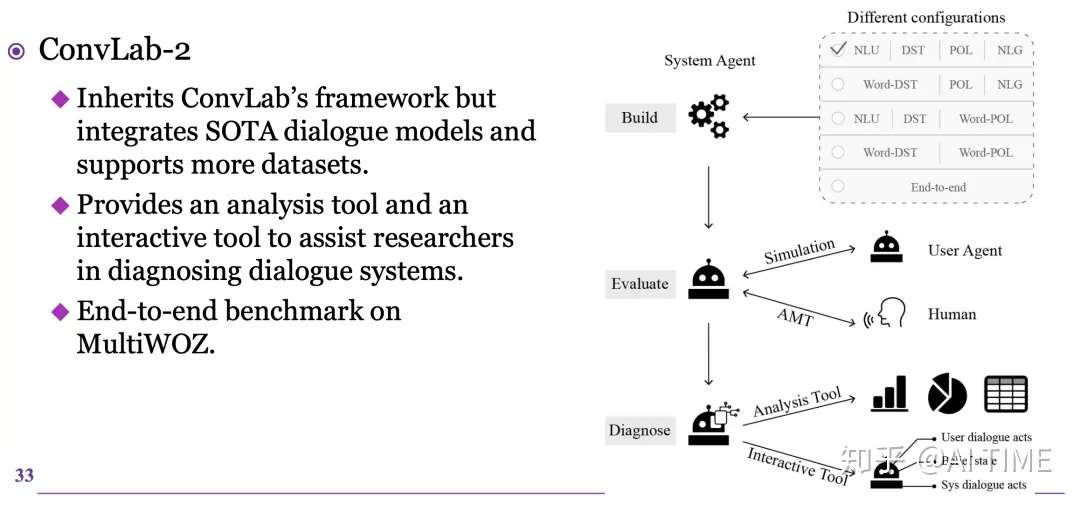

- 管道式架构,(商用典型架构),包含:

- 语音识别(ASR, automatic speech recognition)

- 自然语言理解(NLU, natural language under standing)

- 对话管理器(DM, dialogue manager)

- 语言生成(NLG, natural language generation)

- 语音合成(TTS, text to speech)等组件[5].

- 纯文本的对话不含语音识别NLU和语音合成TTS模块.

- 近几年随着深度学习的发展,一部分对话系统将对话管理器分成对话状态跟踪(DST,dialogue state tracking)及对话策略优化DPO 2个部分,使得对话管理更加依赖统计模型的方法,更加鲁棒.管道式架构中各个模块独立优化,也是目前商用系统的典型架构.

-

尽管模块化的对话系统由于每个部分独立优化,具有更强的可控性,但是端到端的对话系统可以直接利用对话日志进行训练,不需要人工设计特定的语义标签,因此更具备可扩展性,在一些复杂度中低的对话场景中能够快速训练部署使用。

- (1)管道式架构——pipeline

- (2)端到端结构——end2end

- 各个模块彼此依赖,统一优化.目前端到端的人机对话系统随着深度学习等一系列算法技术的进步而迅速发展,逐渐成为当前的研究热点.

- 由于内部独立模块的训练过程,管道式架构往往存在模块之间错误累加的问题.与管道式架构不同,端到端模型根据误差的反向传播共同调整和优化模型内部的网络结构和参数,直到模型收敛或达到预期的效果,中间所有的操作都包含在神经网络内部,不再分成多个独立模块分别处理. 有的方法虽然是端到端的方法,但还是单独设计模型的部件,不同部件解决管道方法中某个或多个模块所承担的任务.

- 端到端对话模型可分为检索式和生成式,检索式模型就是给定对话历史从预定义回复候选集合中选出最佳回复作为当前系统输出,生成式模型则是给定对话历史直接生成回复。两种方式都可以通过和用户多轮交互完成最终的对话任务。图

- 将人机对话的过程看作为从对话历史到系统回复的一种映射问题,通常应用编解码模型来进行端到端训练.

- 端到端对话系统是在有监督的方式下进行训练,需要大量人人对话的训练数据,理论上有很多优点,但目前从结果上看仍需要在技术上做大的提升,以确保对话的逻辑性和鲁棒性.

- 总结:任务型对话系统的架构分类,图,源自清华convlab2的论文

非任务型架构

非任务型对话系统架构演进

- 非任务型的对话系统也称为聊天机器人,在开放领域或某一个特定领域与人进行信息沟通,系统没有特定完成任务的列表和槽位列表.

- 典型的非任务型对话系统的回复,一般通过生成方法生成或基于检索的方法抽取

- (1)基于生成模型的架构

- seq2seq对话生成模型将用户这轮对话的问题作为输入,借助神经元网络将用户的问题编码为一个编码矢量,该编码矢量同对话上下文的隐含矢量结合,共同作为一个神经元网络解码器的输入,逐词生成系统回复的句子.

- 1) 编码器和解码器的常用模型包括循环神经网络(RNN, recurrent neural network)、长短时记忆循环神经网络(LSTM, long short-term memory)、门控循环神经元网络、卷积神经网络(CNN, convolutional neural networks)、注意力模型或者组合.

- 2) 对话上下文的编码.研究人员将对话上下文的语义信息有效地用矢量表示,提出了分层的架构,在编码和解码之间加了一层专门对上下文进行建模.

- 3) 对话的实义性和多样性.在当前以序列到序列为基础的对话系统中,一个具有挑战性的问题是,这些系统倾向于产生无关紧要的或不明确的、通用的、没有意义的回复,如“我不知道”、“哈哈”这样的无实际含义的回复.解决这类问题的方法之一是修改目标函数,在生成式对话中加上行列式点过程,使得生成每个词的时候既考虑质量又考虑多样性.另外一个变化是序列到序列模型同对抗神经元网络的结合,以确保生成的答案同人工回复的相似性.

- 4) 主题一致性.为了确保对话过程中内在主题的一致性,对对话主题进行建模,作为额外的输入给对话生成的解码模型.

- 5) 系统人格的一致性.业界典型的做法是将用户的个性化信息用向量来表示,嵌入序列中进行学习,从而确保不同用户的人格和属性特征的一致性.

- 6) 情感.在传统的序列到序列模型的基础上,使用静态的情感向量嵌入表示,动态的情感状态记忆网络和情感词外部记忆的机制,使得新模型可以根据用户的输入以及指定情感分类输出相应情感的回复语句.

- seq2seq对话生成模型将用户这轮对话的问题作为输入,借助神经元网络将用户的问题编码为一个编码矢量,该编码矢量同对话上下文的隐含矢量结合,共同作为一个神经元网络解码器的输入,逐词生成系统回复的句子.

- (2)基于检索的架构

- 基于检索的方法从候选回复中选择回复.检索方法的关键是消息-回复匹配,匹配算法必须克服消息和回复之间的语义鸿沟.基于学习的搜索和排序算法在基于检索的对话系统中起着至关重要的作用,基础算法在近几年取得了非常大的进步,基于检索的对话系统展现出非常客观的性能和准确率.在众多非任务型对话中,基于检索的方法输出的结构也常常作为生成对话模型的输入,或者进行平行组合使用.

- 检索式对话的基本思路就是将输入和候选输出投射到同一个语义空间中,判断两者是否相似.对于是否相似的计算而言,经典方式是基于独热编码或词袋模型,这是比较传统的表达方式.而当深度学习崛起之后,开始使用表示学习,也就是学习出向量嵌入表示,最后是基于抽象表示的匹配相似度计算.

- 近年来,有很多模型被提出,如微软的DSSM、CDSSM及相关系列模型;华为诺亚方舟实验室提出的ARC-Ⅰ和ARC-Ⅱ;斯坦福的Tree-LSTM,IBM的ABCNN,Pang等提出的MatchPyramid,Qian等提出的ESIM等.通常,深度匹配模型可以从大类上分为表示型和交互型2种表示型模型,如DSSM等,侧重对表示层的学习和构建,它会在表示层将输入转换成整体表示向量,利用深度网络进行语义表示的加强.这种模型的问题是容易发生语义偏移,上下文信息的重要性难以显式衡量.交互型模型,如ARC-Ⅱ等,这类模型在输入层就进行词语间的先匹配,并将匹配的结果作为灰度图进行后续的计算和建模,能够更精细地处理句子中的联系.它的优势是可以较好地把握语义焦点,对上下文重要性合理建模.近年来,基于检索的架构在工业界的实践和应用得到了快速的发展.

- 检索知识库的过程中,最重要的是如何找到与输入语义等价的问句,常用的相似度算法包括: 余弦相似度、编辑距离、关键词重合度、BM25等等,实际使用中是有用,但仍然不够,因为可能遇到如下问题:①字面相似的句子语义不等价②字面不相似的句子语义等价,如“什么是新冠肺炎”和“解释下新冠肺炎的定义”是语义等价,但和“什么是支气管肺炎”却不是语义等价的,采用编辑距离之类的算法是无法识别的。图

- 因而,只有基于语义理解的模型才能识别出来,这里包括两类,一是传统机器学习方法,二是深度迁移学习方法。

- 基于BERT和BIMPM的语义等价模型方案,BIMPM本身是十分经典的模型,底层是通过word2vec向量来进行语义匹配计算,这里我们将word2vec词向量全部替换为BERT的最上面若干层的输出,并将原有模型中的BI-LSTM结构,替换为Transformer,以提高其在序列性上的表现,实际测试中,该模型在Quora和SLNI数据集中达到了state-of-the-art的效果,图

NLU

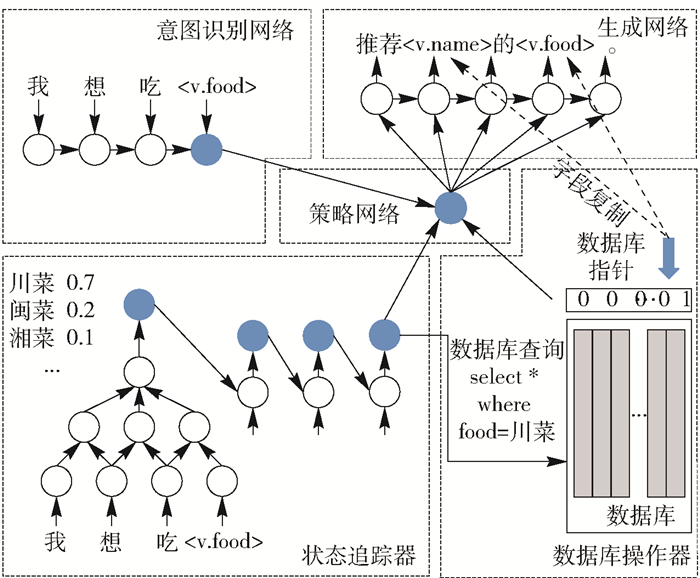

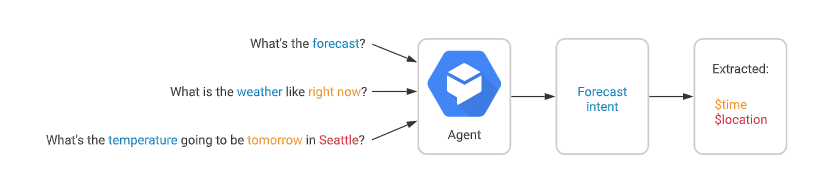

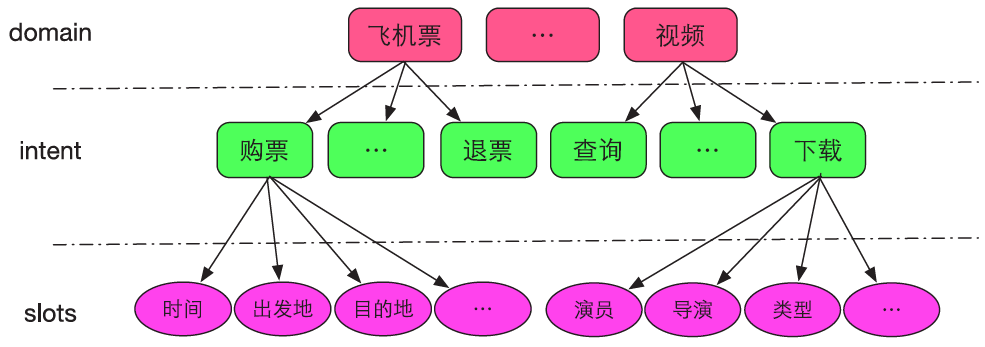

NLU即Natural Language Understanding,负责理解用户的语句输入,一般是做意图识别(intent detection)和槽位抽取(slots filling)。

- 台大陈蕴侬讲解的对话系统,语言理解的pipeline,前两者主要通过Classification实现,第三个是Sequence Labeling

- Domain Identification(分类): Requires Predefined Domain Ontology

- 如:find a good eating place for taiwanese food

- 识别为餐饮领域 2. Intent Detection(分类):Requires Predefined Schema

- 餐饮领域里的找餐馆意图:FIND_RESTAURANT 3. Slot Filling(序列标注):Requires Predefined Schema

- 槽位:rating=“good”,type=“taiwanese”

- Slot Tagging

【2021-5-31】自然语言理解的语义表示主要有分布语义表示 (Distributional semantics)、框架语义表示 (Frame semantics) 和模型论语义表示 (Model-theoretic semantics) 三种方式。在智能对话交互中,自然语言理解一般采用的是 frame semantics 表示的一种变形,即采用领域(domain)、意图(intent)和属性槽(slots)来表示语义结果,如图, 摘自:阿里智能对话交互技术实践与创新

开源代码

- Rasa_NLU 英文版、Rasa_NLU_Chi 中文版

意图识别

- 意图识别通过文本分类实现,但是和文本分类有区别,这个区别造就了它更“难一些”,主要难点如下:

- 输入不规范:错别字、堆砌关键词、非标准自然语言;

- 多意图:输入的语句信息量太少造成意图不明确,且有歧义。比如输入仙剑奇侠传,那么是想获得游戏下载、电视剧、电影、音乐还是小说下载呢;

- 意图强度:输入的语句好像即属于A意图,又属于B意图,每个意图的的得分都不高;

- 时效性:用户的意图是有较强时效性的,用户在不同时间节点的相同的query可能是属于不同意图的,比如query为“战狼”,在当前时间节点可能是想在线观看战狼1或者战狼2,而如果是在战狼3开拍的时间节点搜的话,可能很大概率是想了解战狼3的一些相关新闻了。

填槽

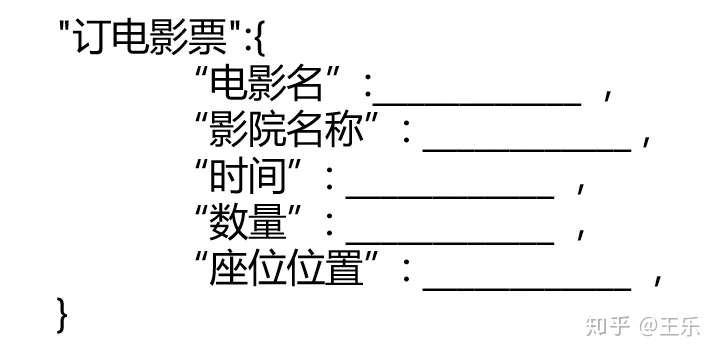

【定义】 填槽(Slot filling)定义:

- 一般定义:填槽指的是为了让用户意图转化为用户明确的指令而补全信息的过程。

- 专业定义:从大规模的语料库中抽取给定实体(query)的被明确定义的属性(slot types)的值(slot fillers)——网络文章定义

- 设定闹钟这个行为,需要两个关键信息,一个是行为,一个是时间。这两个信息可以理解为“设闹钟”行为的前置条件,就好像事有个槽空缺在那,需要先补充完整了这个槽,完成这个条件后,触发新的副本,才能继续后续的行为。

【用途】

- ①多用于任务型对话

- 任务型对话系统的语言理解部分,通常使用语义槽来表示用户的需求,如出发地、到达地、出发时间等信息。

- ②作为意图识别的关键字

- ③作为下一步对话的提示信息

- 填槽的意义有两个:作条件分支多轮对话、作信息补全用户意图。填槽不仅是补全用户意图的方式,而且前序槽位的填写还会起到指导后续信息补全走向的作用。图

【基本概念】

- 槽:实体已明确定义的属性,打车中的,出发地点槽,目的地槽,出发时间槽中的属性分别是“出发地点”、“目的地”和“出发时间”

- 槽位:槽是由槽位构成 图

- 槽位的属性

- 接口槽与词槽

- 词槽,通过用户对话的关键词获取信息的填槽方式

- 接口槽,通过其他方式获取信息的填槽方式

- 可默认填写/不可默认填写:有些槽是不可默认填写的,不填没办法继续下去,有些即使不填,有默认值也可。

- 槽位优先级:当有多个槽位的时候,槽该采用那个信息,这时候有个优先级。

- 澄清话术:当槽不可默认填写同时又没有填写的时候,就要进行澄清

- 澄清顺序:当有多个槽需要澄清的时候,就存在先后顺序的问题,所以需要一个澄清顺序,先问什么,再问什么。

- 平级槽或依赖槽,根据槽和槽之间是否独立,后续的槽是否依赖前面槽的结果。可以将槽之间的关系分为

- 平级槽,槽与槽之间没有依赖,例如打车中的三槽

- 依赖槽,后续的槽是否依赖前面槽的结果,例如手机号码槽,不同国家手机号码格式不同(槽的属性不同),所以国家槽会影响选择哪个手机号码槽。

- 接口槽与词槽

- 准入条件:从一个开放域转入到封闭域,或者从一个封闭域转入到另一个封闭域,中间的跳转是需要逻辑判断的,而这个逻辑判断就是准入条件。

- 封闭域对话:封闭域对话是指识别用户意图后,为了明确用户目的(或者称为明确任务细节)而进行的对话

- 澄清话术:当用户的需求中缺乏一些必要条件时,需要对话系统主动发问,把必要条件全部集齐之后再去做最终的满足执行。图

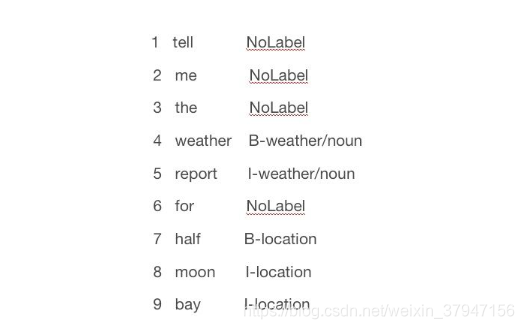

- BIO的解释

- “B-X”表示此元素所在的片段属于X类型并且此元素在此片段的开头。

- “I-X”表示此元素所在的片段属于X类型并且此元素在此片段的中间位置。

- “O”表示不属于任何类型。

- 注意:

- 没明确意图前的聊天可以看做是开放域的对话,开放域对话中也能填槽。

- 参考:Chatbot中的填槽(Slot Filling)

- 全过程示例解析(参考:大话知识图谱–意图识别和槽位填充)

- 用户:订一张今天下午场次的战狼电影票

- 系统:识别出“订电影票”的意图,于是开始操作订电影票的事了

- 系统:“您好,战狼2在XX影城于下午一点半上映,YY影城将在下午两点半上映;你需要去哪个电影院呢?”

- 用户:“去YY影城”

- 系统:“您好,您可以选择电影票张数和座位号完成预定”

- 针对性的“思考”是全靠槽位填充来实现

- 需要填的空包含了电影名、影院名称、时间、数量、座位位置等信息

- 系统是如何填空的呢?答案是命名实体识别和槽位预测

- 用户的输入“订一张今天下午场次的战狼电影票”,识别出电影名是“战狼”,时间是“今天下午”;没有识别到影院名称,于是张三根据用户当前的位置,将其预测为XX影院或YY影院,数量和座位位置就没办法预测。针对没办法预测的槽位,张三决定向用户发问或者提供选择来确认“您可以选择电影票张数和座位号完成预定”;对于预测到槽位值不唯一的情况,比如XX影院或YY影院,张三决定让用户自己进行二选一;对于识别到的槽位存在歧义的问题,张三决定进行“澄清”,比如战狼实体不是很明确,需要澄清是战狼1还是战狼2,张三根据现在正上映的是战狼2这一情况来进行自动澄清,但如果此时两部电影都在上映的话,张三就得向用户发问澄清了,比如问“您是想要看战狼1还是战狼2?”。

- 思考过程完全是按照语义槽来进行的,有什么槽位它就思考什么。当语义槽完全填充且消除了歧义之后,也就完成了整个自然语言理解任务,开始利用知识库回答用户问题或者完成某种操作。

- 语义槽到底是怎么来的呢?它是如何和用户进行“发问”交互的?

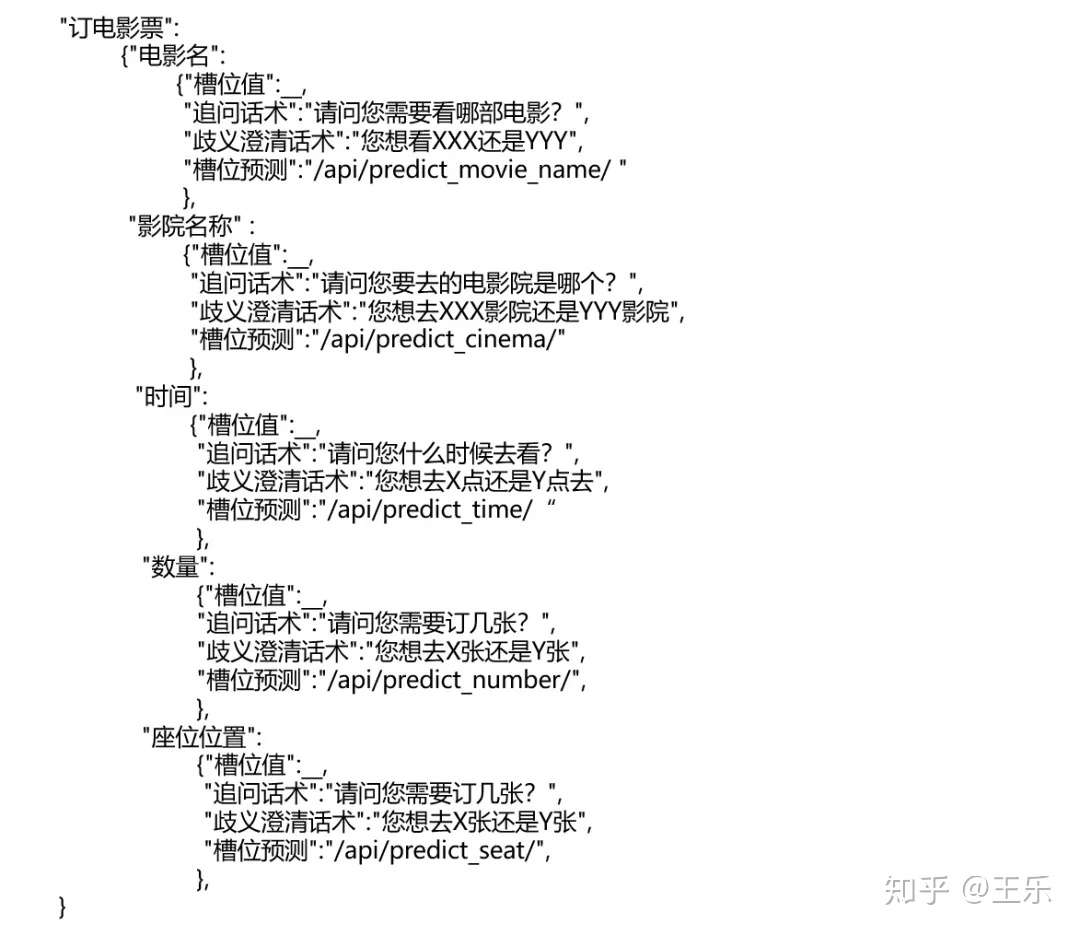

- 语义槽设计

- 语义槽定义升级:在语义槽的每个槽位加上相对应的“话术”,系统发现哪个槽位没填充或者有歧义就使用该槽位事先预定义好的话术去“发问”

- 实现方法

- 槽位填充包括命名实体识别和槽位预测,其实说命名实体识别不严谨

- 如在“订机票”意图下的语义槽中,应该有“出发地”和“目的地”,虽然他们都是地名,但是有区别,他们的顺序不能变,也就是不能用“地名”来统一代替,而命名实体识别的做法就是将他们都当做“地名”

- 只能称槽位填充是一个序列标注任务,但绝不能说序列标注任务就是命名实体识别,且我们在标注数据的时候也不能一样标注

- ①串行:将意图识别和槽位填充分开,依次进行

- ②并行:将意图识别和槽位填充进行联合训练模型

- 经典方法

- CRF: 条件随机场。通过设置各种特征函数来给序列打分。

- 深度方法

- ①RNN 槽填充

- ②RNN Encoder-Decoder 槽填充

- ③Bi-GRU + CRF

- ——A Joint Model of Intent Determination and Slot Filling for Spoken Language

- ④Attention-Based Recurrent Neural Network Models for Joint Intent Detection and Slot Filling (比较经典,论文是意图识别和槽填充共同训练)

- ⑤BERT Slot标注:代码

- 槽位填充包括命名实体识别和槽位预测,其实说命名实体识别不严谨

【2021-5-28】意图识别和槽填充是挂钩的吗?

- 二者区别

- 意图识别目的是识别用户对话内容的意图,本质上是一个分类任务.

- 槽位填充是将我们关心的实体识别出来,本质上是一个序列标注任务.

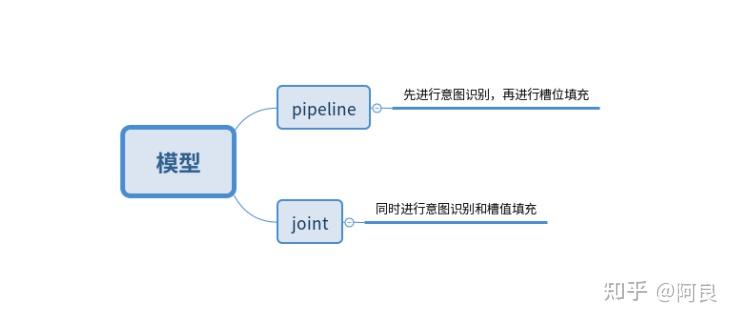

- 当前处理这种具有一定关系任务的两种思想:

- 一种是pipeline思想,先对意图识别,识别完意图之后再提取槽值 —— 简单,直观,普通人的思路

- 另一种是joint思想.两个任务同时做,还能做的更好 —— 大神的思路

- 尤其是在深度学习出现以后,基于joint模型的方法着实火了一把:文本的输入层和中间层保持一致,只需要在输出层加多个输出即可,这样就能共享输入和中间层的特征表示,再输出层进行魔性创新

中文数据集:CQUD

简介

意图识别/意图分类(Intent Classification)和槽位填充 (Slot Filling) 是自然语言理解 (Natural Language Understanding, NLU)领域中的两个比较重要的任务。在聊天机器人、智能语音助手等方面有着广泛的应用。

意图识别可以看作一个分类任务,就是对当前输入的句子进行分类,得到其具体意图,然后完成后续的处理。而槽位填充则是一个序列标注问题,是在得到意图之后,再对句子的每一个词进行标注,标注的格式为BIO格式,将每个元素标注为“B-X”、“I-X”或者“O”。

- “B-X”表示此元素所在的片段属于X类型并且此元素在此片段的开头

- “I-X”表示此元素所在的片段属于X类型并且此元素在此片段的中间位置

- “O”表示不属于任何类型。

比如tell me the weather report for half moon bay这句话中,它的意图类别为weather/find(查询天气),slot filling的结果为:

对话语料

【2020-9-12】百度王凡:开放域对话系统:现状和未来

- 对话语料,往往充斥着已知和未知的背景信息,使得对话成为一个”一对多“的问题,而神经网络模型解决的是一一映射,最大似然只能学到所有语料的共通点,所有背景、独特语境都可能被模型认为是噪音,最终形成大量安全回复;对话语料中潜藏着很多个人属性、生活常识、知识背景、价值观/态度、对话场景、情绪装填、意图等信息,这些潜藏的信息没有出现在语料,建模它们是十分困难的。

- 百度NLP:做有知识、可控的对话生成方案:围绕多样性对话生成、知识对话生成、自动化评价和对话流控制、大规模和超大规模隐空间对话生成模型4个模块展开。

- 对话生成问题是一个条件非常非常多的条件生成问题(conditional generation)

- 多样性对话生成:

- ① 多映射机制的端到端生成模型:假设每一句回复可能来自于一个独特的映射机制 ( Mapping mechanism ),用M1到M4表示。如果给定某种映射机制,就可确定最终的回复,消除了回复过程中的不确定性。

- ② 类似工作也有很多,不过都存在一些弊端。比如CVAE用了连续的高斯空间,对于对话多样性捕捉能力非常差;而MHAM和MARM没有对先验和后验的分布差异进行有效的建模。如一句上文可能对应4种不同的回复,且都是合理的,而训练时只出现一种,推断时就无法捕捉另外几种映射逻辑。推断和训练时对映射机制的选择是存在差异的,这会导致优化的过程乱掉。

- 创新:一时采用离散的映射机制,二是分离了先验和后验的推断。除了用NLLLoss ( negative log likelihood loss ) 外,还用了一个matching loss,这个loss的目标是为了辅助整个后验选择网络的训练,特别是Response encoder这一块。在推断时模型结构有部分差异,因为在推断时是没有Response的,这时我们就任意选择一个Map来生成回复。图

- 知识对话生成

- 通过知识引入有助于对话”去模糊”、”可控制”. 选择知识库的部分来用,所以常规做法是引入attention来进行知识的选择

- 自动化评价和对话流控制

- ①

自进化对话系统( SEEDS ):监督学习只能考虑当前一轮的回复,当不同Agent在进行交流时会发现很多问题,原因是因为在数据中没有见过这些信息。那能否考虑利用长远的反馈信息来提升对话的控制?多样化生成理论,包含两部分。一部分是Diversified Generation,根据特定知识或隐空间生成回复的过程;另一部分是Dialogue “Controller”,怎么去选择知识或者隐空间而不是仅仅依赖于Prior?我们通过强化学习来提升选择知识或者隐变量的能力。 - ②

自动化的对话评价体系:从连贯性、信息量、逻辑等角度用一系列模型去评价这些对话,使用无监督语料训练出来

- ①

- 大规模和超大规模隐空间对话生成模型

- NLP模型发展趋势

- 使用隐空间的对话模型PLATO,基于前面提到的隐空间的机制,来使得Transformer模型生成的对话丰富度要更丰富。PLATO模型总共由三个模块组成,Generation ( 利用隐变量控制生成 )、Recognition ( 隐变量识别 ) 和Prior ( 隐变量推导 )。而我们6月份提出的PLATO2的一个相对PLATO的改进则是没有使用Prior模块,因为实验发现用一个Retrieval模块来代替Prior模块效果会更好。PLATO2有两个训练阶段:一个叫Coarse-Grained Generation,即先训练一个基础版网络,没有用隐变量。之后基于这个网络我们再进一步训练,叫做Fine-Grained Generation,引入隐变量等信息。训练时用到了三个Loss

未来解决对话问题的要素可以从以下方面入手:

- 语料 & 知识, 这是训练任何模型的基础

- 记忆 & Few-shot Learning, 人类是能够在对话中不断学习的,一个好的对话系统需要具有这种能力

- 虚拟环境 & Self-Play, 当前很多语料不能提供足够背景知识的前提下,虚拟环境能很好地提供这一点

平行语料

- 联合国平行语料

- 爱数智慧提供平行语料: 智能翻译技术训练数据——平行语料

【2022-12-4】什么是平行语料?

平行语料库的定义,一直存在分歧。

- Stig Johansson(1998)认为:平行语料库是收录具有可比关系的两种语言文本的语料库。

- 不过,Mona Baker(1995)则主张:平行语料库收录的文本是A语言文本及其B语言译本。

较之于前者,后者更为学界接受。

- 目前,学界普遍认为:平行语料库是指收录某一源语语言文本及其对应的目的语文本的语料库,不同语言的文本之间构成不同层次的平行对应关系。

- 王克非(2004a)指出:平行语料库是由源语语言文本及其平行对应的译语文本构成的双语语料库。

根据语料所涉及语种的数量,平行语料库可分成双语平行语料库(bilingual parallel corpus)和多语平行语料库(multilingual parallel corpus)。

双语平行语料库由构成翻译或对应关系的两种语言文本组成多语平行语料库则收录一种语言文本和该文本的两种以上语言的译本。

按照语料平行对应的方向,平行语料库可分为单向平行语料库(unidirectional parallel corpus)、双向平行语料库(bidirectional parallel corpus)和多向平行语料库(multidirecitonal parallel corpus)。

单向平行语料库是指所收录语料均为一种语言的源语文本及其译成另一种语言的目的语文本。双向平行语料库所收录的语料由A语言文本和其B语言译本,以及B语言和其A语言译本组成。多向平行语料库收录的语料为一种语言的源语文本和译自该文本的两种或两种以上语言的目的语文本。

NLU 数据集

意图分类和槽位填充任务主要数据集Snips、ATIS和NLU-Benchmark

ATIS

数据集信息:航空旅行领域的语料,上个世纪发布的数据,是对话领域常用的数据集。

-

数据源 ATIS

- 该数据集规模很小,训练集4400+,测试集800+,槽位意图识别难度不大,目前处于被刷爆的程度,intent detection和slot filling任务的F值都已经在95+以上了,唯一可以挑战的是NLU的Acc,也称为Sentence Acc,即输入句子的意图、槽位同时正确才算该样本预测正确。目前的SOTA为Bert,具体可上paper-with-code网站搜索

- 当前的SOTA:

ATIS数据集是一个比较常规的NLU数据集,它是一个标注过的预定机票的样本。分为训练集,开发集和测试集,训练集和开发集包括4,478,500样本,测试集包括893 utterances样本。训练集包含21种意图,79种实体。

SNIPS

SNIPS数据集,该数据集是从Snips个人语音助手收集的。它包含13,784个训练样本和700个测试样本。包含7种意图,39种实体。

NLU-Benchmark

NLU-Benchmark数据集标注了场景,动作和实体。例如:

- ”schedule a call with Lisa on Monday morning“ ,标注的场景是日历calendar, 动作action是设立一个事件event,实体有2个,是事件名字和日期 [event name: a call with Lisa]和 [date: Monday morning], 意图标签是通过拼接场景和动作得到的,例如:calendar set event。

该数据集有25716个utterrances语句,涵盖了多个家庭助理任务,例如播放音乐或日历查询,聊天,以及向机器人发出的命令等。数据集拆分成10 folds, 每个fold有9960个训练样本和1076个测试样本,覆盖了64种意图和54种实体类别。

CQUD

- 无

中文聊天语料

开源中文聊天语料的搜集和系统化整理工作,8个公开闲聊常用语料和短信,白鹭时代问答等语料

- chatterbot

- 豆瓣多轮

- PTT八卦语料

- 青云语料

- 电视剧对白语料

- 贴吧论坛回帖语料

- 微博语料

- 小黄鸡语料

| 语料名称 | 语料数量 | 语料来源说明 | 语料特点 | 语料样例 | 是否已分词 |

|---|---|---|---|---|---|

| chatterbot | 560 | 开源项目 | 按类型分类,质量较高 | Q:你会开心的 A:幸福不是真正的可预测的情绪。 | 否 |

| douban(豆瓣多轮) | 352W | 来自北航和微软的paper, 开源项目 | 噪音相对较少,原本是多轮(平均7.6轮) | Q:烟台 十一 哪 好玩 A:哪 都 好玩 · · · · | 是 |

| ptt(PTT八卦语料) | 77W(v1版本42W) | 开源项目,台湾PTT论坛八卦版 | 繁体,语料较生活化,有噪音 | Q:为什么乡民总是欺负国高中生呢QQ A:如果以为选好科系就会变成比尔盖兹那不如退学吧 | 否 |

| qingyun(青云语料) | 10W | 某聊天机器人交流群 | 相对不错,生活化 | Q:看来你很爱钱 A:噢是吗?那么你也差不多了 | 否 |

| subtitle(电视剧对白语料) | 274W | 开源项目,来自爬取的电影和美剧的字幕 | 有一些噪音,对白不一定是严谨的对话,原本是多轮(平均5.3轮) | Q:京戏里头的人都是不自由的 A:他们让人拿笼子给套起来了了 | 否 |

| tieba(贴吧论坛回帖语料) | 232W | 偶然找到的 | 多轮,有噪音 | Q:前排,鲁迷们都起床了吧 A:标题说助攻,但是看了那球,真是活生生的讽刺了 | 否 |

| weibo(微博语料) | 443W | 来自华为的paper | 仍有一些噪音 | Q:北京的小纯洁们,周日见。#硬汉摆拍清纯照# A:嗷嗷大湿的左手在干嘛,看着小纯洁撸么。 | 否 |

| xiaohuangji(小黄鸡语料) | 45W | 原人人网项目语料 | 有一些不雅对话,少量噪音 | Q:你谈过恋爱么 A:谈过,哎,别提了,伤心..。 | 否 |

CCF

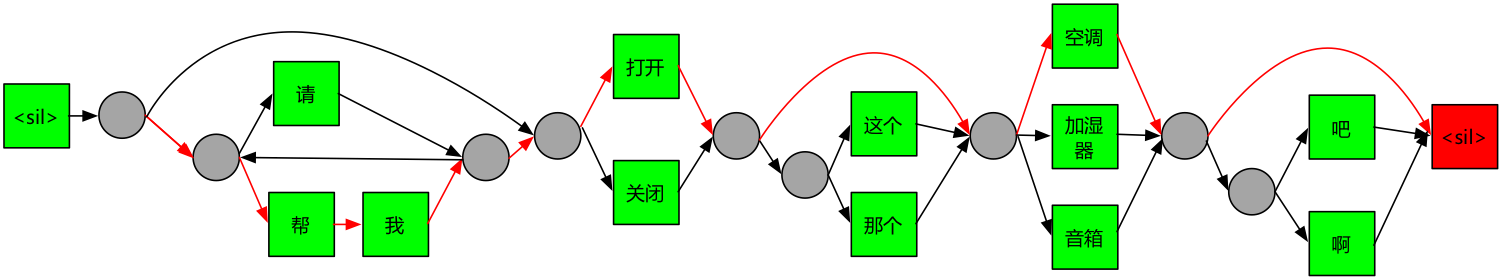

2021年 CCF+中移动 主办的 智能人机交互自然语言理解 智能家居控制 NLU数据集

- 数据集包含用户与音箱等智能设备进行单轮对话文本数据,包含共 11个 意图类别,共计约47个槽位类型。

- train.json 为训练数据,共约 9100条,其文本由ASR语音识别技术转写得到,因此可能需要进一步处理,文本标注包含用户意图、槽位及槽值三个字段

- ccf-2021-iot

交互方式上,“手势交互”,“语音交互”,“AR交互”等新兴交互方式开始出现在公众的视野中,但由于交互效率和人体工学等方面的限制,手势交互等方法短期内较难成为主流的人机交互方式,而搭载了语音交互能力的产品自落地应用起就一直受到极为广泛的关注。在交互手段方面,用户仅需要通过与相关产品对话即可下达命令、完成播放音乐、控制家居等任务,能够真正意义上解放双手,提升生活幸福指数。但在实际应用中,相关产品往往很难满足用户的各类别复杂要求,其根源在于自然语言本身较高的复杂性使得用户意图无法被较好的理解。自然语言理解(NLU ,Natural Language Understanding)任务旨在让计算机具备理解用户语言的能力,从而进行下一步决策或完成交互动作,是具备语音交互能力的产品需要处理的重要任务。

赛题任务:根据用户与系统的单轮对话,识别对话用户意图并进行槽位填充。

除基础的意图识别及槽位填充任务外,本赛题额外包括2个子任务:

- 人机交互-NLU-1(小样本学习任务):根据基础意图类别数据及少量含标注的新意图类别样本,完成新意图类别的识别及槽位填充任务。

- 人机交互-NLU-2(域外意图检测任务):除识别出训练数据中已知的意图类别外,对于未知意图类别数据进行检测。

意图分布

- Alarm-Update 1000

- Audio-Play 50

- Calendar-Query 1000

- FilmTele-Play 1000

- HomeAppliance-Control 1000

- Music-Play 1000

- Radio-Listen 1000

- TVProgram-Play 50

- Travel-Query 1000

- Video-Play 1000

- Weather-Query 1000

意图与槽位信息

{

"FilmTele-Play": ["name", "tag", "artist", "region", "play_setting", "age"],

"Audio-Play": ["language", "artist", "tag", "name", "play_setting"],

"Radio-Listen": ["name", "channel", "frequency", "artist"],

"TVProgram-Play": ["name", "channel", "datetime_date", "datetime_time"],

"Travel-Query": ["query_type", "datetime_date", "departure", "destination", "datetime_time"],

"Music-Play": ["language", "artist", "album", "instrument", "song", "play_mode", "age"],

"HomeAppliance-Control": ["command", "appliance", "details"],

"Calendar-Query": ["datetime_date"],

"Alarm-Update": ["notes", "datetime_date", "datetime_time"],

"Video-Play": ["name", "datetime_date", "region", "datetime_time"],

"Weather-Query": ["datetime_date", "type", "city", "index", "datetime_time"],

"Other": []

}

数据示例

"NLU09095": {

"text": "播放周深的英文歌",

"intent": "Music-Play",

"slots": {

"artist": "周深",

"language": "英语"

}

},

"NLU09096": {

"text": "我想知道开原今天是不是要多加衣物防寒保暖。",

"intent": "Weather-Query",

"slots": {

"city": "开原",

"datetime_date": "今天",

"index": "穿衣指数"

}

}

更多数据分析可视化

获奖方案

Smart Home Assisstant

智能锁视频、图像指令识别

DM 数据集

数据集汇总

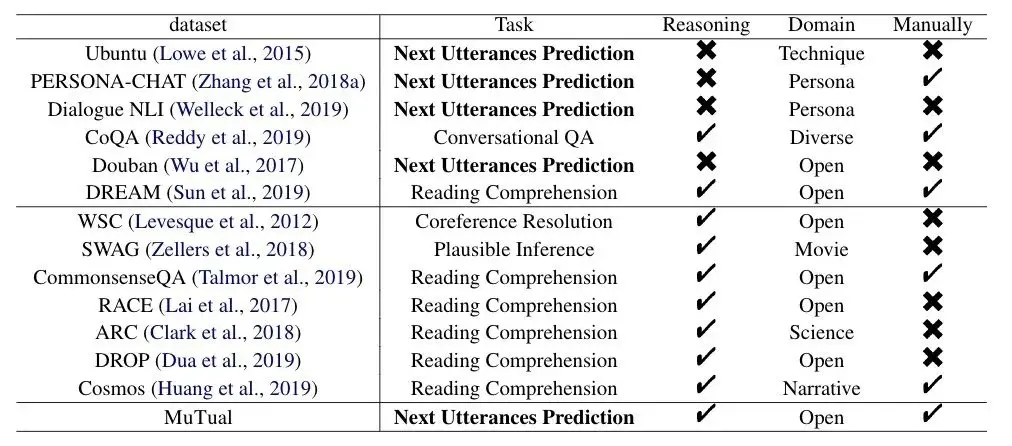

检索式对话数据集 —— 相关性

检索式对话数据集,诸如 Ubuntu、Douban,对于给定的多轮对话,需要模型在若干候选回复中,选出最合适的句子作为对话的回复。

然而这些数据集主要关注模型能否选出相关性较好的回复,并不直接考察模型的推理能力。随着 BERT 等预训练模型的涌现,模型在此类数据集上已经达到了很好的效果。

推理式数据集 —— 推理

已有的针对推理的数据集(DROP、CommonsenseQA、ARC、Cosmos等)大多被设计为阅读理解格式。它们需要模型在阅读文章后回答额外问题。由于任务不同,这些现有的推理数据集并不能直接帮助指导训练聊天机器人。

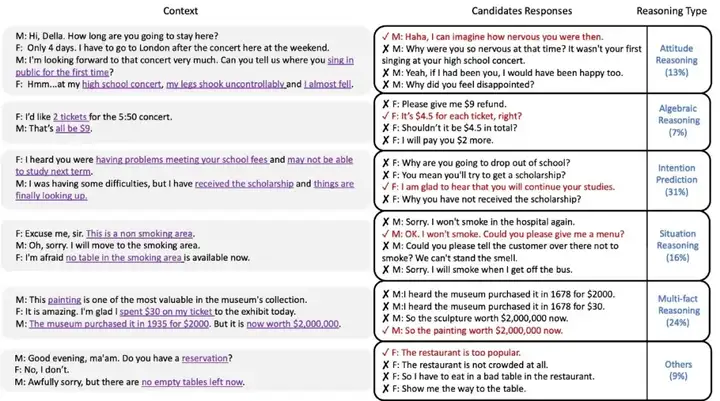

MuTual 微软 —— 高考英语听力

多轮对话推理数据集MuTual发布,聊天机器人常识推理能力大挑战

- 论文, MuTual github,leaderboard

- 在构建聊天机器人时,现有对话模型的回复往往相关性较好,但经常出现常识和逻辑错误。由于现有的大部分检索式对话数据集都没有关注到对话的逻辑问题,导致评价指标也无法直接反映模型对对话逻辑的掌握程度。

- 对此,微软亚洲研究院发布了多轮对话推理数据集 MuTual,针对性地评测模型在多轮对话中的推理能力。

- 相比现有的其他检索式聊天数据集,MuTual 要求对话模型具备常识推理能力;

- 相比阅读理解式的推理数据集,MuTual 的输入输出则完全符合标准检索式聊天机器人的流程。 因此,MuTual 也是目前最具挑战性的对话式数据集。测试过多个基线模型后,RoBERTa-base 表现仅为70分左右。目前已有多个知名院校和企业研究部门进行了提交,最优模型可以达到87分左右,仍与人类表现有一定差距。

MuTual 基于中国高考英语听力题改编。听力考试要求学生根据一段双人多轮对话,回答额外提出的问题(图1左),并通过学生能否正确答对问题衡量学生是否理解了对话内容。为了更自然的模拟开放领域对话,我们进一步将听力题中额外的问题转化为对话中的回复

- 所有的回复都与上下文相关,但其中只有一个是逻辑正确的。一些错误的回复在极端情况下可能是合理的,但正确的回复是最合适的。

MuTual 数据集主要包含聊天机器人需要的六种推理能力:

- 态度推理(13%)

- 数值推理(7%)

- 意图预测(31%)

- 多事实推理(24%)

- 常识等其他推理类型(9%)。

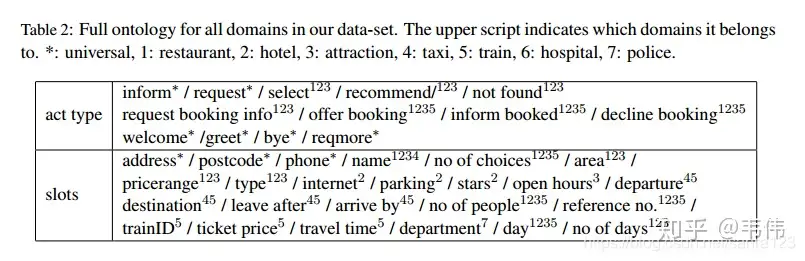

MultiWOZ

【2023-10-21】一文白话跨领域任务型对话系统:MultiWOZ数据集!

MultiWOZ 全称 Multi-domain Wizard-Of-Oz

- MultiWOZ - A Large-Scale Multi-Domain Wizard-of-Oz Dataset for Task-Oriented Dialogue Modelling

- Wizard-Of-Oz(绿野仙踪)是一个过程,允许用户与一个界面互动,这个用户被骗了,认为界面的对面是机器,而事实上在幕后有一个人在进行回复……

- 这个方法是一个比较宏观的建立数据集的思路,能够提升数据集的可信度。

multi-domain 数据集跨越多个领域(domain),MultiWOZ属于任务型对话系统,也就是为了完成一项任务。

MultiWOZ是一个完全标记的人与人之间的书面对话集合。三个关键词:

- 完全标记(每一个round都有标记)

- 人与人(没有任何机器生成的回复,因此属于full-manual dataset)

- 书面(形式比较像一个管家和雇主的对话,而不是随意的聊天,可以自己看下数据集文件,有明确的任务感)。

但是,其实这个数据集最大的亮点是多领域,在这之前的多领域数据集都小的离谱,大的都是单领域的。

MultiWOZ直接提供了三个Benchmark 用来衡量模型的好坏:

- Dialog State Tracking(或者叫做Belief Tracking)

- Act2Text

- Context2Act

这三个benchmark几乎涵盖了多轮会话的所有版块

- NLU+DST:归纳上文,跟踪记录对话状态

- Context2Text:根据上文生成文本

- Act2Text:根据系统推理出的行为生成文本

- 主要目标:旅游城市的信息中心获取旅游者查询的高度自然对话

- Domain:Attraction, Hospital, Police, Hotel, Restaurant, Taxi, Train,其中后四个域属于扩展域,包括子任务Booking。每段对话涉及1-5个领域,因此长度和复杂性差别很大。全部的act和slot如下:

- 数量及分布:10438个对话,其中3406个单领域对话,7032个多领域对话,多领域中,包含最少2-5个领域。70%的对话超过10个回合,其中单领域平均轮数为8.93,多领域为15.39。在数据里,对话的序号前面是SNG就是单轮,MUL就是单轮。

- 数据结构:每个对话包含a goal,multiple user,system utterances,belief state,dialogue acts and slots。

- Belief state:有三个部分,分别是semi、book、booked。其中semi是特定领域里的槽值;book在特定领域的booking slots;booked是book的一个子集,在book这个字典里,是booked entity(一旦预定生成)

DSTC

DSTC大家族(简介):

- DSTC 1 : (人机对话)公交线路查询,目标固定不变。

- 共5个slot(路线,出发点,重点,日期,时间),有些slot(时间和日期)的取值数量不固定。而且DSTC1的用户目标在对话过程中不会发生变化。dialog-state-tracking-challenge

- DSTC 2/3 :(人机对话)餐馆预订,用户查询满足特定条件下的餐馆的某些信息(电话、地址等)。

- 2 用户目标会在对话过程中发生变化

- 例如,一开始用户想订中国餐馆,结果最后改为订印度餐馆,这也从某种程度上增加了对话的复杂度。

- DSTC2 对话状态表示上更加丰富,不仅包含用户目标的槽值对,还包括查找方法以及还有哪些信息用户希望系统可以返回到他。每一轮对话包含三个元素:

informable slot:使用informable slot来对用户目标进行限制,比如用户想要便宜、西边的餐厅等等。requested slot:这个slot是一些信息层面的东西,是用户可以索取索要的,比如说,餐厅地址、电话告诉我等等。search method:用户可以有不同的方法让系统帮忙查询,例如用户有哪些限制,可以在限制内查询;或者用户要求系统更换一个选项;或者用户通过具体的名字直接查询等等。

- 输入/输出:每一轮的输入是SLU的结果,也就是N-BEST的SLU结果的概率分布,输出有三个分布,分别是goal constraints目标限制、requested slot请求槽、search method搜索方法

- 训练数据 1612个,验证集 506个,测试集 1117个

- 3在2的基础上新增了一些slot。而且添加了新领域(旅游信息查询),且只有很少的训练数据,目的就是为了尝试领域迁移。

- dstc

- 2 用户目标会在对话过程中发生变化

- DSTC 4 :(人人对话)旅游信息查询

- DSTC 5 :(人人对话)旅游信息查询,与4的区别在于,训练数据和测试数据用的是不同语言。

- DSTC 6 :由三部分组成,分别是

- End-to-End Goal Oriented Dialog Learning 端到端目标导向对话学习

- End-to-End Conversation Modeling 端到端对话建模

- Dialogue Breakdown Detection 对话终端检测。

- dstc6

- DSTC 7-9 :暂时还没有了解过。

详见:任务型对话系统数据集详解大全(MultiWOZ /DSTC)

模型

- 【2021-8-23】Joint Model (Intent+Slot) 2018年提出的《BERT for Joint Intent Classification and Slot Filling》提出了使用BERT进行文本意图分类和槽位填充的任务,其结果达到了最好的成绩。

| 模型 | 改进点 | 效果 | 其它 |

|---|---|---|---|

| 2018,JointBERT | 联合训练 | snips:98.6(intent),97(slot),92.8(sent); atis:97.5(intent),96.1(slot),88.w(sent); | Joint BERT+CRF不如Joint BERT;github |

| 2018, Slot-Gated | 加gate | 不如Joint BERT | github |

| 双向GRU+CRF | 改进点 | atis:98.32(intent),96.89(slot); | 其它 |

| 2014,RecNN+Viterbi | 语义树构建路径特征 | atis:95.4(intent),93.69(slot); | 其它 |

| 2013,CNN+Tri-CRF | 改进点 | atis:94.14(intent),95.62(slot); | 其它 |

从目前的趋势来看,大体上有两大类方法:

- 多任务学习:按Multi-Task Learning的套路,在学习时最终的loss等于两个任务的loss的weight sum,两者在模型架构上仍然完全独立,或者仅共享特征编码器。

- 交互式模型:将模型中Slot和Intent的隐层表示进行交互,引入更强的归纳偏置,最近的研究显示,这种方法的联合NLU准确率更高。

JointBert——2018年

- JointBERT的pytorch实现:JointBERT

- JointBERT的TensorFlow实现:dialog-nlu

- JointBERT的transformers+TensorFlow实现

参考:Intent Detection and Slot Filling(更新中。。。)

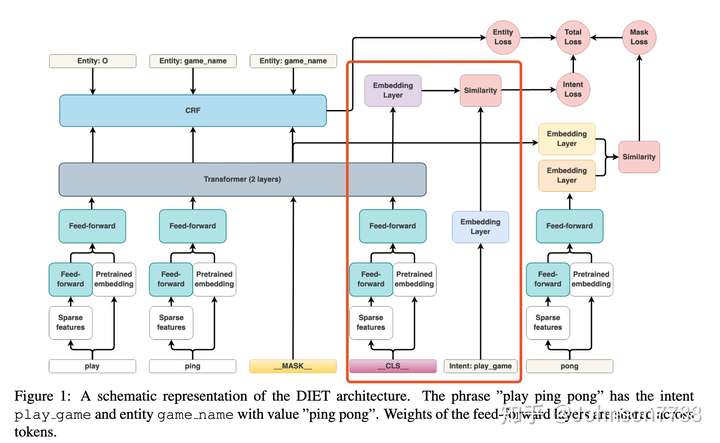

DIET(RASA)——2020年5月

【2021-10-19】DIET模型 rasa 聊天机器人核心模型论文,原文:Introducing DIET: state-of-the-art architecture that outperforms fine-tuning BERT and is 6X faster to train

- With Rasa 1.8, our research team is releasing a new state-of-the-art lightweight, multitask transformer architecture for NLU: Dual Intent and Entity Transformer (DIET).

- 【2023-5】DIET源码开源

DIET模型是Dual Intent and Entity Transformer的简称, 解决了对话理解问题中的2个问题(意图分类和实体识别)。DIET使用纯监督方式,没有任何预训练的情况下,无须大规模预训练是关键,性能好于fine-tuning Bert, 但是训练速度是bert的6倍。

对话建模的2种常用方法:端到端 和 模块化系统

- 模块化系统:如POMDP的对话策略(Williams and Young,2007)和 混合代码网络 (Williams et al., 2017) 会使用独立的自然语言理解(NLU)和生成(NLG)系统。对话策略会从NLU接收输出并选择下一个action,然后NLG生成相应的响应。

- 端到端方法中,用户输入直接喂给对话策略以预测下一个utterance(语句),最新的方法是合并这2种常用方法, Fusion Networks (Mehri et al., 2019)。

对话系统中的自然语言理解的2个任务是意图分类和实体识别, Goo et al认为单独的训练这2个task会导致错误传播,其效果不如2个任务同时使用一个模型,2个任务的效果会相互加强。

最近研究表明大型的预训练模型在自然语言理解上性能很好,但是在训练和微调阶段都需要大量的计算性能。

DIET模型的关键功能是能够将预训练模型的得到的词向量,和可自由组合的稀疏的单词特征和n-gram特征结合起来, 在DIET代码中,这2个是dense-feature 和sparse-feature特征。

(1)通过迁移学习获取dense representations 稠密向量

- 一般使用ELMO,BERT,GPT等模型作为迁移学习的模型,然后使用或不使用fine-tuning获取向量,用于下一个模型,但是这些模型速度慢,训练成本高,不太适合现实的AI对话系统。

- Hen-derson et al. (2019b) 提出了一个更简洁的模型,使用单词和句子级别的encoding进行预训练,比BERT和ELMO效果要好,DIET模型是对此进一步研究。

联合的意图分类和命名实体识别

- Zhang and Wang (2016) 提出了一种由双向门控递归单元(BiGRU)组成的联合架构。每个时间步的隐藏状态用于实体标记,最后时间步的隐藏状态用于意图分类。

- Liuand Lane (2016); Varghese et al. (2020) and Gooet al. (2018) )提出了一种基于注意力的双向长期短期记忆(BiLSTM),用于联合意图分类和NER。

- Haihong et al.(2019) 引入了一个共同关注网络,用于每个任务之间共享信息。

- Chenet al. (2019)提出了联合BERT,该BERT建立在BERT之上,并以端到端的方式进行训练。他们用第一个(CLS)的隐藏状态进行意图分类。使用其他token的最终隐藏状态来预测实体标签。

- Vanzo(2019)提出了一种由BiLSTM单元组成的分层自下而上的体系结构,以捕获语义框架的表示形式。他们从以自下而上的方式堆叠的各个层学习的表示形式,预测对话行为,意图和实体标签。 DIET采用transformer-based 框架,使用的多任务像形式,此外我们还进行了消融测试。

架构图,意图是play_game, 实体是ping pong,FFW是共享权重的。

Featurization 特征

输入特征分为2部分,稠密特征 dense features和稀疏特征sparse features。

- 稀疏特征是n-grams(n<=5)的one-hot 或者multi-hot编码,但是稀疏特征包含很多冗余特征,为了避免过拟合,我们对此加入了dropout。

- 稠密特征来自预训练模型, 例如Bert或GloVe。

使用ConveRT作为句子的编码器,ConveRT的_CLS向量作为DIET的初始输入。这就是作为单词信息之外的句子信息特征了。如果使用BERT,我们使用 BERT [ CLS] token, 对于GloVe,我们使用句子所有token的均值作为_CLS_,

稀疏特征通过一个全连接计算,其中全连接的权重是和其它序列的时间步全连接共享的,目的是为了让稀疏特征的维度和稠密特征的维度一致, 然后将稀疏特征的FFW的输出和稠密特征的向量进行concat拼接,因为transformer要求输入的向量维度需要一致,因此我们在拼接后面再接一个FFW,FFW的权重也是共享的。在实验中,这一层的维度是256.

transformer模块,使用2层layer,使用token的相对位置编码。

Intent classification 意图分类

意图分类就是CLS经过transformers的输出,然后后意图标签y向量化后计算相似度, 这里计算损失是用的dot-product loss,点积损失,使得这个相似度和真实意图的相似性最高,使用负采样计算与其它意图的相似性降低。

Named entity recognition 命名实体识别部分

实体识别分类标签y是根据条件随机场Conditional Random Field (CRF) 计算的,是用的transformer的输出的向量,注意根据输出向量可以找到对应的输入token位置。

详见站内专题: diet实现

任务型对话

- 非任务型对话系统,如开放域的闲聊,常见方法:

- ① 基于生成方法,例如序列到序列模型(seq2seq),在对话过程中产生合适的回复,生成型聊天机器人目前是研究界的一个热点,和检索型聊天机器人不同的是,它可以生成一种全新的回复,因此相对更为灵活,但它也有自身的缺点,比如有时候会出现语法错误,或者生成一些没有意义的回复。

- ② 基于检索的方法,从事先定义好的索引中进行搜索,学习从当前对话中选择回复。检索型方法的缺点在于它过于依赖数据质量,如果选用的数据质量欠佳,那就很有可能前功尽弃。

- 任务导向型对话系统旨在通过分析对话内容提取用户任务,并且帮助用户完成实际具体的任务

- 任务型对话的处理方式有

pipeline和端到端两种结构- pipeline(管道式):定义了数个模块,以一条line的形式串联起来共同完成一个任务,如下图所示。

- 端到端:代表为memory network

- 【2021-1-28】智能对话系统和算法

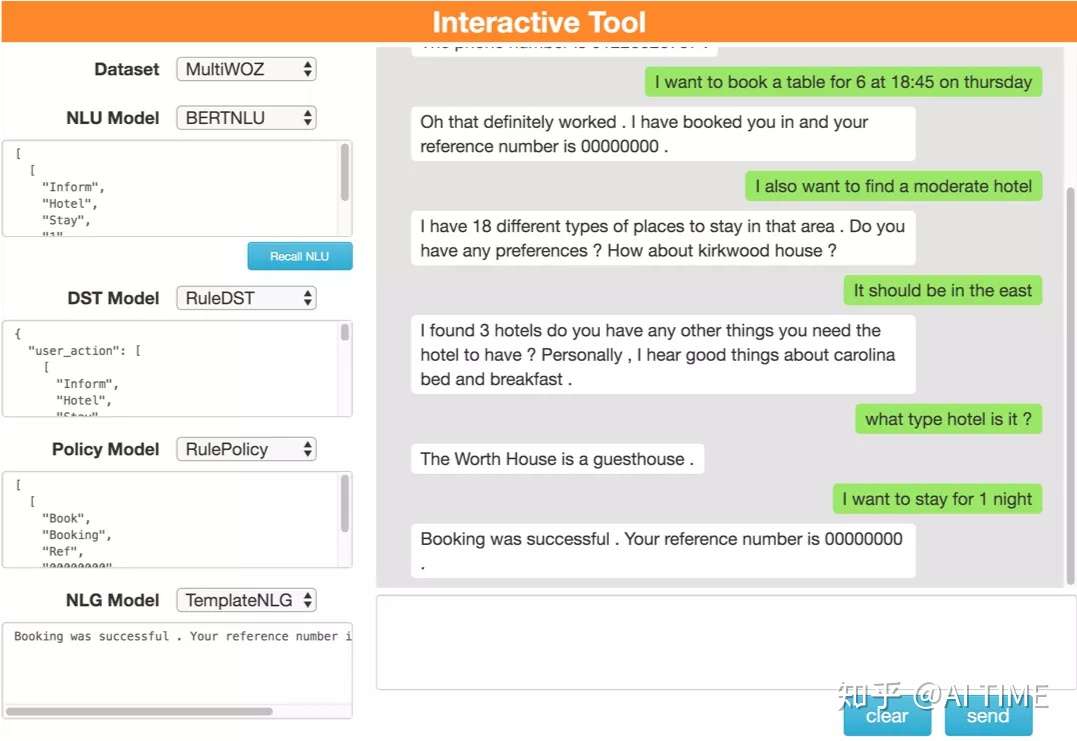

(1)Pipeline

pipline模块

其核心模块组成是NLU->DM->NLG

- (1)NLU负责对用户输入进行理解,随后进入DM模块,负责系统状态的追踪以及对话策略的学习,控制系统的下一步动作,而NLG则配合系统将要采取的动作生成合适的对话反馈给用户。

- 其中若用户的输入是语音形式,则在NLU的输入前需再添加一个ASR语音识别模块,负责将语音信号转换为文本信号。

- (2)

DM对话管理器内部又可分为DST(对话状态追踪)和DPL(对话策略学习),DST(对话状态追踪)根据用户每一轮的输入更新当前的系统状态,而DPL则根据当前的系统状态决定下一步采取何种动作。 - (3)

NLG将语言生成后,若用户采用语音交互方式,则还需要TTS(语音合成)模块将文本转换为语音。

pipline工作原理直观理解

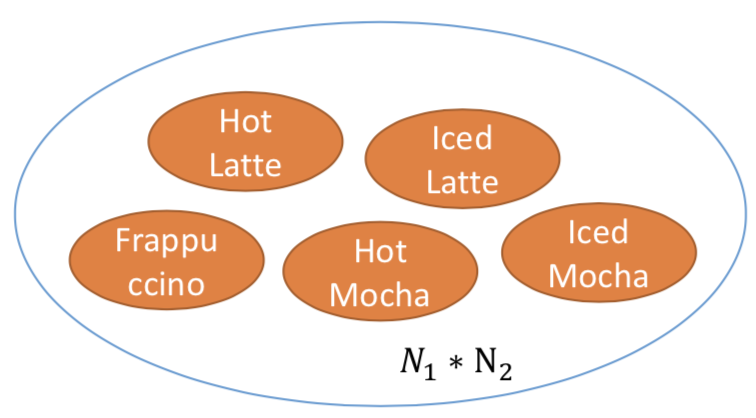

ASR:这部分任务比较单一,只负责将语音转换为文本信号。不过,有些论文提起ASR的输入并不是唯一的,因为语音识别可能会存在一定错误,因此一般会输出多个可能的句子,每个句子同时附带一个置信度,表示这个句子正确的概率。这种方式在论文中被称为N-best,及前N个最有可能的句子。NLU:语言理解模块,用户语音转文本后称为用户Utterance,NLU负责对用户Utterance进行领域/意图分类及槽值对填充。- 领域和意图分类是为了让系统明白用户的对话所处领域及意图,方便后续调用相应的model去识别(并不是一个model跑遍所有的领域意图,就好像树一样,根据领域/意图的分类,在树中找到对应的model。当然model结构可能是一样的,不同的是训练采用的数据是对应领域/意图的)。

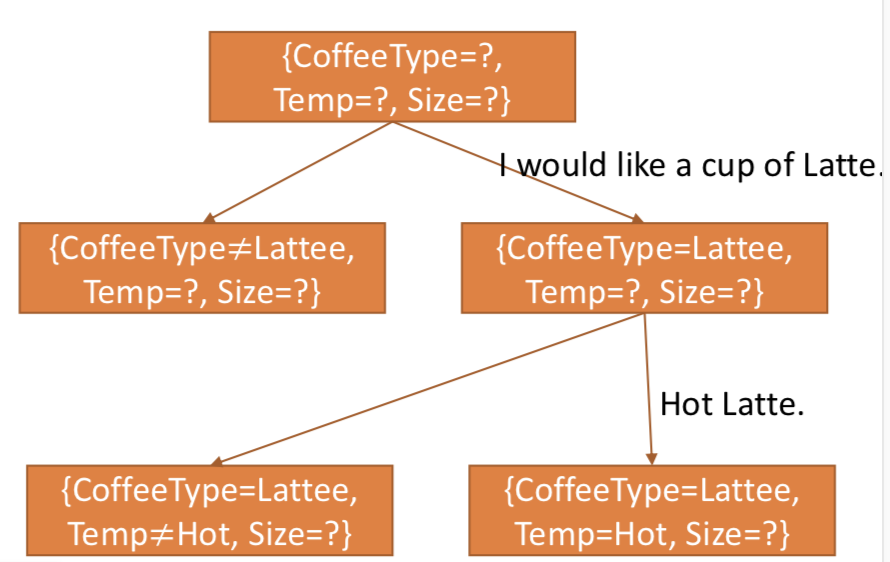

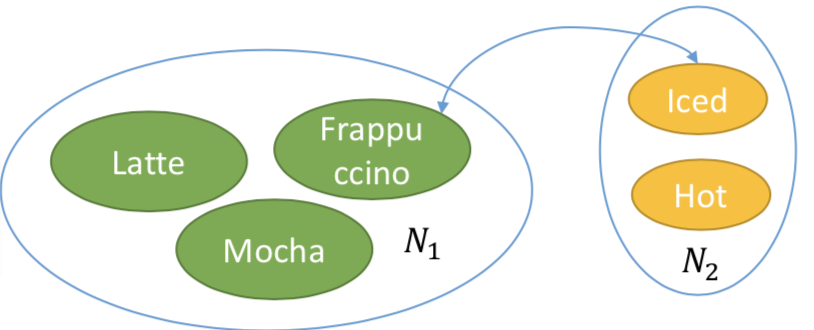

- 完成一个任务需要去弄清楚一些条件,比如说点一杯咖啡,根据领域/意图分类,系统判断用户的意图是点咖啡,此时系统需要弄明白是什么咖啡,甜度怎么样等等。所以会检索点咖啡所需要的槽值对,这时后台检索发现完成这个任务需要弄明白{咖啡类型=?,甜度=?}(其中咖啡类型和甜度被称为