- 机器学习总结

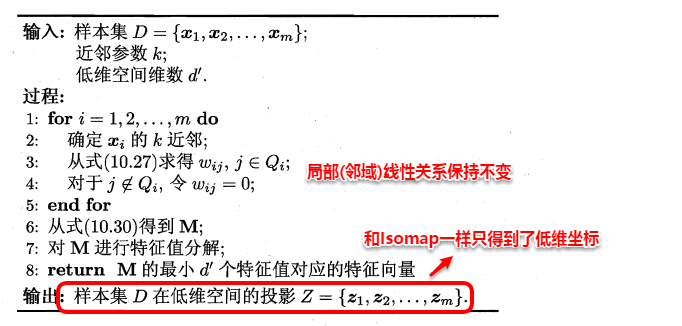

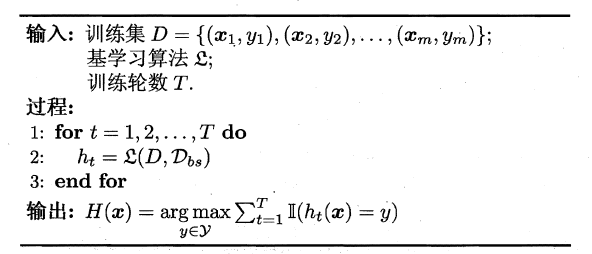

- 机器学习课程

- 机器学习基础

- 深度学习

- 强化学习

- 周志华《机器学习》笔记

- (4)线性模型

- 结束

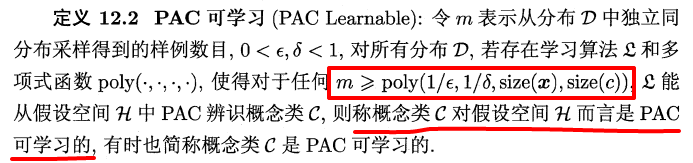

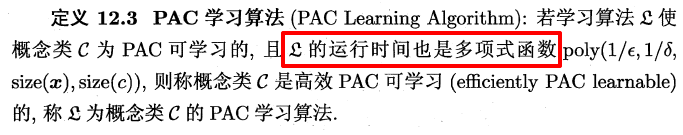

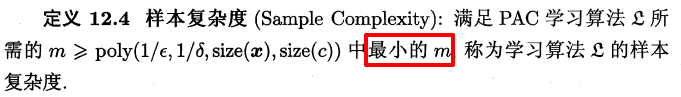

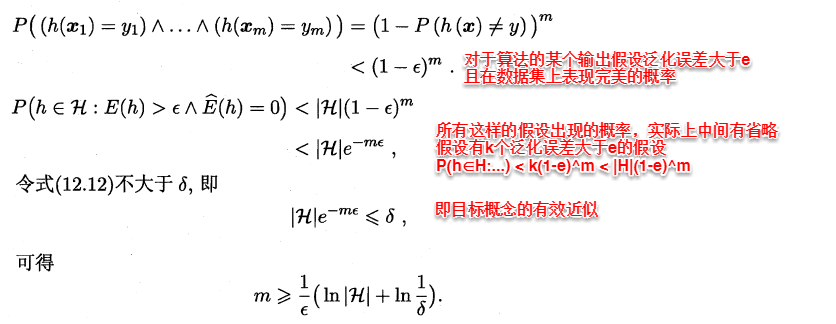

机器学习总结

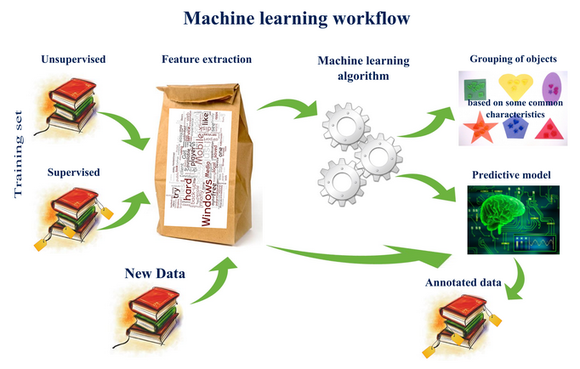

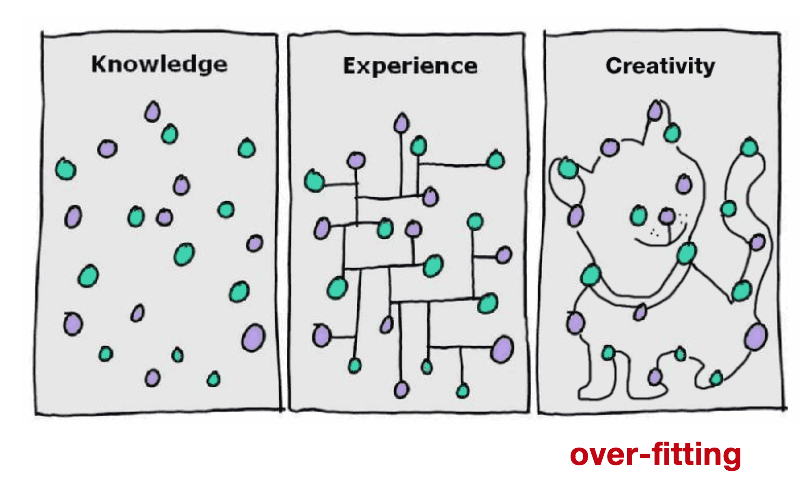

【2023-1-28】机器学习思想 img

- 没有免费的午餐定理(No Free Lunch Theorem/NFL定理 )。NFL定理对于“盲目的算法崇拜”有毁灭性的打击。在某个领域、特定假设下表现卓越的算法不一定在另一个领域也能是“最强者”。正因如此,才需要研究和发明更多的机器学习算法来处理不同的假设和数据。

- 奥卡姆剃刀定理(Occam’s Razor - Ockham定理) 如果两个模型A和B对数据的解释能力完全相同,那么选择较为简单的那个模型

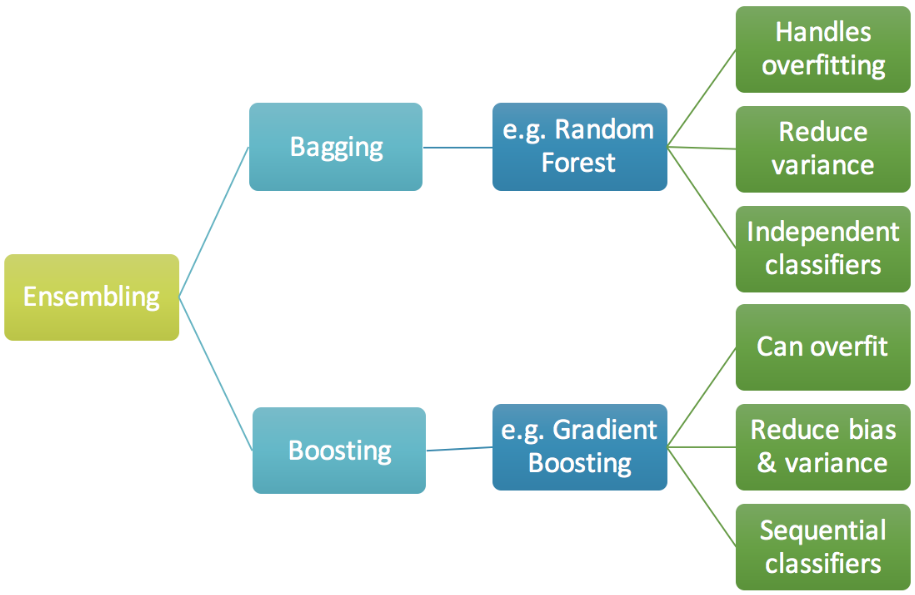

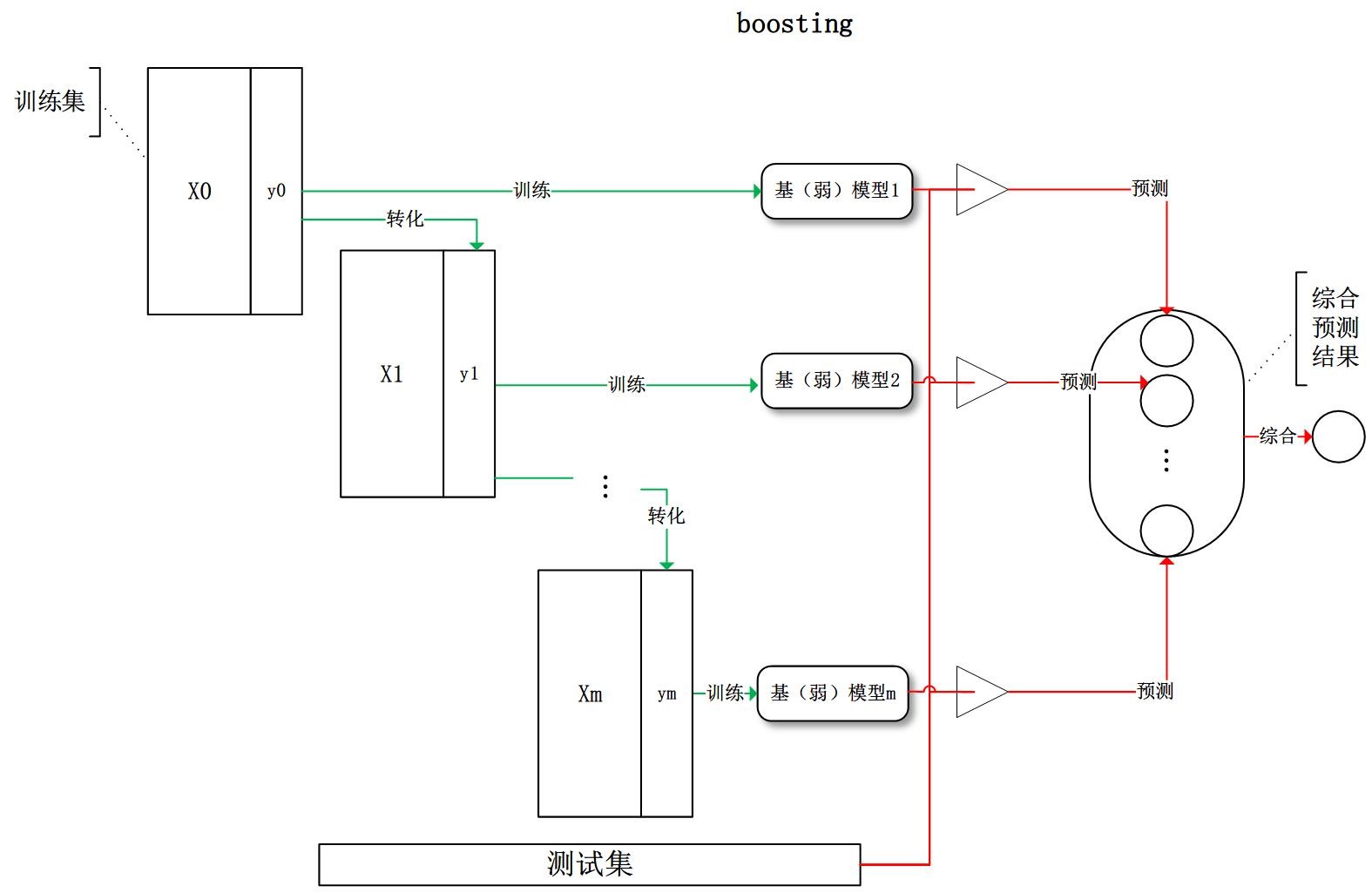

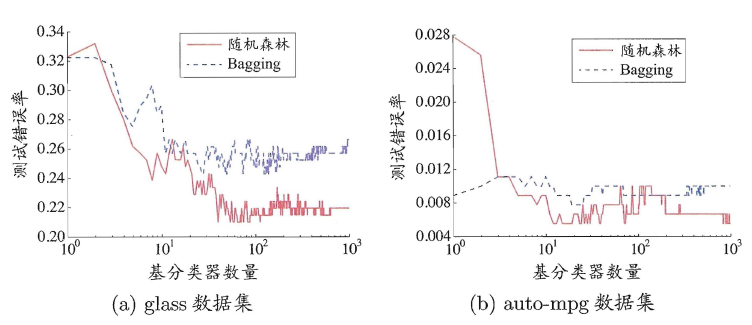

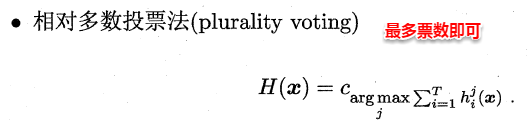

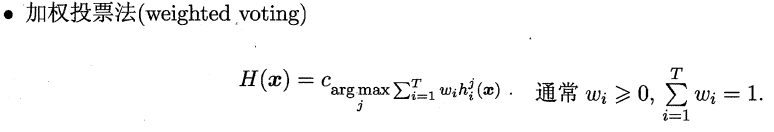

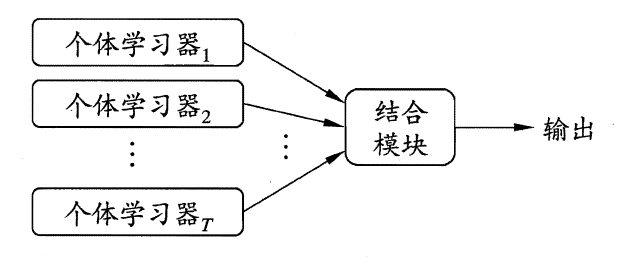

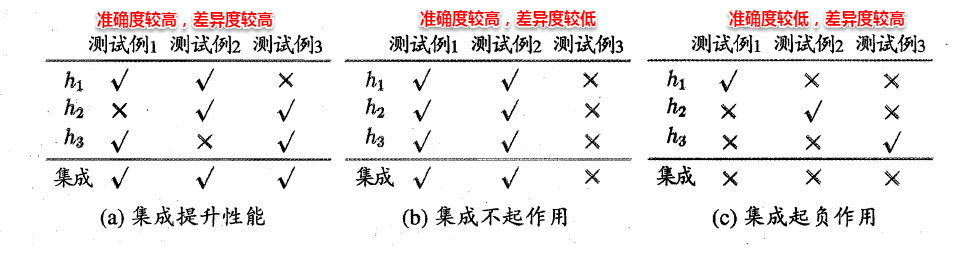

- 集成学习(Ensemble Learning) 思想 个体学习的准确性和多样性本身就存在冲突,一般的,准确性很高后,要增加多样性就需牺牲准确性。

- 频率学派(Frequentism)和贝叶斯学派(Bayesian) - 不可知论

- 数据是王道,garbage in,garbage out

- 分治学习思想

- 终身学习思想

演化历史

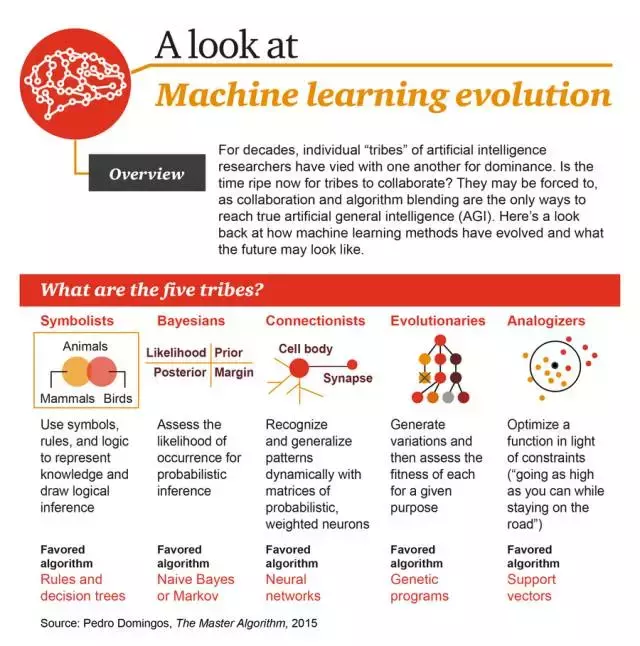

华盛顿大学教授 Pedro Domingos:机器学习领域五大流派

- ① 符号主义:使用符号、规则和逻辑来表征知识和进行逻辑推理,最喜欢的算法是:规则和决策树

- ② 贝叶斯派:获取发生的可能性来进行概率推理,最喜欢的算法是:朴素贝叶斯或马尔可夫

- ③ 联结主义:使用概率矩阵和加权神经元来动态地识别和归纳模式,最喜欢的算法是:神经网络

- ④ 进化主义:生成变化,然后为特定目标获取其中最优的,最喜欢的算法是:遗传算法

- ⑤ Analogizer:根据约束条件来优化函数(尽可能走到更高,但同时不要离开道路),最喜欢的算法是:支持向量机

| 流派 | 时间 | icon | 起源 | 核心思想 | 问题 | 代表算法 | 代表应用 | 代表人物 | 备注 |

|---|---|---|---|---|---|---|---|---|---|

符号主义(Symbolists) |

1980年代 |  |

逻辑学、哲学 | 认知即计算,通过对符号的演绎和逆演绎进行结果预测 | 知识结构 | 逆演绎算法(Inverse deduction) | 知识图谱 | Tom Mitchell、Steve Muggleton、Ross Quinlan |  |

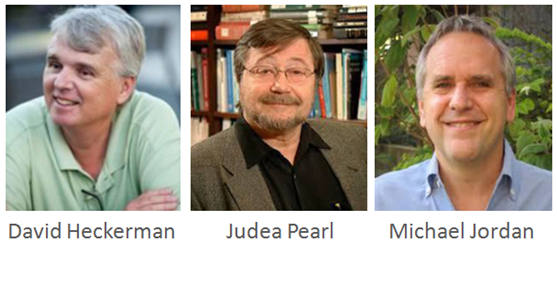

贝叶斯派(Bayesians) |

1990-2000年 |  |

统计学 | 主观概率估计,发生概率修正,最优决策 | 不确定性 | 概率推理(Probabilistic inference) | 反垃圾邮件、概率预测 | David Heckerman、Judea Pearl、Michael Jordan |  |

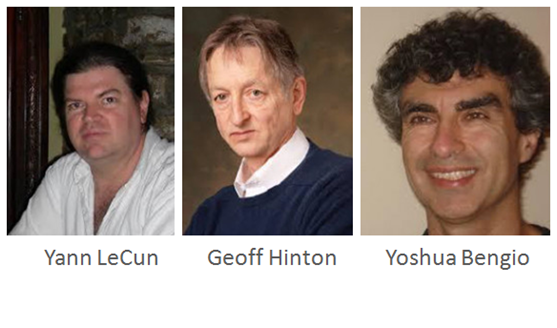

联结主义(Connectionist) |

2010年 |  |

神经科学 | 对大脑进行仿真 | 信度分配 | 反向传播算法(Backpropagation)、深度学习(Deep learning) | 机器视觉、语音识别 | Yann LeCun、Geoff Hinton、Yoshua Bengio |  |

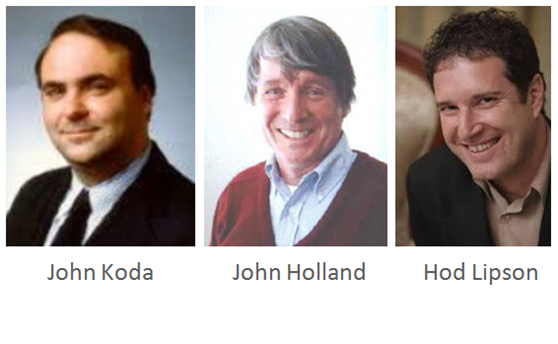

进化主义(Evolutionaries) |

- |  |

进化生物学 | 对进化进行模拟,使用遗传算法和遗传编程 | 结构发现 | 基因编程(Genetic programming) | 海星机器人 | John Koda、John Holland、Hod Lipson |  |

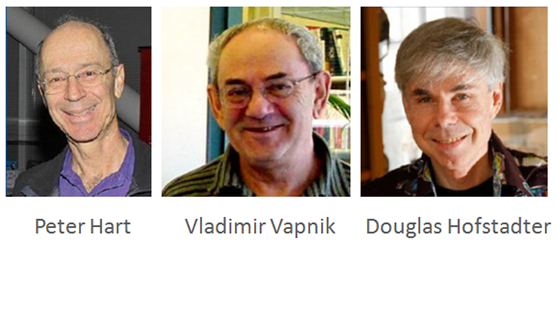

行为类比主义(Analogizer) |

- |  |

心理学 | 新旧知识间的相似性 | 相似性 | 核机器(Kernel machines)、近邻算法(Nearest Neightor) | Netflix推荐系统 | Peter Hart、Vladimir Vapnik、Douglas Hofstadter |  |

- 从20世纪80年代开始,机器学习五大流派不断演化,各个阶段都有相应的主导流派:

- 华盛顿大学教授 Pedro Domingos 曾详细地对机器学习领域的五大流派进行了详细的盘点,写了34页的PPT,各个流派的核心思想和演化过程进行了详细的介绍

这些流派逐渐融合

-

- 【2020-12-31】图解机器学习

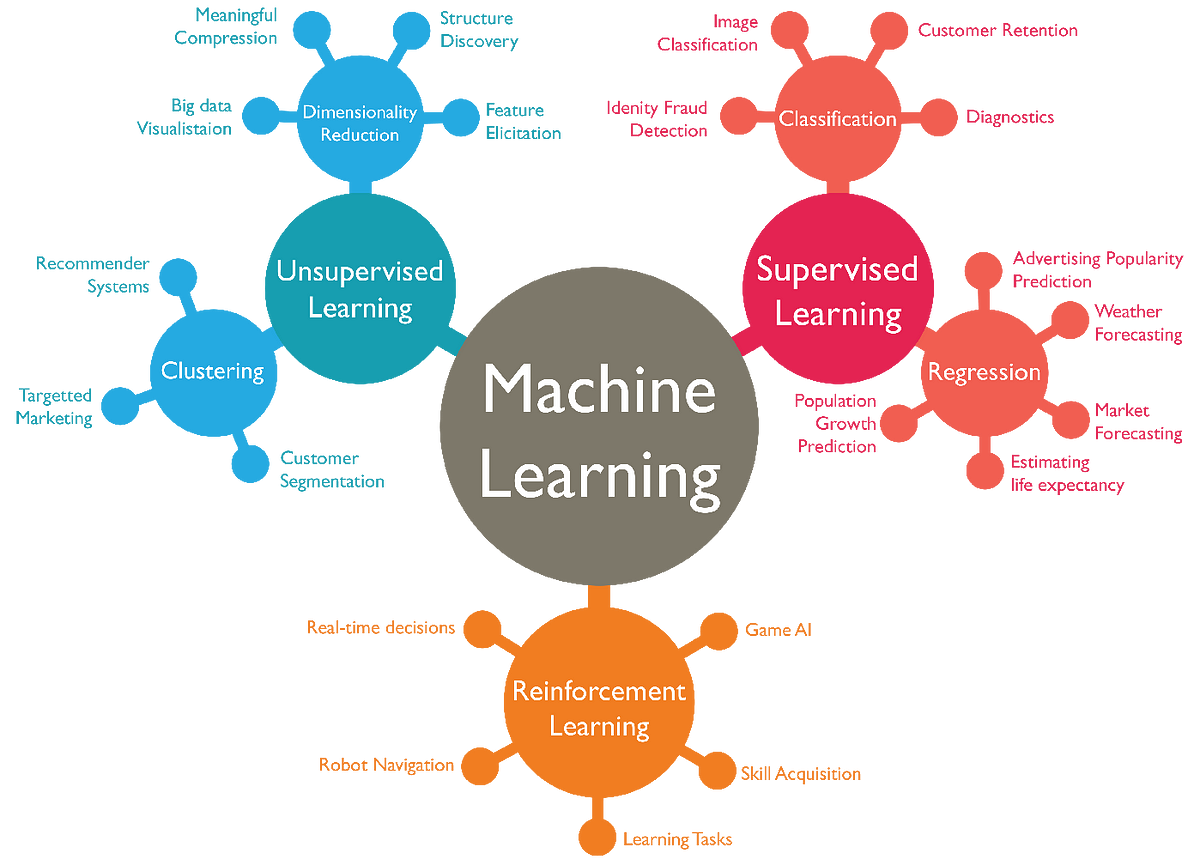

- 按照现阶段主流分类来看,机器学习主要分为四类:

- 经典机器学习;

- 强化学习;

- 神经网络和深度学习;

- 集成方法;

- 【2021-1-2】机器学习的12张思维导图

多模态

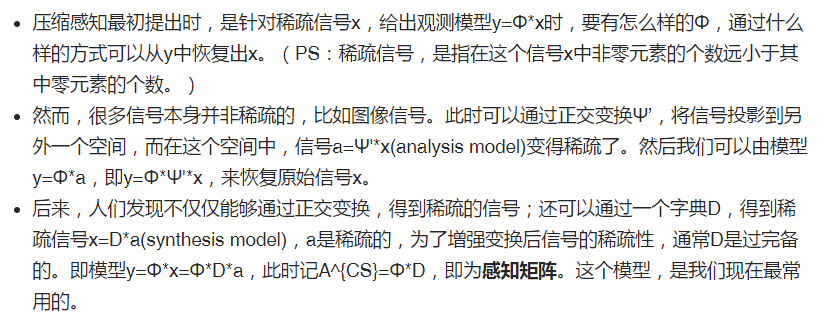

【2022-7-25】聊聊多模态学习

多模态机器学习,英文全称 MultiModal Machine Learning (MMML),旨在通过机器学习的方法实现处理和理解多源模态信息的能力。

每一种信息的来源或者形式,都可以称为一种模态。例如

- 人有触觉,听觉,视觉,嗅觉;信息有语音、视频、文字等媒介;

- 多种多样的传感器,如雷达、红外、加速度计等。

以上的每一种都可以称为一种模态。

模态也可以有非常广泛的定义,比如我们可以把两种不同的语言当做是两种模态,甚至在两种不同情况下采集到的数据集,亦可认为是两种模态。

当下,多模态技术有着相当广泛的应用场景,如淘宝搜图、AI字幕、AI虚拟数字人、仿人交互、智能助手、商品推荐和信息流广告、视频帧人脸帧的图向量检索、语音交互等等。

机器学习算法

【2021-5-24】为什么机器学习算法难以优化?一文详解算法优化内部机制

典型分类

机器学习经过几十年的发展,衍生出了很多种分类方法

监督 vs 无监督

按学习模式的不同,可分为监督学习、半监督学习、无监督学习和强化学习。

机器学习分成:

监督学习:- 分类

- 回归

无监督学习- 聚类

- 降维

半监督学习: 混合学习( Hybrid Learning)强化学习

【2023-12-25】监督学习、无监督学习、半监督学习、强化学习、自监督学习

| 类型 | 原理 | 特征 | 标签 | 数据 | 方法 | 图解 |

|---|---|---|---|---|---|---|

| 监督学习 | 学习特征与标签的映射关系 | 有 | 有 | 样本独立同分布 | 分类、回归 |  |

| 半监督学习 | 学习特征与标签的映射关系,混合学习( Hybrid Learning) | 有 | 部分 | 半监督分类、回归、聚类、异常检测、GAN |  |

|

| 无监督学习 | 自动发现数据中的潜在模式,本质是统计 | 有 | 无 | 聚类、降维、关联规则、异常检测 |  |

|

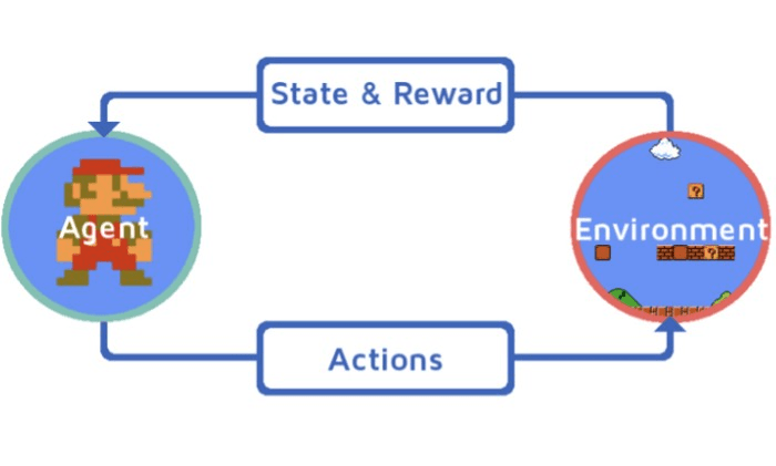

| 强化学习 | 智能体在环境中不断试错来学习,根据奖励信号来调整行为策略,最大化累积奖励 | 样本时序依赖 | DQN |  |

自监督学习(self-supervised learning,简写SSL)不需要人工标注训练数据,模型主要训练从大规模无监督数据中挖掘能够应用于自身的监督信息,从而从输入的一部分数据中去学习另一部分。

自监督学习容易误解为无监督学习中的聚类

- 因为都把不同的未标记事物进行分类

- 但其实自监督学习最大化同类样本在 Embedding 空间中表征的相似性,同时最小化异类样本之间表征的相似性。

分类图解

机器学习可以分为四大块:

分类(Classification): 监督学习,给定了非连续(离散)的属性值,通过一定的逻辑将样本进行归类回归(Regression): 监督学习,产生连续连续的结果,通常是一条回归曲线,和分类问题相似聚类(Clustering): 无监督学习,没有给定属性值,通过一定的标准将样本划分为不同的集合,同一集合内样本像似,不同集合样本相异-

降维(Dimensionality Reduction): 用维数更低的子空间来表示原来高维的特征空间

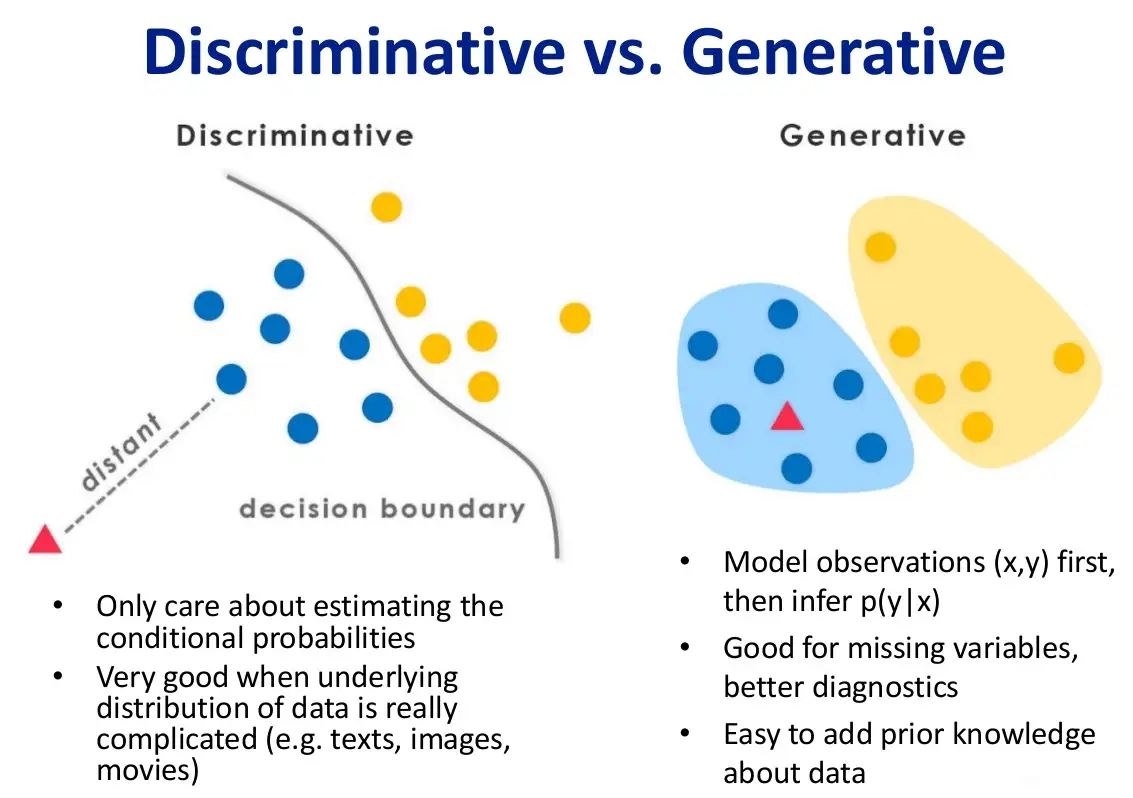

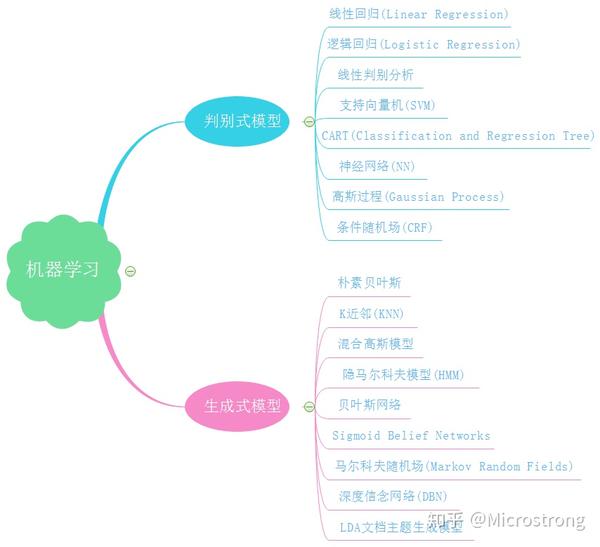

生成模型 & 判别模型

定义

定义

作者:politer

机器学习任务是从属性X预测标记Y,即求概率 $ P(Y|X)$;

判别式模型: 求得 $ P(Y|X) $ ,对未见示例 X,根据 $ P(Y|X) $ 可以求得标记Y,即直接判别出来,如图左所示, 直接得到了判别边界,- 所以传统的机器学习算法( 线性回归模型、支持向量机SVM等 )都是

判别式模型, 特点都是输入属性X可以直接得到Y - 对于二分类任务来说,实际得到一个score,当score大于threshold时则为正类,否则为反类

- 根本原因: 对于某示例$X_1$,对正例和反例的标记的

条件概率之和等于1,即 $ P(Y_1|X_1)+P(Y_2|X_1)=1)$

- 所以传统的机器学习算法( 线性回归模型、支持向量机SVM等 )都是

生成式模型: 求得 $ P(Y,X) $ ,对于未见示例X,要求出X与不同标记之间的联合概率分布,然后大的获胜,如图右所示,并没有什么边界存在,对于未见示例(红三角),求两个联合概率分布(有两个类),比较一下,取那个大的。- “生成”$(X,Y)$样本的概率分布(或称为依据)

- 机器学习中

朴素贝叶斯模型、隐马尔可夫模型HMM等 都是生成式模型 - Naive Bayes,对于输入X,要求出好几个

联合概率,然后较大的那个就是预测结果~ - 根本原因: 对于某示例$X_1$,对正例和反例标记的联合概率不等于1,即 $ P(Y_1,X_1)+P(Y_2,X_1)<1$ ,要遍历所有的X和Y的联合概率求和,即$ sum(P(X,Y))=1$

- 具体可参见楼上woodyhui提到的维基百科Generative model里的例子

举例:确定一个羊是山羊还是绵羊

判别式模型:从历史数据中学习到模型,然后通过提取这只羊的特征来预测出这只羊是山羊/绵羊的概率。生成式模型:根据山羊的特征学习出一个山羊模型,然后根据绵羊特征学习出一个绵羊模型,然后从这只羊中提取特征,放到山羊模型中, 看概率是多少,在放到绵羊模型中看概率是多少,哪个大就是哪个。- 判别式模型是根据一只羊的特征可以直接给出这只羊的概率(比如logistic regression,这概率大于0.5时则为正例,否则为反例),而生成式模型是都要试一试,最大的概率的那个就是最后结果~

作者:Microstrong

判别式模型特点:

- 判别式模型直接学习决策函数 $ Y=f(X)$ 或者

条件概率$P(Y|X)$ ,不能反映训练数据本身的特性,但它寻找不同类别之间的最优分裂面,反映的是异类数据之间的差异,直接面对预测往往学习准确度更高。 - 具体来说有以下特点:

- 对

条件概率建模,学习不同类别之间的最优边界。 - 捕捉不同类别特征的差异信息,不学习本身分布信息,无法反应数据本身特性。

- 学习成本较低,需要的计算资源较少。

- 需要的样本数可以较少,少样本也能很好学习。

- 预测时拥有较好性能。

- 无法转换成生成式。

- 对

生成式模型的特点:

- 生成式模型学习的是

联合概率密度分布 $P(X,Y)$ ,可以从统计角度表示分布的情况,能够反映同类数据本身的相似度,它不关心到底划分不同类的边界在哪里。 - 生成式模型的学习收敛速度更快,当样本容量增加时,学习到的模型可以更快的收敛到真实模型,当存在隐变量时,依旧可以用生成式模型,此时判别式方法就不行了。

- 具体来说,有以下特点:

- 对

联合概率建模,学习所有分类数据的分布。 - 学习到的数据本身信息更多,能反应数据本身特性。

- 学习成本较高,需要更多的计算资源。

- 需要的样本数更多,样本较少时学习效果较差。

- 推断时性能较差。

- 一定条件下能转换成判别式。

- 对

总之,判别式模型和生成式模型都是使后验概率最大化,判别式是直接对后验概率建模,而生成式模型通过贝叶斯定理这一“桥梁”使问题转化为求联合概率。

算法归类

对比

生成模型与判别模型对比

| 问题 | 生成模型 | 判别模型 |

|---|---|---|

| 模型拟合 | 更容易 | 要解决凸优化问题 |

| 添加新类别 | 只需改动一点 | 要重训练 |

| 数据丢失 | 可以处理 | 无法处理 |

| 处理无标签数据 | 处理半监督问题 | 无法处理 |

| 输入和输出的对称 | 可以逆着从输出推断输入 | 无法处理 |

| 特征预处理 | 无法处理 | 可以推广到 GLM |

| 概率矫正 | 概率易走极端 | 概率较正确 |

监督学习 (supervised learning) 划分为两大类方法:生成模型 (generative model) 与判别模型 (discriminative model),贝叶斯方法正是生成模型的代表 (还有隐马尔科夫模型)。

算法总结

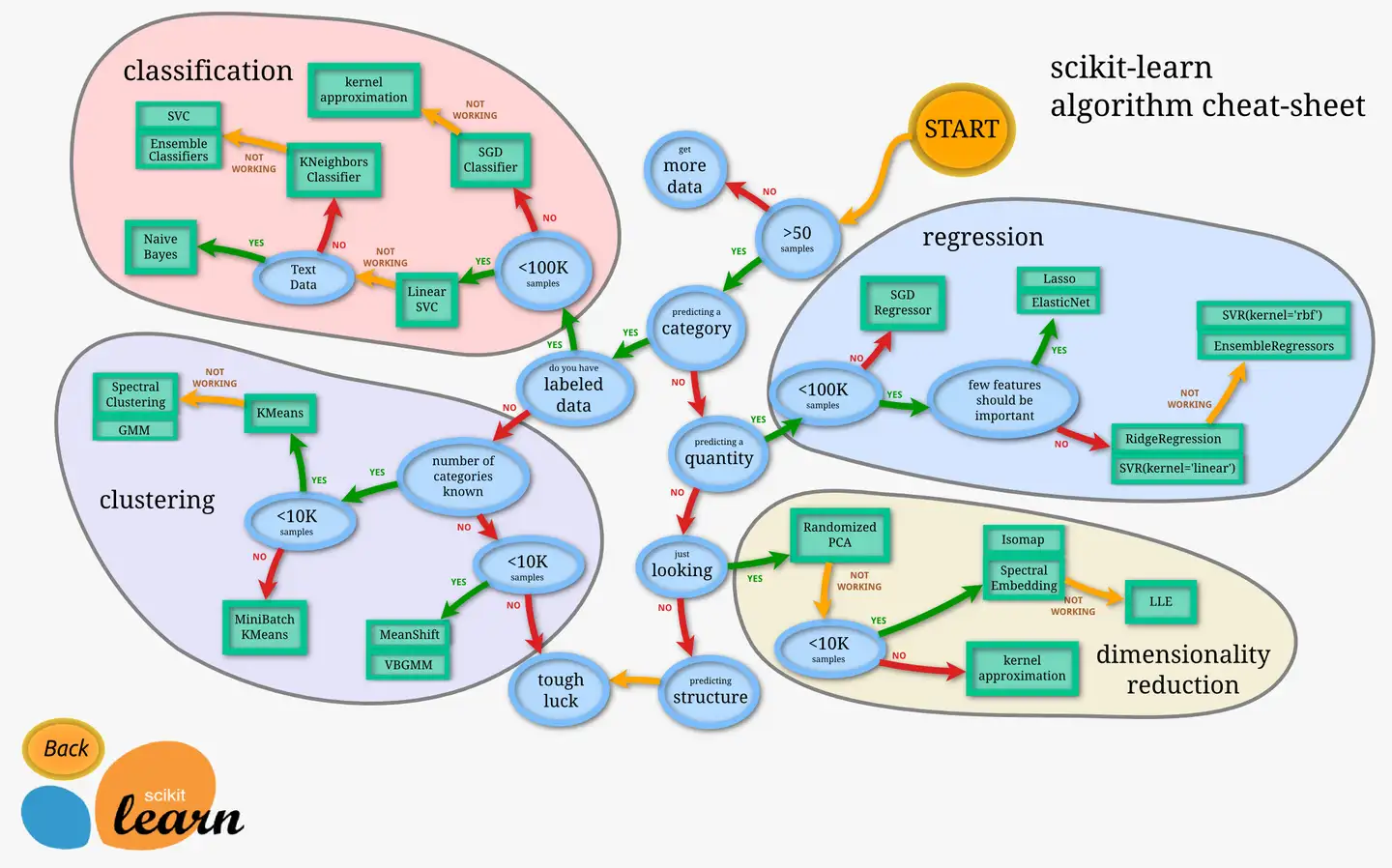

- 微软-ML算法指南:pdf版下载地址

- 详细讲解How to choose algorithms for Microsoft Azure Machine Learning

- 【2020-7-15】新版

- scikit-learn官方总结,Scikit-learn Cookbook:英文本,中文译本,MarkDown格式。【2018-6-12】scikit-learn中文翻译版,主页,scikit-learn网页版,Github版,wiki版,视频版。sklearn库中文版完全手册下载

- 【2017-12-20】Dlib机器学习指南,方法选择:

,中文版,dlib中文指南-图

类型及应用

【2022-7-3】机器学习通识篇

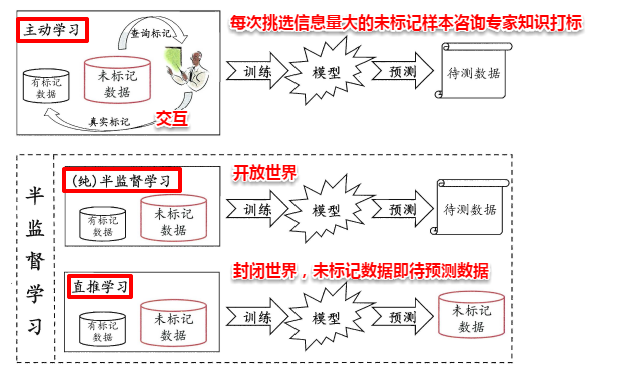

- 主动学习(active learning)

- 大多数情况下,有类标的数据比较稀少而没有类标的数据是相当丰富的,但是对数据进行人工标注又非常昂贵,此时学习算法可以主动地提出一些标注请求,将一些经过筛选的数据提交给专家进行标注,因此需要一个外在的专业人员能够对其进行标注的实体,即主动学习是交互进行的。这个筛选过程是主动学习主要研究点。

- 归纳式学习(inductive learning)

- Induction is reasoning from observed training cases to general rules, which are then applied to the test cases.

- 简而言之,归纳式学习是从训练样本中学习规则然后应用在测试样本中。监督学习就是一种归纳学习。

- 监督学习(supervised learning)

- 半监督学习(semi-supervised learning)

- 无监督学习(unsupervised learning)

- 直推式学习(transductive learning)

- Transduction is reasoning from observed, specific training cases to specific test cases.

- 直推式学习是同时使用训练样本和测试样本来训练模型,然后再次使用测试样本来测试模型效果。

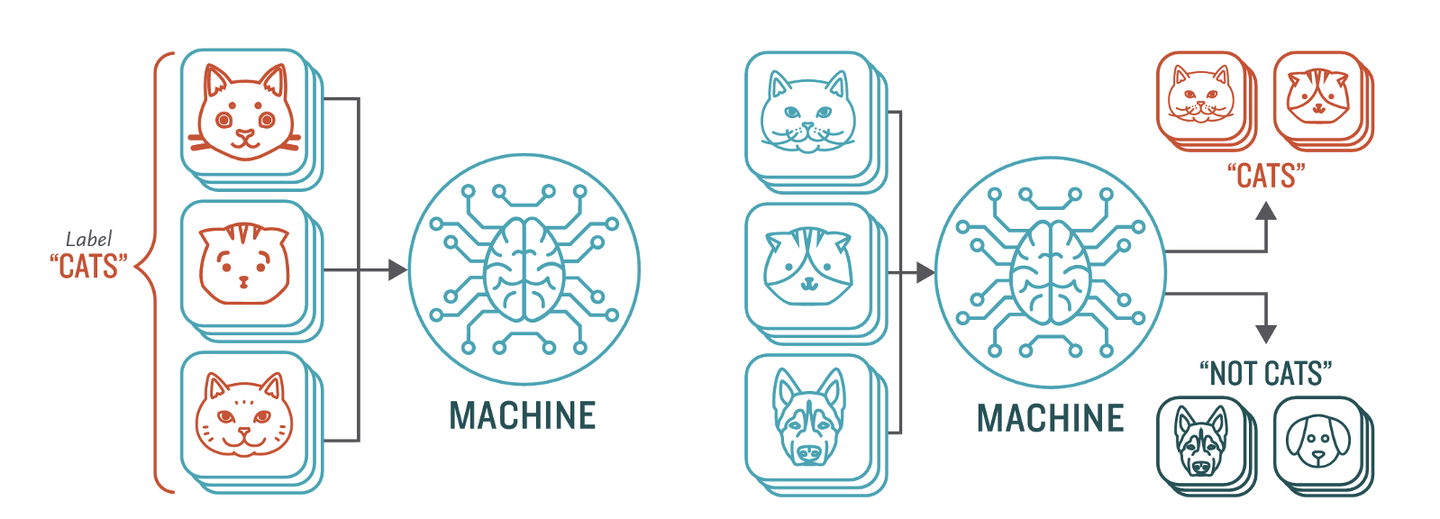

监督学习

监督学习(Supervised Learning)是从有标签的训练数据中学习模型,然后对某个给定的新数据利用模型预测它的标签。如果分类标签精确度越高,则学习模型准确度越高,预测结果越精确。

- 样本和样本标签成对出现

- 监督学习是机器学习中最成熟的学习方法

监督学习主要用于回归和分类。

- 常见的回归算法有线性回归、回归树、K邻近、Adaboost、神经网络等。

- 常见的分类算法有朴素贝叶斯、决策树、SVM、逻辑回归、K邻近、Adaboost、神经网络等。

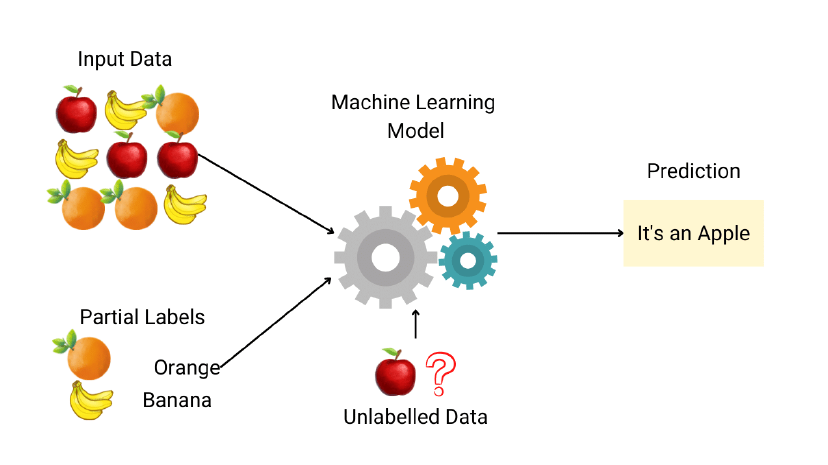

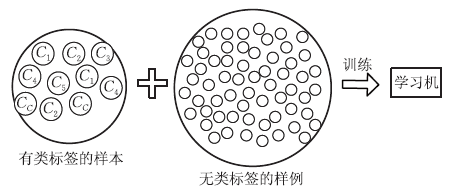

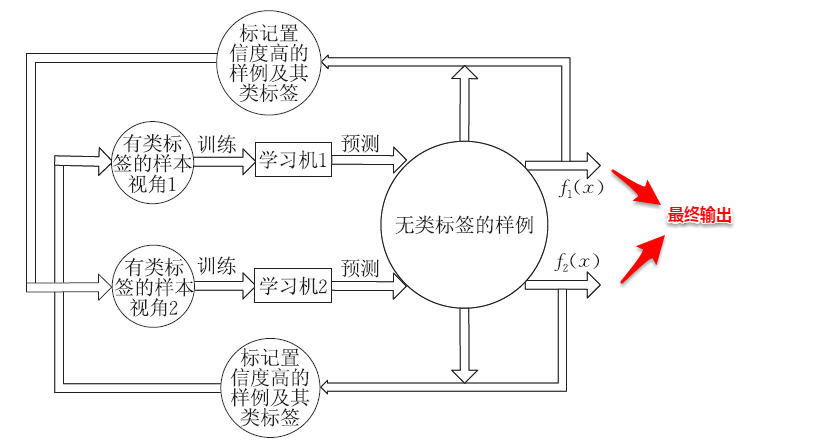

半监督学习

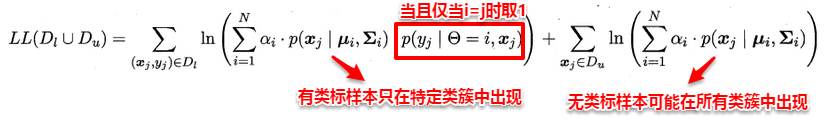

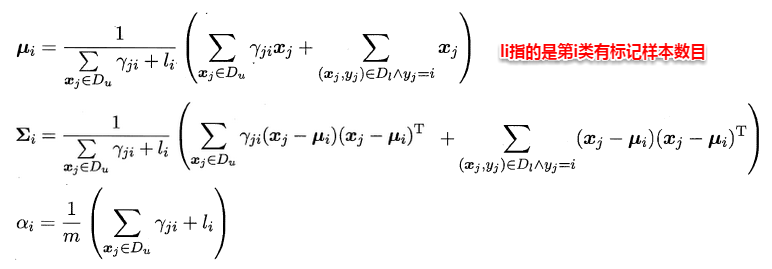

半监督学习(Semi-Supervised Learning)是利用少量标注数据和大量无标注数据进行学习的模式。半监督学习侧重于在有监督的分类算法中加入无标记样本来实现半监督分类。

半监督学习的研究的历史可以追溯到20世纪70年代,这一时期,出现了自训练(Self-Training)、直推学习(Transductive Learning)、生成式模型(Generative Model)等学习方法。

解决的问题

在许多实际问题中,有标签样本和无标签样本往往同时存在,且无标签样本较多,而有标签样本则相对较少。

- 标记数据可能很耗时。假设有1000000张狗图像,将它们输入到分类算法中,目的是预测每个图像是否包含波士顿狗。如果我们想将所有这些图像用于监督分类任务,我们需要一个人查看每个图像并确定是否存在波士顿狗。

- 标记数据可能很昂贵。原因一:要想让人费尽心思去搜100万张狗狗照片,我们可能得掏钱。

- 虽然充足的有标签样本能够有效提升学习性能,但是获取样本标签往往是非常困难的,因为标记样本可能需要专家知识、特殊的设备以及大量的时间。

- 相比于有标签样本,大量的无标签样本广泛存在且非常容易收集。但是,监督学习算法无法利用无标签样本,在有标签样本较少时,难以取得较强的泛化性能。

- 虽然无监督学习算法能够使用无标签样本,但准确性较差。

- 在有标签样本较少时,如何利用无标签样本提升学习性能己成为机器学习及其应用中的重要研究问题。

针对以上问题,学者们想:能否在训练过程中同时使用有标签样本和无标签样本,由此提出了

半监督学习。

半监督学习的基本假设

由于有标签样本较少,为了有效利用大量的无标签样本,半监督学习需要采用合适的半监督假设将学习模型和无标签样本的数据分布联系起来。

- 研究也表明:半监督学习方法的性能依赖于所用的半监督假设!

目前的机器学习技术大多基于独立同分布假设,即数据样本独立地采样于同一分布。

除了独立同分布假设,为了学习到泛化的结果,监督学习技术大多基于平滑(smoothness)假设,即相似或相邻的样本点的标记也应当相似。而在半监督学习中这种平滑假设则体现为两个较为常见的假设:聚类(cluster)假设与流型(manifold)假设。

半监督算法仅在数据的结构保持不变的假设下起作用,没有这样的假设,不可能从有限的训练集推广到无限的不可见的集合。具体地假设有:平滑假设(smoothness assumption)、聚类假设(cluster assumption)、流型假设(maniford assumption)

- 聚类假设(cluster assumption)与流型假设(maniford assumption)这两种假设一般是一致的,属于监督学习中平滑假设的在半监督学习中的推广。

- 流型假设比聚类假设更为一般,因为流型假设是相似的样本点具有相似的性质而不是聚类假设所认为的相同的标记,对于聚类假设无法成立的回归问题上流型假设却可以成立。

1、平滑假设(smoothness assumption)

如果两个样本 x1 ,x2 相似,则相应输出 y1 , y2 也应如此。这意味着如果两个输入相同类,并且属于同一簇,则它们相应的输出需要相近,反之亦成立。 即相似或相邻的样本点的标记也应当相似。

2、聚类假设(cluster assumption)

聚类假设是指同一聚类中的样本点很可能具有同样的类别标记。

- 这个假设可以通过另一种等价的方式进行表达,那就是决策边界所穿过的区域应当是数据点较为稀疏的区域,因为如果决策边界穿过数据点较为密集的区域那就很有可能将一个聚类中的样本点分为不同的类别这与聚类假设矛盾。

- 聚类假设关注样本空间的整体特征,它利用大量无标签样本探测样本分布稠密和稀疏的区域,从而更好地约束决策边界。

- 基于聚类假设的半监督算法通常要求决策边界穿过样本分布稀疏的区域,并能最大化不同聚类簇间的类间间隔。

- 通过利用无标签样本约束目标函数,基于聚类假设的算法能够同时优化有标签样本和无标签样本的类间间隔。

3、流型假设(maniford assumption)

流型假设是指高维中的数据存在着低维的特性。

- 另一种类似的表述为:“处于一个很小的局部邻域内的示例具有相似的性质”。

- 高维数据中的数据的低维的特性是通过局部邻域相似性体现的,比如一个在三维空间卷曲的二维纸带,高维的数据全局的距离度量由于维度过高而显得没有区分度,但是如果只考虑局部范围的距离度量,那就会有一定意义。

- 流形假设主要关注样本空间的局部特征,它利用大量的无标签样增加样本空间的密度,从而更准确地获取样本的局部近邻关系。

- 基于流形假设的半监督算法要求决策边界在数据嵌入到的低维流形上平稳地变化。

半监督学习分类

根据不同的学习场景,现有的半监督学习算法可分为四类:

- 半监督分类

- 半监督回归

- 半监督聚类

- 半监督降维 其中,半监督分类是半监督学习中研宄最多的问题。

半监督学习的主要目标是利用隐藏在大量无标签样本中的数据分布信息来提升仅使用少量有标签样本时的学习性能。

常见的半监督学习算法有 Pseudo-Label、Π-Model、Temporal Ensembling、Mean Teacher、VAT、UDA、MixMatch、ReMixMatch、FixMatch等。

更多:半监督学习(Semi-supervised Learning)算法

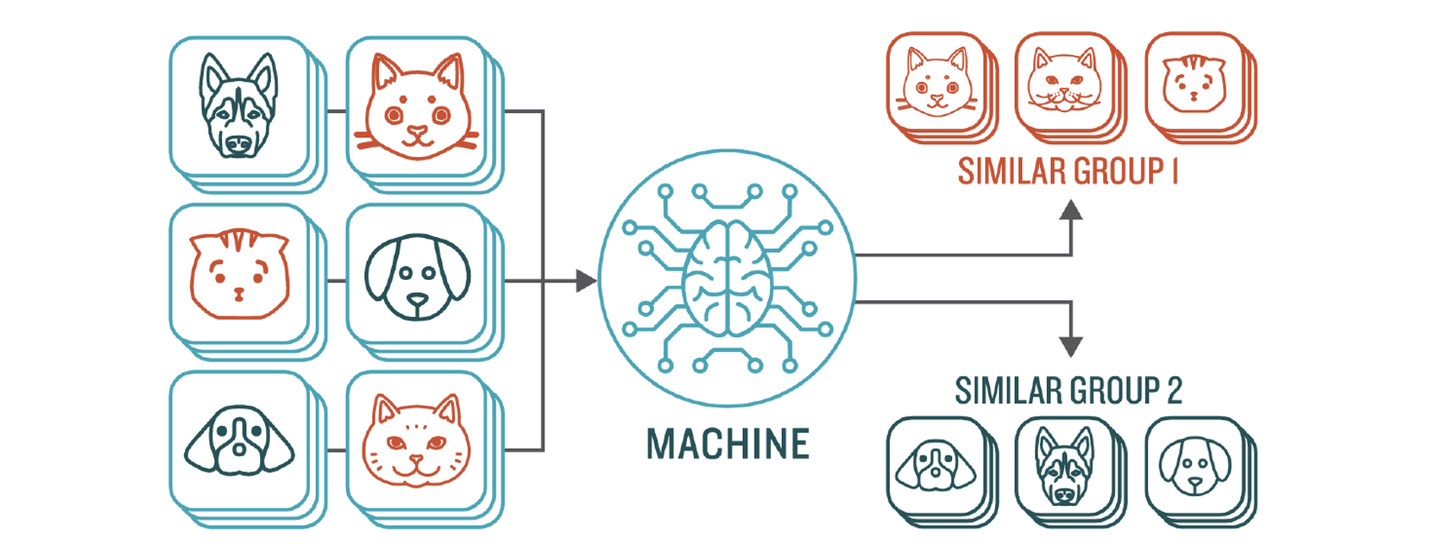

无监督学习

无监督学习(Unsupervised Learning)是从未标注数据中寻找隐含结构的过程。

- 只能利用训练样本的数据分布或样本间的关系将样本划分到不同的聚类簇或给出样本对应的低维结构。

- 无监督特征方法利用训练样本的数据分布信息(如训练样本的方差以及局部结构等)去评估特征的关联性,大部分是利用到统计信息。

- 由于缺少样本标签的引导,无监督特征选择方法可能无法选择出有效的特征,也就是会缺乏先验知识,无法自主决策判断真假,显得比较“笨拙”。

无监督学习主要用于关联分析、聚类和降维。

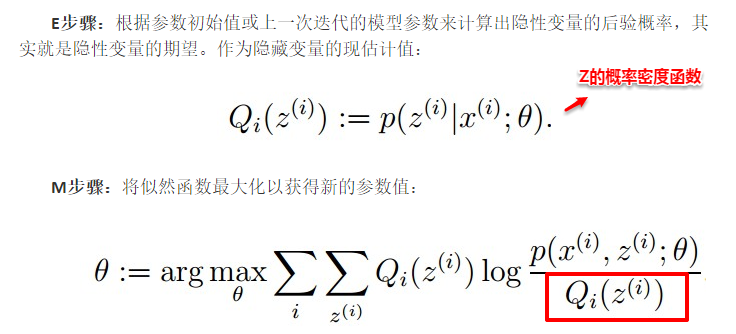

常见的无监督学习算法有稀疏自编码(Sparse Auto-Encoder)、主成分分析(Principal Component Analysis, PCA)、K-Means算法(K均值算法)、DBSCAN算法(Density-Based Spatial Clustering of Applications with Noise)、最大期望算法(Expectation-Maximization algorithm, EM)等。

强化学习

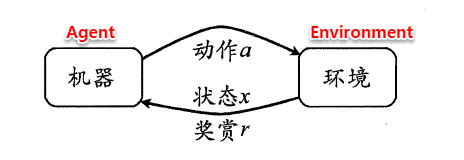

强化学习(Reinforcement Learning)类似于监督学习,但未使用样本数据进行训练,是是通过不断试错进行学习的模式。

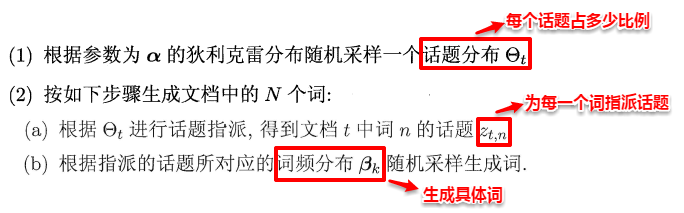

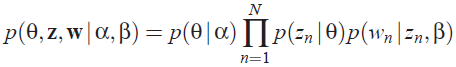

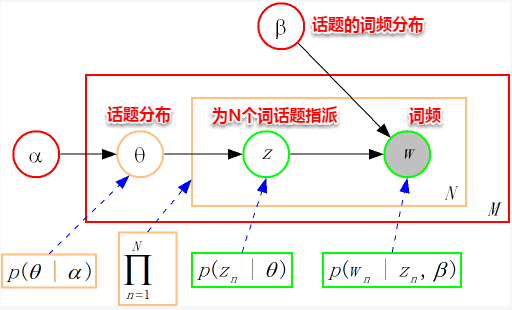

在强化学习中,有两个可以进行交互的对象:智能体(Agnet)和环境(Environment),还有四个核心要素:策略(Policy)、回报函数(收益信号,Reward Function)、价值函数(Value Function)和环境模型(Environment Model),其中环境模型是可选的。

强化学习常用于机器人避障、棋牌类游戏、广告和推荐等应用场景中。

机器学习工具

Google ml-kit 本地

Google ml-kit 工具包提供多种识别能力:OCR、人脸检测、图片加标签、目标检测跟踪、姿势检测以及图片分类

NLP类API功能: 语种识别、翻译、智能回复、实体提取

| 特性 | 设备 | 云端 |

|---|---|---|

| 文本识别 | √ | √ |

| 人脸识别 | √ | × |

| 条形码识别 | √ | × |

| 图像标记 | √ | √ |

| 地标识别 | × | √ |

| 自定义模型装载 | √ | × |

机器学习课程

Introduction to machine learning

【2022-10-25】Introduction to machine learning, 蒙特利尔大学,机器学习ppt总结资料,源自:Deep Learning Summer School, Montreal 2015, 演讲资料

统计学习方法

《统计学习方法》总结:

- 【2019-1-23】Python代码,【2020-6-26】北大研究生的代码实现,第二版课件下载,【2019-11-11】清华教授配套的课件-百度云

统计学习导论

- An-Introduction-to-Statistical-Learning

- Introduction in Statistical Learning with application in R (ISLR),是ESL的入门简单版,作者好像是一样的。

- 官方中文版,英文版

- 【2020-11-10】《统计学习导论》这本书配套视频,英文字幕加中文机翻字幕,配套的R语言教程附在每章的结尾处,github有人用python实现

- 统计学习(机器学习)入门(统计学习导论配套视频)中英字幕

机器学习白板推导

李宏毅课程学习笔记

- 在线笔记

- 李宏毅,机器学习,机器学习-李宏毅(2019) Machine Learning

- 李宏毅, 官网ppt, B站-深度学习19(完整版),一共94节

- 【2021-1-24】李宏毅机器学习知识点脑图

Google机器学习速成课

视频

- 【2020-12-04】对偶机器学习,Duality in machine learning

PRML: 模式识别和机器学习

- 经典书籍:模式识别与机器学习

- 目录

- PRML是模式识别和机器学习领域的经典著作,出版于2007年。该书作者 Christpher M. Bishop 是模式识别和机器学习领域的专家,其1995年所著的“Nerual Networks for Pattern Recognition”也是模式识别、人工神经网络领域的经典著作。

- 将 Bishop 大神的 PRML 称为机器学习圣经一点也不为过,该书系统地介绍了模式识别和机器学习领域内详细的概念与基础。书中有对概率论基础知识的介绍,也有高阶的线性代数和多元微积分的内容,适合高校的研究生以及人工智能相关的从业人员学习。

目录

PRML主要内容:配套代码,Github地址

- 第一章是引子,用曲线拟合让读者对机器学习有个大概理解。

- 第二章主要是介绍了一下基础的统计知识,包括期望方差的计算、高斯分布的参数估计与理解、高斯分布的性质等。

- 第三章和第四章主要在讲最基础的线性模型,并且展示了如何将其应用在分类和回归的场景下,贝叶斯方法是整本书的核心。

- 第五章介绍了神经网络,在线性模型的基础上引入了多层感知机模型,即常说的 BP 网络。

- 第六章讲的是核方法,核是两个样本的内积,也可以理解为某个

希尔伯特空间中由内积定义的“距离”。主要讲了线性模型转成核表达的方式、核的构建以及高斯过程。 - 第七章是向量机,向量机讲的是贝叶斯模型如何通过先验找到一个稀疏的模型。

- 第八章是讲的图模型,对变量的独立性、隐变量和参数的区别(这个会在变分贝叶斯中体现)做了很好的阐释。

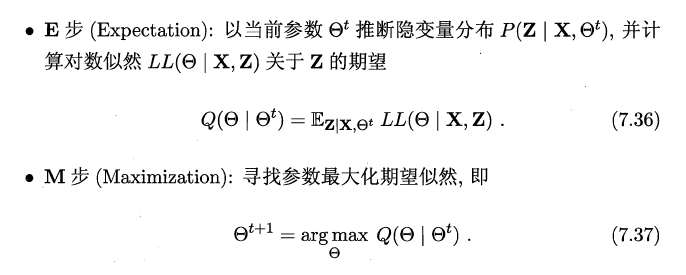

- 第九章讲了混合模型和 EM算法,涉及了隐变量的概念和 EM 算法等。

- 第十章讲的是变分推断,解决了基于现在的模型的分布假设,推断参数难的问题。

- 第十一章讲采样方法,介绍了不同采样方法的优缺点,并重点讲了MCMC采样。

- 第十二章讲主成分分析,是考察多个变量间相关性一种多元统计方法,研究如何通过少数几个主成分来揭示多个变量间的内部结构。

- 第十三章讲的是序列数据,序列数据的特点及马尔可夫假设等。

- 第十四章讲的是 Ensemble,包括适应性的 boosting 最著名的 AdaBoost,以及一些其他的集成方法。

MLAPP:《机器学习:概率视角》——《Machine Learning: a Probabilistic Perspective》

- 作者是谷歌研究员Kevin Patrick Murphy,自2012年出版以来就一直被列为机器学习经典著作之一。本书可以作为PRML的姊妹篇,基于概率论和概率模型的角度来理解机器学习模型

- 电子版: Machine Learning: a Probabilistic Perspective

- 中文翻译

【2022-3-28】新版

- 【2012】Machine Learning: a Probabilistic Perspective

- 【2022-02-08】Probabilistic Machine Learning: An Introduction

- 【2022-3-14】Probabilistic Machine Learning: Advanced Topics

目录

全书包括28个章节,可以算是鸿篇巨制。MLaPP 读书笔记

- Chapter 1: 引言 Introduction,笔记

- 由于现在处于信息爆炸的时代,机器学习的意义在于,发现数据中的模式,并用于新数据的预测之中

- 机器学习三种类型:

- 有监督学习:给定训练集,求从输入到输出的映射;每个输入的维度都是一个特征;predictive or supervised method

- 包含:分类、回归

- 无监督学习:从一推的数据集中找到某些模式,但是不会有显示的标注数据和目标函数,即知识发现(knowledge discovery);descriptive and unsupervised learning;包含:聚类、降维、稀疏图模型、矩阵完成(matric completion,如图像修复/协同过滤/购物篮分析)

- 强化学习:一般都会有一个 agent,通过环境给予的 reward or punishment 来学习正确的做出决策,执行 action,decision theory 是强化学习的基础;reinforcement learning

- 有监督学习:给定训练集,求从输入到输出的映射;每个输入的维度都是一个特征;predictive or supervised method

- 另一种分类:分类标准:参数的数量是固定还是随训练数据的增多而增多

- 参数模型(parametric),如分类、回归

- 非参数模型(non-parametric),如 k-NN

- 对抗维度灾难的主要方法是对数据分布的性质做一些假设,归纳偏置(inductive bias)

- Chapter 2: 概率 Probability,笔记

- 两种概率流派

- 频率学派:frequentist interpretation,参数固定,概率可以看作是多次事件实验的发生的频率的逼近,很多次抛硬币实验,会发现最终硬币会出现正面的概率为0.5

- 贝叶斯学派:Bayesian interpretation,参数变化(服从一定分布),把概率当做是量化事件不确定型的工具,好处是可以估算那些无法进行多次重复实验的事件,如2020年之前北极冰川融化的概率

- 概率基础知识:Discrete random variables 离散随机变量、Joint probabilities 联合概率、Conditional probability 条件概率、Bayes rule 贝叶斯规则、Independence and conditional independence 独立和条件独立、Continuous random variables 连续随机变量、Quantiles 分位数、Mean and variance 均值和方差

- Some common discrete distributions 常见离散分布:The binomial and Bernoulli distributions 二项分布和伯努利分布、The multinomial and numtinoulli distributions 多项式分布和多努利分布

- Some commom continuous distributions 常见连续分布:Gaussian (normal) distribution 高斯分布、Degenerate pdf 退化的概率密度函数、The Laplace distribution 拉普拉斯分布、The gamma distribution 伽马分布、The Beta distribution 贝塔分布、Pareto distribution 柏拉图分布

- Joint probability distributions 联合概率分布:Covariance and correlation 协方差和相关性、The multivariate Gaussian 多元高斯、Multivariate Student t distribution 多元 t 分布、Dirichlet distribution 狄利克雷分布

- Tranformations of random variables 随机变量的变换:Linear transformations 线性变换、General transformations 一般变换、Central limit theorem 中心极限定理

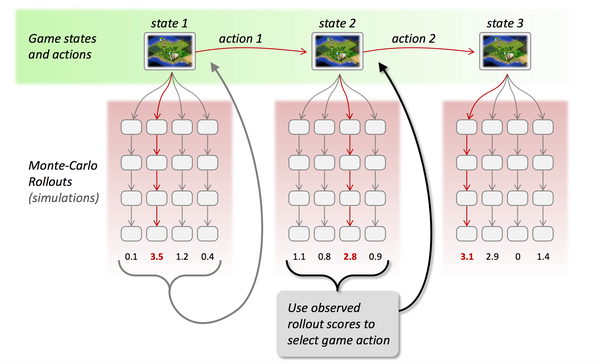

- Monte Carlo approximation 蒙特卡洛近似

- Information theory 信息理论:Entropy 熵、cross-entropy 交叉熵、KL divergence 离散度、Mutual information 互信息

- 两种概率流派

- Chapter 3: 面向离散数据的生成式模型 Generative models for discrete data,笔记

- 生成模型(generative model)按照贝叶斯公式构造分类器

- Bayesian concept learning 贝叶斯概念学习

- 概念学习(Concept learning)其实是一个二分类问题,学习的是一个指示函数(Indicator function),但是和二分类问题不同,我们可以仅仅只从正例中学习

- Likelihood 似然、Prior 先验、Posterior 后验、Posterior predictive distribution 后验预测分布:似然、先验、后验、后验预测

- The Dirichlet-multinomial model:似然、先验、后验、后验预测

- The beta-binomial model 贝塔-二项式模型:似然、先验、后验、后验预测

- Naive Bayes classification 朴素贝叶斯分类器:MLE

- Chapter 4: 高斯模型 Gaussian models,笔记

- 基础:MLE for an MVN 多元高斯模型的极大似然估计、Maximum entropy derivation of the Gaussian * 从最大熵中推导出高斯模型

- Gaussian discriminant analysis 高斯判别分析:Quadratic discriminant analysis (QDA) 二次判别分析、Linear discriminant analysis (LDA) 线性判别分析、Two-class LDA 二分类 LDA、MLE for discriminant analysis、Strategies for preventing overfitting、Regularized LDA * 正则化 LDA、Diagonal LDA 对角化 LDA、Nearest shrunken centroids classifier

- Inference in jointly Gaussian distributions 联合高斯分布的推断:Marginals and conditionals 边缘概率和条件概率、Information form(距参量moment parameters)

- Linear Gaussian systems 线性高斯系统

- Digression: The Wishart distribution * 题外话:Wishart 分布

- Inferring the parameters of an MVN 推断 MVN 的参数

- Chapter 5: 贝叶斯统计 Bayesian statistics,笔记

- 贝叶斯统计的核心内容:用后验分布(posterior distributino)来总结一切

- Summarizing posterior distributions 总结后验分布:MAP estimation 最大后验估计、Credible intervals 置信区间、Inference for a difference in proportions

- Bayesian model selection 贝叶斯模型选择:Bayesian Occam’s razor 贝叶斯奥卡姆剃刀效应、Computing the marginal likelihood (evidence)、Bayes factors 贝叶斯因子

- Priors 先验:Uninformative priors 无信息先验、Jeffreys priors、Robust priors 鲁棒先验、Mixtures of conjugate priors 共轭先验的混合

- Hierarchical Bayes 层次贝叶斯:

- Empirical Bayes 经验贝叶斯

- Bayesian decision theory 贝叶斯决策理论

- Chapter 6: 频率统计 Frequentist statistics,笔记

- 频率学派统计学(frequentist statistics),经典统计学(classical statistics),或者叫正统统计学(orthodox statistics),设计了一些不把参数当做随机变量的统计推断方法,从而避免了使用贝叶斯法则和先验。频率学派依赖于抽样分布(sampling distribution),而贝叶斯学派则依赖后验分布(posterior distribution)

- Sampling distribution of an estimator 估计量的抽样分布:Bootstrap(蒙特卡洛方法来估计抽样分布,分有参数和无参数两种)

- Frequentist decision theory 频率学派决策理论:Bayes risk 贝叶斯风险、Minimax risk 最小化最大风险

- Desirable properties of estimators 想要的估计量性质:Consistent estimators 一致估计量、Unbiased estimators 无偏估计量、Minimum variance estimators 最小化方差估计量、The bias-variance tradeoff 偏置-方差之间的权衡

- Empirical risk minimization 经验风险最小化:Regularized risk minimization 正则化风险最小化、Structural risk minimization 结构风险最小化、Estimating the risk using cross validation 用交叉验证估计风险、Upper bounding the risk using statistical learning theory * 用统计学习理论来估计风险上界、Surrogate loss function 代理损失函数

- Pathologies of frequentist statistics * 频率统计的病态

- Chapter 7: 线性回归 Linear regression,笔记

- 线性回归(Linear Regression)是统计学和机器学习中的主力军(work horse),当用核函数等做基函数扩充(basis function expansion)时,又可以模拟非线性关系。除了回归问题,如果用伯努利或者多努利分布代替高斯分布,那么就可以用来做分类问题(classification)

- Model specification 模型确定:残差服从高斯分布,最大化似然函数就等价于最小化残差平方和,无法处理异常点(outlier)

- MLE (or least squares) 最大似然估计(最小二乘法)

- Derivation of the MLE 最大似然估计推导:Geometric interpretation 几何解释、Convexity 凸性、Robust linear regression 鲁棒线性回归(解决异常点问题)、Ridge regression 岭回归(解决过拟合问题)、Connection with PCA(OLS 和 ridge regression 都是属于 shrinkage method。主成分回归(PCR Principle Components Regression)指的是先用主成分分析降维,然后再用岭回归做回归)

- Bayesian linear regression 贝叶斯线性回归

- Chapter 8: 逻辑回归 Logistic regression,笔记

- LR 是一个非常重要的模型,几乎所有的机器学习职位面试都会问到

- Model specification:把线性回归的高斯分布,换成伯努利分布,就成了逻辑斯特回归,变成了分类模型

- Model fitting 模型拟合:MLE、Steepest descent 梯度下降、Newton’s method 牛顿法、Iteratively reweighted least squares (IRIS)、Quasi-Newton (variable metric) methods 拟牛顿法、ℓ2 regularization L2正则化、Multi-class logistic regression 多分类LR

- Bayesian logistic regression

- Online learning and stochastic optimazation

- Generative vs discriminative classifiers 生成分类器 VS 判别分类器:两种模式的详细对比

- Chapter 9: 广义线性模型和指数族 Generalized linear models and the exponential family,笔记

- 很多概率分布其实都是属于指数家族簇,比如高斯,伯努利,泊松,狄利克雷分布等。当然,均匀分布和学生 t 分布除外。可以用指数家族分布来表示 class-conditional density,由此建立广义线性模型(GLM, Generalized Linear Model)这个生成分类器。

- The exponential family 指数家族

- Generalized linear models (GLMs) 广义线性模型:Linear or Logistic Regression 都算是广义线性模型的特例

- Probit regression 概率回归

- Multi-task learning 多任务学习

- Generalized linear mixed models

- Learning to rank 学习排序:pointwise、pairwise、listwise、Loss function for ranking 排序损失函数

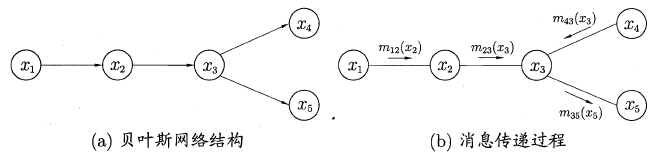

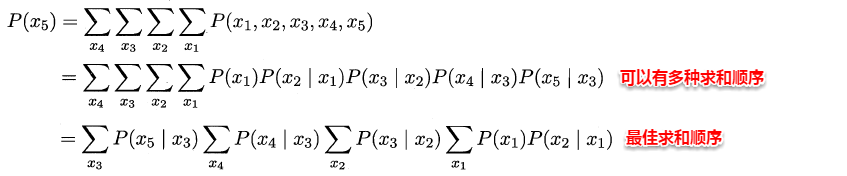

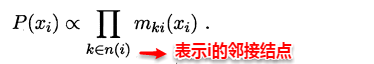

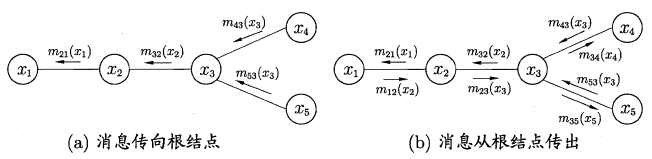

- Chapter 10: 有向图模型(贝叶斯网络) Directed graphical models (Bayes nets)

- Chapter 11: 混合模型与EM算法 Mixture models and the EM algorithm,笔记

- 图模型尝试在不同的观察变量之间建立条件独立关系,另一种思路则是用隐变量模型,即 LVMs, Latent variable models,这种模型假设观察变量都是从一个共同的“隐变量”中得到的。

- 隐变量的意思就是无法观测到,没有数据,可以人为定义个数和表示的含义。因此聚类算法中的簇就可以看做是隐变量,而有监督学习中如果给了簇的标定数据,就变成观察数据了,叫做标签。

- Mixture models 混合模型:Mixtures of Gaussians 高斯混合模型、Mixture of multinoullis 多努利混合模型、Using mixture models for clustering 使用混合模型做聚类、Mixtures of experts 混合专家

- Parameter estimation for mixture models 混合模型的参数估计:Unidentifiability 不可确定性、Computing a MAP estimate is non-convex

- The EM algorithm:EM for GMMs

- Model slection for latent varibale models

- Fitting models with missing data

- Chapter 12: 隐式线性模型 Latent linear models

- Chapter 13: 稀疏线性模型 Sparse linear models

- Chapter 14: 核方法 Kernels

- Chapter 15: 高斯过程 Gaussian processes

- Chapter 16: 自适应基函数模型 Adaptive basis function model

- Chapter 17: 马尔可夫模型和隐马尔可夫模型 Markov and hidden Markov Models

- Chapter 18: 状态空间模型 State space models

- Chapter 19: 无向图模型(马尔可夫随机域) Undirected graphical models (Markov random fields)

- Chapter 20: 图模型精准推断 Exact inference algorithms for graphical models

- Chapter 21: 变分推断 Variational inference

- Chapter 22: 更进变分推断 More variational inference

- Chapter 23: 蒙特卡洛推断 Monte Carlo inference algorithms

- Chapter 24: 马尔科夫链蒙特卡洛推断 MCMC inference algorithms

- Chapter 25: 聚类 Clustering

- Chapter 26: 图模型结构学习 Graphical model structure learning

- Chapter 27: 因变量 Latent variable models for discrete data

- Chapter 28: 深度学习 Deep learning

GitHub上同步开源随书代码,Python代码实现

ESL:统计学习基础

ESL 指的是 The Elements of Statistical Learning。

- 序言

- 第二版序言

- 第一版序言

- 1 简介

- 1.1 导言

- 2 监督学习概要

- 2.1 导言

- 2.2 变量类型和术语

- 2.3 两种预测的简单方法

- 2.4 统计判别理论

- 2.5 高维问题的局部方法

- 2.6 统计模型,监督学习和函数逼近

- 2.7 结构化的回归模型

- 2.8 限制性估计的种类

- 2.9 模型选择和偏差-方差的权衡

- 文献笔记

- 3 回归的线性方法

- 3.1 导言

- 3.2 线性回归模型和最小二乘法

- 3.3 子集的选择

- 3.4 收缩的方法

- 3.5 运用派生输入方向的方法

- 3.6 选择和收缩方法的比较

- 3.7 多重输出的收缩和选择

- 3.8 Lasso 和相关路径算法的补充

- 3.9 计算上的考虑

- 文献笔记

- 4 分类的线性方法

- 4.1 导言

- 4.2 指示矩阵的线性回归

- 4.3 线性判别分析

- 4.4 逻辑斯蒂回归

- 4.5 分离超平面

- 文献笔记

- 5 基展开和正规化

- 5.1 导言

- 5.2 分段多项式和样条

- 5.3 滤波和特征提取

- 5.4 光滑样条

- 5.5 光滑参数的自动选择

- 5.6 非参逻辑斯蒂回归

- 5.7 多维样条

- 5.8 正则化和再生核希尔伯特空间理论

- 5.9 小波光滑

- 文献笔记

- 附录-B 样条的计算

- 6 核光滑方法

- 6.0 导言

- 6.1 一维核光滑器

- 6.2 选择核的宽度

- 6.3IRpIRp中的局部回归

- 6.4IRpIRp中的结构化局部回归模型

- 6.5 局部似然和其他模型

- 6.6 核密度估计和分类

- 6.7 径向基函数和核

- 6.8 混合模型的密度估计和分类

- 6.9 计算上的考虑

- 文献笔记

- 7 模型评估及选择

- 7.1 导言

- 7.2 偏差,方差和模型复杂度

- 7.3 偏差-方差分解

- 7.4 测试误差率的 optimism

- 7.5 样本内预测误差的估计

- 7.6 参数的有效个数

- 7.7 贝叶斯方法和 BIC

- 7.8 最小描述长度

- 7.9 VC 维

- 7.10 交叉验证

- 7.11 自助法

- 7.12 条件测试误差或期望测试误差

- 文献笔记

- 8 模型推断和平均

- 8.1 导言

- 8.2 自助法和最大似然法

- 8.3 贝叶斯方法

- 8.4 自助法和贝叶斯推断之间的关系

- 8.5 EM 算法

- 8.6 从后验分布采样的 MCMC

- 8.7 袋装法

- 8.8 模型平均和堆栈

- 8.9 随机搜索

- 文献笔记

- 9 增广模型,树,以及相关方法

- 9.0 导言

- 9.1 广义可加模型

- 9.2 基于树的方法

- 9.3 PRIM

- 9.4 多变量自适应回归样条

- 9.5 专家的分层混合

- 9.6 缺失数据

- 9.7 计算上的考虑

- 文献笔记

- 10 增强和可加树

- 10.1 boosting 方法

- 10.2 boosting 拟合可加模型

- 10.3 向前逐步加性建模

- 10.4 指数损失和 AdaBoost

- 10.5 为什么是指数损失

- 10.6 损失函数和鲁棒性

- 10.7 数据挖掘的现货方法

- 10.8 垃圾邮件的例子

- 10.9 boosting 树

- 10.10 Gradient Boosting 的数值优化

- 10.11 大小合适的 boosting 树

- 10.12 正则化

- 文献笔记

- 11 神经网络

- 11.1 导言

- 11.2 投影寻踪回归

- 11.3 神经网络

- 11.4 拟合神经网络

- 11.5 训练神经网络的一些问题

- 11.6 模拟数据的例子

- 11.7 邮编数字的例子

- 文献笔记

- 12 支持向量机和灵活的判别方法

- 12.1 导言

- 12.2 支持向量分类器

- 12.3 支持向量机和核

- 12.4 广义线性判别分析

- 12.5 FDA

- 12.6 PDA

- 12.7 混合判别分析

- 计算上的考虑

- 文献笔记

- 13 原型方法和最近邻

- 13.1 导言

- 13.2 原型方法

- 13.3 k 最近邻分类器

- 13.4 自适应的最近邻方法

- 13.5 计算上的考虑

- 文献笔记

- 14 非监督学习

- 14.1 导言

- 14.2 关联规则

- 14.3 聚类分析

- 14.4 自组织图

- 14.5 主成分,主曲线以及主曲面

- 14.6 非负矩阵分解

- 14.7 独立成分分析和探索投影寻踪

- 14.8 多维缩放

- 14.9 非线性降维和局部多维缩放

- 14.10 谷歌的 PageRank 算法

- 文献笔记

- 15 随机森林

- 15.1 导言

- 15.2 随机森林的定义

- 15.3 随机森林的细节

- 15.4 随机森林的分析

- 文献笔记

- 16 集成学习

- 16.1 导言

- 16.2 增强和正则路径

- 16.3 学习集成

- 文献笔记

- 17 无向图模型

- 17.1 导言

- 17.2 马尔科夫图及其性质

- 17.3 连续变量的无向图模型

- 17.4 离散变量的无向图模型

- 文献笔记

- 18 高维问题

- 18.1 当 p 大于 N

- 18.2 对角线性判别分析和最近收缩重心

- 18.3 二次正则的线性分类器

- 18.4 一次正则的线性分类器

- 18.5 当特征不可用时的分类

- 18.6 有监督的主成分

- 18.7 特征评估和多重检验问题

- 文献笔记

机器学习基础

入门教程

【2022-9-25】参考 school-of-ai

深度学习入门:

- 布朗学院新鲜出炉,交互式图解人工智能

- Google PlayGround神经网络训练在线演示,汉化版,手写数字识别3D交互体验

- 神经网络讲解【3Blue1Brown优质讲解】,该系列一共4个视频,第一个如下:

- 神经网络Web Demo,可在线体验神经网络训练过程

- 神经网络3D仿真特效(多种网络结构对比)

- 手写数字识别在线体验

【2024-9-16】Amazon 出品的 MLU-Explain, 网页动态显示机器学习概念

基本流程

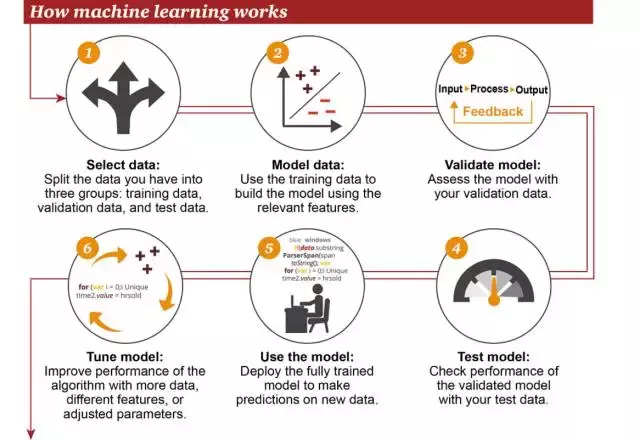

机器学习的工作方式

- ①选择数据:将你的数据分成三组:训练数据、验证数据和测试数据

- ②模型数据:使用训练数据来构建使用相关特征的模型

- ③验证模型:使用你的验证数据接入你的模型

- ④测试模型:使用你的测试数据检查被验证的模型的表现

- ⑤使用模型:使用完全训练好的模型在新数据上做预测

- ⑥调优模型:使用更多数据、不同的特征或调整过的参数来提升算法的性能表现

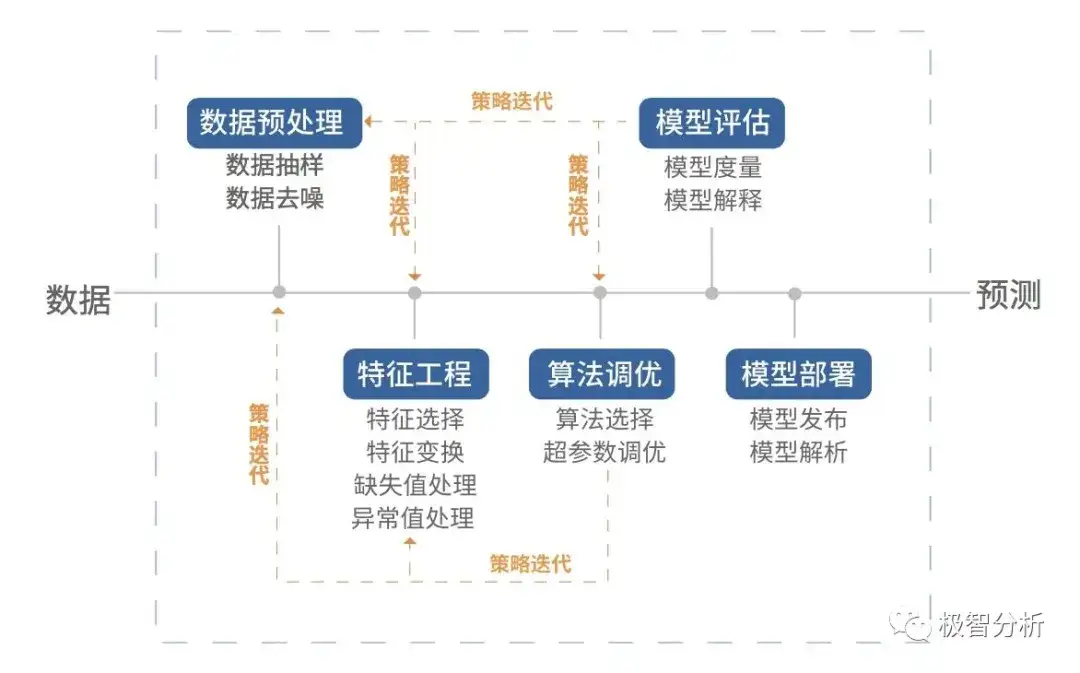

机器学习建模的大致流程:

- (1) 首先对原数据作清洗,筛选,特征标记等处理工作。

- (2) 然后使用处理后的数据来训练指定模型,并根据诊断情况来不断迭代训练模型。

- (3) 最后将训练调整好的模型应用到真实的场景中。

三个步骤:

- 数据准备与预处理

- 模型选择与训练

- 模型验证与参数调优

工程部署

按照机器学习的基本流程划分文件及目录,常见的结构如下:

- data:数据目录,包含:

- train.txt

- test.txt

- validation.txt(可选)

- bin:核心代码,主要包含:

- model.py:模型定义

- feature.py:特征工程部分,离线训练和在线评估都有

- train.py:模型训练代码

- predict.py:在线预测(inference,推断)

- model:模型存放

- log:日志目录

- 训练日志,如tensorboard日志

- conf:配置文件

- common:公共库、组件

- eva.py:效果评估

云端环境

- Google colab,与github直接打通,免费GPU(Tesla T4)

- 如果无法访问,建议使用Kaggle,fastai接入指南,从0到1走进kaggle

- 【2019-05-12】kaggle注册时可能收不到验证码,原因是伟大的墙,解决方法:①找个v-p-n②kaggle注册无法激活怎么办

- fastai官方代码库

基础概念

数据集划分

- 【2017-12-25】知乎:机器学习中的测试机和训练集如何划分?,与时间强相关的问题需要按照时间划分,否则(大部分ML问题)应该随机抽样,与时间无关(应用了未来函数)。随机划分保证了训练集和测试集的历史场景是类似的,就类似于这些数据都是同一台机器同一时期产生的两类数据集。这样计算出的准确率能最真实的反映模型对这段数据学习的效果

把所有数据都用来训练模型的话,建立的模型自然是最契合这些数据的,测试表现也好。但换了其它数据集测试这个模型效果可能就没那么好了。为了防止过拟合,就需要将数据集分成训练集、验证集、测试集。

作用分别是:

训练集(train set):用来训练模型验证集(validation set):评估模型预测的好坏及调整对应的参数测试集(test set:测试已经训练好的模型的推广能力

数据集划分

训练集和测试集大多数人都较容易区分,但关于验证集和测试集的关系却往往会搞混

| 维度 | 验证集 | 测试集 |

|---|---|---|

| 是否参与训练 | 否 | 否 |

| 作用 | 超参调优,防止模型过拟合 | 评估模型最终的泛化能力 |

| 使用次数 | 多次使用 | 仅一次 |

| 缺陷 | 多次训练调参后逼近的验证集可能只代表一部分非训练集,导致模型泛化能力不够 | 测试集由于量大,一般只取训练集中的一部分 |

训练集/测试集分布不一致?

【2022-10-16】训练/测试集分布不一致解法总结

- 训练集高分,测试集预测提交后发现分数很低,为什么?

- 有可能是训练集和测试集分布不一致,导致模型过拟合训练集

(1)发生原因

训练集和测试集分布不一致也被称作数据集偏移(Dataset Shift) 。

西班牙格拉纳达大学Francisco Herrera教授在他PPT里提到数据集偏移有三种类型:

协变量偏移(Covariate Shift): 独立变量的偏移,指训练集和测试集的输入服从不同分布,但背后是服从同一个函数关系,如图1所示。先验概率偏移(Prior Probability Shift): 目标变量的偏移。概念偏移(Concept Shift): 独立变量和目标变量之间关系的偏移。

资料

- Dataset Shift in Classification: Approaches and Problems - Francisco Herrera, PPT

最常见的有两种原因:

样本选择偏差(Sample Selection Bias): 训练集是通过有偏方法得到的,例如: 非均匀选择(Non-uniform Selection),导致训练集无法很好表征的真实样本空间。环境不平稳(Non-stationary Environments): 当训练集数据的采集环境跟测试集不一致时会出现该问题,一般是由于时间或空间的改变引起的。

在分类任务上,有时候官方随机划分数据集,没有考虑类别平衡问题

- 目标变量不均衡:训练集类别A数据量远多于类别B,而测试集相反,这类样本选择偏差问题会导致训练好的模型在测试集上鲁棒性很差,因为训练集没有很好覆盖整个样本空间。

- 输入特征不均衡:输入特征也可能出现样本选择偏差问题,比如要预测泰坦尼克号乘客存活率,而训练集输入特征里“性别”下更多是男性,而测试集里“性别”更多是女性,这样也会导致模型在测试集上表现差。

样本选择偏差也有些特殊的例子

- 阿里天池2021“AI Earth”人工智能创新挑战赛,官方提供两类数据集作为训练集,分别是CMIP模拟数据和SODA真实数据,然后测试集又是SODA真实数据,CMIP模拟数据是通过系列气象模型仿真模拟得到的,即有偏方法,但选手都会选择将模拟数据加入训练,因为训练集真实数据太少了,可模拟数据的加入也无可避免的引入了样本选择偏差。

环境不平稳带来的数据偏移,最常见是在时序比赛里,用历史时序数据预测未来时序,未来突发事件很可能带来时序的不稳定表现,这便带来了分布差异。环境因素不仅限于时间和空间,还有数据采集设备、标注人员等。

(2)如何识别

有三种判断方法

- KDE (核密度估计)分布图

- 如何对比训练集和测试集的分布?画概率密度函数

直方图,但直方图看分布有两点缺陷: 受bin宽度影响大和不平滑 - 因此多数人会偏向于使用

核密度估计图(Kernel Density Estimation, KDE),KDE是非参数检验,用于估计分布未知的密度函数,相比于直方图,它受bin影响更小,绘图呈现更平滑,易于对比数据分布。 - KDE 工具包:seaborn.kdeplot()

- 如何对比训练集和测试集的分布?画概率密度函数

- KS检验

- KDE是

PDF来对比,而KS检验是基于CDF(累计分布函数Cumulative Distribution Function) 来检验两个数据分布是否一致,它也是非参数检验方法(即不知道数据分布情况)。 - 若KS统计值小且p值大,则我们可以接受KS检验的原假设H0,即两个数据分布一致。

- 工具包:调用scipy.stats.ks_2samp()可轻松得到KS的统计值(最大垂直差)和假设检验下的p值

- 注意: p值<0.01,强烈建议拒绝原假设H0,p值越大,越倾向于原假设H0成立。

- KDE是

- 对抗验证

- 思路:构建一个分类器去分类训练集和测试集,如果模型能清楚分类,说明训练集和测试集存在明显区别(即分布不一致),否则反之。

- 具体步骤如下:

- 训练集和测试集合并,同时新增标签‘Is_Test’去标记训练集样本为0,测试集样本为1。

- 构建分类器(例如LGB, XGB等)去训练混合后的数据集(可采用交叉验证的方式),拟合目标标签‘Is_Test’。

- 输出交叉验证中最优的AUC分数。AUC越大(越接近1),越说明训练集和测试集分布不一致。

-

- 相关代码可参考Qiuyan918在Kaggle的Microsoft Malware Prediction比赛中使用实例代码

import numpy as np

import seaborn as sns

import matplotlib.pyplot as plt

# 创建样例特征

train_mean, train_cov = [0, 2], [(1, .5), (.5, 1)]

test_mean, test_cov = [0, .5], [(1, 1), (.6, 1)]

train_feat, _ = np.random.multivariate_normal(train_mean, train_cov, size=50).T

test_feat, _ = np.random.multivariate_normal(test_mean, test_cov, size=50).T

# 绘KDE对比分布

sns.kdeplot(train_feat, shade = True, color='r', label = 'train')

sns.kdeplot(test_feat, shade = True, color='b', label = 'test')

plt.xlabel('Feature')

plt.legend()

plt.show()

# ---------- KS ---------

from scipy import stats

stats.ks_2samp(train_feat, test_feat)

# 输出:KstestResult(statistic=0.2, pvalue=0.2719135601522248)

# 统计值较低,p值大于10%但不是很高,因此反映分布略微不一致。

(3)解决方法

解决方法

- 构造合适的验证集

- 构建跟测试集分布近似相同的验证集,保证线下验证跟线上测试分数不会抖动,这样我们就能得到稳定的benchmark

- Qiuyan918在基于对抗验证的基础上,提出了三种构造合适的验证集的办法:

- 人工划分验证集

- TimeSeriesSplit:Sklearn提供的TimeSeriesSplit。

- 固定窗口滑动划分法:固定时间窗口,不断在数据集上滑动,获得训练集和验证集。(个人推荐这种)

- 选择和测试集最相似的样本作为验证集

- 对训练集的预测概率进行降序排列,选择概率最大的前20%样本划分作为验证集,这样就能从原始数据集中得到分布跟测试集接近的一个验证集

- 评估划分好的验证集跟测试集的分布状况,评估方法:将验证集和测试集做对抗验证,若AUC越小,说明划分出的验证集和测试集分布越接近(即分类器越分不清验证集和测试集)。

- 有权重的交叉验证

- 方法:测试集中样本区别对待,分布一致的权重大,不一致的权重小,这样有助于线下得到不易抖动的评估分数。

- 工具包:在lightgbm库的Dataset初始化参数中,便提供了样本加权的参数weight,详见文档,人工划分验证集的图中,对抗验证的分类器预测训练集的Is_Test概率作为权重即可。

- 删除分布不一致特征

- 直接删去这种特征。该方法在各大比赛中十分常见。例如: 在2018年蚂蚁金服风险大脑-支付风险识别比赛中,亚军团队根据特征在训练集和测试集上的表现,去除分布差异较大的特征

- 修正分布不一致的特征输入

- 蚂蚁金服比赛里,亚军团队发现”用户交易请求”特征在训练集中包含0、1和-1,而测试集只有1和0样本,因此他们对训练集删去了特征值为-1的样本,减少该特征在训练集和测试集的差异

- 修正分布不一致的预测输出

- 在“AI Earth”人工智能创新挑战赛里,我们有提到官方提供两类数据集作为训练集,分别是CMIP模拟数据和SODA真实数据,然后测试集又是SODA真实数据,其中前排参赛者YueTan就将CMIP和SODA的目标特征分布画在一起,然后发现SODA的值更集中,且整体分布偏右一些,所以对用CMIP训练得到的预测值加了一个小的常数,修正CMIP下模型的预测输出,使得它分布更偏向于SODA分布

- 伪标签

- 伪标签是半监督方法,利用未标注数据加入训练,我们先看看伪标签的思路,再讨论为什么它可能在一定程度上对分布不一致的数据集有帮助。伪标签最常见的方法是:

- 使用有标注的训练集训练模型M;

- 然后用模型M预测未标注的测试集;

- 选取测试集中预测置信度高的样本加入训练集中;

- 使用标注样本和高置信度的预测样本训练模型M’;

- 预测测试集,输出预测结果。

- TripleLift知乎主提供的入门版伪标签思路图

-

- 其它

数据不均衡

由于数据分布不平衡造成的。解决方法如下:

- 1)采样,对小样本加噪声采样,对大样本进行下采样

- 2)进行特殊的加权,如在Adaboost中或者SVM中

- 3)采用对不平衡数据集不敏感的算法

- 4)改变评价标准:用AUC/ROC来进行评价

- 5)采用Bagging/Boosting/Ensemble等方法

- 6)考虑数据的先验分布

机器学习模型分类

监督/非监督

监督学习算法有哪些?

- 感知机、SVM、人工神经网络、决策树、逻辑回归

判别 vs 生成

区别

- 生成式模型是根据概率乘出结果,联合概率

- 由数据直接学习决策函数 Y = f(X),或者由条件分布概率

P(Y|X)作为预测模型,即判别模型。 - 常见的判别模型有:K近邻、SVM、决策树、感知机、线性判别分析(LDA)、线性回归、传统的神经网络、逻辑斯蒂回归、boosting、条件随机场

- 由数据直接学习决策函数 Y = f(X),或者由条件分布概率

- 判别式模型是给出输入计算出结果,条件概率

- 由数据学习联合概率密度分布函数 P(X,Y),然后求出条件概率分布

P(Y|X)作为预测的模型,即生成模型。 - 常见的生成模型有:朴素贝叶斯、隐马尔可夫模型、高斯混合模型、文档主题生成模型(LDA)、限制玻尔兹曼机

- 由数据学习联合概率密度分布函数 P(X,Y),然后求出条件概率分布

由生成模型可得到判别模型,但由判别模型得不到生成模型。

判别式模型有:

- Logistic Regression(Logistical 回归)

- Linear discriminant analysis(线性判别分析)

- Supportvector machines(支持向量机)

- Boosting(集成学习)

- Conditional random fields(条件随机场)

- Linear regression(线性回归)

- Neural networks(神经网络)

常见的生成式模型有:

- Gaussian mixture model and othertypes of mixture model(高斯混合及其他类型混合模型)

- Hidden Markov model(隐马尔可夫)

- NaiveBayes(朴素贝叶斯)

- AODE(平均单依赖估计)

- Latent Dirichlet allocation(LDA主题模型)

- Restricted Boltzmann Machine(限制波兹曼机)

线性/非线性模型

如果模型是参数的线性函数,并且存在线性分类面,那么就是线性分类器,否则不是。

- 线性分类器:LR,贝叶斯分类,单层感知机、线性回归。

- 非线性分类器:决策树、RF、GBDT、多层感知机。

SVM两种都有(看线性核还是高斯核)。

- 线性分类器速度快、编程方便,但是可能拟合效果不会很好。

- 非线性分类器编程复杂,但是效果拟合能力强。

线性分类器有三大类:感知器准则函数、SVM、Fisher准则,而贝叶斯分类器不是线性分类器。

- 感知准则函数 :准则函数以使错分类样本到分界面距离之和最小为原则。其优点是通过错分类样本提供的信息对分类器函数进行修正,这种准则是人工神经元网络多层感知器的基础。

- 支持向量机 :基本思想是在两类线性可分条件下,所设计的分类器界面使两类之间的间隔为最大,它的基本出发点是使期望泛化风险尽可能小。(使用核函数可解决非线性问题)

- Fisher 准则 :更广泛的称呼是线性判别分析(LDA),将所有样本投影到一条远点出发的直线,使得同类样本距离尽可能小,不同类样本距离尽可能大,具体为最大化“广义瑞利商”。

根据两类样本一般类内密集,类间分离的特点,寻找线性分类器最佳的法线向量方向,使两类样本在该方向上的投影满足类内尽可能密集,类间尽可能分开。这种度量通过类内离散矩阵SwSw和类间离散矩阵SbSb实现。

分类/回归

分类算法有哪些?

- SVM、神经网络、随机森林、逻辑回归、KNN、贝叶斯

归一化

哪些机器学习算法不需要做归一化处理?

- 概率模型不需要归一化,因为不关心变量的值,而是关心变量的分布和变量之间的条件概率,如决策树、RF。

- 而像Adaboost、GBDT、XGBoost、SVM、LR、KNN、KMeans之类的最优化问题就需要归一化。

标准化 vs 归一化

标准化依照特征矩阵的列处理数据,其通过求z-score方法,将样本的特征值转换到同一量纲下。归一化依照特征矩阵的行处理数据,其目的在于样本向量在点乘运算或其他核函数计算相似性时,拥有统一的标准,都转化为“单位向量”。

特征向量的缺失值处理:

- 缺失值较多.直接将该特征舍弃掉,否则可能反倒会带入较大的noise,对结果造成不良影响。

- 缺失值较少,其余的特征缺失值都在10%以内,我们可以采取很多的方式来处理:

- 1) 把NaN直接作为一个特征,假设用0表示;

- 2) 用均值填充;

- 3) 用随机森林等算法预测填充

特征工程

随机森林如何评估特征重要性。

衡量变量重要性的方法有两种,Decrease GINI 和 Decrease Accuracy:

- 1) Decrease GINI:对于回归问题,直接使用argmax(VarVarLeftVarRight)作为评判标准,即当前节点训练集的方差Var减去左节点的方差VarLeft和右节点的方差VarRight。

- 2) Decrease Accuracy:对于一棵树Tb(x),我们用OOB样本可以得到测试误差1;然后随机改变OOB样本的第j列:保持其他列不变,对第j列进行随机的上下置换,得到误差2。至此,我们可以用误差1-误差2来刻画变量j的重要性。基本思想就是,如果一个变量j足够重要,那么改变它会极大的增加测试误差;反之,如果改变它测试误差没有增大,则说明该变量不是那么的重要。

特征选择

特征选择是一个重要的数据预处理过程,主要有两个原因:

- 一是减少特征数量、降维,使模型泛化能力更强,减少过拟合;

- 二是增强对特征和特征值之间的理解。

特征选择方式:

- 去除方差较小的特征。

- 正则化。1正则化能够生成稀疏的模型。L2正则化的表现更加稳定,由于有用的特征往往对应系数非零。

- 随机森林,对于分类问题,通常采用基尼不纯度或者信息增益,对于回归问题,通常采用的是方差或者最小二乘拟合。一般不需要feature engineering、调参等繁琐的步骤。它的两个主要问题,1是重要的特征有可能得分很低(关联特征问题),2是这种方法对特征变量类别多的特征越有利(偏向问题)。

- 稳定性选择。是一种基于二次抽样和选择算法相结合较新的方法,选择算法可以是回归、SVM或其他类似的方法。它的主要思想是在不同的数据子集和特征子集上运行特征选择算法,不断的重复,最终汇总特征选择结果,比如可以统计某个特征被认为是重要特征的频率(被选为重要特征的次数除以它所在的子集被测试的次数)。理想情况下,重要特征的得分会接近100%。稍微弱一点的特征得分会是非0的数,而最无用的特征得分将会接近于0。

特征工程方法

参数与超参数

- 模型参数:参数属于模型内部的配置变量,它们通常在建模过程自动学习得出。如:线性回归或逻辑回归中的系数、支持向量机中的支持向量、神经网络中的权重。

- 模型超参数:超参数属于模型外部的配置变量,他们通常由研究员根据自身建模经验手动设定。如学习速率,迭代次数,层数、K近邻中的K值。

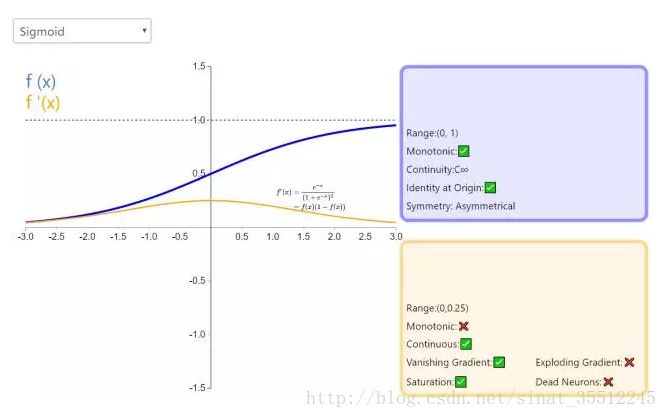

激活函数

常用的非线性激活函数有sigmoid、tanh、relu等等

- 前两者 sigmoid/tanh 常见于全连接层,后者relu常见于卷积层。

为什么引入非线性激励函数?

- 如果不用激励函数(其实相当于激励函数是f(x) = x),在这种情况下你每一层输出都是上层输入的线性函数,很容易验证,无论你神经网络有多少层,输出都是输入的线性组合,与没有隐藏层效果相当,这种情况就是最原始的感知机(Perceptron)了。

Sigmoid、Tanh、ReLu 激活函数

Sigmoid的函数表达式

- $f(z)=\frac{1}{1+\exp{-z}}$

Sigmoid函数的功能

- 把一个实数压缩至0到1之间。

- 当z是非常大的正数时,g(z)会趋近于1

- 而z是非常小的负数时,则g(z)会趋近于0

压缩至0到1有何用处呢?

- 把激活函数看作一种“分类的概率”,比如激活函数的输出为0.9的话便可以解释为90%的概率为正样本。

问题

- 为什么ReLu要好过于Tanh和Sigmoid function?

- 为什么LSTM模型中既存在Sigmoid又存在Tanh两种激活函数?

- 二者目的不一样:

- sigmoid 用在了各种gate上,产生0~1之间的值,这个一般只有sigmoid最直接了。

- tanh 用在了状态和输出上,是对数据的处理,这个用其他激活函数或许也可以。

- 二者目的不一样:

误差分解

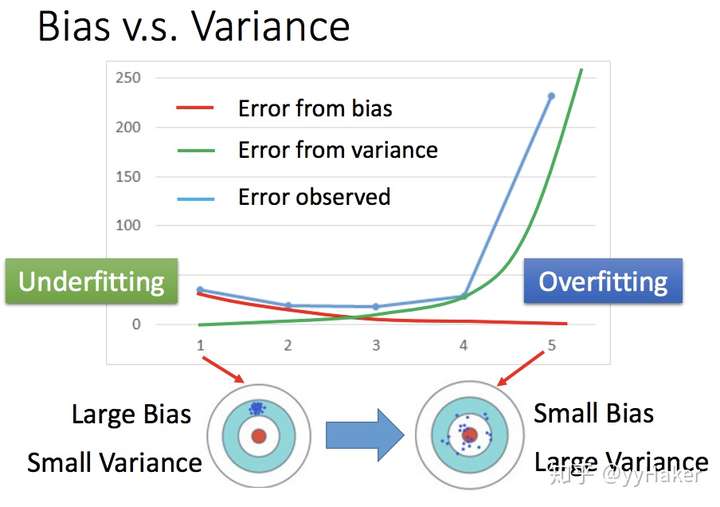

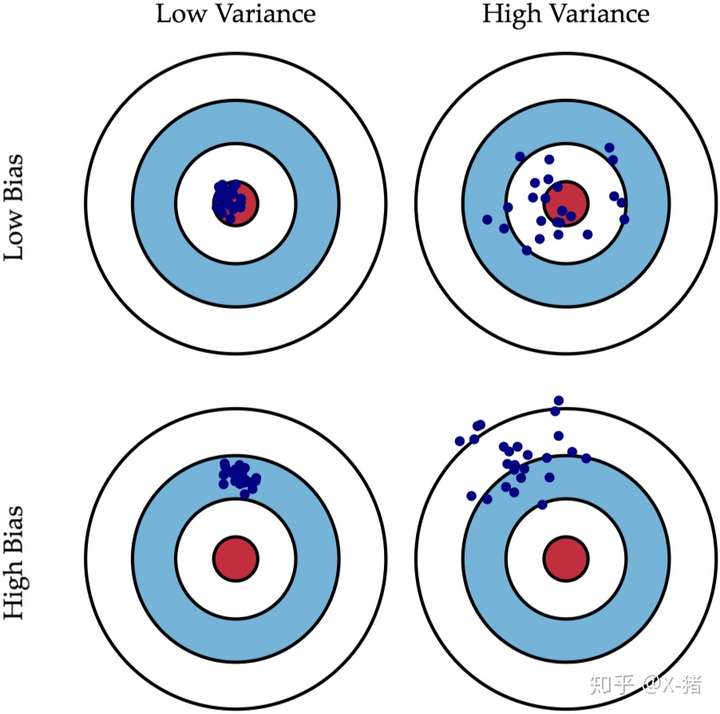

误差分解:偏差方差

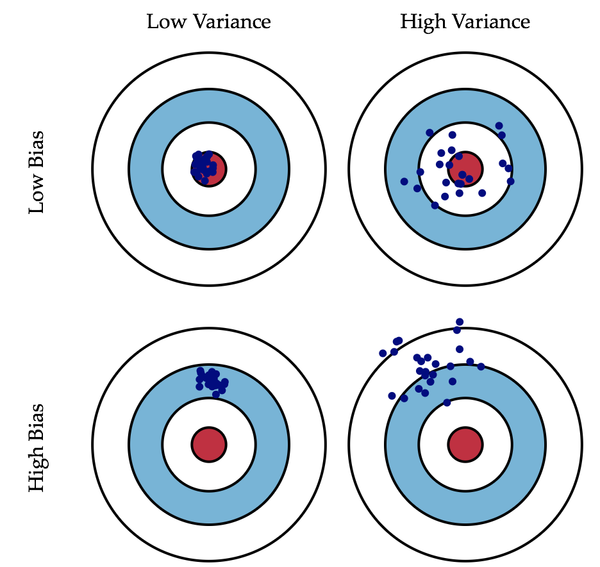

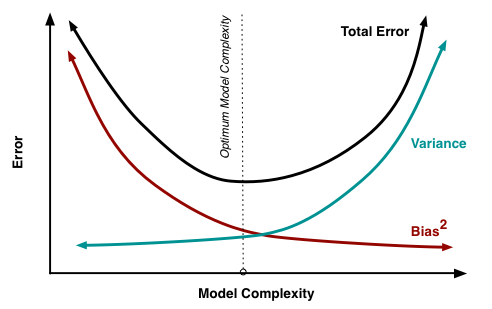

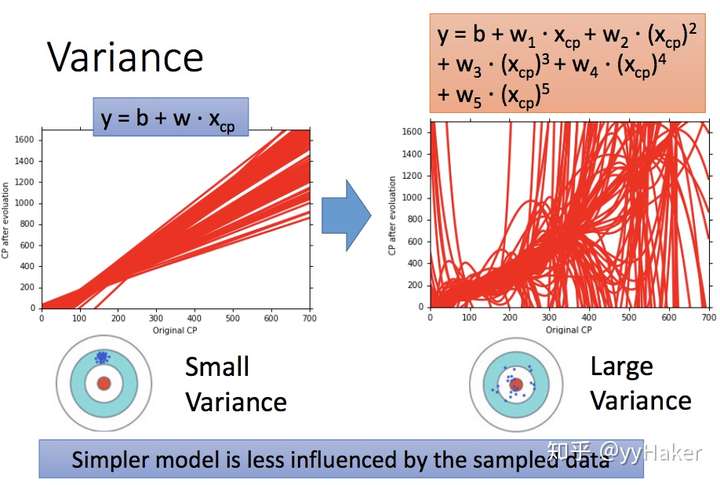

【2022-1-16】广义的偏差(bias)描述的是预测值和真实值之间的差异,方差(variance)描述距的是预测值作为随机变量的离散程度。

- 《Understanding the Bias-Variance Tradeoff》当中有一副图形象地向我们展示了偏差和方差的关系:

-

- 【2021-3-14】偏差、方差关系,偏差Bias和方差Variance——机器学习中的模型选择

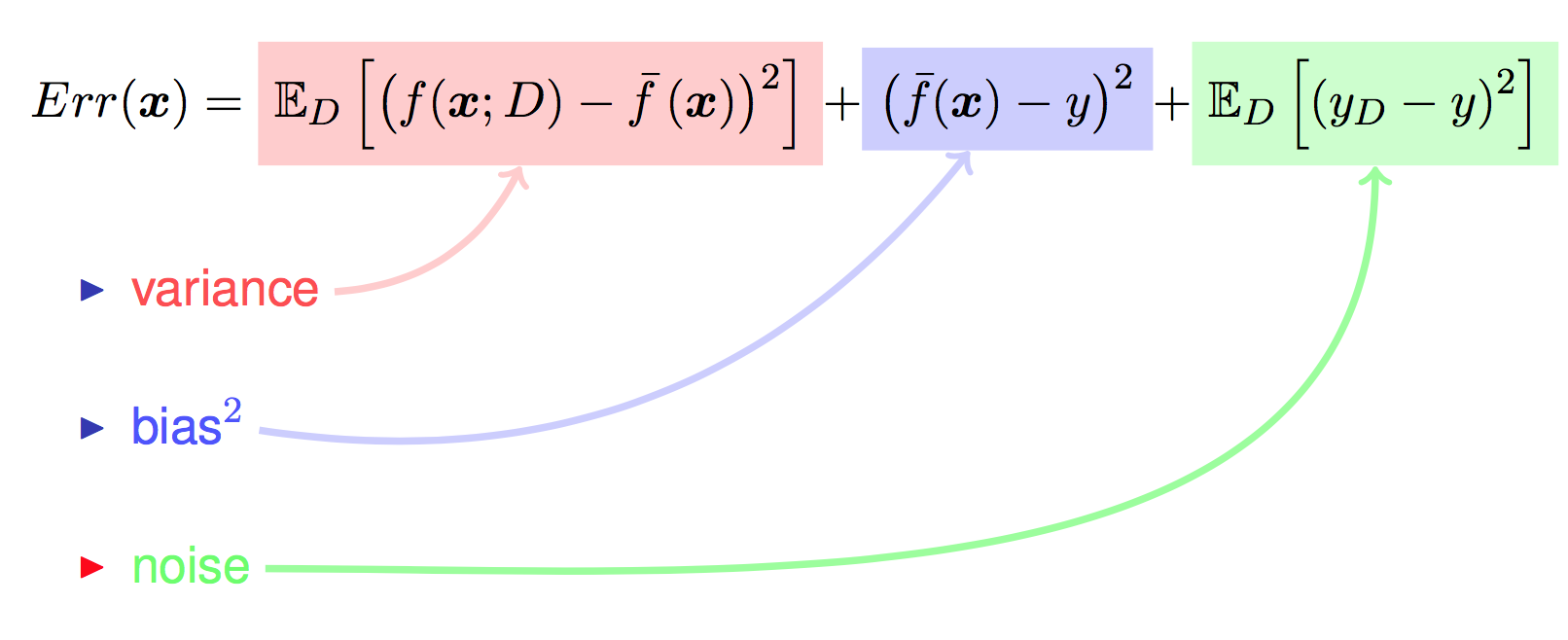

- 误差的期望值可以分解为三个部分:

泛化误差可以分解为偏差(Biase)、方差(Variance)和噪声(Noise) - 误差的期望值 = 噪音的方差 + 模型预测值的方差 + 预测值相对真实值的偏差的平方

- 泛化误差 = 错误率(error) => $ error(x) = {bias}^2(x) + var(x) + \varepsilon^2$

- 解释

- Bias是 f* 的期望到目标模型之间的偏差,Variance是 f* 到 f* 的期望之间的偏差

- 左边是高偏差低方差的情况,右边是低偏差高方差的情况

- 越是越是简单的模型,Variance越小;越是复杂的模型,Variance越大,而且简单的模型更不容易被某些噪声数据所干扰。同样,我们发现越是简单的模型Bias越大,越是复杂的模型Bias越小。

- 越是越是简单的模型,Bias越大Variance越小;越是复杂的模型,Bias越小Variance越大,都会导致泛化误差高。所以,机器学习模型的泛化误差是由Bias和Variance相互影响的

- 误差的期望值可以分解为三个部分:

- 偏差(准)、方差(稳)的选择

- 不同复杂度模型的对比

- 选择相对较好的模型的顺序: 稳 > 准

- 方差小,偏差小(既稳又准) > 方差小,偏差大(稳但不准) > 方差大,偏差小(准但不稳) > 方差大,偏差大(既不准又不稳)。

- 稳定性>精准度:方差小,偏差大 之所以排位靠前,是因为比较稳定。

- 不同复杂度模型的对比

交叉验证

知乎:Xiaotian ZUO

K-fold和Cross validation的区别。

- K-fold的全称就是K-fold cross validation。 Cross validation一般有两种,一种是holdout,一种是k-fold。

- holdout把数据集分成training,validation和test。很多AI项目都会这样来划分。

- k-fold cross validation。介绍算法的时候,一般会称为cross validation,因为字面含义比较清晰;调试的时候,喜欢用k-fold,因为动了k。

交叉验证方法:

- Hold out 留一法: 在训练前,把数据集根据一定比例分成training和test,模型通过training来训练,test来评估。训练的时候常常继续把training分成training和validation,使用validation的反馈来帮助调整参数。严格来说,并不完全可以算作cross validation。

- k-fold cross validation(k折交叉验证): 数据量不够大时,或者想追求更精确的训练结果时,可以将数据集均匀分成k份,每次用其中的一份数据集作为test,其它的k-1份作为training,学习k次,最后得到k个模型,用k个模型预测的平均值作为结果。

- leave-p-out cross validation(留p交叉验证): 遍历数据集中所有可能的p个数据的组合,分别做测试集,每次使用剩下的数据作为训练集。不是特别常用,因为复杂度太高,得到的模型个数是阶乘级别。 另外有一些延伸的奇技淫巧,包括但不限于:

- leave-one-out cross validation(留1交叉验证): 每次只使用一份数据,而不是一份数据集来作为测试集。等于p为1的留p验证,也等于k为数据集大小的k折验证。

- Iterated K-fold validation with shuffling: 每次都进行数据随机排列,然后进行完整的k-fold。适用于数据量小的情况。

- 嵌套k-fold,不怎么常见,但是可以了解一下。在工业级别的项目上,目前我还没使用过这个。

【2022-9-25】交叉验证主要有三种说法:一文彻底理解:训练集,验证集,测试集,交叉验证

- 李航老师的《统计学习方法》中模型选择方法分为两类,一个是正则化,一个是交差验证,交叉验证又分为简单交叉验证、s折交叉验证、留一交叉验证。

- 周志华老师的《机器学习》中,模型评估有三种方式,留出法、交叉验证(分为 k 折交叉验证和留一法)、自助法。

- sklearn 官方文档中,train_test_split 作为留出法的实现方式,而交叉验证进行数据集划分(迭代器)又分为K折(KFold)、p 次 k 折交(RepeatedKFold)、留一(LeaveOneOut )、留 p(LeavePOut)、随机(ShuffleSplit)等等

泛化

常规机器学习流程:

- 训练集上训练模型,验证集调参,最终测试集上的表现作为模型的泛化能力

什么是泛化能力

什么是泛化能力?

- 机器学习算法对新鲜样本的适应能力 —— 模型对未知数据的预测能力

- 学习的目的是学到隐含在数据背后的规律,对具有同一规律的学习集以外的数据,经过训练的网络也能给出合适的输出,该能力称为泛化能力。

奥卡姆剃刀定律在机器学习方面的运用如下:

- 机器学习模型越简单,良好的实证结果就越有可能不仅仅基于样本的特性。

- 现今将奥卡姆剃刀定律正式应用于统计学习理论和计算学习理论领域。这些领域已经形成了泛化边界,即统计化描述模型根据以下因素泛化到新数据的能力:

- 模型的复杂程度

- 模型在处理训练数据方面的表现 虽然理论分析在理想化假设下可提供正式保证,但在实践中却很难应用。机器学习速成课程则侧重于实证评估,以评判模型泛化到新数据的能力。

机器学习模型旨在根据以前未见过的新数据做出良好预测。但是,如果要根据数据集构建模型,如何获得以前未见过的数据呢?一种方法是将您的数据集分成两个子集:

- 训练集:用于训练模型的子集。

- 测试集:用于测试模型的子集。

在测试集上表现是否良好是衡量能否在新数据上表现良好的有用指标,前提是:

- 测试集足够大。

- 不会反复使用相同的测试集来作假。

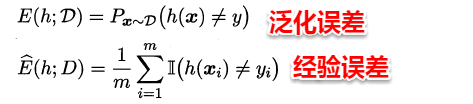

各种误差:

- 模型对训练集数据的误差称为经验误差,对测试集数据的误差称为泛化误差。模型对训练集以外样本的预测能力就称为模型的泛化能力,追求这种泛化能力始终是机器学习的目标

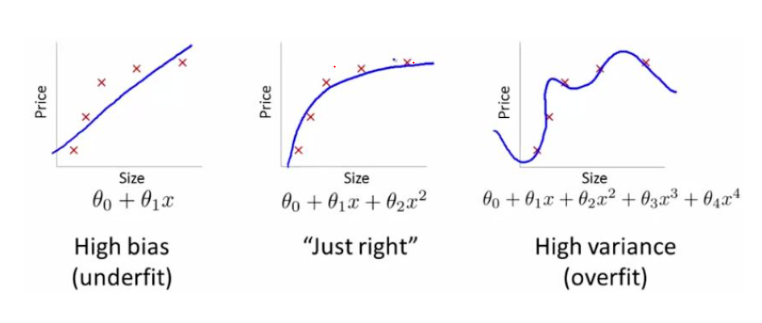

过拟合(overfitting)和欠拟合(underfitting)是导致模型泛化能力不高的两种常见原因,都是模型学习能力与数据复杂度之间失配的结果。“欠拟合”常常在模型学习能力较弱,而数据复杂度较高的情况出现,此时模型由于学习能力不足,无法学习到数据集中的“一般规律”,因而导致泛化能力弱。与之相反,“过拟合”常常在模型学习能力过强的情况中出现,此时的模型学习能力太强,以至于将训练集单个样本自身的特点都能捕捉到,并将其认为是“一般规律”,同样这种情况也会导致模型泛化能力下降。过拟合与欠拟合的区别在于,欠拟合在训练集和测试集上的性能都较差,而过拟合往往能较好地学习训练集数据的性质,而在测试集上的性能较差。在神经网络训练的过程中,欠拟合主要表现为输出结果的高偏差,而过拟合主要表现为输出结果的高方差

欠拟合

欠拟合出现原因

- 模型复杂度过低

- 特征量过少

- 欠拟合的情况比较容易克服,常见解决方法有

- 增加新特征,可以考虑加入进特征组合、高次特征,来增大假设空间

- 添加多项式特征,这个在机器学习算法里面用的很普遍,例如将线性模型通过添加二次项或者三次项使模型泛化能力更强

- 减少正则化参数,正则化的目的是用来防止过拟合的,但是模型出现了欠拟合,则需要减少正则化参数

- 使用非线性模型,比如核SVM 、决策树、深度学习等模型

- 调整模型的容量(capacity),通俗地,模型的容量是指其拟合各种函数的能力

- 容量低的模型可能很难拟合训练集;使用集成学习方法,如Bagging ,将多个弱学习器Bagging

过拟合

什么是过拟合?

- 虽然绿色的分类面可以完美地将两组数据分开,但是这个分类面对训练集非常敏感,在测试机上的效果很有可能不如黑色的分类面。

- 网上有人找到一张将过拟合非常有意思的图,过拟合可以将任何东西都看成模型想看成的东西,也许古代对星座的划分也算得上是一种过拟合吧!

过拟合出现原因

- 建模样本选取有误,如样本数量太少,选样方法错误,样本标签错误等,导致选取的样本数据不足以代表预定的分类规则

- 样本噪音干扰过大,使得机器将部分噪音认为是特征从而扰乱了预设的分类规则

- 假设的模型无法合理存在,或者说是假设成立的条件实际并不成立

- 参数太多,模型复杂度过高

- 对于决策树模型,如果我们对于其生长没有合理的限制,其自由生长有可能使节点只包含单纯的事件数据(event)或非事件数据(no event),使其虽然可以完美匹配(拟合)训练数据,但是无法适应其他数据集

- 对于神经网络模型:

- a)对样本数据可能存在分类决策面不唯一,随着学习的进行,,BP算法使权值可能收敛过于复杂的决策面;

- b)权值学习迭代次数足够多(Overtraining),拟合了训练数据中的噪声和训练样例中没有代表性的特征

过拟合的根本原因: 用有限的观测样本去估计整体

- 对于参数化模型 P(Y|X;θ),通过极大似然估计来估计参数θ。

- 如果观测样本十分有限,而模型的拟合能力又很强,那么最后一个等式的误差会非常大

- 对于非参数模型,通常需要利用观测样本的一个子集来估计期望值等总体的统计量。

- 例如决策树模型,在每个叶子节点上,只用到满足该叶子节点对应规则的样本来估计期望值——正例的概率或者目标的期望值。 如果样本有限而决策树的叶子节点又特别多(模型复杂度高),那么落到一个叶子节点的样本数就非常有限,导致估计的误差很大!

过拟合的解决方案

- 正则化(Regularization)(L1和L2)

- 数据扩增,即增加训练数据样本

- Dropout

- Early stopping

泛化危机

【2022-10-21】神经网络的泛化跟内插外推无关,因为高维学习几乎总是对应着外推

- Learning in High Dimension Always Amounts to Extrapolation, Yann LeCun领导的FAIR团队关于澄清深度学习泛化能力的研究结论。

- 数学上,深度学习可以看作是函数逼近,自然而然地,一些研究把函数逼近里的数据

内插、外推概念应用到深度学习的解释上。 - 概念上,在一维数据,

内插对应样本在数据集的区间内,外插对应样本在数据集的区间外; - 拓展到高维,内插和外插分别对应样本在数据集的

凸包(convex hull)边界之内和之外。 - 据此,产生了对深度学习泛化能力如此之好的一种几何逻辑上非常直观合理的直觉解释:

- 测试样本是训练数据集的

内插,也就是测试样本在训练数据集的凸包之内,因为模型训练时training loss几乎为零,即完全拟合训练数据集,所以,测试样本的泛化性能非常棒。不同任务之间的迁移学习或者预训练也可以类似解释。Almost perfect theory!

- 测试样本是训练数据集的

- FAIR的论文利用综合数据集和实际数据集从理论和实验两方面说明

- 在高维(>100)空间里内插发生的概率几乎为零,无论数据集的

本质维数(intrinsic dimension)是多大。也就是说,从内插外推的维度来理解深度学习泛化的努力可以放弃了,基于数据集内插假设的研究成果都是误解。

- 在高维(>100)空间里内插发生的概率几乎为零,无论数据集的

【2021-11-28】泛化性的危机!LeCun发文质疑:测试集和训练集永远没关系

杨立昆(Yann LeCun)

- (1)机器学习固有观念都错了

- ① 算法之所以起作用,是因为能正确的内插训练数据

- ② 测试集上表现好的模型,泛化性能就好

- ③ 泛化性能取决于插值方式:内插、外推

- ④ 机器学习任务+数据集中,只有内插,没有外推(ood呢?)

- (2)泛化危机

- ① 无论数据流形(data manifold)的基本本征维数(intrinstic dimension)如何,内插都不会出现在高维空间(>100)中。

- ② 由于实际使用的数据量(受限于计算能力),新样本极不可能位于该数据集的convex hull里(即内插),当前任务基本都是外推

- ③ 外推并不能体现模型的泛化能力,也不该用内插、外推作为泛化性能指标。

- ④ 数据集大小应该相对于数据维度呈指数增长

- 高维空间下,测试集和训练集没有关系,模型做的一直只有外推没有内插,那么刷榜竞赛还有意义吗?

- (3)那怎么办?

- 构建合适的内插、外推几何定义,与泛化能力保持一致

观点:

在测试集上表现更好的模型,泛化性一定更好。

不一定!

内插(interpolation)和外推(extrapolation)是机器学习、函数近似(function approximation)中两个重要的概念。

- 机器学习中,当一个测试样本的输入处于训练集输入范围时,模型预测过程称为「内插」,而落在范围外时,称为「外推」。

- 数学角度,外推其实是与内插并列的一个概念。多项式插值、样条插值等插值方法中,通过已知的、离散的数据点,在范围内推求新数据点,即称为内插(Interpolation)。而如果在已知数据在范围外推求新数据点,则是外推(Extrapolate)。

一直以来深度学习的研究都依赖于两个概念:

- 最先进的算法之所以工作得这么好,是因为它们能够正确地内插训练数据;

- 在任务和数据集中只有内插,而没有外推。 图灵奖得主Yann LeCun团队在arxiv挂了一篇论文公开质疑这两个概念是错误的

从理论上和经验上来说,无论是合成数据还是真实数据,几乎可以肯定的是无论数据流形(data manifold)的基本本征维数(intrinstic dimension)如何,内插都不会出现在高维空间(>100)中。

- 本征维度即在降维或者压缩数据过程中,为了让你的数据特征最大程度的保持,你最低限度需要保留哪些features,它同时也告诉了可以把数据压缩到什么样的程度,所以你需要了解哪些 feature 对数据集影响是最大的。

考虑到当前计算能力可以承载的实际数据量,新观察到的样本极不可能位于该数据集的convex hull中。因此,他们得出了两个结论:

- 目前使用和研究的模型基本都是外推的了;

- 鉴于这些模型所实现的超越人类的性能,外推机制也不一定非要避免,但这也不是泛化性能的指标。 可能有人认为像图像这样的数据可能位于低维流形上,因此从直觉和经验上认为无论高维环境空间如何,内插都会发生。但这种直觉会产生误导,事实上,即使在具有一维流形的极端情况下,底层流形维度也不会变化。

内插和外推提供了一种关于给定数据集的新样本位置的直观几何特征,这些术语通常被用作几何代理来预测模型在看不见的样本上的性能。从以往的经验来看似乎已经下了定论,即模型的泛化性能取决于模型的插值方式。这篇文章通过实验证明了这个错误观念。并且研究人员特别反对使用内插和外推作为泛化性能的指标,从现有的理论结果和彻底的实验中证明,为了保持新样本的插值,数据集大小应该相对于数据维度呈指数增长。简而言之,模型在训练集内的行为几乎不会影响该模型的泛化性能,因为新样本几乎肯定位于该凸包(convex)之外。

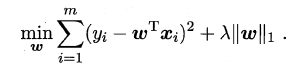

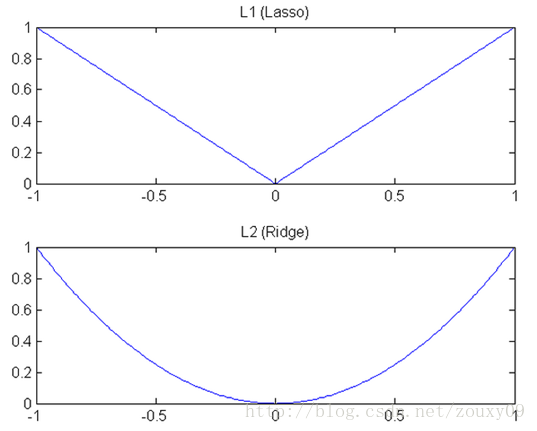

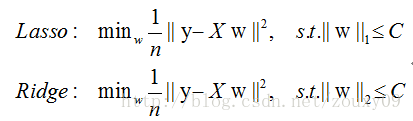

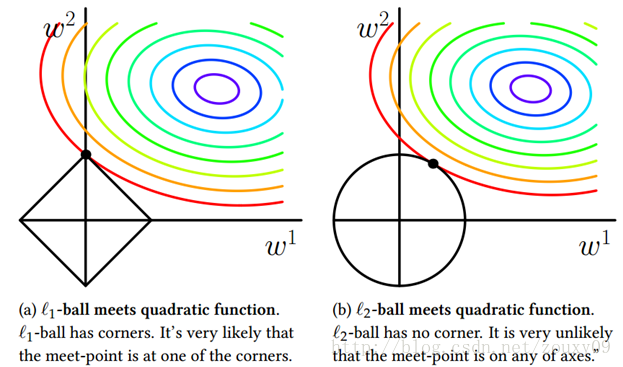

正则化: L1 & L2

正则化解决过拟合问题

- 求解模型最优解一般优化最小经验风险

- 在经验风险上加入模型复杂度这一项(正则化项是模型参数向量的范数),并使用一个rate比率来权衡模型复杂度与以往经验风险权重,如果模型复杂度越高,结构化的经验风险会越大,现在的目标就变为了结构经验风险的最优化,可以防止模型训练过度复杂,有效的降低过拟合的风险。

奥卡姆剃刀原理,能解释已知数据且简单才是最好的模型。

L1范数(L1 norm,Losso回归)指向量中各个元素绝对值之和,也叫“稀疏规则算子”(Lasso regularization,岭回归)。

- 比如 向量

A=[1,-1,3], 那么A的L1范数为|1|+|-1|+|3|.

简单总结一下就是:

L1范数: 为x向量各个元素绝对值之和。L2范数: 为x向量各个元素平方和的1/2次方,L2范数又称 Euclidean范数 或 Frobenius范数Lp范数: 为x向量各个元素绝对值p次方和的1/p次方。

支持向量机学习过程中,L1范数实际是一种对于成本函数求解最优的过程,因此,L1范数正则化通过向成本函数中添加L1范数,使得学习得到的结果满足稀疏化,从而方便人类提取特征。

- L1范数可以使权值稀疏,方便特征提取。

- L2范数可以防止过拟合,提升模型的泛化能力。

L1和L2正则先验分别服从什么分布

- L1是

拉普拉斯分布 - L2是

高斯分布

梯度下降

梯度下降最快吗

梯度下降法并不是下降最快的方向,它只是目标函数在当前的点的切平面(当然高维问题不能叫平面)上下降最快的方向。

- 牛顿方向(考虑海森矩阵)一般被认为是下降最快的方向,可以达到Superlinear的收敛速度。

- 梯度下降类的算法的收敛速度一般是Linear甚至Sublinear的(在某些带复杂约束的问题)。

牛顿法和梯度下降法有什么不同?拟牛顿法(Quasi-Newton Methods),共轭梯度法

最小二乘法(又称最小平方法)是一种数学优化技术。它通过最小化误差的平方和寻找数据的最佳函数匹配。利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和为最小。

梯度消失/爆炸

如何解决梯度消失和梯度膨胀?

- 链式法则:每一层神经元对上一层输出的偏导乘上权重

- 反向传播中链式法则带来的连乘,如果有数很小趋于0,结果就会特别小(梯度消失);如果数都比较大,可能结果会很大(梯度爆炸)。

(1)梯度消失:

- 如果都小于1,那么即使是0.99,经过足够多层传播之后,误差对输入层的偏导会趋于0。

- 解法:采用ReLU激活函数有效解决梯度消失。

(2)梯度膨胀:

- 如果都大于1,经过足够多层传播之后,误差对输入层的偏导会趋于无穷大

- 解法:通过激活函数来解决。或 提取截断

评估方法

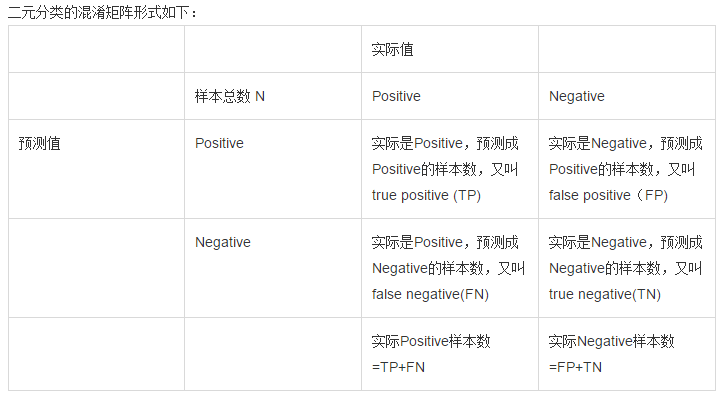

TP、FN(真的判成假的)、FP(假的判成真)、TN四种(可以画一个表格)

常用的指标:

- 精度precision = TP/(TP+FP) = TP/~P (~p为预测为真的数量)

- 召回率 recall = TP/(TP+FN) = TP/ P

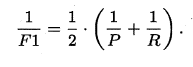

- F1值:2/F1 = 1/recall + 1/precision

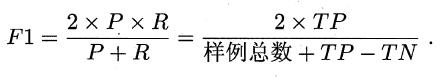

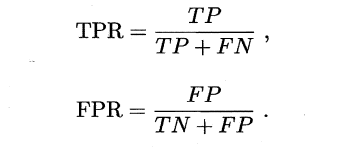

- ROC曲线:ROC空间是一个以伪阳性率(FPR,false positive rate)为X轴,真阳性率(TPR, true positive rate)为Y轴的二维坐标系所代表的平面。其中真阳率TPR = TP P = recall, 伪阳率FPR = FP N

算法分析

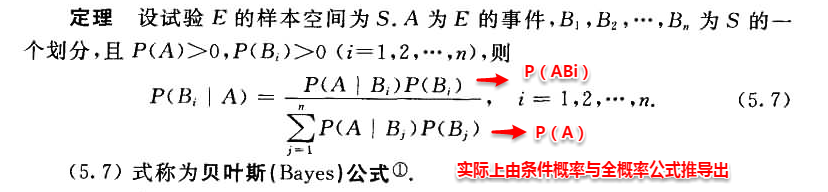

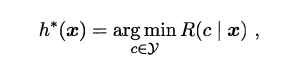

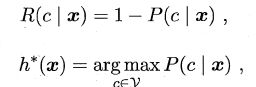

贝叶斯

概念

-

条件概率(又称后验概率):事件A在另外一个事件B已经发生条件下的发生概率。条件概率表示为P(A B),读作“在B条件下A的概率”。 - 联合概率:两个事件共同发生的概率。A与B的联合概率表示为P(A∩B)或者P(A,B)。

- 边缘概率(又称先验概率):某个事件发生的概率。

- 边缘概率获取方式:联合概率中,把最终结果中那些不需要的事件通过合并成它们的全概率,而消去它们(对离散随机变量用求和得全概率,对连续随机变量用积分得全概率),这称为边缘化(marginalization),比如A的边缘概率表示为P(A),B的边缘概率表示为P(B)。

为什么朴素贝叶斯如此“朴素”?

- 假定所有特征在数据集中同样重要且独立。

- 实际上,这个假设在现实世界中不真实,因此,说朴素贝叶斯真的很“朴素”。

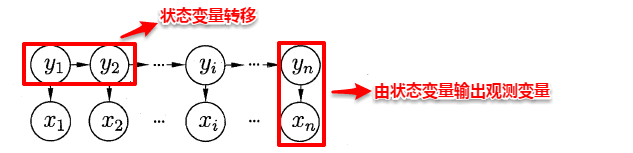

CRF/HMM

CRF,HMM(隐马模型),MEMM(最大熵隐马模型)都常用来做序列标注建模。

- 隐马模型最大的缺点: 由于其输出独立性假设,导致其不能考虑上下文的特征,限制了特征的选择。

- 最大熵隐马模型解决了隐马的问题,可以任意选择特征,但由于其在每一节点都要进行归一化,所以只能找到局部最优值,同时也带来了标记偏见的问题,即凡是训练语料中未出现的情况全都忽略掉。

- 条件随机场很好的解决了这一问题,不在每个节点归一化,而是所有特征进行全局归一化,因此可以求得全局最优值。

总结:进化过程

CRF->HMM->MEMM

对比

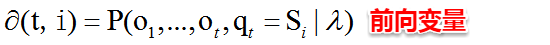

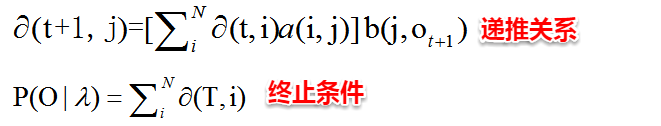

- EM算法:只有观测序列,无状态序列时来学习模型参数,即Baum-Welch算法

- 维特比算法:用动态规划解决HMM的预测问题,不是参数估计

- 前向后向算法:用来算概率

- 极大似然估计:即观测序列和相应的状态序列都存在时的监督学习算法,用来估计参数

SVD/PCA

SVD和PCA

- PCA的理念是使得数据投影后的方差最大,找到这样一个投影向量,满足方差最大的条件即可。

- 而经过了去除均值的操作之后,就可以用SVD分解来求解这样一个投影向量,选择特征值最大的方向。

K-Means

Kmeans的复杂度?

- 时间复杂度:O(tKmn),其中,t为迭代次数,K为簇的数目,m为记录数,n为维数

- 空间复杂度:O((m+K)n),其中,K为簇的数目,m为记录数,n为维数。

优化

- 用Kd树 或 Ball Tree 将所有观测实例构建成一颗 kd树,之前每个聚类中心都是需要和每个观测点做依次距离计算,现在这些聚类中心根据kd树只需要计算附近的一个局部区域即可。

- K-means++算法:选择初始seeds的基本思想,初始的聚类中心之间的相互距离要尽可能的远。

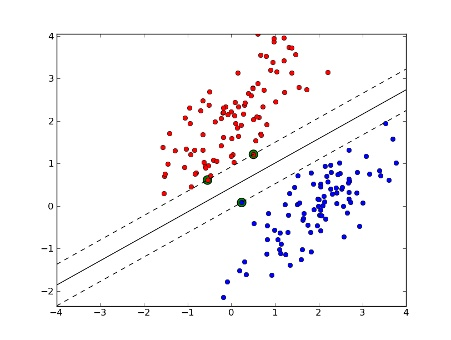

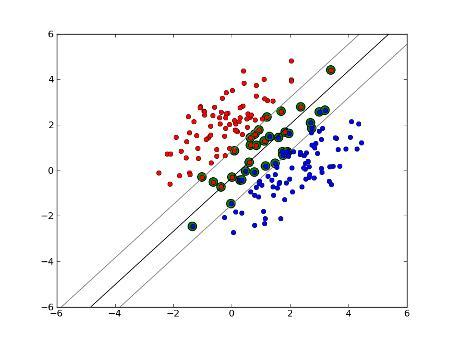

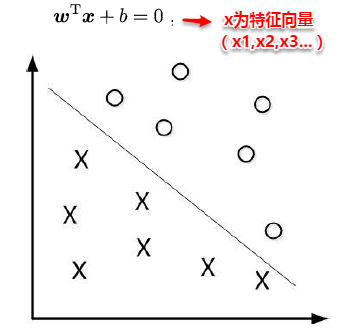

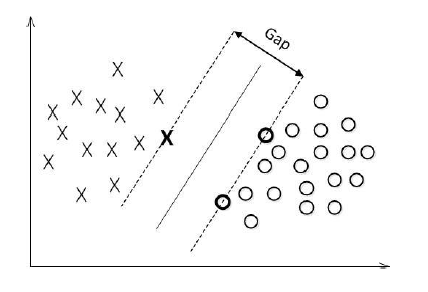

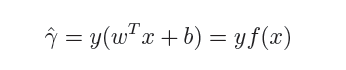

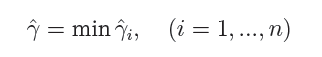

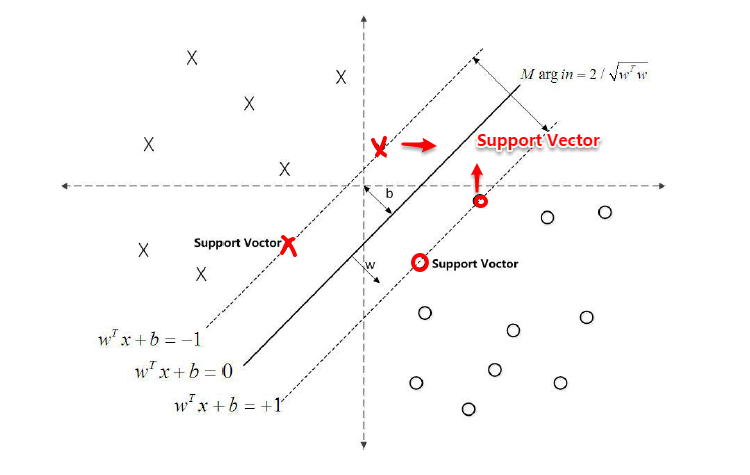

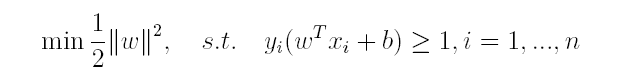

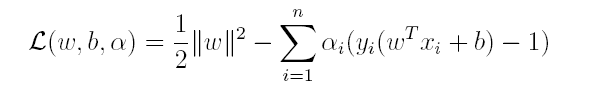

SVM

SVM,全称是support vector machine,中文名叫支持向量机。SVM是一个面向数据的分类算法,它的目标是为确定一个分类超平面,从而将不同的数据分隔开。

支持向量机学习方法包括构建由简至繁的模型:线性可分支持向量机、线性支持向量机及非线性支持向量机。

- 当训练数据线性可分时,通过硬间隔最大化,学习一个线性的分类器,即线性可分支持向量机,又称为硬间隔支持向量机;

- 当训练数据近似线性可分时,通过软间隔最大化,也学习一个线性的分类器,即线性支持向量机,又称为软间隔支持向量机;

- 当训练数据线性不可分时,通过使用核技巧及软间隔最大化,学习非线性支持向量机。

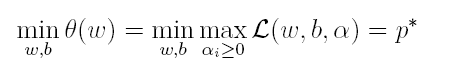

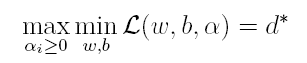

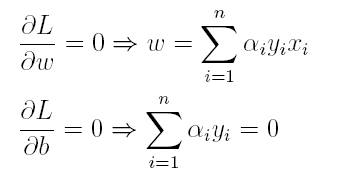

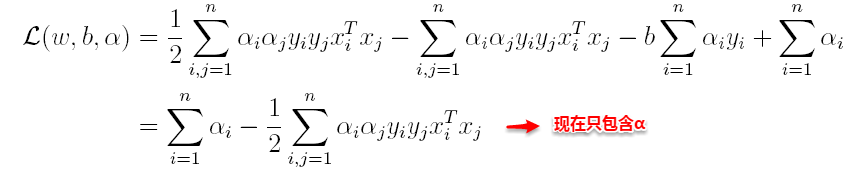

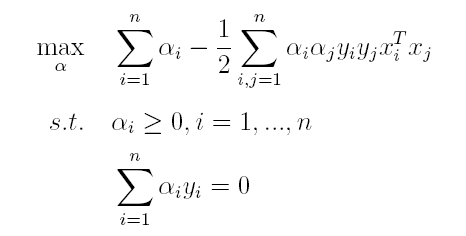

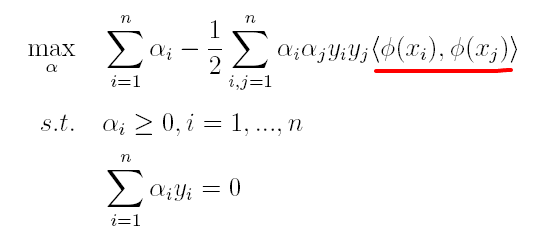

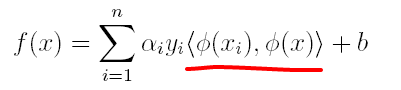

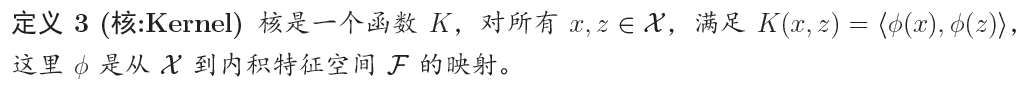

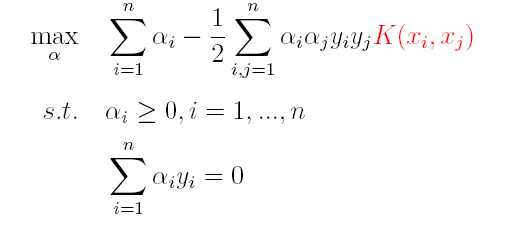

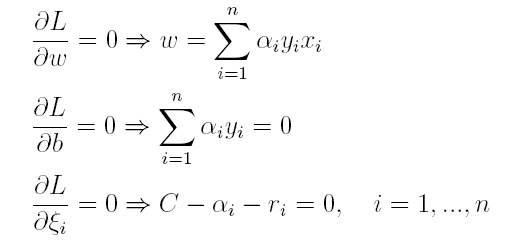

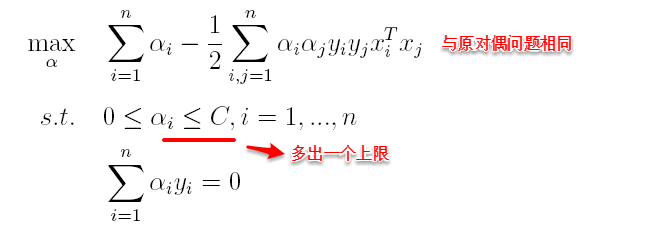

优化问题从两个角度进行考察,一个是 primal 问题,一个是 dual 问题,对偶问题

- 一般情况下对偶问题给出主问题最优值的下界,在强对偶性成立的情况下由对偶问题可以得到主问题的最优下界,对偶问题是凸优化问题,可以进行较好的求解

- SVM中就是将Primal问题转换为dual问题进行求解,从而进一步引入核函数的思想。

GBDT

GBDT(Gradient Boosting Decision Tree)算法

相比 ID3 和 C4.5 只能进行分类任务,CART 还可以进行回归任务,是目前最主流的决策树算法

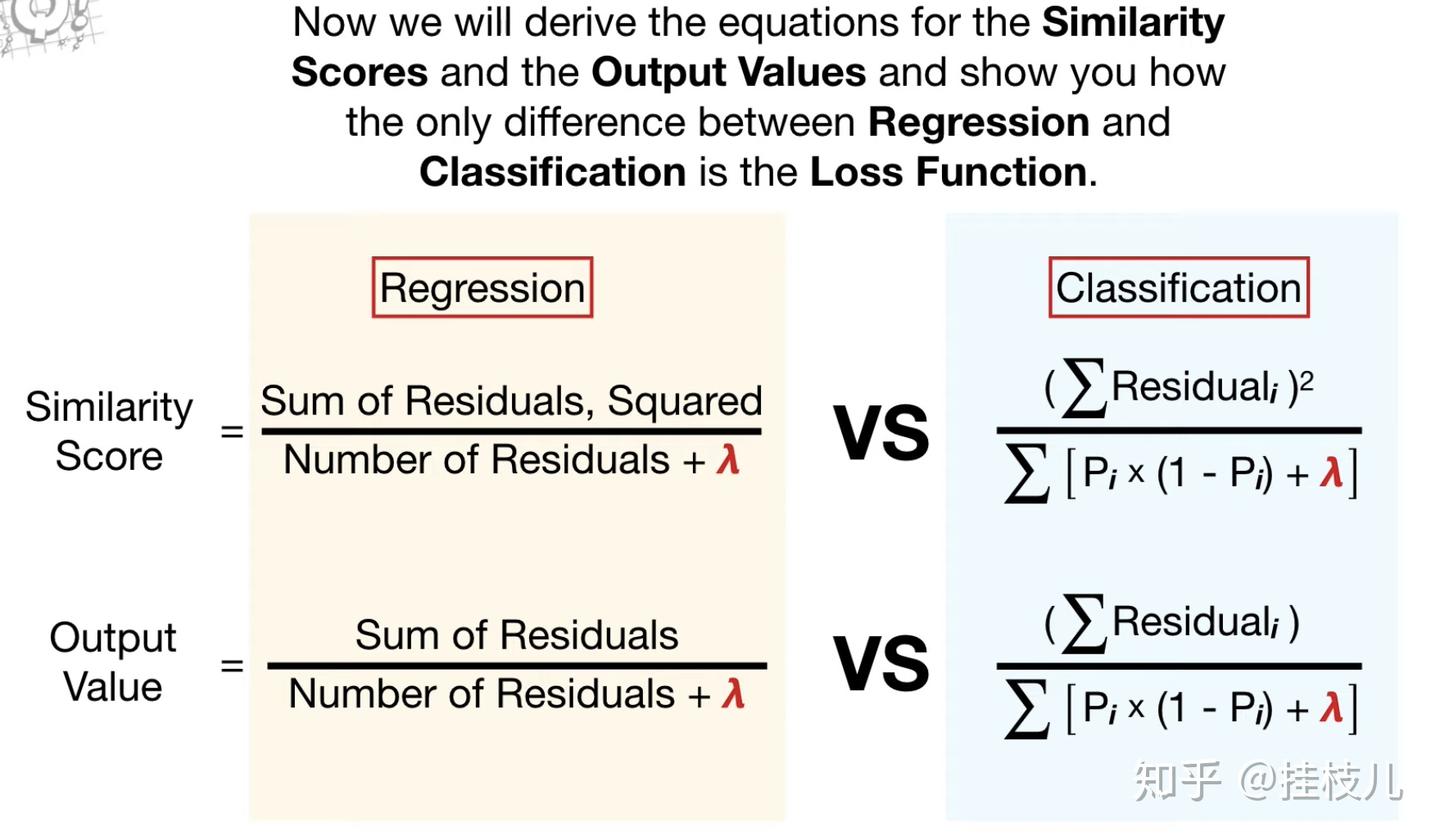

XGBoost

XGBoost 类似于 GBDT 的优化版,不论是精度还是效率上都有了提升。

与GBDT相比,具体优点有:

- 损失函数是用泰勒展式二项逼近,而不是像GBDT里的就是一阶导数;

- 对树的结构进行了正则化约束,防止模型过度复杂,降低了过拟合的可能性;

- 节点分裂的方式不同,GBDT是用的基尼系数,XGBoost是经过优化推导后的。

XGBoost 的一些特点

- 速度快:计算效率很高,尤其适合大数据。

- XGBoost的并行是在特征粒度上

- 准确性高:

- XGBoost 在比赛和实际应用中常常表现优异,因为它在训练过程中逐步减少误差。

- 可以防止过拟合:

- XGBoost 有一些机制可以防止模型过度拟合,比如设置最大深度、学习率等参数。

XGBoost 像很多「小树」组成的团队,这些小树各自负责一部分任务,彼此互相纠正错误,最终得出一个更加准确的预测。对于大部分表格数据问题,比如预测价格、用户行为等,XGBoost 都是一个表现很好的选择。

为什么XGBoost要用泰勒展开,优势在哪里?

- XGBoost用一阶和二阶偏导, 二阶导数有利于梯度下降的更快更准. 使用泰勒展开取得二阶倒数形式, 可以在不选定损失函数具体形式的情况下用于算法优化分析. 本质上也就把损失函数的选取和模型算法优化/参数选择分开了. 这种去耦合增加了XGBoost的适用性。

XGBoost 如何寻找最优特征?是又放回还是无放回的呢?

- XGBoost 在训练的过程中给出各个特征的评分,从而表明每个特征对模型训练的重要性.

- XGBoost 利用梯度优化模型算法, 样本是不放回的(想象一个样本连续重复抽出,梯度来回踏步会不会高兴)。但XGBoost支持子采样, 也就是每轮计算可以不使用全部样本。

XGBoost 特别擅长解决结构化数据问题,比如表格数据。

- 全称「eXtreme Gradient Boosting」,意思是「极限梯度提升」

XGBoost 是梯度提升的升级版,很多细节上做了优化,训练更快、效果更好。

比如

- 用「并行计算」技术,让计算机同时进行多个计算,大大加速了训练速度。

- 一些优化的数学技巧,可以不损失准确性的前提下更快地找到答案。

原理

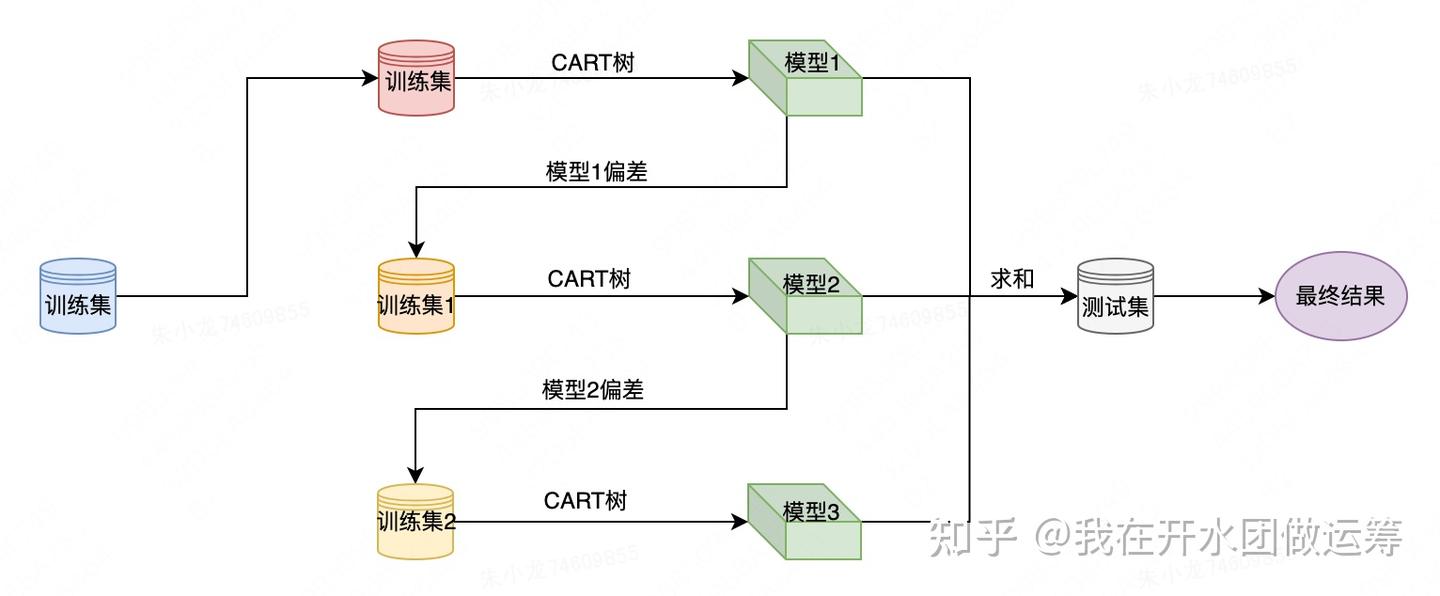

xgboost 算法流程

针对训练集

- xgboost 先用 CART树 训练得到一个模型,每个样本都会产生一个偏差值;

- 然后将样本偏差值作为新的训练集,继续使用CART树训练得到一个新模型;

- 以此重复,直至达到某个退出条件为止。

算法流程图

回归、分类任务的区别在于损失函数

- 分类:损失函数用 logloss 等

- 回归: 损失函数用 rmse 等

分类树、回归树 算法思想一致,都是在XGBOOST框架下,不停的去拟合上一轮的残差(都是0.5分开始)

两者的损失函数不同,造成两者生长的策略有所不同,导致 XGBOOST 参数像是 minchildweight 设置的值域也不同.

实现

XGBoost 进行分类任务的基本示例

Python实现

- xgboost 库

- sklearn 库

xgboost 库

xgboost 是大规模并行 boosted tree 的工具

- 陈天奇 Tianqi Chen and Carlos Guestrin.

- 论文 XGBoost: A Scalable Tree Boosting System

- 目前最快最好的开源boosted tree工具包,比常见的工具包快10倍以上

- kaggle比赛的夺冠方案

XGBoost的优点

- 正则化

- XGBoost在代价函数里加入了正则项,用于控制模型的复杂度。正则项里包含了树的叶子节点个数、每个叶子节点上输出的score的L2模的平方和。从Bias-variance tradeoff角度来讲,正则项降低了模型的variance,使学习出来的模型更加简单,防止过拟合,这也是xgboost优于传统GBDT的一个特性。

- 并行处理

- XGBoost工具支持并行。Boosting不是一种串行的结构吗?怎么并行的?注意XGBoost的并行不是tree粒度的并行,XGBoost也是一次迭代完才能进行下一次迭代的(第t次迭代的代价函数里包含了前面t-1次迭代的预测值)。XGBoost的并行是在特征粒度上的。

- 决策树的学习最耗时的一个步骤就是对特征的值进行排序(因为要确定最佳分割点),XGBoost在训练之前,预先对数据进行了排序,然后保存为block结构,后面的迭代中重复地使用这个结构,大大减小计算量。这个block结构也使得并行成为了可能,在进行节点的分裂时,需要计算每个特征的增益,最终选增益最大的那个特征去做分裂,那么各个特征的增益计算就可以开多线程进行。

- 灵活性

- XGBoost支持用户自定义目标函数和评估函数,只要目标函数二阶可导就行。

- 缺失值处理

- 对于特征的值有缺失的样本,xgboost可以自动学习出它的分裂方向

- 剪枝

- XGBoost 先从顶到底建立所有可以建立的子树,再从底到顶反向进行剪枝。比起GBM,这样不容易陷入局部最优解。

- 内置交叉验证

- XGBoost允许在每一轮boosting迭代中使用交叉验证。因此,可以方便地获得最优boosting迭代次数。而GBM使用网格搜索,只能检测有限个值。

多种数据格式:

- libsvm 格式的文本数据;

- Numpy 二维数组;

- XGBoost 二进制的缓存文件。

加载的数据存储在对象 DMatrix 中

data = np.random.rand(5,10) # 5 entities, each contains 10 features

label = np.random.randint(2, size=5) # binary target

dtrain = xgb.DMatrix( data, label=label) # numpy 格式

dtrain1 = xgb.DMatrix('train.svm.txt') # libsvm 格式

XGBoost 使用 key-value字典的方式存储参数

params = {

'booster': 'gbtree',

'objective': 'multi:softmax', # 多分类的问题

'num_class': 10, # 类别数,与 multisoftmax 并用

'gamma': 0.1, # 用于控制是否后剪枝的参数,越大越保守,一般0.1、0.2这样子。

'max_depth': 12, # 构建树的深度,越大越容易过拟合

'lambda': 2, # 控制模型复杂度的权重值的L2正则化项参数,参数越大,模型越不容易过拟合。

'subsample': 0.7, # 随机采样训练样本

'colsample_bytree': 0.7, # 生成树时进行的列采样

'min_child_weight': 3,

'silent': 1, # 设置成1则没有运行信息输出,最好是设置为0.

'eta': 0.007, # 如同学习率

'seed': 1000,

'nthread': 4, # cpu 线程数

}

更多: xgboost用法

回归

用 XGBoost 进行销售预测

import xgboost as xgb

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

# 加载数据集

data = pd.read_csv("sales_data.csv")

# 划分特征和标签

X = data.drop(columns=["Sales"])

y = data["Sales"]

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 定义XGBoost回归器

model = xgb.XGBRegressor()

# 训练模型

model.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = model.predict(X_test)

# 计算均方根误差(RMSE)

rmse = mean_squared_error(y_test, y_pred, squared=False)

print("Root Mean Squared Error:", rmse)

分类:

- 用 XGBoost 构建风险评分模型

import xgboost as xgb

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 定义参数

params = {'objective': 'multi:softmax', 'num_class': 3, 'eta': 0.1, 'max_depth': 3}

# 转换数据集格式

dtrain = xgb.DMatrix(X_train, label=y_train)

dtest = xgb.DMatrix(X_test, label=y_test)

# 训练模型

model = xgb.train(params, dtrain, num_boost_round=100)

# 预测

y_pred = model.predict(dtest)

# 评估模型

accuracy = accuracy_score(y_test, y_pred)

print("Accuracy:", accuracy)

sklearn 库

用XGBoost对医疗数据进行分类

import xgboost as xgb

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

# 加载数据集

data = load_iris()

X, y = data.data, data.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 定义XGBoost分类器

model = xgb.XGBClassifier()

# 训练模型

model.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = model.predict(X_test)

# 打印分类报告

print("Classification Report:")

print(classification_report(y_test, y_pred))

Python 实现

参考: csdn

代码

### XGBoost定义

class XGBoost:

def __init__(self, n_estimators=300, learning_rate=0.001,

min_samples_split=2,

min_gini_impurity=999,

max_depth=2):

# 树的棵数

self.n_estimators = n_estimators

# 学习率

self.learning_rate = learning_rate

# 结点分裂最小样本数

self.min_samples_split = min_samples_split

# 结点最小基尼不纯度

self.min_gini_impurity = min_gini_impurity

# 树最大深度

self.max_depth = max_depth

# 用于分类的对数损失

# 回归任务可定义平方损失

# self.loss = SquaresLoss()

self.loss = LogisticLoss()

# 初始化分类树列表

self.trees = []

# 遍历构造每一棵决策树

for _ in range(n_estimators):

tree = XGBoost_Single_Tree(

min_samples_split=self.min_samples_split,

min_gini_impurity=self.min_gini_impurity,

max_depth=self.max_depth,

loss=self.loss)

self.trees.append(tree)

# xgboost拟合方法

def fit(self, X, y):

y = cat_label_convert(y)

y_pred = np.zeros(np.shape(y))

# 拟合每一棵树后进行结果累加

for i in range(self.n_estimators):

tree = self.trees[i]

y_true_pred = np.concatenate((y, y_pred), axis=1)

tree.fit(X, y_true_pred)

iter_pred = tree.predict(X)

y_pred -= np.multiply(self.learning_rate, iter_pred)

# xgboost预测方法

def predict(self, X):

y_pred = None

# 遍历预测

for tree in self.trees:

iter_pred = tree.predict(X)

if y_pred is None:

y_pred = np.zeros_like(iter_pred)

y_pred -= np.multiply(self.learning_rate, iter_pred)

y_pred = np.exp(y_pred) / np.sum(np.exp(y_pred), axis=1, keepdims=True)

# 将概率预测转换为标签

y_pred = np.argmax(y_pred, axis=1)

return y_pred

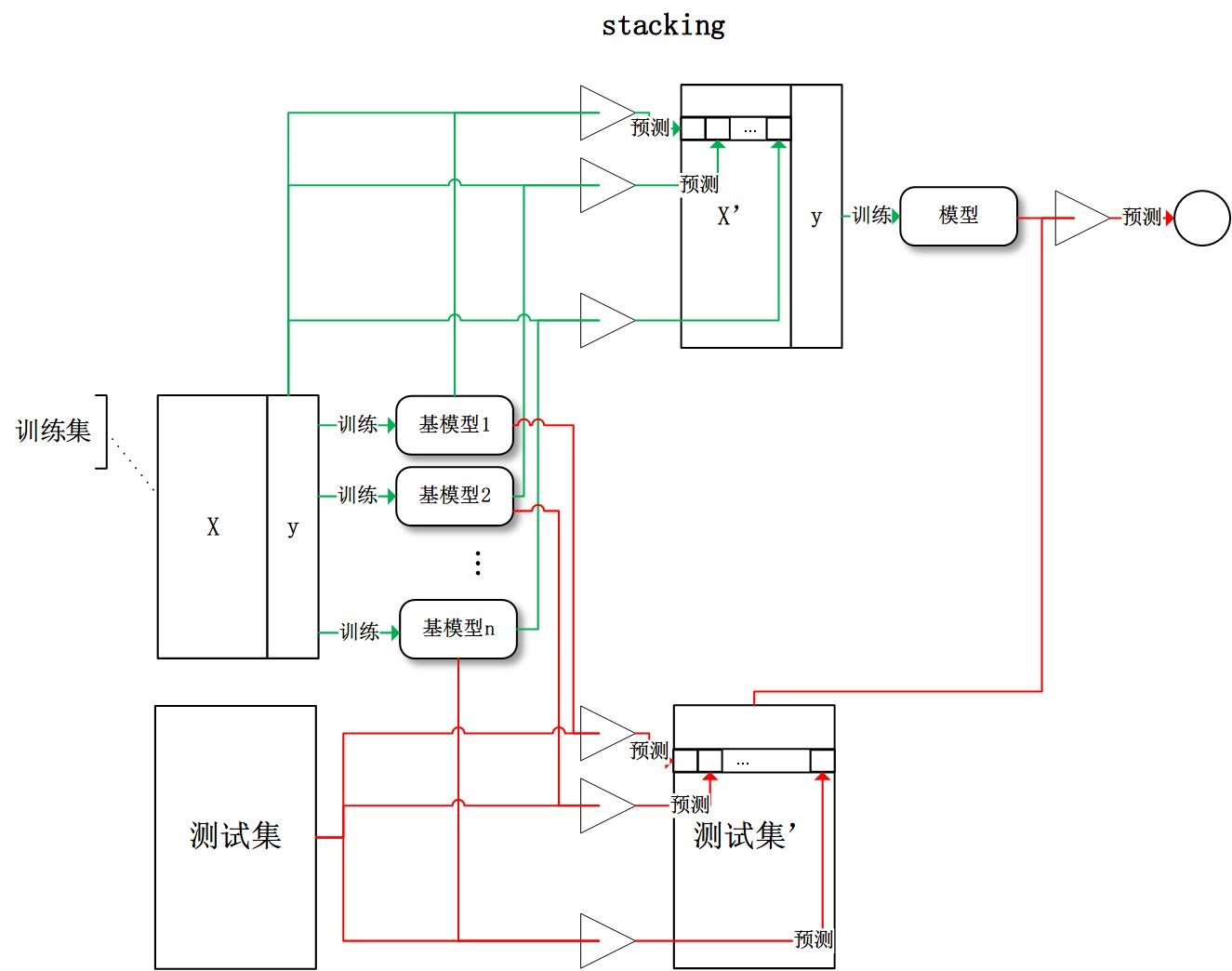

集成学习

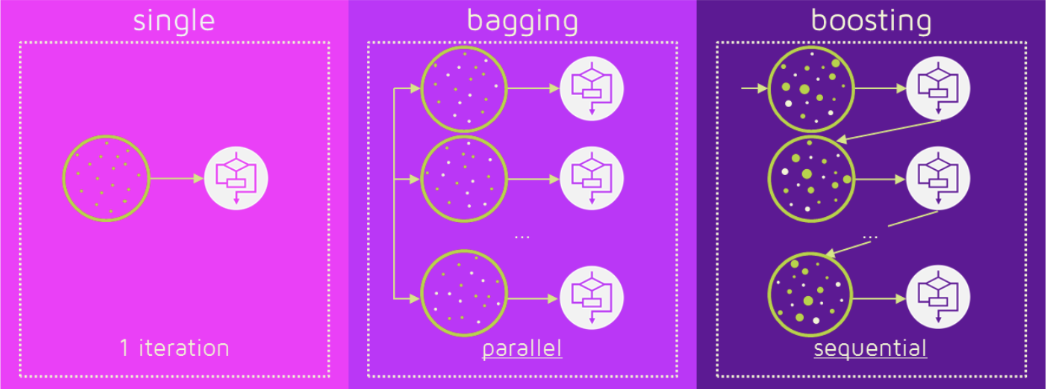

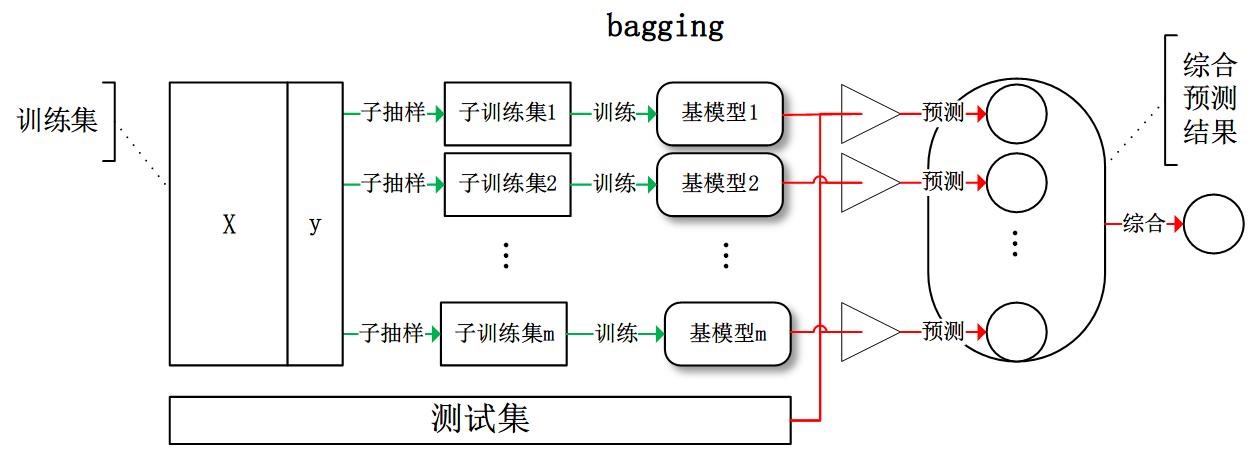

Bagging与Boosting的区别:

- 取样方式不同。

- Bagging采用均匀取样,而Boosting根据错误率取样。

- Bagging的各个预测函数没有权重,而Boosting是有权重的。

- Bagging的各个预测函数可以并行生成,而Boosing的各个预测函数只能顺序生成。

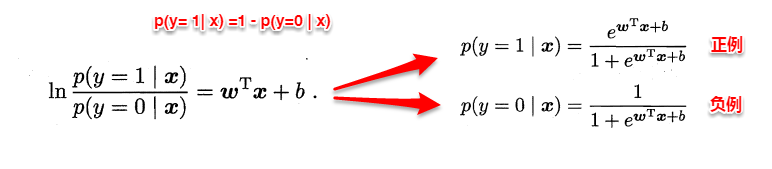

LR

Logistic回归目的

- 从特征学习出一个0/1分类模型,而这个模型是将特性的线性组合作为自变量,由于自变量的取值范围是负无穷到正无穷。

- 因此,使用logistic函数(或称作sigmoid函数)将自变量映射到(0,1)上,映射后的值被认为是属于y=1的概率。

LR vs 线性回归

LR与线性回归的区别与联系?

- 逻辑回归和线性回归都是广义线性回归

- 经典线性模型的优化目标函数是最小二乘,而逻辑回归则是似然函数

- 另外线性回归在整个实数域范围内进行预测,敏感度一致,而分类范围,需要在[0,1]。逻辑回归就是一种减小预测范围,将预测值限定为[0,1] 间的一种回归模型,因而对于这类问题来说,逻辑回归的鲁棒性比线性回归的要好。

逻辑回归模型本质上是一个线性回归模型,逻辑回归都是以线性回归为理论支持的。

- 但线性回归模型无法做到sigmoid的非线性形式,sigmoid可以轻松处理0/1分类问题。

LR VS SVM

- Logit回归目标函数是最小化后验概率,Logit回归可以用于预测事件发生概率的大小

- SVM目标是结构风险最小化,SVM可以有效避免模型过拟合。

LR和SVM的联系与区别?

联系

- 1、LR和SVM都可以处理分类问题,且一般都用于处理线性二分类问题(在改进的情况下可以处理多分类问题)

- 2、两个方法都可以增加不同的正则化项,如L1、L2等等。所以在很多实验中,两种算法的结果是很接近的。

区别:

- 1、LR是参数模型,SVM是非参数模型。

- 2、从目标函数来看,区别在于逻辑回归采用的是Logistical Loss,SVM采用的是hinge loss.这两个损失函数的目的都是增加对分类影响较大的数据点的权重,减少与分类关系较小的数据点的权重。

- 3、SVM的处理方法是只考虑Support Vectors,也就是和分类最相关的少数点,去学习分类器。而逻辑回归通过非线性映射,大大减小了离分类平面较远的点的权重,相对提升了与分类最相关的数据点的权重。

- 4、逻辑回归相对来说模型更简单,好理解,特别是大规模线性分类时比较方便。而SVM的理解和优化相对来说复杂一些,SVM转化为对偶问题后,分类只需要计算与少数几个支持向量的距离,这个在进行复杂核函数计算时优势很明显,能够大大简化模型和计算。

- 5、Logic 能做的 SVM能做,但可能在准确率上有问题,SVM能做的Logic有的做不了。

神经网络

神经网络的发展

- MP模型+sgn -> 单层感知机(只能线性)+sgn— Minsky 低谷 —> 多层感知机+BP+Sigmoid— (低谷) —> 深度学习+Pretraining+ReLU/Sigmoid

RNN/LSTM

LSTM结构推导,为什么比RNN好?

- 推导forget gate,input gate,cell state, hidden information等的变化;

- LSTM有进有出, 且当前cell informaton是通过input gate控制之后叠加的,RNN是叠乘,因此LSTM可以防止梯度消失或者爆炸。

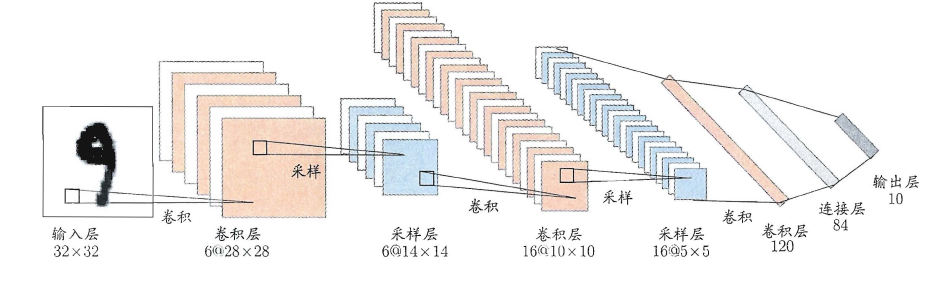

CNN

对图像(不同的数据窗口数据)和滤波矩阵(一组固定的权重:因为每个神经元的多个权重固定,所以又可以看做一个恒定的滤波器filter)做内积(逐个元素相乘再求和)的操作就是所谓的『卷积』操作,也是卷积神经网络。

池化

- 取区域平均或最大

深度学习

斯坦佛-吴恩达

- 【2020-1-2】吴恩达机器学习课程资料,含ppt、word、markdown版笔记,黄海广总结

- 【2021-5-17】machine-learning-yearning, 机器学习秘笈中文版

强化学习

李宏毅

伯克利

斯坦福

周志华《机器学习》笔记

- 摘自:github

(1) 绪论

机器学习是目前信息技术中最激动人心的方向之一,其应用已经深入到生活的各个层面且与普通人的日常生活密切相关。本文为清华大学最新出版的《机器学习》教材的Learning Notes,书作者是南京大学周志华教授,多个大陆首位彰显其学术奢华。本篇主要介绍了该教材前两个章节的知识点以及自己一点浅陋的理解。

1 绪论

傍晚小街路面上沁出微雨后的湿润,和熙的细风吹来,抬头看看天边的晚霞,嗯,明天又是一个好天气。走到水果摊旁,挑了个根蒂蜷缩、敲起来声音浊响的青绿西瓜,一边满心期待着皮薄肉厚瓢甜的爽落感,一边愉快地想着,这学期狠下了工夫,基础概念弄得清清楚楚,算法作业也是信手拈来,这门课成绩一定差不了!哈哈,也希望自己这学期的machine learning课程取得一个好成绩!

1.1 机器学习的定义

正如我们根据过去的经验来判断明天的天气,吃货们希望从购买经验中挑选一个好瓜,那能不能让计算机帮助人类来实现这个呢?机器学习正是这样的一门学科,人的“经验”对应计算机中的“数据”,让计算机来学习这些经验数据,生成一个算法模型,在面对新的情况中,计算机便能作出有效的判断,这便是机器学习。

另一本经典教材的作者Mitchell给出了一个形式化的定义,假设:

- P:计算机程序在某任务类T上的

性能。 - T:计算机程序希望实现的

任务类。 - E:表示

经验,即历史的数据集。

若该计算机程序通过利用经验E在任务T上获得了性能P的改善,则称该程序对E进行了学习。

1.2 机器学习的一些基本术语

假设我们收集了一批西瓜的数据,例如:

- (色泽=青绿;根蒂=蜷缩;敲声=浊响)

- (色泽=乌黑;根蒂=稍蜷;敲声=沉闷)

- (色泽=浅自;根蒂=硬挺;敲声=清脆)……

每对括号内是一个西瓜的记录,定义:

- 所有记录的集合为:

数据集。 - 每一条记录为:一个

实例(instance)或样本(sample)。- 例如:色泽或敲声,单个的特点为

特征(feature)或属性(attribute)。

- 例如:色泽或敲声,单个的特点为

- 对于一条记录,如果在坐标轴上表示,每个西瓜都可以用坐标轴中的一个点表示,一个点也是一个向量

- 例如(青绿,蜷缩,浊响),即每个西瓜为:一个特征向量(feature vector)。

- 一个样本的特征数为:

维数(dimensionality),该西瓜的例子维数为3,当维数非常大时,也就是现在说的“维数灾难”。

计算机程序学习经验数据生成算法模型的过程中,每一条记录称为一个“训练样本”,同时在训练好模型后,我们希望使用新的样本来测试模型的效果,则每一个新的样本称为一个“测试样本”。定义:

- 所有训练样本的集合为:

训练集(trainning set),[特殊]。 - 所有测试样本的集合为:

测试集(test set),[一般]。 -

机器学习出来的模型适用于新样本的能力为:

泛化能力(generalization),即从特殊到一般。西瓜的例子中,我们是想计算机通过学习西瓜的特征数据,训练出一个决策模型,来判断一个新的西瓜是否是好瓜。可以得知我们预测的是:西瓜是好是坏,即好瓜与差瓜两种,是离散值。同样地,也有通过历年的人口数据,来预测未来的人口数量,人口数量则是连续值。定义:

- 预测值为离散值的问题为:

分类(classification)。 -

预测值为连续值的问题为:

回归(regression)。我们预测西瓜是否是好瓜的过程中,很明显对于训练集中的西瓜,我们事先已经知道了该瓜是否是好瓜,学习器通过学习这些好瓜或差瓜的特征,从而总结出规律,即训练集中的西瓜我们都做了标记,称为标记信息。但也有没有标记信息的情形,例如:我们想将一堆西瓜根据特征分成两个小堆,使得某一堆的西瓜尽可能相似,即都是好瓜或差瓜,对于这种问题,我们事先并不知道西瓜的好坏,样本没有标记信息。定义:

- 训练数据有标记信息的学习任务为:

监督学习(supervised learning),容易知道上面所描述的分类和回归都是监督学习的范畴。 - 训练数据没有标记信息的学习任务为:

无监督学习(unsupervised learning),常见的有聚类和关联规则。

2 模型的评估与选择

2.1 误差与过拟合

我们将学习器对样本的实际预测结果与样本的真实值之间的差异成为:误差(error)。定义:

- 在训练集上的误差称为

训练误差(training error)或经验误差(empirical error)。 - 在测试集上的误差称为

测试误差(test error)。 - 学习器在所有新样本上的误差称为

泛化误差(generalization error)。

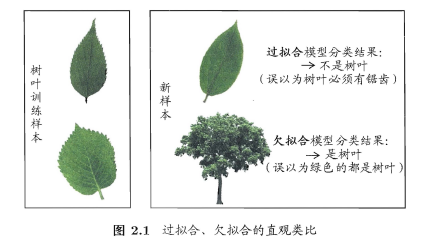

显然,我们希望得到的是在新样本上表现得很好的学习器,即泛化误差小的学习器。因此,我们应该让学习器尽可能地从训练集中学出普适性的“一般特征”,这样在遇到新样本时才能做出正确的判别。然而,当学习器把训练集学得“太好”的时候,即把一些训练样本的自身特点当做了普遍特征;同时也有学习能力不足的情况,即训练集的基本特征都没有学习出来。我们定义:

- 学习能力过强,以至于把训练样本所包含的不太一般的特性都学到了,称为:

过拟合(overfitting)。 - 学习能太差,训练样本的一般性质尚未学好,称为:

欠拟合(underfitting)。

可以得知:在过拟合问题中,训练误差十分小,但测试误差教大;在欠拟合问题中,训练误差和测试误差都比较大。目前,欠拟合问题比较容易克服,例如增加迭代次数等,但过拟合问题还没有十分好的解决方案,过拟合是机器学习面临的关键障碍。

2.2 评估方法

在现实任务中,我们往往有多种算法可供选择,那么我们应该选择哪一个算法才是最适合的呢?如上所述,我们希望得到的是泛化误差小的学习器,理想的解决方案是对模型的泛化误差进行评估,然后选择泛化误差最小的那个学习器。但是,泛化误差指的是模型在所有新样本上的适用能力,我们无法直接获得泛化误差。

因此,通常我们采用一个“测试集”来测试学习器对新样本的判别能力,然后以“测试集”上的“测试误差”作为“泛化误差”的近似。显然:我们选取的测试集应尽可能与训练集互斥,下面用一个小故事来解释why:

假设老师出了10 道习题供同学们练习,考试时老师又用同样的这10道题作为试题,可能有的童鞋只会做这10 道题却能得高分,很明显:这个考试成绩并不能有效地反映出真实水平。 回到我们的问题上来,我们希望得到泛化性能好的模型,好比希望同学们课程学得好并获得了对所学知识”举一反三”的能力; 训练样本相当于给同学们练习的习题,测试过程则相当于考试。显然,若测试样本被用作训练了,则得到的将是过于”乐观”的估计结果。

2.3 训练集与测试集的划分方法

如上所述:我们希望用一个“测试集”的“测试误差”来作为“泛化误差”的近似,因此我们需要对初始数据集进行有效划分,划分出互斥的“训练集”和“测试集”。

下面介绍几种常用的划分方法:

2.3.1 留出法

将数据集D划分为两个互斥的集合,一个作为训练集S,一个作为测试集T,满足D=S∪T且S∩T=∅,常见的划分为:大约2/3-4/5的样本用作训练,剩下的用作测试。

需要注意的是:训练/测试集的划分要尽可能保持数据分布的一致性,以避免由于分布的差异引入额外的偏差,常见的做法是采取分层抽样。同时,由于划分的随机性,单次的留出法结果往往不够稳定,一般要采用若干次随机划分,重复实验取平均值的做法。

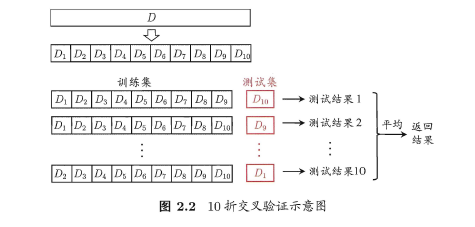

2.3.2 交叉验证法

将数据集D划分为k个大小相同的互斥子集,满足D=D1∪D2∪…∪Dk,Di∩Dj=∅(i≠j),同样地尽可能保持数据分布的一致性,即采用分层抽样的方法获得这些子集。

交叉验证法的思想是:每次用k-1个子集的并集作为训练集,余下的那个子集作为测试集,这样就有K种训练集/测试集划分的情况,从而可进行k次训练和测试,最终返回k次测试结果的均值。交叉验证法也称“k折交叉验证”,k最常用的取值是10,下图给出了10折交叉验证的示意图。

与留出法类似,将数据集D划分为K个子集的过程具有随机性,因此K折交叉验证通常也要重复p次,称为p次k折交叉验证,常见的是10次10折交叉验证,即进行了100次训练/测试。特殊地当划分的k个子集的每个子集中只有一个样本时,称为“留一法”,显然,留一法的评估结果比较准确,但对计算机的消耗也是巨大的。

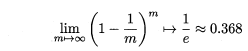

2.3.3 自助法

我们希望评估的是用整个D训练出的模型。但在留出法和交叉验证法中,由于保留了一部分样本用于测试,因此实际评估的模型所使用的训练集比D小,这必然会引入一些因训练样本规模不同而导致的估计偏差。留一法受训练样本规模变化的影响较小,但计算复杂度又太高了。“自助法”正是解决了这样的问题。

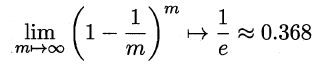

自助法的基本思想是:给定包含m个样本的数据集D,每次随机从D中挑选一个样本,将其拷贝放入D’,然后再将该样本放回初始数据集D 中,使得该样本在下次采样时仍有可能被采到。重复执行m 次,就可以得到了包含m个样本的数据集D’。可以得知在m次采样中,样本始终不被采到的概率取极限为:

这样,通过自助采样,初始样本集D中大约有36.8%的样本没有出现在D’中,于是可以将D’作为训练集,D-D’作为测试集。自助法在数据集较小,难以有效划分训练集/测试集时很有用,但由于自助法产生的数据集(随机抽样)改变了初始数据集的分布,因此引入了估计偏差。在初始数据集足够时,留出法和交叉验证法更加常用。

2.4 调参

大多数学习算法都有些参数(parameter) 需要设定,参数配置不同,学得模型的性能往往有显著差别,这就是通常所说的”参数调节”或简称”调参” (parameter tuning)。

学习算法的很多参数是在实数范围内取值,因此,对每种参数取值都训练出模型来是不可行的。常用的做法是:对每个参数选定一个范围和步长λ,这样使得学习的过程变得可行。例如:假定算法有3 个参数,每个参数仅考虑5 个候选值,这样对每一组训练/测试集就有555= 125 个模型需考察,由此可见:拿下一个参数(即经验值)对于算法人员来说是有多么的happy。

最后需要注意的是:当选定好模型和调参完成后,我们需要使用初始的数据集D重新训练模型,即让最初划分出来用于评估的测试集也被模型学习,增强模型的学习效果。用上面考试的例子来比喻:就像高中时大家每次考试完,要将考卷的题目消化掉(大多数题目都还是之前没有见过的吧?),这样即使考差了也能开心的玩耍了~。

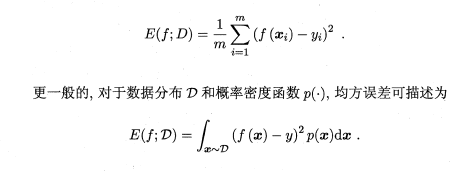

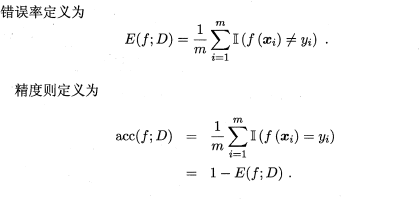

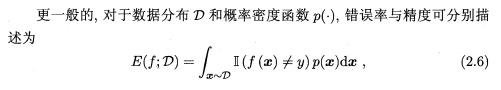

(2) 性能度量

本篇主要是对第二章剩余知识的理解,包括:性能度量、比较检验和偏差与方差。

在上一篇中,我们解决了评估学习器泛化性能的方法,即用测试集的“测试误差”作为“泛化误差”的近似,当我们划分好训练/测试集后,那如何计算“测试误差”呢?这就是性能度量,例如:均方差,错误率等,即“测试误差”的一个评价标准。有了评估方法和性能度量,就可以计算出学习器的“测试误差”,但由于“测试误差”受到很多因素的影响,例如:算法随机性或测试集本身的选择,那如何对两个或多个学习器的性能度量结果做比较呢?这就是比较检验。最后偏差与方差是解释学习器泛化性能的一种重要工具。写到后面发现冗长之后读起来十分没有快感,故本篇主要知识点为性能度量。

2.5 性能度量

性能度量(performance measure)是衡量模型泛化能力的评价标准,在对比不同模型的能力时,使用不同的性能度量往往会导致不同的评判结果。本节除2.5.1外,其它主要介绍分类模型的性能度量。

2.5.1 最常见的性能度量

在回归任务中,即预测连续值的问题,最常用的性能度量是“均方误差”(mean squared error),很多的经典算法都是采用了MSE作为评价函数,想必大家都十分熟悉。

在分类任务中,即预测离散值的问题,最常用的是错误率和精度,错误率是分类错误的样本数占样本总数的比例,精度则是分类正确的样本数占样本总数的比例,易知:错误率+精度=1。

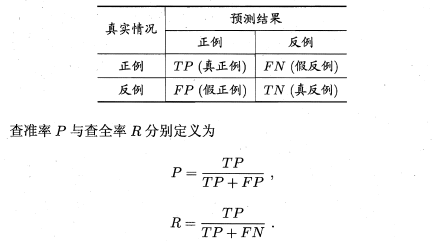

2.5.2 查准率/查全率/F1

错误率和精度虽然常用,但不能满足所有的需求,例如:在推荐系统中,我们只关心推送给用户的内容用户是否感兴趣(即查准率),或者说所有用户感兴趣的内容我们推送出来了多少(即查全率)。因此,使用查准/查全率更适合描述这类问题。对于二分类问题,分类结果混淆矩阵与查准/查全率定义如下:

初次接触时,FN与FP很难正确的理解,按照惯性思维容易把FN理解成:False->Negtive,即将错的预测为错的,这样FN和TN就反了,后来找到一张图,描述得很详细,为方便理解,把这张图也贴在了下边:

正如天下没有免费的午餐,查准率和查全率是一对矛盾的度量。例如我们想让推送的内容尽可能用户全都感兴趣,那只能推送我们把握高的内容,这样就漏掉了一些用户感兴趣的内容,查全率就低了;如果想让用户感兴趣的内容都被推送,那只有将所有内容都推送上,宁可错杀一千,不可放过一个,这样查准率就很低了。

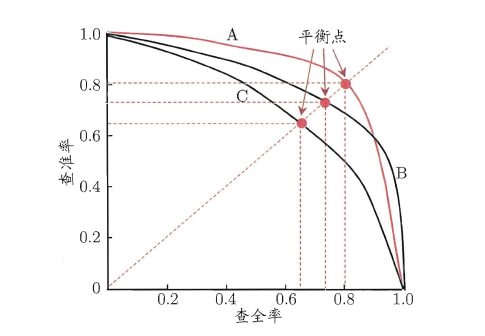

“P-R曲线”正是描述查准/查全率变化的曲线,P-R曲线定义如下:根据学习器的预测结果(一般为一个实值或概率)对测试样本进行排序,将最可能是“正例”的样本排在前面,最不可能是“正例”的排在后面,按此顺序逐个把样本作为“正例”进行预测,每次计算出当前的P值和R值,如下图所示:

P-R曲线如何评估呢?

- 若一个学习器A的P-R曲线被另一个学习器B的P-R曲线完全包住,则称:B的性能优于A。

- 若A和B的曲线发生了交叉,则谁的曲线下的面积大,谁的性能更优。

- 但一般来说,曲线下的面积是很难进行估算的,所以衍生出了“

平衡点”(Break-Event Point,简称BEP),即当P=R时的取值,平衡点的取值越高,性能更优。

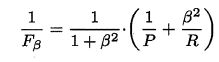

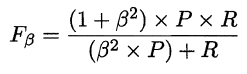

P和R指标有时会出现矛盾的情况,这样就需要综合考虑他们,最常见的方法就是F-Measure,又称F-Score。F-Measure是P和R的加权调和平均,即:

特别地,当β=1时,也就是常见的F1度量,是P和R的调和平均,当F1较高时,模型的性能越好。

有时候我们会有多个二分类混淆矩阵,例如:多次训练或者在多个数据集上训练,那么估算全局性能的方法有两种,分为宏观和微观。

简单理解,宏观就是先算出每个混淆矩阵的P值和R值,然后取得平均P值macro-P和平均R值macro-R,在算出Fβ或F1,而微观则是计算出混淆矩阵的平均TP、FP、TN、FN,接着进行计算P、R,进而求出Fβ或F1。

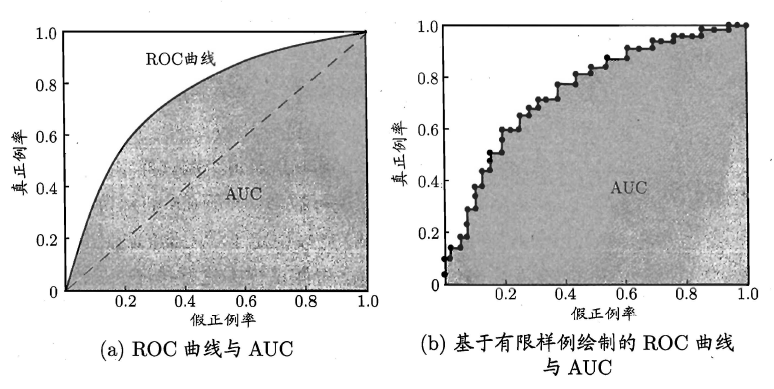

2.5.3 ROC与AUC

如上所述:学习器对测试样本的评估结果一般为一个实值或概率,设定一个阈值,大于阈值为正例,小于阈值为负例,因此这个实值的好坏直接决定了学习器的泛化性能,若将这些实值排序,则排序的好坏决定了学习器的性能高低。ROC曲线正是从这个角度出发来研究学习器的泛化性能,ROC曲线与P-R曲线十分类似,都是按照排序的顺序逐一按照正例预测,不同的是ROC曲线以“真正例率”(True Positive Rate,简称TPR)为横轴,纵轴为“假正例率”(False Positive Rate,简称FPR),ROC偏重研究基于测试样本评估值的排序好坏。

简单分析图像,可以得知:当FN=0时,TN也必须0,反之也成立,我们可以画一个队列,试着使用不同的截断点(即阈值)去分割队列,来分析曲线的形状,(0,0)表示将所有的样本预测为负例,(1,1)则表示将所有的样本预测为正例,(0,1)表示正例全部出现在负例之前的理想情况,(1,0)则表示负例全部出现在正例之前的最差情况。限于篇幅,这里不再论述。

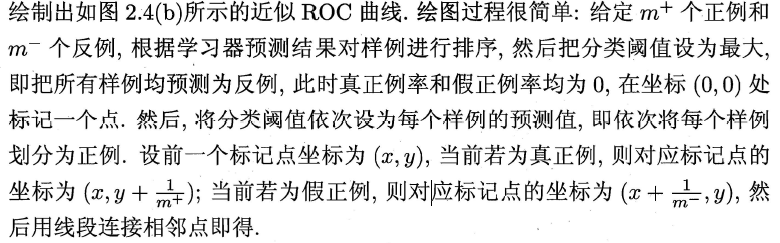

现实中的任务通常都是有限个测试样本,因此只能绘制出近似ROC曲线。绘制方法:首先根据测试样本的评估值对测试样本排序,接着按照以下规则进行绘制。

同样地,进行模型的性能比较时

- 若一个学习器A的ROC曲线被另一个学习器B的ROC曲线完全包住,则称B的性能优于A。

- 若A和B的曲线发生了交叉,则谁的曲线下的面积大,谁的性能更优。

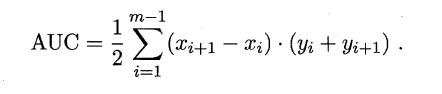

ROC曲线下的面积定义为AUC(Area Uder ROC Curve),不同于P-R的是,这里的AUC是可估算的,即AOC曲线下每一个小矩形的面积之和。

易知:AUC越大,证明排序的质量越好

- AUC为1时,证明所有正例排在了负例的前面

- AUC为0时,所有的负例排在了正例的前面。

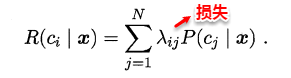

2.5.4 代价敏感错误率与代价曲线

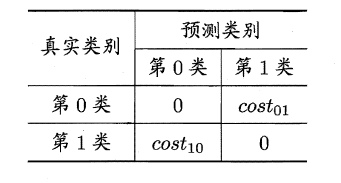

上面的方法中,将学习器的犯错同等对待,但在现实生活中,将正例预测成假例与将假例预测成正例的代价常常是不一样的,例如:将无疾病–>有疾病只是增多了检查,但有疾病–>无疾病却是增加了生命危险。以二分类为例,由此引入了“代价矩阵”(cost matrix)。

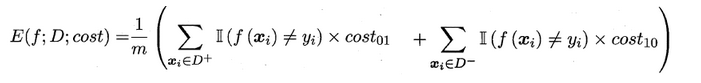

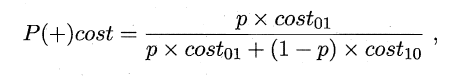

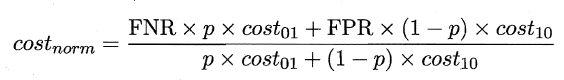

在非均等错误代价下,我们希望的是最小化“总体代价”,这样“代价敏感”的错误率(2.5.1节介绍)为:

同样对于ROC曲线,在非均等错误代价下,演变成了“代价曲线”,代价曲线横轴是取值在[0,1]之间的正例概率代价,式中p表示正例的概率,纵轴是取值为[0,1]的归一化代价。

代价曲线的绘制很简单:设ROC曲线上一点的坐标为(TPR,FPR) ,则可相应计算出FNR,然后在代价平面上绘制一条从(0,FPR) 到(1,FNR) 的线段,线段下的面积即表示了该条件下的期望总体代价;如此将ROC 曲线土的每个点转化为代价平面上的一条线段,然后取所有线段的下界,围成的面积即为在所有条件下学习器的期望总体代价,如图所示:

在此模型的性能度量方法就介绍完了,以前一直以为均方误差和精准度就可以了,现在才发现天空如此广阔~

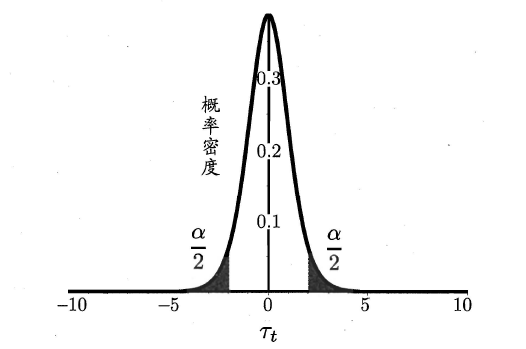

(3)假设检验&方差偏差

在上两篇中,我们介绍了多种常见的评估方法和性能度量标准,这样我们就可以根据数据集以及模型任务的特征,选择出最合适的评估和性能度量方法来计算出学习器的“测试误差“。但由于“测试误差”受到很多因素的影响,例如:算法随机性(例如常见的K-Means)或测试集本身的选择,使得同一模型每次得到的结果不尽相同,同时测试误差是作为泛化误差的近似,并不能代表学习器真实的泛化性能,那如何对单个或多个学习器在不同或相同测试集上的性能度量结果做比较呢?这就是比较检验。最后偏差与方差是解释学习器泛化性能的一种重要工具。本篇延续上一篇的内容,主要讨论了比较检验、方差与偏差。

2.6 比较检验

在比较学习器泛化性能的过程中,统计假设检验(hypothesis test)为学习器性能比较提供了重要依据,即若A在某测试集上的性能优于B,那A学习器比B好的把握有多大。 为方便论述,本篇中都是以“错误率”作为性能度量的标准。

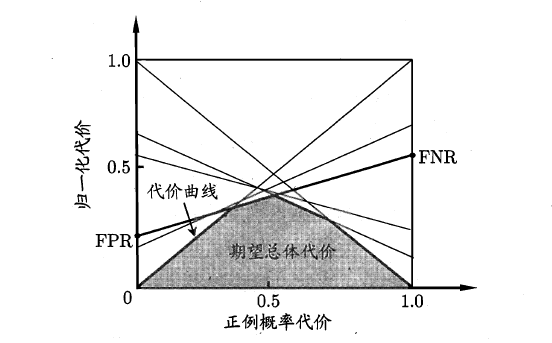

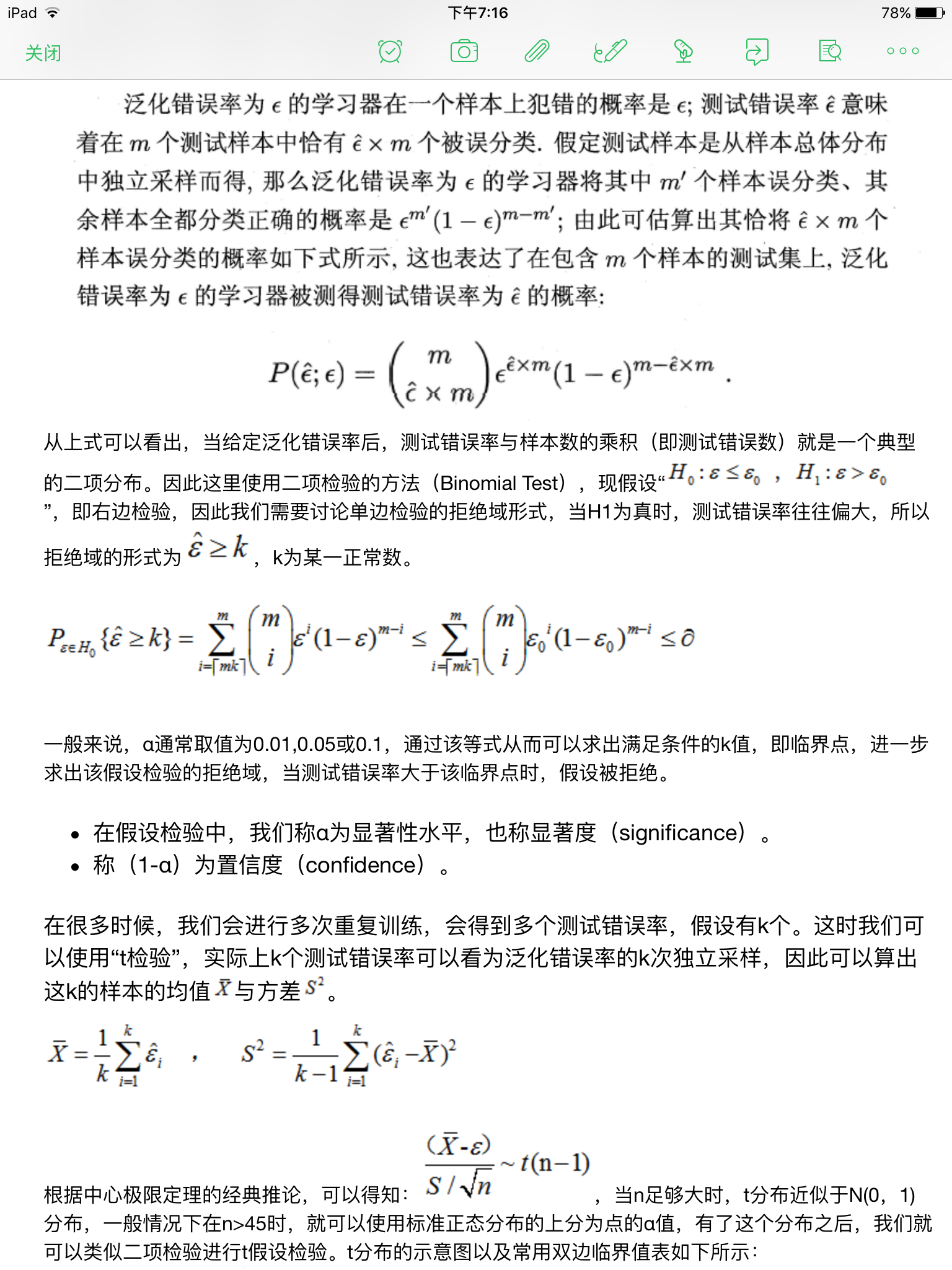

2.6.1 假设检验

“假设”指的是对样本总体的分布或已知分布中某个参数值的一种猜想,例如:假设总体服从泊松分布,或假设正态总体的期望u=u0。回到本篇中,我们可以通过测试获得测试错误率,但直观上测试错误率和泛化错误率相差不会太远,因此可以通过测试错误率来推测泛化错误率的分布,这就是一种假设检验。

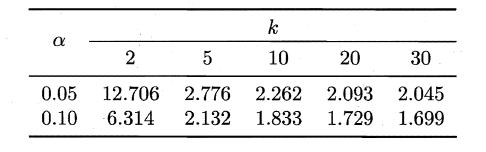

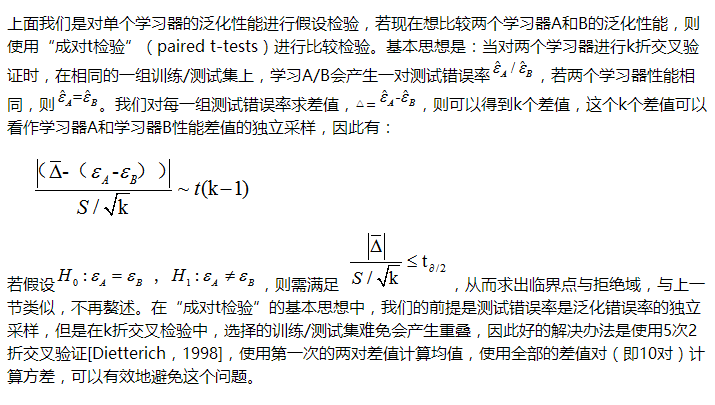

2.6.2 交叉验证t检验

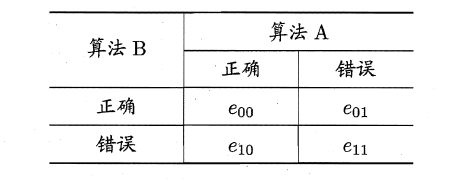

2.6.3 McNemar检验

MaNemar主要用于二分类问题,与成对t检验一样也是用于比较两个学习器的性能大小。

主要思想是:

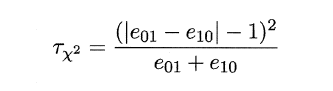

若两学习器的性能相同,则A预测正确B预测错误数应等于B预测错误A预测正确数,即e01=e10,且|e01-e10|服从N(1,e01+e10)分布。

因此,如下所示的变量服从自由度为1的卡方分布,即服从标准正态分布N(0,1)的随机变量的平方和,下式只有一个变量,故自由度为1,检验的方法同上:

做出假设–>求出满足显著度的临界点–>给出拒绝域–>验证假设。

2.6.4 Friedman检验与Nemenyi后续检验

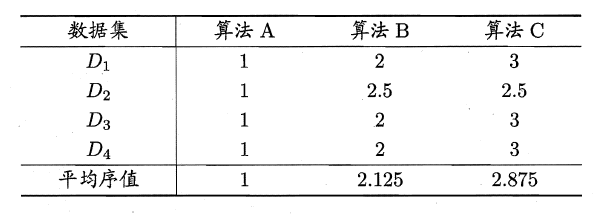

上述的三种检验都只能在一组数据集上,F检验则可以在多组数据集进行多个学习器性能的比较,基本思想是在同一组数据集上,根据测试结果(例:测试错误率)对学习器的性能进行排序,赋予序值1,2,3…,相同则平分序值,如下图所示:

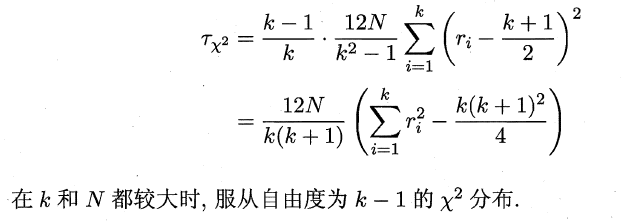

若学习器的性能相同,则它们的平均序值应该相同,且第i个算法的平均序值ri服从正态分布N((k+1)/2,(k+1)(k-1)/12),则有:

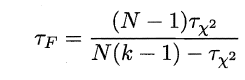

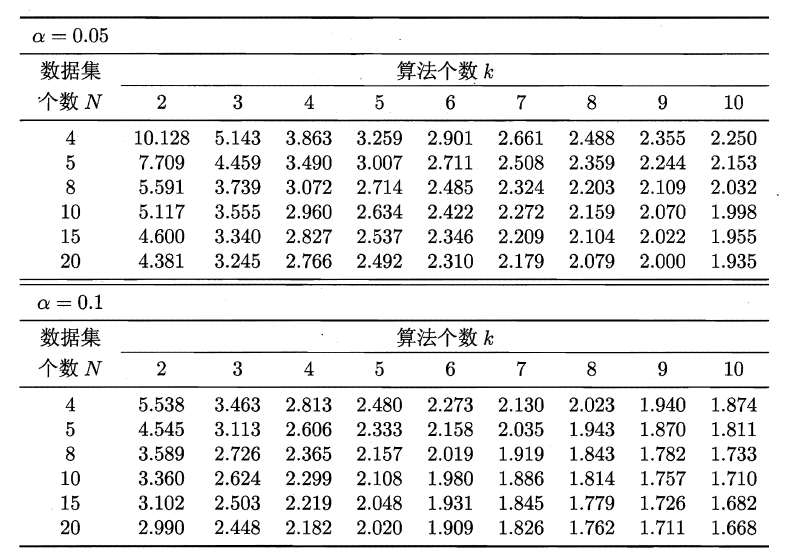

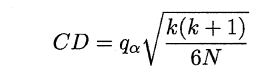

服从自由度为k-1和(k-1)(N-1)的F分布。下面是F检验常用的临界值:

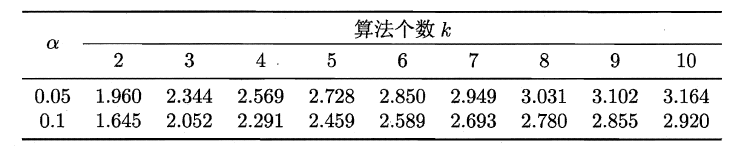

若“H0:所有算法的性能相同”这个假设被拒绝,则需要进行后续检验,来得到具体的算法之间的差异。常用的就是Nemenyi后续检验。Nemenyi检验计算出平均序值差别的临界值域,下表是常用的qa值,若两个算法的平均序值差超出了临界值域CD,则相应的置信度1-α拒绝“两个算法性能相同”的假设。

2.7 偏差与方差

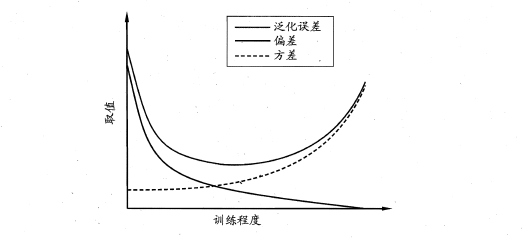

偏差-方差分解是解释学习器泛化性能的重要工具。在学习算法中,偏差指的是预测的期望值与真实值的偏差,方差则是每一次预测值与预测值得期望之间的差均方。实际上,偏差体现了学习器预测的准确度,而方差体现了学习器预测的稳定性。通过对泛化误差的进行分解,可以得到:

- 期望泛化误差=方差+偏差

- 偏差刻画学习器的拟合能力

- 方差体现学习器的稳定性

易知:方差和偏差具有矛盾性,这就是常说的偏差-方差窘境(bias-variance dilamma),随着训练程度的提升,期望预测值与真实值之间的差异越来越小,即偏差越来越小,但是另一方面,随着训练程度加大,学习算法对数据集的波动越来越敏感,方差值越来越大。换句话说:

在欠拟合时,偏差主导泛化误差,而训练到一定程度后,偏差越来越小,方差主导了泛化误差。因此训练也不要贪杯,适度辄止。

(4)线性模型

笔记的前一部分主要是对机器学习预备知识的概括,包括机器学习的定义/术语、学习器性能的评估/度量以及比较,本篇之后将主要对具体的学习算法进行理解总结,本篇则主要是第3章的内容–线性模型。

3、线性模型

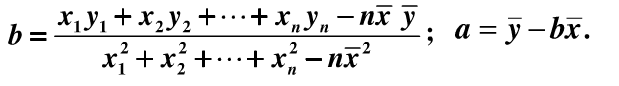

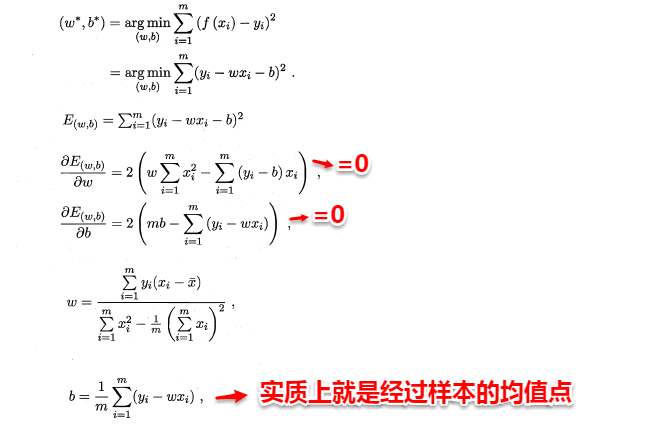

谈及线性模型,其实我们很早就已经与它打过交道,还记得高中数学必修3课本中那个顽皮的“最小二乘法”吗?这就是线性模型的经典算法之一:根据给定的(x,y)点对,求出一条与这些点拟合效果最好的直线y=ax+b,之前我们利用下面的公式便可以计算出拟合直线的系数a,b(3.1中给出了具体的计算过程),从而对于一个新的x,可以预测它所对应的y值。前面我们提到:在机器学习的术语中,当预测值为连续值时,称为“回归问题”,离散值时为“分类问题”。本篇先从线性回归任务开始,接着讨论分类和多分类问题。

3.1 线性回归

线性回归问题就是试图学到一个线性模型尽可能准确地预测新样本的输出值,例如:通过历年的人口数据预测2017年人口数量。在这类问题中,往往我们会先得到一系列的有标记数据,例如:2000–>13亿…2016–>15亿,这时输入的属性只有一个,即年份;也有输入多属性的情形,假设我们预测一个人的收入,这时输入的属性值就不止一个了,例如:(学历,年龄,性别,颜值,身高,体重)–>15k。

有时这些输入的属性值并不能直接被我们的学习模型所用,需要进行相应的处理,对于连续值的属性,一般都可以被学习器所用,有时会根据具体的情形作相应的预处理,例如:归一化等;对于离散值的属性,可作下面的处理:

- 若属性值之间存在“序关系”,则可以将其转化为连续值,例如:身高属性分为“高”“中等”“矮”,可转化为数值:{1, 0.5, 0}。

- 若属性值之间不存在“序关系”,则通常将其转化为向量的形式,例如:性别属性分为“男”“女”,可转化为二维向量:{(1,0),(0,1)}。

(1)当输入属性只有一个的时候,就是最简单的情形,也就是我们高中时最熟悉的“最小二乘法”(Euclidean distance),首先计算出每个样本预测值与真实值之间的误差并求和,通过最小化均方误差MSE,使用求偏导等于零的方法计算出拟合直线y=wx+b的两个参数w和b,计算过程如下图所示:

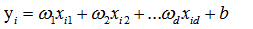

(2)当输入属性有多个的时候,例如对于一个样本有d个属性{(x1,x2…xd),y},则y=wx+b需要写成:

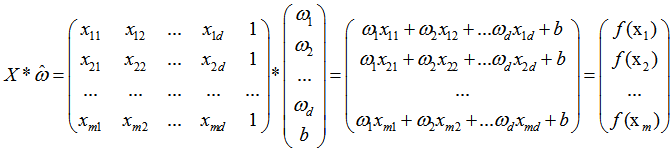

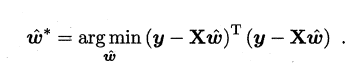

通常对于多元问题,常常使用矩阵的形式来表示数据。在本问题中,将具有m个样本的数据集表示成矩阵X,将系数w与b合并成一个列向量,这样每个样本的预测值以及所有样本的均方误差最小化就可以写成下面的形式:

同样地,我们使用最小二乘法对w和b进行估计,令均方误差的求导等于0,需要注意的是,当一个矩阵的行列式不等于0时,我们才可能对其求逆,因此对于下式,我们需要考虑矩阵(X的转置*X)的行列式是否为0,若不为0,则可以求出其解,若为0,则需要使用其它的方法进行计算,书中提到了引入正则化,此处不进行深入。

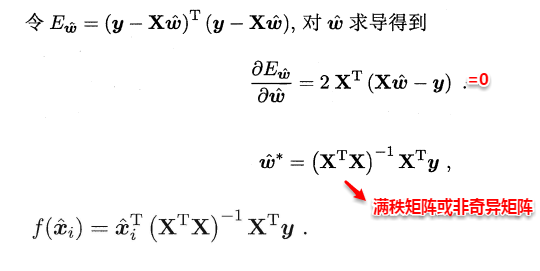

另一方面,有时像上面这种原始的线性回归可能并不能满足需求,例如:y值并不是线性变化,而是在指数尺度上变化。这时我们可以采用线性模型来逼近y的衍生物,例如lny,这时衍生的线性模型如下所示,实际上就是相当于将指数曲线投影在一条直线上,如下图所示:

更一般地,考虑所有y的衍生物的情形,就得到了“广义的线性模型”(generalized linear model),其中,g(*)称为联系函数(link function)。

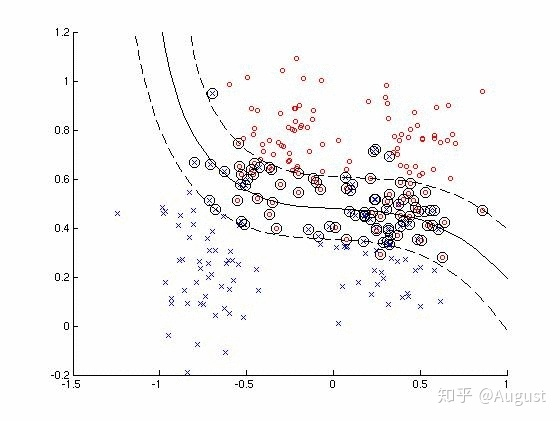

3.2 线性几率回归

回归就是通过输入的属性值得到一个预测值,利用上述广义线性模型的特征,是否可以通过一个联系函数,将预测值转化为离散值从而进行分类呢?线性几率回归正是研究这样的问题。对数几率引入了一个对数几率函数(logistic function),将预测值投影到0-1之间,从而将线性回归问题转化为二分类问题。

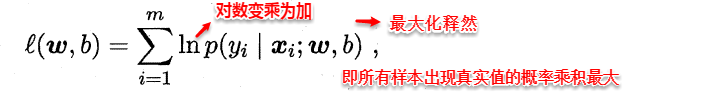

若将y看做样本为正例的概率,(1-y)看做样本为反例的概率,则上式实际上使用线性回归模型的预测结果器逼近真实标记的对数几率。因此这个模型称为“对数几率回归”(logistic regression),也有一些书籍称之为“逻辑回归”。下面使用最大似然估计的方法来计算出w和b两个参数的取值,下面只列出求解的思路,不列出具体的计算过程。

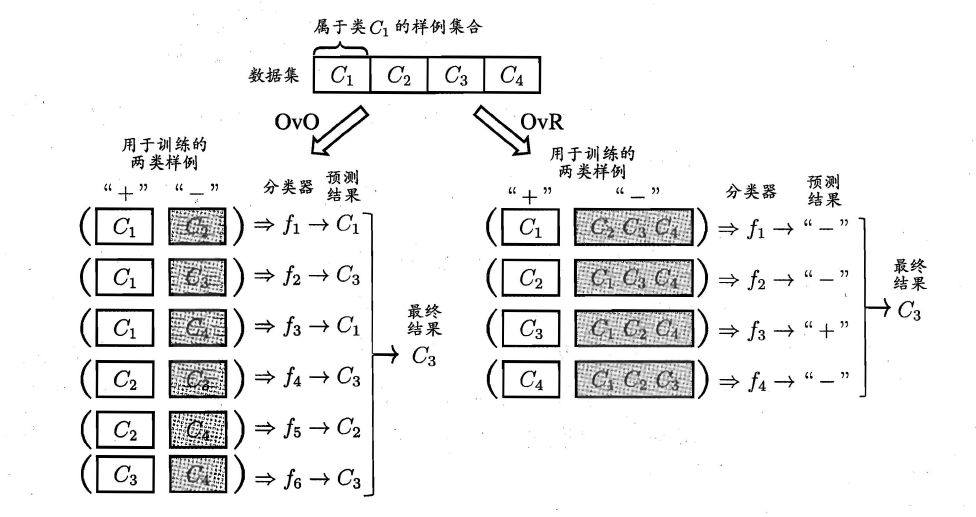

3.3 线性判别分析

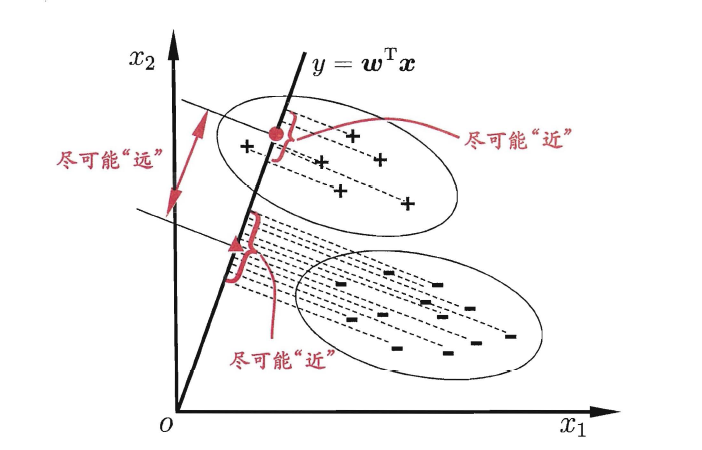

线性判别分析(Linear Discriminant Analysis,简称LDA),其基本思想是:

将训练样本投影到一条直线上,使得同类的样例尽可能近,不同类的样例尽可能远。

如图所示:

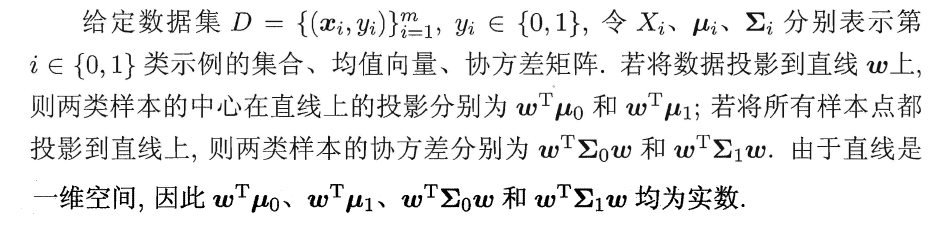

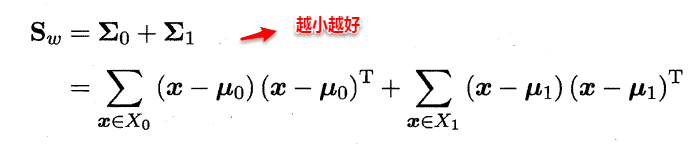

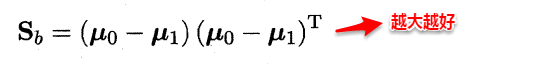

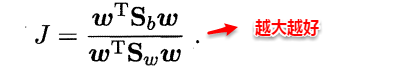

想让同类样本点的投影点尽可能接近,不同类样本点投影之间尽可能远,即:让各类的协方差之和尽可能小,不用类之间中心的距离尽可能大。基于这样的考虑,LDA定义了两个散度矩阵。

- 类内散度矩阵(within-class scatter matrix)

- 类间散度矩阵(between-class scaltter matrix)

因此得到了LDA的最大化目标:“广义瑞利商”(generalized Rayleigh quotient)。

从而分类问题转化为最优化求解w的问题,当求解出w后,对新的样本进行分类时,只需将该样本点投影到这条直线上,根据与各个类别的中心值进行比较,从而判定出新样本与哪个类别距离最近。求解w的方法如下所示,使用的方法为λ乘子。

若将w看做一个投影矩阵,类似PCA的思想,则LDA可将样本投影到N-1维空间(N为类簇数),投影的过程使用了类别信息(标记信息),因此LDA也常被视为一种经典的监督降维技术。

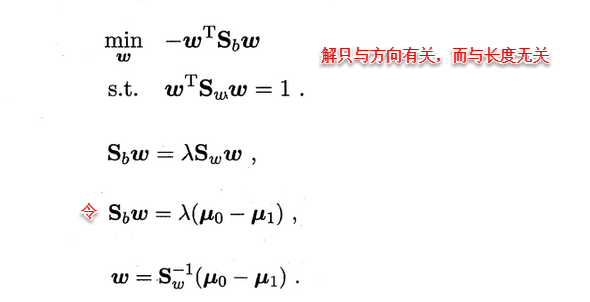

3.4 多分类学习

现实中我们经常遇到不只两个类别的分类问题,即多分类问题,在这种情形下,我们常常运用“拆分”的策略,通过多个二分类学习器来解决多分类问题,即将多分类问题拆解为多个二分类问题,训练出多个二分类学习器,最后将多个分类结果进行集成得出结论。

最为经典的拆分策略有三种:

- “一对一”(OvO)

- “一对其余”(OvR)

- “多对多”(MvM)

核心思想与示意图如下所示。

-

OvO:给定数据集D,假定其中有N个真实类别,将这N个类别进行两两配对(一个正类/一个反类),从而产生N(N-1)/2个二分类学习器,在测试阶段,将新样本放入所有的二分类学习器中测试,得出N(N-1)个结果,最终通过投票产生最终的分类结果。

-

OvM:给定数据集D,假定其中有N个真实类别,每次取出一个类作为正类,剩余的所有类别作为一个新的反类,从而产生N个二分类学习器,在测试阶段,得出N个结果,若仅有一个学习器预测为正类,则对应的类标作为最终分类结果。

-

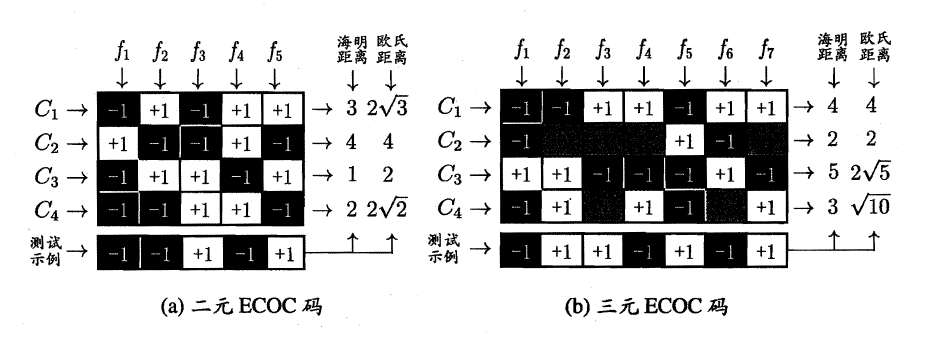

MvM:给定数据集D,假定其中有N个真实类别,每次取若干个类作为正类,若干个类作为反类(通过ECOC码给出,编码),若进行了M次划分,则生成了M个二分类学习器,在测试阶段(解码),得出M个结果组成一个新的码,最终通过计算海明/欧式距离选择距离最小的类别作为最终分类结果。

3.5 类别不平衡问题

类别不平衡(class-imbanlance)就是指分类问题中不同类别的训练样本相差悬殊的情况,例如正例有900个,而反例只有100个,这个时候我们就需要进行相应的处理来平衡这个问题。常见的做法有三种:

- 在训练样本较多的类别中进行“

欠采样”(undersampling),比如从正例中采出100个,常见的算法有:EasyEnsemble。 - 在训练样本较少的类别中进行“

过采样”(oversampling),例如通过对反例中的数据进行插值,来产生额外的反例,常见的算法有SMOTE。 - 直接基于原数据集进行学习,对预测值进行“再缩放”处理。其中再缩放也是

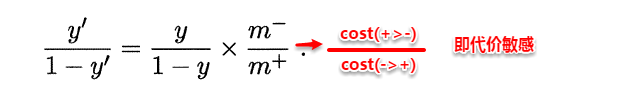

代价敏感学习的基础。

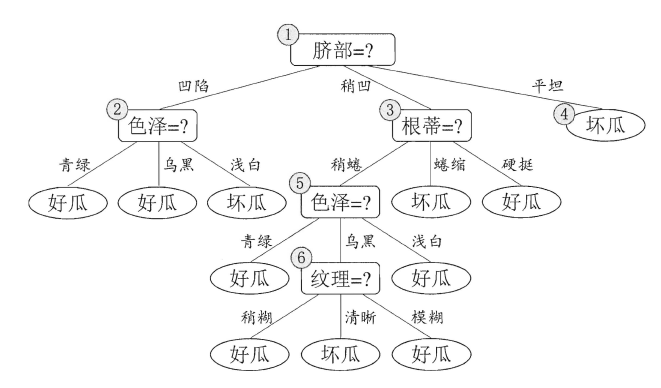

(5)决策树

上篇主要介绍和讨论了线性模型。首先从最简单的最小二乘法开始,讨论输入属性有一个和多个的情形,接着通过广义线性模型延伸开来,将预测连续值的回归问题转化为分类问题,从而引入了对数几率回归,最后线性判别分析LDA将样本点进行投影,多分类问题实质上通过划分的方法转化为多个二分类问题进行求解。本篇将讨论另一种被广泛使用的分类算法–决策树(Decision Tree)。

【2023-1-31】决策树可视化,dtreeviz工具, XGBoost Examples

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

import dtreeviz

iris = load_iris()

X = iris.data

y = iris.target

clf = DecisionTreeClassifier(max_depth=4)

clf.fit(X, y)

viz_model = dtreeviz.model(clf,

X_train=X, y_train=y,

feature_names=iris.feature_names,

target_name='iris',

class_names=iris.target_names)

v = viz_model.view() # render as SVG into internal object

v.show() # pop up window

v.save("/tmp/iris.svg") # optionally save as svg

4、决策树

4.1 决策树基本概念

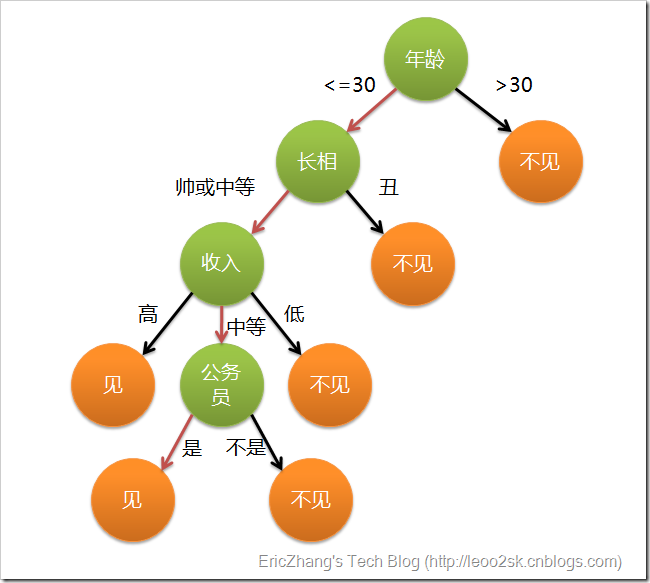

顾名思义,决策树是基于树结构来进行决策的,在网上看到一个例子十分有趣,放在这里正好合适。现想象一位捉急的母亲想要给自己的女娃介绍一个男朋友,于是有了下面的对话:

女儿:多大年纪了?

母亲:26。

女儿:长的帅不帅?

母亲:挺帅的。

女儿:收入高不?

母亲:不算很高,中等情况。

女儿:是公务员不?

母亲:是,在税务局上班呢。

女儿:那好,我去见见。 *****

这个女孩的挑剔过程就是一个典型的决策树,即相当于通过年龄、长相、收入和是否公务员将男童鞋分为两个类别:见和不见。假设这个女孩对男人的要求是:30岁以下、长相中等以上并且是高收入者或中等以上收入的公务员,那么使用下图就能很好地表示女孩的决策逻辑(即一颗决策树)。

在上图的决策树中,决策过程的每一次判定都是对某一属性的“测试”,决策最终结论则对应最终的判定结果。一般一颗决策树包含:一个根节点、若干个内部节点和若干个叶子节点,易知:

* 每个非叶节点表示一个特征属性测试。

* 每个分支代表这个特征属性在某个值域上的输出。

* 每个叶子节点存放一个类别。

* 每个节点包含的样本集合通过属性测试被划分到子节点中,根节点包含样本全集。

4.2 决策树的构造

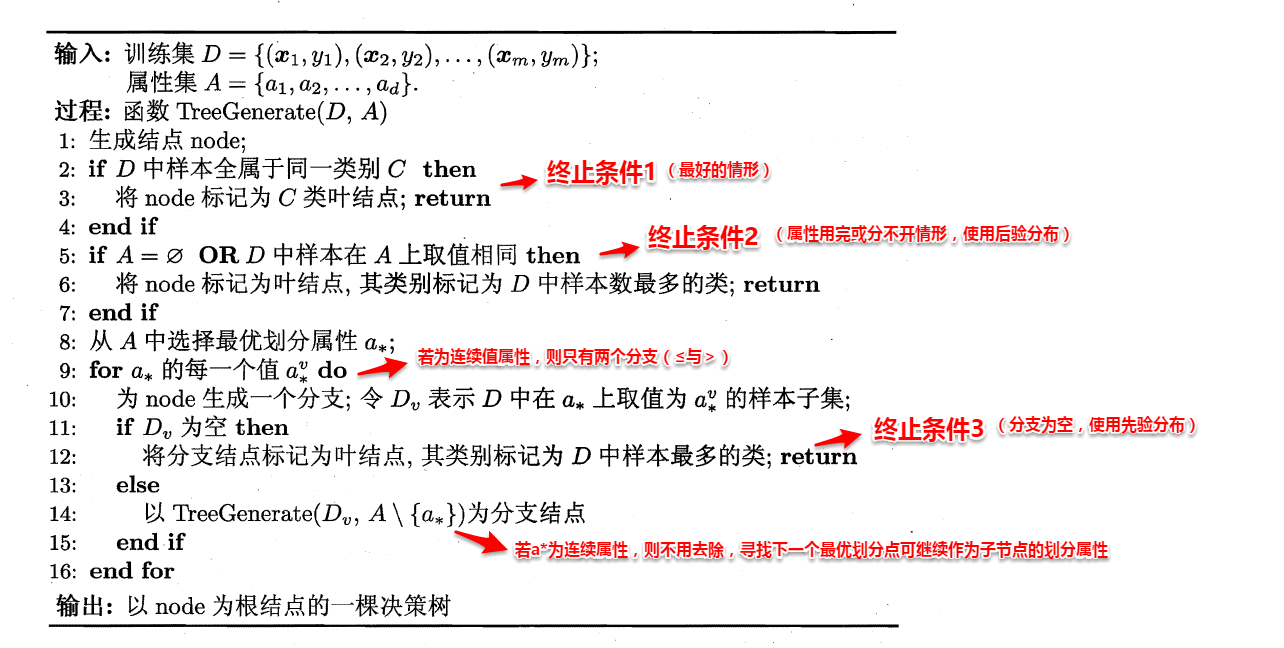

决策树的构造是一个递归的过程,有三种情形会导致递归返回:

- (1) 当前结点包含的样本全属于同一类别,这时直接将该节点标记为叶节点,并设为相应的类别;

- (2) 当前属性集为空,或是所有样本在所有属性上取值相同,无法划分,这时将该节点标记为叶节点,并将其类别设为该节点所含样本最多的类别;

- (3) 当前结点包含的样本集合为空,不能划分,这时也将该节点标记为叶节点,并将其类别设为父节点中所含样本最多的类别。

算法的基本流程如下图所示:

可以看出:决策树学习的关键在于如何选择划分属性,不同的划分属性得出不同的分支结构,从而影响整颗决策树的性能。属性划分的目标是让各个划分出来的子节点尽可能地“纯”,即属于同一类别。因此下面便是介绍量化纯度的具体方法,决策树最常用的算法有三种:ID3,C4.5和CART。

4.2.1 ID3算法

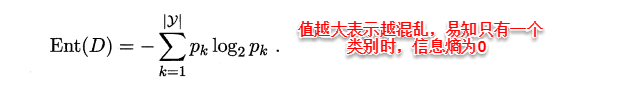

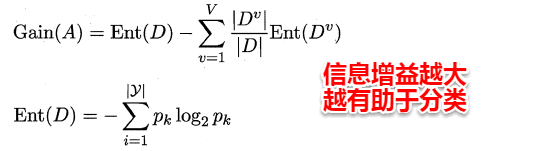

ID3算法使用信息增益为准则来选择划分属性,“信息熵”(information entropy)是度量样本结合纯度的常用指标,假定当前样本集合D中第k类样本所占比例为pk,则样本集合D的信息熵定义为:

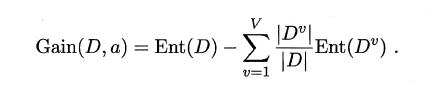

假定通过属性划分样本集D,产生了V个分支节点,v表示其中第v个分支节点,易知:分支节点包含的样本数越多,表示该分支节点的影响力越大。故可以计算出划分后相比原始数据集D获得的“信息增益”(information gain)。

信息增益越大,表示使用该属性划分样本集D的效果越好,因此ID3算法在递归过程中,每次选择最大信息增益的属性作为当前的划分属性。

4.2.2 C4.5算法

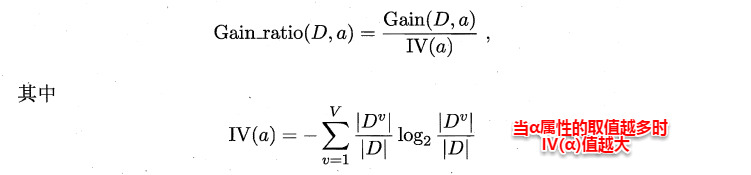

ID3算法存在一个问题,就是偏向于取值数目较多的属性,例如:如果存在一个唯一标识,这样样本集D将会被划分为|D|个分支,每个分支只有一个样本,这样划分后的信息熵为零,十分纯净,但是对分类毫无用处。因此C4.5算法使用了“增益率”(gain ratio)来选择划分属性,来避免这个问题带来的困扰。首先使用ID3算法计算出信息增益高于平均水平的候选属性,接着C4.5计算这些候选属性的增益率,增益率定义为:

4.2.3 CART算法

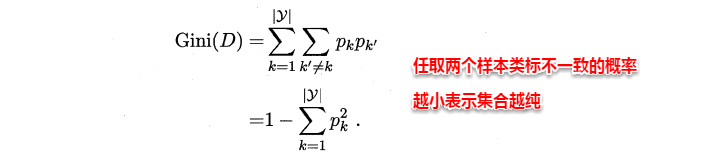

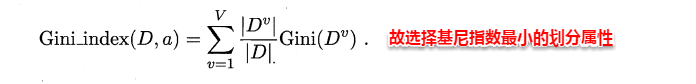

CART决策树使用“基尼指数”(Gini index)来选择划分属性,基尼指数反映的是从样本集D中随机抽取两个样本,其类别标记不一致的概率,因此Gini(D)越小越好,基尼指数定义如下:

进而,使用属性α划分后的基尼指数为:

4.3 剪枝处理

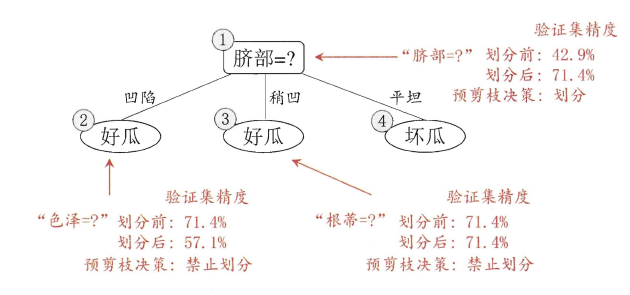

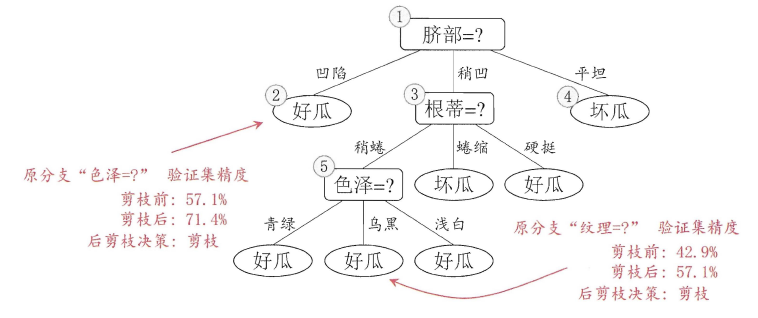

从决策树的构造流程中我们可以直观地看出:不管怎么样的训练集,决策树总是能很好地将各个类别分离开来,这时就会遇到之前提到过的问题:过拟合(overfitting),即太依赖于训练样本。剪枝(pruning)则是决策树算法对付过拟合的主要手段,剪枝的策略有两种如下:

* `预剪枝`(prepruning):在构造的过程中先评估,再考虑是否分支。

* `后剪枝`(post-pruning):在构造好一颗完整的决策树后,自底向上,评估分支的必要性。

评估指的是性能度量,即决策树的泛化性能。之前提到:可以使用测试集作为学习器泛化性能的近似,因此可以将数据集划分为训练集和测试集。

- 预剪枝表示在构造数的过程中,对一个节点考虑是否分支时,首先计算决策树不分支时在测试集上的性能,再计算分支之后的性能,若分支对性能没有提升,则选择不分支(即剪枝)。

- 后剪枝则表示在构造好一颗完整的决策树后,从最下面的节点开始,考虑该节点分支对模型的性能是否有提升,若无则剪枝,即将该节点标记为叶子节点,类别标记为其包含样本最多的类别。

上图分别表示不剪枝处理的决策树、预剪枝决策树和后剪枝决策树。预剪枝处理使得决策树的很多分支被剪掉,因此大大降低了训练时间开销,同时降低了过拟合的风险,但另一方面由于剪枝同时剪掉了当前节点后续子节点的分支,因此预剪枝“贪心”的本质阻止了分支的展开,在一定程度上带来了欠拟合的风险。而后剪枝则通常保留了更多的分支,因此采用后剪枝策略的决策树性能往往优于预剪枝,但其自底向上遍历了所有节点,并计算性能,训练时间开销相比预剪枝大大提升。

##4.4 连续值与缺失值处理

对于连续值的属性,若每个取值作为一个分支则显得不可行,因此需要进行离散化处理,常用的方法为二分法,基本思想为:

给定样本集D与连续属性α,二分法试图找到一个划分点t将样本集D在属性α上分为≤t与>t。

* 首先将α的所有取值按升序排列,所有相邻属性的均值作为候选划分点(n-1个,n为α所有的取值数目)。

* 计算每一个划分点划分集合D(即划分为两个分支)后的信息增益。

* 选择最大信息增益的划分点作为最优划分点。

现实中常会遇到不完整的样本,即某些属性值缺失。有时若简单采取剔除,则会造成大量的信息浪费,因此在属性值缺失的情况下需要解决两个问题:

- (1)如何选择划分属性。

- (2)给定划分属性,若某样本在该属性上缺失值,如何划分到具体的分支上。

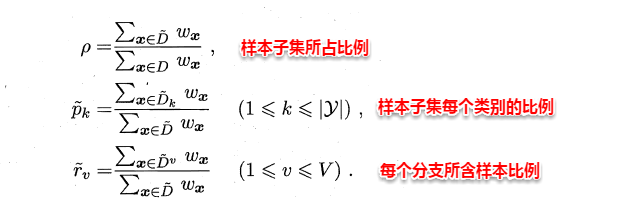

假定为样本集中的每一个样本都赋予一个权重,根节点中的权重初始化为1,则定义:

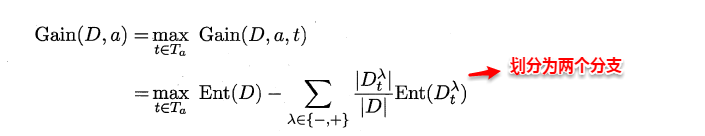

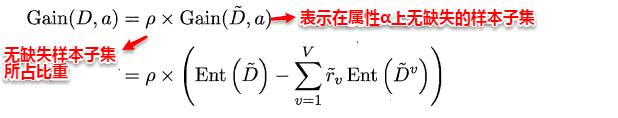

对于(1):通过在样本集D中选取在属性α上没有缺失值的样本子集,计算在该样本子集上的信息增益,最终的信息增益等于该样本子集划分后信息增益乘以样本子集占样本集的比重。即:

对于(2):若该样本子集在属性α上的值缺失,则将该样本以不同的权重(即每个分支所含样本比例)划入到所有分支节点中。该样本在分支节点中的权重变为:

(6)神经网络

上篇主要讨论了决策树算法。首先从决策树的基本概念出发,引出决策树基于树形结构进行决策,进一步介绍了构造决策树的递归流程以及其递归终止条件,在递归的过程中,划分属性的选择起到了关键作用,因此紧接着讨论了三种评估属性划分效果的经典算法,介绍了剪枝策略来解决原生决策树容易产生的过拟合问题,最后简述了属性连续值/缺失值的处理方法。本篇将讨论现阶段十分热门的另一个经典监督学习算法–神经网络(neural network)。

5、神经网络

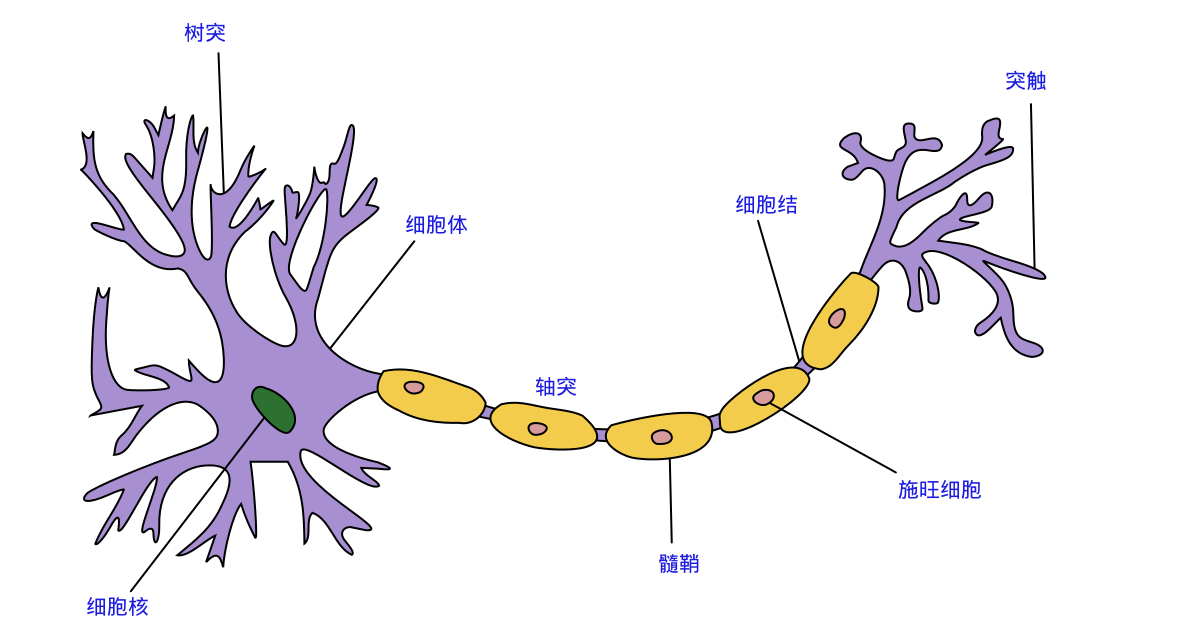

在机器学习中,神经网络一般指的是“神经网络学习”,是机器学习与神经网络两个学科的交叉部分。所谓神经网络,目前用得最广泛的一个定义是“神经网络是由具有适应性的简单单元组成的广泛并行互连的网络,它的组织能够模拟生物神经系统对真实世界物体所做出的交互反应”。

5.1 神经元模型

神经网络中最基本的单元是神经元模型(neuron)。在生物神经网络的原始机制中,每个神经元通常都有多个树突(dendrite),一个轴突(axon)和一个细胞体(cell body),树突短而多分支,轴突长而只有一个;在功能上,树突用于传入其它神经元传递的神经冲动,而轴突用于将神经冲动传出到其它神经元,当树突或细胞体传入的神经冲动使得神经元兴奋时,该神经元就会通过轴突向其它神经元传递兴奋。神经元的生物学结构如下图所示,不得不说高中的生化知识大学忘得可是真干净…

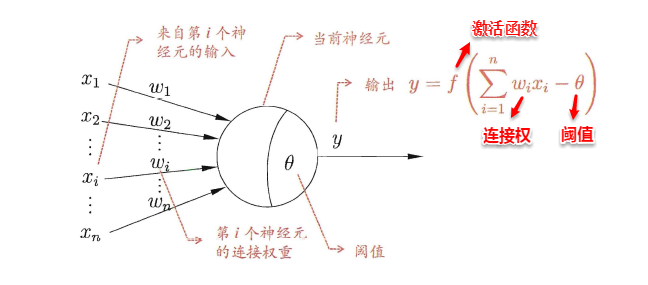

一直沿用至今的“M-P神经元模型”正是对这一结构进行了抽象,也称“阈值逻辑单元“,其中树突对应于输入部分,每个神经元收到n个其他神经元传递过来的输入信号,这些信号通过带权重的连接传递给细胞体,这些权重又称为连接权(connection weight)。细胞体分为两部分,前一部分计算总输入值(即输入信号的加权和,或者说累积电平),后一部分先计算总输入值与该神经元阈值的差值,然后通过激活函数(activation function)的处理,产生输出从轴突传送给其它神经元。M-P神经元模型如下图所示:

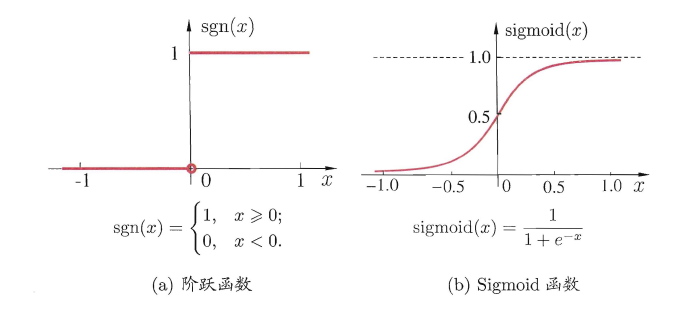

与线性分类十分相似,神经元模型最理想的激活函数也是阶跃函数,即将神经元输入值与阈值的差值映射为输出值1或0,若差值大于零输出1,对应兴奋;若差值小于零则输出0,对应抑制。但阶跃函数不连续,不光滑,故在M-P神经元模型中,也采用Sigmoid函数来近似, Sigmoid函数将较大范围内变化的输入值挤压到 (0,1) 输出值范围内,所以也称为挤压函数(squashing function)。

将多个神经元按一定的层次结构连接起来,就得到了神经网络。它是一种包含多个参数的模型,比方说10个神经元两两连接,则有100个参数需要学习(每个神经元有9个连接权以及1个阈值),若将每个神经元都看作一个函数,则整个神经网络就是由这些函数相互嵌套而成。

5.2 感知机与多层网络

感知机(Perceptron)是由两层神经元组成的一个简单模型,但只有输出层是M-P神经元,即只有输出层神经元进行激活函数处理,也称为功能神经元(functional neuron);输入层只是接受外界信号(样本属性)并传递给输出层(输入层的神经元个数等于样本的属性数目),而没有激活函数。这样一来,感知机与之前线性模型中的对数几率回归的思想基本是一样的,都是通过对属性加权与另一个常数求和,再使用sigmoid函数将这个输出值压缩到0-1之间,从而解决分类问题。不同的是感知机的输出层应该可以有多个神经元,从而可以实现多分类问题,同时两个模型所用的参数估计方法十分不同。

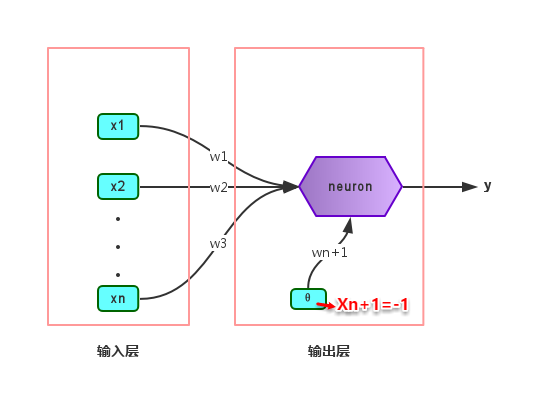

给定训练集,则感知机的n+1个参数(n个权重+1个阈值)都可以通过学习得到。阈值Θ可以看作一个输入值固定为-1的哑结点的权重ωn+1,即假设有一个固定输入xn+1=-1的输入层神经元,其对应的权重为ωn+1,这样就把权重和阈值统一为权重的学习了。简单感知机的结构如下图所示:

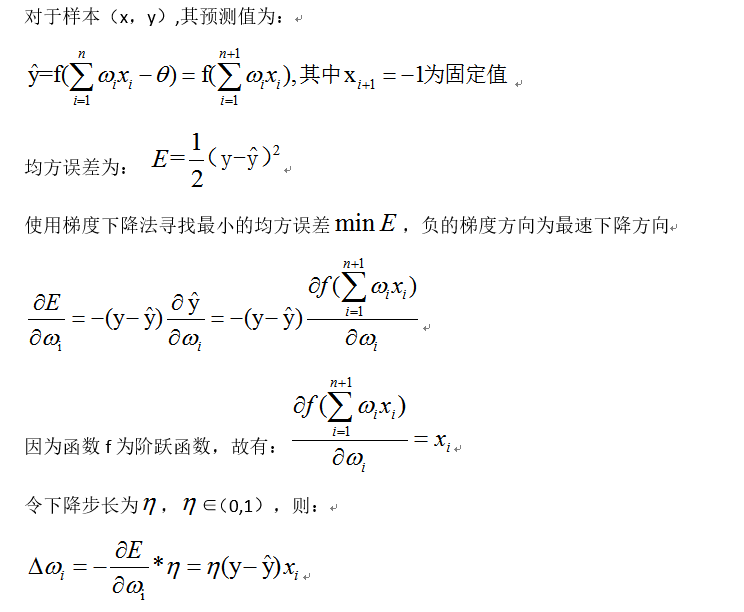

感知机权重的学习规则如下:对于训练样本(x,y),当该样本进入感知机学习后,会产生一个输出值,若该输出值与样本的真实标记不一致,则感知机会对权重进行调整,若激活函数为阶跃函数,则调整的方法为(基于梯度下降法):

其中 η∈(0,1)称为学习率,可以看出感知机是通过逐个样本输入来更新权重,首先设定好初始权重(一般为随机),逐个地输入样本数据,若输出值与真实标记相同则继续输入下一个样本,若不一致则更新权重,然后再重新逐个检验,直到每个样本数据的输出值都与真实标记相同。容易看出:感知机模型总是能将训练数据的每一个样本都预测正确,和决策树模型总是能将所有训练数据都分开一样,感知机模型很容易产生过拟合问题。

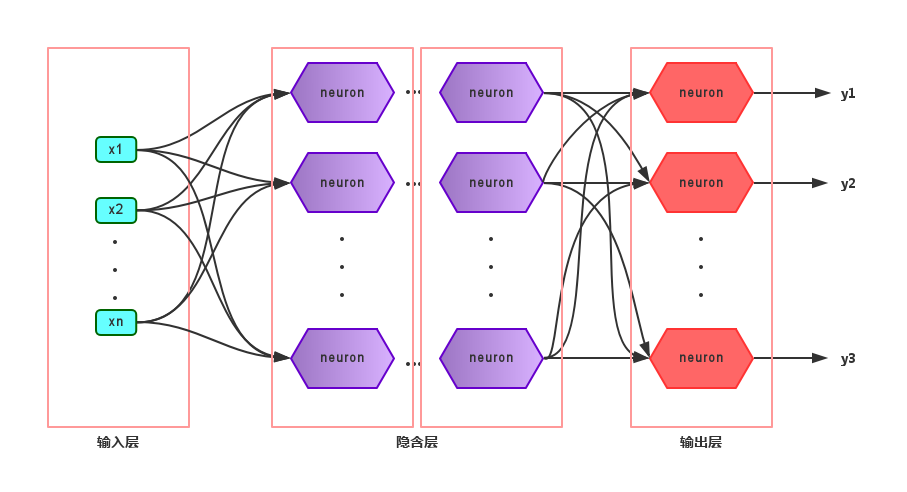

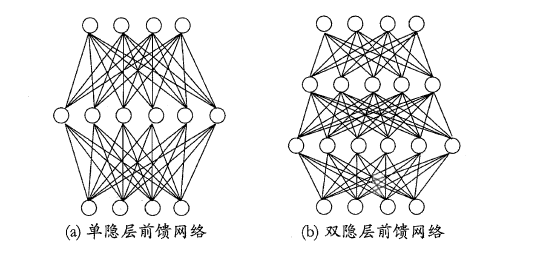

由于感知机模型只有一层功能神经元,因此其功能十分有限,只能处理线性可分的问题,对于这类问题,感知机的学习过程一定会收敛(converge),因此总是可以求出适当的权值。但是对于像书上提到的异或问题,只通过一层功能神经元往往不能解决,因此要解决非线性可分问题,需要考虑使用多层功能神经元,即神经网络。多层神经网络的拓扑结构如下图所示:

在神经网络中,输入层与输出层之间的层称为隐含层或隐层(hidden layer),隐层和输出层的神经元都是具有激活函数的功能神经元。只需包含一个隐层便可以称为多层神经网络,常用的神经网络称为“多层前馈神经网络”(multi-layer feedforward neural network),该结构满足以下几个特点:

* 每层神经元与下一层神经元之间完全互连

* 神经元之间不存在同层连接

* 神经元之间不存在跨层连接

根据上面的特点可以得知:这里的“前馈”指的是网络拓扑结构中不存在环或回路,而不是指该网络只能向前传播而不能向后传播(下节中的BP神经网络正是基于前馈神经网络而增加了反馈调节机制)。神经网络的学习过程就是根据训练数据来调整神经元之间的“连接权”以及每个神经元的阈值,换句话说:神经网络所学习到的东西都蕴含在网络的连接权与阈值中。

5.3 BP神经网络算法

由上面可以得知:神经网络的学习主要蕴含在权重和阈值中,多层网络使用上面简单感知机的权重调整规则显然不够用了,BP神经网络算法即误差逆传播算法(error BackPropagation)正是为学习多层前馈神经网络而设计,BP神经网络算法是迄今为止最成功的的神经网络学习算法。

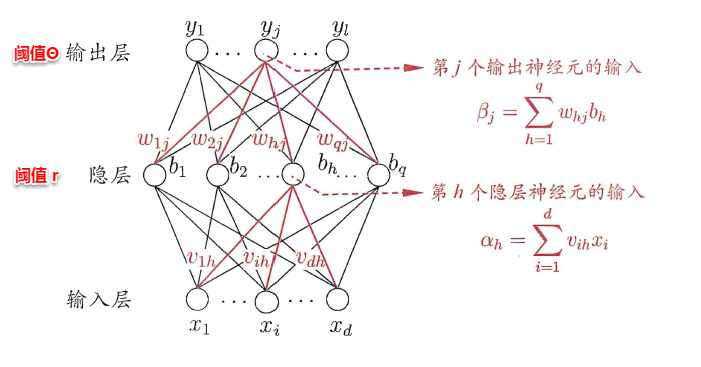

一般而言,只需包含一个足够多神经元的隐层,就能以任意精度逼近任意复杂度的连续函数[Hornik et al.,1989],故下面以训练单隐层的前馈神经网络为例,介绍BP神经网络的算法思想。

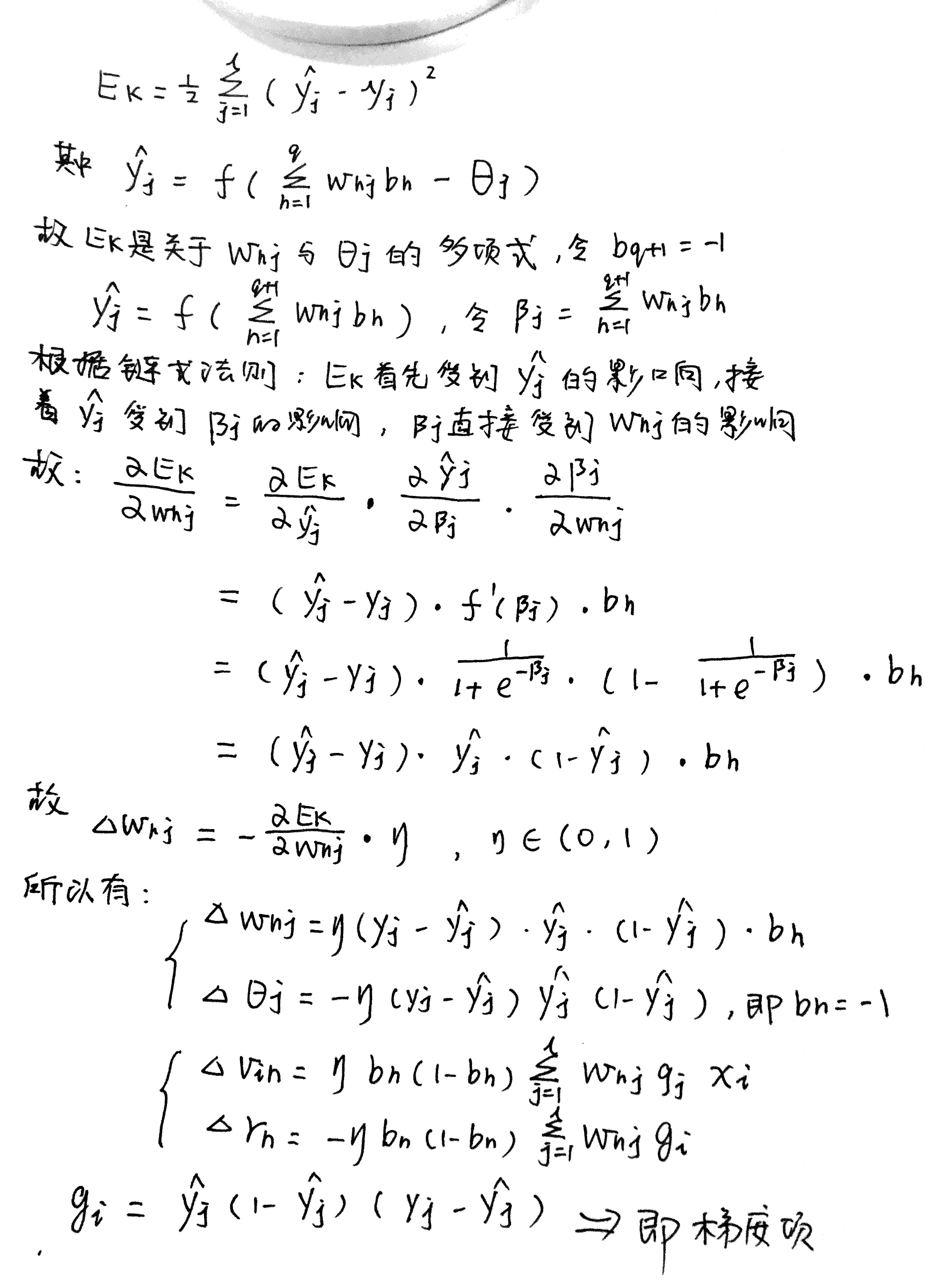

上图为一个单隐层前馈神经网络的拓扑结构,BP神经网络算法也使用梯度下降法(gradient descent),以单个样本的均方误差的负梯度方向对权重进行调节。可以看出:BP算法首先将误差反向传播给隐层神经元,调节隐层到输出层的连接权重与输出层神经元的阈值;接着根据隐含层神经元的均方误差,来调节输入层到隐含层的连接权值与隐含层神经元的阈值。BP算法基本的推导过程与感知机的推导过程原理是相同的,下面给出调整隐含层到输出层的权重调整规则的推导过程:

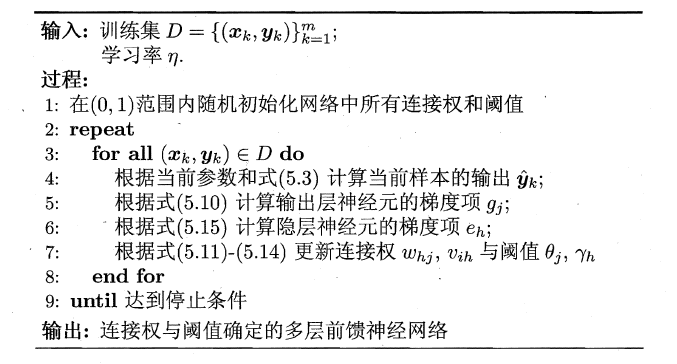

学习率η∈(0,1)控制着沿反梯度方向下降的步长,若步长太大则下降太快容易产生震荡,若步长太小则收敛速度太慢,一般地常把η设置为0.1,有时更新权重时会将输出层与隐含层设置为不同的学习率。BP算法的基本流程如下所示:

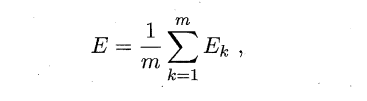

BP算法的更新规则是基于每个样本的预测值与真实类标的均方误差来进行权值调节,即BP算法每次更新只针对于单个样例。需要注意的是:BP算法的最终目标是要最小化整个训练集D上的累积误差,即:

如果基于累积误差最小化的更新规则,则得到了累积误差逆传播算法(accumulated error backpropagation),即每次读取全部的数据集一遍,进行一轮学习,从而基于当前的累积误差进行权值调整,因此参数更新的频率相比标准BP算法低了很多,但在很多任务中,尤其是在数据量很大的时候,往往标准BP算法会获得较好的结果。另外对于如何设置隐层神经元个数的问题,至今仍然没有好的解决方案,常使用“试错法”进行调整。

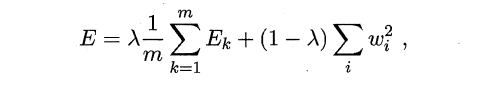

前面提到,BP神经网络强大的学习能力常常容易造成过拟合问题,有以下两种策略来缓解BP网络的过拟合问题:

早停:将数据分为训练集与测试集,训练集用于学习,测试集用于评估性能,若在训练过程中,训练集的累积误差降低,而测试集的累积误差升高,则停止训练。- 引入

正则化(regularization):基本思想是在累积误差函数中增加一个用于描述网络复杂度的部分,例如所有权值与阈值的平方和,其中λ∈(0,1)用于对累积经验误差与网络复杂度这两项进行折中,常通过交叉验证法来估计。

5.4 全局最小与局部最小

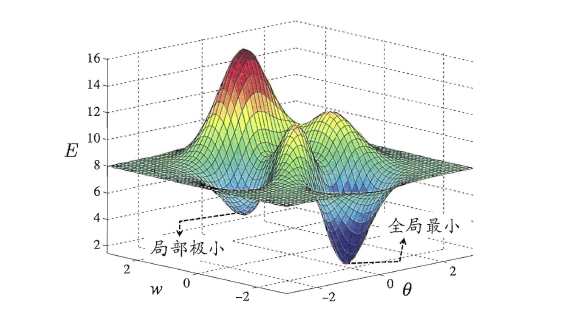

模型学习的过程实质上就是一个寻找最优参数的过程,例如BP算法试图通过最速下降来寻找使得累积经验误差最小的权值与阈值,在谈到最优时,一般会提到局部极小(local minimum)和全局最小(global minimum)。

* 局部极小解:参数空间中的某个点,其邻域点的误差函数值均不小于该点的误差函数值。

* 全局最小解:参数空间中的某个点,所有其他点的误差函数值均不小于该点的误差函数值。

要成为局部极小点,只要满足该点在参数空间中的梯度为零。局部极小可以有多个,而全局最小只有一个。全局最小一定是局部极小,但局部最小却不一定是全局最小。显然在很多机器学习算法中,都试图找到目标函数的全局最小。梯度下降法的主要思想就是沿着负梯度方向去搜索最优解,负梯度方向是函数值下降最快的方向,若迭代到某处的梯度为0,则表示达到一个局部最小,参数更新停止。因此在现实任务中,通常使用以下策略尽可能地去接近全局最小。

* 以多组不同参数值初始化多个神经网络,按标准方法训练,迭代停止后,取其中误差最小的解作为最终参数。

* 使用“模拟退火”技术,这里不做具体介绍。

* 使用随机梯度下降,即在计算梯度时加入了随机因素,使得在局部最小时,计算的梯度仍可能不为0,从而迭代可以继续进行。

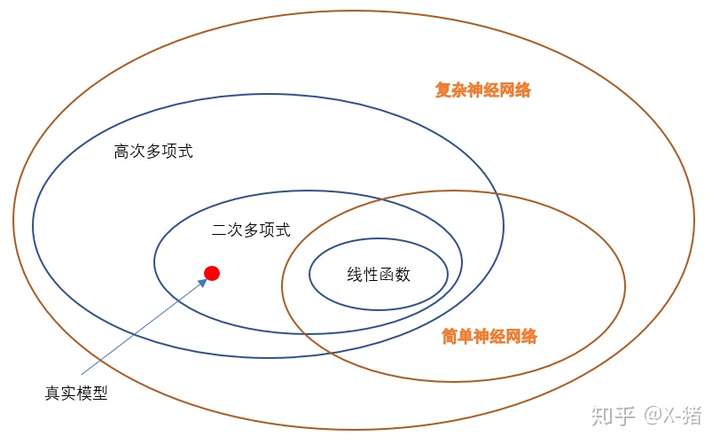

5.5 深度学习

理论上,参数越多,模型复杂度就越高,容量(capability)就越大,从而能完成更复杂的学习任务。深度学习(deep learning)正是一种极其复杂而强大的模型。

怎么增大模型复杂度呢?两个办法,一是增加隐层的数目,二是增加隐层神经元的数目。前者更有效一些,因为它不仅增加了功能神经元的数量,还增加了激活函数嵌套的层数。但是对于多隐层神经网络,经典算法如标准BP算法往往会在误差逆传播时发散(diverge),无法收敛达到稳定状态。

那要怎么有效地训练多隐层神经网络呢?一般来说有以下两种方法:

-

无监督逐层训练(unsupervised layer-wise training):每次训练一层隐节点,把上一层隐节点的输出当作输入来训练,本层隐结点训练好后,输出再作为下一层的输入来训练,这称为预训练(pre-training)。全部预训练完成后,再对整个网络进行微调(fine-tuning)训练。一个典型例子就是深度信念网络(deep belief network,简称DBN)。这种做法其实可以视为把大量的参数进行分组,先找出每组较好的设置,再基于这些局部最优的结果来训练全局最优。 -

权共享(weight sharing):令同一层神经元使用完全相同的连接权,典型的例子是卷积神经网络(Convolutional Neural Network,简称CNN)。这样做可以大大减少需要训练的参数数目。

深度学习可以理解为一种特征学习(feature learning)或者表示学习(representation learning),无论是DBN还是CNN,都是通过多个隐层来把与输出目标联系不大的初始输入转化为与输出目标更加密切的表示,使原来只通过单层映射难以完成的任务变为可能。即通过多层处理,逐渐将初始的“低层”特征表示转化为“高层”特征表示,从而使得最后可以用简单的模型来完成复杂的学习任务。

传统任务中,样本的特征需要人类专家来设计,这称为特征工程(feature engineering)。特征好坏对泛化性能有至关重要的影响。而深度学习为全自动数据分析带来了可能,可以自动产生更好的特征。

(7)支持向量机

上篇主要介绍了神经网络。首先从生物学神经元出发,引出了它的数学抽象模型–MP神经元以及由两层神经元组成的感知机模型,并基于梯度下降的方法描述了感知机模型的权值调整规则。由于简单的感知机不能处理线性不可分的情形,因此接着引入了含隐层的前馈型神经网络,BP神经网络则是其中最为成功的一种学习方法,它使用误差逆传播的方法来逐层调节连接权。最后简单介绍了局部/全局最小以及目前十分火热的深度学习的概念。本篇围绕的核心则是曾经一度取代过神经网络的另一种监督学习算法–支持向量机(Support Vector Machine),简称SVM。

SVM 历史

SVM历史 参考

- 1963年,Vapnik在解决模式识别问题时提出了支持向量方法。起决定性作用的样本为支持向量

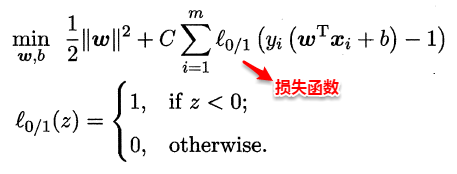

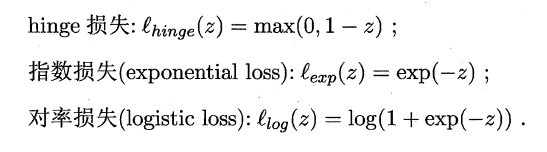

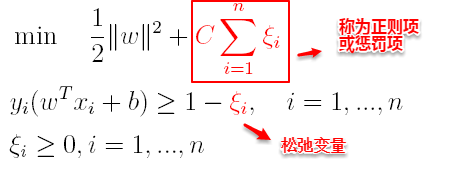

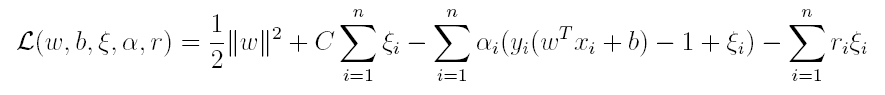

- 1971年,Kimeldorf构造基于支持向量构建核空间的方法