- Python

- 高级语法

- python技能

- Python生态系统

- 空值判断

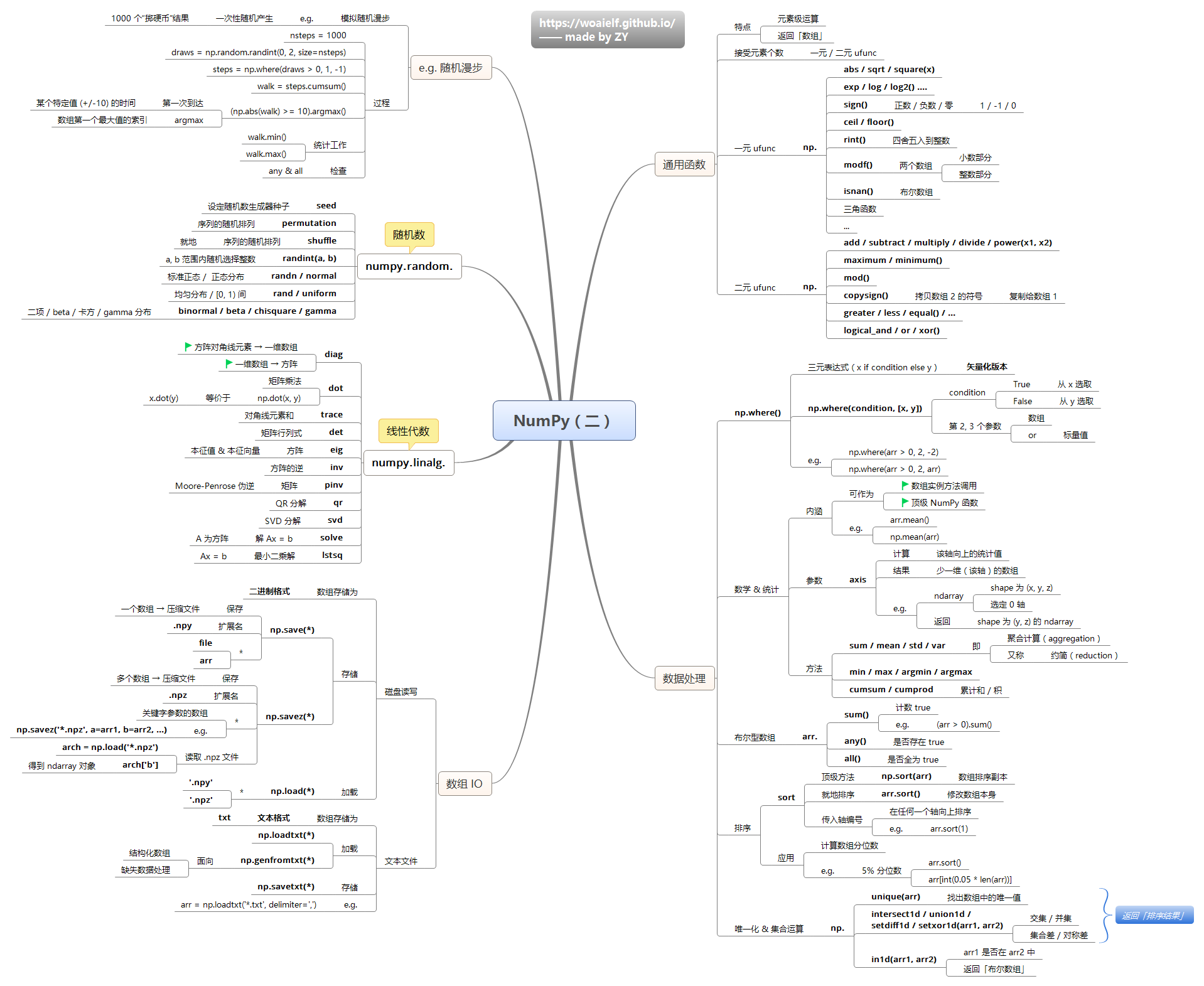

- 数学函数

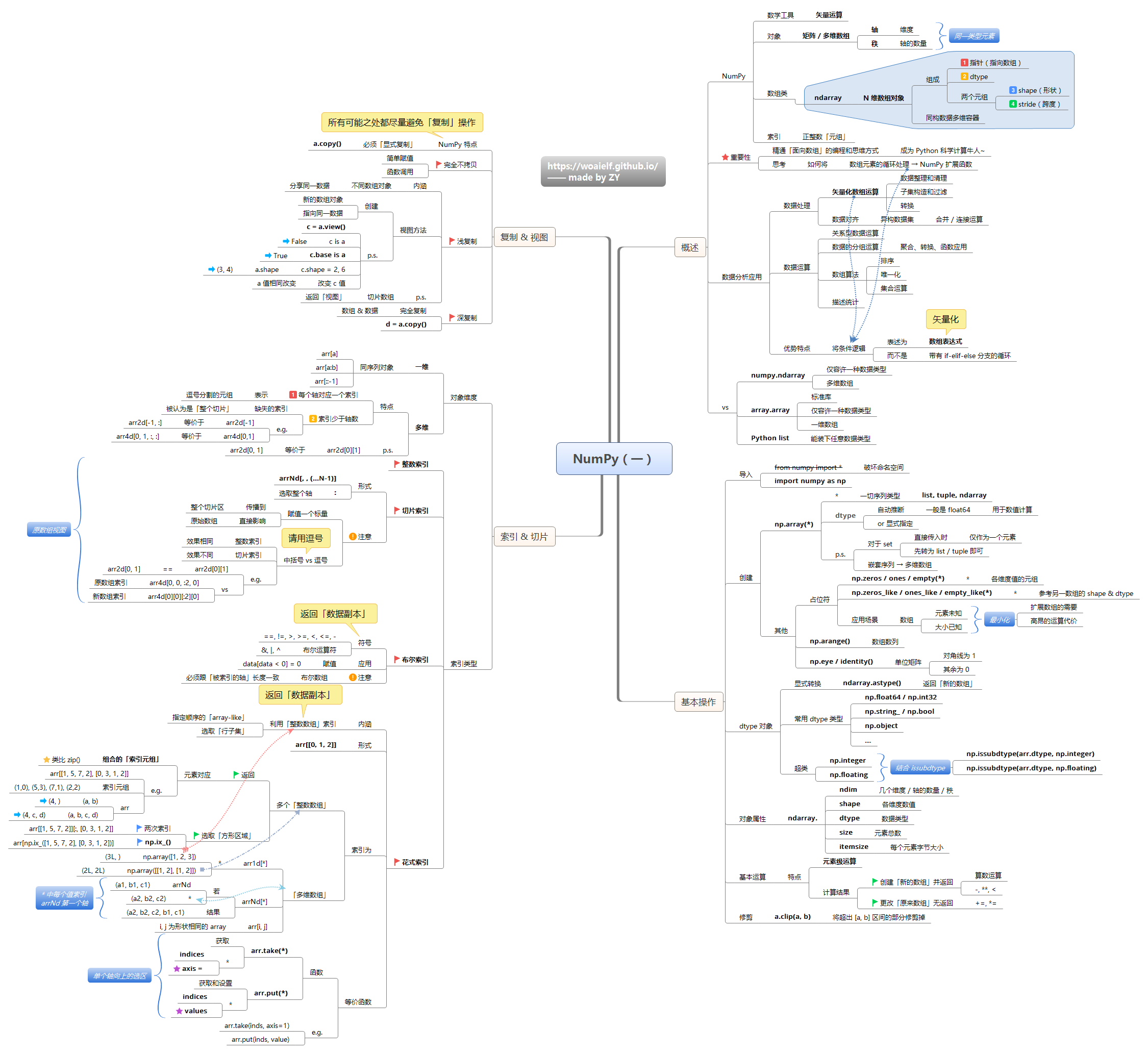

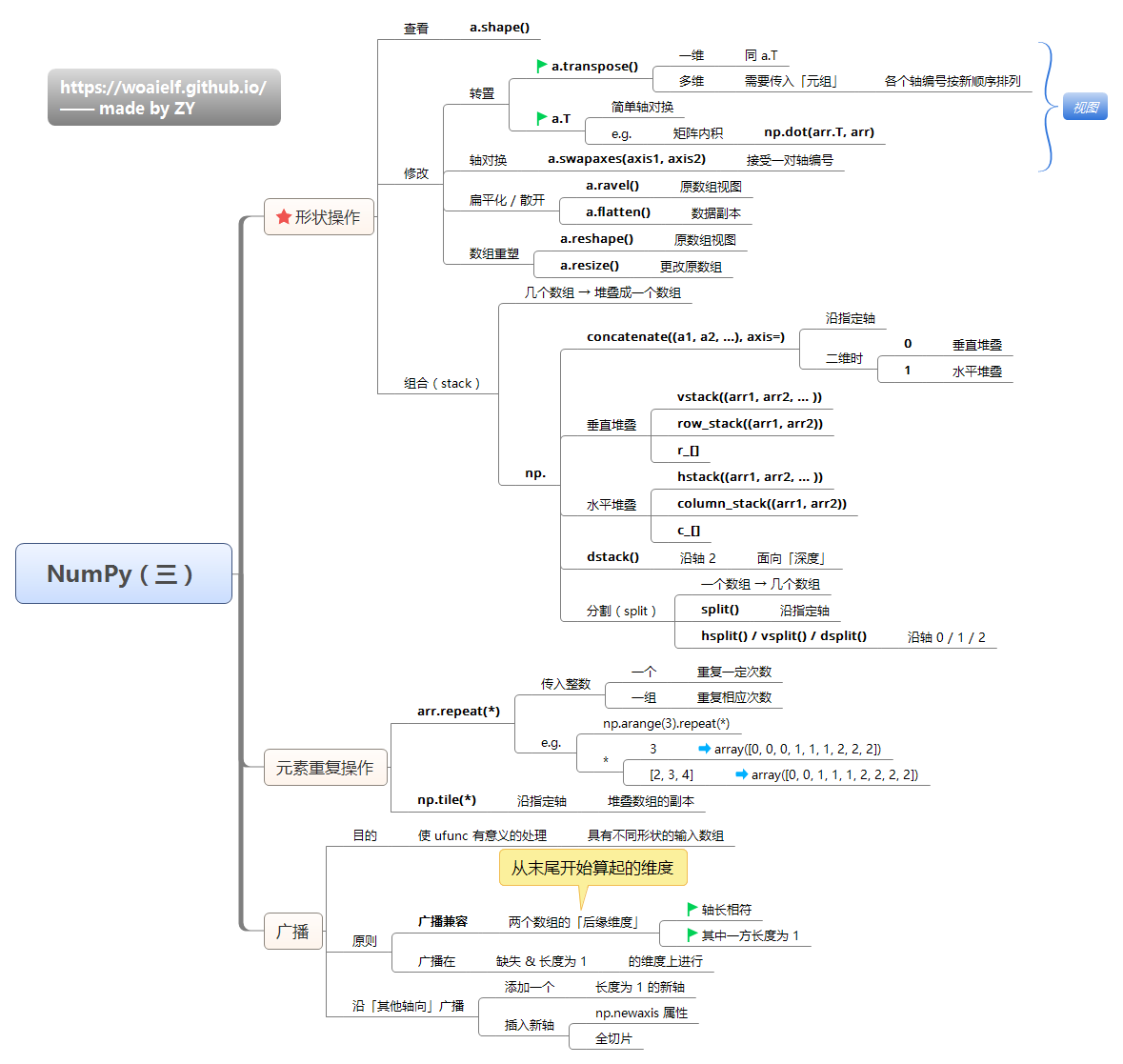

- Numpy

- Arrow

- Pandas

- Python技巧

- 1. 重复元素判定

- 2. 字符元素组成判定

- 3. 内存占用

- 4. 字节占用

- 5. 打印 N 次字符串

- 6. 大写第一个字母

- 7. 分块

- 8. 压缩

- 9. 解包

- 10. 链式对比

- 11. 逗号连接

- 12. 元音统计

- 13. 首字母小写

- 14. 展开列表

- 15. 列表的差

- 16. 通过函数取差

- 17. 链式函数调用

- 18. 检查重复项

- 19. 合并两个字典

- 20. 将两个列表转化为字典

- 21. 使用枚举

- 22. 执行时间

- 23. Try else

- 24. 元素频率

- 25. 回文序列

- 26. 不使用 if-else 的计算子

- 27. Shuffle

- 28. 展开列表

- 29. 交换值

- 30. 字典默认值

- 结束

Python

Python简介

1989年,吉多·范罗苏姆(Guido van Rossum),外号龟叔,1956年出生,荷兰人,26岁在阿姆斯特丹大学获得数学和计算机科学硕士学位。1989年圣诞节,33岁的龟叔为打发时间,决定为当时正构思的一个新的脚本语言编写一个解释器。当时电视上非常流行一个电视剧蒙提·派森的飞行马戏团,作为这个马戏团的狂热粉丝,他以Python命名该项目,使用C进行开发,于是Python就诞生了。

Python(脚本语言)← C语言

- Python的底层是用C语言写的,很多标准库和第三方库也都是用C写的,运行速度非常快

- Python是纯粹的自由软件, 源代码和解释器CPython遵循 GPL(GNU General Public License)协议 。Python语法简洁清晰,特色之一是强制用空白符(white space)作为语句缩进。Python具有丰富和强大的库。它常被昵称为胶水语言,能够把用其他语言制作的各种模块(尤其是C/C++)很轻松地联结在一起。

- 最初的Python用 C语言编写实现,又称为 CPython。一般所讨论的Python其实就是 CPython。

- 随着编程语言的不断发展,Python 的实现方式也发生了变化,除了用 C 语言实现外,Python 还有其他的实现方式。

- 用

Java语言实现的 Python 称为JPython - 用

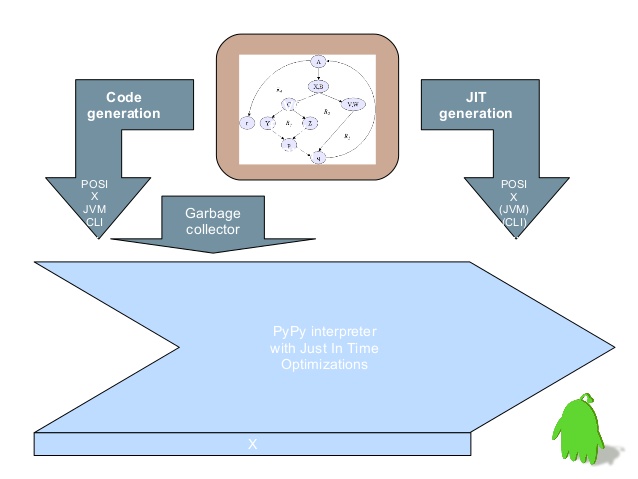

.net实现的 Python 称为IronPython等等。 PyPy可能是最令人兴奋的 Python 实现,因为其目标就是将 Python 重写为 Python。在 PyPy 中,Python 解释器本身是用 Python 编写的。

更多编程语言介绍:

Python 2 vs Python 3

python2 不支持的 Python3语法,案例如下:

# ** 用法

outputs = model.generate(**inputs, max_new_tokens=20)

【2020-8-24】Python代码版本转换

2to3 -help # 帮助

2to3 -w . #将当前整个文件夹代码从python2转到python3

# python2文件会在.py后面再加上一个后缀.bak,而新生成的python3文件使用之前python2文件的命名

安装 python

工具包安装

Mac

mac下安装命令

- 先安装 homebrew

# === brew 工具 ====

# 安装homebrew

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

# 搜索Python版本

brew search python3

# 安装

brew install python@3.8

Windows

windows下安装

- windows miniconda 下载地址

curl https://repo.anaconda.com/miniconda/Miniconda3-latest-Windows-x86_64.exe -o miniconda.exe

start /wait "" miniconda.exe /S

del miniconda.exe

编译安装

自动编译

- 【2020-7-3】脚本如下:

#-----自定义区------

# 下载python3

src_file='https://www.python.org/ftp/python/3.8.3/Python-3.8.3.tgz'

file_name="${src_file##*/}"

install_dir=~/bin

#-------------------

[ -e ${file_name} ]||{

wget ${src_file}

echo "下载完毕..."

}&& echo "文件已存在, $file_name"

# 解压

tar zxvf ${file_name}

echo "安装目录: $install_dir"

# 安装

new_dir=${file_name%.*}

cd $new_dir

./configure --prefix=${install_dir}/python38

# 如果不设置安装目录prefix, 就会提示sudo权限

make && make install

echo "安装完毕,请设置环境变量"

No module named _ssl

错误:No module named ‘_ssl’

- 原因:虽然 mac 系统已经装了openssl包及相关的头文件,但是默认python3.7的源码包中指定的ssl头文件目录不包含mac上openssl的路径

- 备注:macos 没有openssl-devel这个安装包,内容都已经在openssl中了

#./configure --with-ssl # 注明ssl

# [2023-8-5] Debian 10实践,pip install命令瘫痪,编译安装时没有纳入openssl

./configure --prefix=/home/wangqiwen.at/bin --with-ssl=/usr/bin/openssl

# 另一种配置

./configure --prefix=/web-soft/Python-3.11.4 --with-openssl-rpath=auto --with-openssl=/usr/local/openssl

make

sudo make install

【2023-8-5】Python3.8 SSL模块报错 No module named ‘_ssl’, 但Python3.6.9却没有报错。 解法

- 下载 Python 3.8.2

- 解压的文件中找到

Python-3.8.2/Modules/Setup文件 - 注释掉 5行,删掉原bin文件,重新编译

- 再次 import ssl,验证

# Socket module helper for socket(2)

_socket socketmodule.c timemodule.c

# Socket module helper for SSL support; you must comment out the other

# socket line above, and possibly edit the SSL variable:

SSL=/usr/local/ssl

_ssl _ssl.c \

-DUSE_SSL -I$(SSL)/include -I$(SSL)/include/openssl \

-L$(SSL)/lib -lssl -lcrypto

# -------- 再次编译 ------

./configure --prefix=/usr/local/python3.8/

make

make install

【2025-5-14】腾讯云服务器上,CentSO 编译安装 python 3.11,再次遇到 ssl 问题

- 以上解法都失效

解决方法

- SSL模块错误:如果出现 Could not build the ssl module!错误,确保安装了

openssl11

# 下载最新的软件安装包

wget https://www.python.org/ftp/python/3.11.0/Python-3.11.0.tgz

# 解压缩安装包

tar -xzf Python-3.11.0.tgz

pip install openai # 此时报错 ssl 连接问题

# -------------------------------

# SSL模块错误:如果出现Could not build the ssl module!错误,确保安装了openssl11

# centos 里 ssl 自带, 路径 /usr/bin/openssl

# 重新安装依赖包

sudo yum -y install gcc zlib zlib-devel libffi libffi-devel readline-devel openssl-devel openssl11 openssl11-devel

# 设置环境变量

export CFLAGS=$(pkg-config --cflags openssl11)

export LDFLAGS=$(pkg-config --libs openssl11)

# 编译安装,指定 openssl 路径

./configure --prefix=/usr/local/python --with-ssl=/usr/bin/openssl

# 编译

make

sudo make install

环境变量

# 设置环境变量

#vim ~/.bash_profile

echo "

alias python3='${install_dir}/python38/bin/python3.8'

alias pip3='${install_dir}/python38/bin/pip3'

" >> ~/.bash_profile

echo '生效'

source ~/.bash_profile

echo '修改pip源'

mkdir ~/.pip

echo "

[global]

index-url = https://pypi.tuna.tsinghua.edu.cn/simple

[install]

trusted-host=mirrors.aliyun.com

" > ~/.pip/pip.conf

# 或者一行命令设置

#pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

Python 编译器

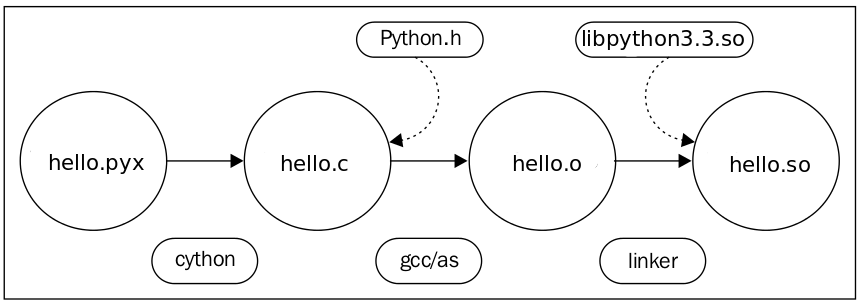

Python解释器可用多种语言来实现,如

- CPython(用C编写)

- Jython(用Java编写)

- Iron Python(用.NET编写)

- PyPy(用Python编写)

CPython

CPython是Python解释器的最初实现,使用最广,最多维护

从Python官方网站下载并安装好Python 3.x后,就直接获得了一个官方版本的解释器:CPython

由于CPython是高级解释语言,因此有一定局限性,并且在速度方面没有任何优势

CPython 使用一种称为引用计数的技术。

- 每当引用对象时,Python对象的引用计数都会增加,而在取消引用该对象时则递减计数。

- 当引用计数为零时,CPython会自动为该对象调用内存释放函数。

陷阱

- 当大型对象树的引用计数变为零时,所有相关对象将被释放。因此,可能有很长的暂停时间,在此期间您的程序根本无法执行。

- 引用循环: 引用计数根本不起作用

class A(object):

pass

a = A()

a.some_property = a

del a

CPython 用循环垃圾回收器 解决

- 从已知根(如类型对象)开始遍历内存中的所有对象。

- 然后,标识所有可访问对象,并释放不可访问的对象,因为不再存在。

这样就解决了引用循环问题。

但是,当内存中存在大量对象时,可能会创建更明显的暂停。

PyPy 不用 引用计数,只使用第二种技术,即循环查找器。

- 定期从根开始遍历活动对象。

- 这使PyPy比CPython 优势,不需要考虑引用计数,从而使内存管理花费的总时间少于CPython。此方法只在每个次要集合之后添加几毫秒,而不像CPython那样一次添加数百毫秒

pypy

PyPy是CPython的一种快速且功能强大的替代方案, 不改代码的情况下大大提高速度。但它也不是万能,有一些局限性

Python 程序运行不快,要切换到另一种编程语言吗?

- 不一定。可以放弃 python.py 运行方式,转而使用 PyPy 即时编译器。

- Python 创建者 Guido von Rossum 都建议将

PyPy用于关键性能的 Python 程序。 - PyPy是不是真的比Python快?

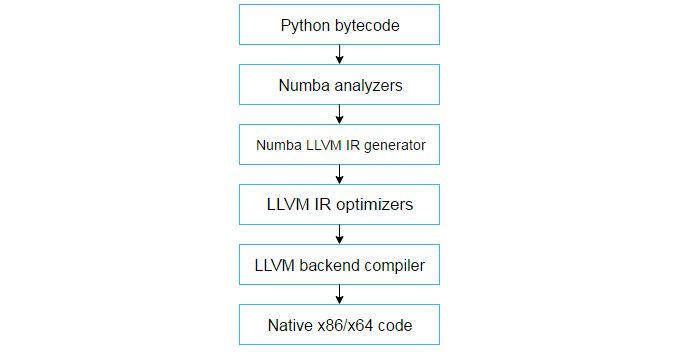

PyPy 是 Python的JIT版本,如果存在大量高耗时且重复执行的代码, pypy运行速度比Python快很多.

PyPy 提升速度的秘诀: 「即时编译( just-in-time compilation)」,即 JIT 编译。

提前编译:- C、C ++、Swift、Haskell、Rust 等编程语言提前编译(AOT 编译)。

- 用这些语言编写代码之后,编译器会将源代码转换成特定计算机架构可读的机器码。

- 执行程序时,执行的并不是原始源代码,而是机器码。

解释语言:- Python、JavaScript、PHP 等。

- 与将源代码转换为机器码相比,解释过程中, 源代码是保持不变。

- 每次运行程序时,解释器都会逐行查看代码并运行。例如,每个 Web 浏览器都内置了 JavaScript 解释器。

PyPy 不同于解释器,并不会逐行运行代码,而是先将部分代码编译成机器码。

Pypy 安装

- 命令安装: 如下

- 源码安装:官网下载,然后添加路径到 PATH

brew install pypy3

效率对比

- 测试代码中, PyPy 速度大约是Python的94倍, 实测 45 倍

- 平均而言,速度是Python的4.3倍

- 参考

测试代码

import time

start_time = time.time()

total = 0

for i in range(1, 10000):

for j in range(1, 10000):

total += i + j

print(f"The result is {total}")

end_time = time.time()

print(f"It took {end_time-start_time:.2f} seconds to compute")

Mac OS 上实测

- 10.44/0.23=45.4

python

# Python 3.10.10 (main, Mar 21 2023, 13:41:39) [Clang 14.0.6 ] on darwin

# Type "help", "copyright", "credits" or "license" for more information.

brew install pypy3

# 安装后直接输入pypy3即可

pypy3

# Python 3.10.13 (fc59e61cfbff, Jan 15 2024, 14:27:53)

# [PyPy 7.3.15 with GCC Apple LLVM 15.0.0 (clang-1500.1.0.2.5)] on darwin

# Type "help", "copyright", "credits" or "license" for more information.

python test.py

# The result is 999800010000

# It took 10.44 seconds to compute

pypy3 test.py

# The result is 999800010000

# It took 0.23 seconds to compute

PyPy的局限性

- PyPy并非万能,并不适合所有任务。

- 甚至可能执行速度比CPython慢得多。

不适用于

- C扩展: C扩展模块运行速度都要比在CPython中慢得多。

- 原因: PyPy无法优化C扩展模块,因为不受完全支持。PyPy必须模拟代码中的引用计数,使其更慢。

- PyPy团队建议去掉CPython扩展并将其替换为纯Python版本。

- 如果不行的话,则必须使用CPython。

- 核心团队正在处理C扩展。有些软件包已被移植到PyPy,并且工作速度也同样快。

PyPy最适合纯Python应用程序, 长时间运行的程序

- PyPy运行时,执行许多操作以使代码运行得更快。

- 如果脚本本身很简单,则运行速度会低于CPython。

- 如果长时间运行,可能会带来显著的性能提升。

PyPy不是一个完全编译型的Python实现

pip

Python工具包查询网站 pypi: Find, install and publish Python packages with the Python Package Index

直接下载文件

注意

- 跟 Python版本匹配,不要错位。 如 Python 3.6就用pip

pip 安装

【2023-2-3】 阿里云服务器不管用,卡住了

# 下载安装脚本

curl https://bootstrap.pypa.io/get-pip.py -o get-pip.py # [2023-2-3] 阿里云服务器不管用,卡住了

wget https://pip.pypa.io/en/stable/installation/#get-pip-py # 从pip官网直接下文件

wget https://bootstrap.pypa.io/get-pip.py # 安装

# 【2023-8-5】微云下载地址

https://share.weiyun.com/2Dr0n4G8

# 直接从whl包安装pip

python -m pip install --upgrade xxx # 注意:pip轮子的文件名.whl

python -m ensurepip --upgrade # 更新

# 【2023-8-5】debian系统,改用命令:

sudo apt install python3-pip

# =========

sudo python get-pip.py # python2

sudo python3 get-pip.py # python3

# mac 下安装

sudo easy_install pip

# 源码安装

wget "https://pypi.python.org/packages/source/p/pip/pip-1.5.4.tar.gz#md5=834b2904f92d46aaa333267fb1c922bb" --no-check-certificate

tar zxvf pip-1.5.4.tar.gz

python setup.py install

# 版本升级

python -m pip install --upgrade pip==20.0.2

【2024-12-12】直接安装 wheel 包

pip install pymupdf-1.25.1-cp39-abi3-win_amd64.whl

【2023-3-2】

- 错误: Defaulting to user installation because normal site-packages is not writeable

- 原因:

- 使用错误Python版本导致: python3 -m pip install $pkg_name

- 当前用户权限不足:

- pip install numpy –user

- sudo pip install numpy

配置pip源

pip源采用阿里云的pip源用于加速下载文件

- 阿里云:http://mirrors.aliyun.com/help/pypi

windows powershell

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

Linux/Mac

在 ~/.pip/pip.conf

[global]

index-url = http://mirrors.aliyun.com/pypi/simple/

[install]

trusted-host=mirrors.aliyun.com

# [install] trusted-host=mirrors.aliyun.com

【2023-8-5】由于pip.conf文件填写错误([install]未换行)导致:

目前收集的比较好的镜像地址有:

- http://pypi.v2ex.com/simple/

- http://pypi.douban.com/simple/

- http://mirrors.aliyun.com/pypi/simple/

pip安装时速度慢或者报超时?

解决办法:指定库地址,最好是国内

#(1)-i 指定源

sudo pip install face_recognition -i https://pypi.tuna.tsinghua.edu.cn/simple

# (2)设置超时时间

pip --default-timeout=100 install ....

#(3)新建文件pip.conf,内容:

mkdir ~/.pip

# [global]

# timeout = 6000

# index-url = http://pypi.tuna.tsinghua.edu.cn/simple/

# [install]

# use-mirrors = true

# mirrors = http://pypi.tuna.tsinghua.edu.cn/simple/

# trusted-host = pypi.tuna.tsinghua.edu.cn

pip install $p --trusted-host didiyum.sys.xiaojukeji.com -i http://didiyum.sys.xiaojukeji.com/didiyum/pip/simple/

pip 问题

pip 使用问题

ctypes

【2023-8-7】pip install 报错

ModuleNotFoundError: No module named '_ctypes'- 原因:Python3 有个内置模块 ctypes,外部函数库模块,兼容C语言的数据类型,并通过它调用Linux系统下的共享库(Shared library)

解决方法: 参考

- (1)、安装 libffi-devel

- centos下,可以使用命令 yum install libffi-devel -y

- ubuntu下,可以使用命令 sudo apt-get install libffi-dev

- (2)、重新安装python3版本即可

- python3源码安装包下执行命令:make install,重新进行安装

错误

ImportError: No module named bz2- 分析: debian 系统上没有安装bz2工具包

- 解法: 安装bz2后重新编译Python

sudo apt-get install libbz2-dev

ubuntu

【2025-1-8】ubuntu 新系统下实践

- 直接 pip install flask 报错

- 错误信息:

externally-managed-environment

原因

- “外部管理环境”错误背后的原因:Manjaro 22、Ubuntu 23.04、Fedora 38 以及其他的最新发行版中,正在使用 Python 包来实现此增强功能。

- 这个更新是为了避免「操作系统包管理器 (如pacman、yum、apt) 和 pip 等特定于 Python 的包管理工具之间的冲突」。

解法

- 修改变量

- sudo mv /usr/lib/python3.x/EXTERNALLY-MANAGED /usr/lib/python3.x/EXTERNALLY-MANAGED.bk

- 实践:无效,不存在对应文件

- 使用 pipx:

- sudo apt install pipx

- pipx ensurepath

- pipx install flask

- 开启虚拟环境后,再使用 pip —— 实践有效

windows site-package

【2025-3-12】python之修改pip默认install路径

- windows 环境下,Python pip 安装库,默认在C盘, 导致C盘空间满

- 比如

C:\Users\wqw\AppData\Roaming\Python\Python37\site-packages

- 比如

查看默认安装路径

- USER_BASE 和 USER_SITE 就是默认路径

python -m site

sys.path = [

'F:\\',

'D:\\Programs\\Python\\Python37\\python37.zip',

'D:\\Programs\\Python\\Python37\\DLLs',

'D:\\Programs\\Python\\Python37\\lib',

'D:\\Programs\\Python\\Python37',

'C:\\Users\\wqw\\AppData\\Roaming\\Python\\Python37\\site-packages',

'D:\\Programs\\Python\\Python37\\lib\\site-packages',

]

USER_BASE: 'C:\\Users\\wqw\\AppData\\Roaming\\Python' (exists)

USER_SITE: 'C:\\Users\\wqw\\AppData\\Roaming\\Python\\Python37\\site-packages' (exists)

ENABLE_USER_SITE: True

解法:

- 修改文件

D:\Programs\Python\Python37\lib\site.py

ENABLE_USER_SITE = True

USER_SITE = r"D:\Programs\Python\Python37\Lib\site-packages"

USER_BASE = r"D:\Programs\Python\Python37\Scripts"

pip 用法

pip命令:

- show:显示包详细信息

- list:list –outdate查看过期的包

- install :

pip install pyecharts==0.4.1(安装指定版本)pip install --upgrade pyecharts(升级)

- uninstall

- search

# pip版本

pip -v

# --- python ----

import sys

#sys模块提供了一系列有关Python运行环境的变量和函数。

print(sys.version)

#sys.version用来获取Python解释程序的版本信息

# ------------

pip -h

# 从备用索引安装

pip install --index-url http://my.package.repo/simple/ SomeProject

# 在安装期间搜索附加索引,PyPI

pip install --extra-index-url http://my.package.repo/simple SomeProject

# 指定源

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple some-package matplotlib

# 设为默认

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

# 指定版本

pip install 模块名==版本号

# 安装特定的源存档文件。

pip install ./downloads/SomeProject-1.0.4.tar.gz

# whl包

pip install test.whl

# 批量安装

pip install -r requirements.txt

# 升级

pip install --upgrade package_name

pip install -U transformers==4.38.2 # [2024-3-16]

# 查看信息

pip show -f package_name

# 查看已安装的库

pip list

# 已经安装的库中,看哪些需要版本升级

pip list -o

# 把已经安装的库信息保存到到本地txt文件中

pip freeze > requirements.txt

# 验证已安装的库是否有兼容依赖问题

pip check package-name

# 将库下载到本地指定文件,保存为whl格式

pip download package_name -d "要保存的文件路径"

# 卸载

pip uninstall package_name

特殊用法

pip install "project[extra]"

pip install splinter django # 安装两个名为 splinter 和 django 的包。

pip install splinter[django] # 安装 splinter 包的变体,其中包含对 django 的 _支持_。请注意,与 django 包本身无关,而只是由 splinter 包定义的字符串,用于启用的特定功能集

installing 对 splinter 新增支持的软件包django。方括号([])不是特定的语法,只是约定。安装名为的软件包”splinter[django]“。

解释@chetner:

- 该命令

pip install splinter django将安装两个名为splinter和的软件包django。splinter[django] - 安装的一个变体splinter,其包含包支持对django。

注意,与django程序包本身无关,只是splinter程序包为启用的特定功能集定义的字符串。

pip search

【2023-5-30】pip search命令废弃

故障

(py310) TQV9MF4NXR:tree-of-thoughts bytedance$ pip install scikit-llm

# Looking in indexes: https://pypi.tuna.tsinghua.edu.cn/simple

# ERROR: Could not find a version that satisfies the requirement scikit-llm (from versions: none)

# ERROR: No matching distribution found for scikit-llm

(py310) TQV9MF4NXR:tree-of-thoughts bytedance$ pip search scikit-llm

# ERROR: XMLRPC request failed [code: -32500]

# RuntimeError: PyPI no longer supports 'pip search' (or XML-RPC search). Please use https://pypi.org/search (via a browser) instead. See https://warehouse.pypa.io/api-reference/xml-rpc.html#deprecated-methods for more information.

替代品

git clone https://github.com/shubhodeep9/pipsearch

cd pipsearch

python setup.py install

pip search your_pkg

Python依赖包

依赖包总结

【2020-8-23】python 项目依赖包管理

- 安装:

pip install -r requirements.txt

- 自动生成

requirements.txtpip install pipreqspipreqs /path/to/project

- 生成requirements.txt文件

pip freeze #显示所有依赖

pip freeze > requirement.txt #生成requirement.txt文件

pip install -r requirement.txt #根据requirement.txt生成相同的环境

- 对比分析

| 工具包 | 优点 | 缺点 |

|---|---|---|

pip freeze |

包含列表完全 | 不相关的依赖包也会包含进来 |

pipreqs |

只会包含项目 imports 的包 | 包含列表不是很完全 |

pip-compile |

精准控制项目依赖包 | 需要手动操作,不方便 |

pip requirements

python项目必须包含一个 requirements.txt 文件,用于记录所有依赖包及其精确的版本号,以便新环境部署。

语法格式

【2024-11-25】requirements.txt 中指定条件版本

omegaconf==2.3.0 // 指定某个版本

torch>=2.3.0 // 版本以上

// 条件分支,根据系统属性选择对应版本

onnxruntime-gpu==1.16.0; sys_platform == 'linux'

onnxruntime==1.16.0; sys_platform == 'darwin' or sys_platform == 'windows'

文件创建

① 生成 requirements 文件:

- 方法一:pip freeze

pip freeze > requirements.txtpip的freeze命令用于生成将当前项目的pip类库列表生成requirements.txt文件

- 方法二:使用 pipreqs

pipreqs用于生成requirements.txt文件可以根据需要导入的任何项目

为什么不用 pip Freeze 命令呢?

- pip 的 freeze 命令保存了保存当前Python环境下所有类库包,其它包括那些没有在当前项目中使用的类库。 (如果你没有的virtualenv)。

- pip 的 freeze 命令只保存与安装在环境python所有软件包。但有时只想将当前项目使用的类库导出生成为 requirements.txt;

生成 requirements.txt 文件的方法有很多,上面三种方法各有优劣

| 名称 | 优点 | 缺点 |

|---|---|---|

| pip freeze | 包含列表完全 | 不相关的依赖包也会包含进来 |

| pipreqs | 只会包含项目 imports 的包 | 包含列表不是很完全 |

| pip-compile | 精准控制项目依赖包 | 需要手动操作,不方便 |

注:requirements.txt 写法

# ==也可以换成>=, <=。

sed -i 's/==.*$//g' requirements.txt # 安装最新版本要去除后面的==再安装

spacy>=2.1.0,<2.2.0 # 版本范围

https://github.com/explosion/spacy-models/releases/download/en_core_web_lg-2.1.0/en_core_web_lg-2.1.0.tar.gz#egg=en_core_web_lg # 直接从某地址下载

pymagnitude>=0.1.120 # 版本范围

# 【2023-4-12】直接使用git地址

git+https://github.com/microsoft/deepspeed.git

git+https://github.com/huggingface/transformers

更多实例见地址

② 创建环境副本,全新安装

pip install -r requirements.txt

# 安装远程机器上的requirements文件:

# 服务端搭建server:

python -m SimpleHTTPServer

# 获取:

pip install -i http://127.0.0.1:8000/ -r requirements.txt

使用方法:

pip install pipreqs # 安装

pipreqs /path/to/project # 按需导出requirements.txt

# 示例:

pipreqs mycode/recommond/ivr

# INFO: Successfully saved requirements file in mycode/recommond/ivr/requirements.txt

# 内容:只包含对应项目下用到的库

# xgboost==0.7.post4

# requests==2.18.4

# numpy==1.14.2

# pandas==0.22.0

# config_reader==0.8

# matplotlib==2.2.2

# scikit_learn==0.19.1

# tensorflow==1.8.0

参考:Python使用requirements.txt安装类库

虚拟环境

venv

注意:venv 只能使用当前系统已经安装好的python,无法使用其他版本的python环境。

优缺点分析:

- 1、venv 是 python3 自带,不需要额外安装库就能运行。

- 也可以单独安装: sudo apt install python3-venv

- 2、只能在3.3版本以后,2.x 用不了

- 3、venv 过于简单,没有额外api。

- 只能创建个虚拟环境,不能指定系统不存在的 python环境版本,不能查看环境列表。

pip install flask # 报错

python3 -m venv test_env # 生成 test_env 目录

# 激活虚拟环境

source test_env/bin/activate

pip install flask # 正常

virtualenv

virtualenv 是最流行的 python 虚拟环境配置工具。

- 不仅同时支持 python2 和 python3,而且可以为每个虚拟环境指定 python 解释器,并可以选择继承基础版本的包。

- 【2018-1-3】Python–Virtualenv简明教程,virtualenv官方文档

- python沙盒环境,virtualenv创建一个拥有自己安装目录的环境, 这个环境不与其他虚拟环境共享库, 能够方便的管理python版本和管理python库

优点

- 更快

- 扩展性更强

- 自动发现并可创建多版本的 Python 环境

- 可通过 pip 更新

- 丰富的编程接口

(1)安装:

pip install virtualenv

#或者由于权限问题使用sudo临时提升权限

sudo pip install virtualenv

virtualenv -h #获得帮助

(2)创建:

- 用virtualenv管理python环境

- 生成ENV目录,包含bin(解释器)、include 和 lib(python库)文件夹

- 运行, 会继承/usr/lib/python2.7/site-packages下的所有库, 最新版本virtualenv把把访问全局site-packages作为默认行为

virtualenv ENV # 创建一个名为ENV的目录, 并且安装了ENV/bin/python

virtualenv --system-site-packages ENV # 继承系统python环境

(3)激活虚拟环境:

- 当前目录下生成 ENV,进入,启动虚拟环境

virtualenv ENV # 创建一个名为ENV的目录, 并且安装了ENV/bin/python

#virtualenv --system-site-packages ENV # 继承已有环境

cd ENV

source ./bin/activate #激活当前virtualenv

# (ENV)➜ ENV git:(master) ✗ #注意终端发生了变化

【2020-5-14】注意:windows下没有bin目录,参考,执行方法:.\scripts\activate.bat

(4)关闭

# 关闭

deactivate

# 删除虚拟环境

rm -r venv

(5)指定python版本

- 可以使用-p PYTHON_EXE选项在创建虚拟环境的时候指定python版本

virtualenv venv --python=python3.5 # 指定python 3.5

#创建python2.7虚拟环境

virtualenv -p /usr/bin/python2.7 ENV2.7 # 指定本地python

virtualenv -p "C:\Program Files (x86)\Python\Python27" py2 # Windows下

添加 环境变量(env),并执行,便于启动

# vim ~/.bash_profile

alias env="source ${ENV}/bin/activate"

# 执行

source ~/.bash_profile

# 启动环境

env # 进入虚拟环境

anaconda 系列

anaconda 及 miniconda(小型版)

Conda 分为 Anaconda 和 Miniconda

Anaconda是一个包含了许多常用库的集合版本Miniconda是精简版本(只包含conda、pip、zlib、python 及所需的包),剩余的通过conda install command命令自行安装

anaconda

官方下载

# mac环境下安装

#brew cask install anaconda

brew install anaconda

export PATH="/usr/local/anaconda3/bin:$PATH"

# 官方地址,https://www.anaconda.com/products/individual,上面有最新版本地址

wget https://repo.anaconda.com/archive/Anaconda3-2021.05-Linux-x86_64.sh

# 获取mincoda linux最新版

wget -c https://repo.continuum.io/miniconda/Miniconda3-latest-Linux-x86_64.sh

# mincoda mac用户

curl -O https://repo.anaconda.com/miniconda/Miniconda3-latest-MacOSX-x86_64.sh

# 清华镜像地址: https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/, 找最新下载地址

wget https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/Anaconda3-5.3.1-Linux-x86_64.sh

bash Anaconda3-2019.03-Linux-x86_64.sh

# [2021-6-15]注意:直接使用以上命令会出错:from conda.cli import main ModuleNotFoundError: No module named 'conda'

# 解法:加-u

bash Anaconda3-2019.03-Linux-x86_64.sh -u

miniconda

【2023-2-27】miniconda安装过程

- 先后选择:enter(同意协议)→ yes(同意默认目录~/miniconda)→ yes(同意初始化)

- 执行环境变量: source ~/.bashrc

# 下载linux版本miniconda

wget -c https://repo.continuum.io/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 安装

sh Miniconda3-latest-Linux-x86_64.sh # enter(同意协议)→ yes(同意默认目录~/miniconda)→ yes(同意初始化)

# 环境变量配置

install_dir='/mnt/bn/flow-algo-intl/wangqiwen/bin'

export PATH=${PATH}:${install_dir}/miniconda3/bin # conda 命令路径

source ${install_dir}/miniconda3/etc/profile.d/conda.sh # 【2024-3-17】避免 Ubuntu上环境激活失效问题(conda init无效)

环境设置

conda config --set auto_activate_base true # 设置conda自动启动

# 自动在 ~/.bashrc 里添加环境变量

# 如果不执行,就报错, 且无法 activate 环境

conda activate base # 提示 CondaError: Run 'conda init' before 'conda activate'

# 添加bin路径, 并执行

source ~/.bashrc/ # 或 ~/.bash_profile

# 启动conda

conda

# 创建新的Python环境

conda create -n py310 python=3.10

conda activate py310 # 激活环境

conda deactivate

安装完成之后会多几个应用

- Anaconda Navigtor :用于管理工具包和环境的图形用户界面,后续涉及的众多管理命令也可以在 Navigator 中手工实现。

- Jupyter notebook :基于web的交互式计算环境,可以编辑易于人们阅读的文档,用于展示数据分析的过程。

- qtconsole :一个可执行 IPython 的仿终端图形界面程序,相比 Python Shell 界面,qtconsole 可以直接显示代码生成的图形,实现多行代码输入执行,以及内置许多有用的功能和函数。

- spyder :一个使用Python语言、跨平台的、科学运算集成开发环境。

- 加入环境变量

- 安装器若提示“

Do you wish the installer to prepend the Anaconda install location to PATH in your /home/<user>/.bash_profile ?,建议输入“yes”。 - 如果输入“no”,则需要手动添加路径。添加 export PATH=”/

/bin:$PATH" 在 .bashrc 或者 .bash_profile 中。

- 安装器若提示“

- 注意:

- 不要擅自在bash_profile中添加alias别名!会导致虚拟环境切换后python、pip转换失效

# anaconda 环境

export PATH="~/anaconda3/bin:$PATH"

# 以下语句不要添加!

alias python='/home/wangqiwen004/anaconda3/bin/python'

alias pip='/home/wangqiwen004/anaconda3/bin/pip'

# 如果仍然失效,强制使用变量切换

sra(){

CONDA_ROOT="~/anaconda3"

env=$1

conda activate $env

export LD_LIBRARY_PATH="$CONDA_ROOT/envs/$env/lib:$LD_LIBRARY_PATH"

export PATH=$CONDA_ROOT/envs/$env/bin:$PATH

}

# 【2020-7-10】以上方法不支持默认环境base的切换,优化如下:

sra(){

CONDA_ROOT="~/anaconda3"

# 获取当前虚拟环境名称列表(不含base)

env_list=(`conda info -e | awk '{if($1!~/#|base/)printf $1" "}'`)

env=$1

conda activate $env

echo "env=$env, str=${env_list[@]}"

# 判断是否匹配已有环境名称

# echo "${env_list[@]}" | grep $env && echo "yes" || echo "no"

#[[ "$1" =~ "${env_str}" ]] && echo "yes" || echo "no"

#[[ ${env_list[@]/${env}/} != ${env_list[@]} ]] && {

res="no"

for i in ${env_list[@]}

do

[ "$i" == "$env" ] && res="yes"

done

[ $res == "yes" ] && {

echo "找到目标环境$env"

export LD_LIBRARY_PATH="$CONDA_ROOT/envs/$env/lib:$LD_LIBRARY_PATH"

export PATH=$CONDA_ROOT/envs/$env/bin:$PATH

}||{

echo "启用默认环境base"

env="base"

export LD_LIBRARY_PATH="$CONDA_ROOT/lib:$LD_LIBRARY_PATH"

export PATH=$CONDA_ROOT/bin:$PATH

}

echo "环境切换完毕: --> $env"

}

alias srd='conda deactivate'

# 激活的使用方法

sra learn

- 注意:不要这样加!

常用命令

汇总如下:

conda --version # 查看版本

# 创建新的Python环境

conda create -n py310 python=3.10

conda activate py310 # 激活环境

conda deactivate

activate # 切换到base环境

activate py3 # 切换到py3环境

conda create -n py3 python=3 # 创建一个名为py3的环境并指定python版本为3(的最新版本,也可以是2.7、3.6等))

conda create -n py3 numpy matplotlib python=2.7 # 创建环境同时安装必要的包

conda create -n py36_tf1 python=3.6 tensorflow==1.11 # [2020-7-21]

conda create -n myenv python=3.6 -y # 免交互提示

conda create --prefix="D:\\my_python\\envs\\my_py_env" python=3.6.3 # 自定义虚拟环境

conda create --name env_name --clone py3 # 克隆环境 py3 -> env_name

conda env list # 列出conda管理的所有环境, conda info -e

source activate py3 # linux下激活虚拟环境conda activate,windows下为:activate py3

source deactivate # linux下关闭虚拟环境conda deactivate,windows下为:deactivate

conda list # 列出当前环境的所有包

conda list -n py3 # 列出某环境下的所有包

conda install requests #安装requests包, 同pip install

# 【2023-2-27】

conda install -q pandas # 静默安装

conda install -y pandas # 默认yes,免交互提示

conda install --yes pandas # 默认yes,免交互提示

# 或者使用环境变量

# enable yes to all in current env

conda config --env --set always_yes true

# disable it in current env

conda config --env --remove always_yes

conda install -n your_env_name [package] # 即可安装package到your_env_name中

conda remove requests #卸载requets包

conda remove -n py3 --all # 删除py3环境及下属所有包

conda remove --name py3 package_name # 删除py3环境下某个包

# pip install openpyxl -U

# conda update openpyxl

conda update requests # 更新requests包

# conda update --all # 更新所有库

conda search pyqtgraph # 搜索包(模糊查找)

conda search --full-name pyqtgraph # 精确查找

conda env export > environment.yaml # 导出当前环境的包信息

conda env create -f environment.yaml # 用配置文件创建新的虚拟环境

下载源设置

# 添加Anaconda的TUNA镜像

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

# TUNA的help中镜像地址加有引号,需要去掉

# -------- 清华镜像 ---------

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

#Conda Forge

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge/

#msys2(可略)

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/msys2/

#bioconda(可略)

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/bioconda/

#menpo(可略)

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/menpo/

#pytorch

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/

# for legacy win-64(可略)

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/peterjc123/

conda config --set show_channel_urls yes

#-------- 中科大镜像 --------

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/cloud/conda-forge/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/cloud/msys2/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/cloud/bioconda/

conda config --add channels https://mirrors.ustc.edu.cn/anaconda/cloud/menpo/

conda config --set show_channel_urls yes

#-------- 北外镜像 ---------

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/pkgs/main/

#Conda Forge

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/conda-forge/

#msys2(可略)

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/msys2/

#bioconda(可略)

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/bioconda/

#menpo(可略)

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/menpo/

#pytorch

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/pytorch/

# for legacy win-64(可略)

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/peterjc123/

# 设置搜索时显示通道地址

conda config --set show_channel_urls yes

# 【2021-6-15】直接修改文件

vim ~/.condarc

channels:

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge/

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/

ssl_verify: true

问题解决

install 速度慢

- 使用

conda install安装各种包的时候速度很慢,参考:conda install速度慢

解决

- 修改conda镜像路径

- 执行如下命令,更换仓库径路为清华镜像路径

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

- 在自己用户目录C:\Users<你的用户名>下生成一个文件,名字为:~/.condarc

conda config --set show_channel_urls yes

- 修改.condarc文件为如下:

channels:

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

show_channel_urls: true

ssl_verify: true

- 执行完上述三步,conda的镜像路径就更换完毕,如不放心可以

conda info查看 channel URLs 信息已经更改。

【2021-9-22】更换清华源后,依然很慢:出现卡顿/失败

- Collecting package metadata (repodata.json)

- 解决办法: 将.condarc中的清华源的https全部换成http,或者将代理软件(clash for windows)设置为全局代理

- conda清除国内源:conda config –remove-key channels

channel 问题

【2020-8-22】执行 conda install flask-restplus 时,pip没问题

- Solving environment: failed with initial frozen solve. Retrying with flexible solve

- 解决:执行

conda config --add channels conda-forgeconda config --set channel_priority flexible

【2021-7-15】问题:

- PackagesNotFoundError: The following packages are not available from current channels

- 解决:

conda config --add channels https://anaconda.org(缺失的源)

env 激活失败

【2023-7-21】conda activate 激活失败

- 错误提示:

- 【2024-3-8】 CondaError: Run ‘conda init’ before ‘conda activate’

- CommandNotFoundError: Your shell has not been properly configured to use ‘conda activate’

- 按照提示执行

conda init bash并重新打开窗口依然不行

解决方法: refer

- anaconda:

source ~/anaconda3/etc/profile.d/conda.sh - minconda:

source ~/miniconda3/etc/profile.d/conda.sh# 实践成功

# 环境变量配置

install_dir='/mnt/bn/flow-algo-intl/wangqiwen/bin'

export PATH=${PATH}:${install_dir}/miniconda3/bin # conda 命令路径

source ${install_dir}/miniconda3/etc/profile.d/conda.sh # 【2024-3-17】避免 Ubuntu上环境激活失效问题(conda init无效)

Python 3.12 问题

安装 wandb 时,出错

pip install -U byted-wandb -i https://bytedpypi.byted.org/simple

错误信息

ModuleNotFoundError: No module named ‘imp’

原因:

- Python 3.12版本问题, imp 丢弃

解法:

- (1) 替换 imp:

import imp->import importlib - (2) 使用 Python 3.11

conda 环境迁移

【2024-3-27】将conda安装目录复制到新目录后,修改路径后,用 pip install 安装软件时,依然调用旧目录

- 更新 ~/.bashrc 里的旧目录, source 后,

conda init # 安装conda后,自动通过 conda init 命令在 ~/.bashrc 尾部追加以下代码片段

# modified /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/condabin/conda

# no change /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/conda

# modified /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/conda-env

# modified /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/activate

# modified /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/deactivate

# no change /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/etc/profile.d/conda.sh

# modified /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/etc/fish/conf.d/conda.fish

# no change /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/shell/condabin/Conda.psm1

# modified /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/shell/condabin/conda-hook.ps1

# modified /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/lib/python3.12/site-packages/xontrib/# conda.xsh

# modified /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/etc/profile.d/conda.csh

# no change /root/.bashrc

# >>> conda initialize >>>

# !! Contents within this block are managed by 'conda init' !!

__conda_setup="$('/mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/conda' 'shell.bash' 'hook' 2> /dev/null)"

if [ $? -eq 0 ]; then

eval "$__conda_setup"

else

if [ -f "/mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/etc/profile.d/conda.sh" ]; then

. "/mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/etc/profile.d/conda.sh"

else

export PATH="/mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin:$PATH"

fi

fi

unset __conda_setup

# <<< conda initialize <<<

# 指向新路径

which conda pip python

# /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/conda

# /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/pip

# /mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/python

# 但 执行 conda 时,还是指向旧路径

conda env list

# bash: /mnt/bn/larkai-fr-gpt/wangqiwen/bin/miniconda3/bin/conda: No such file or directory

原因:

- 当前版本下的 conda 和 pip 文件是python代码, 且第一行就指定了Python旧路径

- 修改配置文件里的目录(

CONDA_EXE和CONDA_PYTHON_EXE),miniconda3/etc/profile.d/conda.sh - vim 修改命令:

%s/larkai-fr-gpt/flow-algo-cn/g

head ../../bin/miniconda3/etc/profile.d/conda.sh

# 显示内容

export CONDA_EXE='/mnt/bn/larkai-fr-gpt/wangqiwen/bin/miniconda3/bin/conda'

export _CE_M=''

export _CE_CONDA=''

export CONDA_PYTHON_EXE='/mnt/bn/larkai-fr-gpt/wangqiwen/bin/miniconda3/bin/python'

# 以上旧路径都改成新路径

#!/mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/python

# Copyright (C) 2012 Anaconda, Inc

# SPDX-License-Identifier: BSD-3-Clause

__conda_exe() (

"$CONDA_EXE" $_CE_M $_CE_CONDA "$@"

)

这个配置文件会影响其他文件,如: conda, pip

- 单独修改 这两个文件没用

conda_dir="/mnt/bn/flow-algo-cn/wangqiwen/bin"

cat ${conda_dir}/miniconda3/bin/conda

cat ${conda_dir}/miniconda3/bin/pip

You will probably get the following:

# ----------------- 【conda 文件】 ----------------

#!/mnt/bn/larkai-fr-gpt/wangqiwen/bin/miniconda3/bin/python

# 改成新路径

#!/mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/python

# -*- coding: utf-8 -*-

import sys

# Before any more imports, leave cwd out of sys.path for internal 'conda shell.*' commands.

# see https://github.com/conda/conda/issues/6549

if len(sys.argv) > 1 and sys.argv[1].startswith('shell.') and sys.path and sys.path[0] == '':

# The standard first entry in sys.path is an empty string,

# and os.path.abspath('') expands to os.getcwd().

del sys.path[0]

# ----------------- 【pip 文件】 ----------------

#!/mnt/bn/larkai-fr-gpt/wangqiwen/bin/miniconda3/bin/python

# 改成新路径

#!/mnt/bn/flow-algo-cn/wangqiwen/bin/miniconda3/bin/python

# -*- coding: utf-8 -*-

import re

import sys

from pip._internal.cli.main import main

if __name__ == '__main__':

sys.argv[0] = re.sub(r'(-script\.pyw?|\.exe)?$', '', sys.argv[0])

UV

Rust 编写的极速 Python 包和项目管理工具

- 【2025-4-5】UV包管理工具全面指南:对比conda/pip与实战教程

- UV中文文档

包管理和虚拟环境工具演进

pip->virtualenv->conda->UV(Ultrafast Virtualenv)

UV 简介

UV(Ultrafast Virtualenv)是 Astral 团队2023年用Rust开发的新一代Python包管理工具。

设计目标

- 解决Python包管理中的速度和依赖解析问题,使Python开发更加流畅高效。

UV 由 Rust语言编写,性能上有显著优势。

可替代 pip, pip-tools, pipx, poetry, pyenv, twine, virtualenv

UV 特点

传统 Python 需要多个工具配合:

- venv 创建环境

- pip 装包

- requirements.txt 管依赖

- 手动处理依赖冲突

- virtualenvwrapper 管多项目

- pip-tools 锁依赖

而 uv 整合这些功能,统一通过 pyproject.toml + uv.lock 管理。

这种集中式管理方式极大提升了开发专注度:不再分神在环境配置上,只专注写业务逻辑。

特点

- 极速安装:比pip和conda快5-10倍

- 可靠的依赖解析:使用先进的解析算法,能更好地处理复杂依赖关系

- 兼容性:与pip的大部分命令兼容,支持requirements.txt和pyproject.toml

- 高效缓存:智能缓存系统,减少重复下载

- 原子操作:安装过程更安全,失败时不会留下半完成状态

- 轻量级:专注于Python包管理,不像conda那样管理整个系统级依赖

另外

- UV 兼容 pip 大部分命令,但某些高级或不常用的选项可能不支持。使用

uv pip --help查看支持的选项。 - UV创建的是标准Python虚拟环境,可以被任何支持venv的工具识别。

对比分析

UV vs. conda vs. pip :深度对比

设计哲学与适用场景

| 工具 | 设计哲学 | 最适用场景 |

|---|---|---|

| UV | 极速、安全的Python包管理 | Python Web开发、一般Python项目 |

| conda | 全语言包管理系统 | 数据科学、跨语言项目、需要系统级依赖的项目 |

| pip | Python官方包安装工具 | 简单Python项目、作为其他工具的后端 |

总结:uv

- 快: rust编写,并行安装依赖,比 pip 和 conda 都快;

- 现代: 项目结构清晰,依赖写在 pyproject.toml ,最后锁定在 lock文件 中;

- 轻: 删除

.venv文件夹就等于删掉环境; - 干净: 不污染系统,不自动写配置,不乱改 .bashrc

venv、Conda (Miniconda) 、uv (推荐project模式)

具体特性对比内容如下:

| 特性 | venv | Conda (Miniconda) | uv (推荐project模式) |

|---|---|---|---|

| 是否内置 | ✅是 | ❌(需安装) | ❌(需安装) |

| 安装方式 | Python自带 | 官网下载安装(推荐Miniconda) | pip install uv |

| 环境创建速度 | ✅快 | ❌慢 | 超快(并行) |

| 占用空间 | ✅小 | ❌大 | ✅小 |

| 依赖管理 | 手动requirements.txt | conda + pip | ✅pyproject.toml + uv.lock |

| 项目初始化 | ❌无 | ❌无 | ✅uv init一键结构化 |

| 源支持 | 使用pip镜像 | 使用Conda自有源 | 使用pip镜像 |

| 非Python包支持 | ❌ | ✅(如cudatoolkit) | ❌ |

| 适合场景 | 脚本 / 嵌入式工具链 | 数据科学 / 科研项目 | 所有项目,特别是现代开发 |

虚拟环境管理对比

UV

- 创建标准兼容的Python虚拟环境

- 与venv模块兼容,但速度更快

- 环境激活方式与标准Python虚拟环境相同

conda

- 创建独立的环境,包含完整的Python解释器副本

- 环境之间完全隔离,包括系统库

- 需要特定的conda命令来激活环境

pip

- 本身不创建虚拟环境,通常与venv或virtualenv配合使用

- 只管理Python包,不处理环境

依赖解析方式

UV 使用先进的依赖解析器,能更快地解决冲突 在复杂依赖网络中表现更好 支持锁文件,确保环境可重现

conda 有自己的依赖解析系统,考虑非Python依赖 解析速度较慢,但能处理跨语言依赖 使用environment.yml管理环境

pip 简单的依赖解析,可能在复杂情况下出现问题 不支持原生锁文件(需要依赖pip-tools等工具) 在解决依赖冲突时可能不够智能

性能对比

在安装pandas包及其依赖时的性能对比(数据为示例):

| 工具 | 首次安装时间 | 重复安装时间(缓存后) |

|---|---|---|

| UV | 8秒 | 2秒 |

| conda | 45秒 | 12秒 |

| pip | 25秒 | 10秒 |

UV 安装

安装UV工具:

# 使用pipx安装(推荐)

pipx install uv

# 或使用pip安装

pip install uv

# 或在conda环境中安装

conda install uv -c conda-forge

#-------------

# Linux或者MacOS系统安装:

curl -LsSf https://astral.sh/uv/install.sh | sh

# Windows系统:

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

# 或直接 pip 安装(可能影响系统 Python):

pip install uv

# 检查是否安装成功

uv --help

uv --version

uv -v

uv python list # 查看可用python版本

或

# 默认安装在 ~/.local/bin

# 如果设置了 XDG_BIN_HOME,则会使用该路径代替。

# 如果设置了 XDG_DATA_HOME,目标目录将推断为 XDG_DATA_HOME/../bin。

curl -LsSf https://astral.sh/uv/install.sh | sh

# 自定义安装路径,使用 UV_INSTALL_DIR

# powershell 实测无效,报错

$env:UV_INSTALL_DIR = "E:\program_file\uv" powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

# powershell 实测有效

$env:XDG_BIN_HOME='E:\program_file\uv'

问题

win 11上,自定义安装目录到 e 盘,出现问题:

- uv 安装后,没有 uv.exe 文件

原因

- 默认将 uv.exe 编译到

Lib\site-packages\bin中,而此目录已存在(如提前安装了别的库 tensorboard),导致生成失败

按照提示,加 –upgrade 后,bin 目录被覆盖,别的bin文件没了

- E:\program_file\python\Lib\site-packages\bin

pip install uv

# Successfully installed uv-0.6.14

# WARNING: Target directory E:\program_file\python\Lib\site-packages\uv already exists. Specify --upgrade to force replacement.

# WARNING: Target directory E:\program_file\python\Lib\site-packages\uv-0.6.14.dist-info already exists. Specify --upgrade to force replacement.

# WARNING: Target directory E:\program_file\python\Lib\site-packages\bin already exists. Specify --upgrade to force replacement.

# 按照提示,

pip install uv --upgrade

改进:

- 手工将 bin 目录下 exe 文件复制到 E:\program_file\python\Scripts

使用

使用方式:

- (1) 传统方式: venv + pip 加速版,适合脚本或已有项目

- (2) project 模式: 类似nodejs 的 npm

- (3) Tool 模式

(1) 传统方式

传统方式(兼容 venv):

uv venv myenv --python=3.10 # 创建虚拟环境

source myenv/bin/activate # 激活环境

# 工具包安装

uv pip list

uv pip install --upgrade numpy # 升级

uv pip install numpy

uv pip uninstall numpy

uv pip freeze > requirements.txt # 导出依赖包

uv pip install <path_to_wheel>.whl # 本地wheel文件

uv pip install -r requirements.txt

uv pip install -r requirements.txt --force-reinstall # 覆盖安装

(2) project 模式

推荐方式:project 模式

uv init # 初始化项目(生成 pyproject.toml)

uv add numpy # 安装依赖并自动写入配置文件

uv run main.py # 自动激活环境 + 运行代码

执行 uv run 时,uv 会自动创建 .venv 文件夹,读取 pyproject.toml 和 uv.lock,同步依赖并运行程序。

还可以

uv add -r requirements.txt # 从传统依赖列表迁移

模式(2)和现有工程融合, 从创建到build都包含。

uv 推荐模式以项目为中心,类似 npm 的体验:

uv init

uv add flask

uv run app.py

一切都写在 pyproject.toml,不需要手动维护 requirements.txt,也不需要关心激活哪个环境、有没有冲突

- 因为环境就是项目自己管理的

.venv文件夹。 - 只要把项目文件夹打包发给别人,对方很快就能100%同步

git clone ...

uv sync

就能 100% 还原运行环境。比 pip + venv 要靠谱

(3) Tool 模式

除了project,还有 tool 方式,安装和运行命令行程序时,做到较好的隔离。 比如

uv tool install --python 3.12 pdf2zh

一键安装pdf翻译工具。独立依赖,不会因电脑环境导致问题。

虚拟环境

创建新环境:

# 创建名为 "myproject" 新虚拟环境

uv venv myproject

# 指定Python版本

uv venv myproject --python=3.10

激活环境:

source myproject/bin/activate # Unix/Linux/macOS:

myproject\\Scripts\\activate # Windows:

deactivate # 退出环境

其他

uv cache clean # 清理缓存

安装包

uv 安装Python

uv python list # 查看python

uv python install # 默认最新版,cpython

uv python install 3.12 # 指定版本

uv python install 3.11 3.12

uv python install pypy@3.10 # pypy

uv python install --reinstall # 重新安装

配置

设置环境变量

| 变量 | 功能 | 取值 | 分析 |

|---|---|---|---|

UV_DEFAULT_INDEX |

指定国内源,加速安装 | https://pypi.tuna.tsinghua.edu.cn/simple |

|

XDG_BIN_HOME |

自定义安装路径 | ‘E:\program_file\uv’ | |

直接安装

# 安装单个包

uv pip install numpy

# 安装特定版本

uv pip install pandas==2.0.0

# 从requirements.txt安装

uv pip install -r requirements.txt

# 从pyproject.toml安装

uv pip install -e .

性能优化功能

# 并行安装依赖

uv pip install -r requirements.txt --parallel

# 使用缓存安装

uv pip install numpy --cache-dir ~/.uv/cache

依赖解析失败时如何处理?

解决方案:

# 查看详细的依赖冲突信息

uv pip install package-name --verbose

# 尝试放宽版本限制

uv pip install "package-name>=1.0.0" --no-deps

UV缓存占用太多空间

解决方案:

# 清理UV缓存

uv cache clean

# 限制缓存大小

uv cache limit 2GB

uv tool

“tool”命令:独立工具安装

UV 提供类似于 pipx 的功能,隔离环境中安装Python工具,同时命令行接口全局可用。

这个功能通过 uv tool 命令实现。

c install vs 普通包安装:

简明对比

普通包安装 (例如 pip install black)

- 安装位置:安装到当前活跃的Python环境中

- 使用范围:只能在安装环境中使用

- 环境影响:可能会影响当前环境的其他包

- 使用方式:需要先激活环境才能使用

把工具放在一个特定的工具箱里,只有打开那个工具箱时才能用这工具。

# 在项目A环境中

pip install black

# 在项目B环境中也需要单独安装

pip install black

uv tool install black (类似于 pipx install black)

- 安装位置:创建专用隔离环境来安装这个工具

- 使用范围:全局可用,任何终端会话都能使用

- 环境影响:不会影响其他Python项目或环境

- 使用方式:直接在命令行调用,无需激活环境

给工具建了独立的小房间,但在房子的任何地方都能用到它。

uv tool安装:

# 只需安装一次

uv tool install black

# 在任何项目中都可以使用black命令,不需要激活环境

uv tool install 让工具全局可用,且不与项目环境冲突。适用于想在所有项目中使用的命令行工具。

uv tool安装的工具无法运行?

解决方案:

# 检查工具是否成功安装

uv tool list

# 检查PATH环境变量是否包含UV的bin目录

echo $PATH

# 重新安装工具

uv tool install --force tool-name

uv tool 安装的工具版本管理?

解决方案:

# 查看当前安装的版本

uv tool list

# 安装特定版本

uv tool install tool-name==1.2.3

# 升级到最新版本

uv tool upgrade tool-name

项目管理

项目依赖文件

uv tree # 查看依赖树

# 将当前环境导出到requirements.txt

uv pip freeze > requirements.txt

# 创建锁文件

uv pip compile pyproject.toml -o requirements.lock

工具集成

Poetry

与Poetry项目集成:

# 从Poetry项目安装依赖

uv pip install -e .

# 将Poetry依赖导出并安装

poetry export -f requirements.txt | uv pip install -r -

PDM

与PDM项目集成:

# 使用PDM生成的requirements.txt

uv pip install -r pdm.lock

conda

UV和conda可以协同工作

conda管理Python解释器和系统库

# 创建基础conda环境,只包含Python和系统依赖

conda create -n datascience python=3.10 numpy pandas -c conda-forge

# 激活环境

conda activate datascience

# 使用UV安装其余Python包

uv pip install scikit-learn matplotlib seaborn jupyterlab

现有conda项目中引入UV

对于已有的conda项目,可以逐步引入UV:

# 从conda环境导出Python包依赖

conda activate myenv

pip freeze > requirements.txt

# 使用UV安装新的Python包依赖

uv pip install -r requirements.txt

uv pip install new-package

使用UV的tool命令替代conda安装独立工具

# 替代conda安装独立工具

uv tool install --force --python python3.10 jupyter

uv tool install --force --python python3.11 black mypy ruff

UV 使用命令

python 版本

# 管理 Python 版本。

uv python install # 安装 Python 版本。

uv python list # 查看可用的 Python 版本。

uv python find # 查找已安装的 Python 版本。

uv python pin # 为当前项目指定使用的 Python 版本。

uv python uninstall # 卸载 Python 版本。

运行独立的 Python 脚本(如 example.py)。

uv run # 运行脚本。

uv add --script # 为脚本添加依赖。

uv remove --script # 从脚本中移除依赖。

tool 管理

# 安装Python工具

uv tool install black

# 指定版本安装

uv tool install flake8==6.0.0

# 安装最新版本

uv tool install mypy@latest

# 使用特定Python版本安装

uv tool install --python python3.11 pytest

# 强制重新安装

uv tool install --force django-admin

高级选项

# 安装带有额外依赖的工具

uv tool install "jupyter[notebook]"

# 从特定源安装

uv tool install --index-url <https://test.pypi.org/simple/> experimental-tool

# 安装开发版本

uv tool install git+https://github.com/user/project.git

# 列出已安装的工具

uv tool list

# 升级已安装的工具

uv tool upgrade aider-chat

# 卸载工具

uv tool uninstall black

uvx / uv tool run # 在临时环境中运行工具。

uv tool install # 全局安装工具。

uv tool uninstall # 卸载工具。

uv tool list # 列出已安装的工具。

uv tool update-shell # 更新 shell,使工具可执行文件生效。

uv tool 命令的优势:

- 比pipx更快的安装速度

- 更可靠的依赖解析

- 与UV的其他命令保持一致的体验

- 支持多种安装源和安装方式

项目管理

创建并管理包含 pyproject.toml 的 Python 项目。

uv init # 创建一个新项目。

uv add # 向项目添加依赖。

uv remove # 从项目中移除依赖。

uv sync # 同步项目依赖到环境。

uv lock # 为项目依赖创建锁文件。

uv run # 在项目环境中运行命令。

uv tree # 查看项目的依赖树。

uv build # 构建项目的分发包。

uv publish # 将项目发布到包索引。

包管理

uv venv # 创建新虚拟环境

uv pip install # 安装包到当前环境。

uv pip show # 显示已安装包的详细信息。

uv pip freeze # 列出已安装包及其版本。

uv pip check # 检查当前环境中的包是否兼容。

uv pip list # 列出已安装的包。

uv pip uninstall # 卸载包。

uv pip tree # 查看环境的依赖树。

# 锁定报

uv pip compile # 将需求文件编译为锁文件。

uv pip sync # 根据锁文件同步环境。

状态管理

uv 的状态,如缓存、存储目录,或执行自更新:

uv cache clean # 清理缓存条目。

uv cache prune # 清理过期的缓存条目。

uv cache dir # 显示 uv 缓存目录路径。

uv tool dir # 显示 uv 工具目录路径。

uv python dir # 显示 uv 安装的 Python 版本路径。

uv self update # 将 uv 更新到最新版本。

案例

Web开发项目步骤:

创建和设置项目:

# 创建项目目录

mkdir webproject && cd webproject

# 创建虚拟环境

uv venv .venv

source .venv/bin/activate # 或在Windows上使用 .venv\\Scripts\\activate

# 创建基本项目结构

mkdir -p src/webproject tests

touch pyproject.toml

配置项目依赖: pyproject.toml

[project]

name = "webproject"

version = "0.1.0"

description = "A web project example"

dependencies = [

"flask>=2.0.0",

"sqlalchemy>=2.0.0",

"pydantic>=2.0.0",

]

安装依赖:

# 安装项目依赖

uv pip install -e .

# 安装开发依赖

uv pip install pytest black mypy

创建锁文件:

# 生成锁文件确保环境可重现

uv pip compile pyproject.toml -o requirements.lock

安装开发工具:

# 使用uv tool安装常用开发工具

uv tool install black

uv tool install --python python3.10 aider-chat@latest

开发项目:

# 添加更多依赖时

# 1. 更新pyproject.toml

# 2. 运行:

uv pip install -e .

# 3. 更新锁文件:

uv pip compile pyproject.toml -o requirements.lock

可执行文件

Python 打包

- 将 可见的 Python 源码转成不可见可执行文件

- 好处: 不用安装依赖包、提升安全性

- 运行环境: win下的exe, linux下的bin文件

总结

【2025-2-25】Python 脚本打包工具

| 工具 | 打包输出 | 适用平台 | 分析 | 备注 |

|---|---|---|---|---|

Py2exe |

可执行文件 | windows | 已经停止维护 | |

py2app |

可执行文件 | Mac | ||

pyinstaller |

可执行文件 | win/linux/mac | 次之 | |

cx_Freeze |

可执行文件 | 跨平台 | ||

Nuitka |

可执行文件 | win/linux/mac | 推荐 | |

setuptools |

Python工具包 | - | 打包分发 |

setuptools

setuptools 是 python标准的打包分发工具,将python项目打包安装

- 其他人像调用标准库或python第三方库那样直接使用;

- 也可以将项目上传到Pypi供更多人的下载安装使用。

构建前的结构包含:demo、docs、setup.py , 其中主要的 demo文件夹和setup.py。

setup.py 内容示例

import os, shutil

from setuptools import setup, find_packages

#移除构建的build文件夹

CUR_PATH = os.path.dirname(os.path.abspath(__file__))

path = os.path.join(CUR_PATH, 'build')

if os.path.isdir(path):

print('INFO del dir ', path)

shutil.rmtree(path)

setup(

name = 'demo', #应用名

author = 'selfeasy',

version = '0.1', #版本号

packages = find_packages(), #包括在安装包内的Python包

include_package_data = True, #启用清单文件MANIFEST.in,包含数据文件

exclude_package_data = {'docs':['1.txt']}, #排除文件

install_requires = [#自动安装依赖

'Flask>=0.10',

],

)

打包

python setup.py bdist_egg

python setup.py --help #查看setup文件的配置信息可以包含哪些

python setup.py --help-commands # 查看程序打包和分发可以使用的命令有哪些

当前目录下的”dist”创建”egg”文件,名为”MyApp-1.0-py2.7.egg”。

- 文件名格式: ”应用名-版本号-Python版本.egg”

- 当前目录多了”build”和”MyApp.egg-info”子目录来存放打包的中间结果。

安装

python setup.py install

将当前的Python应用安装到当前Python环境的”site-packages”目录下,像导入标准库一样导入该应用的代码

py2exe

py2exe 是Python打包工具,将Python代码打包成Windows可执行文件。

使用 py2exe 打包Python代码也很简单,只需要在命令行中输入以下命令:

python setup.py py2exe

cx_Freeze

cx_Freeze 将 Python 脚本打包成可执行文件,并且支持跨平台。

使用 cx_Freeze 也可以将 Python 代码打包成独立的可执行文件。

安装 cx_Freeze

pip install cx-Freeze

使用 cx_Freeze 打包

cxfreeze your_script.py --target-dir dist

执行以上命令后,cx_Freeze 将会在指定目录下生成可执行文件。

py2app

py2app 将 Python代码打包成MacOS可执行文件。

使用

python setup.py py2app

pyinstaller

用 pyInstaller 打包的示例命令

安装

pip install pyinstaller

使用

# 打包单个文件

pyinstaller your_script.py

# 打包多个py文件

pyinstaller [主文件] -p [其他文件1] -p [其他文件2]

# 打包时去除cmd框

pyinstaller -F XXX.py --noconsole

# 打包加入exe图标 picturename.ico是图片

pyinstaller -F -i picturename.ico -w XXX.py

# 打包去除控制台

pyinstaller -w xxx.py

# 打包方便查看报错,可看到控制台

pyinstaller -c xxx.py

# 错误

# class RegexFlag(enum.IntFlag):

# AttributeError: module 'enum' has no attribute 'IntFlag'

# 查看是否安装enum34包

# 卸载enum34即可,python程序可正常运行

执行命令后,pyinstaller 将会在当前目录下生成多个文件,其中包含了打包好的可执行文件。

- 目录:

build(打包时临时文件)dist(打包好的应用) 包含 exe 和 依赖包

- 文件:

xxx.spec(打包参数)

Nuitka

新一代 Python打包+加速神器:Nuitka

可打包 Python代码,并提升执行效率,支持多平台

Nuitka 是Python编译器,将Python代码编译成C++代码,然后将其打包成可执行文件。

使用命令:

nuitka your_script.py

这将生成一个可执行文件,在Windows、Linux和MacOS上运行。

Nuitka 和 pyinstaller 可以结合使用

- 将 Python代码 编译成C++代码,然后 pyinstaller将其打包成可执行文件。

命令:

nuitka --standalone your_script.py

pyinstaller your_script.spec

Python 教程

python入门教程:

入门路线图

- 基本语法

- 变量

- 数据类型: 字符串、数值型、list、tuple、set、bool、dict

- 控制流: 条件判断、循环

- 函数: 迭代器、生成器

- 面向对象: 类、抽象、继承

- 装饰器、异常

- 模块

- 测试

变量

命名规则

变量的命名规则

- 1、需要见名知义,通过变量名,就知道它所指向的值是什么。

- 2、变量名可以由字母、下划线和数字组成。

- 3、但是不能以数字开头。

- 4、页不能以关键字重名。

- 5、建议不要与内置函数或者是类重名,不然会覆盖原始内置函数的功能。

- 6、被视为一种惯例,并无绝对性与强制性。

- 7、目的是为了增加代码的可读性。

注意

- Python中的标识符区分大小写

变量类型

数据类型可以分为数字型和非数字型

- 数字型:整型(int)、浮点数(float)、布尔(bool)、复数(complex)

- 非数字型:字符串、列表、元组、字典

提示:

- 在Python2.0中,整数根据保存数值的长度还分为:int(整数)、long(长整数)

类型判断

判断变量类型的几种方法

- type: type(a) == type([])

- isinstance(a, list)

prompt = 'fdsfd'

print(type(prompt))

# if type(prompt) != 'str':

if type(prompt) != type('test'):

print('不是str')

else:

print('是str')

if isinstance(prompt, str):

print('是str')

else:

print('不是str')

传值 or 传引用

在 C/C++ 中,传值和传引用是函数参数传递的两种方式,在Python中参数是如何传递的?

- python函数参数既不是传参,也不是传引用,而是传对象!

- Python 函数中,参数的传递本质上是一种赋值操作,而赋值操作是一种名字到对象的绑定过程

全局变量

注意

- 引用全局变量,不需要golbal声明

- 修改全局变量,需要使用global声明

- 特别地,列表、字典等如果只是修改其中元素的值,可以直接使用全局变量,不需要global声明

#!/usr/bin/python

# Filename: func_global.py

def func():

global x

print 'x is', x

x = 2

print 'Changed local x to', x

x = 50

func()

print 'Value of x is', x

类型提示 typing

Python 主要卖点之一是动态类型,这一点也不会改变。

- 2014年9月,Guido van Rossum (Python BDFL) 创建了一个Python增强提议(PEP-484),为Python添加类型提示(Type Hints)。并在一年后,于2015年9月作为Python3.5.0的一部分发布了。于是对于存在了二十五年的Python,有了一种标准方法向代码中添加类型信息

- 仅仅提示作用:输入函数的第一个参数 first_name,输入点号(.)然后敲下 Ctrl+Space 来触发代码补全

def test(a: str) -> str:

print(a)

return 3

def document_frequency(term: str, corpus: str) -> tuple[int, int]:

"""

Calculate the number of documents in a corpus that contain a

given term

@params : term, the term to search each document for, and corpus, a collection of

documents. Each document should be separated by a newline.

@returns : the number of documents in the corpus that contain the term you are

searching for and the number of documents in the corpus

@examples :

>>> document_frequency("first", "This is the first document in the corpus.\\nThIs\

is the second document in the corpus.\\nTHIS is \

the third document in the corpus.")

(1, 3)

"""

corpus_without_punctuation = corpus.lower().translate(

str.maketrans("", "", string.punctuation)

) # strip all punctuation and replace it with ''

docs = corpus_without_punctuation.split("\n")

term = term.lower()

return (len([doc for doc in docs if term in doc]), len(docs))

以上类型提示方式偏弱,对于复杂类型不管用, 即便已经声明为了对应的类型,但实际上并不能反映整个列表、元组的结构

names: list = ['Germey', 'Guido'] # 并不知道元素时string类型

version: tuple = (3, 7, 4) # 并不知道元素是 int

operations: dict = {'show': False, 'sort': True}

typing 模块提供了非常 “强 “的类型支持,比如 List[str]、Tuple[int, int, int] 则可以表示由 str 类型的元素组成的列表和由 int 类型的元素组成的长度为 3 的元组。

# 强类型提示

from typing import List, Tuple, Dict

# List(列表) 是 list 的泛型

names: List[str] = ['Germey', 'Guido']

var: List[int or float] = [2, 3.5] # 多种元素类型

var: List[List[int]] = [[1, 2], [2, 3]] # 嵌套

# Tuple(元组)是 tuple 的泛型

version: Tuple[int, int, int] = (3, 7, 4)

person: Tuple[str, int, float] = ('Mike', 22, 1.75) # 多种类型

# Sequence,是 collections.abc.Sequence 的泛型,不区分是列表还是元组

def square(elements: Sequence[float]) -> List[float]:

return [x ** 2 for x in elements]

# Dict(字典)是 dict 的泛型;Dict 用于注解返回类型

operations: Dict[str, bool] = {'show': False, 'sort': True}

# Mapping(映射)是 collections.abc.Mapping 的泛型。Mapping 用于注解参数

def size(rect: Mapping[str, int]) -> Dict[str, int]:

return {'width': rect['width'] + 100, 'height': rect['width'] + 100}

# Set(集合)是 set 的泛型;Set 用于注解返回类型

# AbstractSet 是 collections.abc.Set 的泛型,用于注解参数。

def describe(s: AbstractSet[int]) -> Set[int]:

return set(s)

# NoReturn,当一个方法没有返回结果时,注解它的返回类型

def hello() -> NoReturn:

print('hello')

# Any是一种特殊的类型,可以代表所有类型,静态类型检查器的所有类型都与 Any 类型兼容,所有的无参数类型注解和返回类型注解的都会默认使用 Any 类型

def add(a):

return a + 1

def add(a: Any) -> Any:

return a + 1

# TypeVar 自定义兼容特定类型的变量

height = 1.75

Height = TypeVar('Height', int, float, None)

def get_height() -> Height:

return height

# NewType 声明一些具有特殊含义的类型

Person = NewType('Person', Tuple[str, int, float])

person = Person(('Mike', 22, 1.75))

# Callable,可调用类型

print(Callable, type(add), isinstance(add, Callable)) # typing.Callable <class 'function'> True

# Union,联合类型,Union[X, Y] 代表要么是 X 类型,要么是 Y 类型。 联合类型的联合类型等价于展平后的类型

Union[Union[int, str], float] == Union[int, str, float]

Union[int] == int # 仅有一个参数的联合类型会坍缩成参数自身

Union[int, str, int] == Union[int, str] # 多余的参数会被跳过

Union[int, str] == Union[str, int] # 在比较联合类型的时候,参数顺序会被忽略

【2023-11-9】LLM 推理代码

from typing import Any, Dict, List, Union

prompts: List[str] = [

"user: 上海有什么好玩的地方 assistant: ",

"user: 请给我一些学习上的建议 assistant: ",

]

print(prompts)

数值型

bool

bool 类型来表示真(True)或假(False),

True 和 False 是 Python 中的关键字,当作为 Python 代码输入时,一定要注意字母的大小写,否则解释器会报错。

bool 类型用于代表某个事情的真(对)或假(错)

- 如果这个事情是正确的,用 True(或 1)代表;

- 如果这个事情是错误的,用 False(或 0)代表。

5>3 # True

4>20 # False

整型

【2025-4-25】Python 整型是整数,包括: 负整数、0、正整数,在程序中的表示方法和数学上的写法一模一样,例如:1,100,-8080,0,等等。

Python 3.x 允许使用下划线_作为数字(包括整数和小数)分隔符。

- 通常每隔三个数字添加一个下划线,类似于英文数字中的逗号。

- 下划线不会影响数字本身的值。

click = 1301547

distance = 384_000_000

print("Python教程阅读量:", click) # Python教程阅读量:1301547

print("地球和月球的距离:", distance) # 地球和月球的距离:384000000

浮点型

浮点型就是小数

python中的两种形式:

- 例如 34.6、346.0、0.346。

- Python 小数的指数形式的写法为:

aEn或aen- a 为尾数部分,是一个十进制数;

- n 为指数部分,是一个十进制整数;

- E或e是固定的字符,用于分割尾数部分和指数部分。

- 整个表达式等价于 a×10^n。

字符串

格式化输出

格式化输出主要方法:Python 3’s f-Strings: An Improved String Formatting Syntax

%: 老方法, 不适宜多变量,容易混淆、错位format: 变量多,字符串长时,仍然不方便f'{x}': 最方便

a = 'I\'m like a {} chasing {}.'

# 按顺序格式化字符串,'I'm like a dog chasing cars.'

a.format('dog', 'cars')

b = 'I prefer {1} {0} to {2} {0}'# 在大括号中指定参数所在位置

b.format('food', 'Chinese', 'American')

a = 2000

name = "Eric"

age = 74

# (1) % 方式

"Hello, %s." % name # 老方法, 不适宜多变量,容易混淆、错位

# (2) format 方式

"Hello, {}. You are {}.".format(name, age) # 改进:format

"Hello, {1}. You are {0}.".format(age, name)

person = {'name': 'Eric', 'age': 74}

"Hello, {name}. You are {age}.".format(name=person['name'], age=person['age'])

"Hello, {name}. You are {age}.".format(**person) # format:变量多,字符串长时,仍然不方便

print(f"{a}.wav") # 直接引用变量

# (3) f string 方式

f"Hello, {name}. You are {age}."

# [2024-8-9] 输出变量的简洁方式, 后面加=

f"{name=}" # name=Eric

f"{2 * 37}" # 直接放表达式

特殊操作

常见特殊符号

- r 前缀表示原始字符串, 忽略转义符,如 换行符

\n、\t、\r、\"等 - b 前缀表示字节字符串

- u 前缀表示Unicode字符串

- f 前缀表示格式化字符串。

【2025-6-27】问题

- python 中

json.loads(x), 当x包含嵌套json字符串时,转义符号(")会触发json解析错误

解决方法

folder_name = r"C:\Users\username\Documents"

file_name = "example.txt"

file_path = fr"{folder_name}\{file_name}"

print(file_path) # 输出: C:\Users\username\Documents\example.txt

s = '{"a":1, "b":"{\"b1\":3}"}'

def fun(x):

return json.loads(fr'{x}')

# 嵌套方式通过函数传参后,特殊符号失效

fun(s) # 无效,照常 json load 失败

format – py26

Python 2.6 引入了 format 进行字符串格式化,相比在字符串中用 % 类似C的方式,更加强大方便

a = 3.1415

b = 'hello'

c = 'world'

print('%.1f' % a) # 取1位小数

print('{}'.format(a))

print('{:,}'.format(a)) # 千分位逗号区分

print('{0} {1} {0}'.format(b,c)) # 打乱顺序

print('{a} {tom} {a}'.format(tom='hello',a='world')) # 带关键字

print('%.3e' % 1.11) # 取3位小数,用科学计数法

print('{:.2f}'.format(a))

print(f'{a:.2f}') # format的隐含模式

# 对齐方式,分别使用<、>和^三个符号表示左对齐、右对齐和居中对齐

print('{:30}'.format(b)) # 宽度30

print('{:<30}'.format(b)) # 宽度30, 左对齐

print('{:30>}'.format(b)) # 宽度30, 右对齐

print('{:^30}'.format(b)) # 宽度30, 居中

print('{:*^30}'.format(b)) # 宽度30, 居中, *填充

填充常跟对齐一起使用

- ^、<、>分别是居中、左对齐、右对齐,后面带宽度

- :号后面带填充的字符,只能是一个字符,不指定的话默认是用空格填充

'{:0>8}'.format('189') #'00000189'

# >代表右对齐,>前是要填充的字符,依次输出:

# 000001

# 000019

# 000256

for i in [1, 19, 256]:

print('The index is {:0>6d}'.format(i))

# <代表左对齐,依次输出:

# *---------

# ****------

# *******---

for x in ['*', '****', '*******']:

progress_bar = '{:-<10}'.format(x)

print(progress_bar)

'{:.2f}'.format(321.33345)

for x in [0.0001, 1e17, 3e-18]:

print('{:.6f}'.format(x)) # 按照小数点后6位的浮点数格式

print('{:.1e}'.format(x)) # 按照小数点后1位的科学记数法格式

print ('{:g}'.format(x)) # 系统自动选择最合适的格式

其他类型:

- b、d、o、x分别是二进制、十进制、八进制、十六进制

'{:b}'.format(17) #10001

'{:,}'.format(1234567890) #'1,234,567,890',用,号还能用来做金额的千位分隔符

template = '{name} is {age} years old.' #按变量名引用

c = template.format(name='Tom', age=8)) # Tom is 8 years old.

d = template.format(age=7, name='Jerry')# Jerry is 7 years old.

字符串 format 函数可以接受不限个参数,位置可以不按顺序,可以不用或者用多次,不过2.6不能为空{},2.7才可以。

- list和tuple可以通过“打散”成普通参数给函数,而dict可以打散成关键字参数给函数(通过和*)。

- 可轻松的传个 list/tuple/dict 给 format函数,非常灵活。

#(1)通过关键字参数

'{name},{age}'.format(age=18,name='kzc') # 'kzc,18'

# (2)通过对象属性

class Person:

def __init__(self,name,age):

self.name,self.age = name,age

def __str__(self):

return 'This guy is {self.name},is {self.age} old'.format(self=self)

str(Person('kzc',18)) #'This guy is kzc,is 18 old'

# (3)通过下标

p=['kzc',18]

'{0[0]},{0[1]}'.format(p) #'kzc,18'

format 在生成字符串和文档时非常有用

f string – py36

f 字符串:

Python 3.6新特性,更方便、更快- As of Python 3.6, f-strings are a great new way to format strings. Not only are they more readable, more concise, and less prone to error than other ways of formatting, but they are also faster

a = 2000

name = "Eric"

age = 74

# [2024-8-9] 输出变量的简洁方式, 后面加=

f"{name=}" # name=Eric

def to_lowercase(input):

return input.lower()

name = "Eric Idle"

f"{to_lowercase(name)} is funny." # 调用函数

f"{name.lower()} is funny."

# 类中调用

class Comedian:

def __init__(self, first_name, last_name, age):

self.first_name = first_name

self.last_name = last_name

self.age = age

def __str__(self):

return f"{self.first_name} {self.last_name} is {self.age}."

def __repr__(self):

return f"{self.first_name} {self.last_name} is {self.age}. Surprise!"

new_comedian = Comedian("Eric", "Idle", "74")

f"{new_comedian}" # 'Eric Idle is 74.'

f"{new_comedian!r}" # 'Eric Idle is 74. Surprise!'

name = "Eric"

profession = "comedian"

affiliation = "Monty Python"

# 多行模式

# If you don't put an f in front of each individual line, then you'll just have regular, old, garden-variety strings and not shiny, new, fancy f-strings.

# 用tuple

message = ( # 多行模式

f"Hi {name}. "

f"You are a {profession}. "

f"You were in {affiliation}."

)

# 换行模式

message = f"Hi {name}. " \

f"You are a {profession}. " \

f"You were in {affiliation}."

message # 'Hi Eric. You are a comedian. You were in Monty Python.'

message = f"""

Hi {name}.

You are a {profession}.

You were in {affiliation}.

"""

message # 包含换行符:'\n Hi Eric.\n You are a comedian.\n You were in Monty Python.\n'

性能测试

import timeit

timeit.timeit("""name = "Eric"

age = 74

'%s is %s.' % (name, age)""", number = 10000) # 0.00332

timeit.timeit("""name = "Eric"

age = 74

'{} is {}.'.format(name, age)""", number = 10000) # 0.00424

timeit.timeit("""name = "Eric"

age = 74

f'{name} is {age}.'""", number = 10000) # 0.00248

字符串示例

Python中字符串相关的处理都非常方便,来看例子:

a = 'Life is short, you need Python'

a.lower() # 'life is short, you need Python'

a.upper() # 'LIFE IS SHORT, YOU NEED PYTHON'

a.count('i') # 2

a.find('e') # 从左向右查找'e',3

a.rfind('need') # 从右向左查找'need',19

a.replace('you', 'I') # 'Life is short, I need Python'

tokens = a.split() # ['Life', 'is', 'short,', 'you', 'need', 'Python']

b = ' '.join(tokens) # 用指定分隔符按顺序把字符串列表组合成新字符串

c = a + '\n' # 加了换行符,注意+用法是字符串作为序列的用法

c.rstrip() # 右侧去除换行符

[x for x in a] # 遍历每个字符并生成由所有字符按顺序构成的列表

'Python' in a # True

print(a.capitalize()) #将字符串首字母大写

print(a.center(20)) #将字符串a置于20个空格字符的中间

print(a.startswith('H')) #判断字符串是否以某个字母开始

print(a.startswith('h'))

print(a.endswith('n')) #判断字符串是否以某个字母结束

print(a.lower()) #将字符串统一小写

print(a.upper()) #将字符串统一大写

print(a.islower()) #判断字符串是否小写

print(a.isupper()) #判断字符串是否大写

print(a.find('l')) #查找字符串,返回第一个查找到的字符串的首字符的索引,找不到不报错返回-1

print(a.index('P')) #查找字串,返回索引,查不到报错

print(a.replace('l', 'W')) #替换所有

编码方式

常见编码介绍:

GB2312编码:适用于汉字处理、汉字通信等系统之间的信息交换GBK编码:是汉字编码标准之一,是在 GB2312-80 标准基础上的内码扩展规范,使用了双字节编码ASCII编码:是对英语字符和二进制之间的关系做的统一规定Unicode编码:这是一种世界上所有字符的编码。当然了它没有规定的存储方式。UTF-8编码:是 Unicode Transformation Format - 8 bit 的缩写, UTF-8 是 Unicode 的一种实现方式。它是可变长的编码方式,可以使用 1~4 个字节表示一个字符,可根据不同的符号而变化字节长度。

Python内部的字符串一般都是 Unicode编码。代码中字符串的默认编码与代码文件指定编码是一致。所以要做一些编码转换通常是要以Unicode作为中间编码进行转换的,即先将其他编码的字符串解码(decode)成 Unicode,再从 Unicode编码(encode)成另一种编码。

- decode: 将其他编码的字符串转换成 Unicode 编码

- name.decode(“GB2312”),表示将GB2312编码的字符串name转换成Unicode编码

- encode: 将Unicode编码转换成其他编码的字符串

- name.encode(”GB2312“),表示将Unicode编码的字符串name转换成GB2312编码 所以在进行编码转换的时候必须先知道 name 是那种编码,然后 decode 成 Unicode 编码,最后载 encode 成需要编码的编码。当然了,如果 name 已经就是 Unicode 编码了,那么就不需要进行 decode 进行解码转换了,直接用 encode 就可以编码成你所需要的编码。值得注意的是:对 Unicode 进行编码和对 str 进行编码都是错误的。

#-*- coding: UTF-8 -*-

# 指定编码方式

import sys

print sys.getdefaultencoding() # 获取系统默认编码

name = '你好'

name.decode(“GB2312”) # 将GB2312编码的字符串name转换成Unicode编码

name.encode(”GB2312“) # 将Unicode编码的字符串name转换成GB2312编码

bytes.decode(encoding="utf-8", errors="strict")

str.encode(encoding="utf-8", errors="strict")

errors 是 错误处理方案。

- 默认为 ‘strict’, 意为编码错误引起一个UnicodeError。

- 其他可能得值有 ‘ignore’, ‘replace’, ‘xmlcharrefreplace’, ‘backslashreplace’ 以及通过 codecs.register_error() 注册的任何值。

汉字识别

汉字的unicode编码范围 u4e00 到 u9fa5

- 汉字的判断

- 汉字的unicode编码范围 u4e00 到 u9fa5

- 数字0-9的判断

- 数字的unicode编码范围根据全角和半角,有两个不同区域,半角数字 u0030 到 u0039,全角数字 uff10 到 uff19。

- 字母的unicode编码根据字母大小写,以及全角和半角共有四个区域。

- 半角大写字母:u0041 - u005a ,半角小写字母:u0061 - u007a ;

- 全角大写字母:uff21 - uff3a , 全角小写字母:uff41 - uff5a 。

- 非汉字和数字字母的判断

- 判断除汉字、数字0-9、字母之外的字符

ord('。') # str -> int

chr(12290) # int -> str

def is_chinese(uchar):

"""判断一个unicode是否是汉字"""

if uchar >= u'\u4e00' and uchar<=u'\u9fa5':

return True

else:

return False

def is_number(uchar):

"""判断一个unicode是否是半角数字"""

if uchar >= u'\u0030' and uchar<=u'\u0039':

return True

else:

return False

def is_Qnumber(uchar):

"""判断一个unicode是否是全角数字"""

if uchar >= u'\uff10' and uchar <= u'\uff19':

return True

else:

return False

def is_other(uchar):

"""判断是否非汉字,数字和英文字符"""

if not (is_chinese(uchar) or is_number(uchar) or is_alphabet(uchar)):

return True

else:

return False

中文全角、半角

【2022-11-18】在自然语言处理过程中,全角、半角的的不一致会导致信息抽取不一致,因此需要统一。

全角半角转换说明

有规律(不含空格):

- 全角字符unicode编码从65281~65374 (十六进制 0xFF01 ~ 0xFF5E)

- 半角字符unicode编码从33~126 (十六进制 0x21~ 0x7E)

特例:

- 空格比较特殊,全角为 12288(0x3000),半角为 32(0x20)

- 除空格外,全角/半角按unicode编码排序在顺序上是对应的(半角 + 0x7e= 全角),所以可以直接通过用+-法来处理非空格数据,对空格单独处理。

注:

- 中文文字永远是全角,只有英文字母、数字键、符号键才有全角半角的概念,一个字母或数字占一个汉字的位置叫全角,占半个汉字的位置叫半角。

- 引号在中英文、全半角情况下是不同的

库函数说明

chr() 函数用一个范围在 range(256)内的(就是0~255)整数作参数,返回一个对应的字符。unichr() 跟它一样,只不过返回的是Unicode字符。ord() 函数是chr()函数(对于8位的ASCII字符串)或 unichr()函数(对于Unicode对象)的配对函数,它以一个字符(长度为1的字符串)作为参数,返回对应的ASCII数值,或者Unicode数值。

# -*- coding: cp936 -*-

def strQ2B(ustring):

"""全角转半角"""

rstring = ""

for uchar in ustring:

inside_code=ord(uchar)

if inside_code == 12288: #全角空格直接转换

inside_code = 32

elif inside_code == 12290: # 句号。【2022-11-18】补充

inside_code = 46

elif (inside_code >= 65281 and inside_code <= 65374): #全角字符(除空格)根据关系转化

inside_code -= 65248

#rstring += unichr(inside_code) # python 2

rstring += chr(inside_code) # python 3

return rstring

def strB2Q(ustring):

"""半角转全角"""

rstring = ""

for uchar in ustring:

inside_code=ord(uchar)

if inside_code == 32: #半角空格直接转化

inside_code = 12288

elif inside_code == 46: # 句号.【2022-11-18】补充

inside_code = 12290

elif inside_code >= 32 and inside_code <= 126: #半角字符(除空格)根据关系转化

inside_code += 65248

#rstring += unichr(inside_code) # python 2

rstring += chr(inside_code) # python 3

return rstring

b = strQ2B("mn123abc博客园")

print b

c = strB2Q("mn123abc博客园")

print c

注意

- Python2 使用 chr() 将 Ascii 值转换成对应字符,unichr() 将 Unicode 值转换成对应字符

- Python3中该内置函数消失了!实际上是Python3中的 chr() 不仅仅支持 Ascii 转换,直接支持了更为适用的 Unicode 转换。

中文编码

Python 2.x中,str和bytes的数据类型是Byte类型的对象,但在Python 3.x中,这一点现在已经改变。

Python b 字符串由字节数据组成,这意味着代表整数的字头在0 到255 之间**。

- ** b string 和 string的主要区别在于其数据类型。

- 普通字符串有一串Unicode字符,如UTF-16或UTF-32,而Python b字符串有字节数据类型,意味着代表0到255之间的整数的字头(也被称为八位数)。

- 通过在Python普通字符串前面添加前缀b,将其数据类型从 字符串修改 为字节。

app_string = 'Happiest Season'

print(type(app_string)) # <class 'str'>

app_string_b = b'Happiest Season'

print(type(app_string_b)) # <class 'bytes'>

print('ÑÞ') # ÑÞ

print('ÑÞ'.encode('UTF-8')) # b'\xc3\x91\xc3\x9e'

print(len('ÑÞ'.encode('UTF-8'))) # 4 --- utf8编码

print(b'\xc3\x91\xc3\x9e'.decode('UTF-8')) # ÑÞ --- 解码(字节转字符串)

print(len(b'\xc3\x91\xc3\x9e'.decode('UTF-8'))) # 2

基础数据结构

Python中的容器是异常好用且异常有用的结构, 主要有列表(list),元组(tuple),字典(dict)和集合(set)

Python中的内置数据结构(Built-in Data Structure): 列表list、元组tuple、字典dict、集合set

list- list的显著特征:

- 列表中的每个元素都可变的,意味着可以对每个元素进行修改和删除;

- 列表是有序的,每个元素的位置是确定的,可以用索引去访问每个元素;

- 列表中的元素可以是Python中的任何对象;

- 可以为任意对象就意味着元素可以是字符串、整数、元组、也可以是list等Python中的对象。

- Python中包含6中內建的序列:列表,元组,字符串、Unicode字符串、buffer对象和xrange对象

- list的显著特征:

tuple- 元组Tuple,用法与List类似,但Tuple一经初始化,就不能修改,没有List中的append(), insert(), pop()等修改的方法,只能对元素进行查询

dict- 字典dictionary全称这个概念就是基于现实生活中的字典原型,生活中的使用名称-内容对数据进行构建,Python中使用键(key)-值(value)存储,也就是java、C++中的map。

- 字典中的数据必须以键值对的形式出现,即k,v:

- key:必须是可哈希的值,比如intmstring,float,tuple,但是,list,set,dict不行 ; value:任何值

- 键不可重复,值可重复,键若重复字典中只会记该键对应的最后一个值

- 字典中键(key)是不可变的,何为不可变对象,不能进行修改;而值(value)是可以修改的,可以是任何对象。在dict中是根据key来计算value的存储位置,如果每次计算相同的key得出的结果不同,那dict内部就完全混乱了。

set- 集合更接近数学上集合的概念。集合中每个元素都是无序的、不重复的任意对象。可以通过集合去判断数据的从属关系,也可以通过集合把数据结构中重复的元素减掉。集合可做集合运算,可添加和删除元素。

- 集合内数据无序,即无法使用索引和分片, 集合内部数据元素具有唯一性,可以用来排除重复数据, 集合内的数据:str,int,float,tuple,冰冻集合等,即内部只能放置可哈希数据

- frozen set:冰冻集合是不可以进行任何修改的集合

frozenset是一种特殊集合- 常用方法

- intersection:交集

- difference:差集

- union:并集

- issubset:检查一个集合是否为另一个子集

- issuperset:检查一个集合是否为另一个超集

- 常用方法

list 列表

list 遍历

遍历列表可使用 for循环、while循环 和 enumerate()函数等多种方法来实现。

for循环: 最常用,因为简单、易读且高效。enumerate: 同时获取元素索引和值。while循环: 虽然也可以遍历列表,但通常更加复杂且容易出错。

在处理嵌套列表时,可以使用嵌套的for循环来遍历所有元素。

经典示例

arr = ['马','蹄','哒','哒','哒']

idx = 1

# for 遍历

for item in arr: # 未复制, 原地操作

# print(f'{idx}: {item}')

if item == '哒':

arr.remove(item) # 修改原数组, 删除第一个出现元素

print(f'{idx}\t{arr}')

idx += 1

print(f'end\t{arr}')

# 3 ['马', '蹄', '哒', '哒']

# 4 ['马', '蹄', '哒']

# end ['马', '蹄', '哒']

# enumerate 遍历

for i, item in enumerate(arr):

# print(f'{i}: {item}')

if item == '哒':

arr.remove(item) # 修改原数组, 删除第一个出现元素

print(f'{i}\t{arr}')

print(f'end\t{arr}')

list 操作

列表的基本操作有访问,增加,删除,和拼接

a.append(5) # 末尾插入值,[1, 2, 3, 5]

a.extend([34, 37]) # 扩充列表

a.index(2) # 找到第一个2所在的位置,也就是1

a[2] # 取下标,也就是位置在2的值,也就是第三个值3

a += [4, 3, 2] # 拼接,[1, 2, 3, 5, 4, 3, 2]

a.insert(1, 0) # 在下标为1处插入元素0,[1, 0, 2, 3, 5, 4, 3, 2]

x.insert(6,6666)

# 删除元素

a.pop() # 删除最后一个元素,并返回值

a.pop(1) # 删除第2个元素,并返回值

a.remove(2) # 按值删除,移除第一个2,[1, 0, 3, 5, 4, 3, 2]

del(x[3]) #字符串删除操作,小心使用,不要在遍历时改变list结构

reverse(a)

a.reverse() # 倒序,a变为[2, 3, 4, 5, 3, 0, 1]

x.clear() # 清空列表

x.copy() # 复制

a[3] = 9 # 指定下标处赋值,[2, 3, 4, 9, 3, 0, 1]

b = a[2:5] # 取下标2开始到5之前的子序列,[4, 9, 3]

c = a[2:-2] # 下标也可以倒着数,方便算不过来的人,[4, 9, 3]

d = a[2:] # 取下标2开始到结尾的子序列,[4, 9, 3, 0, 1]

e = a[:5] # 取开始到下标5之前的子序列,[2, 3, 4, 9, 3]

f = a[:] # 取从开头到最后的整个子序列,相当于值拷贝,[2, 3, 4, 9, 3, 0, 1]

a[2:-2] = [1, 2, 3] # 赋值也可以按照一段来,[2, 3, 1, 2, 3, 0, 1]

g = a[::-1] # 也是倒序,通过slicing实现并赋值,效率略低于reverse()

a.sort()

print(a) # 列表内排序,a变为[0, 1, 1, 2, 2, 3, 3]

【2017-9-5】

c = [-10,-5,0,5,3,10,15,-20,25]

print(c.index(min(c))) # 返回最小值

print(c.index(max(c))) # 返回最大值

print(x.count(23)) #统计元素出现个数

# 排序

c = sorted(a, reverse=True)

tuple 元组

元组和列表有很多相似的地方,最大的区别在于不可变

- 还有如果初始化只包含一个元素的tuple和列表不一样,因为语法必须明确,所以必须在元素后加上逗号。

- 另外直接用逗号分隔多个元素赋值默认是个tuple,这在函数多返回值的时候很好用:

a = (1, 2)

b = tuple(['3', 4]) # 也可以从列表初始化

c = (5,)

print(c) # (5,)

d = (6)

print(d) # 6

e = 3, 4, 5

print(e) # (3, 4, 5)

dict 字典

字典是一种非常常见的“键-值”(key-value)映射结构

- 键无重复,一个键不能对应多个值,不过多个键可以指向一个值

重要方法

- keys():获取所有键

- values():获取所有值

- items():获取所有键值对

常见操作

a = {'Tom': 8, 'Jerry': 7}

print(a['Tom']) # 8

b = dict(Tom=8, Jerry=7) # 一种字符串作为键更方便的初始化方式

print(b['Tom']) # 8

if 'Jerry' in a: # 判断'Jerry'是否在keys里面

print(a['Jerry']) # 7

print(a.get('Spike')) # None,通过get获得值,即使键不存在也不会报异常

a['Spike'] = 10

a['Tyke'] = 3

a.update({'Tuffy': 2, 'Mammy Two Shoes': 42})

print(a.values()) # dict_values([8, 2, 3, 7, 10, 42])

print(a.pop('Mammy Two Shoes')) # 移除'Mammy Two Shoes'的键值对,并返回42

print(a.keys()) # dict_keys(['Tom', 'Tuffy', 'Tyke', 'Jerry', 'Spike'])

b = a.items()

print(b) # [('Tuffy', 2), ('Spike', 10), ('Tom', 8), ('Tyke', 3), ('Jerry', 7)]

from operator import itemgetter

c = sorted(a.items(), key=itemgetter(1))

print(c) # [('Tuffy', 2), ('Tyke', 3), ('Jerry', 7), ('Tom', 8), ('Spike', 10)]

d = sorted(a.iteritems(), key=itemgetter(1))

print(d) # [('Tuffy', 2), ('Tyke', 3), ('Jerry', 7), ('Tom', 8), ('Spike', 10)]

e = sorted(a)

print(e) # 只对键排序,['Jerry', 'Spike', 'Tom', 'Tuffy', 'Tyke']

dict 有序输出

dic = {'t':2, 'r':1, 'e':3}

# 用sorted函数的key= 参数排序:

# 按照key进行排序

print(sorted(dic.items(), key=lambda d: d[0])) # [('e', 3), ('r', 1), ('t', 2)]

# 按照value进行排序

print(sorted(dic.items(), key=lambda d: d[1])) # [('r', 1), ('t', 2), ('e', 3)]

经验:流式计算均值

【2023-7-27】读入元素过程中,同时计算均值

a = {'x':3, 'y':7, 'z':2}

score = 0

for i, k in enumerate(a):

score = (score * i + a[k])/(i+1)

print(f"第{i+1}轮: 当前元素: {k}, 当前均值: {score}")

# 第1轮: 当前元素: x, 当前均值: 3.0

# 第2轮: 当前元素: y, 当前均值: 5.0

# 第3轮: 当前元素: z, 当前均值: 4.0

set 集合

集合是一种很有用的数学操作,比如列表去重,或是理清两组数据之间的关系,集合的操作符和位操作符有交集

set是一个无序且不重复的元素集合。

- 集合对象是一组无序排列的可哈希的值,集合成员可以做字典中的键。

- 集合支持用 in 和 not in 操作符检查成员,由 len() 内建函数得到集合的基数(大小), 用 for 循环迭代集合的成员。

- 但是因为集合本身是无序的,不可以为集合创建索引或执行切片(slice)操作,也没有键(keys)可用来获取集合中元素的值。

set和dict一样,只是没有value,相当于dict的key集合,由于dict的key是不重复的,且key是不可变对象因此set也有如下特性:

- 不重复

- 元素为不可变对象

A = set([1, 2, 3, 4])

B = {3, 4, 5, 6}

C = set([1, 1, 2, 2, 2, 3, 3, 3, 3])

print(C) # 集合的去重效果,set([1, 2, 3])

print(A | B) # 求并集,set([1, 2, 3, 4, 5, 6])

print(A & B) # 求交集,set([3, 4])

print(A - B) # 求差集,属于A但不属于B的,set([1, 2])

print(B - A) # 求差集,属于B但不属于A的,set([5, 6])

print(A ^ B) # 求对称差集,相当于(A-B)|(B-A),set([1, 2, 5, 6])

# ===== 比较 ======

se = {11, 22, 33}

be = {22, 55}

temp1 = se.difference(be) # 找到se中存在,be中不存在的集合,返回新值

print(temp1) # {33, 11}

print(se) # {33, 11, 22}

temp2 = se.difference_update(be) # 找到se中存在,be中不存在的集合,覆盖掉se

print(temp2) # None

print(se) # {33, 11},

# ===== 删除 ======

discard()、remove()、pop()

se = {11, 22, 33}

se.discard(11)