- 总结

- 车联网

- 自动驾驶

- 结束

总结

- 【2019-3-9】全球自动驾驶实力排名公布:谷歌第一,百度第七,苹果Uber垫底 《2018年自动驾驶接管报告》的结果更具参考性。

- 在加州机车辆管理局(DMV)刚刚披露的这些年度报告中,达到披露标准的48家自动驾驶路测单位,技术实力一一曝光。

- 谷歌系Waymo仍然排名第一且遥遥领先,通用旗下Cruise紧随其后,美国无人车明星创业公司Zoox排名第三。

- 华人/中国无人车玩家Nuro、Pony.ai和百度,拿下了第四、第五和第七交椅。意料之外的是垫底的公司——Uber倒数第一,苹果倒数第二。但无论如何,这都是自动驾驶技术实力的最真实反映。

- 【2020-5-8】无人驾驶科研笔记 My Bibliography for Research on Autonomous Driving

【2025-9-17】animagraffs 网站:电动汽车工作原理可视化

- Most electric cars are Battery Electric Vehicles (BEVs), which are a subset of Electric Vehicles (EVs). BEVs use a battery-powered electric motor for propulsion.

- How electric car works

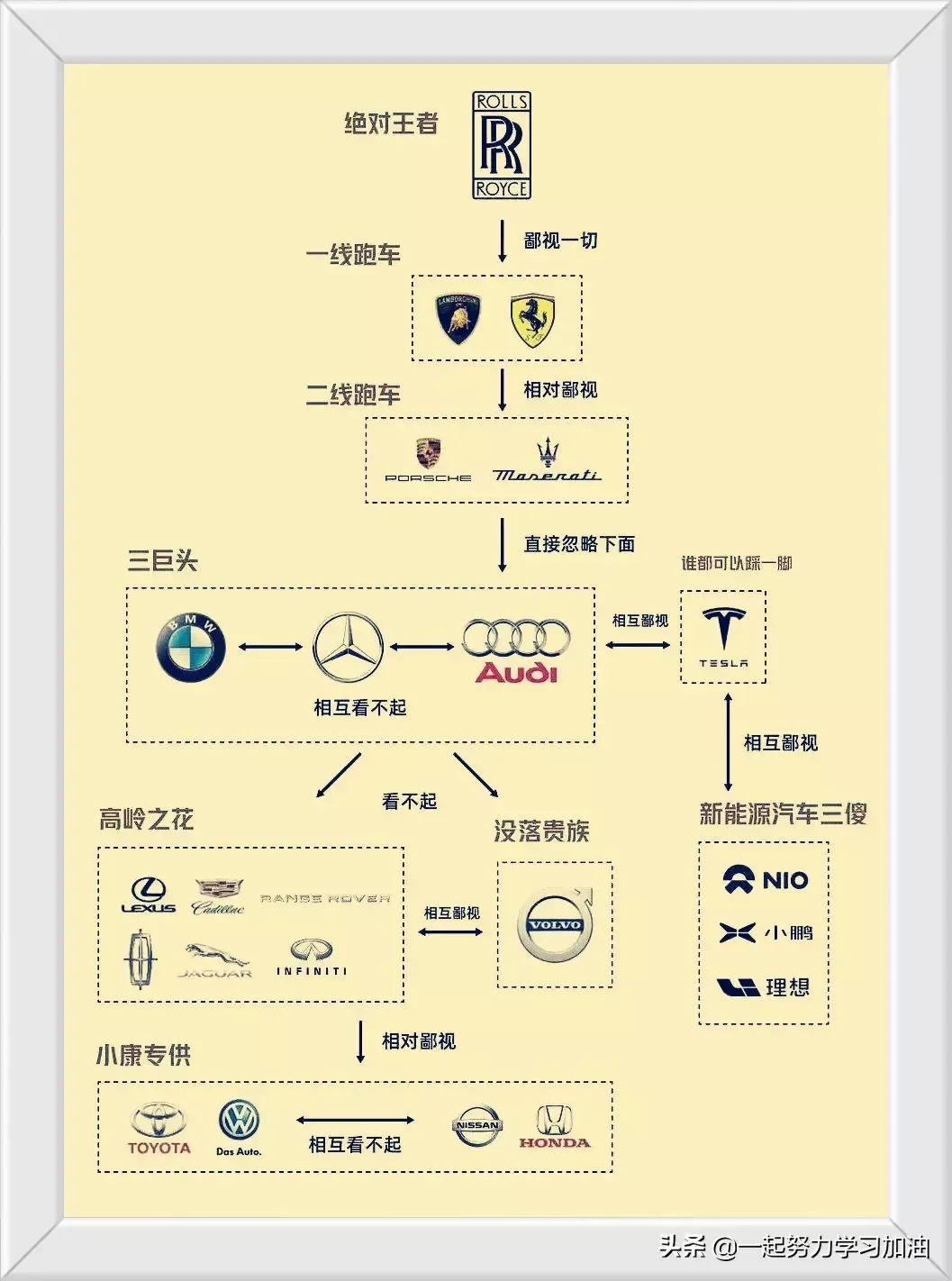

汽车品牌

【2021-7-12】汽车品牌鄙视链, IMG

国内车厂

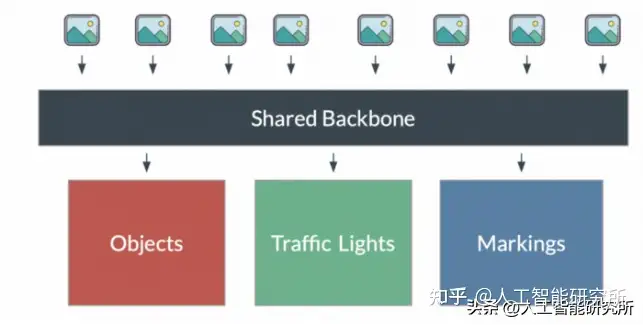

自动驾驶技术排列

- 第一梯队:百度自动驾驶、小马智行、文远知行、AutoX、Momenta、图森未来、领骏科技、元戎启行

- 第二梯队:智加科技、菜鸟、京东、美团、轻舟智航、滴滴自动驾驶、智行者

- 第三梯队:赢彻科技、飞步科技、斯年智驾、酷哇机器人、高仙机器人、驭势科技、行深智能、白犀牛、踏歌智行、慧拓智能

- 第四梯队:中智行、希迪智驾、千挂科技、主线科技、西井科技、恒润科技、盟识科技、仙途智能、新石器、一汽挚途

- 第五梯队:行猩科技、擎天智卡、畅加风行、伯镭科技、易控智驾、路凯智行、于万智驾、深兰科技、仓擎智能、九耀智能

造车新势力

【2021-7-20】小米,也许可以造个车

互联网造车主要可以分为三种模式:

- 自主造车;

- 自主设计,汽车厂代工;

- 与传统车企深度合作。

不同于消费类电子产品,汽车的产业链复杂且冗长,对安全性可靠性的要求极高。同时,完全自主造车又需要重资产的投入。因此,基于深度合作的方式,无论是互联网企业还是传统车企,都可以发挥自身的优势——软件上实现智能的效果,硬件上也有安全保障。据了解,这一模式已有多家巨头背书:百度+吉利、阿里+上汽(智己汽车)、华为+长安+宁德时代、苹果+起亚。

小米已经明确了“5G+AI+loT 下一代超级互联网”的战略方向,并且,将在 2025 年前为此投资 500 亿元人民币。

国内的几家科技巨头似乎都已找准自己的核心优势,并朝着相应的路线推进上车计划。

- 阿里巴巴的重点向车载操作系统 AliOS 倾斜;

- 百度手握自动驾驶的王牌 Apollo,以及车载系统小度 OS;

- 腾讯能够充分发挥自己在应用生态方面的优势;

- 华为则更倾向于为车企提供 ICT 技术。

- 「手机」从某种程度上来说就是小米的核心优势。作为与用户生活紧密结合度最高的智能硬件,手机能够清晰了解用户的日常习惯和生活规律,便于收集海量的用户真实数据。这是打造个性化定制的驾驶体验必不可少的要素。

【2021-7-20】科技巨头都来造车,打的什么算盘?

- 继社区卖菜之后,科技巨头又盯上了造车。一年前,新造车这个赛道里,最活跃的是特斯拉,以及以蔚来、小鹏、理想为代表的造车新势力,如今,名单里增加了百度、阿里、华为、富士康、苹果,如果算上投资这种形式,还有腾讯、美团——大大小小的科技巨头,都在抢造车这块蛋糕。鲶鱼特斯拉,激活了国内的新造车市场,淘汰了那些“骗补贴”的落后玩家,正在大批进场的科技巨头,则会对现在的造车格局带来新的冲击。

- 造车是一个最早以PPT闻名的行业,因为往往车还没量产,PPT先出来了,投资人和客户的钱一收,至于车怎么造出来,那是很多年以后的事情。所以,要造车,先画饼。科技巨头,就是看到了那张大饼。而看起来最美味的那一张,是在2025年。

- 国务院在《新能源汽车产业发展规划(2021-2035年)》中是这样说的:到2025年,中国新能源汽车市场竞争力明显增强……新能源汽车新车销售量达到汽车新车销售总量的20%左右。,并且力争于 2030 年前实现「碳达峰」,2060 年前完成「碳中和」的目标。

- 根据中国汽车工业协会的数据,2020年,中国全年汽车销量2531.1万辆,其中新能源汽车有136.7万辆,占比5.4%。从5.4%到20%的过程,是新能源汽车逐步取代燃油车的过程,也是接下来这五年里,新能源汽车在中国的增量空间。新能源汽车在国内发展速度很快,尤其是从2020年下半年开始加速,从7月开始,每个月产销均刷新当月历史记录,12月创下月度历史新高,同比增速达49.5%,全年增速10.9%。按照这个速度发展到2025年,按照20%的渗透率计算,新能源汽车的市场空间是非常有想象力的。

- 2003年特斯拉成立,凭借一己之力开启了汽车电动化浪潮,这背后的底层逻辑是电池取代燃油,是能源革命催生了新的出行方式。中国造车新势力的崛起是第二个变量。2014年以蔚来、小鹏、理想为代表的互联网车企站到台前,成为新造车的一股力量,随后陆续推出量产车型。2020年是一个关键节点,特斯拉在这一年起飞,全球销量接近50万辆,理想和小鹏都在美股成功上市,蔚来重新步入正轨,它们吸引了全球投资者的关注,把新造车这个赛道放在了聚光灯下。

- 腾讯、阿里、百度、美团,过去是通过投资参与造车——腾讯投资了蔚来,阿里投资了小鹏,百度投资了威马,美团投资了理想。中国造车新势力发展最好的这四家,很早就已经被中国的科技巨头们瓜分完毕。

但是从2020年下半年开始,巨头们的策略发生了变化。

- 阿里似乎要亲自下场。2020年11月,在上海中心观光厅最高层,上汽集团、浦东新区和阿里达成合作,推出新造车品牌智己汽车,上汽出资54亿,浦东张江出资18亿,阿里等出资28亿,阿里占股18%。从股权结构来看,智己汽车是由上汽主导,阿里的角色尚不明朗,但有分析认为,阿里或是为了发展车联网业务,小鹏的XmartOS是自研,阿里的AliOS未得到应用。阿里一直偏好轻资产模式,阿里入局新造车,并不是想赚硬件的钱,它一直想推阿里云,但汽车行业大家都在推私有云,所以阿里在跟车企合作的时候就会比较难

- 百度则终于要亲自下场了。1月11日,百度宣布正式组建一家智能汽车公司,以整车制造商的身份进军汽车行业。吉利控股集团将成为新公司的战略合作伙伴。百度汽车公司独立于母公司体系,保持自主运营。

- 腾讯也在加大布局力度。1月19日,腾讯和吉利汽车达成合作,重点围绕智能座舱、自动驾驶、数字化营销、数字化底座、数字化新业务及低碳发展等领域展开。从合作形式来看,腾讯是以互联网服务商的角色介入,并未介入更深层的整车制造和系统开发环节。

- 华为内部一直有一句话:华为不造车,但我们聚焦ICT技术,帮助车企造好车。去年11月流出的一份华为内部文件,显示华为依然坚持这一战略,帮助车企做好智能化。同月,长安汽车宣布将携手华为、宁德时代,联合打造一个全新高端智能汽车品牌

百度是最着急、下场决心最坚决的那个。从业务匹配度来讲,百度是BAT中离造车最近的。过去百度all in AI,重金投入自动驾驶项目Apollo,尽管Apollo已经在全球有上百家合作伙伴,但做了七年还没有赚钱。把技术变现,不仅需要客户,也需要商业场景。百度宣布造车之前,蔚来的市值已经超过了百度,小鹏也在去年11月短暂超过了百度。新造车超高的估值溢价,也在催着百度跑步进场。效果很明显,1月8日百度和吉利合作造车的消息传出后,百度股价当天暴涨15.57%,如今市值重回800亿美元上方。“Apollo自动驾驶是百度手上比较好的一张牌,但这块业务过去一直无法分拆,因为分拆了百度市值会下滑。现在资本市场对电动车行业高度乐观,所以百度才亲自下场去做。”张君毅说。

车联网

资料

- 【2018-09-21】一篇文章告诉你什么是“车联网”?

- 车联网产业发展报告

发展历史

车联网的发展经历了好几个阶段

- 最初出现的时候被称为“汽车移动物联网”,这个时候物联网发展正当时,人们纷纷盼望着物联网技术能够应用于汽车领域。

- 后来,为了方便,“汽车移动物联网”又改名为“车联网”,并用英文“Internet of Vehicles”来表示,主要用于车车/车路通信,实现协同应用,但是这个概念一开始出现时,人们更多地是把它跟“Telematics”(车载信息服务,是指应用无线通信技术的车载计算机系统)应用混为一谈,而Telematics应用那时已经非常成熟。为了跟Telematics业务做更好的区分,业界开始更多地用“V2X”(Vehicle to Everything,包括Vehicle to Vehicle和Vehicle to Infrastructure,即V2V和V2I)来表示车联网。

- 在车间通信逐步被大家认可之后,一个融合的网络架构被提了出来,它包括车内网、车际网(也叫车间网)、车云网(也叫车载移动互联网),用于更好地为智能交通系统(ITS)提供通信服务。

- 随着人工智能不断成熟,智能驾驶也向着更高阶段发展,人们希望把网络和人工智能有机地结合起来,通过协作式感知来弥补自主式感知的不足,以更好地服务于智能驾驶。于是,一个全新的说法“智能网联汽车”开始出现,智能汽车需要网联技术提供全方位的感知,也需要网络来共享云端的处理资源。

车联网就是把汽车连起来,组成网络。不过,从宏观上来说,车联网其实是一个非常庞大的体系。很多人了解的车联网,可能只是车联网体系的一小部分而已。接下来全面介绍,希望能够讲清楚车联网的相关概念,帮助大家具体、客观、理性地了解车联网。

- 1、到底什么是车联网?

- 2、车联网包括哪些东西?是一个什么样的架构?

- 3、车联网有哪些主要的技术?是如何发展和演进的?

- 4、车联网会带来什么好处?会如何影响我们的生活?

- 5、马上要到来的5G,和车联网又有什么关系?

什么是车联网

百度百科:

车联网(Internet of Vehicles)概念引申自物联网(Internet of Things),是以车内网、车际网和车载移动互联网为基础,按照约定的通信协议和数据交互标准,在车-X(X:车、路、行人及互联网等)之间,进行无线通讯和信息交换的大系统网络,是能够实现智能化交通管理、智能动态信息服务和车辆智能化控制的一体化网络,是物联网技术在交通系统领域的典型应用。

车联网,英文叫做 IoV(Internet of Vehicles),它属于物联网(IoT,Internet of Things)的一种。

- Vehicle,就是车辆、交通工具的意思。以前我们学英语,都知道把车叫做car、bus、truck,其实,vehicle老外用得更多,相当于是统称。

- 摘自:车联网最强科普

前面说了,车联网,就是把车连接在一起的网络。其实,确切来说,车联网并不只是把车与车连接在一起,它还把车与行人、车与路、车与基础设施(信号灯等)、车与网络、车与云连接在一起。这里牵出了好几个大家经常看到的车联网概念:

- V2V:车与车,Vehicle to Vehicle

- V2P:车与行人,Vehicle to Pedestrian

- V2R:车与路,Vehicle to Road

- V2I:车与基础设施,Vehicle to Infrastructure

- V2N:车与网络,Vehicle to Network

- V2C:车与云,Vehicle to Cloud

不管是V2什么,都可以统称为V2X(X代表everything,任何事物)。有的同学把上面的某个V2当作了车联网,这样是不准确的。实际上,真正的车联网,就是V2X(车连万物)。

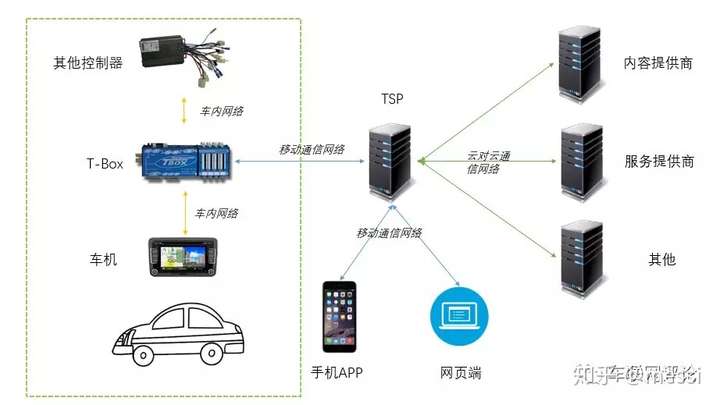

车联网简要架构

前装车联网和后装车联网

在讨论V2X之前,我们先来看看这个Vehicle本身,也就是先看看车的内部。

对于一辆车来说,它包括很多的部件,例如空调、音响、摄像头、发动机、轮胎等。这些部件都可以信息化、数字化。通过安装传感器,可以产生表达状态的数据。例如轮胎,可以安装胎压传感器,产生胎压数据,监控轮胎的状态。

有了数据,就可以进行传输。将车内各个部件的数据,传递给这辆车的“神经中枢”,这种网络,可以称之为“车内网”。

对于车内网来说,传感器技术显得非常关键。这里的传感器,并不只是车内信息的采集,更包括车辆外部的传感器数据,例如防碰撞的传感器信息,感应外部环境变化的摄像头,监测路面路况的传感器,等等。这些传感器数据,关系到车辆的舒适性和安全性。

除了传感器之外,更关键的,就是“神经中枢”了。一般来说,汽车制造商喜欢在生产汽车时,就把作为“神经中枢”的车联网设备给装配好,通常称之为“前装车联网”。前装的代表,就是福特的SYNC、通用的OnStar(安吉星),以及国内上汽集团的inkaNet、吉利的iNTEC、长安的Incall等。

前装车联网系统一般包括四部分:主机、车载T-BOX,手机APP及后台系统。

- T-BOX,就是Telematics BOX(Telematics是电信Telecommunications与信息科学Informatics的合成词),又称TCU(车联网控制单元)。简单说,就是安装在汽车上用于控制和跟踪汽车状态的一台计算机(嵌入式)。

T-BOX

而互联网公司这样的非汽车制造商,因为无法参与汽车前期制造环节,所以,只能通过后装的方式,安装用于车联网的车载终端。后装的代表,是腾讯的路宝盒子。这是一种后期加装的通过汽车OBD接口获取实时车辆数据的装置。OBD,就是On-Board Diagnostic,车载自动诊断系统。

腾讯路宝

汽车上的OBD接口: 这种设备通过OBD接口获取数据后,再通过蓝牙等方式,将数据传输给手机。

注意,这个神经中枢,除了硬件之外,软件也很重要,所以像阿里这样的公司,就做了YUN OS Auto这样的车载智能操作系统(VOS,Vehicle Operating System)。相当于手机的Android一样,是给汽车用的操作系统。

总之,不管是前装还是后装,不管是硬件还是软件,都是为了获取数据,监测和控制车辆。

如果车辆本身没有对外进行通讯的能力,那么,“车内网”就是一个局域网,一个孤岛。汽车的“神经中枢”,可以通过仪表盘或者中控,告知驾驶员车辆的情况。或者,按刚才说的,通过蓝牙和手机相连,把数据传出来。但是,这种方式不管是传输速率,还是数据量、及时性、便捷性等,都是不够的。

于是,就要想办法让车辆具备足够强大的外部通讯能力。

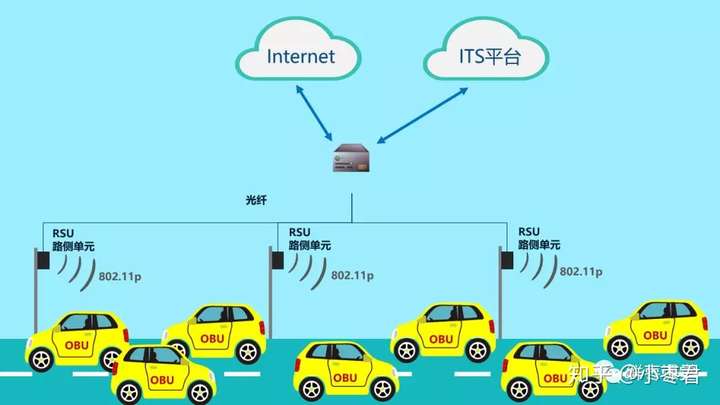

DSRC vs LTE-V

敲黑板!这一部分很关键!

实现车辆的对外通讯,是有很高要求的。因为车辆通常在高速移动,而且是长距离大范围移动。

早期的时候,为了实现车辆的对外通信,采用的是DSRC技术(DeDICated Short Range CommunICation,专用短程通信)。这项技术是1992年美国材料试验学会ASTM(American Society for Testing Materials)针对ETC业务而提出来的,后来经过不断完善,变成了IEEE的车联网通信技术标准(802.11p)。在很长一段时间里,DSRC都是像美国这样国家的主流车联网通信技术,现在也仍然有很多国家以它为主流标准。

DSRC的工作原理

- RSU,Road Side Unit,路侧单元

- OBU,On Board Unit,车载单元

- ITS,Intelligent Transport System,智能交通系统

DSRC技术其实就类似于,在道路边上装Wi-Fi,让车辆通过这个Wi-Fi进行通信。从名字也可以看出来,“专用短程通信”,短程,就是适合短距范围内进行通信,如果距离长了,可靠性等各方面都会存在问题。

那么,什么技术的通信距离长呢?当然是蜂窝移动通信啦!也就是我们使用的手机通信。进入21世纪后,蜂窝移动通信得到了快速的发展,技术水平和行业生态都飞速进步。于是,人们开始研究使用蜂窝通信技术(Cellular),用于车联网通信。

目前我们最主流的蜂窝通信技术标准是什么呢?当然是4G LTE。

- 2014年9月,LG向3GPP提交了LTE在V2X通信应用的规范草案。同年12月,Ericsson提交了增强LTE D2D相近服务的规范草案。

- 随后,2015年,3GPP正式启动了LTE-V技术标准化的研究。

-

速度很快,到2016年9月,3GPP就在R14版本里完成了对LTE-V2X标准的制定。可以这么说,LTE-V是给车联网量身定制的LTE。

LTE-V依托现有的LTE基站,避免了重复建设,而且工作距离远比DSRC大,提供了更高的带宽,更高的传输速率,更大的覆盖范围。

LTE-V技术包括集中式(LTE-V-Cell)和分布式(LTE-V-Direct)两个工作模式。LTE-V-Cell需要基站作为控制中心,实现大带宽、大覆盖通信,而LTE-V-Direct可以无需基站作为支撑,可直接实现车辆与车辆,车辆与周边环境节点的可靠通信。

车与车通信(V2V),及时互相通报路况和异常

DSRC和LTE-V的竞争非常激烈,两者都希望成为主流的车联网通信标准。目前,我们国家倾向于采用LTE-V。

车联网的意义

车联网说了那么多年,一直都不温不火,其实,问题就在于车辆的对外通讯能力。汽车制造商善于造车,车内网可以搞得很溜,但解决不了外部通讯能力问题。互联网企业,软件搞得很溜,但是拿不到数据,也是白搭。所以,在广域物联网通信技术没有成熟之前,车联网很难有实质性的意义。

现在不一样了,借助LTE-V的能力,车辆对外通讯的这个瓶颈,有望打破。车联网的潜在能力,很有可能彻底释放出来。

- 首先,车辆数据联网,所有关于车的运行状态信息都会传到云端。围绕这些信息数据,是海量的应用场景。

- 例如,车没有油或者没有电了,云端会告知车主,哪里有加油站(充电桩)。车的某个零部件数据异常,云端会进行分析,然后告知可能存在的风险。不仅可以上传数据,还可以下载数据,交通导航、拥堵路况信息、车位数据、气象信息等,都可以下载到车里,影音娱乐更是小儿科。

在上面这些初级应用之上,在更加庞大的云计算能力和通信能力的支撑下,远程驾驶甚至是自动驾驶,终于变成了可能。

自动驾驶,可以说是车联网进化的终极形态。

自动驾驶

汽车,和各种交通基础设施(例如信号灯),全部接入网络,由强悍的云计算系统,分析整个城市的交通流量、拥堵状况,对所有道路车辆进行路径规划,辅以交通调度,就可以最大效率地提升城市的运力。同时,还会大幅降低交通事故的发生概率。阿里和腾讯都提出了“城市大脑”这个概念,其实就是在朝这个方向努力。

说白了,就是计算机的算力,代替人类的脑力。

此外,配合大数据和人工智能,对车主的驾驶习惯进行分析,对企业的物流需求进行分析,对城市车流的流向规律进行分析,可以挖掘的商业价值就更大了。

简而言之,我们不是为了联网而联网,联网是为了数据。有了车联网,就有了数据。有了数据,辅以强大的计算能力,就有了一切。

5G和车联网

那么,即将到来的5G,又和车联网有什么关系呢?

刚才我们说的LTE-V,仍然不够强大。刚才LTE-V和DSRC进行对比时,细心的同学会发现,有一项指标,LTE-V是不如DSRC的,那就是时延。时延在车联网里,就意味着生死。你看,现在高速公路的时速是120Km/h,也就是33米每秒。刹车哪怕是晚了1秒,也会有40米以上的制动距离。

所以,如果要支持远程驾驶或自动驾驶,这个网络的时延,必须是个位数的毫秒级(ms)。

- LTE做不到,但是5G作为LTE的演进,可以做到。5G的时延,可以达到1ms,足以满足要求。

- LTE会演进到5G,LTE-V,就随着演进为NR-V2X。

除了时延之外,5G还拥有很多LTE不具备的优点——它拥有更高的带宽,支持更大数量的连接,还支持更高的移动速度。

所以说,5G就是为物联网而生的

5G和车联网的关系,简单来说,就是相互依赖。没有5G,车联网就不是真正的车联网。没有车联网,5G就少了一个很重要的应用,也就少了投资来源,少了存在的必要性,价值也大打折扣。

目前看来,车联网是现在5G最重要的一个应用场景,也是最有可能引爆5G需求的场景。别的物联网需求,都无法形成车联网这样的规模和体量,也不会有车联网这么强大的推动力。甚至可以说,车联网就是未来五年5G兴衰的晴雨表。

智能座舱

【2022-5-29】造车,造爱与造人

车载语音助手

2016年,一位大哥第一次按下车里的“语音控制”按钮。他的诉求很简单,让汽车帮他打个电话。一阵甜美的AI女声响起,一段人类首次尝试驯服语音助手的珍贵对话由此展开。

- 甜美AI:请说出您要拨打的号码,或者说取消。大哥:135XXXX7557。

- 因为口音问题,系统未能识别准确。大哥急了,赶忙下达第二道语音指令:纠正!纠正!系统也急了:969696……

- 大哥更急了:纠正,纠正,不是96!

- 大哥:口吐芬芳。系统:对不起,我没有听清。

- 大哥带着哭腔:你耳朵聋,耳朵聋啊?我说了多少遍了我都。系统:请再说一次,请再说一次,请再说一次。

- 大哥:我再说最后一遍啊,135…… 系统:对不起,再见。

| 用户发言 | 系统(助手) | 情绪变化 |

|---|---|---|

| 启动助手 | 请说出您要拨打的号码,或者说取消。 | |

| 135XXXX7557 | 口音问题,系统未能识别准确 | |

| 纠正!纠正! | 969696…… | 用户着急了 |

| 纠正,纠正,不是96!口吐芬芳 | 对不起,我没有听清 | 发飙 |

| 你耳朵聋,耳朵聋啊?我说了多少遍了我都。 | 请再说一次,请再说一次,请再说一次。 | |

| 我再说最后一遍啊,135…… | 对不起,再见。 |

短短2分钟,浓缩了六年前车机语音识别真实的用户怨念,中国消费者对语音助手糟糕印象的种子就此埋下。语音助手“听不见”、“听不清”、“听不懂”灾难级的系统表现,让人和机器总得疯一个。

智能座舱诞生

好在,这一切都在2018年发生了改变。这一年,汽车座舱在造车新势力的推动下,进入智能2.0时代,语音助手的角色也从系统添头,变成智能座舱基石。

近5年来,人工智能、自动驾驶、语音识别、手势交互等研发成果逐步落地,特别是驾驶辅助功能的完善,让开车不再是辛苦的体力劳动。未来L4、L5级自动驾驶的实现,会彻底颠覆传统驾驶行为。人——这个驾驶行为最重要的主导者,也将会从枯燥重复的操作中解脱出来。汽车座舱的角色由此转变为休息、娱乐和放松的第三空间。

“第三空间”要求汽车公司从乘员的实际需求及应用场景角度出发,从头开始搭建一套全新的、智能程度更高的人机交互体系,让车内的每个人都能获得安全的驾驶行为和轻松的感官体验。

智能座舱的发展分为三个主要阶段:

- 第一,电子座舱,驾驶者可以在车内实现听歌、导航、打电话等基础型电子功能,但与座舱的互动接近于零;

- 第二,智能助理,车辆本身可以完成一定的驾驶行为,驾驶者开始以人脸识别、眼球追踪、语音手势控制等多种方式与座舱互动;

- 第三,移动空间,自动驾驶完成车辆控制,乘员沉浸式体验座舱场景。

中国造车新势力先后下场的2018年普遍被认为是智能座舱进入第二阶段的里程碑,这一阶段座舱硬件有两大标志性趋势:

- 第一,实体按键被大幅简化,直至消失;

- 第二,屏幕尺寸和数量迅速上升,直至铺满。

随着功能叠加,智能座舱系统的构成也从单一功能电气元件升级为一套庞杂电子设备系统,包括:车载信息娱乐系统、车联网系统、感知交互系统、空调系统、声光和气味系统等。

功能多了,车机界面自然就复杂了,以前只用旋钮调收音机和温度。现在新花样层出不穷。由于各大汽车公司对功能的认知和排序都有自己理解,导致驾驶者需要在驾驶过程中花费更多注意力去寻找和调节相应功能,危险出现的概率也就此提升。

汽车公司在架构智能座舱时,会围绕三大原则:安全、人性化和愉悦为展开,而这恰好是语音交互与生俱来的三大特性。从现有自动驾驶技术发展态势判断,“人机共驾”阶段的延续时间不会很短,语音交互可以让驾驶者在不失焦的情况下,完成车内大部分功能操作。在硬件和算法的迭代升级下,语音交互也在不停地自我升级。举两个例子:之前只能通过语音打开或关闭空调,现在可以精准调节温度,或者直接说“我冷了、热了”,让车辆自行调节;此前语音只能完成车窗玻璃升降,现在可以实现升三分之一,降三分之二这样颗粒度更细的控制。

从2021年开始,语音交互成为一个成熟智能座舱中,最具代表性的功能模块之一,消费者对语音交互的兴趣开始高涨,需求也开始多元。

想“只动口不动手”地控制座舱,车本身要“听得见、听得懂、做得到”,对应语音交互三个步骤:“识别、理解、执行”。

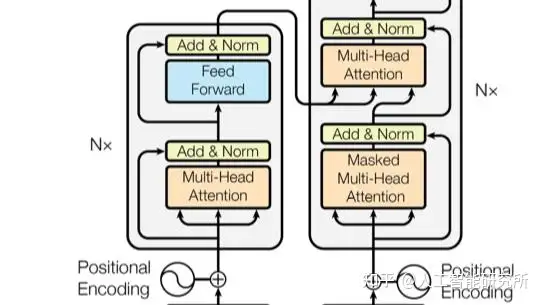

- 首先是

语音识别(Automatic Speech Recognition,ASR)。车内麦克风接受声音信号,转化为音频信号,经过解码、降噪、增强、特征提取、音素选取、再次解码后,最终落地为文字。高阶语音识别会对声源定位,这就是部分车辆支持副驾和后排用户语音控制的原理。 - 然后是

自然语言处理(Natural Language Processing,NLP)。文字被识别后,系统会拾取相应功能性词汇,生成摘要。比如驾驶者说“你好,我的爱车,今天好热,帮我把空调调到18度”。系统比照词库和深度学习筛选后,拾取出的摘要是“空调,18度”。 - 系统将识别后的摘要转换为命令规划,发送给相应车载控制单元,执行动作。

- 最后,

语音合成(Text to Speech,TTS)模块将动作执行完成的文本转换为语音播报反馈给驾驶者:“好的,空调已调至18度”。至此,一次语音交互完成闭环。

语音交互有三大技术难点:一是拾音准确,噪音消除;二是语音深度学习模型的训练数据;三是识别特征抽出模型的训练。

- 第一个比较好解决,用多个麦克风组成阵列加算法即可;

- 后面两个难度不大,但费钱又耗时,座舱语音交互要对齐不同车型不同车载环境表现,电动车和燃油车的车厢噪音水平不同,轿车、SUV和MPV的差别也不小,要针对性搜集整合数据。这个过程成本高,周期长,最终还有可能吃力不讨好。

语音交互做得够好,用户很快就会养成使用习惯。

- 中国乘用车智能语音交互功能的搭载率逐年攀升,从2019年的49.82%,到2021年的63.25%,再到2021年的86%。

- 中国的高频运用场景是:导航、播放音乐、空调和拨打电话。

对汽车公司来说,有两种实现语音交互的方式:

- 第一种硬件采购,软件自研,这样可以将主动权牢牢掌握在自己手里,实现灵活调整,高度定制,常用常新,提供科技感,是造车新势力常用的方式。

- 第二种是做“甩手掌柜”,让车机系统供应商全权负责,投入低,量产快,适配度高,出了问题还可以一键呼叫(甩锅)供应商,是传统汽车公司偏爱的路径。

在语音交互底层功能实现后,用户开始需求这些功能的情感价值,希望能和自己车上的语音助手建立一种柏拉图式的精神亲密关系。一些汽车公司的做法是将语音助手的机械化原声,更换为林志玲或郭德纲声线。这能给用户提供短暂的新鲜感,却很难走进用户心里。

用户与车载语音助手建立精神亲密的过程和电影《Her》中的情节很像:男主偶然接触到人工智能系统OS1,迷人甜美的声线,温顺体贴的性格,事事投缘的相处模式,颇具心思的生活情趣,让男主很快就陷入到人工智能的“赛博温柔乡”中不可自拔。简单来说,就是“呼应上了”。

“OS1”让人着迷的原因是,工程师揭掉了覆盖在人工智能表面冰冷的面纱,尝试赋予它人格,并以此为切口和用户建立信任通道,让人机对话变成从单向关系转换为双向关系。

《语音人机界面》一文里写过:

- 没有人格的语音用户界面是不存在的,如果你不给语音用户界面设定人格化特征,用户就会自行脑补。

- 所以更聪明的做法是,在设计的初期就确定好人格。

在设计语音交互体验时,工程师会考虑视觉形象和听觉形象两个方面,再将两者进行有机结合,向用户输出“语音助手”。

视觉形象大体分为三类:

- 第一,

具象型。一般是二维图形,颜色单一、动效朴素,声波图形 、麦克风是典型案例; - 第二,

抽象型。一般是三维不规则形状、色彩多样、光效炫酷,如宝马iDrive 8.0系统里会呼吸的流光球体; - 第三,

拟人型。企业IP明显、动效丰富、活泼生动,如小鹏语音助手,一汽奔腾全息投影百变娇娃。

一汽奔腾的全息影像

这些语音助手执行起“功能”来没问题,遗憾的是,对用户言听计从的它们没有“人格”,用户只把它们当工具,鲜少把它们视为伙伴。人机之间信任感的建立,本质上不是技术问题,是社会学问题。这时,就要请社会学专业出身的李斌上场了。

2017年,蔚来发布第一台量产车型ES8,座舱正中央处有一个圆头圆脑的装置,李斌给它起了个名字——NOMI,取英文“Know Me”的谐音。李斌给它下了个定义——全球首个量产车载人工智能系统。

除基础语音助手功能外,NOMI还能做三件事:

- 第一,循语音来源转动方向;

- 第二,根据使用场景展示对应表情;

- 第三,实时监测车内状况,识别驾驶者疲劳程度。

相较以车内大屏为载体的语音助手,NOMI的做法更具象化。除对话外,你还可以摸摸它(不要硬掰),拍拍它(不要太用力),吹吹它(不要喷口水)。实体化做法的好处是让用户清晰地感知到语音助手的生命能量和情感能力。

批量交付后,NOMI很快成为许多车主言之必谈的对象和拿来炫耀的资本。比如一位蔚来车主在APP上表示,“没NOMI,ES8就是台电动车,有NOMI,两儿子整天挂嘴上的就是我家有辆NOMI车”。许多蔚来车主认为,没有NOMI的蔚来缺少灵魂。用户有多喜欢NOMI呢,喜欢到为这个人工圆球设计各种帽子:棒球帽、绒线帽、牛仔帽、水手帽、睡帽……

NOMI比其它语音助手更能打动用户的原因是,它把自己活成了人样,模糊了与人工智能与人类用户的边界。从一定程度上,NOMI完整表达了陀思妥耶夫斯基的理念:“要爱具体的人,不要爱抽象的人”。

基于实体,NOMI可利用的表达途径有表情、声音和动作,能做的事情比虚拟动画多得多。

- 比如用户伸手点击屏幕时,NOMI会稍微低头,展现自己的“八卦属性”。

- 用户把手收回,NOM会抬头恢复原状。

- NOMI内装的700多个动态表情,会根据当前心情和正在进行的任务进行实时呈现,大晴天会戴墨镜,雾霾会戴口罩,下雨天会撑伞,放音乐时会跟着打拍子。

除动作回应外,NOMI有些时候还能做车主的“人生导师”,展现一丝人文主义光辉。比如有用户问“活着的意义是什么”,NOMI回答“不要对生活失去信心呀,说不定下一秒会有有趣的事情发生呢”,有赛博哲学家那味儿了。

- 针对这一问题,大部分语音助手的回答可能是

- “这个问题我暂时理解不了呢,你可以尝试其它语音指令”

- “请问你是不是要购买《活着》这本书,我可以为你下单呢”。

相较而言,NOMI确实做了个人。

“NOMI之父”李天舒分享过一个开发细节:NOMI做的第一件事不是完成复杂的自然语言交互和多轮对话,而是当车主打开车门的那一刻,NOMI可以把车当成是自己的肌体一样,感受到有人进入车内了,然后它把头扭向有人开门的方向,和用户打个招呼。

这些精妙且具象的互动细节,拼凑出一个机灵、俏皮、细致、懂事、有情趣的NOMI。而不是一个停留在屏幕上,千人一面的抽象语音包。

- 从人性角度出发,语音是最简单、自然的交互方式,也是人类最基本的沟通方式。

- 从行车安全角度出发,语音交互不需要注意力转移,是毋庸置疑的车载第一交互方式,本身就是刚需。

用户将语音交互误解为“伪需求”,是因为大部分汽车公司没有在语音交互场景中,制造出足够显著的体验差。除了常用的电话和导航,其它功能体验很差,用户懒得去了解。

举个例子,用户开车时说“我想听《本草纲目》”,这是个很简单的需求链路,但车机上常出现的场景是:系统内置音乐软件内没有周杰伦歌曲版权,要么无法播放,要么播放翻唱版或剪辑片段。在线搜索出的音乐平台有版权可播放,但用户未登录或未购买平台付费会员,只能忍受低廉的音质和试听部分。几次经历后,大部分用户都会扭头走开,宣传中的“智能语音”,用起来却是“智障语音”,还不如手机连蓝牙。

蔚来的老道之处在于,让NOMI的情感入口能效高于功能入口。用户使用其它语音助手是“对事不对人”,使用NOMI是“对人不对事”。毕竟这么可爱的一个小家伙,偶尔犯点小迷糊,怎么舍得对它发脾气,就算要发脾气,还得考虑后排大宝和二宝的感受呢。

解决语音助手的鸡肋困境,可以从两个方面入手:

- 第一,从驾驶场景实际需求出发,对语音助手进行适配化改造,比如最新的语音助手,车主在车外说一句“开出来”,车辆就会从停车位上自动向前驶出,解决停车、挪车、开门场景痛点;

- 第二,提升语音助手自我成长的能力,通过积累为用户制定最优策略,比如用户偏爱麻辣口味,语音助手在推荐附近餐厅时会提升川菜、湘菜、火锅、串串的优先级,以人文主义手段拉近用户距离。

安全

汽车攻击

【2024-9-6】360 周鸿祎演示电动汽车被攻击示例

- 无需接触汽车,不用知晓汽车品牌,盖上帆布,也能实现攻击

- 打开前大灯、摇下车窗,甚至行驶过程中断电

【2023-10-20】万字长文:智能汽车十大网络安全攻击场景

随着软件定义汽车时代的到来,汽车网络安全攻击面变得非常广泛,主要分布在10个主要模块,也被称为十大易受攻击威胁模块。

- 信息娱乐系统(IVI)、车载网联通讯终端(T-BOX)、车载网关(Gateway)、统一诊断服务(Unified Diagnostic Services,UDS)、车载诊断(On-board diagnostics,OBD)、高级辅助驾驶系统(ADAS)、车载信息服务(TSP)、充电网络系统(Charging System)、汽车远程升级(Over-The-Air,OTA)以及手机端车联网应用程序(App)

- img

图见原文

场景1:车载信息娱乐系统

车载信息娱乐系统(In-Vehicle Infotainment,IVI)指结合了向用户提供娱乐信息的车载系统。

- IVI系统使用音频/视频(A/V)接口、触摸屏、键盘和其他类型的设备来提供这些服务。

- 车载信息娱乐系统通常具备一部分CAN总线操控能力,因此通过攻击车载信息娱乐系统可能会导致远程控制车辆。

2018年,Computest 研究人员Thijs Alkemade和Daan Keuper发现了某汽车品牌的IVI漏洞。在某些情况下,该漏洞可能允许黑客控制关键功能,这些功能包括打开和关闭汽车的麦克风,使用麦克风来收听驾驶员的谈话,以及获得对谈话历史和汽车通讯录的访问权限。最重要的是,研究人员表示,攻击者还可以通过其导航系统跟踪汽车。

IVI系统是最容易遭受到攻击的模块,一般IVI系统采用安卓系统,因此安卓系统的安全风险,在IVI上可能都会出现,如图2所示,这是IVI主要攻击面(非详尽)。

场景2:车载网联通讯终端

车载网联通讯终端,即T-BOX,对内与车载CAN总线相连,对外通过云平台与手机端实现互联,是车内外信息交互的纽带,实现指令和信息的传递。T-BOX的结构简单示意如图所示。

为了研究方便,一般会从车上把T-BOX拆下来,这就需要知道T-BOX在车上的位置。T-Box的安装位置因制造商而异,但一般的T-Box安装位置在仪表板内侧、油门踏板旁边、主/副驾驶座椅下方、汽车中控台内侧、手套箱内部,齿轮盖内部等。如图4所示,这是T-Box在主/副驾驶座椅下方的安装位置。

由于T-Box的安装位置不固定,拆卸应由专业修车的人员负责,所以搞汽车网络安全的团队最好有懂修车的,例如基于S32K148的T-BOX开发板如图5所示。

T-BOX作为车辆中的接入点,是车内最核心的模块。T-BOX常见功能包括远程控制、远程诊断、OTA、高精定位、近场控制、V2X等,T-BOX系统一般采用Linux系统,因此Linux系统的安全风险,T-BOX都具备,以下是T-BOX主要攻击面(非详尽)。

- 远程通讯:中间人攻击、数据监听、篡改、否认

- 中程通讯:中间人攻击、数据监听、篡改、否认(包括蓝牙、Wi-Fi)

- CAN通讯:数据监听、篡改、否认

-

I2C/SPI/UART等串型总线数据监听

- 隐私风险: 私钥提取、日志泄漏、定位数据等敏感信息泄漏

- 系统风险: 提权、反弹Shell、缓冲区溢出等

- 固件风险: 固件提取、固件逆向、固件篡改等

场景3:车载网关

汽车网关是一个中央枢纽,可在车辆中的许多不同网络之间安全可靠地互连和传输数据,汽车网关的核心功能是在车内安全可靠地传输数据,车辆中可能存在多个网关,它们可以是集中式网关和多个域网关。集中式网关在远程信息处理控制单元(TCU)、动力总成、车身、信息娱乐系统、智能座舱和高级辅助驾驶应用程序等域之间安全可靠地传输数据。域网关(或域控制器)具有类似的功能,实现各自域内ECU的相互通信。与域网关相比,集中式网关通常需要更高的处理性能、接口和更高带宽的网络协议。图6说明了如何在车辆中实现这两种类型的网关。

网关作为汽车网络系统的核心控制装置,主要功能是在车载网络和各种电子控制单元之间提供无缝通信,通过不同网络间的物理隔离和不同通信协议间的转换,在各个共享通信数据的功能域(动力总成域、底盘和安全域、车身控制域、信息娱乐域、远程信息处理域、ADAS域)之间进行信息交互。表2提供了网关关键功能的摘要(非详尽列表)。

网关功能

- 协议转换: 将数据和控制信息转换为不兼容的网络,以实现它们之间的通信

- 数据路由: 在节点上路由数据以到达其预期目的地,它可能位于需要协议转换的不同网络上

- 诊断路由: 外部诊断设备和ECU之间的诊断消息路由,可能涉及DolP和ECU等诊断协议之间的转换

- 防火墙: 基于规则过滤入站和出站网络流量,禁止来自未经授权的源的数据传输,高级防火墙可能包括上下文感知过滤

- 消息镜像: 从接收到的接口捕获数据,以通过另一接口传输,用于诊断或数据记录(存储)

- 入侵检测: 监控网络流量是否存在可能表示入侵的异常

- 网络管理: 管理网络和连接到网络的ECU的状态和配置,并支持诊断

- 密钥管理: 安全处理和存储网络密钥和证书 OTA管理 管理车辆内通过网关访问的ECU,远程OTA固件更新 网关也是智能汽车最可能成为网络攻击的目标,网关一般是RTOS系统,能够弄清楚他的指令集是关键,网关的主要攻击面(非详尽),如表3所示。

表3 网关的攻击面

| 攻击入口 | 攻击位置 | 攻击结果 |

|---|---|---|

| OBD-II | 内部 | CAN总线注入 访问权限 控制制动器 警示灯和安全气囊 |

| USB | 内部 | USB升级 ADB调试接口 |

| 蓝牙 | 外部 | 车辆钥匙 车辆启动 |

| Wi-Fi | 外部 | 未授权访问 注入CAN信息 |

| 传感器 | 内部 | 激光雷达干扰 摄像头欺骗 TPSM欺骗 |

| OTA升级 | 内部 | 签名绕过 |

场景4:汽车远程升级

汽车远程升级(Over the Air Technology,OTA)是指替代本地连接方式,通过无线传输方式进行软件下载和软件更新的过程,更新的速度和安全性至关重要。OTA是实现软件定义汽车的必备基础,是智能网联汽车系统及其应用的唯一远程升级通道。作为安全的最后一道防线,OTA常见类型包括SOTA、FOTA,实现对动力域、底盘域、辅助驾驶域、信息娱乐域和车身域在内的重大功能更新。

- FOTA:Firmware OTA,固件升级,面向车端上的固件升级

- SOTA:Software OTA,应用软件升级,面向车载端上应用软件升级。

通过OTA能够为车端添加新功能、修复漏洞等,传统更新汽车软件的做法是到4S店通过UDS对相应的ECU进行软件升级,通过USB等接口对信息娱乐系统进行升级。伴随着智能汽车的发展,本地升级已不再适应高速变化的车载生态,OTA流程如图7所示。

OTA主要分为云端和车端,云端包括SBOM管理、任务调度、打包升级、软件分发、升级审批、升级通知、升级日志、升级包上传、版本控制、升级监控与统计等。车端包括定时检查更新、手动检查更新、安全下载、断点续传、订阅升级消息、升级包签名验证、ECU刷写、升级日志上报等。可以看出OTA的难点在于保证安全和传输效率,以下是OTA攻击面,如图8所示。

场景5:车载信息服务

车载信息服务(TelematicsServiceProvider,TSP)在车联网系统中以云的形式向用户侧与车辆侧提供以下服务:用户信息维护、车辆定位、状态监控等。TSP功能如图9所示。

TSP是重要的车联网云服务,一般云服务存在的安全风险,TSP同样存在,可以参考OWASP Top 10。云端主要靠提供应用程序编程接口(API)与其他端进行通信,API位于应用程序之间或者充当处理系统之间数据传输的中间层,它提供了一个简单而高效的接口,用于扩展功能和改善联网汽车体验。API安全不是汽车网络安全独有的,更多API安全可以参考OWASP API安全十大漏洞,如表4所示。

OWASP API安全十大漏洞

- API 1:损坏的对象级授权

- API 6:批量分配

- API 2:认证失败

- API 7:安全配置错误

- API 3:过度数据暴露

- API 8:注入

- API 4:缺乏资源和速率限制

- API 9:资产管理不当

- API 5:损坏的功能级别身份验证

- API 10:记录和监控不足

场景6:车载诊断

车载诊断(On-Board Diagnostics,OBD)系统是一台计算机,负责通过一系列传感器监控汽车的状态,在典型的乘用车中,可以在汽车驾驶员侧的仪表板下方找到OBD-II端口,根据车辆类型,端口可能具有16针、6针或9针,如图10所示。

OBD包含OBD-I和OBD-II,OBD-I是自1991年起适用于为加利福尼亚制造的车辆的车载诊断标准,以控制该州的车辆排放,所有在该地区销售的汽车都必须配备OBD-I以检测发动机问题并报告故障代码。OBD-II于1996年成为美国的全国标准,并沿用至今。与OBD-I不同,配备OBD-II的汽车都支持相同类型的扫描仪,故障代码本身也已标准化,尽管制造商会定制一些额外的特定信息。随着汽车计算机变得越来越复杂,汽车制造商也为其汽车的OBD-II系统添加了越来越多的功能,可以使用OBD-II扫描仪查看实时诊断数据、连接汽车计算机等,如图11所示,通过OBD-II不仅可以实现为外部测试工具(OFF Board)提供诊断服务,还可以实现车辆在运行过程中的自我诊断。

从OBD-I到OBD-II,最显著的改进是所有OBD-II汽车都有相同类型的端口,以相同的方式发送相同类型的数据。换句话说,可以购买一台OBD-II扫描仪,并从任何制造商生产的任何汽车中获取有用的信息。

OBD-II包括一系列标准化的故障诊断代码,即DTC。DTC是当OBD-II系统指示故障时由动力总成控制模块(PCM)生成和存储的代码。简而言之,当您的汽车系统诊断出问题时,它会发送一个代码来指示具体故障。根据汽车工程师协会(SAE)发布的故障手册,就可以通过DTC代码查看问题出在哪里,同时有许多工具可用于插入OBD-II连接器并访问DTC,如图12所示。

现在的远程诊断功能也可以基于OBD-II的诊断数据,如发动机转数、车速、故障代码等信息,然后通过T-BOX等远程信息处理设备将这些数据上传到云端,再使用这些信息来对车辆进行监控和远程诊断。前面也提到了2021年OBD-II接口攻击占比5.4%,OBD-II的攻击路径如图13所示,后续会深入介绍。

场景7:统一诊断服务

今天行驶在路上的汽车包含多达几百个ECU,每个都执行特定的功能,这增加了系统的复杂性,需要更有效的方法在发生故障时测试和诊断车辆系统。统一诊断服务(Unified diagnostic services,UDS)与OBD最大的区别就在于“统一”,具体来说,它是面向整车所有UDS的,而OBD是面向排放系统诊断系统的。随着时间的推移,已经开发了许多诊断协议,例如KWP 2000、ISO 15765和K-Line,用于车辆诊断。因此,为确保通用兼容性,原始设备制造商和供应商同意依赖名为统一诊断服务协议的标准协议。UDS用于诊断全球车辆的最新汽车车辆诊断协议,UDS协议遵从ISO-14229标准。

UDS不仅应用于远程诊断,还可以应用ECU刷写,这在OTA升级非智能ECU时经常使用。UDS刷写也就是通过UDS将服务实现软件ECU放在非易失性存储器中,ECU包含启动管理器(Boot Manager)、应用软件(Application Software)、重新编程软件(Reprogramming Software),可以参考ISO 14229-1给出的ECU刷写执行流程如图14所示。

OTA的快速发展,对ECU刷写提出了更高的要求,要能适应各种极端情况,因此安全性会更加重要,如果安全措施不到位,ECU将会遭受攻击,例如欺骗攻击、密码暴力破解、会话劫持、中间人攻击以及权限提升等。

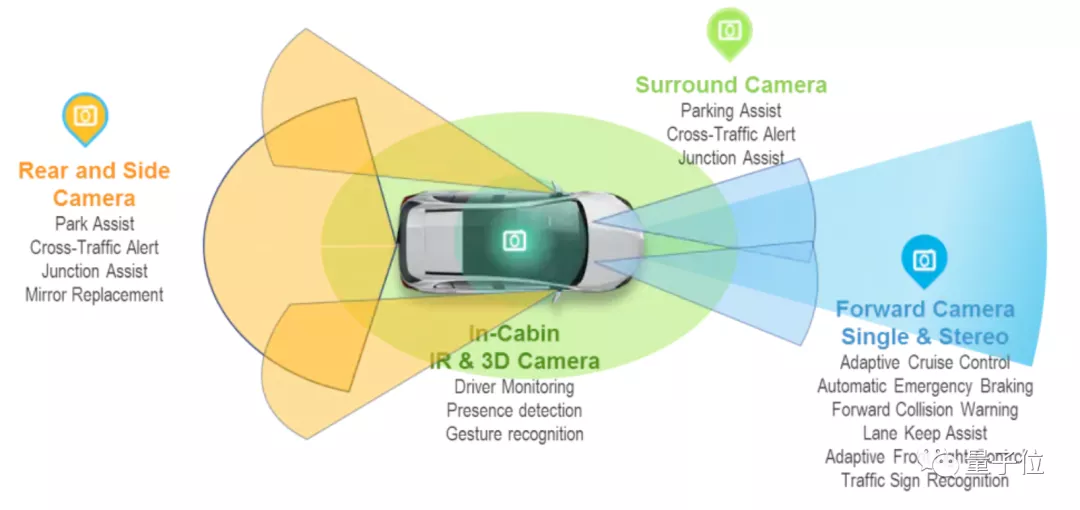

场景8:高级辅助驾驶系统 安全性是高级辅助驾驶系统(ADAS)和自动驾驶系统(ADS)的关键设计目标,本书讨论的范围仅限于ADAS,ADAS的开发人员需要确保他们已经考虑和分析了问题的所有方面,并且提供可衡量的证据来证明他们的功能是安全的,而即将出台的标准和法规没有描述任何特定的方法。由于ADAS暴露出巨大的攻击面,因此网络安全漏洞可能会造成毁灭性的后果,汽车网络安全不仅是一项关键要求,还是ADAS和ADS的关键先决条件,通用ADAS的分层架构如图15所示。

确保ADAS和ADS的网络安全是一项具有挑战性的任务,因为任何无线接口都可能成为潜在的攻击媒介。ADAS基于复杂的硬件和软件的混合,通常集成了车辆与V2X通信。高级驾驶辅助系统和自动驾驶汽车部署了各种传感器,如超声波、雷达、摄像头和激光雷达等。比如,摄像头传感器应用了许多图像分析、传感器融合、感知的算法,而尤其是那些基于神经网络、深度学习系统的算法,很容易受到网络攻击。ADAS攻击面如图16所示。

场景9:充电网络系统

里程焦虑是现在购买电动车的用户最大的顾虑,也是电动汽车行业要重点解决的问题。随着充电站市场的发展,不同公司专注于充电生态系统的特定领域,充电生态系统如图17所示。

充电生态系统由这些部分组成:汽车制造商(OEM)、电动汽车(EV)、电动汽车充电桩(EVCS)、充电点运营商(CPO)、电动汽车服务提供商(eMSP)。

为了更好地了解充电系统安全,我们必须要先了解充电相关的技术,图18可以让我们更直观地感受电流如何在电动汽车中进行转换。

图18 电动汽车中电流转换的简化框图(图片来源:Keysight E-Mobility Design and Test Technologies)

要搞清楚上图的原理,可能需要明白以下问题,这些部分将在本书中详细介绍。

- 充电电流如何输送到电动汽车?

- 充电过程如何控制?

- 充电站如何通信及其通信协议?

- 如何进行接线和安装?

充电设备通常通过云平台和移动应用程序进行控制,因此具有可远程访问且易受攻击的API。Upstream对2022年初以来100多起公开报道的汽车网络相关事件的分析中得出结论,电动汽车充电被确定为头号新兴攻击媒介。这些安全漏洞可能会影响电动汽车充电网络的所有组成部分,根据上述漏洞,总结电动汽车充电设备的安全风险分类如下。

- 身份伪造

- 植入木马

- 固件更新

- 固件劫持

- 重放攻击

- 移动应用

- 物理接入

- 协议安全

场景10:手机端车联网应用程序

前面已经描述了手机App操纵汽车的过程,目前多数车联网汽车厂商会向车主提供车联网移动应用程序,使用移动应用程序可以通过Wi-Fi、蓝牙、蜂窝网络控制车门开关、调节车窗等,移动应用程序的使用场景如图19所示,可以通过手机App查询车辆的实时位置以及历史轨迹等。

手机App本身的安全问题不仅在车联网中存在,而且车联网场景下允许通过手机控制车辆,这样会将安全危害放大,必须要重视起来。以下是手机端车联网应用程序攻击面。

- 数据泄露

- 蓝牙钥匙

- 不安全的Wi-Fi

- 网络钓鱼攻击

- 恶意软件

- 逆向伪造应用程序

- 会话处理不当

从上述可以看到汽车网络安全涉及Web安全、协议安全、无线安全、内核安全、移动端安全、固件安全、硬件安全等,任何一方都可能会是薄弱点,所以保护汽车网络安全更重要的是将安全基础打牢,避免出现安全短板。随着汽车行业创新的加速,智能汽车正在转向自动驾驶,新技术正在为扩大攻击面铺平道路,这是一个日益受到关注的问题。朝着该目标的每一次新进展,都可能会引入一个新的攻击面,需要持续的安全投入。

自动驾驶

自动驾驶产业链

无人驾驶介绍

自动驾驶的实现路径可分为渐进式和跨越式。

- 前者以特斯拉、蔚小理等造车新势力以及相关供应商为代表,从 L1、L2、L3 逐步演进到 L4,主要针对私家车市场;

- 后者以 Waymo、百度小马等玩家为代表,直接从 0 到 L4,主要针对智慧出行服务领域。 遗憾的是,无论是上述何种形式,商业化变现之路依然充满着谜团。

【2021-6-25】关于「无人驾驶」,一位投资大佬给出了四大预判

- 预判 1:开放高速载人落地仍需等待 10 年以上

- 目前,自动驾驶在封闭低速场景的应用主要集中在矿山、港口、末端配送等三个领域。

- ①相对而言,矿山的整体落地环境最为友好。矿山多在偏远地区且人烟稀少,相对简单的运营环境对自动驾驶技术容错率较高,无人矿卡在此拥有更多路权,运营商可根据需求自行规划行驶路线。相关数据显示:国内矿山自动驾驶市场规模超千亿,露天煤矿的土石方运输是最适于自动驾驶推广应用的场景,其市场空间超过450亿元/年。踏歌智行、慧拓智能、易控智驾、希迪智驾、跃薪智能等自动驾驶公司齐聚于此。辰韬资本预计,国内无人矿卡将在2022-2023年将开始实现商业化应用。

- ②港口方面,由于其道路结构化程度较高,运营环境相对简单,因此自动驾驶卡车的港口路权相对较多,这也为自动驾驶商业化运营带来可能。过去几年,斯年智驾、西井科技、飞步科技等自动驾驶公司将目光聚焦此处,其中,斯年智驾近期拿下全球首个港口无人驾驶商业化付费订单。在开放道路中,根据道路环境的不同可分为Robotaxi和干线物流。

- 总结:封闭低速载物场景需要 2-3 年才可以落地,高速载物场景需要 5-8 年,而开放高速载人需要 10 年以上。

- 预判 2:无人配送批量应用将在未来三年爆发

- 去年12月24日,提供末端无人配送服务公司Nuro获得加州第一张商业运营牌照,成为全球首家商业化运营的无人驾驶公司。获得商业运营牌照后,Nuro获准在加州圣马特奥县和圣克拉拉县开启商业化运营,日常配送食品、饮料、药品和其他产品。商超零售场景与无人配送最为匹配。目前,国内典型无人配送共有三大场景:快递、外卖与商超零售。

- 快递的即时性要求不高,等待时间较长但数量很大;

- 外卖的即时性要求高,等待时间短,但环境很复杂。另外,并非每个商家都配套停车设施,因此取件和配件存在不确定性。

- 而商超零售的即时性要求比外卖低,配送路线更固定,同时商超零售的线上业务已有成熟的仓库和配送人员,配送的基础设施更为齐全。

- 国内无人配送企业主要分为三类:

- 互联网科技公司,如阿里、京东、美团等;

- 初创公司,如白犀牛、新石器、一清创新等;

- 主机厂及Tier 1背书的公司,如毫末智行、东风悦享。

- 辰韬资本发布的《末端无人配送赛道研究报告》认为,城市配送”最后一公里”,是物流配送业成本最高的环节。因车型、传感器方案等成本不同,无人配送车的整车成本在20万至50万元不等。再算入保险、车辆运维、现场安全运维、后台远程监控/操作人员费用、云平台服务费用等成本,无人配送车的成本将进一步增加。

- 无人配送批量应用将在未来三年迎来爆发。

- 首先,随着未来三年无人配送车批量生产,其整车成本将降低至10万元以内。无人配送车的技术迭代也将取消车辆运维、现场安全运维、后台远程监控/操作人员等费用,成本将大大降低。

- 其次,无人配送市场规模达千亿级,美团、京东、阿里巴巴等互联网科技公司已经将无人配送车实际应用。如阿里巴巴在全国数十家高校投放小蛮驴,为师生配送快递包裹;京东、美团多次在疫情期间为医院、社区运输医疗生活物资。而当前各公司逐步在多种场景开启无人配送,或可视作无人配送在批量应用的前夜。

- 第三,随着过去几年企业在无人配送业的多种尝试,其商业模式已初步成型,技术也可支撑部分场景需求。尽管国外的无人配送车已先行落地,但贺雄松认为国内的无人配送行业或将更容易实现盈亏平衡。

- 预判 3 :激光雷达的竞争是半固态的竞争

- 激光雷达本质上并不存在技术方案的路线之争,不同的技术路线满足不同阶段的市场需求。当前纯固态激光雷达主要分为flash 和 OPA 方案,后者在国际上的发展已基本停滞。在众多企业的研发下,flash 方案的探测距离已提升至 100 米,但这仍不适用于对探测距离要求数百米的高速公路场景。纯固态激光雷达的探索范围是否能更远仍然未知,一昧押注纯固态激光雷达或将面临风险。据中金研究预测,纯固态激光雷达方案距离技术成熟以及大规模量产仍需要5年以上时间。半固态激光雷达目前已经搭载于量产车型之中,在中短期内或将成为市场的主流选择。

- 头部公司在半固态激光雷达的各个技术路线都有研发,头部公司也将拥有更多的生存机会。此前, 车规级激光雷达主要面向自动驾驶汽车。自今年起,车规级激光雷达开始前装于乘用车,一个前装市场正在缓缓打开。蔚来ET7、智己汽车、上汽MARVEL R、上汽R汽车ES33、小鹏P5、极狐阿尔法 S 华为HI版等具备一定自动驾驶功能的智能汽车面世,正式开启激光雷达前装量产元年。

- 随着智能汽车的自动驾驶等级提高,激光雷达在传感器中的作用也将从辅助走向主导。咨询机构Yole的一项数据显示:2020年全球大约有20万颗激光雷达用于智能驾驶,相关销售额大约为9500万美元;至2025年,全球有望340万颗激光雷达用于智能驾驶,相关销售额大约为15.35亿美元。

- 预判 4:造车新势力目前无法达到L3级自动驾驶

- 特斯拉、小鹏、蔚来、理想目前都只是辅助驾驶,离L3级自动驾驶仍有一定距离。根据今年4月SAE联合ISO合作发布的最新版本的分级标准定义,SAE L1-L2级被命名为驾驶员支持系统(Driver Support Systems),SAE L3-L5级所用术语为自动驾驶系统(Automated Driving Systems)。L3和L4自动驾驶功能可以在系统运转时监视和强制执行其ODD限制,并防止使用或操作超出其规定的ODD,即运行设计域(Operational Design Domain),随着自动驾驶级别的提高, ODD也将适应更多的道路及环境。如果在不符合ODD的条件下运行,则必须由驾驶员接管。

- 小鹏在宣传NGP辅助驾驶功能时经常强调其属于”辅助驾驶”范畴,绝非”替代”用户。目前,国内三大造车新势力已构建各自的壁垒:如蔚来的品牌塑造,小鹏的自研算法,理想的产品定义等。

- 造车新势力也面临着不同挑战。如蔚来针对大城市的停车位较少,难以安装充电桩这一情况推出车电分离模式,受到用户的欢迎。但假如以后的快充技术超预期发展,长时间充电将不再困扰用户,或将对蔚来的换电模式产生影响。

- 各造车新势力之间的算法发展情况不尽相同,算法成熟的公司较少。此时为算法定制芯片意义不大。曾有消息传出特斯拉或将加入激光雷达阵营,在贺雄松看来这对于特斯拉的益处较少。

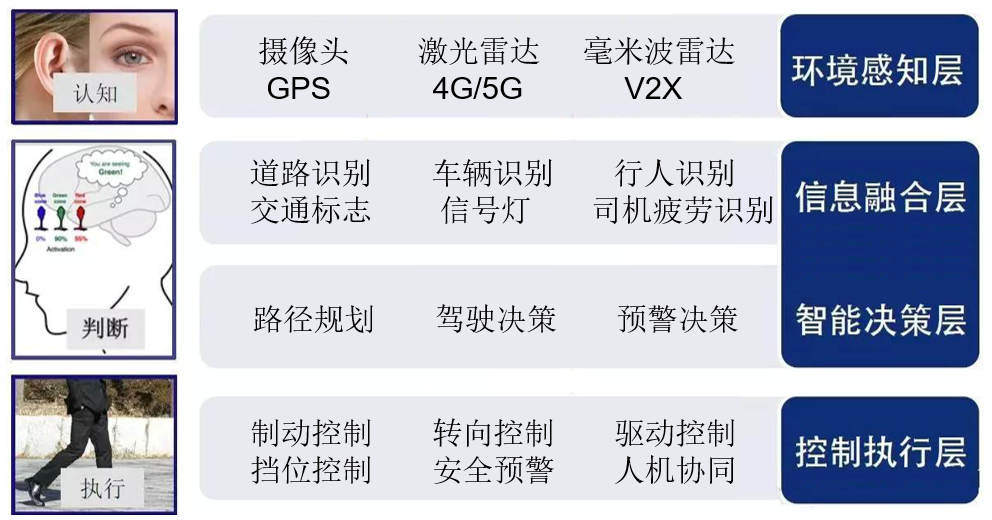

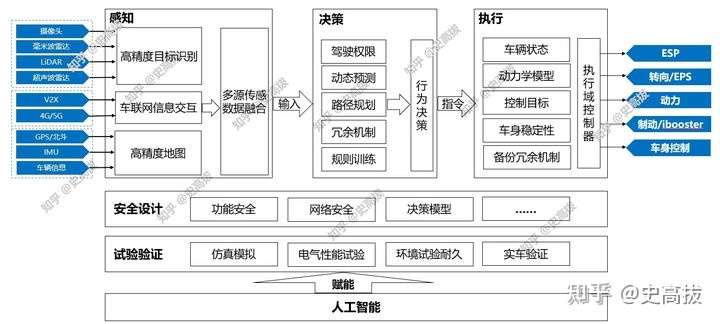

自动驾驶核心

【2022-7-25】知乎专题:自动驾驶的核心是什么; 自动驾驶分为感知、决策和执行三个部分

- 自动驾驶评测体系,对Model 3、小鹏P7、蔚来ES6的自动驾驶功能进行了完整的测试。其中一项是对雪糕筒的识别和反馈

- 视频见原贴

三台车在同样的路段冲向同样的桩桶 ,结果却截然不同:

- 小鹏:直接冲过去。

- 特斯拉:变道躲避。

- 蔚来:提示驾驶员接管车辆,自动刹车,同时打开双闪。

当时我们测试的车辆速度是40-50km/h,理论上来说,以三台车当前的硬件能力,不可能识别不到前方桩桶,最终不同的表现其实代表的就是三台车不同的决策逻辑,内心独白:

- 小鹏P7:前方有桩桶?这是施工路段呐,理论上这属于驾驶员自己接管的范围,主动介入有可能造成危险,万一出了事责任也很难划分清楚吧?算了,还是维持当前操作!

- 特斯拉:前方有障碍物?哈哈,大显身手的机会来了!看我的,变道避障!

- 蔚来:前方有障碍物?可能有危险吧?不行不行,赶紧刹车降速,同步告知驾驶员和周围车辆,小心!有危险啊!

针对以上三台车的表现,肯定会有人觉得特斯拉“太激进”,或者P7“太保守”,当然这不是本次回答的重点,以后有机会再深入交流。

回到题目:“自动驾驶最核心的技术是什么”。我认为是决策能力。

- 过去几年由于视觉感知的不稳定,自动驾驶的发展收到了极大的制约,因此很多人都认为环境感知才是自动驾驶技术的核心。但随着环境感知的硬件越来越好,底层控制系统越来越精准,智能决策的重要性越来越关键。

- 如果自动驾驶类比人开车,那么感知就类似于人的眼耳,获取汽车周边的环境信息,而手脚则是偏执行层的控制。那么自动驾驶的核心就应该更偏向脑部的功能——决策。

随着激光雷达的应用、其他传感器能力的加强,车辆能“感知”到的信息一定会越来越丰富,但我觉得这并不一定代表着自动驾驶能力一定会加强。之前做市场调研,刚接触到“大数据”的时候特别兴奋,我们能拿到运营商和银联的数据,而且能够打通(当时管控还没那么严),这意味着几乎所有的消费者网络行为和消费行为都是能获取的,本以为就此拥有了“王炸”的调研资源,但是,实际做出来的分析报告却并不理想。后来慢慢明白了,大数据,能用好才是宝矿,用不好就是一堆垃圾。

大家基本都在说算法,决策、感知的算法。提一个不一样的角度,我觉得现阶段的核心技术是自动驾驶企业掌握的cornor case,或者说fail case;即在开发、测试、应用自动驾驶的过程中积累的各种各样的极端案例、失败案例。

全自动无人驾驶还有多远

自动驾驶等级表

2013年,美国国家公路交通安全管理局(NHTSA, 制定各种监管和标准)发布了汽车自动化的五级标准,以应对汽车主动安全技术的爆发增长。先看NHTSA下的定义:

- Level 0:无自动化,驾驶员需要负责启动、制动、操作和观察道路状况。任何驾驶辅助技术,只要仍需要人控制汽车,都属于Level 0. 所以现有的前向碰撞预警,车道偏离预警以及自动雨刷和自动前灯控制,虽然有一定的智能化,都仍属于Level 0.

- Level 1:单一功能级的自动化,驾驶员仍然对行车安全负责,但某些功能已经自动进行,比如常见的自适应巡航(Adaptive Cruise Control, ACC),应急刹车辅助(Emergency Brake Assist, EBA),车道保持(Lane-Keep Support,LKS)。特点是Level 1只有单一功能,驾驶员无法做到手和脚同时不操控。

- Level 2: 多功能级的自动化,驾驶员在某些预设环境下可以不操作汽车,即手脚同时离开控制,但驾驶员仍然需要对驾驶安全负责,并随时准备在短时间里接管汽车驾驶权。比如结合了ACC和LKS形成的跟车功能。Level 2的核心不在于要有两个以上的功能,而在于驾驶员可以不再作为主要操作者。两周前Tesla新推送的autopilot也是Level 2的功能。

- Level 3: 有限的自动驾驶,在预设的路段(如高速和人流较少的城市路段),汽车自动驾驶并承担架势安全的责任,驾驶员仍需要在某些时候接管汽车,但有足够的预警时间,如即将进入修路的路段(Road work ahead)。Level 3将解放驾驶员,即对行车安全不再负责,不必监视道路状况。

- Level 4: 全自动驾驶,不再有驾驶员,仅需起点和重点信息,汽车将在全程负责行车安全,并完全不依赖驾驶员干涉。行车时可以没有人乘坐(如空车货运)。

当前,自动驾驶处于L3水平,需要驾驶员监督。达到L5水平时,驾驶员可以全程睡大觉。特斯拉的时间表是2019年达到L5。全球主流的汽车巨头,其时间表普遍在2020年或2021年。百度的计划也非常相近。可以确定地说,全自动无人驾驶已经近在咫尺。

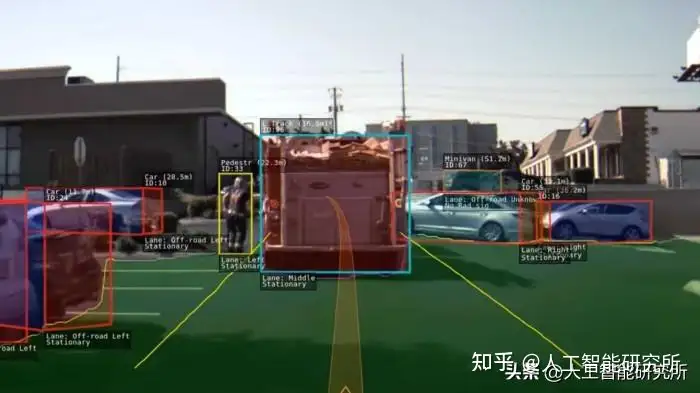

让我们提前感受一下无人驾驶时,人工智能眼中的世界吧。

眼观六路

汽车的眼睛:以特斯拉为例,包括8个摄像头,12个声呐,1个前置雷达。具有360度视角,在夜晚,雾霾,暴雨时保持良好视力。其雷达甚至可以探测到前面车辆之前的车辆。

从”眼睛”这个角度来看,自动驾驶的眼睛是完爆人类的。即使当前还有缺陷,也可以很快进化。

人出生时就是睁眼瞎

眼睛做到的是:看,look。 而大脑才能做到:看见,see。将信息转为视觉,以及物体的识别。

这张动图是新生儿1到3月的视觉变化。可以说,你在刚出生时,几乎就是睁眼瞎,初始视觉只能帮助你吃到奶。在后天的经历中,大脑皮层的神经网络得以重塑。这个就是人类的学习。视觉是在学习过程中获取的。对学习(learning)一词需要重新定义一下:并不是指上课或者读书,而是出生后所有经历与体验对神经系统的重新塑造。神经系统中,神经元之间的连接是可变的。大脑是自我进化与适应的。

人工智能召唤出机器视觉

对于自动驾驶而言,人工智能需要理解路面上所发生的所有状况。在十年前,这是完全不可能的。计算机在数学运算方面比人脑快出了很多个数量级,但在视觉方面显得非常笨拙。但在过去十年,通过构建类似于人脑神经网络的计算模型,加上大数据的训练,使得机器通过学习(learning)开了眼。机器视觉的突破,影响会非常深远和广泛。

这张图片中,人工智能对运动中的汽车和人进行了不同颜色的标记。其中那个数字,是概率。数值为1时,计算机认为有100%的把握。0.996时,计算机认为有99.6%的把握。

这张图片右边有3个小图,上中下分别为左侧,前方,右侧。

几年后最危险的驾驶员是人

只需要几年时间,人们的观念可能会发生颠覆性的改变。全球每年死于车祸的人数超过百万。尽管汽车行业在过去几十年中不断的追求更加安全,但收效甚微,因为最大的不安全因素就是人本身。由机器代替人来驾驶,会让车祸概率大幅减小。无人驾驶每出现一起车祸,都会成为天下尽知的新闻。

概要

资讯

自动驾驶新闻时间

- 【2023-10-2】旧金山,一个十字路口,Cruise自动驾驶汽车Panini撞到倒地行人(被他人撞到),撞击后停下来,系统误将事故识别成侧面碰撞,并启动了靠边停车操作,导致女子夹在车轮之间,11km/h的速度下被拖行6m,造成多处严重受伤

- 【2024-10-15】问界武汉事件,一辆问界M9在武汉,与对向车道大货车发生对撞事故,随后官方也是进行了回应:经过数据分析,事故发生前车辆已退出智驾,车辆制动、转向及加速功能正常。

- 【2025-3-29】小米su7车祸,安徽铜陵,女乘客驾驶小米SU7,与两位同学从武汉出发,前往安徽考编,于德上高速枞阳至祁门路段发生事故,事故造成3人身亡。 事故发生前车辆处于NOA智能辅助驾驶状态,车速为116km/h。

自动驾驶分级

领航辅助驾驶(NOA)属于L2级别一下的L2+自动驾驶

| 级别 | 中国标准名称 | 中国标准描述 | 美国SAE标准名称 | 美国SAE标准描述 |

|---|---|---|---|---|

| L5 | 完全自动驾驶 | 在其设计运行条件下,能够持续地执行全部动态驾驶任务和执行动态驾驶任务接管。自动化排除商业和法规因素等限制外,在车辆可行驶环境下没有设计运行条件的限制 | 完全自动化 | 无需人类驾驶者任何操作,全靠无人驾驶系统操作,在有需要时可切换至人工操作模式 |

| L4 | 高度自动驾驶 | 在其设计运行条件内,能够持续地执行全部动态驾驶任务和执行动态驾驶任务接管 | 高度自动化 | 在限定的道路和环境中可由无人驾驶系统完成所有驾驶操作 |

| L3 | 有条件自动驾驶 | 驾驶自动化系统在其设计运行条件内持续地执行全部动态驾驶任务,动态驾驶任务接管用户能够以适当的方式执行动态驾驶任务接管 | 有条件自动化 | 由无人驾驶系统完成所有驾驶操作,根据系统请求,人类驾驶者提供适当操作 |

| L2+ | 领航辅助驾驶(NOA) | 无(仅为中国标准里L2级别下的细分) | - | - |

| L2 | 组合驾驶辅助 | 驾驶自动化系统在其设计运行条件内能够持续地执行车辆横向或纵向运动控制,具备部分目标和事件探测与响应的能力 | 部分自动化 | 针对方向盘和加速中多项操作提供驾驶支援,其他由驾驶者操作 |

| L1 | 部分驾驶辅助 | 驾驶自动化系统在其设计运行条件内能够持续地执行车辆横向或纵向运动控制 | 驾驶支援 | 针对方向盘和加减速其中一项操作提供驾驶支援,其他由驾驶者操作 |

| L0 | 应急辅助 | 车辆横向及纵向运动控制均由驾驶员完成 | 无自动化 | 需要人类驾驶者全权操作 |

行业格局

自动驾驶厂商

| 应用领域 | 占比 |

|---|---|

| 量产辅助驾驶 | 32% |

| Robotaxi | 21% |

| 物流配送 | 13% |

| Robobus | 11% |

| Robotruck | 8% |

| 环卫自动驾驶 | 5% |

| 农用自动驾驶 | 3% |

| 泊车 | 3% |

| 矿区自动驾驶 | 3% |

| 车路协同 | 3% |

Top 2 企业分布

| 类别 | 国内 | 国外 |

|---|---|---|

| L2 辅助驾驶量产车 | 华为、momenta、小鹏、理想、蔚来、大疆卓驭、地平线、百度 | 特斯拉FSD |

| L4 Robotaxi | 百度、pony、滴滴、文远、autox、轻舟 | Waymo、特斯拉、Curise |

方案

目前量产并产品化的车端自动驾驶方案

- 基于纯视觉环视自动驾驶方案: 特斯拉,

- 纯相机方案 + 雷达与激光雷达方案: 如 Mobileye 的 True Redundancy方案,形成一冗余的自动驾驶方案。

这两种方案对移动平台的算力要求不容忽视,就 Tesla 2021 AI DAY 公布的FSD chip就达到144TOPS,Mobileye面向L4级自动驾驶推出的EyeQ Ultra,其AI算力更是能够达到176TOPS。虽然两者在TOPS上面都不是最出彩的,但拼算力的背后,也道出了算法模型复杂度不断攀升的原因。

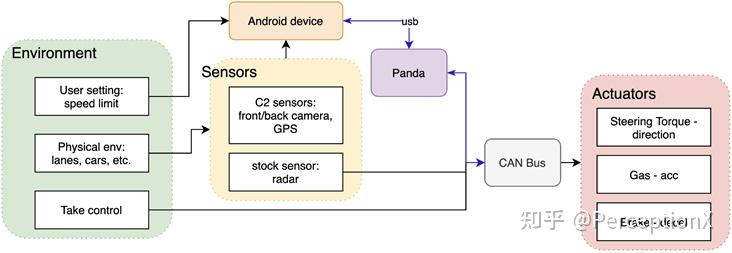

另外,还有经济实用且性价比超高的自动驾驶外装产品

- 来自 Comma.ai 的 Openpilot,仅仅用一款乐视手机以及高通骁龙821芯片,搭载openpilot software,就能实现L2+自动驾驶。

L4 架构

整体架构

- 3个部分:传感组件、步骤流程、执行组件

| 模块类型 | 具体模块 | 子模块/相关技术/描述 |

|---|---|---|

| 传感组件(Sensors) | 摄像头(Camera) | - |

| 激光雷达(LiDAR) | - | |

| 雷达(RADAR) | - | |

| 卫星定位(GPS) | - | |

| 步骤流程(Navigation Pipeline) | 定位(Localization) | 即时定位与地图构建(SLAM)、全球导航卫星系统(GNSS) |

| 规划路线(Mapping) | 高分辨率地图(High-Definition Map) | |

感知(Perception) |

- | |

预知(Prediction) |

轨迹预测(Trajectory Prediction),轨迹预测、行为预测、motion、mlplanner | |

决策(Decision) |

有限状态机(Finite-State Machine) | |

路径规划(Path Planning) |

无碰撞规划(Obstacle-free Path Planning) | |

控制(Control) |

纵向控制(Longitudinal Control) | |

| 执行组件(Actuator) | 驾驶(Steering) | - |

| 刹车(Brake) | - | |

| 加速(Acceleration) | - |

其中

- 规划路线:高精地图提供丰富语义信息包括交通规则、路面信息、连接关系等。

- 感知:感知检测,如bev环视感知、3d目标感知、occupancy grid、雷视融合。

- voyager

- detection: lidar detection、cam3d detection、cam 2d detection。

- understanding: 雷视融合one model detection、lidar occ grid、雷视融合occ grid

- tracking

- localization

- 预测:轨迹预测、行为预测、motion、mlplanner

- 决策:综合感知和预测的结果,依据交通规则和预设的安全、效率等目标,做出宏观的行驶决策。目前架构中一般与规划合并

- 规划:Routing 路由

- speed reasoning 纵向规划

- path reasoning 横向规划

- lane change 等决策规划。

- 控制:规划结果转化为具体的控制指令,精确控制车辆的动力系统、转向系统和制动系统。

架构图

难点

| 自动驾驶难点分类 | 具体难点内容 |

|---|---|

| 安全与验证 | - |

| 成本与规模化 | - |

| 基础设施与社会接受度 | - |

| 感知 | 长场景的感知;传感器局限性;识别与理解的挑战 |

| 规划 | 安全、舒适、效率的平衡;复杂场景的认知能力;动态的学习能力要求 |

| 法规与伦理 | - |

归零场景(L0)

- 鬼探头:小孩横穿马路、夜晚行人从树丛中冒出来

- 倒地行人:

感知场景(L1)

- 异型车:翻滚车辆

- 未让行:前方撞车

- 形状识别不准:

- 漏识别:叉车前铲、铁皮

- Lidar丢点:camera距离太远

- 误识别(FN):空中飘带、杂物、限高杆

- 小动物:无牵引动物识别晚

规划场景(L1)

- cut in:前车太慢,后车cut in

- 对向车辆

- 环岛:不理解合理场景避让

- 交互:creep to pass

- 让行:复杂场景让行

- yield:大车转弯让行

- 遮挡FN

- merge:合理汇入

- nudge

技术升级

- 端到端 Apollo、autoware、ros

- navigation模块化架构 -》端到端架构

- 半端到端:MLPlanner,包含决策、路径规划

- VLA/VLM架构

- 综述: Large VLM-based Vision-Language-Action Models for Robotic Manipulation: A Survey

- 单体模型、分层模型

- 基于Qwen2.5-VL的FMV2

- 端到端架构 -》 VLA4AD架构范式

- 论文 A Survey on Vision-Language-Action Models for Autonomous Driving

RL Pipeline

效果

2020年基于消费者使用评价进行统计出来的评测报告

纯视觉

Tesla

雷达

视觉+雷达(激光)

Openpilot

Openpilot 整体产品表现还是比较惊艳

- 首款开源的基于端到端(Perception to Planning)的辅助驾驶系统

- 采用自标定模块,相机安装简单

- 整体算法思路很新奇

- 将感知+规划放到一个model

- 引入时序信息

- 关注最危险的几个目标/输出速度

- 数据体系/生态体系完善

- 积累了大量数据

- 用户可以自行上传数据

- 开源社区共同服务

系统架构

【2022-6-7】Openpilot EP1:Openpilot开源项目深度解析

问题

数据

【2022-5-12】万字综述:如何打造自动驾驶的数据闭环?

最近自动驾驶和数据闭环结合在一起,原因是自动驾驶工程已经被认可是一个解决数据分布“长尾问题”的任务,时而出现的corner case(极端情况)是对数据驱动的算法模型进行升级的来源之一

Tesla的Autopilot数据引擎框架:确认模型误差、数据标注和清洗、模型训练和重新部署。

Tesla的Autopilot数据引擎框架:确认模型误差、数据标注和清洗、模型训练和重新部署。

谷歌waymo报告提到的数据闭环平台:其中有数据挖掘、主动学习、自动标注、自动化模型调试优化、测试校验和部署发布。

如图是英伟达公司在自动驾驶开发建立的机器学习平台MAGLEV,也是基于闭环的模型迭代:其中有smart的数据选择、数据标注、模型搜索、训练、评估、调试和部署。

数据闭环各个组成部分:

- 自动驾驶的数据驱动模型;

- 云计算平台的基建和大数据处理技术;

- 训练数据标注工具;

- 大型模型训练平台;

- 模型测试和检验;

- 相关的机器学习技术。

车道线检测 Lane detection

- sota水平的code

- 车道线检测(Finding Lane Lines)

定位精度

详见站内LBS专题

道德困境

【2019-05-24】自动驾驶汽车的道德困境

每个人都曾想拥有自己的自动驾驶汽车,但自动驾驶汽车并不完美。首先需要肯定一点,自动驾驶汽车仍然需要像你和我一样做出决定,而这样的结果是它们并没有完全消除碰撞的可能性,从某一个角度来看,自动驾驶汽车只是减少它发生的可能性而已,越来越多在自动驾驶模式下的汽车发生事故的报告能说明这点。 诸多的自动驾驶汽车事故报告可以表明,自动驾驶汽车不会主动去碰撞行人(杀人),而是选择被动情况下不得不碰撞行人(被动杀人),汽车不会故意杀人,但如果发生碰撞,自动驾驶系统中会有相关机制告知自动驾驶汽车不能做什么。如果让自动驾驶汽车选择在两个不同的人群之间碰撞,那么选择不杀死一个人对另一个人来说则是致命的,这反映的一个问题就是自动驾驶汽车的优先项和他的“价值观”,这是自动驾驶机制编程人员的一个基本考虑因素,因为他们决定计算机的功能,以及汽车在各种复杂工况中的行动方式。那么是谁,通过什么方式以什么形式确定的优先项和机器的“价值观”呢? 如果你在Netflix上观看了Circle(2015),你就会知道它是怎么回事!这部剧能让我们思考人类的未来,以及我们每天做出决定对别人的影响 -每个人都要拼命“活在当下”,证明他们的价值。电影的前提很简单:影片讲述被俘虏的人,面对即将到来的处决,五十个陌生人被迫从中选择一个值得存活下去的人的故事。Circle是一部关于人性的电影,当我们被迫在最坏的情况下做出决定时,我们如何评价彼此以及人们如何反应。这部电影讲述了什么使我们成为人类的核心——我们是谁,我们相信什么,以及最终,我们将会花费多少时间去拯救我们自己 ,但是自动驾驶汽车似乎没有这么多人性和道德的考量!

- 道德选择并不通用

- 你认为正确的道德选择很可能与你周围的人想的完全不一样。因为道德是主观的,而 每个人的价值观都不同。无论你喜欢与否,我们都必须承认的一点是我们的选择都是缺陷的:我们根据我们过去的经验和预判及偏见来做出决定, 关于你是否应该在事故中拯救A或B也很难辩论,因为你根据你已经制定的一些抽象标准以及社会接受的东西判断一个人的价值。 什么是好人的标准在哪里? 因此,除了通用道德之外,人们普遍认为“对社会更重要”是评价的标准之一。医生,孕妇和孩子是更值得关注的人,即使在泰坦尼克号上,妇女和儿童也是第一批登上安全船的人,这种道德选择已经深入人心。

- 看着不同的人做不同的选择是一件很有意思的事情。做选择能体现人的性格,就像Trolley problem问题一样。电影Circle结束时,您可以看到不同房间中的其他组决定谁能活下去的结果,很让人震惊。如果我们回归到“生活主题”中:我们应该思考我们该重视什么:是群体还是个体?

- 用户(有时)永远是对的

- 如果发生车祸,而你怀孕的妹妹和她的丈夫正好就在其中,如果你是一名医生或随机的一名陌生人,大家都不难猜测,你会来救你的妹妹和妹夫。 但是如果车祸中还有其他随行乘客呢,为了拯救你的家人,随行的乘客将不得不死你会作何选择。你可能仍然会救你的妹妹和妹夫,这时候我意识到,因为人们并不总是想要拯救乘客,更多的关注杀死了多少人和什么类型的人。

- 可以对汽车进行编程来实现“最佳情况”, 这看起来很容易。但困难的是,没有人愿意买一辆在发生事故时牺牲乘客的汽车,这对企业来说很糟糕,这对他们的营销或销售产品时带来选择困境,自动驾驶汽车是否应该被编程不惜一切代价来避免事故?如果怀孕的母亲和丈夫违反交通规则的情况下该如何选择?就目前来看仍然没有确定的答案。这篇文章的构思启发源于麻省理工学院的测验,让你在自驾车的不同场景中选择行动(选择谁不被杀)。 在测验结束时,他们会为您提供结果摘要,令人惊讶的是,我的“最佳拯救角色”是一位女医生,而我最“被该杀的角色”则是一位老人,我觉得结果令我很沮丧,但就其实际以及我个人的偏见和经验而言,结果仍然是有道理的。

- 此外需要注意的是,这并不一定是您处于该情况时将执行的准确且唯一操作,因为理论与实践中的一切都有所不同。 如果感兴趣可以参与道德测试:道德机器 - 麻省理工学院。

- 性别偏好

- 当您看到结果时,您还会了解到与你一起参加测试的其他人的结果。总的来说,人们倾向于挽救女孩而不是男孩。这可以追溯到一些古老的生物学推理,因为女性的主要角色是繁殖和生育,而这依赖来自于对女性的刻板印象,即女性是“照顾者”并表现出母性行为,这使得杀害她们更加残忍。

- 这个结果很有趣,因为即使当今世界的人仍然很多人认为在求助选择时候选择一个女人而不是一个男人。虽然这个小样本量并不是一个很具有代表性的统计数据结果,但确实提供了一种暗示性的趋势。如果你考虑性别角色和过去的男性优势,你仍然能够预测到未来的潜在结果如何。当然我并不知道偏见不会彻底消除,因为我们可以发现这种偏见已经渗透到了各个领域!

- 人类>动物

- 人们不仅拯救女孩而不是男孩,而且还会一次又一次地拯救人类超过动物。有一个物种偏好,仅仅因为我们是人类并具有自我保护的基本本能。如果你与那只动物有所属关系,比如它是你的宠物,那可能就会略有不同,这恰恰反映了人自私的本性。

- 抛弃老人,留下幼童

- 前面我曾经说过,上述实验中我的“杀死最多的人物”是一位老人,我不知道我是否潜意识的同意这一点,但我很明确的认为老年人有价值。 无可否认,根据过去的经验,老一辈人是智慧和知识的载体。虽然他们可能没有以最典型的方式为社会做出具体贡献,但谁能说他们的知识和/或智慧无效呢? 当然,时代变了,几个世纪前的智慧和经验并不适用于当代社会。当我们做选择的时候,我们仍然可能倾向于拯救这些幼童,因为他们还没有完整的拥有过自己的一生,而老年人已经体验了他们经历的一切,我知道这就是我所做上述选择的原因。因为在我所救下的那个年轻人很可能是下一个伊隆马斯克,很可能会对社会带来更多价值,但从反面来看,这个年幼的孩子有可能也是坏人,但这是一个事实,无论你喜不喜欢,其实我们决定不了这个幼童的未来走向,但我们仍然更倾向于拯救他们。

- 留下医生

- 在做决定时,我发现倾向于拯救医生而不是流浪者。我并不是唯一一个做出这样选择的人。我认为这不是一种好的思维方式,因为社会地位不应该是你生还是死的决定因素。

- 所有国家都表现出令人不安的选择偏好,即拯救地位较高的人[例如,高管人数超过流浪者],我们也发现这与一个国家的经济不平等程度密切相关,在存在更大的不平等的情况下,更倾向于牺牲无家可归者。 - 图卢兹经济学院Jean-FrançoisBonnefon

- 我们重视医生,因为我们认为他们的工作对人类的生存至关重要 - 事实上确实如此,不是每个人都能做到这一点,医生需要接受大量的教育才能开始就医,但是医生不是每个人过好生活所需的唯一角色,我们不能忽视的一点是,没有农民,我们照样不能吃到饭菜,没有工程师,就没有桥梁和工厂,没有教育工作者,你将如何学习?

- 这让我意识到测验本身是有缺陷的,因为给出的关于不同选择的信息是有限的,但是缺陷不来源于测试,而是源于固有的社会缺陷和社会偏见,我们对一个人的重视程度是基于他们对社会的贡献吗?我们的答案很多时候是肯定的。

- 如何定义正确和错误?善与恶?

- 把这个问题想成“选择不杀谁”是很苛刻的。但这是我们处境的现实,我们都知道。那么答案是什么?在发生事故之前,你只需要踩刹车…… 哈哈,不 - 我只是在开玩笑 - 虽然这是一种可能性,但制造自动驾驶汽车必须考虑到大量不同的情况,包括你不能踩刹车而汽车必须做选择的情况。关于自动驾驶汽车杀人的道德决定,这可能是罕见的(或我们希望是),但是不可避免的问题, 而这个问题最大的隐患在于没有真正的答案。目前来看没有关于什么是“正确”和什么是“错误”的机制,我们每个人都会拯救不同的人,那么谁的道德规范适用于自动驾驶汽车? 这种自动驾驶汽车决定杀人的特殊情况可能不到0.001%,但是风险因素如何分配?

入侵检测

【2022-9-7】LCCDE:自动驾驶系统中的网络安全守护者

- 自动驾驶和物联网是最近非常火热的领域,然而随着车辆互联网(Internet of Vehicles, IoV)的日益增长,对于网络安全的保护也越来越重要。

- 作者提出了一个识别恶意网络攻击的入侵检测系统,基于 XGBoost、LightGBM 和 CatBoost 来构建的。

- 项目地址

- 论文地址

堵车问题

【2023-10-15】幽灵堵车

现象:拥挤路段(车距小于35m),正常行驶的车流中,只要一个司机改变速度、车道,整个路段就从“畅通无阻”变成“寸步难行”,道路并没有拥堵,却出现堵车现象。

- 明明前方没有发生事故,也没有路段整修,一切都是那么的平静和正常,但还是堵车了(不考虑红绿灯的情况)。此时除了等待之外,似乎也别无他法。这种颇为诡异的交通堵塞被称为“幽灵堵车(Phantom Traffic Jams)”

- 通常会在路面承载过多通行车辆时出现,如前不久刚刚结束的“高速春运”。

- 麻省理工学院的计算机科学教授Berthold Horn表示:造成“幽灵堵车”的原因可能和一些司机的“坏习惯”有关,如:急刹车、不必要的更换车道等。因为,在车辆过多过密的情况下,当一辆车做了轻微的减速,后面的车辆也要跟着做出反应,这种调整会像一波一波浪潮不断向后传递(且减速程度因人而异),最终迫使后面的某辆车不得不停滞下来(以避免追尾),从而形成拥堵。

- “幽灵堵车”归根结底是被“不良开车习惯”引发和加剧的蝴蝶效应。

Horn教授一直在致力于研究“幽灵堵车”现象的成因和解决方法:行车间距双边控制法(vehicle spacing bilateral control),即

- “(在遇到前方刹车等情况时)快速的调整与前后车之间的距离,尽量使其位于二者之间”。因为适当车距在车流中扮演着阻尼器的作用,理论上来讲可以缓解潜在的“幽灵堵车”。

Horn教授和研究员们还建立了一个机器人仿真模型以作验证。视频大概7分钟,一开始模拟的是普通路况,可以看到小车开始进入“循环拥堵”。2分09秒时,研究员开启了双边控制(车上的小灯会变蓝),拥堵情况开始缓解并最终消失(后面则是关闭后再次试验了一次)

视频中展示的是简单而理想化的实验环境,现实车道要复杂的多,单就“让所有司机时刻注意调整与前后车的车距”这一条,似乎就很困难了。不过,Horn教授表示,行车间距双边控制法可以通过对“自适应巡航控制系统(ACC)”进行简单修改来实现。ACC是一种智能化的自动控制系统,安装在车身前部的传感器(雷达)会时刻扫描车辆前方的道路,当车距过小时,ACC控制单元会通过与制动防抱死系统、发动机控制系统协作,使车轮适当制动,并降低发动机的输出功率,从而让车身与前方车辆始终保持安全距离。

目前不少新车都已安装ACC系统。Horn教授认为,在“联网自动驾驶汽车(networked self-driving cars)”普及之前,通过微调ACC实现行车间距双边控制,是解决“幽灵堵车”的一种可选方案。

出事故了谁负责

【2022-1-23】自动驾驶开启的情况下出事故了,由谁负责?

由于自动驾驶技术发展尚未完全成熟,自动驾驶引发的交通事故不绝于耳,比较知名事件包括:

- 2016年5月,美国佛罗里达州某男子以自动驾驶模式行驶特斯拉 Model s,全速撞到一拖挂卡车造成车毁人亡。

- 2018年3月,一辆 Uber 自动驾驶汽车处于四级以上自动驾驶模式,在美国亚利桑那州撞到一横穿马路的行人,导致其不治身亡。

- 2016年1月,高某宁驾驶父亲的特斯拉 Model S,在高速行驶时与前方的道路清扫车发生追尾事故身亡。事故后,特斯拉方面确认在车祸发生时,车辆处于「自动驾驶」状态。(国内首起「特斯拉自动驾驶」车祸致死案)

自动驾驶开启的情况下发生事故,最终到底由谁何方承担赔偿责任,是个非常复杂的法律问题。

此种情况下,涉及到两个主要责任主体:驾驶员以及汽车厂家,不论将责任分配给哪一方都将对自动驾驶行业的发展产生巨大影响。

- 如认为由驾驶员承担责任,那意味着认定即使在开启自动驾驶的情况下,驾驶员仍然对汽车的驾驶情况负有注意义务,此时自动驾驶技术似乎失去了「自动」本来的功能。

- 如认为由厂家承担责任,在自动驾驶技术尚未完全成熟的情况下,频繁发生事故是否会给厂家增加相应成本,打击厂家开发自动驾驶技术的积极性。(实际上,汽车厂家也压根不想承担此责任,例如特斯拉在《车主手册》中就写明因使用自动驾驶技术而产生的责任由车主本人承担)

正是由于上述原因,时至今日,法院尚未就国内首起「特斯拉自动驾驶案」作出判决。

结合当前自动驾驶技术的发展情况,个人对自动驾驶导致事故时责任划分的一些看法。

总的原则是由驾驶员先承担责任,具体理由如下:

- 对当前自动驾驶技术不成熟的充分预见。

- 作为一名成年人,在当前自动驾驶技术尚不成熟的情况下,特别是在已经出现了一些由于自动驾驶技术导致交通事故的情况下,应当预见由此可能带来的风险。

- 在此,不排除未来自动驾驶技术完全成熟,能够将事故概率降到极低水平。

- 但至少目前在国内,自动驾驶技术尚不能完全应用于全路段,这也意味着即使启动自动驾驶技术的驾驶员,仍负有随时接管汽车的注意义务。

- 驾驶员是车辆「运行利益」享有者,并在一定程度上仍「支配管领」汽车。

- 虽然车辆已经开启自动驾驶技术(有时可能至L5以上),但汽车并未完全脱离驾驶员的「支配管领」,驾驶员可以选择随时停止自动驾驶。

- 驾驶员作为车辆「运行利益」的享有者,也理应承担车辆运行造成事故的责任。汽车此时只是驾驶员的工具、物件,物件伤人自然由物件的占有者先承担责任。

- 但是,如果涉及车辆、技术产品问题,驾驶员可以在承担责任之后,向厂家等相关主体追偿。

未来的自动驾驶汽车交通事故情形将越来越复杂,希望有关部门能尽快注意到这个情况,相应制定、修订法规,以更好应对自动驾驶技术非诉发展带来的挑战。

无人驾驶研讨会

无人驾驶交流总结

无人驾驶流派

- (1)激光雷达(主动):google,成本比较高(一个雷达几万),受天气影响

- (2)图像(被动)

人的视野范围200m,500m以上就得靠雷达

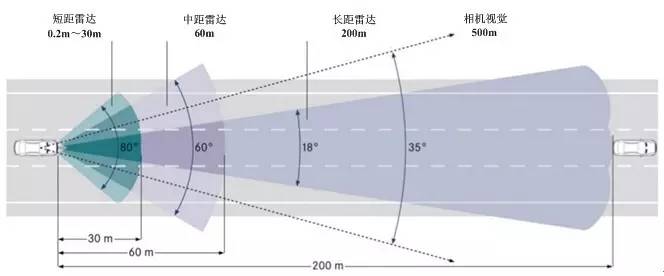

无人驾驶的车载传感器配置,图

常用的车载外部传感器各具特点 —— 【2016-11-9】专家讲坛:无人驾驶车辆环境感知系统该如何构建?

- 毫米波雷达可以准确检测前方车辆的距离和速度,具备较强的穿透雾、烟、灰尘的能力;

- 而相机视觉系统可以获得车道线、交通信号等目标的颜色和形状等细节,从而进行细化识别;

- 激光雷达通过点云来建立周边环境的3D模型,可以检测出包括车辆、行人、树木、路沿等细节。通过激光雷达或毫米波雷达与视觉传感器进行融合,不仅可以进行目标物体检测,而且还能进行目标空间测距、目标图像识别等功能。类似,GPS定位、视觉传感器和激光雷达进行融合,则可以实现车道保持所需的高精度定位,也能实现多类障碍物目标检测。

在构建典型的环境感知系统时,常用传感器包括相机和激光雷达等传感器。

- Velodyne 激光雷达获取三维点云数据,用于定位和和地图构建,同时也用来测量车辆与周围物体的距离;

- Ibeo激光雷达传感器虽然垂直方向分辨率低于Velodyne激光雷达,但可以产生长距三维点云数据;

- Hokuyo北洋激光雷达传感器产生短距二维激光扫描数据,常用于紧急停车,而不用于定位与地图创建;

- 相机可以用于目标检测,Point Grey 相机有360度全方位视角覆盖,而Grasshopper相机是单一朝向,运行帧率较高,前者可以用于检测运动物体,后者可以用于识别交通信号灯;

- Javad RTK定位传感器接收卫星全球定位信息,经常采用陀螺仪传感器和里程计来修复定位信息。

主讲人:北京出版社,kitt.camp无人驾驶创始人 短距离的局域网覆盖是为了弥补

数据瓶颈解决方案:

- (1)整车厂

- (2)模拟驾驶

- (3)Tesla

- (4)common:众包,开源驾驶。

panda收集骑车形式数据公开到github上,据说1996上以后的车都能看到

chffr:app记录路况,摄像头

贾老师(做发动机的):智能驾驶主要看硬件,而不是软件。车辆与人互动更好,有危险提前预防;博世

容易做的:

- (1)封闭环境下低速自动驾驶已经实现,比如深圳有个凯德mall,停车场有摆渡车,自动将车开到电梯口

- (2)低速开放环境

最难的是高速公路,容错率低,tesla两个死亡案例,一个在河北,一个在美国。驾驶人有7s反应时间(充足);无人车事故大多来自人为原因

国内无人驾驶:

- 百度改了ROS(robot operation system),哪来开源,作为业界标准,ROS网上才是算法。其中有些问题,北理工马教授说百度改的颇有争议。李彦宏五环开了6分钟,视频就1分多钟

- 百度有两个无人驾驶事业部:L3(李彦宏)和L4(吴恩达做drive.ai、楼天城做pony.ai),L4出走。楼天城把原来姚期智班的同学拉过去,参加比赛拿第6名,把名次高的都挖了一遍

- 无人驾驶肯定还是中国人自己做,不可能由外国人做(国家安全)

- 日本车企一个比一个低调,实际上他们的无人驾驶能力非常强,比如丰田和本田,原因:硬件能力强,如半导体。本田的“阿西莫”(ASIMO)机器人由日本本田公司研制,可以称得上是世界上最先进的类人机器人,是全球唯一具备人类双足行走能力的机器人

汽车媒体

行情

- 汽车之家美股股价,相较于2021年1月27日147.67美元的高点,到8月26日39.65美元的收盘价,大幅跌去了73.15%,其已经远远不止腰斩了。

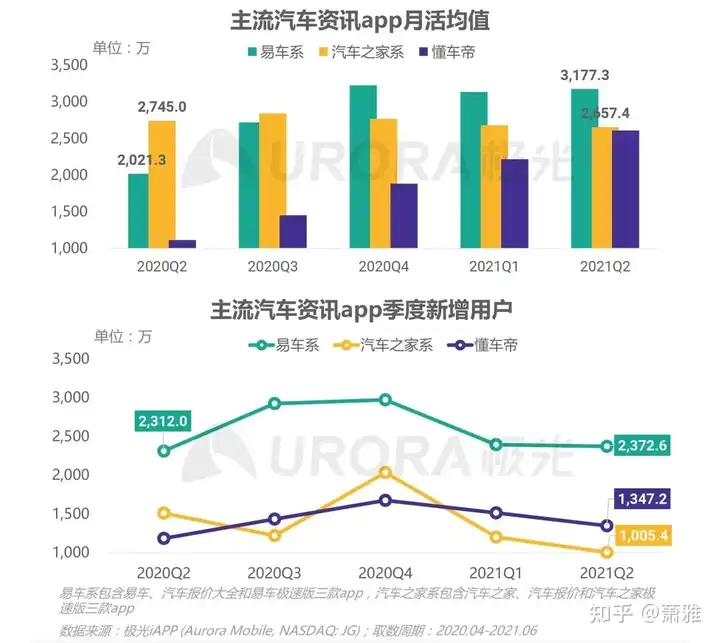

- 易车系2021年Q2的MAU均值达到了3177.3万,同比增幅为57.2%,超过了汽车之家系的2657.4万。牢牢占据了2020年Q4夺来的头把交椅。

- 分析图 参考

汽车行业垂直类平台除了汽车之家之外,还包括易车和懂车帝

易车是“中国汽车行业赴美上市第一股”,亏损数年后,2021年11月私有化退市,以腾讯为首的买方财团并购成为控股股东;- 而

懂车帝的前身是今日头条的汽车频道,主要靠汽车内容起家。

评论

- 脱胎于今日头条汽车频道的

懂车帝,虽然不缺流量的支出,也不缺自媒体,但在内容上还是存在不足。- 知乎汽车大V

黄恒乐就曾发文质疑:”如果你仔细看几天懂车帝,就会发现这不是义乌小商品集散地,而是垃圾填埋场。” - 懂车帝上随便搜一个关键词“路虎加完油”,能搜到30多条假新闻。

- 知乎汽车大V

汽车之家都发力已久,且已经取得了一定成绩。这点从其他企业选择跟汽车之家合作,就体现的非常明显了。- 去年7月,

瓜子二手车、毛豆新车的母公司车好多集团宣布与汽车之家二手车达成合作关系,合作的重点在于“数据”。 车好多集团联合创始人、副总裁王晓宇的表示则更加直接:基于汽车之家二手车的平台流量、精准的数据挖掘等优势。

- 去年7月,

天下三分,三足鼎立,汽车之家、易车与懂车帝纷争抗衡之外,最终将演变为腾讯、字节、平安三大巨头技术、资源、战略的对决。

- 【2022-10-13】被平安吞下六年后,汽车之家凛冬将至

行业格局:汽车之家,懂车帝,瓜子,易车

汽车之家

口碑

- 【2025-4-4】脉脉

- offer上16个月,对应年终奖4个月,实际平均3个月

- 工时: 平均11h, 公司政策要求打卡,工时10h以上;部门平均工时12h以上才允许招新

- 稳定性: 持续裁员

业务

业务包括车媒体、车电商、车金融、车生活四大块。

如今的汽车之家已经是一个集内容、工具、营销平台为一身的,一站式的汽车服务平台了。汽车之家建立起来的车型库、报价查询以及厂商、经销商资源等核心竞争力,正是懂车帝所欠缺的。

发展史

2000年前后,大众刚触网,新鲜的资讯类网站,掀起了国内第一次互联网浪潮, 但很快,更细分的市场需求催生了,IT、汽车、金融等细分垂类资讯网站应运而生。李想创立的以做电脑硬件相关资讯的“泡泡网”,凭借相对优质的内容和高频的更新速度,泡泡网快速成为国内第三大中文IT资讯网站。

当电脑市场爆发期一过,门户网站就出现了很明显的头部集中效应,果不其然,没多久,泡泡网被盛拓传媒收购。

2005年前后,中国汽车消费从爆发期进入短暂的低谷期

- 一边是居民汽车保有量不足3200万辆,消费市场才刚刚打开

- 另一边是中国入世后,越来越多国际品牌进入国内市场,汽车销售的卖方市场逐渐转为买方市场,消费者需要专业信息以供决策参考。

2005年,李想看中了更具有商业价值的购车人群,创立了汽车之家。

李想将泡泡网的成功经验嫁接到汽车之家,包括频率更高、实拍图片保证质量等。汽车之家又通过成立汽车数据库和用户论坛建立与用户沟通的桥梁,通过规范管理,不给汽车经销商回扣,树立起了权威、客观的形象。

2009年,汽车之家日均浏览量突破千万,用户量超越易车网,成为汽车垂类媒体第一。

2013年汽车之家在纽交所上市,开盘股价上涨77%。

创立于互联网野蛮生长时期的汽车之家,随着互联网与中国汽车市场的腾飞,实现了纽交所和港交所两地上市,创造了700亿市值,成为全球访问量最大的汽车资讯平台。

辉煌过后,尤其是创始人李想出走创业、平安血洗管理层之后,汽车之家的不确定性因素正越来越多。

- 2016年4月,汽车之家爆发股权之争,创始人李想已抽身离开,当家人秦致想联合财团将汽车之家私有化,没想到的是第一大股东澳洲电讯却在此时想退出,并出售47.7%股份。

- 这时,

中国平安就盯上了,用李想的话就是:走了一只树袋熊,来了一只大黑熊。 - 由于

澳洲电讯希望能尽快出售股份,财大气粗的中国平安在6月25日就拿出16亿美元收购了澳洲电讯 47.7% 股份的第一大股东。 中国平安入主汽车之家仅仅2天后,CEO秦致,CFO钟弈祺即被清洗出局,随后一年内,平安对汽车之家大批的高管实施大清洗,并裁撤了不少业务,不少员工被离职。

2016年,汽车之家创始团队与中国平安展开耗时数月,结果却在意料之中的股权争大战,在万众瞩目下,最终以中国平安入主汽车之家,落下帷幕。

汽车之家从汽车媒体转型汽车平台,业务从资讯内容拓展至交易、金融、和汽车生活等其他三个环节,往汽车服务生态链的方向规划。

汽车电商业务也因盈利模式未跑通,被战略优化了。

平安试图构建“汽车销售+金融服务”的生态闭环。然而,随着移动互联网流量入口分散化,平安未能有效整合汽车之家的数据资源与自身金融业务。

- 2024年第三季度,汽车之家媒体收入暴跌31.7%,净利润缩水23.9%,标志着这一战略的实质性失败。

- 公司员工数量从2023年的5511名减少至4415名,裁员近20%

2018年以后,数字化改革成为汽车之家的转型重点,OEM、智慧销售、智慧展厅等数字产品陆续推出,汽车之家还收购了二手车交易平台“天天拍车”,完善服务链条。

并购后的两年,背靠平安系的汽车之家地确获得了更多安全感。

相较于2015年,2018年订阅汽车之家媒体服务的主机厂从87家增长至103家,移动网站和主要应用程序每日独立平均访问者总数为从1380万增长至2910万,2018年股价最高达到119美元,比收购价翻了2.5倍。

汽车之家的收入: 媒体业务、线索业务、在线营销及其他业务三部分构成。

- 媒体业务的早期收入占比在70%以上。然而业务大调整后,这部分业务在2019年第四季度出现负增长,2021年降幅扩大至41.78%,2022年第一季度单季收入降至最低2.67亿元,占比不到20%。

2018年,数字化战略实施后,在线营销及其他业务的收入从8.54亿元增长至2020年的20.05亿元,占总收入比重从11.8%增长至23.15%,成为企业收入增长的动力引擎。

然而好景不长。2021年第二季度,这部分收入增速从过去30%以上下滑至10%,第四季度首次出现负增长,2022年第二季度降幅进一步扩大至24.35%,下滑趋势明显。

2021年,汽车之家,收入、利润全线大幅下滑,到2022年上半年,汽车之家收入32.04亿元,同比下降15.22%,降幅较2021年上半年的2.08%明显扩大。

2022年上半年,汽车之家的归母净利润为7.53亿元,下降将近一半。在7.6亿元的税前利润中,有2.4亿元的利息和投资收益净额,产生于银行存款和账面上170亿元的短期投资,比如理财。

汽车之家有近1/3的利润是来自金融业务,而来自经营,这部分利润的下降幅度超过了55%。

2021年,投放媒体广告的主机厂由2018年的103家降至91家,另前五大广告客户收入占比也降低了3个百分点。

2021年之前,借助信息平台的优势,向主机厂和经销商提供信息流服务是汽车之家的商业模式

- 优质的信息,才能吸引高质量的客户,最终留住主机厂和经销商投放广告和线索订阅。一切交易都是基于真实可靠的信息源。

- 慢慢的,汽车之家渐渐失去了过往的优质信息的优势,“车托之家”“广告之家”成了汽车之家的代名词。

2022上半年,面对来势汹汹的懂车帝,汽车之家加大营销力度,营销费用同比增长6.91%达到13.31亿元,占收入比重首次突破40%。

- 2019年车市寒冬,有经销商表示“线索虽然多了,但是实际线索促进交易的

转化率在降低”,这对于勒紧裤腰带过日子车企无异于雪上加霜。 - 汽车行业所面临的不是线索量不够,而是线索泡沫化:线索规模的增长速度远超实际成交规模增速

- 2011年,中国的乘用车销量是1447万台;2021年,这个数字达到2015万台,这10年时间增长1.4倍;

- 同样在这10年,2011汽车行业线上线索量是1000万条,但2021年增长到6.6亿条,激增66倍。

买方市场出现了新趋势:用户年轻化、信息渠道复杂化、用户留资分散化等。野蛮人汽车之家没有抓住新趋势的脉动。

中国汽车流通协会调研报告显示

- 2020年90后汽车用户占总用户比重达到41%,但90后汽车用户在

汽车之家用户中占比不到三成。懂车帝用户中,这一比例达到52.1%。

这也决定了短视频、直播等新兴营销方式,更受年轻用户欢迎,而传统广告模式日渐式微。

本质上看,汽车之家广告业务与线索销售业务一样,都依赖于网站流量。随着移动互联网行业的快速发展,快手、抖音等短视频平台快速崛起,专业性的汽车媒体平台已经不再是整车厂家投放广告的唯一选择。汽车之家目前正遭遇到流量的困扰,两大传统业务急需找到突破的方式。

汽车之家更直接的竞争压力来自于懂车帝、易车网等平台的成长性。懂车帝背靠字节跳动,在流量和算法上优势明显,借助短视频和直播渠道发力,2021年第四季度,懂车帝APP的市场渗透率从一季度的3.1%增长至3.6%,超过易车网,位居行业第二,而汽车之家全年仅提升6了1%。即在用户使用时长、用户打开频次等核心数据上跻身行业前三位。

虽然汽车之家用户总量仍处在行业第一,但2020和2021年无论是新增用户总量还是增速,均不及易车网和懂车帝。加入腾讯生态后的易车,在流量和内容端获得持续扶持,很快用户数量上实现了对汽车之家的反超。2021年新增用户数量超过6千万,位于行业第一。

汽车之家下行,参考

被李想曾津津乐道炫耀的700亿市值的汽车之家,只剩不到270亿了

汽车之家已经从稳固的在线垂直市场领导者,转变为受汽车业逆风和竞争影响而日益疲软的市场参与者。行业老大地位已经被易车所取代。

四大内部原因:

- 第一,新领导战略布局能力还有待观察。

- 互联网企业规律:领导的水平是企业的天花板。

- 上一任 CEO

陆敏很有前瞻眼光和战略布局能力 - 2016年,

陆敏被调任汽车之家时,就迅速提出了“4+1”战略: 车媒体、车电商、车金融和车生活,汽车之家进入 2.0 时代; - 2018年,战略升级,提出以 AI、大数据和云微核心的 3.0 智能汽车生态圈, 探索出 广告、线索、数据、金融和交易五大盈利模式。

- 而2021年1月新任CEO

龙泉相对低调,大半年过去了,并没有传出理念、战略

- 第二,2021年初,管理层变化大

- 2021年1月,平安财险副总经理

龙泉上任 - 2021年5月,联席总裁

张京宇因个人原因离职 - 2021年7月,首席财务官邹钧辞任

- 董事长、CEO、联系总裁、首席财务官,几乎所有高层都离职。

- 2021年1月,平安财险副总经理

- 第三,技术创新和内容生产上,变革不够

- 2021年,汽车之家给人的第一印象依旧是 论坛、图文,这种门槛最低的内容呈现形式被相关机构过度商业开发,失去客观公正性,而此时汽车资讯、汽车互联网早已进入长视频、短视频、直播、AR/VR,甚至 AI 时代。

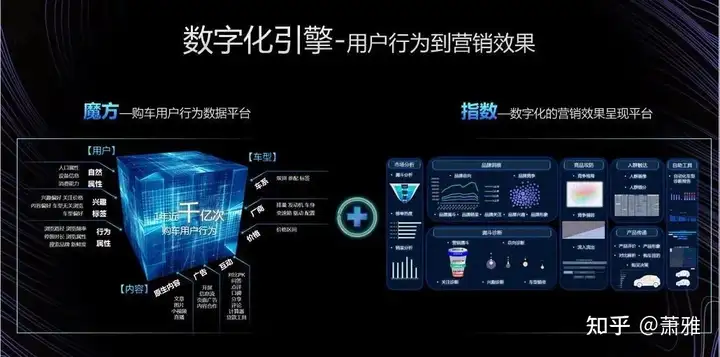

- 汽车之家老对手易车网更加有创意,早早提出内容视频化战略,推出《马力对决》《江湖车神》《易车横评》《易车横拆》《我是车手》等专题,涵盖体验、赛事、改装、越野、评测和生活方式等原创视频内容。技术上,易车魔方和指数平台深受用户喜爱,并据此构建行业首个全域数字化引擎。

- 易车结合AI的“智能编辑部”产出100万篇文章、100万分钟视频。

- 第四,企业气质:传统→互联网,又慢慢回归传统

- 前两年,陆敏表现非常好,变成一家互联网公司,而2021年,互联网气质不断淡化,回归传统

外部因素

残酷的外部竞争和外部环境,也是使得汽车之家不断没落、式微的重要因素

- 其一,

汽车之家和易车、懂车帝相比,天然地有着单体企业对生态体系企业的劣势。易车背后有腾讯,懂车帝背后有字节跳动。这不仅仅是入口和流量优势,还有全方位生态资源加持的优势。比如,作为腾讯系的一员,易车如今就在内容端、获客端、销售线索、经销商SAAS服务等方面,和腾讯展开了深度的合作。- 虽然

汽车之家的背后有中国平安,然而 汽车互联网和保险行业几乎没有交集;平安自身也面临着巨大挑战,即使有心扶持汽车之家,恐怕也是心有余而力不足。

- 其二,新能源车取代原有燃油汽车成为了必然趋势,而新能源车企的营销逻辑发生了巨大的变化。

- 崇尚“产品即营销”的新能源汽车语境里,广大厂商对汽车之家这种最为传统的汽车资讯平台的渠道依附,已经大大降低。

- 自己的官网、会员体系、线下门店、自身构建的自有新媒体平台,才是连接客户、用户、消费者、潜在消费者更为高频和高效的平台。

- 其三,用户对产品身份认同问题。

- 汽车互联网用户也和绝大部分普通人一样,不管年龄大小,都会向往年轻,都在与时俱进。

- 不少用户印象里,

汽车之家是相对老的人才用的产品,所以为了彰显年轻,大家更愿意选择易车、懂车帝。 - 相比于行动缓慢的

汽车之家,易车的转身则要迅速得多。- 早在2018年的时候,易车就开启了以“年轻化”为导向的品牌焕新运动;

- 并在2019年启动“三年品牌计划”, 易车签约

沈腾作为品牌代言人,并进行了大规模的品牌投放。 通过长期而持续的品牌建设和品牌营销,易车逐步在用户群体尤其是年轻用户群体中,树立起了年轻、潮酷、科技、会玩儿的品牌形象,在不断占领年轻用户心智的同时,也开始不断打破圈层,此次“超级818汽车狂欢夜”,就是易车从汽车、互联网、科技,向综艺、娱乐、时尚跨界突破的典范之一。

- 其四,负面问题一定程度上也影响了汽车之家的品牌形象。

- 经销商方面,2019年,汽车之家曾经与部分经销商爆发过颇为激烈的纷争。当年1月9日,中升集团发布内部文件《关于暂停汽车之家会员合作及费用支付的通知》,从而拉开了这场纷争的序幕。之后,运通集团、上海永达集团等几个经销商集团也纷纷表态,认为汽车之家2019年会员价格涨幅过高,要暂停与汽车之家的合作。运通汽车集团李竑微博上指出:“一个靠汽车经销商起家的垂直网站当羽翼渐丰时居然想依靠垄断来侵食。” 而客户和用户方面,根据新浪湖南的报道,湖南岳阳的一个客户通过汽车之家平台购买了二手车,提车前,该车经专家鉴定为泡水车,且已经过户3次,申请退车后,商家却扣押部分车费不予退还,之后又将泡水车再次放到汽车之家平台上进行售卖。虽然汽车之家可能只是个展示平台,但是用户遭遇如此糟心的事情,必然不会对平台有好的品牌印象。

实践

无人遥控车

【2024-10-25】自制远程遥控车,低成本,带摄像头

教程:老肖带你做车

- 车型一:前后采用双直流有刷电机(四驱)+2线直流有刷电机转向,对标市面上200元左右至以下的RC遥控车

- 固件下载:链接(最后更新:20241026)

- 车型二:前后采用单直流有刷电机+3线舵机转向,对标市面上300-500元的RC遥控车

- 固件下载:链接,(最后更新:20241106)

- 车型三:前后采用单直流有刷电机+5线舵机转向,对标市面上300-500元的RC遥控车

- 固件下载:链接(待更新)

- 车型四:双电机,L298驱动版

- 固件下载:链接(最后更新:20241026)

【2024-11-9】老肖带你做车,自制遥控车,购物,远程操控,取快递、买菜

4G远程遥控车功能

- 视频监控

- 语音通话

- 无距离限制

- 最新版还支持地图功能

成本

- 成品车 2k-4k

- 自制只需100多元

门槛:

- 无需编程,只需按要求接线

材料

RC遥控车- 把车里的主控板线拆下来,控制3个电机(前后电机和转向电机)

- 替换为8266主板(接受网络控制信号)+电机驱动板(驱动马达)

摄像头- 云台摄像头,萤石cp1云台,使用时只需通电、联网

- 小米小白云台不支持开放平台接入!

网络:无需电话卡,4G模块(成本高)- 低成本方案:带手机卡的旧手机,开一个热点,跟车绑在一起

- 随身WiFi:格行随身wifi

电力:- 方案1:RC遥控车自带锂电池

- 方案2: 充电宝供电

- 核心部件:

8266主控板(能联网)+电机驱动板- 8266主控板

- 电机驱动板

- 杜邦线

- type c 数据线

程序下载到主板,驱动遥控车

视频信息如何传到手机?复制摄像头画面到APP中

- 目前只支持萤石

- 配置参数:登录萤石开放平台,AppKey, SECRET, 序列号, 轻应用模板

- 连接,就能看到摄像头画面

海外

美国自动驾驶:Waymo、特斯拉

日本机器人开车

【2024-6-25】日本为了弯道超车自动驾驶,研发AI人形机器人开车

- 东京大学研发的仿人机器人”武藏”可以驾驶汽车

- 视频

- Our paper presented at Robotics and Automation Magazine is now on

- paper: Toward Autonomous Driving by Musculoskeletal Humanoids:A Study of Developed Hardware and Learning-Based Software

- 作者 twitter Kento Kawaharazuka / 河原塚 健人

- youtube: Toward Autonomous Driving by Musculoskeletal Humanoids (RAM 2020)

东京大学开发并训练了一种名为”武藏“的”肌肉骨骼仿人“,让它驾驶一辆小型电动汽车通过测试轨道。

武藏“装有

- 两个摄像头,可以代替人类的眼睛,”看到”前方的道路以及汽车侧镜反射的景象。

- 通过机械手,它可以转动汽车钥匙、拉手刹和打开转向灯。

- 此外,凭借防滑”脚”,”武藏”还能踩下油门或刹车踏板。

通过向”武藏”提供原始传感器数据,”教会”它如何使用汽车方向盘后,他们设法让机器人在十字路口转弯,同时遵守交通信号灯的指示。

但也有注意事项

- 首先,”武藏”在转弯时只是轻轻地把”脚”从制动踏板上抬起来,而不是猛踩油门。研究人员说,这是技术限制的结果,也是出于谨慎,但结果是,转弯花了大约两分钟。

“武藏”确实在另一项实验中使用了加速器。但它很难保持稳定的速度,这取决于道路坡度的陡峭程度。

因此,显然还有一些工作要做。

- 他们已经准备好迎接挑战,并计划开发下一代机器人和软件。

- 也许几十年后,”武藏”将成为你下一辆东京出租车的驾驶员。

让人形机器人学开车,肌肉和骨架跟人很像

- 自动挂挡、踩离合、拉手刹,每个动作都依靠AI驱动,快速适应人类方向盘和刹车

- 目前只能开老头乐,不能合法上路

汽车品牌格局

观点

- 车企蔚小理都不行,目前就

特斯拉和比亚迪稳,后者主阵地在海外,汽车是生态系统。 - 实体机器人行业刚起步,尚未经历市场考核,预计要倒一大批

智能驾驶

【2024-2-24】2024,智能驾驶决战元年

新能源汽车

- 2023年汽车总销量已经突破3000万辆,同比增长11.7%,而新能源汽车更是以惊人的36.5%的增长率领跑

- 尽管汽车市场经历了降价竞争的风波,但新能源汽车凭借不断优化的电池技术、智能化配置等方面的进步,成功夺得了市场的认可,为整个行业的增长做出了重要贡献。

- 新能源汽车仍然是行业增长的主要动力,为车企们提供了市场空间基础。

- 热门车型:理想系列(MEGA)、华为智选车(智界S7,问界M9)、小鹏G6等成功赢得市场青睐

自动驾驶领域

- 华为和小鹏等公司率先发起了城市NOA(自主导航)的竞争。尽管高阶辅助驾驶功能在市场上的渗透率仍较低,但随着更多车企的加入和技术的进步,这一趋势有望在2024年加速。

- 我国对L3级别自动驾驶的政策放开,也将推动更多品牌参与智能驾驶技术的研发和落地。

座舱领域

- 智能汽车厂商将继续加强与其他智能设备的互联互通,并引入更多AI大模型,重新定义智能座舱的交互体验。

车机智能化方面

- 不同厂商将展现出各自的特色,如华为的鸿蒙车机和小米搭载的澎湃OS。此外,引入AI大模型将成为智能汽车厂商的一项重要策略,以提升座舱智能化水平,为用户提供更加智能的服务和体验。

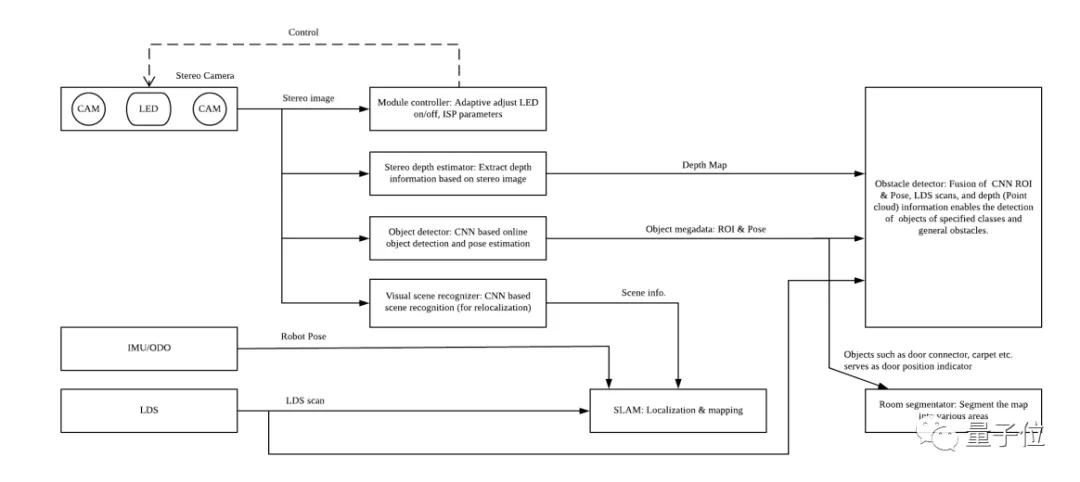

扫地机器人

【2020-11-5】扫地机器人“离家出走”的真实原因找到了:差个自动驾驶算法

- 机器人想要避开物体(如数据线、猫狗),用目标检测算法不就行了?

- 但目标检测算法只能识别已知物体,无法识别、测量未知物体的距离。

- 想让机器避障,除了检测特殊目标,还需要自动驾驶技术中的一项核心算法三维感知,即判断障碍物距离和三维尺寸(体积大小)的能力。

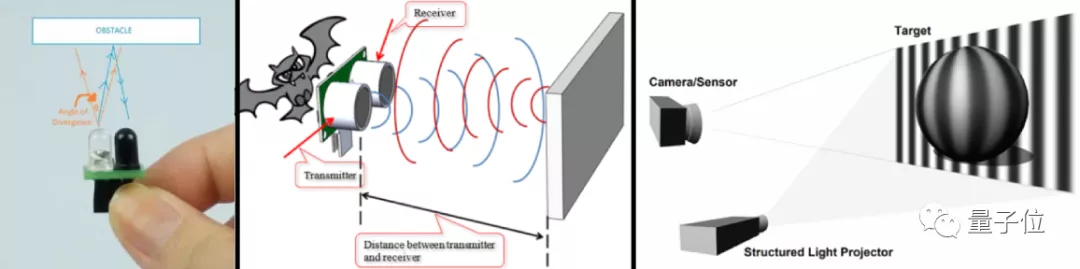

- 深度感知用到的测距方法有很多,包括红外、超声波、激光、3D结构光、3D ToF、单目视觉、双目视觉等。

- 自动驾驶避障核心:双目视觉算法

- 如果只有单目(只用一只眼睛,利用时间和判定框大小变化去测量距离)的话,机器也有办法判断距离,但就与人一样,没办法判断得那么精确。

- 多个雷达全方位感知,机器就拥有了“神之视角”,每个角落都能看得清清楚楚。然而,它造价太昂贵。如果在机器人身上装上可以无死角扫视房间的雷达数量,它就变成了“行走的小金库”,价格让人无法直视。

- 红外、超声波等算法,避障精度不如双目准确;

- 至于3D ToF、结构光等算法,不仅成本高,需要额外配摄像头做目标检测,而且没有区分物体的能力,只能通过大小判断障碍物。(例如,薄薄的袜子可能就被误吸了)

- 这也是为什么,双目视觉算法在无人车与无人机领域“备受欢迎”。

- 双目视觉原理

- (1)3cm以上:结合LDS,障碍物全识别

- 机器的“眼睛”,通俗点来说就是各种大大小小的传感器。(激光雷达、相机后面的传感器)

- 传感器通常的工作原理,是机器(在角α顶点处)发射红外线、超声波、激光,通过“眼睛”(下图角β的顶点)接收到后,再根据反射回来的角度、相位或时间,来判断距离(d)。

- 原理就两步:

- ①确定视差,即将两个相机拍下来的照片进行对比,找出两张照片中相同的点间像素差

- ②基于视差,通过已知的双目空间几何关系,计算立体空间中各点的距离。

- 原理就两步:

- (2)3cm以下:目标检测算法的最强“辅助”

- 不过,在实际应用中,单靠双目视觉算法和激光雷达,还远远不够。

- 小于3×5厘米的物体,会比较麻烦,既要区分出要清扫的部分(纸屑、地毯)、又要避开一些容易缠住的障碍(数据线)。

- 这种情况下,双目视觉算法就成了最好的“辅助”:协助目标识别算法,将需要避开的物体检测出来,准确地区分垃圾与障碍物。

- 目标检测模型上,T7 Pro自研的神经网络借鉴了SSD,YOLO,及CenterNet等多种新型模型,目前还在不断地迭代。

- 算法上,石头采用了“一分为二”的待遇:高于3厘米的物体,绕障碍物边沿避障和清扫;小于3厘米的物体,按种类进行清扫(纸屑、地毯)或避障(宠物便便、数据线)。

- 数据集上,石头也“别有用心”:选出了一些特殊的物体,进行“有差别对待”。例如,大家都有所担心的动物便便,石头T7 Pro的算法中直接加入了便便的识别(同情做数据集的一秒钟),在接触之前,远远地就避开它。

- 双目视觉算法仍然有缺点

- 受光线影响依旧很大。所以在光线不足时,就用算法去主动“补上光线”。

- 以石头T7 Pro扫地机器人的算法为例,双目视觉模块分为视觉控制和深度估计两部分,一个智能补光,一个估计深度。(甚至专门做个红外拍出的相片,搞成数据集,训练补光识别效果)

- 自动驾驶算法,也绝不仅仅只靠“两只眼睛”。

- 与人类不同,无论是自动驾驶汽车、无人机、还是扫地机器人,都可以说是“全身遍布”着眼睛。

- 其中就包括LDS(激光雷达)。当双目视觉算法遇上激光雷达(能搞定所在高度的平面避障),在二者的结合之下,机器人不仅能完美避开3cm以上的障碍物,还能通过它们“找准自身定位”。

- 此外,激光雷达也会用在SLAM的建图和定位上。

- 从深度感知部分来看,扫地机器人深度感知的原理,与无人驾驶算法有着相似之处:

- 如下图,算法包含三大部分,第一部分是传感器数据的获取,第二部分是信息的提取,第三部分是独特导航算法的融合(后融合)。

- 但并不意味着扫地机器人的算法与无人驾驶汽车的算法一样。

- 在实际应用上,扫地机器人需要“近距离避障”(晚点刹车,扫得更干净),自动驾驶汽车则相反,需要以“安全”为主(尽早刹车)。

- 所以,虽然二者的避障核心都是自动驾驶中的双目视觉算法,但数据处理方式不同。

- 从根本上来说,它们都是智能机器人,为了让生活变得更方便而存在。

微软系自动驾驶公司

微软亚洲研究院一直被称为「IT界或人工智能界的黄埔军校」,在 NLP 领域亦是如此。现在中国各大公司的 NLP 组,有世界级的专家带领,也服务于世界级的任务,无论是文章发表还是产品,都是世界级的水平。这个事实背后,我想说跟与微软亚洲研究院在中国恰逢其时地推动了这个领域的发展有巨大的关系。

过去的 20 多年,微软亚洲研究院在 NLP 领域培养了超过 500 名实习生、20 名博士生、20 名博士后,绝大多数都去了学校或其他公司。这些人也都逐渐成为了所在单位的技术核心或者领导人物;他们又带动了更多人的成长。

微软亚洲研究院培养出来的知名学者和业界专家数不胜数,包括张亚勤、张宏江、沈向洋、洪小文、王坚、马维英、汤晓鸥、孙剑、王海峰、林斌……

-

-

【2021-6-17】17 位「前」微软人,成就了中国自动驾驶又一个黄埔军校, 谷歌孵化Waymo、亚马逊并购Zoox、苹果重启泰坦计划时,微软却迟迟按兵不动, 直到2021年1月20日,微软联合通用与本田,为一家名叫Cruise的自动驾驶初创公司注资20亿美金,直接将后者的估值推上 300亿美金新台阶。微软的自动驾驶进程稍显徐缓,但不少前微软人却早已涌进了这个领域。

- (1)文远知行:

钟华、李岩:- 工程资深副总裁的钟华,加入文远之前,曾任职谷歌及西门子研究院,也是微软亚研的最早期成员之一,1998年底,从清华大学计算机系毕业的钟华加入微软亚研担任核心工程师,其直系领导是沈向洋。

- 联合创始人兼首席技术官李岩,1998年从清华大学计算机系毕业后去了刚成立的微软亚研。他是微软亚研的前15名员工,期间一直任资深工程师一职。他当时的直系领导也是沈向洋,而第一任院长则是李开复。

- (2)飞步科技创始人:

何晓飞- 2000年,何晓飞前往芝加哥大学攻读计算机博士学位,之后以实习生的身份进入微软亚研。微软亚研期间,何晓飞跟随张宏江、马维英攻克两大方向:一是跟张宏江做人脸识别的相关研究;二是跟马维英做信息检索的研究。

- 2003年,他与相关单位合作提出laplacianfaces人脸识别算法。中国大陆在NIPS上获奖的第一篇论文(除了港台地区)

- 2015年,何晓飞出任滴滴高级副总裁、研究院创始院长、无人车业务领头人,正式在自动驾驶领域一展拳脚。

- 之后,不甘于袖手旁观人工智能创业的汹涌浪潮,何晓飞决定造一叶乘风破浪的帆船投身其中。

- 离开滴滴后,何晓飞于2017年8月创立自动驾驶公司飞步科技,专注于港口、码头的无人驾驶货运。飞步科技与中国邮政、德邦物流达成合作,并与宁波舟山港集团共同落地了行业首个混线工况下的自动驾驶集卡编队独立整船作业。

- 近日,飞步科技还宣布完成B轮数亿元融资

- (3)地平线CEO:

余凯- 1998年和2000年,余凯分别在南京大学获得学士和硕士学位。

- 2002年,余凯以实习生的身份加入微软亚研,与上文所提的何晓飞成为同事。当时,他主要进行图像搜索方面的研究。而后,他前往德国慕尼黑大学攻读计算机科学博士学位。之后,他先后加入西门子担任数据挖掘部门的资深研究员、美国NEC研究院担任部门主管。

- 2012年,他加入百度并推动百度深度学习研究院的成立。在余凯的影响下,彼时吴恩达等人工智能界的大牛也相继加入百度。

- 2015年,余凯离开百度,创立地平线。后者专注研发基于人工智能算法的芯片、系统和软硬件产品,让家居、汽车、服务机器人等,具有从感知、交互、理解到决策的智能功能。

- 近日,地平线的第三款车规级芯片”征程5”提前一次性流片并成功点亮。6月11日,地平线完成高达15亿美元的大C轮融资,投后估值高达50亿美元

- (4)智加科技中国区总经理:容力

- 上世纪九十年代,大数据应用尚未普及,容力当时主要利用大数据计算为工业提供智能化服务。第二波互联网浪潮兴起之后,容力选择投身数字广告行业。

- 2006年,容力回国加入微软亚洲工程院数字广告部门。在微软工程院期间,他带领团队负责搜索广告、基于用户行为的广告定向、基于搜索的广告重定向以及内容广告等产品开发工作。

- 此后,容力曾在雅虎北京研发中心,美国全球通讯公司Comcast及其子公司工作。

- 目前,容力在智加科技担任集团工程高级副总裁、中国区总经理,全面负责智加科技中国的日常运营管理及业务发展。

- (5)超星未来CEO:张剑

- 张剑毕业于清华大学计算机科学与技术系,本科毕业后选择直博,是国内第一批人工智能专业博士。

- 2001年,张剑加入成立不久的微软亚研,专注于机器学习、自然语言处理等方面的研究。在微软亚研工作期间,他获得TREC9竞赛两个项目的冠亚军。

- 2002年,张剑抱着对技术和创业的热情加入了百度,成为了百度最早一批核心技术骨干,主要带领团队对搜索引擎算法不断优化。

- 此后,他任职于清华大学车辆与运载学院,并曾担任一汽启明北京研究院副院长。从事人工智能与汽车电子方向的核心研发和技术团队领导工作。

- 2019年,超星未来正式成立。值得注意的是,成立仅两个月,超星未来就收获了多方资本的天使轮投资。

- (6)Momenta创始人:曹旭东

- 出于对人工智能研究的热爱,曹旭东在清华读博期间一度想前往国外深造。”当时我一心扎入人工智能计算机相关的课程,哪怕自己上课、看书、查文献都乐在其中。”曹旭东曾如此形容他对于AI的狂热痴迷。当时,曹旭东还在微软亚研实习,项目领导得知这一想法后对他说:”即使在美国读完人工智能方向的博士,去工业界的最好选择之一依然是微软亚研。” 这一番话打消了曹旭东的留学念头,他继续留在微软亚研担任研究员一职。

- 在这期间,曹旭东参与研发的成果广泛用于 Xbox、Bing、How-Old等知名产品中,其中现象级产品 How-Old 影响着数亿用户。

- 五年后,曹旭东选择加入商汤科技。

- 但不久之后,他就离职商汤,创立了自动驾驶公司Momenta。得益于其良好的技术背景。这家公司在成立两年左右的时间里便获得了超过2亿美元的融资。

- 今年三月,Momenta又迎来了新一个成长节点,他们宣布完成C轮总计5亿美元的融资。

- 相比起赛道内大多数玩家一开始就高举高打 L4 的技术路线,Momenta 创立之初就秉持着「量产数据+ 数据驱动的算法+闭环自动化工具链」一个飞轮的技术路线,和「量产自动驾驶 + 完全无人驾驶路线」两条腿走路的产品战略打法,志在实现无人驾驶规模化落地。

- (7)Wayz.ai创始人:陶闯

- 武汉测绘科技大学(现武汉大学)硕士毕业后,他于1995年赴加拿大卡尔加里大学攻读博士,并参与世界最早的移动街景测图系统的研发,拿下七项国际大奖。在加拿大两所大学任教的同时,他还被加拿大政府聘为联合国IAEA核能源署顾问。

- 此后,他创立的GeoTango公司在2005年被微软收购。他也因此加入微软,成为微软虚拟地球部的创建者及管理者。基于对三维地图的深入研究,陶闯带领微软团队建造了基于云计算的微软地图全球平台,为微软取得了全球企业领域近70%的市场份额。

- 2008年,他开始负责微软亚太区互联网地图和本地搜索业务,直接参与建立亚太区移动搜索和在线地图产品的研发和市场拓展团队。

- 2017年初,陶闯创办了提供位置智能服务解决方案的Wayz.ai,提供智慧零售、智慧营销、智慧出行、智慧城市多种解决方案。在出行方面,Wayz.ai可提供车辆高精定位、反向寻车、自主泊车多种服务,目前已经与一线车厂、后装市场、汽车科技、出行服务商达成合作。

- (8)商汤科技:汤晓鸥、杨帆、徐立

- 1996年从麻省理工学院博士毕业后,汤晓鸥受邀在香港中文大学信息工程系任教。

- 2001年,汤晓鸥创立了香港中文大学多媒体实验室,为商汤科技的成立埋下伏笔。

- 2005年-2007年,汤晓鸥接受时任微软亚研院长沈向洋的邀请,成为微软亚研视觉计算组负责人。在微软亚研期间,汤晓鸥带领团队在计算机视觉领域的三大顶会ICCV、CVPR、ECCV累计发表了60多篇论文。

- 离开微软亚研后,汤晓鸥加入了深圳先进技术研究院多媒体集成技术研究室,担任主任和研究员。香港中文大学多媒体实验室终于迎来丰收时期。在2011~2013 年间,汤晓鸥团队在ICCV和CVPR上累计发表了14篇深度学习论文,而当时这两大会议在深度学习方面的论文总数不过29篇。

- 2014年11月,商汤科技正式成立,汤晓鸥团队中的50多名博士、博士后先后加入其中。除此之外,还有汤晓鸥微软亚研工作时期的同事杨帆。杨帆于2006年毕业于清华大学电子工程系,刚毕业的他就加入了微软亚研创新工程组。当时,他主要负责视觉算法的产品转化工作。在微软亚研9年的工作中,他曾参与Xbox、Kinect、Windows Hello、Bing图像搜索、视频编辑软件Movie Maker等数十项视觉新技术产品模块研发。2014年,杨帆接受了汤晓鸥的邀请,成为商汤科技的联合创始人、副总裁。

- 在商汤科技的创始人团队中,徐立也是其中一员。2007年,徐立毕业于上海交通大学计算机科学与技术专业,获硕士学位。2008年,徐立获得比尔·盖茨亲自颁发的”微软学者奖学金”,并得到在微软亚研实习的机会。微软亚研院实习结束后,他曾先后在摩托罗拉研究院、欧姆龙研究所、联想研究院等计算机视觉基础研究机构进行访问、工作。

- 2010年,徐立决定放弃所有工作,前往香港中文大学攻读博士,主要研究计算机视觉和计算机成像学。

- 2014年,他在同学邀请下参观了当时还未成立的商汤科技。一番考虑之后,徐立决定接受汤晓鸥的邀请,成为商汤科技的联合创始人、CEO。

- 今年的上海车展上,商汤科技带着 SenseAutoCabin智能车舱解决方案、SenseAuto Pilot自动驾驶解决方案重磅亮相,超过50+OEM 、20000+观众深度体验。据商汤科技预估,SenseAuto Pilot-P驾驶领航方案在 2022 年底到 2023 年初将搭载上量产车。

- (9)禾多科技CEO:倪凯

- 倪凯参与了微软三维地图和HoloLens增强现实眼镜的研发项目。除此之外,他还曾经是微软机器人项目组的成员,和知名的软件设计师George Chrysanthakopoulos 共同工作。

- 告别微软后,倪凯先后加入百度无人车项目、乐视汽车。正是这两个工作经历,使他得以从人工智能,以及汽车行业的角度审视当时方兴未艾的自动驾驶。

- 2017年,倪凯创立禾多科技。提出 Level 3.5 级别的系统标准:研发一个准 Level 4 级别的系统,但在产品中降维为 Level 3 系统来使用。他们称之为Level 3.5 自动驾驶系统,这是禾多科技成立之初研发的核心目标。团队认为,这才是真正从用户角度出发打造的好产品。

- (10)中科慧眼联合创始人:姜安、崔峰

- 姜安是中科院自动化所计算机应用技术专业博士,研究方向主要是图像处理和模式识别。2003年博士毕业后,姜安先后就职于中国科学院自动化研究、诺基亚。

- 2013年,微软收购诺基亚手机业务,姜安因此成为微软移动的一名图像处理算法专家,从事信号处理、图像/视频处理、模式识别等相关领域的研发工作。姜安在微软移动工作仅一年时间,便迎来了大裁员,后者软件团队裁员高达90%以上。怀着”老是给资本家打工,还不如我自己干”的愤懑,姜安与同事崔峰在2014年10月共同创立了中科慧眼。

- 崔峰先后在三星、诺基亚工作,随后来到微软移动担任图像处理算法专家及算法团队技术经理。在创立中科慧眼之前,姜安和崔峰曾创业推出了两款围绕图像和视频相关的 App。由于缺乏资金推广又遭遇股灾,他们的创业项目发展坎坷。股灾过后,他们发现市场环境发生改变,流量并不一定带来盈利,姜安和崔峰不得不另寻出路,有了创业失败的前车之鉴,他们想做一款看得见摸得着的产品,同时”还能卖钱”。姜安提到创立中科慧眼的原因时曾表示:”毕竟是老博士团队,有技术功底,可以做更好的事情。” 这个”更好的事情”便是 ADAS,而图像是他们的老本行。从手机 App 到双目 ADAS,姜安觉得两者的核心的依然是图像识别处理技术,技术原理基本上相通。更重要的是,姜安发现 ADAS 是一个亿级别的市场。中科慧眼在此背景下成立,姜安与崔峰分别担任CEO、CTO一职。

- 中科慧眼主要从事汽车自动驾驶双目感知系统及相关产品研发,在车载产品和立体视觉开发平台方面已推出多款产品。

- (11)深动科技:蔡锐、李志伟、杨奎元

- 蔡锐本科至博士期间都在清华大学计算机系度过。博士毕业后,他曾在微软亚研担任主管研究员。在此期间,蔡锐参与了微软当时的明星项目Hololens,主要负责通过深度摄像头对显示物体进行3D重建。李志伟在微软亚研也担任主管研究员,主要研究立体视觉、机器学习、数据挖掘、多媒体信号处理等领域。而在Hololens项目中,他主要负责视觉SLAM部分。据蔡锐介绍,他们是国内唯二参加此项目的人员。

- 杨奎元是中国科技大学自动控制博士,于2012年毕业后加入微软亚研。他曾担任微软亚研研究员,参与了必应搜索、微软小冰实现图片识别与搜索功能的研发。三位联合创始人在微软亚研工作均超过五年。

- 2017年,他们集体离职,联合创立了自动驾驶解决方案公司深动科技。对于此事,蔡锐表示:”很可惜的是,微软亚研在自动驾驶领域并没有很多投入,而自动驾驶是行业发展的必然趋势,我们想顺应这个趋势,就决定出来试一试。”

- 深动科技围绕高精地图,提供以环境感知、高精地图构建以及高精定位为主的自动驾驶解决方案。目前,深动科技已开发了自主代客泊车、智能感知、高精定位、高精地图四大核心产品。

- (1)文远知行:

飞步科技

- 【2021-5-24】爆料:浙大AI教授何晓飞再获数亿投资

- 2017年创办的飞步科技,总部位于杭州的自动驾驶公司,滴滴研究院创始院长、浙江大学教授何晓飞的创业项目。近期已完成了数亿元B轮融资

- 飞步的自动驾驶轻卡,已经为在城市及高速道路累计为中国邮政EMS、德邦快递等企业运送包裹超100 万件。另一大落地场景——自动驾驶微公交接驳也被一同曝光——还是已经连续两年为乌镇世界互联网大会提供服务的那种。

- 最核心的自然是飞步自主研发的自动驾驶全栈系统。该系统完整覆盖感知、定位、控制、规划等技术,是行业内适配最多商用车型的自动驾驶系统。据称自2018年以来,飞步的自动驾驶系统相继经历了货运物流、公交接驳、港口运输等不同场景下的应用验证,逐步积累了海量、多场景、复杂的多传感器数据,为系统的快速迭代奠定了扎实的基础。

- 面向落地和规模化商用,飞步的云调度平台也被曝光。同样出自飞步自研,该云端智能调度平台,提供供需匹配、运力调度、路径规划等核心功能。该平台的另一亮点,是在人机共驾的过渡阶段,能够实现有人驾驶与无人驾驶的混合调度。

- 全球无人驾驶落地尚未成熟,不管是技术还是政策准入,现阶段无法直接上马全无人自动驾驶,所以如何在“有人”向“无人”实现过渡,也就成为了货运等强商用导向场景的题中之义。

- 在实际落地中,飞步的车路云一体化协同平台支持毫秒级响应,厘米级精度,日均千万级车货(人)匹配计算,以及基于动态高精度地图的实时路径规划。目前,飞步的车路云一体化协同作业方案在宁波舟山港率先成型,将通过全球最大规模的港口自动驾驶集卡车队,在混线环境下实船作业运营。飞步被关注更多的是货运场景的进展,但在微公交和车企如一汽、万向等出现在最新进展公告后,也意味着飞步开启了更多元场景、更多维度自动驾驶能力的落地及释放。飞步,已不单单是货运自动驾驶,也不单纯只有自建AI卡车车队路线。

演示:

小马智行

- 【2021-5-24】国内初创公司Pony.ai获准在加利福尼亚测试无人驾驶汽车

滴滴

自动驾驶是未来出行的必然趋势,大公司蜂拥而入,无人车行业的共识是仿真里程和路测里程同样重要。而滴滴针对仿真系统的优势在于:

- 1、数据规模足够大;

- 2、采集成本足够低。

Waymo与滴滴路测里程的对比:

- 1、waymo的仿真时间长,我们去年下半年开始量产;

- 2、算法:fuzzy algorithm,我们全是真实情况,如果加,也可以;

- 3、高精地图覆盖区域

仿真&路测

- Rand:110亿英里

- Waymo: 路测:十年:2000万英里. 仿真:截至2019年7月就已经完成了100亿英里

- Apollo 2019.12 300万公里

- 滴滴 2018 488亿公里,上线两个城市苏州+上海,场景数目70w+,虚拟里程累计21w公里

- 2018/12,与voyager对接

- 2019/1,苏州实验

- 2019/5,苏州1k+

- 2019/9,10w+

- 2019/10,上海-安亭

- 2020/2,70w+

Tesla

2003年7月1日,马丁·艾伯哈德和马克·塔彭宁创立特斯拉汽车公司(Tesla Motors),创始人将公司命名为“特斯拉汽车(Tesla Motors)”,以纪念物理学家尼古拉·特斯拉。工程师莱特(Ian Wright)加入成为公司的第3号员工。

特斯拉汽车的创立初期以台湾新北市为重要生产基地,公司人数一路由20人增至150人,于2008年2月方正式生产出7辆“创始人系列”,2008年10月第一批TeslaRoadster投线生产,2009年响应奥巴马补贴政策,特斯拉正式关闭台湾分公司,将产线移回加州费利蒙市的新工厂。

2004年,伊隆·马斯克以A轮投资人的身份加入这家公司,并且雇用了锂电池专家史特劳贝尔(JB Straubel)而组成公司早期的团队。

2007年8月,时任公司CEO的创始人艾伯哈德宣布辞职,11月,艾伯哈德被逐出董事会,转由Michael Marks接任临时首席执行官(第二任)。

2007年11月末,Ze’ev Drori 接任成为新的首席执行官(第三任)。另一位创始人塔彭宁则先后担任公司的首席财务官、副总裁等职位直到2008年,二位创始人先后离开特斯拉,2008年10月马斯克成为特斯拉CEO(第四任)。

特斯拉车型概览

- 2008 第一款车 Tesla Roadster

- 2012 第二款车 Tesla Model S

- 2015 第三款车 Tesla Model X

- 2017 第四款车 Tesla Model 3

- 2020 第五款车 Tesla Model Y

- 2022 第六款车 Tesla Cybertruck

- 2023 第七款车 Tesla Semi Truck

- 2023 第八款车 新版Roadster

- 2023-2024 第九款车 Model Q

| 时间 | 车型 | 类型 | 价格(美金) | 图 |

|---|---|---|---|---|

| 2008 | 第一款车 Tesla Roadster | 跑车 | 10w |  |

| 2012 | 第二款车 Tesla Model S | 轿车 |  |

|

| 2015 | 第三款车 Tesla Model X | 轿车 |  |

|

| 2017 | 第四款车 Tesla Model 3 | 轿车 | 25-34w |  |

| 2020 | 第五款车 Tesla Model Y | 轿车 | 30-40w |  |

| 2022 | 第六款车 Tesla Cybertruck | 卡车 |  |

|

| 2023 | 第七款车 Tesla Semi Truck | 重型卡车 | 15w |  |

| 2023 | 第八款车 新版Roadster | 跑车 | 20w |  |

| 2023-2024 | 第九款车 Model Q | 轿车 | 2.5w |  |

【2023-1-11】HydraNet——特斯拉自动驾驶强大的人工智能神经网络模型

Tesla 车型

Tesla Vision

特斯拉的自动驾驶仪是目前最先进的计算机视觉系统,从自动驾驶汽车最重要的功能,车道检测到行人跟踪,再到信号灯识别等等,它们必须涵盖所有道路信息,并预测每种情况。因此特斯拉发布了“ Tesla Vision ” 相机制成的感知系统,特斯拉的计算机视觉新系统只配备了8个摄像头……

特斯拉的计算机视觉系统。车辆周围的 8 个摄像头(左,搜集车周围的影像)通过神经网络生成 3 维“向量空间”(右,生成最终的车道信息),代表自动驾驶所需的一切信息,如线条、边缘、路缘、交通标志、红绿灯、汽车;汽车的位置、方向、深度、速度等等信息,而这一些的实现,只是特斯拉上面的8个摄像头与自动驾驶系统来实现的。其中自动驾驶系统中,最重要的便是来训练处理8个摄像头采集到的影像信息的神经网络模型了。

这种纯计算机视觉的应用,使其成为世界上唯一不使用雷达的自动驾驶公司之一

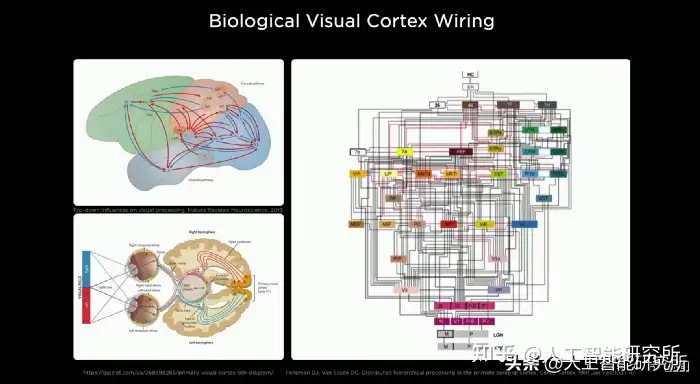

Hydranets

最初研究计算机视觉时,人们参考了人类的视觉系统,当眼睛搜集的信息到达视网膜后,经过大脑皮层的多个区域、神经层,最终形成生物视觉,我们才能在脑中生成图像。

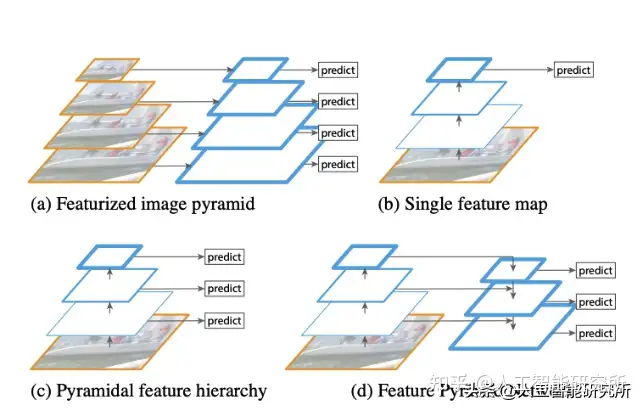

计算机视觉系统就是参考这样的设计来设计目前的计算机视觉神经网络系统,而计算机视觉任务中,物体检测一般有如下通用的结构:

- Input → backbone → neck → head → Output

Backbone:指特征提取网络,用于识别单个图像中的多个对象,并提供对象的丰富特征信息。常用 AlexNet、ResNet、VGGNet 作为骨干网络。- 检测头(

head):在特征提取(骨干)之后,提供了输入的特征图表示。对于一些实际的任务,比如检测对象、分割等。通常在特征图上应用一个“检测头”,所以就像一个头附着在主干上。 neck:颈部位于主干和头部之间,用于提取一些更精细的特征。(例如特征金字塔网络(FPN),BiFPN)

在目标检测任务中,特斯拉最初用了一些手动设计的网络,例如 AlexNet、VGG、ResNet、DenseNet等神经网络主干。后来,随着数据规模和网络深度的增加,相关特斯拉研究人员开始考虑使用半自动化网络设计和自动化网络设计来代替人工网络设计

2020 年 Facebook 人工智能研究 (FAIR) 论文Designing Network Design Spaces中提出了一种新的神经网络Regnet(正则网络结构)。经过神经网络主干处理后,RegNet给出了不同尺度、不同分辨率的多个特征。在这个特征提取网络中,在最底部,我们有非常高的分辨率和非常低的通道数,而在顶部有高通道数,且低分辨率。所以底部的神经元用于检查图像的细节,顶部的神经元用于理解场景上下文(语义)信息. 正是RegNet神经网络这样的特性,特斯拉使用 Regnet(正则网络结构)作为其神经网络主干。

Hydranets——特斯拉的疯狂神经网络

检测头部分,特斯拉由于要在一个神经网络中,需要检测很多任务,比如车道线检测,人物检测与追踪,信号灯检测等等,而以往的计算机视觉任务中,我们的神经网络最终只有一个输出头,要么是对象检测,要么是实例分割,等等,显然,在一个自动驾驶系统中,这样的神经网络不太实用,且我们也不能同时运行多个神经网络模型来控制自动驾驶系统,这样的话,很容易引起神经网络之间的问题,计算机视觉系统处理也很困难。

特斯拉将这些任务融合在一个新的架构中,有一个共同共享的主干并分支成多个头。这种架构称为 HydraNets。简称九头蛇网络,当然,并不是输出只有9个头,毕竟自动驾驶的计算机视觉任务,不是9个头就可以处理的。

- 1、所有 8 幅图像首先由图像提取器处理。为此,使用了类似于 ResNet 的架构,Regnet(正则网络结构)

- 2、然后是多机位融合。这个想法是将所有 8 个图像组合成一个超级图像。为此,HydraNets使用了类似transformer的架构。

- 3、时间融合。这个想法是将时间带入神经网络,并将超级图像与所有先前的超级图像融合在一起。为此,有 N 个图像的视频队列。例如,如果他们想用 2 秒进行融合,并且假设摄像机以每秒 30帧的速度工作,N 将为 60。时间融合是使用 3D CNN、RNN 或 Transformer 完成的。

- 4、最后,输出被分成 HEADS。

注意:

- 正如上图所看到的,整个神经网络模型都被分成了左右2部分:这实际上是神经网络模型在 2 个芯片上并行运行的方式.

HydraNets 具有三个主要优点

- 特征共享:减少重复卷积计算,减少主干数量,在测试时特别高效

- 解耦任务:将特定任务从主干中解耦,能够单独微调任务

- Representation Bottleneck:训练时缓存特征,在做微调工作流时,只使用缓存的特征微调头部

HydraNet 训练工作流程:

- 1、进行端到端培训,他们共同训练所有内容

- 2、在多尺度特征级别缓存特征。

- 3、使用缓存功能微调每个特定任务

- 4、再次进行端到端培训并进行迭代。

视频是一个版本的 HydraNet 中处理单个图像得到的一些预测

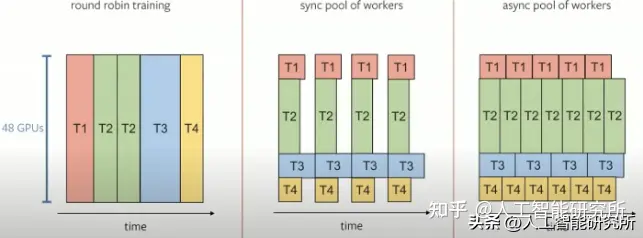

特斯拉如何训练 Hydranet?

- 在 GPU 上训练一个有 48 个头的神经网络需 70,000 小时!差不多8年了,特斯拉团队为了解决这个问题,把训练模式从 “round robin”模式转换为“pool of workers”模式.这样就大大缩短了训练时间,且我们从HydraNets神经网络架构中知道,特斯拉还使用了双MCU架构,并行处理。

Transformer模型作为NLP与图片视频领域中,最重要的模型构架,在最近今年越来越受到了重视,虽然Transformer模型刚开始设计,是在NLP领域,但是随着VIT模型,以及SWIN模型的发布,把Transformer模型也有效的应用到了CV计算机视觉领域,让Transformer模型也能够进行CV领域的任务处理

Nikola

【2023-2-26】【奇闻】新能源汽车惊天骗局-风口上的电动汽猪, offer帮创始人Lindsay, 米尔顿,市场营销背景,毫无技术准备,视频作假,电动货车,哄骗投资人,2020年跟壳公司一起上市,股价疯涨,一周翻5倍,尽管一辆车都没造出来,市值就超过了福特,直至被做空机构hindenberg research揭穿谎言:我从没有见过一家上市公司如此欺诈!美国司法部提起三项诉讼,判了25年,投资人的钱打了水漂。

- 贾跃亭PPT造车,贾跃亭的大前辈——Nikola。 一辆车都没造出来,就吸引到上亿投资,甚至还上市了,它是如何做到的?

蔚来汽车

世界模型 NWM

【2024-7-29】蔚来世界模型NWM 万千平行世界寻找最优解

2024年7月27日,NIO IN 2024 蔚来创新科技日上,蔚来正式发布——中国首个智能驾驶世界模型 NWM(NIO WorldModel),即可以全量理解信息、生成新的场景、预测未来可能发生的多元自回归生成模型。

NWM 可以在100毫秒内,推演216种可能发生的轨迹、寻找最优路径;还能基于3秒钟视频的Prompt输入,生成120秒想象的视频。

世界模型是智能驾驶技术在「BEV&Transformer」、「占用网络 OCC」、「端到端」等技术后,又一次跨越式的进步。

世界模型具备对信息的全景理解力,在想象的维度理解物理规律,并重建世界。

通过构建人类大脑的复杂认知过程,模拟人类感知和决策过程,为自动驾驶系统提供预测和适应动态环境的能力。

大脑是如何认知并想象的?

大脑通过眼睛接收光线,转化为电信号,沿视神经传至大脑后部的视觉皮层,解析成图像。

- 基于「空间理解」进行「想象重建」

- 再基于「时间理解」进行「想象推演」。

通过多个脑区整合视觉信息与其他感官数据,形成对世界的深层理解。

想象力则利用记忆和思维,通过海马体等结构的回忆重播,自由拼接形成独特的内容,创造出超越现实的视觉概念,是大脑对认知的自由扩展和创新。

观察榕树时,眼睛先看到了生长的树干、树枝以及绿叶,「记住」了这些结构和颜色特征;当我们闭上眼在脑海里回顾时,则是在「重构」这幅画,可能会忽略一些不重要的细节,但能将基本特征描述出来。甚至,我们可以「想象」这棵树在不同角度的样子,微风吹拂,树枝与树叶如何摆动。

更多内容见站内专题: 大脑认知过程

世界模型NWM 的核心能力正是这两点:

- 认知世界后,在模型内进行想象重建;

- 基于信息的理解,进行想象推演,从而规划轨迹。

自动驾驶在空间理解层面的进化史,在想象重构之前,智能驾驶算法多次升级了空间理解能力。

- 2020年之前,感知算法只能进行2D/3D检测,即分辨特定对象、确认三维空间位置,并提取车道线。

- 2022年,行业进化到「

BEV」算法,将所有摄像头信息聚合到一个环境中,通过一张鸟瞰图俯瞰周边,动态感知更精准。- 但是,BEV 算法的框架还是二维的,高度信息不足,无法感知异形物体。

- 2023年开始,行业引入「占用网络

OCC」算法,对环境的感知升级为三维化描述,类似在「我的世界」里认知世界。- 但OCC感知缺失表面材质信息,对细小物体等不确定性的描述不足。

- OCC之后,空间理解能力的再次升级方向,是「重构世界」。

- 世界模型

NWM 后,模型实现了三点优化:

- 全量理解信息,空间认知能力更强

- 能够预测接下来的场景

- 生成式无监督的方式,对海量数据的利用更加高效

而这三个基本特征,也就形成了「多元自回归」生成模型——NWM

通过自回归的方式,NWM 重建原始传感器信息的输入,在其中自动学习知识和物理规律;做到全量信息重建,想象重构世界,泛化能力更有保证。

NWM 在脑海里的想象的画面、物体之间的相互运动关系,都符合物理世界的基本逻辑。NWM所关注到的信息,也只在关注「重点」,例如即将切入进来的车辆。就像人类开车,会关注到前方的车辆、道路结构,余光还能感受到路边的绿植、道路上方的广告牌,但不会直接去关注广告牌上的画了什么画、写了什么字。

「蔚来世界模型 NWM」还具备与生俱来的闭环仿真测试能力,在一系列极具挑战性的道路环境中,全面测试并验证性能,涵盖各种复杂交互场景。

NWM 可生成120秒的预测视频,生成能力已经超越了很多视频生成AI 软件。

此外,NWM 还有三点对于智能驾驶来说更需要的能力:

- 想象画面真实。还原物理世界,动态物体和静态物体之间的关系,符合大家对于真实场景的认知。

- 整体场景多变。视频生成软件给出的视频只有简单的一个运镜,场景相对简单,NWM产生的视频场景丰富度高、更多变

- 能生成决策。有轨迹waypoints 有方向角度有加减速,使得NWM生成是带驾驶动作决策的生成

作为智能驾驶专用的世界模型,在驾驶场景中NWM有最强的生成能力,比Sora更强。

人事关系

【2023-3-23】蔚来自动驾驶没有内斗

- 蔚来中美两地离心离德,

伍丝丽带领的北美团队几近失控、蔚来NIO Pilot一再延期,李斌被逼得写信向客户道歉,最后决定将这尊大佛请走。

“李斌对伍丝丽越界的仁慈,直至2019年陷入至暗时刻。但正如前段时间的《满江红》,岳飞之死,秦桧之过?宋高宗才是问题的根源。好人李斌在‘蔚来自动驾驶跳票’中,该负多少责任?”

- 2015年,当蔚来计划将搭载NIO Pilot的ES8在2018年3月首批交付给用户时,小鹏汽车的首款产品G3还未交付(2018年12月),理想ONE更是还未发布。

- 2016年,李斌拉来了高瓴和红杉作为联合发起人成立蔚来资本,更是邀请伍丝丽作为蔚来汽车派驻到蔚来资本唯三的代表之一。

- 2016年,时任猎豹副总裁庄莉买了一辆特斯拉Model S。庄莉之前在微软、雅虎都曾担任要职,凭借着技术人特有的灵敏嗅觉,她的感受非常强烈——属于汽车的新时代要来了。对智能汽车的好奇、对全新挑战的振奋,促使庄莉想做点什么。她找到当时于百度供职的清华师弟张天雷,俩人一起筹划智能驾驶相关的创业项目,尽管这件事后来没成,但也在她心中埋下了创业的种子。由于庄莉经常在朋友圈分享Model S的使用感受,一天,微信列表里的汽车猎头突然联系她,说李斌正在找人做车联网。庄莉从猎豹离开时,竞业协议里写的是今日头条,谁也不知道、也没想到她去做车了。2016年7月加入蔚来之后,年轻又聪明的庄莉受到了重用。当时,有关自动驾驶的核心技术研发已由伍丝丽掌管。李斌就将座舱底层技术、车联网云端平台以及用户服务体系搭建等业务全权交给了庄莉。

- 为了证明自己的实力,庄莉一手打造了人车交互项目Nomi,令李斌颇为赏识。但除了这些项目,车辆的落地交付还是离不开美国团队的支持。原因在于,美国团队负责硬件和底层软件开发,中国团队则负责场景定义、软件开发、算法开发和集成验证。风格迥异的部门交流,很难跟上蔚来在软件业务方面不断变更的需求。甚至有中国团队对的人吐槽,美国团队交付的东西太垃圾,需要进行二次开发。

- 2017年,伍丝丽带领北美团队独立融资,NIO Pilot进度被拖累。

- 中国这边,蔚来联合创始人郑显聪给公司拉来了一个金主——

MTK。当时郑显聪主要负责供应链、制造和质量,再加上台湾人的身份,与MTK关系十分熟络。双方在一来二往之间达成某种协议:MTK可以向蔚来投资一个亿,唯一的要求就是蔚来必须将英特尔芯片(Mobileye EyeQ4)换成性价比更高的MTK产品。且不说临时换芯片平台对于团队研发延续性的影响,这种行为无异于在掌控技术研发生杀大权的伍丝丽头上动土,她是绝对不能接受的。既然北美团队不愿意换MTK,那中国团队能不能自己做?对于郑显聪的提议,李斌原想睁一只眼闭一只眼,直到中美团队之间的出现信任危机。考虑到大局,李斌紧急叫停了这个项目。那时候,郑显聪手下管着一家叫作XPT的子公司,他是XPT的CEO,拥有自由签合同的权利,很多事情可以绕开蔚来集团层面的监控。江湖传闻,郑显聪后来通过财务运作手段,从XPT划拨了几百万预算在北京招了一个近100人的硬件团队,自己用MTK的芯片做demo。 - 等到2019年,NIO Pilot主要功能正式规模推送给用户时,「全栈自研自动驾驶」的标签已经落入小鹏怀中。

- 2017年,李斌找到彭军和楼天城时,想法简单粗暴:重仓刚成立不久的小马智行,而且是蔚来汽车和蔚来资本各投10%,实现20%的控股。身处激战正酣的赛道,彭、楼最终没有同意李斌的诉求,只看在情分上让李斌“投了很少一部分”。

- 2017年7月,蔚来资本领投了Momenta金额4600万美元的B轮投资,并希望双方能够在业务层面合作。

- 2018年底,李斌需要找人接替伍丝丽,随后将庄莉提拔为负责软件研发的副总裁,北美智能座舱团队和中国打通,向庄莉汇报。

萝卜快跑

【2024-1-2】萝卜快跑在武汉试运营,老外看到很新奇

萝卜快跑已在北京、上海、广州、深圳、重庆、长沙、阳泉等城市全面开放,面向公众常态化试运营。 已在北京、重庆、武汉、阳泉等城市开启商业化运营。 其中,萝卜快跑在武汉、重庆、北京、深圳开启了全无人自动驾驶运营。

- 通过萝卜快跑小程序打车

北京开通地区:

- 首钢园、中关村软件、亦庄到大兴机场等

Waymo

世界最强无人驾驶汽车 Waymo

美国洛杉矶无人驾驶体验视频 google waymo

waymo vs tesla

Waymo 与 FSD V12 选择相同路线, 但因为 Waymo 没有能力处理环岛,导致目的地附近的环岛 Waymo 选择直行通过再下一个路口调头回来再环岛右转

V12 可以丝滑处理环岛所以先到达,领先一个环岛的时间

油车智驾

Openpilot

【2025-2-7】Openpilot 开源系统,l2级别的辅助驾驶,美国加州的创业公司 comma.ai

该系统通常需要汽车具备ACC主动式定速巡航系统和辅助转向或相似系统,以实现对汽车油门、刹车及方向盘的控制。

软件可安装在安卓手机上,如红米手机

openpilot 为受支持的汽车品牌、车型和车型年份执行自适应巡航控制(ACC)、自动车道保持(ALC)、前向碰撞警告(FCW)和车道偏离警告(LDW)功能。

此外,当 openpilot 启动时,基于 camera 的驾驶员监控(DM)功能会提醒分心和打瞌睡的驾驶员。

Openpilot 官方版本支持 车道保持 、ACC巡航、自动辅助变道。

- 车道保持:控制方向盘,使车辆保持在左右两车道正中间。

- ACC巡航:检测前车、障碍物,根据前车速度调节车速(油门、刹车),与前车保持安全距离。

- 自动辅助变道:当驾驶员需要切换车道时,需要打开转向灯(常亮),确认变向车道安全后,然后朝变道方向轻推方向盘,车辆将驶向旁边车道,变道完成后,需要驾驶员关闭转向灯。

0.6.4 之后的版本在测试过程中发现,如果没有车道线情况下,会跟随前车轨迹行驶

Openpilot 软件本身暂时不支持 AEB 刹车,只能在激活自动驾驶的时候,检测到前方车辆或障碍物距离太近,提示用户或刹车减速。

新能源

甲醇

【2025-2-9】 吉利超醇电混汽车:甲醇动力能否引领新能源革命?

吉利推出了一项名为“超醇电混”的创新技术,允许甲醇与汽油在同一燃料箱内以灵活比例混合使用,赋予了发动机前所未有的燃料适应性。

从技术层面分析,超醇电混技术的发动机热效率高达48.15%,即使在零下40℃的极端环境中,使用甲醇也能确保车辆正常运行,这无疑为北方地区的用户提供了极大的便利。

该技术的独特之处,打破了传统燃料的界限,实现了汽油与甲醇的混合燃烧,这在全球范围内尚属首次。

支付宝打赏

支付宝打赏  微信打赏

微信打赏