- 大数据

- 相关性分析

- 数据分析

- 数据库

- 分析工具

- 大数据分析

- 数据的游戏:冰与火

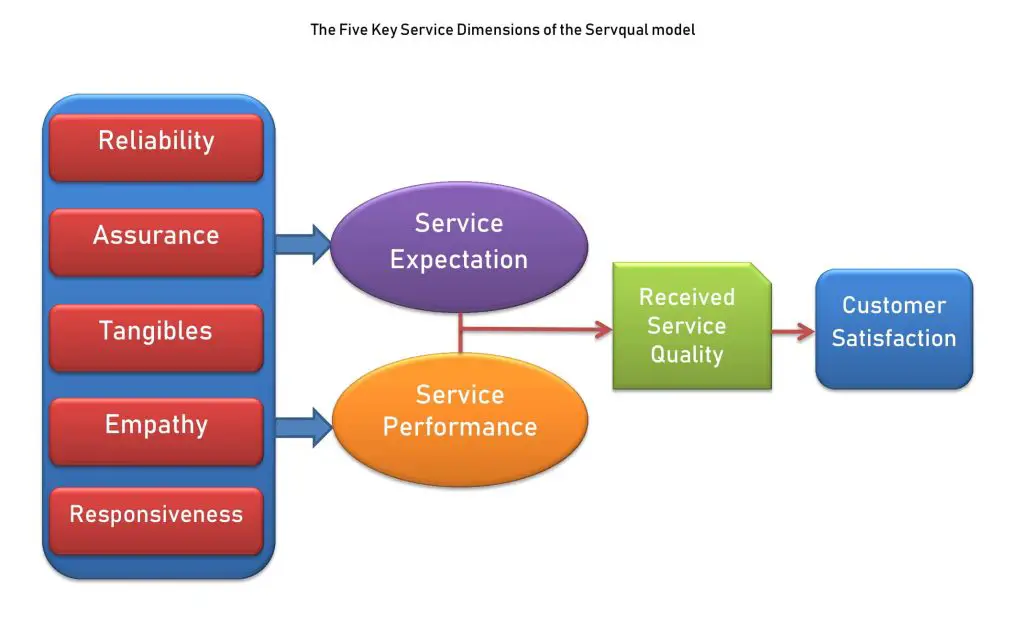

- 服务质量评价

- 结束

数据挖掘方向知识点、经验总结

大数据

总结

【2021-11-4】美团王庆:当老板对指标进行灵魂拷问时,该如何诊断分析?,主要从四个方面进行展开:

- 为什么要做诊断分析?

- 第一类是发生型问题。昨天相比订单量为什么下降10%?现状就是今天的订单量,期望是昨天的大量问题。

- 第二类是潜在型问题。天气变冷,客服人力是否够用,现状是当前的供需关系,期望是按这个趋势走下去,供需关系会怎样?是否存在差距,过剩还是不足?

- 第三类为理想型的问题,比如如何完成Q3的OKR,当前的访购率是10%,期望下个季度的访购率是12%,差距就是2pp。

- 如何做诊断分析?

- 一种相对普适性的方法就是“逻辑树+假设驱动”。 因为逻辑树能够帮助我们确定分析问题的框架,而假设驱动可以确定分析问题的视角。这里,逻辑树是表达指标(问题)内部结构的最佳方法,适用于外卖业务多数指标的问题诊断。

- 智能诊断案例解析

- Tips:诊断分析中易犯的错误

- 原因1:问题界定不清楚。问题是现状与期望的差距。对现状认识不清、期望不合理、问题定义不对

- 原因2:舒适地带偏见。在有限的时间、有限的维度内进行诊断,只寻找局部最优解,很容易导致漏诊和误诊。

- 【2021-2-22】27岁华裔小伙一战成名!搞出美国新冠最准预测模型,一人干翻专业机构,彭博:Superstar,凭一己之力,仅用一周时间打造的新冠预测模型,准确度方面碾压那些数十亿美元、数十年经验加持的专业机构。不仅如此,他的模型还被美国疾控中心采用。模型地址

- fast.ai创始人Jeremy Howard高度评价道:唯一看起来合理的模型。他是唯一一个真正查看数据,并且做得正确的人。

- 2家专业机构打造的预测系统——伦敦帝国理工学院、总部位于西雅图的健康指标与评估研究所(IHME)。

- 但2家机构给出的预测结果却是天差地别:

- 伦敦帝国理工学院:到夏天,美国因新冠病毒而死亡的人数将达到200万。

- IHME:预计到8月,死亡人数将达到6万。

- (后来的事实证明,死亡人数是16万。)

概念

大数据

【2018-5-23】IBM大中华区 谢国忠:大数据在金融领域实践应用

计算机技术的发展历程与演变,三个时代: 早期的制表系统时代、现在的可编程系统时代和正在跨越的认知系统时代。

未来的计算模式:可编程系统+认知系统,可编程系统实现“交易”,认知系统实现“分析”。

大数据是认知系统的基础。

- 大交易数据: OLTP(联机交易处理)、OLAP(联机分析处理) 和 数据仓库

- 大交互数据: 移动终端、物联网、互联网、社交网络

- 大数据集成和融合

- 大数据处理与分析

统计特性

详见站内专题 概率统计

数据可视化

【2021-11-9】用python进行描述性统计。描述性统计是借助图表或者总结性的数值来描述数据的统计手段

总结:频次分析(定性、定量)、关系分析、探索分析

数值分析

- 1 基本概念

- 2 中心位置(均值、中位数、众数)

- 3 发散程度(极差,方差、标准差、变异系数)

- 4 偏差程度(z-分数)

- 5 相关程度(协方差,相关系数)

import numpy as np

#from numpy import array

#from numpy.random import normal, randint

data = [1, 2, 3]#使用List来创造一组数据

data = np.array([1, 2, 3])#使用ndarray来创造一组数据

data = np.random.normal(0, 10, size=10)#创造一组服从正态分布的定量数据(μ=0,σ=10)

data = np.random.randint(0, 10, size=10)#创造一组服从均匀分布的定性数据([0,10)之间的均匀分布)

# ------- 中心位置 -------

#from numpy import mean, median

import numpy as np

np.mean(data)#计算均值,期望

np.median(data)#计算中位数

# 对于定性数据来说,众数是出现次数最多的值,使用SciPy计算众数:

import scipy as sp

sp.stats.mode(data)#计算众数,注报错!

from scipy.stats import mode

mode(data)#ModeResult(mode=array([2]), count=array([2])),方法:mode、count和index

# -------- 发散程度 ---------

#from numpy import mean, ptp, var, std

import numpy as np

np.min(data);np.max(data)

np.ptp(data)#极差:|max-min|

np.var(data)#方差

np.std(data)#标准差

np.mean(data)/np.std(data)#变异系数——近似正态分布变换

# --------- 偏差程度 ---------

# z-分数的绝对值大于3将视为异常。#注:三倍标准差以外视为小概率事件

(data[0]-np.mean(data)) / np.std(data)#计算第一个值的 z-分数

# --------- 相关程度 ---------

data = np.array([data1, data2])

# ① 协方差的绝对值越大表示相关程度越大,协方差为正值表示正相关,负值为负相关,0为不相关。

# ② 相关系数是基于协方差但进行了无量纲处理。使用NumPy计算协方差和相关系数:

data = np.array([data1, data2])

#计算两组数的协方差.参数bias=1表示结果需要除以N,否则只计算了分子部分.返回结果为矩阵,第i行第j列的数据表示第i组数与第j组数的协方差。对角线为方差

np.cov(data, bias=1)

#计算两组数的相关系数.返回结果为矩阵,第i行第j列的数据表示第i组数与第j组数的相关系数。对角线为1

np.corrcoef(data)

可视化分析

- 1 基本概念

- 2 频数分析

- 2.1 定性分析(柱状图、饼形图)

- 2.2 定量分析(直方图、累积曲线)

- 3 关系分析(散点图)

- 4 探索分析(箱形图)

描述性统计是容易操作,直观简洁的数据分析手段。但是由于简单,对多元变量的关系难以描述。现实生活中,自变量通常是多元的:决定体重不仅有身高,还有饮食习惯,肥胖基因等等因素。通过一些高级的数据处理手段,我们可以对多元变量进行处理,例如特征工程中,可以使用互信息方法来选择多个对因变量有较强相关性的自变量作为特征,还可以使用主成分分析法来消除一些冗余的自变量来降低运算复杂度。

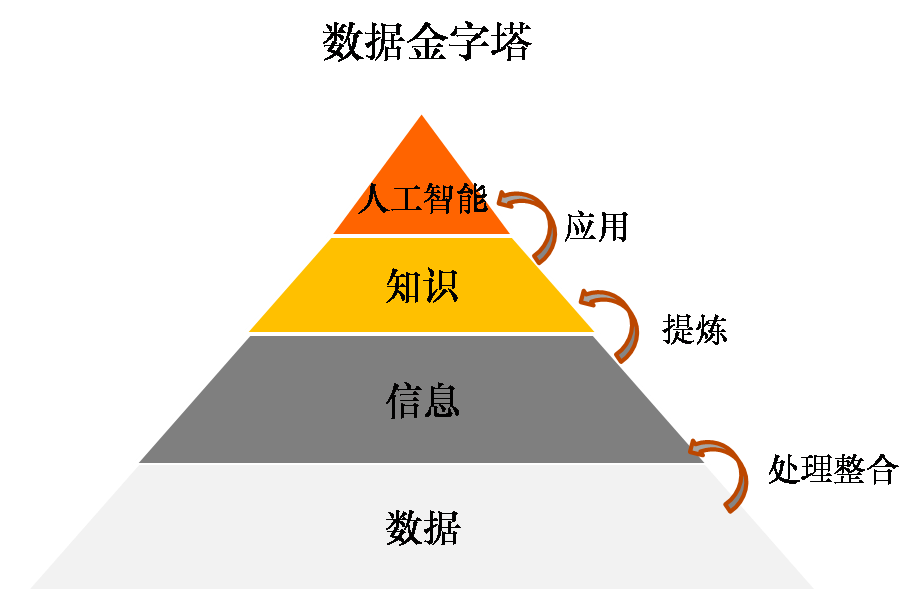

数据金字塔

- 数据金字塔可以帮助我们理解数据与信息、知识和人工智能的关系。

- 数据本身是没有意义的,如果它不能转化为信息和知识的话;

- 但如果没有数据,或者数据匮乏,信息和知识的产生也就成了无水之源。

- 图

- 数据

- 问题

- 数据存在缺失

- 数据采集的无效性

- 问题

- 信息:是被组织起来的数据

- 为了特定目标对数据进行处理和建立内在关联,让数据具有意义,可以回答谁(who)、什么(what)、哪里(where)、什么时候(when)的问题,对于企业经营而言,信息的作用在于过程管理和绩效评估。

- 问题

- 缺乏有效的数据分析工具

- 缺乏将数据转化为信息的分析能力

- 知识:对信息的总结和提炼。

- 基于信息之间的联系,总结出来的规律和方法论,主要用于回答为什么(why)和怎么做(how)的问题,在企业里的应用包括问题诊断、预测和最佳做法。

- 知识来源于经验(数据),来源于人类对这个三维世界的观察,而智慧可以无需通过经验,有可能通过与高维度建立连接而获得

- 人工智能:机器对信息和知识的自主应用

- 人工智能是系统基于数据、信息和知识,形成类似于人脑的思维能力(包括学习、推理、决策等)。

- 在信息和知识层面,数据都是提供决策支持作用,而到了人工智能阶段,则是系统模仿人类应用信息和知识进行自主决策了。

- 人工智能永远无法超越人类的智慧。由此也可以看到数据的局限性:

- 它可以将人类的理性发挥到极致,但它只会模仿却无法创造,它无法替代人类的感性和直觉,而正是这份感性和直觉,让生命多了一些有趣和柔软,真正的创造也由此发生!

相关性分析

- 注意: $ 相关关系 ≠ 因果关系 $

- 相关分析的方法很多

- 初级方法:快速发现数据之间的关系,如正相关,负相关或不相关。

- 中级方法:对数据间关系的强弱进行度量,如完全相关,不完全相关等。

- 高级方法:将数据间的关系转化为模型,并通过模型对未来的业务发展进行预测。

相关系数总结

| 系数 | 数值类型 | 顺序因素 | 适用条件 | 示例 |

|---|---|---|---|---|

| pearson | 连续 | 无序 | 连续数据,正态分布,线性关系 | T恤与空调销售量关系 |

| kendall | 离散 | 有序 | 定序变量或不满足正态分布的等间隔数据 | 商品排名关系 |

| spearman | 不限 | 有序 | 定序变量或不满足正态分布的等间隔数据 | 有序即可,数据类型分布不限,适用范围广但统计效能低 |

相关系数分析

参考:

(1)协方差及协方差矩阵

协方差用来衡量两个变量的总体误差,如果两个变量的变化趋势一致,协方差就是正值,说明两个变量正相关。如果两个变量的变化趋势相反,协方差就是负值,说明两个变量负相关。如果两个变量相互独立,那么协方差就是0,说明两个变量不相关。协方差只能对两组数据进行相关性分析,当有两组以上数据时就需要使用协方差矩阵。协方差通过数字衡量变量间的相关性,正值表示正相关,负值表示负相关。但无法对相关的密切程度进行度量。面对多个变量时,无法通过协方差来说明那两组数据的相关性最高。要衡量和对比相关性的密切程度,就需要使用下一个方法:相关系数。

(2)相关系数

- 相关系数(Correlation coefficient)是反应变量之间关系密切程度的统计指标,相关系数的取值区间在1到-1之间。1表示两个变量完全线性相关,-1表示两个变量完全负相关,0表示两个变量不相关。数据越趋近于0表示相关关系越弱。

- 缺点是无法利用这种关系对数据进行预测,简单的说就是没有对变量间的关系进行提炼和固化,形成模型。要利用变量间的关系进行预测,需要使用到下一种相关分析方法,回归分析。

- pearson(皮尔逊), kendall(肯德尔)和spearman(斯伯曼/斯皮尔曼)三种相关分析方法有什么异同

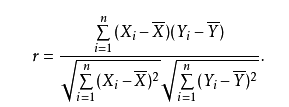

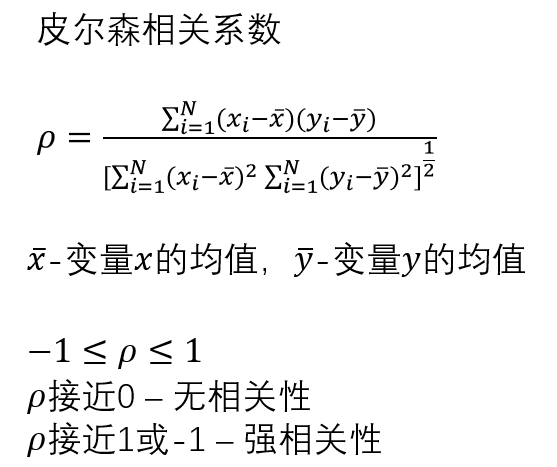

- (2.1)pearson(皮尔逊) 线性相关系数

- r = Cov(x,y) / σᵪσ

- $ \rho_{X, Y}=\frac{\operatorname{cov}(X, Y)}{\sigma_{X} \sigma_{Y}} $

- 两个连续变量间呈线性相关时

- 满足积差相关分析的适用条件时,使用Pearson积差相关系数

- 不满足积差相关分析的适用条件时,使用Spearman秩相关系数来描述.

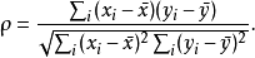

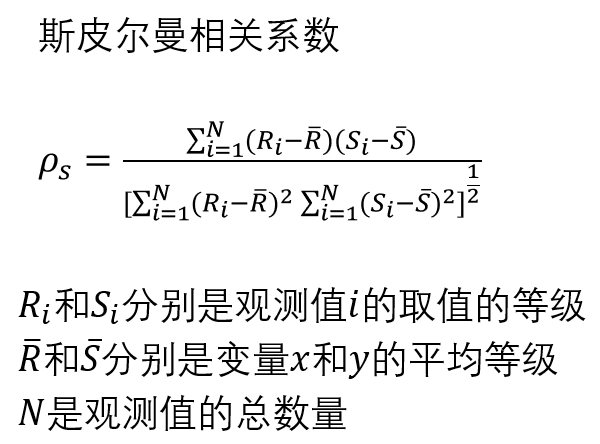

- (2.2)Spearman(斯皮尔曼)相关系数又称秩相关系数,是利用两变量的秩次大小作线性相关分析,对原始变量的分布不作要求,属于非参数统计方法,适用范围要广些。对于服从Pearson相关系数的数据亦可计算Spearman相关系数,但统计效能要低一些。Pearson相关系数的计算公式可以完全套用Spearman相关系数计算公式,但公式中的x和y用相应的秩次代替即可。

- 1.连续数据,正态分布,线性关系,用pearson相关系数是最恰当,当然用spearman相关系数也可以, 就是效率没有pearson相关系数高。

- 2.上述任一条件不满足,就用spearman相关系数,不能用pearson相关系数。

- 3.两个定序数据之间也用spearman相关系数,不能用pearson相关系数。

- 定序数据是指仅仅反映观测对象等级、顺序关系的数据,是由定序尺度计量形成的,表现为类别,可以进行排序,属于品质数据。

- 斯皮尔曼相关系数的适用条件比皮尔逊相关系数要广,只要数据满足单调关系(例如线性函数、指数函数、对数函数等)就能够使用。

- (2.3)Kendall’s tau-b等级相关系数:用于反映分类变量相关性的指标,适用于两个分类变量均为有序分类的情况。对相关的有序变量进行非参数相关检验;取值范围在-1-1之间,此检验适合于正方形表格;

- 计算积距pearson相关系数,连续性变量才可采用;

- 计算Spearman秩相关系数,适合于定序变量或不满足正态分布假设的等间隔数据;

- 计算Kendall秩相关系数,适合于定序变量或不满足正态分布假设的等间隔数据。

- 计算相关系数:当资料不服从双变量正态分布或总体分布未知,或原始数据用等级表示时,宜用 spearman或kendall相关

- Pearson 相关复选项 积差相关计算连续变量或是等间距测度的变量间的相关分析

- Kendall 复选项 等级相关 计算分类变量间的秩相关,适用于合并等级资料

- Spearman 复选项 等级相关计算斯皮尔曼相关,适用于连续等级资料

- 注:

- 1 若非等间距测度的连续变量 因为分布不明-可用等级相关/也可用Pearson 相关,对于完全等级离散变量必用等级相关

- 2 当资料不服从双变量正态分布或总体分布型未知或原始数据是用等级表示时,宜用 Spearman 或 Kendall相关。

- 3 若不恰当用了Kendall 等级相关分析则可能得出相关系数偏小的结论。则若不恰当使用,可能得相关系数偏小或偏大结论而考察不到不同变量间存在的密切关系。对一般情况默认数据服从正态分布的,故用Pearson分析方法。

(3)一元回归及多元回归

- 回归分析(regression analysis)是确定两组或两组以上变量间关系的统计方法。两个变量使用一元回归,两个以上变量使用多元回归。

- 详情见专题:机器学习之回归分析

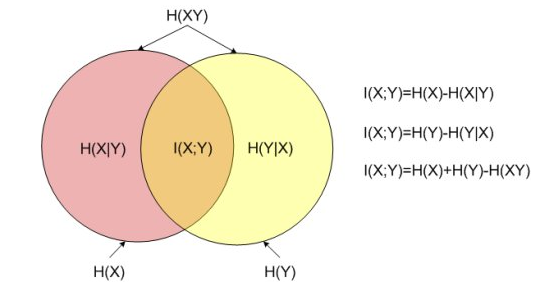

(4)信息熵及互信息

- 影响最终效果的因素可能有很多,并且不一定都是数值形式

互信息可以发现哪一类特征与最终的结果关系密切.- 互信息是用来衡量信息之间相关性的指标。当两个信息完全相关时,互信息为1,不相关时为0。

- 信息之间是有相关性的,互信息是度量相关性的尺子。互信息越高,相关性也越高。

相关系数vs互信息:- 线性相关系数,从统计学出发度量信息A、B的关系,范围在-1到1,即有正相关和负相关。0表示相关

- 互信息,从联合概率的角度计算,可以理解为A出现的时候B出现的概率,概率范围是从0到1,即完全不确定到完全确定

- 计算方法见:决策树分类和预测算法的原理及实现

- 离散

- 连续

- 代码

# 方法1:

#sklearn 计算

from sklearn import metrics as mr

if __name__ == '__main__':

A = [1, 1, 1, 2, 3, 3]

B = [1, 2, 3, 1, 2, 3]

result_NMI=metrics.normalized_mutual_info_score(A, B)

print("result_NMI:",result_NMI)

#备注:计算A和B的互信息,A,B为list或array。

#方法2:

from scipy.stats import chi2_contingency

def calc_MI(x, y, bins):

c_xy = np.histogram2d(x, y, bins)[0]

g, p, dof, expected = chi2_contingency(c_xy, lambda_="log-likelihood")

mi = 0.5 * g / c_xy.sum()

# 备注:唯一区别就是这样实现使用自然对数而不是基2对数(因此它以“nats”而不是“bits”表示信息)。如果你喜欢bit,只需把mi除以log(2)

#方法3:

import numpy as np

def calc_MI(X,Y,bins):

c_XY = np.histogram2d(X,Y,bins)[0]

c_X = np.histogram(X,bins)[0]

c_Y = np.histogram(Y,bins)[0]

H_X = shan_entropy(c_X)

H_Y = shan_entropy(c_Y)

H_XY = shan_entropy(c_XY)

MI = H_X + H_Y - H_XY

return MI

def shan_entropy(c):

c_normalized = c / float(np.sum(c))

c_normalized = c_normalized[np.nonzero(c_normalized)]

H = -sum(c_normalized* np.log2(c_normalized))

return H

A = np.array([[ 2.0, 140.0, 128.23, -150.5, -5.4 ],

[ 2.4, 153.11, 130.34, -130.1, -9.5 ],

[ 1.2, 156.9, 120.11, -110.45,-1.12 ]])

bins = 5 # ?

n = A.shape[1]

matMI = np.zeros((n, n))

for ix in np.arange(n):

for jx in np.arange(ix+1,n):

matMI[ix,jx] = calc_MI(A[:,ix], A[:,jx], bins)

【2020-12-07】

Sperman或kendall等级相关分析, Sperman 连续,kendall 离散Person相关(样本点的个数比较多),无顺序关系,一般常用皮尔逊相关Copula相关(比较难,金融数学,概率密度)- 一般这样认为:

- 0.8-1.0 极强相关

- 0.6-0.8 强相关

- 0.4-0.6 中等程度相关

- 0.2-0.4 弱相关

- 0.0-0.2 极弱相关或无相关

- 参考

Pearson——无序、连续

皮尔逊相关系数( Pearson correlation coefficient),又称皮尔逊积矩相关系数(Pearson product-moment correlation coefficient,简称 PPMCC或PCCs)。用于衡量两个变量X和Y之间的线性相关相关关系,值域在-1与1之间。- 给定两个连续变量x和y,皮尔森相关系数被定义为

- img

- img

- $ \rho_{\mathrm{X}, \mathrm{Y}}=\frac{\operatorname{cov}(\mathrm{X}, \mathrm{Y})}{\sigma_{\mathrm{X}} \sigma_{\mathrm{Y}}}=\frac{\mathrm{E}[(\mathrm{X}-\mathrm{EX})(\mathrm{Y}-\mathrm{EY})]}{\sigma_{\mathrm{X}} \sigma_{\mathrm{Y}}}=\frac{\mathrm{E}(\mathrm{XY})-\mathrm{E}(\mathrm{X}) \mathrm{E}(\mathrm{Y})}{\sqrt{\mathrm{E}\left(\mathrm{X}^{2}\right)-\mathrm{E}^{2}(\mathrm{X})} \sqrt{\mathrm{E}\left(\mathrm{Y}^{2}\right)-\mathrm{E}^{2}(\mathrm{Y})}} $

- img

Pearson相关系数的一个关键数学特性:

- 它在两个变量的位置和尺度的单独变化下是不变的。可以将X变换为a+bX并将Y变换为c+dY,而不改变相关系数,其中a,b,c和d是常数,b,d > 0

|r|相关强度

- 0.8-1.0 极强相关

- 0.6-0.8 强相关

- 0.4-0.6 中等程度相关

- 0.2-0.4 弱相关

- 0.0-0.2 极弱相关或无相关

注意以下几个问题:

- 1、 积差相关系数适用于线性相关的情形,对于曲线相关等更为复杂的情形,积差相关系数大小并不能代表相关性的强弱

- 2、 样本中存在的极端值对Pearson积差相关系数的影响极大,因此要慎重考虑和处理,必要时可以对其进行剔出,或者加以变量变换,以避免因为一两个数值导致出现错误的结论。

-

3、 Pearson积差相关系数要求相应的变量呈双变量正态分布,注意双变量正态分布并非简单的要求x变量和y变量各自服从

正态分布,而是要求服从一个联合的双变量正态分布 - 代码

# (1)numpy库

pccs = np.corrcoef(x, y)

# (2)scipy库

from scipy.stats import pearsonr

pccs = pearsonr(x, y)

# (3)直接计算

def cal_pccs(x, y, n):

"""

warning: data format must be narray

:param x: Variable 1

:param y: The variable 2

:param n: The number of elements in x

:return: pccs

"""

sum_xy = np.sum(np.sum(x*y))

sum_x = np.sum(np.sum(x))

sum_y = np.sum(np.sum(y))

sum_x2 = np.sum(np.sum(x*x))

sum_y2 = np.sum(np.sum(y*y))

pcc = (n*sum_xy-sum_x*sum_y)/np.sqrt((n*sum_x2-sum_x*sum_x)*(n*sum_y2-sum_y*sum_y))

return pcc

Spearman——有序(不限)

Spearman秩相关系数:使利用两变量的秩次大小作线性相关分析,对原始变量的分布不做要求,属于非参数统计方法。因此适用范围比Pearson相关系数要广的多。即使原始数据是等级资料也可以计算Spearman相关系数。

- 对于服从Pearson相关系数的数据也可以计算Spearman相关系数,但统计效能比Pearson相关系数要低一些(不容易检测出两者事实上存在的相关关系)。如果数据中没有重复值, 并且当两个变量完全单调相关时,斯皮尔曼相关系数则为+1或−1。

-

Spearman相关系数即使出现异常值,由于异常值的秩次通常不会有明显的变化(比如过大或者过小,那要么排第一,要么排最后),所以对Spearman相关性系数的影响也非常小。

- 由于原则上无法准确定义顺序变量各类别之间的距离,导致计算出来的相关系数不是变量间的关联性的真实表示。因此,建议对顺序变量使用斯皮尔曼相关系数。

- 斯皮尔曼相关系数的计算采用的是取值的等级,而不是取值本身。例如,给定三个值:33,21,44,它们的等级就分别是2,1,3. 计算斯皮尔曼相关系数的公式与计算皮尔森相关系数的类似,但用等级代替了各自的取值。

- 相对于皮尔森相关系数,斯皮尔曼相关系数对于数据错误和极端值的反应不敏感。

- 斯皮尔曼相关系数的另一种公式表示如下:

- img

- $\rho=\frac{\sum_{i}\left(x_{i}-\bar{x}\right)\left(y_{i}-\bar{y}\right)}{\sqrt{\sum_{i}\left(x_{i}-\bar{x}\right)^{2} \sum_{i}\left(y_{i}-\bar{y}\right)^{2}}}$ 对于样本容量为n的样本,n个原始数据被转换成等级数据,相关系数ρ为:

- img

- img

【2024-7-3】计算公式

$\rho=1-\frac{6 \sum_{i=1}^{n} d_{i}^{2}}{n\left(n^{2}-1\right)}=1-\frac{6 \times(4+9+1+4)}{4\left(4^{2}-1\right)}=-0.8$

示例

# 原始数值

x = [9.2, 2.1, 7.2, 9.1]

y = [2.4, 8.1, 4.2, 1.1]

# 离散化为等级数据,如 分成4档, n=4

x = [4,1,2,3]

y = [2,4,3,1]

# 计算等级差

d = [-2,3,1,-1]

d2 = [4,9,1,4] # 平方

# 计算 spearman 系数

ro = -0.8

Kendall——有序、离散

Kendall秩相关系数是一种秩相关系数,用于反映分类变量相关性的指标,适用于两个变量均为有序分类的情况,用希腊字母τ(tau)表示其值。

- 分类变量可以理解成有类别的变量,可以分为无序的,比如性别(男、女)、血型(A、B、O、AB);

- 有序的,比如肥胖等级(重度肥胖,中度肥胖、轻度肥胖、不肥胖)。通常需要求相关性系数的都是有序分类变量

Kendall相关系数的取值范围在-1到1之间

- 当τ为1时,表示两个随机变量拥有一致的等级相关性;

- 当τ为-1时,表示两个随机变量拥有完全相反的等级相关性;

- 当τ为0时,表示两个随机变量是相互独立的。

计算公式:

- Kendall系数是基于协同的思想。对于X,Y的两对观察值Xi,Yi和Xj,Yj,如果$ X_i<Y_i$ 并且 $ X_j<Y_j$, 或者$X_i>Y_i$并且$X_j>Y_j$,则称这两对观察值是和谐的,否则就是不和谐。

- $\tau=\frac{\text { (一致的pairs数) }-\text { (不一致的pairs数) }}{\frac{1}{2} n(n-1)}$

Kendall系数可以度量两个排序之间的相关性强弱

- k<0.5:负相关,数值越接近0,负相关性越强

- 如:[1,2,3,4], [4,3,2,1], 肯德尔系数为0

- k=0.5:不相关

- k>0.5:正相关,数值越接近1,正相关性越强

- 如:[1,2,3,4], [1,2,3,4], 肯德尔系数为1

- 一致性评价中,通常认为

- k>0.7 较好

- k>0.9 优秀

三种相关系数都是对变量之间相关程度的度量,由于其计算方法不一样,用途和特点也不一样。

- 1)Pearson相关系数是在原始数据的方差和协方差基础上计算得到,所以对离群值比较敏感,它度量的是线性相关。因此,即使pearson相关系数为0,也只能说明变量之间不存在线性相关,但仍有可能存在曲线相关。

- 2)Spearman相关系数和kendall相关系数都是建立在秩和观测值的相对大小的基础上得到,是一种更为一般性的非参数方法,对离群值的敏感度较低,因而也更具有耐受性,度量的主要是变量之间的联系。

代码

import pandas as pd

df = pd.read_csv('demo.csv')

## 计算相关度系数 ##

df.corr() #计算pearson相关系数

#df.corr('kendall') #计算kendall相关系数

#df.corr('spearman') #计算spearman相关系数

# Dataframe.corr(method='spearman'), 返回相关关系矩阵

from scipy.stats import spearmanr

# spearmanr(array)返回 Pearson 系数和检验P值, 样本要求>20。

无序分类变量的统计推断:卡方检验

- $\chi^{2}=\sum_{i=1}^{k}\left(\left(A_{i}-n p_{i}\right)^{2} / n p_{i}\right)$

Ai为i水平的观测频数,Ei为i水平的期望频数,n为总频数,Pi为i水平的期望概率。

主要用于检验某无序分类变量各水平在两组或多组间的分布是否一致。还可以用于检验一个分类变量各水平出现的概率是否等于指定概率;一个连续变量的分布是否符合某种理论分布等。其主要用途:

- 1、 检验某个连续变量的分布是否与某种理论分布相一致。

- 2、 检验某个分类变量各类的出现概率是否等于制定概率。

- 3、 检验某两个分类变量是否相互独立。

- 4、 检验控制某种或某几种分类因素的作用以后,另两个分类变量是否相互独立。

- 5、 检验某两种方法的结果是否一致。

数据分析

- 【2021-6-9】阿里巴巴:数据分析思维及意义

Google的数字营销传播者Avinash Kaushik曾说“All data in aggregate is crap”,即“所有汇总的数据都是废话”,汇总的数据掩盖了很多问题,即需要下钻分析数据指标,以理解指标的各种取值或者趋势背后的真正原因(特别是指标取值或者趋势异常时),以便于优化指标。

5W2H分析法又叫七问分析法,简单、方便,易于理解、使用,富有启发意义,广泛用于企业管理和技术活动,对于决策和执行性的活动措施也非常有帮助,也有助于弥补考虑问题的疏漏。

- 5W是指:what(是什么)、when(何时)、where(何地)、why(为什么)、who(是谁)。

- 2H是指:how(怎么做)、how much(多少钱)。

案例

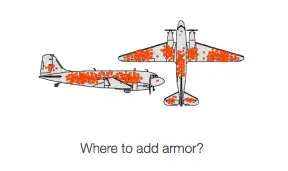

幸存者偏差

【2023-12-16】中国工程院资深院士金涌:人还有一种反向思维能力

- 二战期间,统计飞机中弹点,好商议哪些部位需要加强,没考虑到真正需要加强的位置并没有采样(飞机没飞回来)

幸存者偏差(Survivorship bias)是一种常见的逻辑谬误(所以我说叫“谬误”而不是“偏差”)

- 只能看到经过某种筛选而产生的结果,而没有意识到筛选过程,因此忽略了被筛选掉的关键信息。

- 别名有很多,比如“沉默的数据”、“死人不会说话”等等。

举例

- 仅通过研究大学生来探究高中教育的问题,那就忽略了高考这个筛选器:没有通过高考、没有考上大学的人,他们才是在高中教育真正出现问题的人,而他们不在大学生的研究样本中。

因果分析

流浪地球

【2023-10-15】真实故事:

- 某互联网平台通过大数据发现,《流浪地球》观众喜欢喝热饮,而《战狼2》的观众喜欢喝冷饮。

- 这是为什么呢?他们百思不得其解,却唯独忘记了前者是在冬天上映,后者是在夏天上映……

教科书般的过度理论化,一个不懂得领导带着一帮刚出社会的985就大概率干这样的事,依赖所谓的科学工具

- 过分话追求数据分析 天天看各种无意义的报表 根本挖掘不出数据背后隐藏的意义

- 研究了大半天,发现忘记了常识:数据分析时,必须要对比分析时间、地点、人群等

数据和AI都是建立在统计学上,需要植入了因果分析

高压线麦田

现象:

- 高压线下的小麦长势更好

于是,专家申请课题:研究电磁与小麦生长关系,历时两年,一通折腾,没有成果

农民一语点醒

- 高压线上鸟儿多,掉下来的粪便成了小麦养料。

数据分析常见技巧

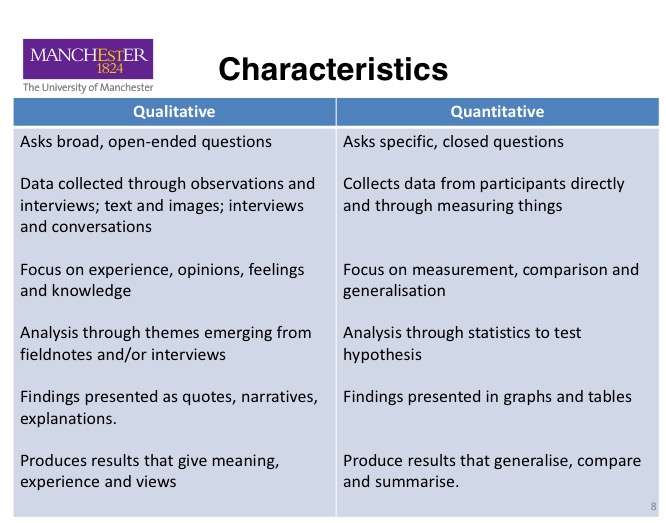

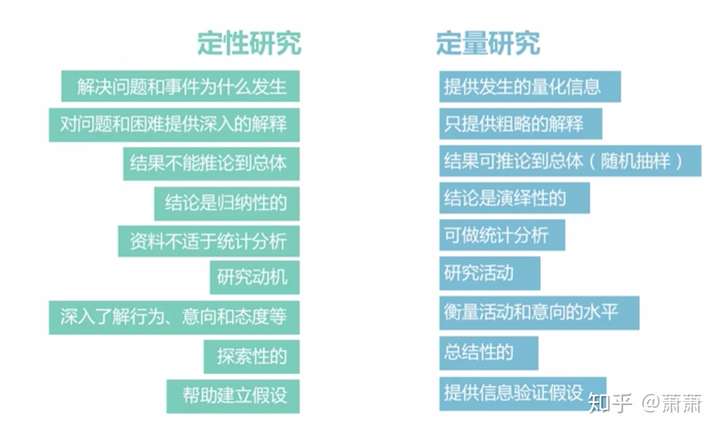

- 【2020-9-29】数据分析知识点:定性分析和定量分析的根本区别在于

- ① 画图前想想是定性分析还是定量分析

- 定性分析描述性质,侧重结论,如占比,一般用饼图、四分位图等;

- 分析1:郭小明胃口很大

- 分析2:郭晓明胃口很小

- 定量分析描述量级变化,侧重数字,一般用折线图、曲线图等。

- 分析1:郭小明一顿可以吃3个Schweinshaxe

- 分析2:郭小明在吃了3个Schweinshaxe之后还可以吃5个蛋挞

- 定性分析描述性质,侧重结论,如占比,一般用饼图、四分位图等;

- ② 数据分析三大类:趋势、比较、细分。参考:数据分析的三个常用方法:数据趋势、对比和细分分析

- 趋势

- 比较

- 细分

宏观战略分析

常用战略分析方法有PEST、SWOT和波特五力模型

PEST

PEST分析是指宏观环境的分析,P是政治(politics),E是经济(economy),S是社会(society),T是技术(technology)。

SWOT

SWOT即基于内外部竞争环境和竞争条件下的态势分析,可以对研究对象所处的情景进行全面、系统、准确的研究。分析角度:优势(Strengths)、劣势(Weaknesses)、机会(Opportunities)和威胁(Threats)。

波特五力

波特五力即行业中存在着决定竞争规模和程度的五种力量,这五种力量综合起来影响着产业的吸引力以及现有企业的竞争战略决策。五种力量分别为同行业内现有竞争者的竞争能力、潜在竞争者进入的能力、替代品的替代能力、供应商的讨价还价能力与购买者的议价能力。

微观数据分析

由于业务数据指标往往是由多个微观原因引起的,上面的方法难以定位这类问题(如“订单量为什么下降”)的根本原因,这时候就需要运用其他微观数据分析方法。

逻辑树分析法

逻辑树分析方法是把复杂问题拆解成若干个简单的子问题,然后像树枝那样逐步展开。

多维度拆解法

假设在每个医院最近收治的1000例患者中,A医院有900例患者存活。然而,B医院只有800例患者存活(如下图)。这样看起来,A医院的存活率更高,应该选择A医院。你的选择真的是正确的吗?

对比方法

1)什么是对比方法

数据分析中,我们通过对比分析方法,来追踪业务是否有问题。例如,我的CTR是4%,你说是高还是低?这个CTR有问题吗?这时候,就需要用对比分析方法来追踪业务是不是有问题。正所谓,没有对比就没有好坏。

心理学家给这种现象发明了一个术语叫作价格锚定,也就是通过和价格锚点对比,一些商品会卖得更好。

2)与谁比

与谁比一般分为两种:与自己比,与行业比。

3)如何比较

一般从3个维度比较:数据整体的大小、数据整体的波动、趋势变化。

- a)数据整体的大小:某些指标可用来衡量整体数据的大小。常用的是平均值、中位数,或者某个业务指标。

- b)数据整体的波动:标准差除以平均值得到的值叫作变异系数。变异系数可用来衡量整体数据的波动情况。

- c)趋势变化:趋势变化是从时间维度来看数据随着时间发生的变化。常用的方法是时间折线图,环比和同比。

- 时间折线图是以时间为横轴、数据为纵轴绘制的折线图。从时间折线图上可以了解数据从过去到现在发生了哪些变化,还可以通过过去的变化预测未来的动向。

- 环比是和上一个时间段对比,用于观察短期的数据集。例如某数据在2020年12月比2020年11月下降10%。

- 同比是与去年同一个时间段进行对比,用于观察长期的数据集。例如某数据在2020年12月比2019年12月下降10%。

假设检验分析法

1)什么是假设检验分析法

假设检验分析方法分为3步:

- 提出假设:根据要解决的问题,提出假设。例如警察破案的时候会根据犯罪现场提出假设:这个人有可能是嫌疑人。

- 收集证据:通过收集证据来证明。例如警察通过收集嫌疑犯的犯罪数据,来作为证据。

- 得出结论:这里的结论不是你主观猜想出来的,而是依靠找到的证据得到的结论。例如警察不能主观地去猜想,然后下结论说这个人是罪犯,而是要通过收集的数据(证据)来证明这个人是不是罪犯。

2)假设检验分析方法有什么用

由于假设检验分析方法背后的原理是逻辑推理,所以学会这个方法以后,可以显著提高我们的逻辑思维能力。

假设检验分析方法的另一个作用是可以分析问题发生的原因,也叫作归因分析。例如是什么原因导致活跃率下降、CTR下降、订单量下降等。这类问题就是分析原因,通过找到问题发生的原因,才能根据原因制定对应的策略。

3)如何使用假设检验分析方法?

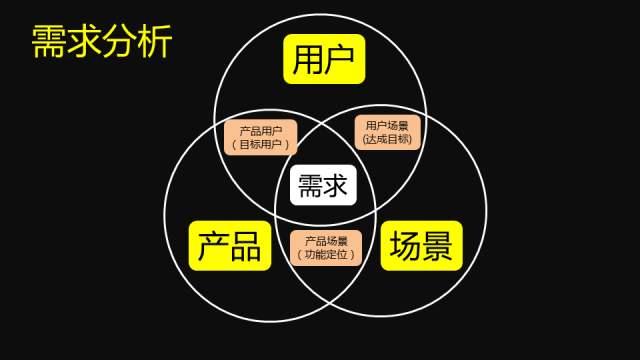

我们可以按用户、产品、竞品这3个维度提出假设(如下图),来检查提出的假设是否有遗漏。这3个维度分别对应公司的3个部门:用户对应运营部,产品对应产品部,竞品对应市场部。这3个维度有助于在发现问题原因以后,对应落实到具体部门上,有利于把问题说清楚。还可以从4P营销理论出发来提出假设。

相关分析

1)什么是相关分析法

时候我们研究的问题只有一种数据,例如人的身高;但是,还有另外一些问题需要研究多种数据,例如身高和体重之间的关系。当我们研究两种或者两种以上的数据之间有什么关系的时候,就要用到相关分析。如果两种数据之间有关系,叫作有相关关系;如果两种数据之间没有关系,叫作没有相关关系。

我们看一个例子。某个地区的用户在搜索引擎里搜的信息,和这个地区房价有什么关系呢?

谷歌首席经济学家哈尔·瓦里研究发现,如果更多人搜索“八成按揭贷款”,或者“涨幅”“涨价的速度”,这个地区的房价就会上涨;如果更多人搜索“快速卖房的流程”或者“按揭超过房价”,这个地区的房价就会下跌。也就是说,用户在搜索引擎里搜的信息和这个地区的房价有相关关系。

2)相关分析方法有什么用?

相关分析的作用有以下三点:

- 在研究两种或者两种以上数据之间有什么关系,或者某个事情受到其他因素影响的问题时,可以使用相关分析,以量化两个量的相关性。例如在分析产品的各个功能对产品用户留存的影响时,就可以使用相关分析,得出各个功能与产品用户留存的相关性。

- 在解决问题的过程中,相关分析可以帮助我们扩大思路和找到优先级,将视野从一种数据扩大到多种数据,扩展经验之外的因素,另外就是找到问题后可以根据相关性找到各个影响因素的重要性,进而先解决相关性高的主要问题。举个例子,在分析“为什么销量下降”的过程中,可以研究哪些因素和销售量有关系,例如产品价格、售后服务等。使用相关分析,可以知道哪些因素影响销量,哪些对销量没有影响,从而快速锁定问题的原因。

- 相关分析通俗易懂。这在实际工作中很重要,因为数据分析的结果需要得到其他人的理解和认可,所以要方便大家沟通。很多分析方法看上去很高端,但是没有相关知识的人不容易理解。而相关分析通俗易懂,你不需要向对方解释什么是“相关”的含义及分析结果的意义,对方也能够理解。

3)相关系数的含义?

相关系数数值的正负可以反映两种数据之间的相关方向,也就是说两种数据在变化过程中是同方向变化,还是反方向变化。

相关系数的范围是-1~1,-1、0和1这三个值是相关系数的极值(如下图),下面解释一下相关系数的3个极值。假如有两种数据a和b,把这两种数据画在散点图上,横轴用来衡量数据a,纵轴用来衡量数据b。

- 如果相关系数=1,数据点都在一条直线上,表示两种数据之间完全正相关,两种数据是同方向变化。也就是数据a的值越大,数据b的值也会越大。

- 如果相关系数=-1,数据点都在一条直线上,表示两种数据之间完全负相关,两种数据是反方向变化。也就是数据a的值越大,数据b的值反而会越小。

- 如果相关系数=0,表明两种数据之间不是线性相关,但有可能是其他方式的相关(例如曲线方式)。

- 如果相关系数>0,说明两种数据是正相关,是同方向变化,也就是一种数据的值越大,另一种数据的值也会越大;如果相关系数<0,说明两种数据是负相关,是反方向变化,也就是一种数据的值越大,另一种数据的值反而会越小,如下图所示。

6)区别相关关系和因果关系

群组分析

1)什么是群组分析法

群组分析方法”(也叫同期群分析方法)是按某个特征,将数据分为不同的组,然后比较各组的数据,说白了就是对数据分组然后来对比。比如按时间划分新用户、按职责划分人群。

2)群组分析的作用

产品会随着时间发布新的版本,产品改版的效果如何?版本更新后用户是增长了,还是流失了?像这类问题,就需要将用户按时间分组,然后比较不同组的用户留存率。所以,群组分析方法常用来分析用户留存率(或者流失率)随时间发生了哪些变化,然后找出用户留下或者离开的原因。

漏斗分析法

1)什么是漏斗分析法

用户建模

session 分析、切分、用户行为序列

详见站内专题:用户画像

数据驱动

- 摘自:关于数据驱动增长的四个问题:是什么?为什么?有何用?怎么用?

- 数据驱动增长”在2015年开始在国内被人提及,作为“Growth Hacking”的一部分,伴随Growth Hacking概念的流行而逐渐被互联网行业的产品、运营、数据分析人员所接受。

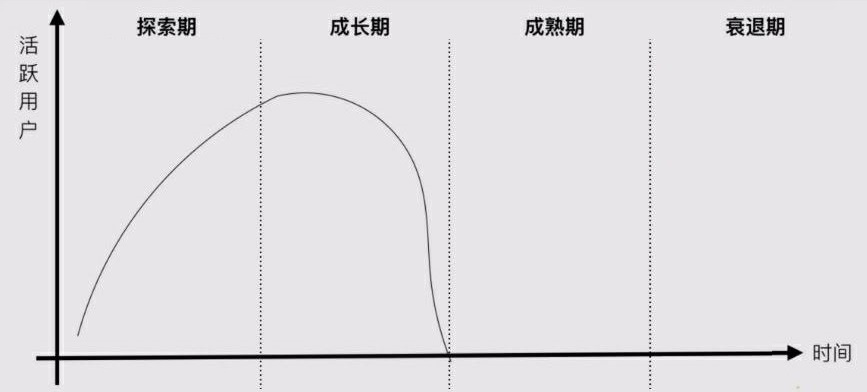

“增长”是什么?

- 通常认为增长是提升DAU、PV、UV,最好的办法就是多引流量。然而事实是:只有“拉新”,没有“留存”的DAU/PV/UV提升不是增长!

- 只拉新不留存”的作死姿势

- 那增长该怎么定义?

- DAU、UV这样的指标属于“虚荣指标”,关注这些指标很容易误入歧途。

- 目前对“增长”最好的解释就是“AARRR”模型,在有的地方也被称为“海盗模型”

- ①获取。就是从搜索引擎、应用市场等渠道,获得产品的“访问新用户”。提升的目标要是:渠道的质量、数量、新用户比例等。

- ②激活。完成“体验完整产品”所需的所有前置操作,如注册、购买等,由“访问新用户”变成“使用用户”。

- ③留存。用户认同产品带给他的价值,持续使用产品。由“使用用户”变成“活跃用户”。

- ④变现。通过点击广告、流量售卖、服务付费等方式回收获客成本并盈利。提升的目标要是:付费转化率、客单价等。

- ⑤推荐。用户对产品的价值非常满意,并推荐他人使用。由“活跃用户”转变为“粉丝用户”。

- 这5个核心指标共同构成了增长,5个指标在产品生命周期的不同阶段中有所侧重

- 探索期更关注“激活”和“留存”

- 增长期更关注“获取”和“推荐”

- 稳定期更关注“变现”。

数据能为增长带来什么

- “转化漏斗”和“留存图(表)”是分析增长数据不可或缺的2个基础工具,可以应用到AARRR模型的每个阶段。具体来说,可以用“转化漏斗”来衡量渠道质量、激活转化率、付费转化率、推荐转化率,可以用“留存图(表)”来衡量日/周/月的留存率。如图6。

- 这2个基本工具再结合下个小节提到的“用户分群”、“用户细查”等工具,可以让我们通过数据发现AARRR中每一步的提升空间和提升方法,这就是数据为增长带来的价值。

数据驱动增长需要什么样的工具

工欲善其事必先利其器,数据驱动增长需要有具备特定功能的工具。从上一小节可以看出,最常用到的数据工具是以下5个:

- ①转化漏斗。如图7。用于量化用户在某个功能的一组操作行为中,各个步骤的转化/流失情况,以及产品内各个功能的使用率。

- ②留存图(表)。如图8。用于分析7日留存、1月后周留存、1年后月留存等数据,可以通过它寻找留存率的提升空间、提升方法,检验产品优化方向的正确性等等。

- ③用户分群。通过用户行为筛选用户群体,达到标记重要功能的作用。

- ④用户细查。可以查看某个用户的所有点击和页面浏览行为,是进行定性研究的利器。

- ⑤来源管理。用于标记用户来源,进而可以分析各渠道的转化率、留存率、新用户占比等流量质量指标。

数据驱动增长的局限性

- 没有数据是万万不能的,但是数据也不是万能的!

- 数据驱动的2个局限性:

- ①数据很难启发重大创新。

- ②某些问题压根没有数据可供分析。

- 除了数据驱动之外,产品的优化一定还要依赖其他驱动力。

数据库

教程

【2023-12-16】数据库教程

在线写sql的网页,不用本地安装;

数据库分类

数据库按照数据结构来组织、存储和管理数据,实际上,数据库一共有三种模型:层次模型,网状模型,关系模型

- 层次模型:以“上下级”的层次关系来组织数据的一种方式,层次模型的数据结构看起来就像一颗树:

- 网状模型:把每个数据节点和其他很多节点都连接起来,它的数据结构看起来就像很多城市之间的路网:

- 关系模型:把数据看作是一个二维表格,任何数据都可以通过行号+列号来唯一确定,它的数据模型看起来就是一个Excel表:

随着时间的推移和市场竞争,最终,基于关系模型的关系数据库获得了绝对市场份额。

- (1)根据数据库的类型划分。

- 关系型数据库: mysql,oracle,sqlserver,postgresql等。

- nosql数据库: mongodb,hbase,cassandra,redis,CouchDB,Riak,Membase等。

- (2)根据数据库的用途划分。

- 缓存数据库:redis,memcached,h2db等

- 日志数据库:kahadb等。

- k-v型数据库:leveldb,redis等。

- (3)检索型存储中间件有:elasticsearch、solr、Lucene等。

NoSQL

NoSQL,主要有四大类型,不同类型适用于不同的存储需求场景:

- 键值数据库:Key-Value Database是一个哈希表,一个特定的值可以指定一个特定的内容(value)。key用来定位。value可以是任何类型。key可以无限扩展。典型代表是内存数据库Redis。

- 列族数据库:以列的形式存储数据,适合批量数据处理和即时查询,降低I/O开销,支持大量并发的用户查询。典型的代表是HBase。

- 文档数据库:文档数据库通过键值定位一个文档。可以看成是键值数据库的衍生品。典型代表产品MangoDB。

- 图数据库:存储有关网络的信息,是为了满足对象之间有很多关系的场景,用于处理具有高度相互关系的数据。比较适合设计网络,依赖分析,路径寻找,模糊识别等,典型代表产品Neo4j。

数据库选型

演变:

- 传统的关系型数据库(RDBMS)是用途最广泛也是用的最多的数据库。关系型数据库是强事物一致性(ACID),使用比较早,技术相对成熟,查询可以根据字段,以及表现各个数据对象之间的关系。在CAP理论中实现的是CA。没有P分区性,单点瓶颈是硬伤。

- 当关系型数据库越来越成为瓶颈时,为解决单点瓶颈牺牲CAP属性中的C,出现了nosql数据库。针对某些特殊的使用场景,出现了非关系型数据库。如:nosql,缓存等。以下针对不同的业务场景阐述各个数据库的特性。

对于数据库的选型,ACID是重要的考虑指标

- 如果对ACID要求很高,应该选择关系型数据库。

- 其次部分对一致性要求不高的,写并发非常大的可以考虑其他的nosql数据库。

- 但是有的业务并发非常高,对ACID要求也非常高,则对业务数据和数据库进行拆分

业务场景

- (1)读多写少

- 对于一般的量级,免费的关系型数据库mysql、postgresql是首选。支持事物,稳定性和成熟度比较好。

- 当访问量越来越大,数据量不大时。写不是瓶颈,而读成为主要瓶颈。改进方法:

- 主从分离:增加从库分担读的压力

- 加缓存:在数据库和应用系统之间加一层缓存 memcache,redis。增加缓存之后,能抗住很多压力,大大降低了数据库的读请求。

- (2)读多写多

- 高并发场景中,对数据库的操作往往提现在高并发读和高并发写。当读和写都成为瓶颈时,这时采用的方案有:

- 1)对数据库进行横向和纵向扩展。按业务划分,把一个数据库实例扩展成多个实例。按数据分片,把单表大数据量,水平分片成多个小表。

- 2)使用内存表负载压力。常见的内存表有:redis开启aof功能。业务数据要持久化落盘。否则进程一旦重启,内存数据就会丢失。

- 数据库举例

- redis:是有硬盘存储的内存数据库,可以支持Master-Slave复制,其可以提供并发量远高于关系型数据库。支持的数据结构:K-V,K-Sets,K-Queue,K-Hash。可适用于高并发读写业务场景,但局限于其数据结构,不能做复杂查询,只能以Key键值为基础数据结构操作。

- memcachedb:是基于memcache添加了BerkeleyDB存储机制和主辅复制而来。支持的数据结构只要K-V结构。可适用于高并发读写业务场景,同样只局限于其数据结构,不能做复杂查询,只能以Key键值为基础数据结构操作。

- MongoDB:支持Master-Salve复制,无schema,json结构。字段可以任意扩展,可以建立字段索引和全字段索引。可以对任意字段建立索引查询。数据量越来越大时,是吃内存的大户,数据一致性问题会越来越严重。如果对数据一致性要求不高的读多写多业务,可以考虑使用此数据库存储。

- (3)读少写多

- 海量数据的写入。如货车app中的gps路线轨迹数据,每天的写入库的数据量上亿条。如此巨大的写入量用关系型数据库显然是不合适的。关系型数据库虽然可以采用批量导入的方式增强写入能力,但其强制落盘,对磁盘IO是影响主要因素。cassandra和habase其先写内存,异步落盘机制对磁盘IO消耗更低。

- 数据库示例

- Cassandra:java开发,结构简单。其数据采用分片机制,副本备份与容错复制。面向列式存储。内存写入与异步刷盘的机制,使其在写操作远高于读操作场景中,也能轻松应对。

- HBASE:支持数十亿行,数百万列。对于海量数据的宽表,面向列式存储,无schema,可任意扩展列。

- (4)读少写少

- 在小系统,业务量低、数据量少的系统,对读写操作都比较少,当然是怎么快就怎么来。选用mysql免费数据库是最合适的选择。

- (5)复杂条件检索

- 关系型数据库通常使用b+tree索引,非关系型数据库如cassandra使用LSM结构索引。所有的索引多列复杂条件查询的检索效率远远低于索引引擎。

- 常用开源的搜索引擎有luence,solr,elasticsearch,sphinx等。

- solr:查询快,但是更新索引速度偏慢。主要应用于那种对数据的实时性要求不高的业务。

- elasticserach:更新速度比solr快,但是查询速度相对solr较慢。主要应用于实时索引查询的业务。

总结

- 1)对ACID有强要求业务一般使用的数据存储采用关系型数据库,如mysql,postgresql、oracle、sql server等。

- 2)读多写少的场景,使用非关系型数据库Cassandra、hbase、MongoDB等。

- 3)缓解高并发读对数据库造成的读瓶颈,使用缓存:memcached、redis等。

- 4)复杂的数据检索,使用外置索引:elasticsearch、solr等。

MySQL

python使用mysql方法

mysql安装方法

- 【2021-6-17】mysql官方下载,适配各种操作系统,含UI界面工具workbench

# 下载mysql包

# 解压,如果是tar.xz文件,使用xz -d命令解压

tar -xzvf mysql-5.7.26-linux-glibc2.12-x86_64.tar.gz -C /usr/local/

# 创建用户和组

groupadd mysql

useradd -r -g mysql mysql

# 将安装目录所有者及所属组改为mysql

chown -R mysql.mysql /usr/local/mysql

# 创建data目录

mkdir data #进入mysql文件夹

#

yum install libaio

/usr/local/mysql/bin/mysqld --user=mysql --basedir=/usr/local/mysql/ --datadir=/usr/local/mysql/data --initialize

连接mysql

shell 代码,shell脚本中调用sql脚本

#mysql初始化-shell

mysql=/usr/local/mysql/bin/mysql

$mysql -uroot -pwqw < init.sql

或者shell脚本中直接执行sql

mysql=/usr/local/mysql/bin/mysql

$mysql -uroot -p123456 <<EOF

source /root/temp.sql;

select current_date();

delete from tempdb.tb_tmp where id=3;

select * from tempdb.tb_tmp where id=2;

EOF

PostGreSQL

分析工具

excel数据分析

常用函数

常用的是文本函数,逻辑函数,日期与时间函数,查找与引用函数,数学函数等

相对引用于绝对引用:

- 相对引用:单元格或单元格区域的相对引用是指相对于包含公式的单元格的相对位置。例如,单元格 B2 包含公式 =A1 ;Excel 将在距单元格 B2 上面一个单元格和左面一个单元格处的单元格中查找数值。

- 绝对引用:1 乘以单元格 A2 (=A1*A2)放到A4中,现在将公式复制到另一单元格中,则 Excel 将调整公式中的两个引用。如果不希望这种引用发生改变,须在引用的”行号”和”列号”前加上美元符号($),这样就是单元格的绝对引用。A4中输入公式如下:

=$A$1*$A$2 复制A4中的公式到任何一个单元格其值都不会改变

【2021-11-18】Excel最常用函数介绍, 一篇说尽Excel常见函数用法

| 函数名 | 作用 | 用法 | 示例 |

|---|---|---|---|

| LEN | 统计文本字符串中字符数目(计算文本的长度) | LEN(text) | |

| SEARCH | 检索字符位置(不区分大小写) | SEARCH(find_text,within_text,start_num) | |

| FREQUENCY | 计算区间里所含数值的个数 | FREQUENCY(data_array,bins_array) | =FREQUENCY($C$19:$C$30,$E$19:$E$23) |

| INDEX | (数组形式)返回行和列交叉位置的值;(单元格引用方式)返回行和列交差位置的单元格引用 | INDEX(array,row_num,column_num) | |

| MATCH | 返回搜索值的相对位置 | MATCH(lookup_value,lookup_array,match_type) | MATCH(“b”,{“a”,”b”,”c”},0) |

| OFFSET | 计算指定位置的单元格引用 | OFFSET(reference,rows,cols,height,width) | =SUM(OFFSET(B5,6,2,1,2)) |

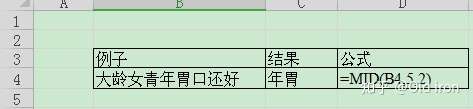

| MID | 文本字符串截取指定数目的子串 | MID(text, start_num, num_chars) |  |

| REPLACE | 替换 | =REPLACE( old_text , start_num , num_chars , new_text ) | |

| CONCATENATE(或&) | 单元格(文本、数字)连接 | CONCATENATE(text1,text2,……) |  |

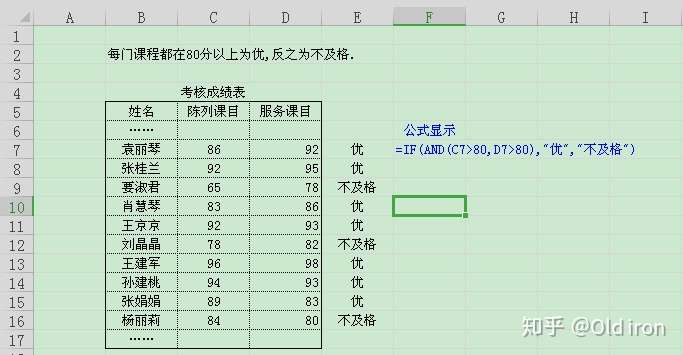

| AND/OR/NOT | 条件是否都满足;可以IF配合使用;逻辑值或数值时,函数AND返回错误值#VALUE | AND(logical1,logical2,……logical30) |  |

| IF | 分支判断 | IF(logical_test,value_if_true,value_if_false) |  |

| IS | |||

| MIN/MAX | |||

| SUM/SUMIF | SUMIF ( range , criteria , sum_range ) | ||

| SUMPRODUCT | 数组点积(对应元素相乘) | ||

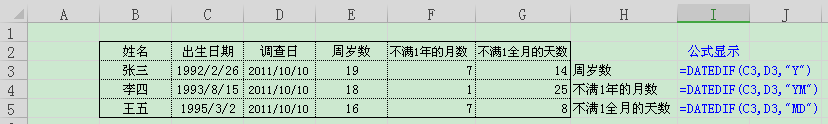

| DATEDIF | 计算期间内的年数、月数、天数 | =DATEDIF(start_date,end_date,”m”) |  |

| COUNTIF | 计算满足条件的单元格计数 | COUNTIF(range,criteria) |  |

| SUMIF | 对满足条件的单元格的数值求和 | SUMIF(range,criteria,sum_range) | =SUMIF($B$4:$B$14,”家居*”,$C$4:$C$14) |

| DCOUNT | 计算满足条件的数值的个数 | DCOUNT(database,field,criteria) |  |

| ISERROR | 查看是否为错误,查看是否值为任意错误值 | ISERROR(value) | |

| VLOOKUP | 按照垂直方向搜索区域 | VLOOKUP(lookup_value,table_array,col_index_num,range_lookup) |

COUNTIF函数几种用法:

- 求包含值139的单元格数量 ‘=COUNTIF($D$4:$D$14,139)

- 求包含负值的单元格数量 ‘=COUNTIF($C$4:$C$14,”<0”)

- 求不等于0 的单元格数量 ‘=COUNTIF($C$4:$C$14,”<>0”)

- 求大于等于5的单元格数量 ‘=COUNTIF($C$4:$C$14,”>=5”)

- 求等于单元格B45中内容的单元格数量 ‘=COUNTIF($B$4:$B$14,B4)

- 求大于单元格E45中内容的单元格数量 ‘=COUNTIF($E$4:$E$14,”>”&E4)

- 求包含文本内容的单元格数量 ‘=COUNTIF($B$4:$B$14,”*”)

- 求包含六个字符内容的单元格数量 ‘=COUNTIF($B$4:$B$14,”??????”)

- 求在文本中任何位置包含单词”文胸”字符内容的单元格数量 ‘=COUNTIF($B$4:$B$14,”文胸”)

- 求包含以英文”D”(不分大小写)开头内容的单元格数量 ‘=COUNTIF($B$4:$B$14,”D*”)

- 求包含当前日期的单元格数量 ‘=COUNTIF($E$4:$E$14,TODAY())

- 求大于平均值的单元格数量 ‘=COUNTIF($D$4:$D$14,”>”&AVERAGE($D$5:$D$14))

vlookup

loopup

使用格式:VLOOKUP(lookup_value,table_array,col_index_num,range_lookup)

参数定义:

- Lookup_value:为需要在数组第一列中查找的数值.Lookup_value可以为数值、引用或文本字符串.

- Table_array: 为需要在其中查找数据的数据表.可以使用对区域或区域名称的引用,例如数据库或列表.

- Col_index: 为table_array中待返回的匹配值的列序号. Col_index_num为1时,返回table_array第一列中的数值;col_index_num为2,返

- table_array第二列中的数值,以此类推.如果col_index_num小于1,函数VLOOKUP返回错误值值#VALUE!;如果col_index_num大于table_array的

- 数, 函数VLOOKUP返回错误值#REF!.

- Range_lookup:为一逻辑值,指明函数VLOOKUP返回时是精确匹配还是近似匹配.如果为TRUE或省略,则返回近似匹配值.也就是说.如果找不到精确匹配值,则返回小于lookup_value的最大数值;如果range_value为FALSE,函数VLOOKUP将返回精确匹配值.如果找不到,则返回错误值#N/A.

注意:

- 如果range_lookup为TRUE,则table_array的第一列中的数值必须按升序排列:…、 -2、-1、0、1、2、…、-Z、FALSE、TRUE;否则,函数VLOOKUP不能返回正确的数值.如果range_lookup为FALSE,table_array不必进行排序.

- Table_array的第一列中的数值可以为文本、数字或逻辑值.

- 文本不区分大小写.

- 如果函数VLOOKUP找不到lookup_value,且range_lookup为TRUE,则使用小于等于lookup_value的最大值.

- 如果lookup_value小于table_array第一列中的最小数值,函数VLOOKUP返回错误值#N/A.

- 如果函数VLOOKUP找不到lookup_value且range_lookup为FALSE,函数VLOOKUP返回错误值#N/A.

- 若有多个符合条件的情况:vlookup返回的是第一个满足条件的值,lookup返回的是最后一个满足条件的值.

公式:=VLOOKUP(H5,B5:D13,3,0)

精确查找是vlookup最基本也是最常用的功能,对于数据量大的查找,其速度比菜单中的查找还快.设置vlookup第四个参数为false或0,即为精确查找.

爬虫

网页抓取

html→text

将 html格式 文件转换成 文本文件

- 直接使用BeautifulSoup的get_text方法

- 结合 BeautifulSoup+html2text 工具

- html.parser

from bs4 import BeautifulSoup

soup = BeautifulSoup(html)

print(soup.get_text()) # 不含换行符

print(soup.get_text('\n')) # 保留换行符

soup.get_text().replace('\n','\n\n') # To be identical to your example, you can replace a newline with two newlines

import html2text

from BeautifulSoup import BeautifulSoup

soup = BeautifulSoup(urllib2.urlopen('http://example.com/page.html').read())

txt = soup.find('div', {'class' : 'body'})

print(html2text.html2text(txt))

from html.parser import HTMLParser

class HTMLFilter(HTMLParser):

text = ""

def handle_data(self, data):

self.text += data

f = HTMLFilter()

f.feed(data)

print(f.text)

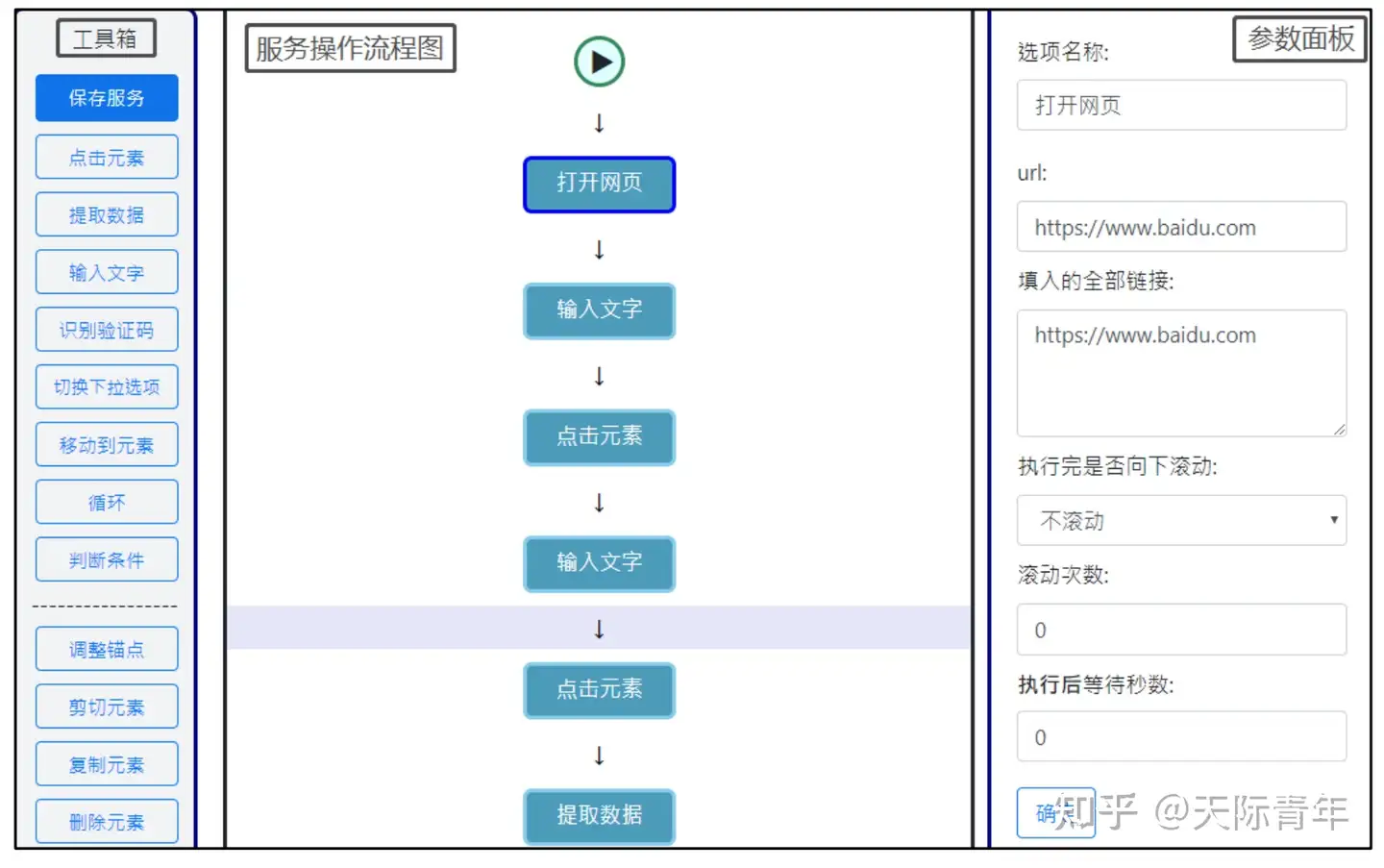

可视化爬虫

【2021-12-28】可视化爬虫工具:spider-flow,智能高效的在线爬虫,以流程图的方式定义爬虫

EasySpider

EasySpider 是一款完全免费和开源的可视化爬虫软件,此软件可以让大家使用图形化界面,无代码可视化的设计和执行爬虫任务。只需要在网页上选择自己想要爬的内容并根据提示框操作即可完成爬虫设计和执行。同时软件还可以直接在命令行中通过传参的方式执行,从而可以很方便的嵌入到其他系统中。

- github

- 下载图片,元素截图,执行任意JS指令和系统命令,通过JS代码进行条件判断,OCR识别等等功能,想要的功能应有尽有,而且这些功能完全免费

python抓取链接二手房数据

- 链家二手房数据分析

- scrapy爬链家成都房价并可视化

- 抓知乎爬虫

- 【2019-11-24】链家房源爬虫及可视化,github

模拟登录

cookie 与 session

cookie信息是保存在本地浏览器里面的,服务器上并不存储相关的信息。

- 在发送请求时,cookie的这些内容是放在 Http协议中的header 字段中进行传输的。

cookie不安全,所以有了session机制。

整过过程:

- 服务器根据用户名和密码,生成一个session ID,存储到服务器的数据库中。

- 用户登录访问时,服务器会将对应的session ID发送给用户(本地浏览器)。

- 浏览器会将这个session ID存储到cookie中,作为一个键值项。

- 以后,浏览器每次请求,就会将含有session ID的cookie信息,一起发送给服务器。

- 服务器收到请求之后,通过cookie中的session ID,到数据库中去查询,解析出对应的用户名,就知道是哪个用户的请求了。

总结

【2022-12-5】Python模拟登录的几种方法

- 方法一:直接使用已知的cookie访问

- 特点:简单,但需要先在浏览器登录

- 方法二:模拟登录后再携带得到的cookie访问

- 方法三:模拟登录后用session保持登录状态

- 方法四:使用无头浏览器访问

方法一:直接使用已知的cookie访问

特点:简单,但需要先在浏览器登录

原理:

- cookie保存在发起请求的客户端中,服务器利用cookie来区分不同的客户端。因为http是一种无状态的连接,当服务器一下子收到好几个请求时,是无法判断出哪些请求是同一个客户端发起的。

- 只要得到了别的客户端的cookie,就可以假冒成它来和服务器对话。

操作

- 用浏览器登录,用开发者工具查看cookie。

- network选项卡。在左边的Name一栏找到当前的网址,选择右边的Headers选项卡,查看Request Headers,这里包含了该网站颁发给浏览器的cookie。

- 在程序中携带该cookie向网站发送请求,就能让程序假扮成刚才登录的那个浏览器,得到只有登录后才能看到的页面。

requests库的版本:

import requests

import sys

import io

sys.stdout = io.TextIOWrapper(sys.stdout.buffer,encoding='utf8') #改变标准输出的默认编码

# 登录后才能访问的网页

url = 'http://ssfw.xmu.edu.cn/cmstar/index.portal'

# 浏览器登录后得到的cookie,也就是刚才复制的字符串

cookie_str = r'JSESSIONID=xxxxxxxxxxxxxxxxxxxxxx; iPlanetDirectoryPro=xxxxxxxxxxxxxxxxxx'

# 把cookie字符串处理成字典,以便接下来使用

cookies = {}

for line in cookie_str.split(';'):

key, value = line.split('=', 1)

cookies[key] = value

方法二:模拟登录后再携带得到的cookie访问

方法二:模拟登录后再携带得到的cookie访问

原理:

- 先在程序中向网站发出登录请求,提交包含登录信息的表单(用户名、密码等)。从响应中得到cookie,访问其他页面时也带上这个cookie,就能得到只有登录后才能看到的页面。

具体步骤:

- 找出表单提交到的页面

- 开发者工具, 转到network选项卡,并勾选Preserve Log(重要!)。在浏览器里登录网站。

- 然后在左边的Name一栏找到表单提交到的页面。

- 找出要提交的数据

- 虽然浏览器登陆时只填了用户名和密码,但表单里包含的数据可不只这些。从Form Data里就可以看到需要提交的所有数据。

requests库的版本:

import requests

import sys

import io

sys.stdout = io.TextIOWrapper(sys.stdout.buffer,encoding='utf8') #改变标准输出的默认编码

# 登录后才能访问的网页

url = 'http://ssfw.xmu.edu.cn/cmstar/index.portal'

# 浏览器登录后得到的cookie,也就是刚才复制的字符串

cookie_str = r'JSESSIONID=xxxxxxxxxxxxxxxxxxxxxx; iPlanetDirectoryPro=xxxxxxxxxxxxxxxxxx'

# 把cookie字符串处理成字典,以便接下来使用

cookies = {}

for line in cookie_str.split(';'):

key, value = line.split('=', 1)

cookies[key] = value

# 设置请求头

headers = {'User-agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.113 Safari/537.36'}

# 在发送get请求时带上请求头和cookies

resp = requests.get(url, headers = headers, cookies = cookies)

print(resp.content.decode('utf-8'))

方法三:模拟登录后用session保持登录状态

原理:

- session是会话的意思。和cookie的相似之处在于,它也可以让服务器“认得”客户端。

- 把每一个客户端和服务器的互动当作一个“会话”。既然在同一个“会话”里,服务器自然就能知道这个客户端是否登录过。

具体步骤:

- 找出表单提交到的页面

- 找出要提交的数据

这两步和方法二的前两步是一样的

写代码

import requests

import sys

import io

sys.stdout = io.TextIOWrapper(sys.stdout.buffer,encoding='utf8') #改变标准输出的默认编码

# 登录时需要POST的数据

data = {'Login.Token1':'学号',

'Login.Token2':'密码',

'goto:http':'//ssfw.xmu.edu.cn/cmstar/loginSuccess.portal',

'gotoOnFail:http':'//ssfw.xmu.edu.cn/cmstar/loginFailure.portal'}

# 设置请求头

headers = {'User-agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.113 Safari/537.36'}

# 登录时表单提交到的地址(用开发者工具可以看到)

login_url = 'http://ssfw.xmu.edu.cn/cmstar/userPasswordValidate.portal'

# 构造Session

session = requests.Session()

# 在session中发送登录请求,此后这个session里就存储了cookie

# 可以用print(session.cookies.get_dict())查看

resp = session.post(login_url, data)

# 登录后才能访问的网页

url = 'http://ssfw.xmu.edu.cn/cmstar/index.portal'

# 发送访问请求

resp = session.get(url)

print(resp.content.decode('utf-8'))

方法四:使用无头浏览器访问

特点:

- 功能强大,几乎可以对付任何网页,但会导致代码效率低

原理:

- 如果能在程序里调用一个浏览器来访问网站,那么像登录这样的操作就轻而易举了。

- 在Python中可以使用 Selenium库 来调用浏览器,写在代码里的操作(打开网页、点击……)会变成浏览器忠实地执行。这个被控制的浏览器可以是Firefox,Chrome等,但最常用的还是 PhantomJS 这个无头(没有界面)浏览器。

- 只要把填写用户名密码、点击“登录”按钮、打开另一个网页等操作写到程序中,PhamtomJS就能确确实实地让你登录上去,并把响应返回给你。

具体步骤:

- 安装selenium库、PhantomJS浏览器

- 在源代码中找到登录时的输入文本框、按钮这些元素

- 因为要在无头浏览器中进行操作,所以就要先找到输入框,才能输入信息。找到登录按钮,才能点击它。

- 在浏览器中打开填写用户名密码的页面,将光标移动到输入用户名的文本框,右键,选择“审查元素”,就可以在右边的网页源代码中看到文本框是哪个元素。同理,可以在源代码中找到输入密码的文本框、登录按钮。

- 考虑如何在程序中找到上述元素

import requests

import sys

import io

from selenium import webdriver

sys.stdout = io.TextIOWrapper(sys.stdout.buffer, encoding='utf8') #改变标准输出的默认编码

# 建立Phantomjs浏览器对象,括号里是phantomjs.exe在你的电脑上的路径

browser = webdriver.PhantomJS('d:/tool/07-net/phantomjs-windows/phantomjs-2.1.1-windows/bin/phantomjs.exe')

# 登录页面

url = r'http://ssfw.xmu.edu.cn/cmstar/index.portal'

# 访问登录页面

browser.get(url)

# 等待一定时间,让js脚本加载完毕

browser.implicitly_wait(3)

# 输入用户名

username = browser.find_element_by_name('user')

username.send_keys('学号')

# 输入密码

password = browser.find_element_by_name('pwd')

password.send_keys('密码')

# 选择“学生”单选按钮

student = browser.find_element_by_xpath('//input[@value="student"]')

student.click()

#点击“登录”按钮

login_button = browser.find_element_by_name('btn')

login_button.submit()

# 网页截图

browser.save_screenshot('picture1.png')

# 打印网页源代码

print(browser.page_source.encode('utf-8').decode())

browser.quit()

文件下载

wget

windows版 wget

- Windows系统使用wget批量下载NASA遥感数据

- wget批量下载txt文件内的所有链接

# windows 终端命令

wget --load-cookies C:\.urs_cookies --save-cookies C:\.urs_cookies --auth-no-challenge=on --keep-session-cookies --user=<your username> --ask-password --content-disposition -i myfile.dat

wget 包

- 用 pip 安装这个包

- 实际下载只有一行

- wget.download(url, path) ,只有两个参数,第一个是网址,第二个是存放路径。

- 如果下载网址有规律的话,使用一个 for 循环就能批量下载了。

import wget

import tempfile

url = 'https://p0.ifengimg.com/2019_30/1106F5849B0A2A2A03AAD4B14374596C76B2BDAB_w1000_h626.jpg'

# 获取文件名

file_name = wget.filename_from_url(url)

print(file_name) #1106F5849B0A2A2A03AAD4B14374596C76B2BDAB_w1000_h626.jpg

# ① 下载文件,使用默认文件名,结果返回文件名

file_name = wget.download(url)

print(file_name) #1106F5849B0A2A2A03AAD4B14374596C76B2BDAB_w1000_h626.jpg

# ② 下载文件,重新命名输出文件名

target_name = 't1.jpg'

file_name = wget.download(url, out=target_name)

print(file_name) #t1.jpg

# ③ 创建临时文件夹,下载到临时文件夹里

tmpdir = tempfile.gettempdir()

target_name = 't2.jpg'

file_name = wget.download(url, out=os.path.join(tmpdir, target_name))

print(file_name) #/tmp/t2.jpg

#===============

# 批量下载 pdf

import wget

path = 'D:\Desktop'

for i in range(1,20):

if i < 10:

new_i = "0"+str(i) # 如果是单个数字,前面加零

else:

new_i = str(i)

url = f'https://see.stanford.edu/materials/lsocoee364a/transcripts/ConvexOptimizationI-Lecture{new_i}.pdf'

wget.download(url, path)

requests

单个文件下载

#引用 requests文件

import requests

Download_addres='' # 下载地址

# 把下载地址发送给requests模块

f=requests.get(Download_addres)

# 下载文件

with open("12.xlsx","wb") as code:

code.write(f.content)

多文件下载

批量文件下载

- excel文档中,保存url和文件名/编号。

- request读取网页内容,filetype判断文件类型,批量下载保存。

需要安装filetype包:pip install filetype

# -*- coding: utf-8 -*-

"""

Created on Mon Feb 22 10:24:35 2021

@author: wangqiwen

"""

import requests

import pandas as pd

import filetype

myHeaders = {'User-Agent': "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.141 Safari/537.36"}

# 定义文件下载函数 downloadFile

def downloadFile(url,savePath):

# 将网页链接 url,文件夹路径 savePath 作为参数传入

try:

webPage = requests.get(url, headers = myHeaders, timeout=5)

#print(webPage.status_code)

# 获取网页

webContent = webPage.content

# 网页内容

file_type = filetype.guess(webContent).extension

# 识别文件类型

#print(file_type)

file_path = savePath + fileId + '.' + file_type

# 根据文件夹路径、文件名id、文件类型,组合文件保存路径

f = open(file_path, 'wb')

f.write(webContent)

# 将网页内容写入保存路径中

f.close()

except requests.exceptions.RequestException:

print(fileId + '超时')

# 读取excel表格

data = pd.read_excel(r'D:\保存url和文件编号的文档.xlsx')

#data = pd.read_excel(r'D:\保存url和文件编号的文档.xlsx', sheet_name='abc')

# 下载文件保存文件夹

savePath = 'D:/文件下载/'

for i in data.index:

fileId = str(data.loc[i, '编号'])

url = str(data.loc[i, 'url'])

if url == 'nan':

continue

else:

downloadFile(url,savePath)

带进度条

实现分段、连续下载文件。

import requests

# 文件下载直链

url = 'https://issuecdn.baidupcs.com/issue/netdisk/yunguanjia/BaiduNetdisk_7.2.8.9.exe'

# 请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36 QIHU 360SE'

}

# 发起 head 请求,即只会获取响应头部信息

head = requests.head(url, headers=headers)

# 文件大小,以 B 为单位

file_size = head.headers.get('Content-Length')

if file_size is not None:

file_size = int(file_size)

response = requests.get(url, headers=headers, stream=True)

# 一块文件的大小

chunk_size = 1024

# 记录已经读取的文件大小

read = 0

for chunk in response.iter_content(chunk_size=chunk_size):

read += chunk_size

read = min(read, file_size)

print(f'已读取: {read} 总大小: {file_size}')

但是输出显然太多了,有一个单行的进度条更好。 tqdm 这个进度条库

import time

from tqdm import tqdm

total = 100

for _ in tqdm(range(total)):

time.sleep(0.1)

# ---- 自定义进度更新次数 ----

# 每次刷新的进度

step = 10

# 总共要刷新的次数

flush_count = total//step

bar = tqdm(total=total)

for _ in range(flush_count):

time.sleep(0.1)

bar.update(step)

bar.close()

下载进度条

import requests

# 导入 tqdm

from tqdm import tqdm

# 文件下载直链

url = 'https://issuecdn.baidupcs.com/issue/netdisk/yunguanjia/BaiduNetdisk_7.2.8.9.exe'

# 请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36 QIHU 360SE'

}

file_name = 'BaiduNetdisk_7.2.8.9.exe'

# 发起 head 请求,即只会获取响应头部信息

head = requests.head(url, headers=headers)

# 文件大小,以 B 为单位

file_size = head.headers.get('Content-Length')

if file_size is not None:

file_size = int(file_size)

response = requests.get(url, headers=headers, stream=True)

# 一块文件的大小

chunk_size = 1024

bar = tqdm(total=file_size, desc=f'下载文件 {file_name}')

with open(file_name, mode='wb') as f:

# 写入分块文件

for chunk in response.iter_content(chunk_size=chunk_size):

f.write(chunk)

bar.update(chunk_size)

# 关闭进度条

bar.close()

多线程

multitasking 工具

import time

# 导入用于多线程操作的库

# 这样子仅需要在自定义的函数前面使用装饰器即可将函数开启新的线程

import multitasking

import signal

# 按快捷键 ctrl + c 终止已开启的全部线程

signal.signal(signal.SIGINT, multitasking.killall)

# 多线程装饰器

@multitasking.task

def say(number: int):

print(number)

time.sleep(0.5)

start_time = time.time()

for i in range(5):

say(i)

# 等待全部线程执行完毕

multitasking.wait_for_tasks()

end_time = time.time()

print('耗时:', end_time-start_time, '秒')

带进度条的多线程下载器

from __future__ import annotations

from tqdm import tqdm # 用于显示进度条

import requests # 用于发起网络请求

import multitasking # 用于多线程操作

import signal

# 导入 retry 库以方便进行下载出错重试

from retry import retry

signal.signal(signal.SIGINT, multitasking.killall)

# 请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36 QIHU 360SE'

}

# 定义 1 MB 多少为 B

MB = 1024**2

def split(start: int, end: int, step: int) -> list[tuple[int, int]]:

# 分多块

parts = [(start, min(start+step, end))

for start in range(0, end, step)]

return parts

def get_file_size(url: str, raise_error: bool = False) -> int:

'''

获取文件大小

url : 文件直链

raise_error : 如果无法获取文件大小,是否引发错误

------

文件大小(B为单位), 如果不支持则会报错

'''

response = requests.head(url)

file_size = response.headers.get('Content-Length')

if file_size is None:

if raise_error is True:

raise ValueError('该文件不支持多线程分段下载!')

return file_size

return int(file_size)

def download(url: str, file_name: str, retry_times: int = 3, each_size=16*MB) -> None:

'''

根据文件直链和文件名下载文件

----------

url : 文件直链

file_name : 文件名

retry_times: 可选的,每次连接失败重试次数

'''

f = open(file_name, 'wb')

file_size = get_file_size(url)

@retry(tries=retry_times)

@multitasking.task

def start_download(start: int, end: int) -> None:

'''

根据文件起止位置下载文件

----------

start : 开始位置

end : 结束位置

'''

_headers = headers.copy()

# 分段下载的核心

_headers['Range'] = f'bytes={start}-{end}'

# 发起请求并获取响应(流式)

response = session.get(url, headers=_headers, stream=True)

# 每次读取的流式响应大小

chunk_size = 128

# 暂存已获取的响应,后续循环写入

chunks = []

for chunk in response.iter_content(chunk_size=chunk_size):

# 暂存获取的响应

chunks.append(chunk)

# 更新进度条

bar.update(chunk_size)

f.seek(start)

for chunk in chunks:

f.write(chunk)

# 释放已写入的资源

del chunks

session = requests.Session()

# 分块文件如果比文件大,就取文件大小为分块大小

each_size = min(each_size, file_size)

# 分块

parts = split(0, file_size, each_size)

print(f'分块数:{len(parts)}')

# 创建进度条

bar = tqdm(total=file_size, desc=f'下载文件:{file_name}')

for part in parts:

start, end = part

start_download(start, end)

# 等待全部线程结束

multitasking.wait_for_tasks()

f.close()

bar.close()

if "__main__" == __name__:

# url = 'https://mirrors.tuna.tsinghua.edu.cn/pypi/web/packages/0d/ea/f936c14b6e886221e53354e1992d0c4e0eb9566fcc70201047bb664ce777/tensorflow-2.3.1-cp37-cp37m-macosx_10_9_x86_64.whl#sha256=1f72edee9d2e8861edbb9e082608fd21de7113580b3fdaa4e194b472c2e196d0'

url = 'https://issuecdn.baidupcs.com/issue/netdisk/yunguanjia/BaiduNetdisk_7.2.8.9.exe'

file_name = 'BaiduNetdisk_7.2.8.9.exe'

# 开始下载文件

download(url, file_name)

json使用

shell中使用json

- #[2016-12-31] shell中使用json

- 安装:

pip install git+https://github.com/dominictarr/JSON.sh#egg=JSON.sh

- 使用:

echo '{"a":2,"b":[3,6,8]}' |JSON.sh详情参考:https://github.com/dominictarr/JSON.sh

Python工具包

命令:

- mysql -h10.26.21.38 -utest -p123

两个工具包:

- MySQLdb:MySQLdb(MySQL-python)仅支持python2

- pymysql:MySQL-python不支持py3,可以pip install pymysql代替

要想使python可以操作mysql,就需要MySQL-python驱动,它是python 操作mysql必不可少的模块。

- 下载地址

- 下载MySQL-python-1.2.5.zip 文件之后直接解压。

- 进入MySQL-python-1.2.5目录:

python setup.py install

#!pip install mysqldb

#!/usr/bin/python

# -*- coding: UTF-8 -*-

import MySQLdb

# 打开数据库连接

db = MySQLdb.connect("localhost", "testuser", "test123", "TESTDB", charset='utf8' )

# 使用cursor()方法获取操作游标

cursor = db.cursor()

# 使用execute方法执行SQL语句

cursor.execute("SELECT VERSION()")

# 使用 fetchone() 方法获取一条数据

data = cursor.fetchone()

print("Database version : %s " % data)

# 关闭数据库连接

db.close()

【2021-7-8】pymysql使用教程

import pymysql

# 连接database

conn = pymysql.connect(

host='10.26.21.38',

user='test',password='123456',

#database='test',

charset='utf8')

# 得到一个可以执行SQL语句的光标对象

cursor = conn.cursor() # 执行完毕返回的结果集默认以元组显示

# 得到一个可以执行SQL语句并且将结果作为字典返回的游标

#cursor = conn.cursor(cursor=pymysql.cursors.DictCursor)

# 定义要执行的SQL语句

sql = """

CREATE TABLE USER1 (

id INT auto_increment PRIMARY KEY ,

name CHAR(10) NOT NULL UNIQUE,

age TINYINT NOT NULL

)ENGINE=innodb DEFAULT CHARSET=utf8; #注意:charset='utf8' 不能写成utf-8

"""

#============= 查询数据 ========

sql = "select * from nlp_data_collection.t_intention limit 10"

res = cursor.execute(sql) # 执行SQL语句,只返回条数

print(res)

#cursor.scroll(1,mode='absolute') # 相对绝对位置移动,第一个参数是相对绝对位置移动的记录条个数

# cursor.scroll(1,mode='relative') # 相对当前位置移动,第一个参数是相对当前位置移动的记录条个数

#通过fetchone、fetchmany、fetchall拿到查询结果

res1=cursor.fetchone() #以元组的形式,返回查询记录的结果,默认是从第一条记录开始查询

# res2=cursor.fetchone() #会接着上一次的查询记录结果继续往下查询

# res3=cursor.fetchone()

# res4=cursor.fetchmany(2) #查询两条记录会以元组套小元组的形式进行展示

res5=cursor.fetchall()

print(res5)

#============= 插入数据 ========

# 获取一个光标

cursor = conn.cursor()

# 定义要执行的sql语句

sql = 'insert into userinfo(user,pwd) values(%s,%s);'

data = [

('july', '147'),

('june', '258'),

('marin', '369')

]

# 拼接并执行sql语句

rows = cursor.execute(sql,data[0]) # 单条语句

cursor.executemany(sql, data) # 多条语句

print(cursor.lastrowid) # 当前插入的第一条记录

conn.commit() # 涉及写操作要注意提交

#============= 删除数据 ========

cursor = conn.cursor() # 获取一个光标

# 定义将要执行的SQL语句

sql = "delete from userinfo where user=%s;"

name = "june"

cursor.execute(sql, [name]) # 拼接并执行SQL语句

conn.commit() # 涉及写操作注意要提交

#============= 更改数据 ========

cursor = conn.cursor()

# 定义将要执行的SQL语句

sql = "update userinfo set pwd=%s where user=%s;"

# 拼接并执行SQL语句

cursor.execute(sql, ["july", "july"])

conn.commit() # 涉及写操作注意要提交

cursor.close() # 关闭光标对象

conn.close() # 关闭数据库连接

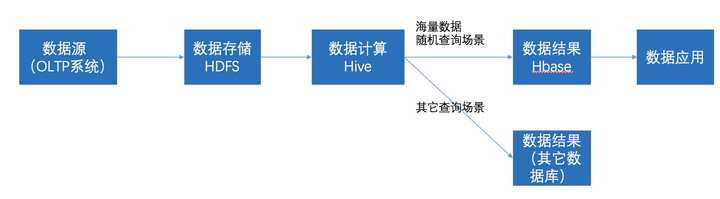

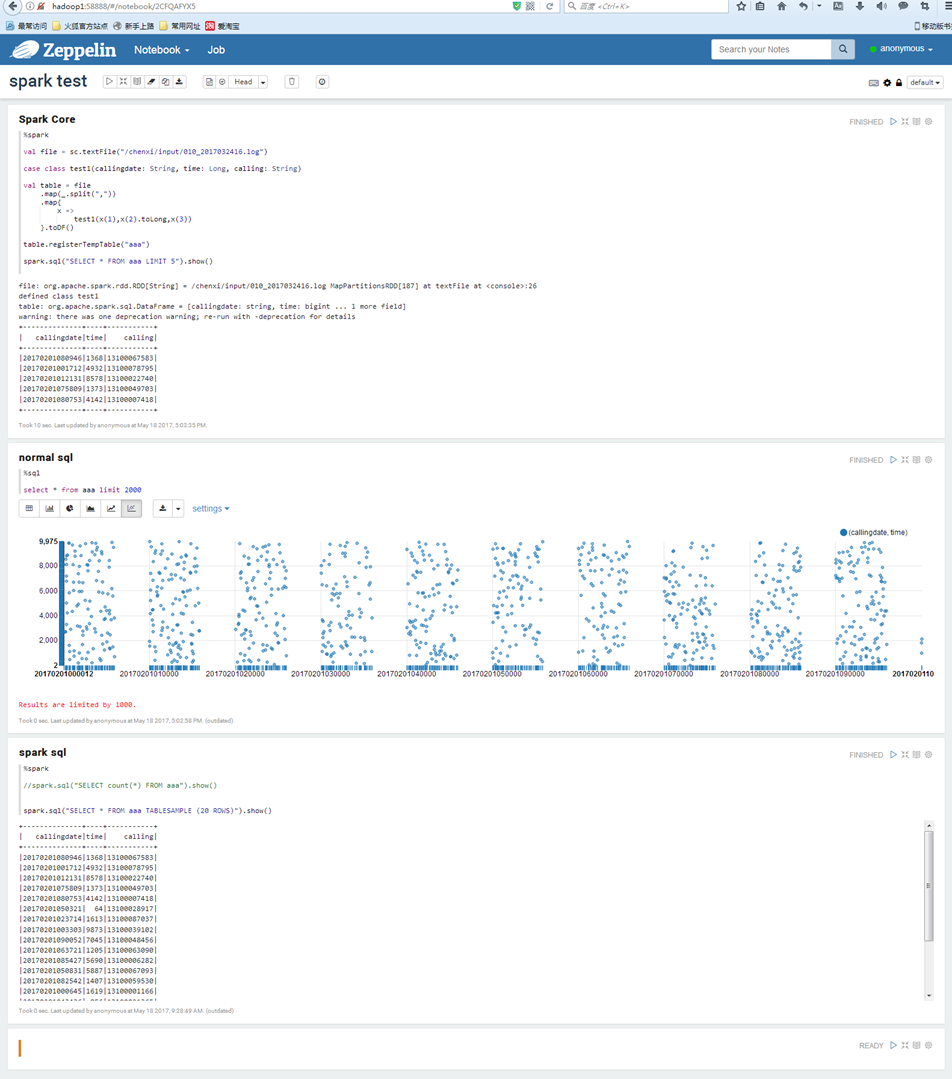

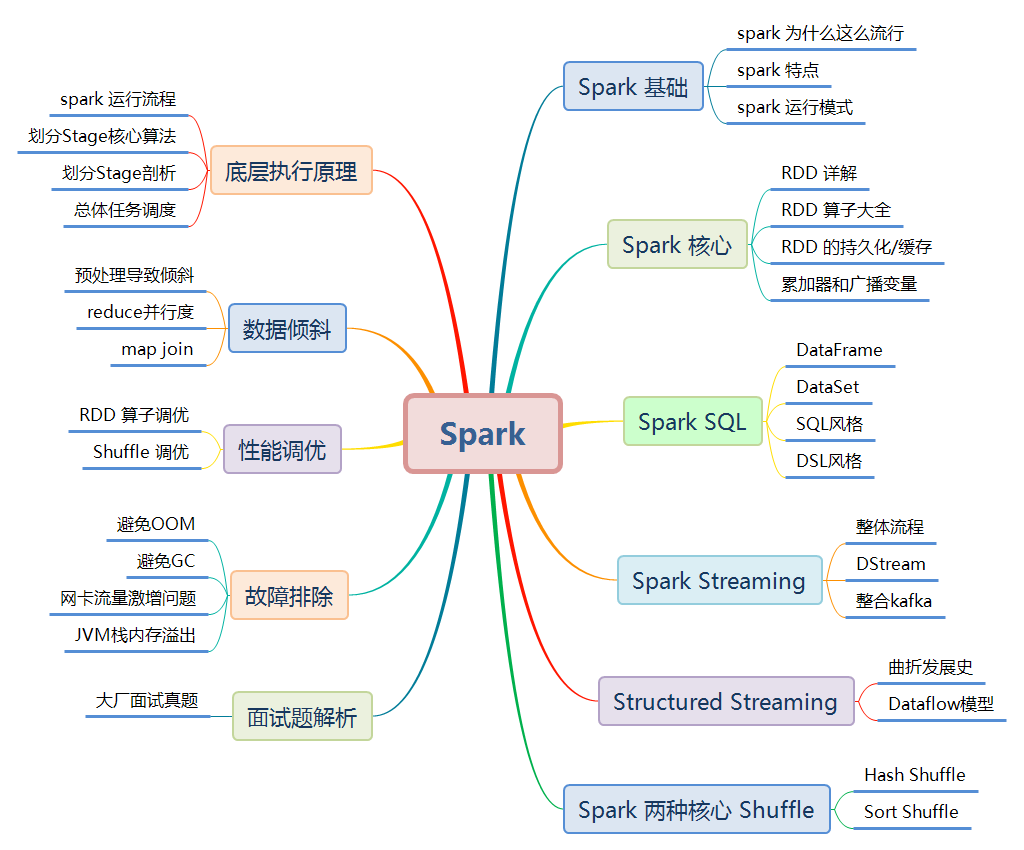

大数据分析

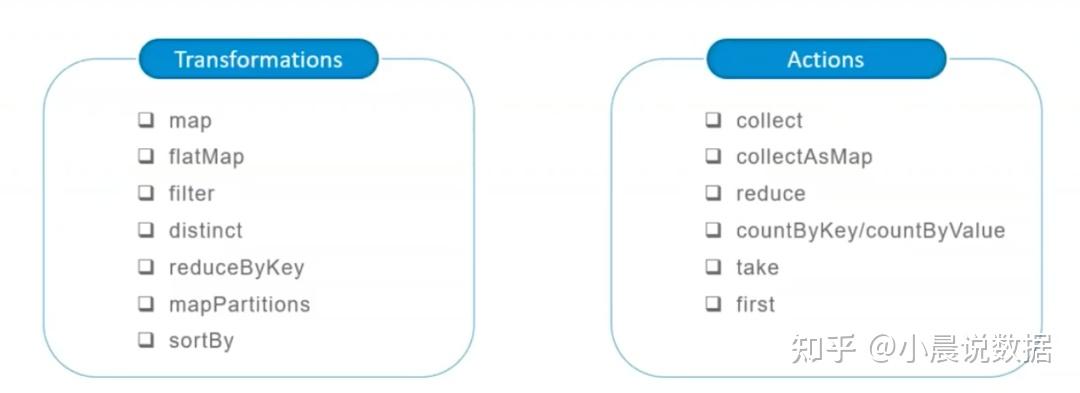

- Hadoop 是基础,其中的HDFS提供文件存储,Yarn进行资源管理。在这上面可以运行MapReduce、Spark、Tez等计算框架。

- MapReduce 是一种离线计算框架,将一个算法抽象成Map和Reduce两个阶段进行处理,非常适合数据密集型计算。

- Spark : Spark是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用的并行计算框架,Spark基于map reduce算法实现的分布式计算,拥有Hadoop MapReduce所具有的优点;但不同于MapReduce的是Job中间输出和结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的map reduce的算法。

- Storm : MapReduce也不适合进行流式计算、实时分析,比如广告点击计算等。Storm是一个免费开源、分布式、高容错的实时计算系统。Storm令持续不断的流计算变得容易,弥补了Hadoop批处理所不能满足的实时要求。Storm经常用于在实时分析、在线机器学习、持续计算、分布式远程调用和ETL等领域

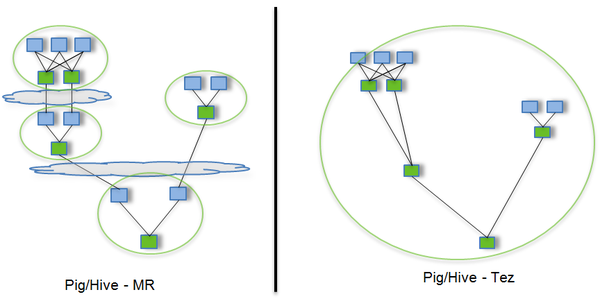

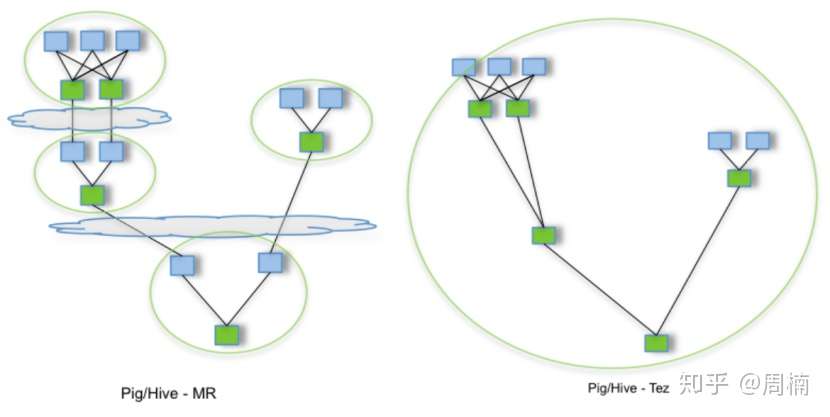

- Tez : 是基于Hadoop Yarn之上的DAG(有向无环图,Directed Acyclic Graph)计算框架。它把Map/Reduce过程拆分成若干个子过程,同时可以把多个Map/Reduce任务组合成一个较大的DAG任务,减少了Map/Reduce之间的文件存储。同时合理组合其子过程,也可以减少任务的运行时间

技术工具

大数据的计算引擎分成了 4 代。

- 第一代计算引擎,无疑是Hadoop MapReduce。它将计算分为两个阶段,分别为 Map 和 Reduce。上层应用需要自己手写map任务和reduce任务。

- 第一代框架基于简单的 Map Reduce 模型,计算框架和运算的基础是分布式文件系统 HDFS 和分布式资源管理系统 一起被创建出来。

- 第二代计算引擎,支持 DAG(有向无环图) 的框架: Tez ,主要还是批处理任务

- Spark沿用现有的分布式文件系统和分布式资源管理系统,在计算模型方面有很大的创新。

- 第三代计算引擎,以 Spark 为代表,特点主要是 Job 内部的 DAG 支持(不跨越 Job),以及强调的实时计算。

- 第四代计算引擎,以Flink、Blink为代表,一统批流,支持DAG运算,并具备进一步的实时性。

大数据技术漫谈 ——从Hadoop、Storm、Spark、HBase到Hive、Flink、Lindorm

离线计算历史演进

离线计算就是在计算开始前已知所有输入数据,输入数据不会产生变化。离线计算领域主要有Hadoop MapReduce、Spark、Hive/ODPS等计算框架。

- Hadoop MapReduce进行数据处理,需要用java、python等语言进行开发调试,分别编写Map、Reduce函数,并需要开发者自己对于Map和Reduce过程做性能优化,开发门槛较高,计算框架提供给开发者的助益并不多。在性能优化方面,常见的有在做小表跟大表关联的时候,可以先把小表放到缓存中(通过调用MapReduce的api),另外可以通过重写Combine跟Partition的接口实现,压缩从Map到reduce中间数据处理量达到提高数据处理性能。

- Spark 基于内存计算的准MapReduce,在离线数据处理中,一般使用Spark SQL进行数据清洗,目标文件一般是放在HDFS或者NFS上。

- Hive 是一种建立在Hadoop文件系统上的数据仓库架构,并对存储在HDFS中的数据进行分析与管理。Hive在Hadoop上架了一层SQL接口,可以将SQL翻译成MapReduce去Hadoop上执行,这样就使得数据开发和分析人员很方便的使用SQL来完成海量数据的统计和分析,而不必使用编程语言开发MapReduce,从而降低了数据开发的门槛。

目前业内离线数据处理,阿里的Odps平台(阿里内部的离线处理平台)底层利用自己的一套Hadoop集群每天提供PB级的数据处理,华为目前还是在基于Hadoop集群云化ETL处理数据,而字节跳动的数据平台在离线计算方向也主要运用Hive。

综合来看,Hive的学习成本最低,各大公司应用最广泛。

流式计算历史演进

目前主流的流式计算框架有Storm/Jstorm、Spark Streaming、Flink/Blink三种。

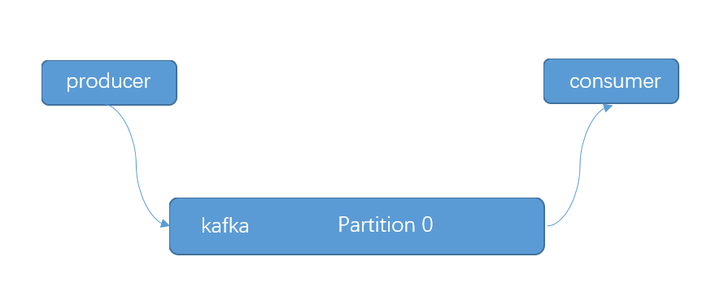

- Apache Storm是一个分布式实时大数据处理系统。Storm设计用于在容错和水平可扩展方法中处理大量数据。它是一个流数据框架,具有最高的摄取率。在Storm中,需要先设计一个实时计算结构,我们称之为拓扑(topology)。之后,这个拓扑结构会被提交给集群,其中主节点(master node)负责给工作节点(worker node)分配代码,工作节点负责执行代码。在一个拓扑结构中,包含spout和bolt两种角色。数据在spouts之间传递,这些spouts将数据流以tuple元组的形式发送;而bolt则负责转换数据流。Jstorm则是阿里巴巴使用Java语言复刻的Apache Storm,号称性能四倍于Apache Storm,于2016年停止更新。

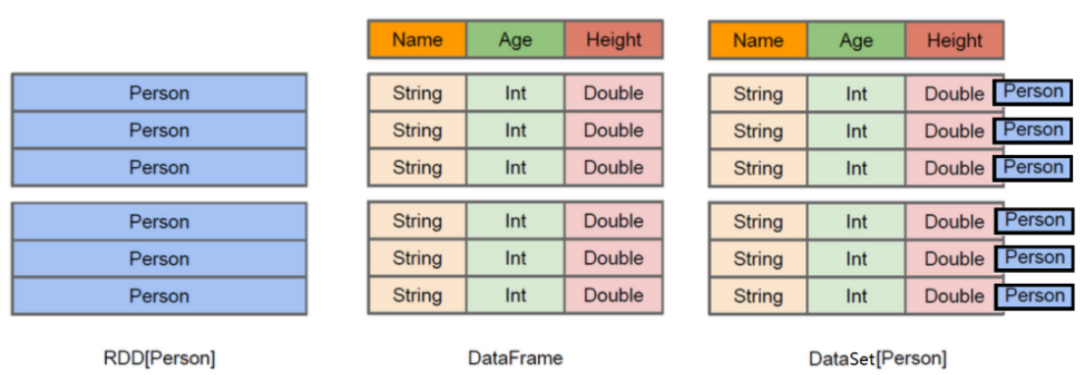

- Spark Streaming,即核心Spark API的扩展,不像Storm那样一次处理一个数据流。相反它在处理数据流之前,会按照时间间隔对数据流进行分段切分。Spark针对连续数据流的抽象,我们称为DStream(Discretized Stream)。DStream是小批处理的RDD(弹性分布式数据集),RDD则是分布式数据集,可以通过任意函数和滑动数据窗口(窗口计算)进行转换,实现并行操作。

- Apache Flink是针对流数据+批数据的计算框架。把批数据看作流数据的一种特例,延迟性较低(毫秒级),且能够保证消息传输不丢失不重复。Flink创造性地统一了流处理和批处理,作为流处理看待时输入数据流是无界的,而批处理被作为一种特殊的流处理,只是它的输入数据流被定义为有界的。Flink程序由Stream和Transformation这两个基本构建块组成,其中Stream是一个中间结果数据,而Transformation是一个操作,它对一个或多个输入Stream进行计算处理,输出一个或多个结果Stream。

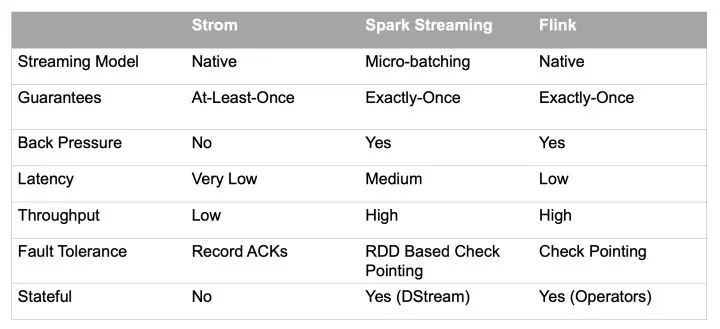

三种计算框架的对比如下

Flink/Blink是当前流式计算领域的主流框架

Flink/Blink是当前流式计算领域的主流框架

列式存储NOSQL数据库历史演进

NOSQL的概念博大精深,有键值(Key-Value)数据库、面向文档(Document-Oriented)数据库、列存储(Wide Column Store/Column-Family)数据库、图(Graph-Oriented)数据库等,主要讲述列存储数据库中最流行的HBase及其替代品Lindorm。

- HBase 是一个基于HDFS的、分布式的、面向列(列族)的非关系型数据库(NOSQL)。HBase巧妙地将大而稀疏的表放在商用的服务器集群上,单表可以有十亿行百万列,而且可以通过线性方式从下到上增加节点来进行横向扩展,读写性能优秀,支持批量导入,无需分库分表,存储计算分离,成本低,弹性好。

- Lindorm 是新一代面向在线海量数据处理的分布式数据库,适用于任何规模、多种模型的云原生数据库服务,其基于存储计算分离、多模共享融合的云原生架构设计,具备弹性、低成本、稳定可靠、简单易用、开放、生态友好等优势。

总体来说,Lindorm是HBase的升级版本,性能和稳定性等等通通优于HBase,如果需要使用海量数据提供在线服务,可以考虑Lindorm。

大数据开发语言历史演进

Scala语言曾是大数据开发的宠儿,行业内热度最高的消息中间件kafka就是使用Scala写就的,而大数据领域杀手级框架Spark也是由Scala编写的。另外,Scala语言函数式编程风格、天然适合处理大规模数据的Lambda表达式、简洁优雅的语法糖、陡峭的学习曲线也深受对代码美感有极致追求的程序员所喜爱。

- 曾经,Kafka + Scala + Spark + Spark Streaming的技术体系可以通吃批处理和流处理,直到一统批流、学习曲线也更平缓的Flink/Blink出现,彻底打破了这个局面,SQL语言在大数据处理中的占比大大提高。 当前,大数据开发语言可谓百花齐放、各领风骚。

- SQL语言(编写Flink/Blink、Hive任务)在数据仓库建设和数据分析领域应用广泛

- JVM语系(Java、Scala为主)在Hadoop生态中举足轻重并且是数据平台开发的首选

- Python在人工智能方向极为受宠

- R语言则是数据建模和数据可视化的利器。 每种语言都有自己的适用场景,建议根据自身的工种和兴趣来做选择。

建议学习的大数据组件:

- 1)流式、实时计算:Flink

- 2)离线计算:Hive

- 3)列式存储NOSQL数据库:Lindorm

Hadoop

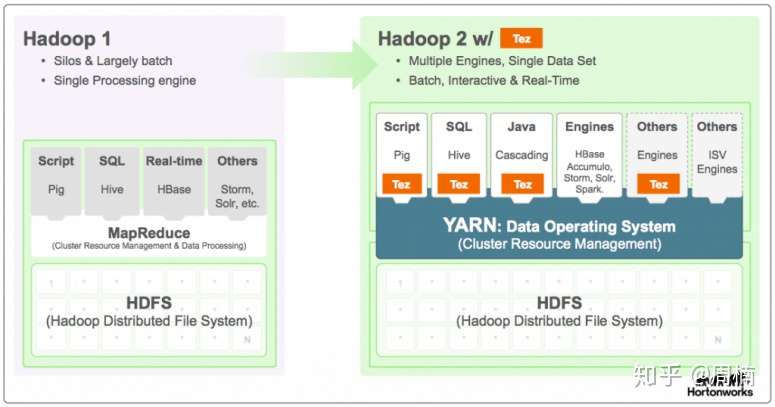

- Hadoop1到Hadoop2所做的改变,Hadoop1主要使用MapReduce引擎,到了Hadoop2,基于yarn,可以部署spark,tez等计算引擎,这里MapReduce作为一种引擎实现用的越来越少了,但是作为框架思路,tez本身也是MapReduce的改进。

- MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算。概念”Map(映射)”和”Reduce(归约)”。

Hadoop 资讯

数据湖

【2021-10-27】抛弃Hadoop,数据湖才能重获新生, 十年前,Hadoop 是解决大规模数据分析的“白热化”方法,如今却被企业加速抛弃。曾经顶级的 Hadoop 供应商都在为生存而战,Cloudera于本月完成了私有化过程,黯然退市。MapR 被 HPE 收购,成为 HPE Ezmeral 平台的一部分,该平台尚未在调查中显示所占据的市场份额。

从数据湖方向发力的 Databricks,却逃脱了“过时”的命运,于今年宣布获得 16 亿美元的融资。另一个大数据领域的新星——云数仓 Snowflake,去年一上市就创下近 12 年来最大 IPO 金额,成为行业领跑者。

行业日新月异,十年时间大数据的领导势力已经经历了一轮更替。面对新的浪潮,我们需要做的是将行业趋势和技术联系起来,思考技术之间的关联和背后不变的本质。

百度Hadoop

【2013-1-25】李彦宏的“罪己诏”

Hadoop之前,百度也曾开发自己的 GFS+MapReduce+BigTable

- 没错,百度想要开发的系统就是基于Google那三篇著名的论文的2。

- 这个系统叫做

Pyramid,其领衔人是王选的高徒阳振坤博士。 Pyramid大约开发了2-3年,最终以失败告终,据说最后与HadoopPK时, 完败下来,阳振坤也在其后离职加盟淘宝

不知道Google开发GFS+MapReduce+BigTable用了多久,但是GFS论文是2003年,MapReduce论文是2004年,BigTable应该是2007年,想来Google应该也是开发了4-6年左右的时间。

- Pyramid的失败直接导致了Hadoop在百度的崛起,不到两年,Hadoop的机器数量从无到有,很快就突破了万台的规模,并且机房也从北京开始像长三角扩展,百度也终于迈出了跨数据中心的步子,尽管这个步伐似乎比Google慢了5-8年4?

不过百度虽然Hadoop用得很High,负载什么的,报表都弄得不错,集群规模也上了国内少有的3000+台,但是却很少对Hadoop社区进行开源回馈。

- 其内部Hadoop是基于Hadoop 0.19-0.20改进的。

- 好处就是快,一方面依赖社区拿到已有的代码基,整合测试就可上线,同时也不用管什么伦理道德奉献回馈的鸟事

- 但其缺点是内部Hadoop和官方Hadoop会逐渐越走越远,上游的Patch和改进越到后来会越难引进合并。

- 结果就是和社区分离,用自己一人之力对抗全球智慧,最终只能自讨苦吃。

- 有一次内部年会上,有位工程师跳起来问,“公司可不可以做一些开源的产品呢?很多东西本来就是从外边拿过来的。”

- 只记得当时台上的两位高管,其中一位女高管脸色稍变,过了一会又开始讲什么“做开源需要时间精力;好的东西才好意思开源出去,否则会丢脸”。

- 一个IT公司有没有勇气拥抱开源,是一个公司是否对自己的技术有足够自信的一个表现。在这方面,百度乏陈可善,不但没有代码,连论文也很少。而淘宝在

章文嵩带领下,其开源已经做的如火如荼,算是国内IT企业中开源做的最好的一个。

三驾马车

【2022-2-8】Google 引爆大数据时代的三篇论文-《GFS》、《BigTable》、《MapReduce》

大数据起源于– 谷歌于2003年起发布一系列论文(大数据三驾马车):

- 《The Google File System 》

- 《MapReduce: Simplified Data Processing on Large Clusters》在大型集群中简化数据处理

- 《Bigtable: A Distributed Storage System for Structured Data》结构化数据的分布式存储系统

1. GFS

- GFS 是一个大型的分布式文件系统。一个面向大规模数据密集型应用的、可伸缩的分布式文件系统。

- 为 Google 大数据处理系统提供海量存储,并且与 MapReduce 和 BigTable 等技术结合得十分紧密,处于系统的底层。

- GFS 的系统架构如图 所示,主要由一个 Master Server(主服务器)和多个 Chunk Server(数据块服务器)组成。

- Master Server 主要负责维护系统中的名字空间,访问控制信息,从文件到块的映射及块的当前位置等元数据,并与 Chunk Server 通信。

- Chunk Server 负责具体的存储工作。数据以文件的形式存储在 Chunk Server 上。Client 是应用程序访问 GFS 的接口。

- Master Server 的所有信息都存储在内存里,启动时信息从 Chunk Server 中获取。这样不但提高了 Master Server 的性能和吞吐量,也有利于 Master Server 宕机后把后备服务器切换成 Master Server。

GFS 的系统架构设计有两大优势。

Client 和 Master Server 之间只有控制流,没有数据流,因此降低了 Master Server 的负载。 由于 Client 与 Chunk Server 之间直接传输数据流,并且文件被分成多个 Chunk 进行分布式存储,因此 Client 可以同时并行访问多个 Chunk Server,从而让系统的 I/O 并行度提高。

- Chunk Server 在硬盘上存储实际数据。Google 把每个 chunk 数据块的大小设计成 64MB,每个 chunk 被复制成 3 个副本放到不同的 Chunk Server 中,以创建冗余来避免服务器崩溃。如果某个 Chunk Server 发生故障,Master Server 便把数据备份到一个新的地方。

- HDFS (Hadoop Distributed File System)最早是根据 GFS(Google File System)的论文概念模型来设计实现的。

- HDFS 参照了它所以大部分架构设计概念是类似的,比如 HDFS NameNode 相当于 GFS Master,HDFS DataNode 相当于 GFS chunkserver。

2、MapReduce

GFS 解决了 Google 海量数据的存储问题,MapReduce 则是为了解决如何从这些海量数据中快速计算并获取期望结果的问题。

MapReduce 是由 Google 开发的一个针对大规模群组中的海量数据处理的分布式编程模型。

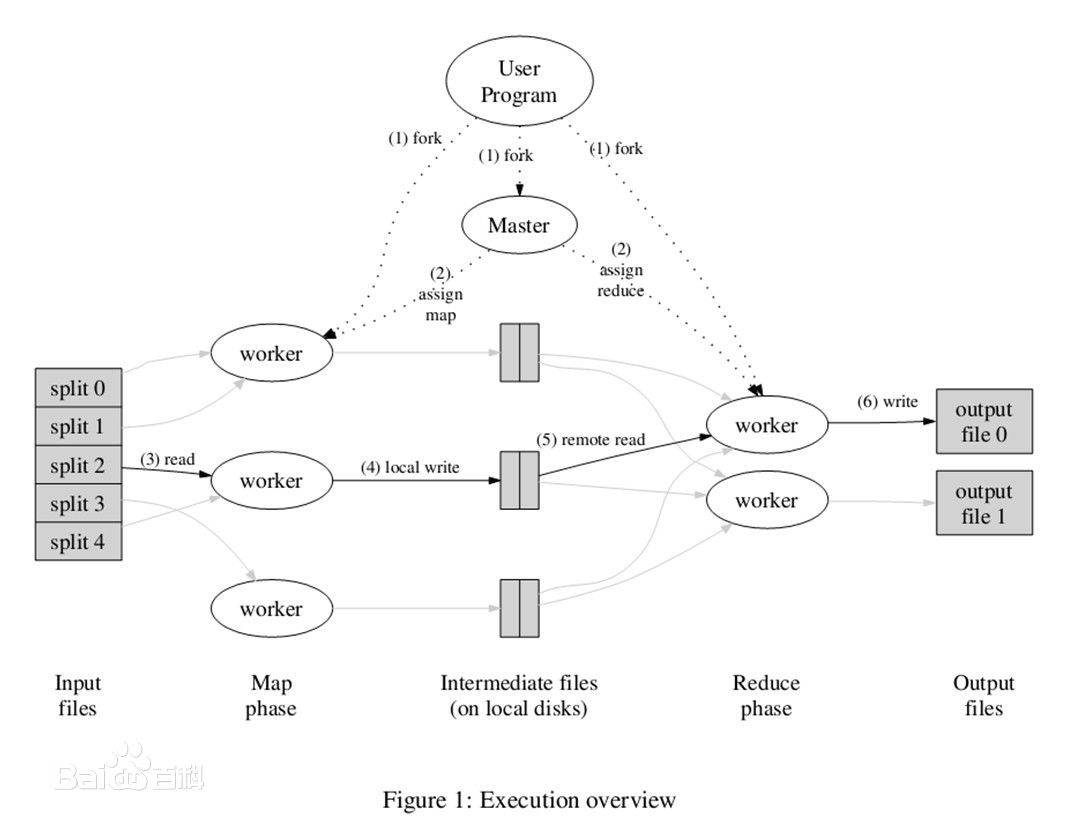

MapReduce 实现了 Map 和 Reduce 两个功能。Map 把一个函数应用于集合中的所有成员,然后返回一个基于这个处理的结果集,而 Reduce 是把两个或更多个 Map 通过多个线程、进程或者独立系统进行并行执行处理得到的结果集进行分类和归纳。

用户只需要提供自己的 Map 函数及 Reduce 函数就可以在集群上进行大规模的分布式数据处理。与传统的分布式程序设计相比,MapReduce 封装了并行处理、容错处理、本地化计算、负载均衡等细节,具有简单而强大的接口。正是由于 MapReduce 具有函数式编程语言和矢量编程语言的共性,使得这种编程模式特别适合于非结构化和结构化的海量数据的搜索、挖掘、分析等应用。

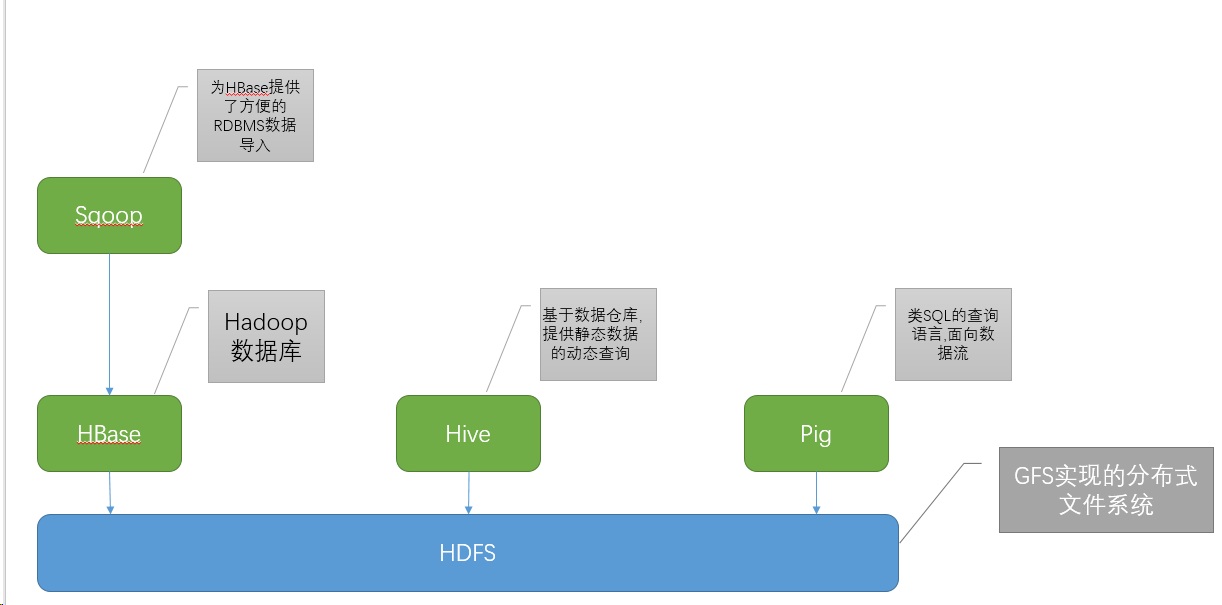

Hive基于数据仓库,提供静态数据的动态查询。其使用类SQL语言,底层经过编译转为MapReduce程序,在Hadoop上运行,数据存储在HDFS上。hive是用于OLAP,提供类sql语言的分析与计算的框架,底层就是MR。

3、BigTable

BigTable 是 Google 设计的分布式数据存储系统,是用来处理海量数据的一种非关系型数据库。BigTable 是一个稀疏的、分布式的、持久化存储的多维度排序的映射表。

BigTable 的设计目的是能够可靠地处理 PB 级别的数据,并且能够部署到上千台机器上。

BigTable 开发团队确定了 BigTable 设计所需达到的几个基本目标。

- 广泛的适用性(要满足一系列 Google 产品而并非特定产品的存储要求。)

- 很强的可扩展性(根据需要随时可以加入或撤销服务器。)

- 高可用性(确保几乎所有的情况下系统都可用。对于客户来说,有时候即使短暂的服务中断也是不能忍受的。)

- 简单性(底层系统的简单性既可以减少系统出错的概率,也为上层应用的开发带来了便利。)

Hbase是Hadoop database,即Hadoop数据库。它是一个适合于非结构化数据存储的数据库,HBase基于列的而不是基于行的模式。

- HBase是Google Bigtable的开源实现,类似Google Bigtable利用GFS作为其文件存储系统,HBase利用Hadoop HDFS作为其文件存储系统;Google运行MapReduce来处理Bigtable中的海量数据,HBase同样利用Hadoop MapReduce来处理HBase中的海量数据。

Hbase和Hive在大数据架构中处在不同位置,Hbase主要解决实时数据查询问题,Hive主要解决数据处理和计算问题,一般是配合使用。

Hadoop架构

hadoop分为几大部分:

- yarn负责资源和任务管理

- hdfs负责分布式存储

- map-reduce负责分布式计算

- Map-reduce依赖于yarn和hdfs

hadoop虽然有多个模块分别部署,但是所需要的程序都在同一个tar包中,所以不同模块用到的配置文件都在一起,几个最重要的配置文件:

- 各种默认配置:core-default.xml, hdfs-default.xml, yarn-default.xml, mapred-default.xml

- 各种web页面配置:core-site.xml, hdfs-site.xml, yarn-site.xml, mapred-site.xml

还有一些重要的配置:hadoop-env.sh、mapred-env.sh、yarn-env.sh,用来配置程序运行时的java虚拟机参数以及一些二进制、配置、日志等的目录配置

- Hadoop:是一个分布式计算的开源框架

- HDFS:是Hadoop的三大核心组件之一

- HDFS是GFS的一种实现,他的完整名字是分布式文件系统,类似于FAT32,NTFS,是一种文件格式,是底层的。

- Hive与Hbase的数据一般都存储在HDFS上。Hadoop HDFS为他们提供了高可靠性的底层存储支持。

- Hive:用户处理存储在HDFS中的数据,hive的意义就是把好写的hive的sql转换为复杂难写的map-reduce程序。

- Hive不支持更改数据的操作,Hive基于数据仓库,提供静态数据的动态查询。其使用类SQL语言,底层经过编译转为MapReduce程序,在Hadoop上运行,数据存储在HDFS上。

- Hbase:是一款基于HDFS的数据库,是一种NoSQL数据库,主要适用于海量明细数据(十亿、百亿)的随机实时查询,如日志明细、交易清单、轨迹行为等。

- Hbase是Hadoop database,即Hadoop数据库。它是一个适合于非结构化数据存储的数据库,HBase基于列的而不是基于行的模式。

- HBase是Google Bigtable的开源实现,类似Google Bigtable利用GFS作为其文件存储系统,HBase利用Hadoop HDFS作为其文件存储系统;Google运行MapReduce来处理Bigtable中的海量数据,HBase同样利用Hadoop MapReduce来处理HBase中的海量数据。

- Hadoop HDFS为HBase提供了高可靠性的底层存储支持,Hadoop MapReduce为HBase提供了高性能的计算能力,Zookeeper为HBase提供了稳定服务和failover机制。Pig和Hive还为HBase提供了高层语言支持,使得在HBase上进行数据统计处理变的非常简单。 Sqoop则为HBase提供了方便的RDBMS(关系型数据库)数据导入功能,使得传统数据库数据向HBase中迁移变的非常方便。

- Pig

- Pig语言层包括一个叫做PigLatin的文本语言,Pig Latin是面向数据流的编程方式。Pig和Hive类似更侧重于数据的查询和分析,底层都是转化成MapReduce程序运行。

- 区别是Hive是类SQL的查询语言,要求数据存储于表中,而Pig是面向数据流的一个程序语言。

- Sqoop:

- Sqoop则为HBase提供了方便的RDBMS数据导入功能,使得传统数据库数据向HBase中迁移变的非常方便。

Hive与HBase的区别与联系

区别:

- Hive:Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的sql查询功能。

- Hive本身不存储和计算数据,它完全依赖于HDFS和MapReduce,Hive中的表纯逻辑。hive需要用到hdfs存储文件,需要用到MapReduce计算框架。

- hive可以认为是map-reduce的一个包装。hive的意义就是把好写的hive的sql转换为复杂难写的map-reduce程序。

- HBase:HBase是Hadoop的数据库,一个分布式、可扩展、大数据的存储。

- hbase是物理表,不是逻辑表,提供一个超大的内存hash表,搜索引擎通过它来存储索引,方便查询操作

- hbase可以认为是hdfs的一个包装。他的本质是数据存储,是个NoSql数据库;hbase部署于hdfs之上,并且克服了hdfs在随机读写方面的缺点。

联系:

- Hbase和Hive在大数据架构中处在不同位置,Hbase主要解决实时数据查询问题,Hive主要解决数据处理和计算问题,一般是配合使用。

在大数据架构中,Hive和HBase是协作关系,数据流一般如下图:

- 通过ETL工具将数据源抽取到HDFS存储;

- 通过Hive清洗、处理和计算原始数据;

- HIve清洗处理后的结果,如果是面向海量数据随机查询场景的可存入Hbase

- 数据应用从HBase查询数据;

HDFS

HDFS的设计思路主要有三点:

- 一是普通服务器的硬性故障是常态,而不是“异常”,所以分布式文件系统要有自动化的容错性;

- 二是和Linux或者Windows的文件系统相比,分布式文件系统存储的文件要大得多,所以存储粒度大;

- 三是存储的大文件,很少需要修改其中的某一小部分,通常情况下只需要在尾部追加内容。有了HDFS,TB、PB基本的数据存取很容易了,不但如此,HDFS还要多并行处理提供支持,并行处理需要并发地读和写文件。

hdfs部分由 NameNode、SecondaryNameNode 和 DataNode组成。

- DataNode 是真正的在每个存储节点上管理数据的模块

- NameNode 是对全局数据的名字信息做管理的模块

- SecondaryNameNode 是它的从节点,以防挂掉。

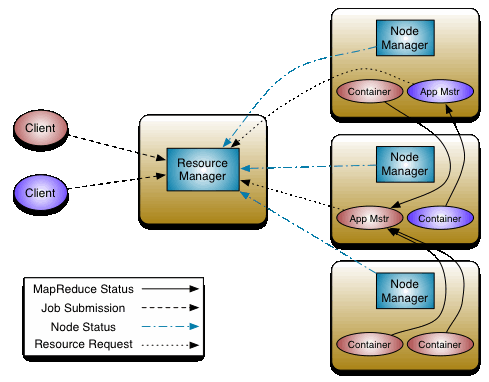

Yarn

yarn的两个部分:资源管理、任务调度。

- 资源管理需要一个全局的ResourceManager(RM)和分布在每台机器上的NodeManager协同工作,RM负责资源的仲裁,NodeManager负责每个节点的资源监控、状态汇报和Container的管理

- 任务调度也需要ResourceManager负责任务的接受和调度,在任务调度中,在Container中启动的ApplicationMaster(AM)负责这个任务的管理,当任务需要资源时,会向RM申请,分配到的Container用来起任务,然后AM和这些Container做通信,AM和具体执行的任务都是在Container中执行的

yarn区别于第一代hadoop的部署(namenode、jobtracker、tasktracker)

Yarn由一个ResourceManager和每台机器上的一个NodeManager组成。ResourceManage拥有为系统中所有应用分配资源的绝对权力。NodeManager作为每个机器上的容器,管理系统资源(cpu,memory,disk,network)的使用情况,并向ResourceManager或者Scheduler报告。

在Yarn上运行分布式应用,是通过ApplicationsMaster进行的,这里的应用指一个MapR job或者构成DAG图的多个job,应用运行结束相应的ApplicationsMaster就关闭退出了。

在Yarn上运行分布式应用,是通过ApplicationsMaster进行的,这里的应用指一个MapR job或者构成DAG图的多个job,应用运行结束相应的ApplicationsMaster就关闭退出了。

有些持续运行的框架,比如Hbase比较特殊,可以部署在yarn上,也可以不部署在yarn上。还有flink在yarn上运行,有两种部署方式: 一是long-running Flink cluster on YARN;另一种是 run a Flink job on YARN。

Mesos也是一个分布式集群的资源管理框架,相比较yarn它更底层,使用mesos需要它上面计算框架实现更多东西。使用Hadoop组件有这样一种部署方式,是先启动mesos,然后再在上面部署hdfs,yarn,这样就可以运行mapreduce了。Spark,flink这种计算框架都支持直接部署到mesos上(需要用到hdfs的话,需要在mesos上部署hdfs)。

Mrv2

再了解了解ApplicationsMaster

- Yarn支持不同的计算框架是通过ApplicationsMaster来实现的,不同的计算框架实现各自的类库,然后由ApplicationsMaster运行,比如Mrv2,Spark,Flink都可以通过这种方式在Yarn上运行。

- Mrv2运行时,首先作为ApplicationsMaster向Yarn的ResourceManager请求所需的资源,然后通过和NodeManager配合启动这些资源,监控它们的执行情况,直到任务运行结束,然后这个ApplicationsMaster实例退出。

Hadoop 命令

Hadoop HDFS Commands with Examples

【2024-3-4】touch和touchz区别

- touch 命令在指定路径下创建一个空文件

- 如果该文件不存在,则创建一个新文件。

- 如果文件已经存在,则也不会报错,只是会修改文件的访问时间。

- touchz 命令只会创建一个空文件

- 但是如果文件已经存在,则不会更改现有文件的时间戳

hadoop fs -ls /user/hadoop

hadoop fs -lsr [-d] [-h] [-R] / # 递归

hadoop fs -touch /usr/test.txt # 创建文件,修改访问时间

hadoop fs -touchz /usr/test.txt # 创建空文件,不修改访问时间

# 文件信息

hadoop fs -stat /in/appendfile # 2014-11-26 04:57:04

hadoop fs -stat %Y /in/appendfile # 1416977824841

hadoop fs -stat %o /in/appendfile # 134217728

# 目录

hadoop fs -mkdir /user/hadoop/

hadoop fs -chmod [-R] PATH # 改权限

# 查看内容

hadoop fs -cat /user/data/sampletext.txt

hadoop fs -tail /user/data/sampletext.txt

hadoop fs -head /user/data/sampletext.txt

# This command appends the contents of all the given local files to the provided destination file on the HDFS filesystem. The destination file will be created if it is not existing earlier.

# hadoop fs -appendToFile

hadoop fs -appendToFile derby.log data.tsv /in/appendfile # 追加文件到hdfs文件上

hadoop fs -cat /in/appendfile

# hdfs 文件 复制

hadoop fs -cp /user/data/sample1.txt /user/hadoop1

hadoop fs -cp /user/data/sample2.txt /user/test/in1

# hdfs 文件移动

hadoop fs -mv /user/hadoop/sample1.txt /user/text/

# hdfs 文件删除

hadoop fs -rm /user/test/sample.txt

hadoop fs -rmdir /user/test/ # 删除目录

hadoop fs -rm -r /user/test/sample.txt # 递归删除

hadoop fs -rm -rR /user/test/sample.txt # 递归删除目录

hadoop fs -rm -f /user/test/sample.txt # 无文件提示

hadoop fs -rm -skipTrash /user/test/sample.txt # 避开trash目录

# 获取hdfs文件到本地

hadoop fs -get [-f] [-p]

hadoop fs -get /user/data/sample.txt workspace/

hadoop fs -moveToLocal /user/data/sample.txt workspace/ # 文件获取

hadoop fs -getmerge /user/data # 热门命令:将hdfs目录合并复制到本地, used for merging a list of files in a directory on the HDFS filesystem into a single local file on the local filesystem.

# 上传本地文件到Hadoop

hadoop fs -put /usr/tmp/test1.txt /test1.txt

hadoop fs -copyFromLocal /usr/tmp/test1.txt /test1.txt # local -> hdfs

hadoop fs -put sample.txt /user/data/

hadoop fs -moveFromLocal sample.txt /user/data/

# change the replication factor of a file to a specific count instead of the default replication factor for the remaining in the HDFS file system

hadoop fs -setrep -R /user/hadoop/

# create a file of zero bytes size in HDFS filesystem.

hadoop fs -touchz URI

# test an HDFS file’s existence of zero length of the file or whether if it is a directory or not.

hadoop fs -test -[defsz] /user/test/test.txt

# used to empty the trash available in an HDFS system

hadoop fs –expunge

# This command is used to show the capacity, free and used space available on the HDFS filesystem

hadoop fs -du [-s] [-h] # 文件大小

hadoop fs -dus [-s] [-h] # 目录总大小

# This command is used to count the number of directories, files, and bytes under the path that matches the provided file pattern.

hadoop fs -count [-q]

# This command is used to run the MapReduce JobTracker node, which coordinates the data processing system for Hadoop

hadoop jobtracker –dumpConfiguration

【2023-11-10】HDFS不支持用户磁盘配额和访问权限控制,也不支持硬链接和软链接

Hive

Hive的出现是为了自动化编写MapReduce程序。

- 复杂业务中,逐个写Mapreduce比较繁琐,并且对不同的数据集,处理方式可能类似,都是筛选、分组统计、排序等相似的功能。于是Hive通过熟悉的SQL语句来描述需要对数据进行的处理,然后通过hive引擎把sql转换成一个或多个mapreduce任务并调度执行,这就大大减少了相似的mapreduce编写工作,提高了效率。

环境设置

设置变量

set k=v;

set date='20240130';

reduce 数目

用局部排序 sort 实现全局排序

- top k 功能

set mapred.reduce.tasks=1; -- 旧版 mapred

select * from sales

sort by amount desc

limit 10

yarn 队列

Hive设置运行参数

- Hive设置YARN执行队列

- Hive3.0默认引擎是tez,所以写mapreduce那一套指定队列不生效。

MapReduce引擎

设置执行任务时的yarn资源队列:

- 进入hive命令行后:

set mapreduce.job.queuename=队列名 - 启动hive时指定:

--hiveconf mapreduce.job.queuename=队列名

TEZ引擎

设置执行任务时的yarn资源队列:

- 进入Hive命令行后:

set tez.queue.name=队列名 - 启动hive时指定:

--hiveconf tez.queue.name=队列名

-- 多级队列

root.xxx.yyy

-- 进入hive命令行后:

set mapreduce.job.queuename=队列名

-- 在启动hive时指定

--hiveconf mapreduce.job.queuename=队列名

数据结构

Hive 复杂数据结构

- 数组 array

- 映射 map

- 结构体 struct

-- 一组有序字段,类型相同

Array(1,2)

-- 一组无序键值对, key必须原子,同一个映射的键值必须同类型

Map('a', 1)

-- 一组命名字段, 类型不要求

Struct('a',1,1,o)

-- named_struct 主要用于字段拼接,定义别名

named_struct("a", a, "b":b) as new

array

使用array[下标]方式访问

-- 创建 array

create table test4(field4 array<string>);

-- sql 插入数据

insert into test4(field4) values(array("zhangsan","lisi","wangwu"));

insert into test4(field4) values(`array`("lily","bob","alice"));

insert into test4(field4) values(`array`("A","B","C"));

-- 查询数据

select * from test4;

select field4[0] from test4;

select * from test4 where field4[0]="zhangsan";

struct

-- 创建 struct 结构

create table test2(field1 struct<name:string, age:int> comment "test field") row format delimited fields terminated by "," collection items terminated by ":";

-- 插入 struct 类型

insert into test2(field1)values(named_struct("name",'zhangsan',"age",25));

insert into test2(field1)values(named_struct("name","lisi","age",23));

-- 或从文件导入

-- name:wangwu|age:27

-- name:zhaoliu|age:28

load data local inpath '/Users/.../test.txt' into table test2;

-- 查询所有数据

select * from test2;

-- 查询name字段

select field1.name from test2;

-- 查询name为zhangsan的记录

select field1 from test2 where field1.name = "zhangsan";

map

map的用法基本相似

-- 创建 map 结构

create table test3(field2 map<string,string>) row format delimited fields terminated by ',' collection items terminated by "|" map keys terminated by ":";

-- sql插入

insert into test3(field2)values(str_to_map("name:zhangsan,age:25")),(str_to_map("name:lisi,age:23"));

-- 文件导入

load data local inpath '/Users/zhangsheng/hive/note/hive/test.txt' into table test3;

-- 查询数据

select * from test3;

select field2["name"] as name,field2["age"] as age from test3;

select * from test3 where field2["age"] > 25;

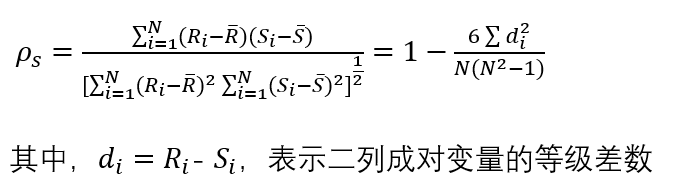

join

Hive中,JOIN是一种常用的操作,用于将两个或多个表中的数据按照指定的条件进行关联

- 1、左连接 left outer join

- 以左边表为准,逐条去右边表找相同字段,如果有多条会依次列出。

- 2、连接join

- 找出左右相同同的记录。

- 3、全连接 full outer join

- 包括两个表的join结果,左边在右边中没找到的结果(NULL),右边在左边没找到的结果。

- 会对结果去重,返回并集。

多种JOIN类型,包括:

内连接(inner join或者简写成join):只返回两个表中匹配的行。内连接基于一个或多个条件(通常是相等条件),匹配两个表中的行,并将匹配的行返回为结果。只有满足条件的行才会被包含在结果中。左外连接(left outer join或者简写成left join):返回左表中的所有行以及与右表匹配的行。如果右表中没有匹配的行,则对应的结果列将包含NULL值。右外连接(right outer join或者简写成right join):返回右表中的所有行以及与左表匹配的行。如果左表中没有匹配的行,则对应的结果列将包含NULL值。全外连接(full outer join或者简写成full join):返回两个表中的所有行,如果某一行在另一个表中没有匹配,则对应的结果列将包含NULL值。- full outer join 无效

SELECT *

FROM table1

JOIN table2 -- 内连接

-- LEFT JOIN table2 -- 左连接

-- RIGHT JOIN table2 -- 右连接

-- FULL OUTER JOIN table2 -- 全外连接

ON table1.id = table2.id;

-- 多表连接

SELECT *

FROM table1

INNER JOIN table2

ON table1.id = table2.id

INNER JOIN table3

ON table2.id = table3.id;

图解

MapJoin

- 常规 join 时,Hive 会启动 MapJoin优化,将小表加载内存,提速

- FULL JOIN 时,Hive不会使用 MapJoin来优化

除此之外,Hive还支持 LEFT SEMI JOIN 和 CROSS JOIN,但这两种JOIN类型也可以用前面的代替。

数据准备

create external table IF NOT EXISTS temp_testjoin_ta

(

label string,

qu string

)

partitioned by (dt string)

row format delimited fields terminated by '\t'

stored as textfile;

ALTER TABLE temp_testjoin_ta ADD IF NOT EXISTS PARTITION (dt = '2014-08-08') location '/temp/jinlong10/testjoin/ta';

-- l1 q1

-- l1 q2

create external table IF NOT EXISTS temp_testjoin_tb

(

qu string,

inmyway string

)

partitioned by (dt string)

row format delimited fields terminated by '\t'

stored as textfile;

ALTER TABLE temp_testjoin_tb ADD IF NOT EXISTS PARTITION (dt = '2014-08-08') location '/temp/jinlong10/testjoin/tb/';

-- q1 i1

-- q1 i1

-- q1 i2

-- q1 i3

-- q2 i1

-- q2 i2

-- q3 i10

join

select * from (select label,qu from temp_testjoin_ta where dt = '2014-08-08') ta join (select qu,inmyway from temp_testjoin_tb where dt = '2014-08-08') tb on ta.qu = tb.qu ;

-- l1 q1 q1 i1

-- l1 q1 q1 i1

-- l1 q1 q1 i2

-- l1 q1 q1 i3

-- l1 q2 q2 i1

-- l1 q2 q2 i2

select * from (select label,qu from temp_testjoin_ta where dt = '2014-08-08') ta join (select qu,inmyway from temp_testjoin_tb where dt = '2014-08-08') tb on ta.qu = tb.qu group by label,inmyway;

-- l1 i1

-- l1 i2

-- l1 i3

left outer

select * from (select label,qu from temp_testjoin_ta where dt = '2014-08-08') ta left outer join (select qu,inmyway from temp_testjoin_tb where dt = '2014-08-08') tb on ta.qu = tb.qu ;

-- l1 q1 q1 i1

-- l1 q1 q1 i1

-- l1 q1 q1 i2

-- l1 q1 q1 i3

-- l1 q2 q2 i1

-- l1 q2 q2 i2

select * from (select label,qu from temp_testjoin_ta where dt = '2014-08-08') ta left outer join (select qu,inmyway from temp_testjoin_tb where dt = '2014-08-08') tb on ta.qu = tb.qu group by label,inmyway;

-- l1 i1

-- l1 i2

-- l1 i3

full outer

select * from

(select label,qu from temp_testjoin_ta where dt = '2014-08-08') ta

full outer join (select qu,inmyway from temp_testjoin_tb where dt = '2014-08-08') tb

on ta.qu = tb.qu ;

-- l1 q1 q1 i3

-- l1 q1 q1 i2

-- l1 q1 q1 i1

-- l1 q1 q1 i1

-- l1 q2 q2 i2

-- l1 q2 q2 i1

-- NULL NULL q3 i10

left semi join

从a表中提取命中b表的数据

SELECT a.id,

a.name

FROM lxw1234_a a

LEFT SEMI JOIN lxw1234_b b

ON (a.id = b.id);

--执行结果:

1 zhangsan

2 lisi

--等价于:

SELECT a.id,

a.name

FROM lxw1234_a a

WHERE a.id IN (SELECT id FROM lxw1234_b);

--也等价于:

SELECT a.id,

a.name

FROM lxw1234_a a

join lxw1234_b b

ON (a.id = b.id);

--也等价于:

SELECT a.id,

a.name

FROM lxw1234_a a

WHERE EXISTS (SELECT 1 FROM lxw1234_b b WHERE a.id = b.id);

笛卡尔积关联(CROSS JOIN)

返回两个表的笛卡尔积结果,不需要指定关联键。

- 表不大时,才适合CROSS JOIN,否则内存爆满

SELECT a.id,

a.name,

b.age

FROM lxw1234_a a

CROSS JOIN lxw1234_b b;

Hive SQL优化

【2022-8-12】Hive/HiveSQL常用优化方法全面总结

影响Hive效率的几乎从不是数据量过大,而是数据倾斜、数据冗余、job或I/O过多、MapReduce分配不合理等等。对Hive的调优既包含对HiveSQL语句本身的优化,也包含Hive配置项和MR方面的调整。

- 列裁剪和分区裁剪: 查询时只读取需要的列、分区

- 当列很多或者数据量很大时,如果select *或者不指定分区,全列扫描和全表扫描效率都很低。

- Hive中与列裁剪优化相关的配置项是 hive.optimize.cp,与分区裁剪优化相关的则是 hive.optimize.pruner,默认都是true。在HiveSQL解析阶段对应的则是ColumnPruner逻辑优化器。

- 谓词下推: 将SQL语句中的where谓词逻辑都尽可能提前执行,减少下游处理的数据量。

- 将SQL语句中的where谓词逻辑都尽可能提前执行,减少下游处理的数据量。

- sort by代替order by: 局部排序 vs 全局排序

- order by 全局排序,只使用1个reducer,数据量大时节点的时间开销大

- sort by启动多个reducer进行排序,并且保证每个reducer内局部有序。配合distribute by一同使用

- group by代替distinct

- 统计某一列的去重数时,如果数据量很大,count(distinct)就会非常慢,原因与order by类似,count(distinct)逻辑只会有很少的reducer来处理。这时可以用group by来改写

- group by配置调整

- map端预聚合

- 倾斜均衡配置项

- join基础优化

- build table(小表)前置

- 多表join时key相同

- 利用map join特性

- 分桶表map join

- 倾斜均衡配置项

- 优化SQL处理join数据倾斜

- 空值或无意义值

- 单独处理倾斜key

- 不同数据类型

- build table过大

- MapReduce优化

- 调整mapper数

- 调整reducer数

- 合并小文件

- 启用压缩

- JVM重用

- 并行执行与本地模式

- 严格模式

- 采用合适的存储格式

-- 列/分区裁剪

select uid,event_type,record_data

from calendar_record_log

where pt_date >= 20190201 and pt_date <= 20190224 and status = 0;

-- 谓词下推

select a.uid,a.event_type,b.topic_id,b.title

from calendar_record_log a left outer join (

select uid,topic_id,title from forum_topic

where pt_date = 20190224 and length(content) >= 100

) b on a.uid = b.uidwhere a.pt_date = 20190224 and status = 0;

-- sort by与group by

select uid,upload_time,event_type,record_data

from calendar_record_log

where pt_date >= 20190201 and pt_date <= 20190224

distribute by uid

sort by upload_time desc,event_type desc;

-- group by代替distinct

select count(1) from (select uid from calendar_record_log where pt_date >= 20190101 group by uid) t;

-- 其它看原文

Hive SQL经验

- 【2021-12-10】统计代码:test.sql,多年Hive学习总结 飞书文档

- 函数使用:sum、if、round、count

- 环境变量:hivevar

--- 拼接 ---

-- ①多个字符串连接(任意个数字段) concat(a, b, c)

select concat(‘abc’,'def’,'gh’) from lxw_dual; -- CONCAT

-- ②多个字符串连接,指定分隔符 concat_ws('-', a, b, c)

SELECT CONCAT_WS(",","First name","Second name","Last Name");

-- ③分组连接多个字符串字段 group_concat

SELECT locus,GROUP_CONCAT(id) FROM info WHERE locus IN('AB086827','AF040764') GROUP BY locus; -- 直接连接字段,分隔符默认逗号,

SELECT locus,GROUP_CONCAT(distinct id ORDER BY id DESC SEPARATOR '_') FROM info WHERE locus IN('AB086827','AF040764') GROUP BY locus; -- 组内去重排序后,按照指定分隔符连接

SELECT locus,GROUP_CONCAT(concat_ws(', ',id,journal) ORDER BY id DESC SEPARATOR '. ') FROM info WHERE locus IN('AB086827','AF040764') GROUP BY locus; -- 组内处理后,再连接

-- coalesce 选择第一个非空值

select coalesce(a,b,c);

select COALESCE(is_test, -1) as saas_is_test,

-- 参数说明:如果a==null,则选择b;如果b==null,则选择c;如果a!=null,则选择a;如果a b c 都为null ,则返回为null。

-- 【2023-4-5】spark, 同组数值聚合, 自定义,非官方

select

collect_list(COALESCE(deal_cnt,0)) as deal_cnts, -- 当日成交量

from tbl

group by a

-- 交互成功率

select city_name as `城市`, count(*) as `总交互数`,

sum(if(intent!='other',1,0)) as `成功数`, round(sum(if(intent!='other',1,0))*100/count(*),2) as `成功率`,

sum(if(intent!='other',1,0)) as `失败数`, round(sum(if(intent=='other',1,0))*100/count(*),2) as `失败率`

from aisearch.aisearch_olap_speech_dialog_management_log_data_raw_di

-- where pt between '20210923000000' and '20210926000000' and bot_id='contract_center' group by city_name

where pt between '${hivevar:start_dt}' and '${hivevar:end_dt}' and bot_id='contract_center' group by city_name

union

select '所有', count(*), sum(if(intent!='other',1,0)), round(sum(if(intent!='other',1,0))*100/count(*),2),

sum(if(intent!='other',1,0)), round(sum(if(intent=='other',1,0))*100/count(*),2)

from aisearch.aisearch_olap_speech_dialog_management_log_data_raw_di

where pt between '20210923000000' and '20210926000000' and bot_id='contract_center' group by '所有'

order by `总交互数` desc;

-- 【2022-11-30】时间戳转换

select from_unixtime(1605108612); -- 2020-11-11 15:30:12

select from_unixtime(1605108612,'MM-dd-yyyy HH:mm:ss'); -- 11-11-2020 15:30:12

【2023-4-5】参考

IF/COALESCE 条件

SELECT

SUM(COALESCE(sex_age.age, 0)) AS age_sum,

SUM(IF(sex_age.sex='Female',sex_age.age,0)) AS female_age_sum

FROM employee;

CASE WHEN 分支条件

SELECT SUM(

CASE WHEN sex_age.sex='Male' THEN sex_age.age ELSE 0 END

)/COUNT(

CASE WHEN sex_age.sex='Male' THEN 1 ELSE NULL END

) AS male_age_avg

FROM employee;

CONCAT_{WS}

字符串连接:横向

- CONCAT 逐个链接

- CONCAT_WS 统一指定分隔符

select subtype

,concat_ws('&',collect_set(cast(from as string))) from

,concat_ws('&',collect_set(cast(id as string))) id

,concat_ws('&',collect_set(cast(name as string)))name

,concat_ws('&',collect_set(cast(type as string))) type

from aaaaaaa

group by subtype;

聚合函数(UDAF)

聚合函数

- SUM 求和

- AVG 均值

Hive聚合中,如果某个聚合列的值中有null,则包含该null的行将在聚合时被忽略。

为了避免这种情况,可以使用 COALESCE 来将null替换为一个默认值。

SELECT AVG(COUNT(*)) AS row_cnt FROM employee;

SELECT COUNT(DISTINCT sex_age.sex) AS sex_uni_cnt, COUNT(DISTINCT name) AS name_uni_cnt FROM employee;

-- 使用 COALESCE 保留空值行

SELECT SUM(COALESCE(val1, 0)), SUM(COALESCE(val1, 0)+val2) FROM t;

高级聚合主要有以下几种情况:

- GROUPING SETS

- 对同一个数据集的多重GROUP BY操作。事实上 GROUPING SETS是多个GROUP BY进行UNION ALL操作的简单表达,仅使用一个stage完成这些操作。GROUPING SETS 的子句中如果包换()数据集,则表示整体聚合。

- 然而GROUPING SETS目前还有未解决的问题,参考HIVE-6950

- ROLLUP和CUBE

- 这两个关键字都是GROUP BY的高级实现。

-- 一次标记多种 group

SELECT name, work_place[0] AS main_place,

count(employee_id) AS emp_id_cnt

FROM employee_id

GROUP BY name, work_place[0]

GROUPING SETS((name, work_place[0]), name, work_place[0], ());

-- 或 ---

SELECT name, work_place[0] AS main_place,

count(employee_id) AS emp_id_cnt

FROM employee_id

GROUP BY name, work_place[0]

UNION ALL

SELECT name, NULL AS main_place, count(employee_id) AS emp_id_cnt

FROM employee_id

GROUP BY name

UNION ALL

SELECT NULL AS name, work_place[0] AS main_place,

count(employee_id) AS emp_id_cnt

FROM employee_id

GROUP BY work_place[0]

UNION ALL

SELECT NULL AS name, NULL AS main_place,

count(employee_id) AS emp_id_cnt

FROM employee_id;

SELECT sex_age.sex, sex_age.age,

count(name) AS name_cnt

FROM employee

GROUP BY sex_age.sex, sex_age.age

GROUPING SETS((sex_age.sex, sex_age.age));

- 对比于规定了n层聚合的GROUPING SETS,ROLLUP会创建n+1层聚合,在此n表示分组列的个数。

- GROUP BY a, b, c WITH ROLLUP 等价于 GROUP BY a,b,c GROUPING SETS ((a,b,c),(a,b),(a),())

- CUBE将会对分组列进行所有可能的组合聚合。如果为CUBE指定了n列,则将返回2^n个聚合组合。

- GROUP BY a, b, c WITH ROLLUP 等价于 GROUP BY a,b,c GROUPING SETS ((a,b,c),(a,b),(b,c),(a,c),(a),(b),(c),())